Trí tuệ nhân tạo

Ít hơn là nhiều hơn: Tại sao việc lấy ít tài liệu hơn có thể cải thiện câu trả lời của AI

Thế hệ tăng cường truy xuất (RAG) là một cách tiếp cận để xây dựng các hệ thống AI kết hợp mô hình ngôn ngữ với nguồn kiến thức bên ngoài. Nói một cách đơn giản, AI đầu tiên tìm kiếm các tài liệu có liên quan (như bài viết hoặc trang web) liên quan đến truy vấn của người dùng, sau đó sử dụng các tài liệu đó để tạo ra câu trả lời chính xác hơn. Phương pháp này đã được ca ngợi vì giúp mô hình ngôn ngữ lớn (LLM) hãy trung thực và giảm ảo giác bằng cách dựa phản ứng của mình vào dữ liệu thực tế.

Theo trực giác, người ta có thể nghĩ rằng AI thu thập càng nhiều tài liệu thì câu trả lời của nó sẽ càng có thông tin tốt hơn. Tuy nhiên, nghiên cứu gần đây cho thấy một bước ngoặt đáng ngạc nhiên: khi nói đến việc cung cấp thông tin cho AI, đôi khi ít hơn lại là nhiều hơn.

Ít tài liệu hơn, câu trả lời tốt hơn

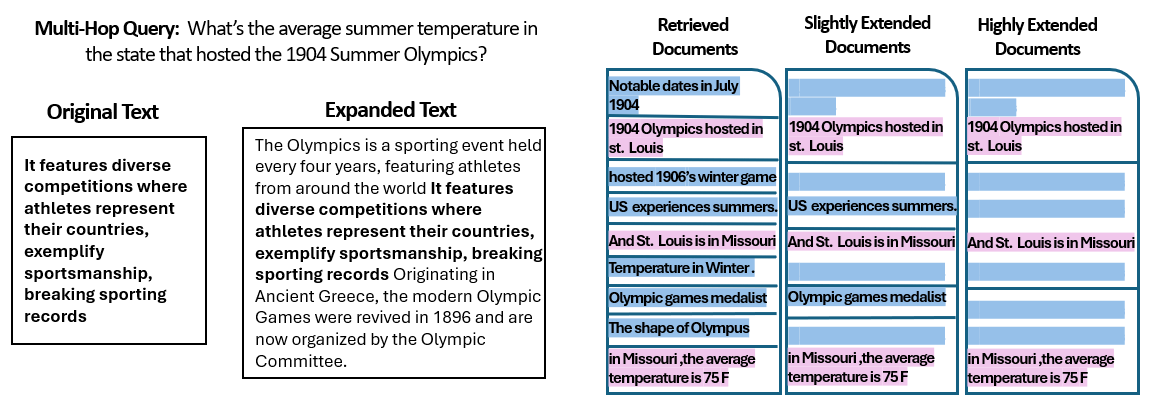

A Nghiên cứu mới bởi các nhà nghiên cứu tại Đại học Hebrew ở Jerusalem đã khám phá cách thức con số của các tài liệu được cung cấp cho hệ thống RAG ảnh hưởng đến hiệu suất của nó. Quan trọng là, họ giữ nguyên tổng lượng văn bản – nghĩa là nếu ít tài liệu được cung cấp hơn, các tài liệu đó sẽ được mở rộng một chút để lấp đầy cùng độ dài như nhiều tài liệu khác. Theo cách này, bất kỳ sự khác biệt nào về hiệu suất đều có thể được quy cho số lượng tài liệu thay vì chỉ đơn giản là có đầu vào ngắn hơn.

Các nhà nghiên cứu đã sử dụng một tập dữ liệu trả lời câu hỏi (MuSiQue) với các câu hỏi đố vui, mỗi câu ban đầu được ghép nối với 20 đoạn văn Wikipedia (chỉ một số ít trong số đó thực sự chứa câu trả lời, phần còn lại là các yếu tố gây mất tập trung). Bằng cách cắt giảm số lượng tài liệu từ 20 xuống chỉ còn 2–4 tài liệu thực sự có liên quan - và thêm vào đó một chút ngữ cảnh bổ sung để duy trì độ dài nhất quán - họ đã tạo ra các tình huống trong đó AI có ít tài liệu hơn để xem xét, nhưng vẫn có tổng số từ gần như nhau để đọc.

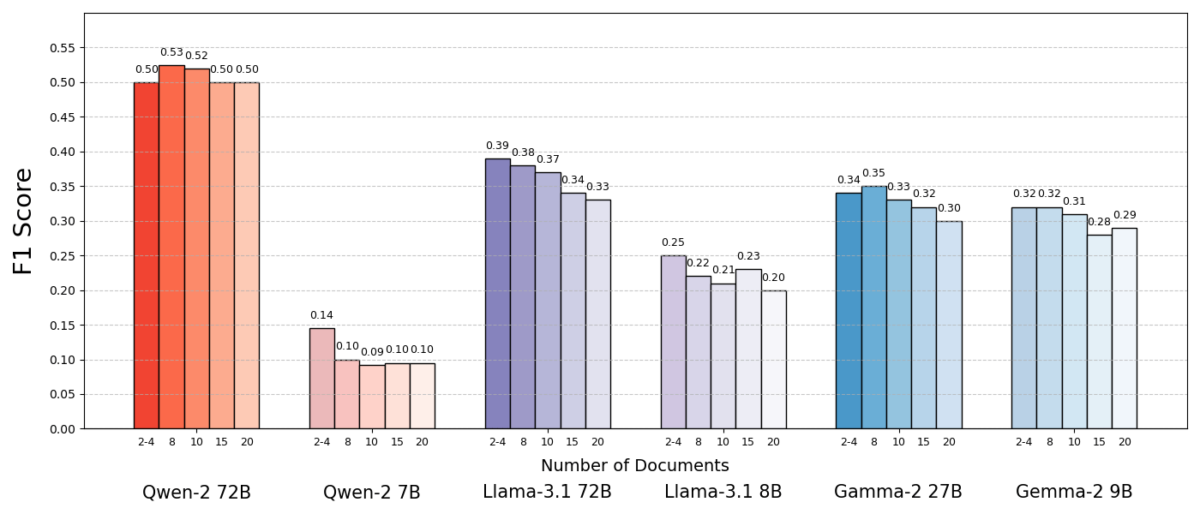

Kết quả thật đáng kinh ngạc. Trong hầu hết các trường hợp, các mô hình AI trả lời chính xác hơn khi chúng được cung cấp ít tài liệu hơn thay vì toàn bộ tập hợp. Hiệu suất được cải thiện đáng kể - trong một số trường hợp, độ chính xác lên đến 10% (điểm F1) khi hệ thống chỉ sử dụng một số ít tài liệu hỗ trợ thay vì một bộ sưu tập lớn. Sự gia tăng phản trực giác này đã được quan sát thấy trên một số mô hình ngôn ngữ nguồn mở khác nhau, bao gồm các biến thể của Llama của Meta và các biến thể khác, cho thấy hiện tượng này không liên quan đến một mô hình AI duy nhất.

Một mô hình (Qwen-2) là một ngoại lệ đáng chú ý khi xử lý nhiều tài liệu mà không làm giảm điểm, nhưng hầu như tất cả các mô hình được thử nghiệm đều hoạt động tốt hơn với ít tài liệu hơn. Nói cách khác, việc thêm nhiều tài liệu tham khảo ngoài các phần có liên quan chính thực sự làm giảm hiệu suất của chúng nhiều hơn là giúp ích.

Nguồn: Levy et al.

Tại sao điều này lại gây ngạc nhiên đến vậy? Thông thường, các hệ thống RAG được thiết kế theo giả định rằng việc truy xuất một lượng thông tin rộng hơn chỉ có thể giúp AI – xét cho cùng, nếu câu trả lời không nằm trong một vài tài liệu đầu tiên, thì có thể nằm trong tài liệu thứ mười hoặc thứ hai mươi.

Nghiên cứu này đảo ngược kịch bản đó, chứng minh rằng việc chồng chất thêm các tài liệu bổ sung một cách bừa bãi có thể phản tác dụng. Ngay cả khi tổng độ dài văn bản được giữ nguyên, thì sự hiện diện của nhiều tài liệu khác nhau (mỗi tài liệu có ngữ cảnh và đặc điểm riêng) khiến nhiệm vụ trả lời câu hỏi trở nên khó khăn hơn đối với AI. Có vẻ như sau một điểm nhất định, mỗi tài liệu bổ sung sẽ tạo ra nhiều nhiễu hơn là tín hiệu, gây nhầm lẫn cho mô hình và làm suy yếu khả năng trích xuất câu trả lời đúng của mô hình.

Tại sao ít có thể nhiều hơn trong RAG

Kết quả "ít hơn là nhiều hơn" này có ý nghĩa khi chúng ta xem xét cách các mô hình ngôn ngữ AI xử lý thông tin. Khi AI chỉ được cung cấp các tài liệu có liên quan nhất, bối cảnh mà nó nhìn thấy sẽ tập trung và không bị phân tâm, giống như một học sinh được giao đúng trang để học.

Trong nghiên cứu, các mô hình hoạt động tốt hơn đáng kể khi chỉ được cung cấp các tài liệu hỗ trợ, với các tài liệu không liên quan bị loại bỏ. Bối cảnh còn lại không chỉ ngắn hơn mà còn sạch hơn – nó chứa các sự kiện chỉ trực tiếp đến câu trả lời và không có gì khác. Với ít tài liệu hơn để xử lý, mô hình có thể dành toàn bộ sự chú ý của mình vào thông tin có liên quan, khiến nó ít có khả năng bị lạc hướng hoặc nhầm lẫn.

Mặt khác, khi nhiều tài liệu được thu thập, AI phải sàng lọc qua hỗn hợp nội dung có liên quan và không liên quan. Thông thường, những tài liệu bổ sung này "tương tự nhưng không liên quan" - chúng có thể chia sẻ một chủ đề hoặc từ khóa với truy vấn nhưng thực tế không chứa câu trả lời. Nội dung như vậy có thể gây hiểu lầm cho mô hình. AI có thể lãng phí công sức cố gắng kết nối các dấu chấm trên các tài liệu không thực sự dẫn đến câu trả lời đúng hoặc tệ hơn, nó có thể kết hợp thông tin từ nhiều nguồn không chính xác. Điều này làm tăng nguy cơ ảo giác - những trường hợp AI tạo ra một câu trả lời nghe có vẻ hợp lý nhưng không dựa trên bất kỳ nguồn nào.

Về bản chất, việc cung cấp quá nhiều tài liệu cho mô hình có thể làm loãng thông tin hữu ích và đưa ra các chi tiết mâu thuẫn, khiến AI khó xác định thông tin nào là đúng.

Điều thú vị là các nhà nghiên cứu phát hiện ra rằng nếu các tài liệu bổ sung rõ ràng là không liên quan (ví dụ, văn bản ngẫu nhiên không liên quan), thì các mô hình sẽ bỏ qua chúng tốt hơn. Rắc rối thực sự đến từ dữ liệu gây mất tập trung trông có vẻ liên quan: khi tất cả các văn bản được lấy về đều có chủ đề tương tự, AI cho rằng nó nên sử dụng tất cả chúng và có thể gặp khó khăn trong việc xác định chi tiết nào thực sự quan trọng. Điều này phù hợp với quan sát của nghiên cứu rằng những yếu tố gây mất tập trung ngẫu nhiên ít gây nhầm lẫn hơn những yếu tố gây mất tập trung thực tế trong đầu vào. AI có thể lọc ra những điều vô nghĩa trắng trợn, nhưng thông tin lạc đề tinh vi là một cái bẫy khéo léo – nó lẻn vào dưới vỏ bọc của sự liên quan và làm chệch hướng câu trả lời. Bằng cách giảm số lượng tài liệu xuống chỉ còn những tài liệu thực sự cần thiết, chúng ta tránh được việc đặt những cái bẫy này ngay từ đầu.

Ngoài ra còn có một lợi ích thực tế: việc truy xuất và xử lý ít tài liệu hơn sẽ làm giảm chi phí tính toán cho hệ thống RAG. Mọi tài liệu được đưa vào đều phải được phân tích (được nhúng, đọc và xử lý bởi mô hình), điều này sử dụng thời gian và tài nguyên tính toán. Việc loại bỏ các tài liệu thừa giúp hệ thống hiệu quả hơn – hệ thống có thể tìm ra câu trả lời nhanh hơn và với chi phí thấp hơn. Trong các tình huống mà độ chính xác được cải thiện bằng cách tập trung vào ít nguồn hơn, chúng ta sẽ có được chiến thắng đôi bên cùng có lợi: câu trả lời tốt hơn và quy trình tinh gọn hơn, hiệu quả hơn.

Nguồn: Levy et al.

Suy nghĩ lại về RAG: Hướng đi trong tương lai

Bằng chứng mới này cho thấy chất lượng thường đánh bại số lượng trong quá trình truy xuất có ý nghĩa quan trọng đối với tương lai của các hệ thống AI dựa vào kiến thức bên ngoài. Nó cho thấy rằng các nhà thiết kế hệ thống RAG nên ưu tiên lọc thông minh và xếp hạng các tài liệu hơn là khối lượng lớn. Thay vì tìm kiếm 100 đoạn văn có thể và hy vọng câu trả lời được chôn vùi ở đâu đó, có thể khôn ngoan hơn khi chỉ tìm kiếm một vài đoạn văn có liên quan cao nhất.

Các tác giả của nghiên cứu nhấn mạnh nhu cầu về các phương pháp truy xuất để "cân bằng giữa tính liên quan và tính đa dạng" trong thông tin mà họ cung cấp cho mô hình. Nói cách khác, chúng tôi muốn cung cấp đủ phạm vi bao phủ của chủ đề để trả lời câu hỏi, nhưng không quá nhiều đến mức các sự kiện cốt lõi bị chìm trong một biển văn bản không liên quan.

Tiến về phía trước, các nhà nghiên cứu có thể sẽ khám phá các kỹ thuật giúp các mô hình AI xử lý nhiều tài liệu một cách duyên dáng hơn. Một cách tiếp cận là phát triển các hệ thống truy xuất hoặc xếp hạng lại tốt hơn có thể xác định tài liệu nào thực sự mang lại giá trị và tài liệu nào chỉ gây ra xung đột. Một góc độ khác là cải thiện bản thân các mô hình ngôn ngữ: nếu một mô hình (như Qwen-2) có thể xử lý nhiều tài liệu mà không mất độ chính xác, thì việc kiểm tra cách nó được đào tạo hoặc cấu trúc có thể cung cấp manh mối để tạo ra các mô hình khác mạnh mẽ hơn. Có lẽ các mô hình ngôn ngữ lớn trong tương lai sẽ kết hợp các cơ chế để nhận ra khi hai nguồn nói cùng một điều (hoặc mâu thuẫn với nhau) và tập trung phù hợp. Mục tiêu là cho phép các mô hình sử dụng nhiều nguồn phong phú mà không bị nhầm lẫn - hiệu quả là tận dụng tối đa cả hai thế giới (thông tin rộng và trọng tâm rõ ràng).

Cũng đáng lưu ý rằng như Hệ thống AI có cửa sổ ngữ cảnh lớn hơn (khả năng đọc nhiều văn bản cùng một lúc), chỉ cần đổ nhiều dữ liệu hơn vào lời nhắc không phải là giải pháp hoàn hảo. Ngữ cảnh lớn hơn không tự động có nghĩa là hiểu tốt hơn. Nghiên cứu này cho thấy rằng ngay cả khi AI về mặt kỹ thuật có thể đọc 50 trang cùng một lúc, thì việc cung cấp cho nó 50 trang thông tin chất lượng hỗn hợp có thể không mang lại kết quả tốt. Mô hình vẫn được hưởng lợi từ việc có nội dung được quản lý, có liên quan để làm việc cùng, thay vì một bản sao không phân biệt. Trên thực tế, việc truy xuất thông minh có thể trở nên quan trọng hơn nữa trong kỷ nguyên của các cửa sổ ngữ cảnh khổng lồ - để đảm bảo dung lượng bổ sung được sử dụng cho kiến thức có giá trị thay vì nhiễu.

Những phát hiện từ “Nhiều tài liệu hơn, cùng độ dài” (bài báo có tiêu đề phù hợp) khuyến khích xem xét lại các giả định của chúng ta trong nghiên cứu AI. Đôi khi, việc cung cấp cho AI tất cả dữ liệu chúng ta có không hiệu quả như chúng ta nghĩ. Bằng cách tập trung vào các thông tin có liên quan nhất, chúng ta không chỉ cải thiện độ chính xác của các câu trả lời do AI tạo ra mà còn khiến hệ thống hiệu quả hơn và dễ tin cậy hơn. Đây là một bài học phản trực giác, nhưng lại có những hệ quả thú vị: các hệ thống RAG trong tương lai có thể vừa thông minh hơn vừa tinh gọn hơn bằng cách cẩn thận lựa chọn ít tài liệu tốt hơn để truy xuất.