Yapay Zeka

Web'den Toplanan Yapay Zeka Veri Kümeleri ve Gizlilik: CommonPool'a Neden Bir Göz Atmayı Hak Ediyor?

Yapay Zeka (AI) günlük yaşamın bir parçası haline geldi. Hastalara rehberlik eden tıbbi sohbet robotlarında ve sanatçılara, yazarlara ve geliştiricilere yardımcı olan üretken araçlarda bunu görmek mümkün. Bu sistemler gelişmiş görünse de, tek bir temel kaynağa, yani verilere dayanıyorlar.

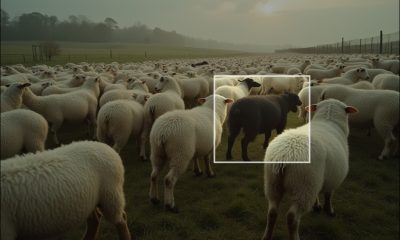

Yapay zeka sistemlerini eğitmek için kullanılan verilerin çoğu halka açık internetten gelir. Otomatik programlar, çevrimiçi platformlardan büyük miktarda metin, resim ve ses toplar. Bu koleksiyonlar, aşağıdakiler gibi bilinen modellerin temelini oluşturur: GPT 4, Kararlı Difüzyonve daha birçokları. Ancak bu geniş koleksiyon, gizlilik, mülkiyet ve bilgilendirilmiş onam konusunda çözümlenmemiş endişeleri gündeme getiriyor.

Eğitim veri kümeleri pazarı, bu faaliyetin ölçeğini yansıtmaktadır. Şu an itibarıyla, yapay zeka veri kümelerinin küresel değerinin şu şekilde tahmin edildiği tahmin edilmektedir: 3.2 milyar dolar. Tahminlere göre, 16.3 yılına kadar yıllık %2034 büyüme oranıyla 20.5 milyar dolara ulaşabilir. Bu rakamların ardında önemli bir zorluk yatıyor. Toplanan materyalin önemli bir kısmı açık izin olmadan elde ediliyor. Genellikle kişisel veriler, telif hakkıyla korunan eserler ve makine öğrenimi sistemleri için asla tasarlanmamış diğer hassas içerikler içeriyor.

Bu sorunlara yanıt olarak, veri yönetimine yönelik alternatif yaklaşımlar araştırılıyor. Bir örnek: Ortak Havuz, Nisan 2023'te piyasaya sürüldü VeriBilgisi kıyaslama. 12.8 milyar resim-metin çiftinden oluşan büyük bir veri kümesidir çok modlu yapay zeka Geleneksel veri toplama çalışmalarından farklı olarak, filtreleme yöntemleri uygular, şeffaflığı vurgular ve geliştirilmesinde topluluk katılımını dikkate alır. Tartışmaya açık olsa da CommonPool, yapay zeka eğitim verileri için daha sorumlu ve denetlenebilir uygulamalar geliştirme çabasını göstermektedir. Bu tür girişimler, yapay zekanın geleceğinde etik standartlara duyulan ihtiyacı vurgulamaktadır.

Yapay Zekanın Geliştirilmesinde Web'den Toplanan Verilerin Rolü

Veri, yapay zekânın merkezinde yer alır ve sistem performansı, eğitim için mevcut bilgi miktarı ve çeşitliliğiyle yakından bağlantılıdır. Son yıllarda, web kazıma, büyük veri kümelerini büyük ölçekte bir araya getirmek için standart bir yöntem haline gelmiştir. Araştırmacılar ve geliştiriciler, herkese açık çevrimiçi içerik toplayarak geniş ve çeşitli veri kaynakları elde etmişlerdir.

Popüler bir örnek Ortak Tarama2025 yılına kadar, her biri 250 terabayttan fazla olan aylık taramalar yoluyla toplanan petabaytlarca metni depolayan LAION-5B, metin tabanlı yapay zeka modellerinin eğitimi için yaygın olarak kullanılmaktadır. Bir diğer örnek ise, yaklaşık 5.85 milyar resim-metin çifti içeren LAION-XNUMXB'dir. Yazılı komutlardan gerçekçi görüntüler oluşturabilen Stable Diffusion gibi uygulamalar için önemli olmuştur.

Bu veri kümeleri, model doğruluğunu artırdıkları, çeşitli içerikler aracılığıyla genellemeyi iyileştirdikleri ve üniversiteler de dahil olmak üzere daha küçük grupların yapay zeka geliştirme sürecine katılmalarına olanak sağladıkları için değerlidir. Stanford Yapay Zeka Endeksi 2025, çoğu gelişmiş modelin hâlâ kazınmış verilere dayandığını ve veri kümelerinin hızla büyüdüğünü göstermektedir. Bu talep, XNUMX milyon doları aşan yoğun yatırımları da beraberinde getirmiştir. 57 milyar dolar 2024 yılında veri merkezleri ve bilgi işlem gücü için.

Aynı zamanda, web kazıma da zorluklardan muaf değildir. Toplanan içeriğin büyük bir kısmı başlangıçta makine kullanımı için oluşturulmadığından, gizlilik, mülkiyet ve yasal haklar konusunda sorular ortaya çıkarmaktadır. Mahkeme kararları ve politika tartışmaları, bu zorlukların giderek daha acil hale geldiğini göstermektedir. Yapay zeka veri toplamanın geleceği, ilerleme ve etik sorumluluk arasında bir denge kurulmasına bağlı olacaktır.

Kazınmış Verilerle İlgili Gizlilik Sorunu

Web tarama araçları, genel içerik ile hassas ayrıntılar arasında net bir ayrım yapmadan bilgi toplar. Metin ve görsellerin yanı sıra, genellikle adlar, e-posta adresleri ve yüz fotoğrafları gibi Kişisel Tanımlayıcı Bilgileri (PII) de yakalarlar.

An denetim Temmuz 2025'te CommonPool veri setinin incelenmesi, filtrelemeden sonra bile örneklerin %0.1'inin hala tanımlanabilir yüzler, resmi kimlikler ve özgeçmiş ve pasaport gibi belgeler içerdiğini ortaya koydu. Bu oran küçük görünse de, milyarlarca kayıt ölçeğinde, yüz milyonlarca etkilenen birey anlamına geliyor. İncelemeler ve güvenlik denetimleri, bu tür materyallerin varlığının olağandışı olmadığını ve riskleri arasında kimlik hırsızlığı, hedefli taciz ve özel verilerin istenmeyen şekilde ifşa edilmesinin bulunduğunu doğruluyor.

Veri sahipliği ve makul kullanımla ilgili endişeler mahkemelere taşındıkça, hukuki anlaşmazlıklar da artıyor. 2023 ve 2024 yılları arasında, aşağıdaki gibi şirketler: OpenAI ve Stability AI davalarla karşı karşıya kaldı Kişisel ve telif hakkıyla korunan verileri izinsiz kullanmaktan dolayı. Şubat 2025'te, ABD federal mahkemesi karar verdi Yapay zekanın lisanssız kişisel bilgiler üzerinde eğitilmesinin ihlal olarak sayılacağı. Bu karar, daha fazla toplu dava açılmasını teşvik etti. Telif hakkı da bir diğer önemli sorun. Toplanan birçok veri kümesi kitap, makale, sanat eseri ve kod içeriyor. Yazarlar ve sanatçılar, eserlerinin onay veya ödeme olmadan kullanıldığını iddia ediyor. Devam eden New York Times - OpenAI davası, yapay zeka sistemlerinin korunan içeriği hukuka aykırı olarak çoğaltıp çoğaltmadığını sorguluyor. Görsel sanatçılar da yapay zekanın kendi tarzlarını kopyaladığını iddia ederek benzer şikayetlerde bulundu. Haziran 2025'te bir ABD mahkemesi, adil kullanım kapsamında bir yapay zeka şirketini destekledi, ancak uzmanlar kararların tutarsız olduğunu ve yasal çerçevenin hala belirsiz olduğunu söylüyor.

Yapay zeka eğitiminde onay eksikliği, kamuoyunun güvenini zayıflattı. Birçok kişi, bloglarının, yaratıcı çalışmalarının veya kodlarının bilgileri dışında veri kümelerine dahil edildiğini fark etti. Bu durum, etik endişelere ve daha fazla şeffaflık talebine yol açtı. Buna karşılık, hükümetler, yapay zeka modellerinin adil geliştirilmesini ve verilerin dikkatli kullanımını teşvik eden yasalar aracılığıyla daha sıkı bir denetime doğru ilerliyor.

Kazınan Veri Kümelerinin Değiştirilmesi Neden Zordur?

Gizlilik ve onay konusundaki endişelere rağmen, yapay zeka eğitimi için veri kümeleri hala gerekli. Bunun nedeni ölçek. Modern yapay zeka modelleri, metin, görsel ve diğer medyalardan trilyonlarca token gerektirir. Bu tür veri kümelerini yalnızca lisanslı veya düzenlenmiş kaynaklar aracılığıyla oluşturmak yüz milyonlarca dolara mal olur. Bu, çoğu girişim veya üniversite için pratik değildir.

Yüksek maliyet, derlenmiş veri kümelerinin tek zorluğu değildir. Genellikle çeşitlilikten yoksundurlar ve belirli dillere, bölgelere veya topluluklara odaklanma eğilimindedirler. Bu dar kapsam, yapay zeka modellerini daha az dengeli hale getirir. Buna karşılık, toplanan veriler, gürültülü ve kusurlu olmasına rağmen, daha geniş bir kültür, konu ve bakış açısı yelpazesini yakalar. Bu çeşitlilik, yapay zeka sistemlerinin gerçek dünyada kullanıldığında daha iyi performans göstermesini sağlar.

Ancak risk, katı düzenlemelerin toplanan verilere erişimi kısıtlamasıdır. Bu gerçekleşirse, daha küçük kuruluşlar rekabette zorlanabilir. Google veya Meta gibi özel veya tescilli veri kümelerine sahip büyük şirketler ilerlemeye devam edecektir. Bu dengesizlik rekabeti azaltabilir ve yapay zekada açık inovasyonu yavaşlatabilir.

Şimdilik, toplanan veri kümeleri yapay zeka araştırmalarının merkezinde yer alıyor. Aynı zamanda, CommonPool gibi projeler kapsamlı ve etik kaynaklı koleksiyonlar oluşturmanın yollarını araştırıyor. Bu çabalar, yapay zeka ekosistemini daha açık, adil ve sorumlu tutmak için gerekli.

CommonPool: Sorumlu Büyük Ölçekli Veri Mühendisliğine Doğru

CommonPool, açık ve büyük ölçekli çok modlu bir veri kümesi oluşturmaya yönelik teknik açıdan en iddialı girişimlerden biridir. Yaklaşık olarak 12.8 milyar Görüntü-metin çiftleri, LAION-5B'nin ölçeğiyle eşleşirken, daha güçlü veri mühendisliği ve yönetişim mekanizmalarını da entegre ediyor. Temel tasarım hedefi yalnızca ölçeği en üst düzeye çıkarmak değil, aynı zamanda yeniden üretilebilirlik, veri kaynağı ve yasal düzenlemelere uyum ilkeleriyle de uyumlu olmaktı.

CommonPool veri kümesinin oluşturulması, yapılandırılmış üç aşamalı bir işlem hattını takip eder. İlk aşama, 2014 ve 2022 yılları arasında toplanan Common Crawl anlık görüntülerinden ham örneklerin çıkarılmasını içerir. Hem görseller hem de başlıklar veya çevreleyen pasajlar gibi ilişkili metinler toplanır. Anlamsal uyumu değerlendirmek için, bakımcılar CLIP tabanlı benzerlik puanlaması uygulayarak, görsel ve metin yerleştirmeleri arasında zayıf uyum olan çiftleri atar. Bu erken filtreleme adımı, basit veri toplama işlem hatlarına kıyasla gürültüyü önemli ölçüde azaltır.

İkinci aşamada, veri kümesi büyük ölçekli veri tekrarlarından arındırılır. Algısal karma ve MinHash teknikleri, neredeyse aynı olan görüntüleri belirleyip kaldırmak ve gereksiz tekrarların model eğitimine hakim olmasını önlemek için kullanılır. Bozuk dosyaları, bozuk bağlantıları ve düşük çözünürlüklü görüntüleri hariç tutmak için ek filtreler uygulanır. Bu aşamada, veri hattı metin normalizasyonu ve otomatik dil tanımlamayı da içerir ve hedeflenen araştırmalar için alan veya dil özelinde alt kümelerin oluşturulmasını sağlar.

Üçüncü aşama, güvenlik ve uyumluluğa odaklanır. Otomatik yüz algılama ve bulanıklaştırma uygulanırken, çocuklara ait görüntüler ve adlar, e-posta adresleri ve posta adresleri gibi kişisel tanımlayıcılar kaldırılır. Süreç ayrıca telif hakkıyla korunan materyalleri de tespit etmeye çalışır. Hiçbir otomatik yöntem web ölçeğinde mükemmel filtrelemeyi garanti edemese de, bu güvenlik önlemleri, filtrelemenin çoğunlukla yetişkinlere yönelik içerik ve toksisite tespitleriyle sınırlı olduğu LAION-5B'ye kıyasla önemli bir teknik gelişmeyi temsil eder.

CommonPool, veri işlemenin ötesinde, onu statik veri kümesi sürümlerinden ayıran bir yönetişim modeli sunar. Sürümlenmiş sürümler, yapılandırılmış meta veriler ve belgelenmiş güncelleme döngüleri ile canlı bir veri kümesi olarak tutulur. Her örnek, mevcut olduğunda lisans bilgilerini içerir ve telif hakkı düzenlemelerine uyumu destekler. Kaldırma protokolü, bireylerin ve kurumların hassas içeriklerin kaldırılmasını talep etmelerine olanak tanır ve AB Yapay Zeka Yasası ve ilgili düzenleyici çerçeveler tarafından dile getirilen endişeleri giderir. Kaynak URL'leri ve filtreleme puanları gibi meta veriler, şeffaflığı ve yeniden üretilebilirliği artırarak araştırmacıların dahil etme ve hariç tutma kararlarını izlemelerine olanak tanır.

DataComp girişiminin kıyaslama sonuçları, bu tasarım tercihlerinin teknik etkilerini göstermektedir. LAION-5B ve CommonPool üzerinde aynı görüntü-dil mimarileri eğitildiğinde, CommonPool, özellikle ince ayrıntılı veri alma ve sıfır-atış sınıflandırma görevlerinde daha kararlı bir akış performansına sahip modeller üretmiştir. Bu sonuçlar, CommonPool'un daha yüksek hizalama kalitesinin, daha az filtrelenmiş veri kümelerinin bazı ölçek avantajlarını telafi ettiğini göstermektedir. Bununla birlikte, 2025'teki bağımsız denetimler, kalıcı riskleri ortaya koymuştur: veri kümesinin yaklaşık %0.1'i hala bulanıklaştırılmamış yüzler, hassas kişisel belgeler ve tıbbi kayıtlar içermektedir. Bu durum, en son teknoloji ürünü otomatik filtreleme sistemlerinin bile sınırlarını ortaya koymaktadır.

Genel olarak CommonPool, veri kümesi mühendisliğinde ham ölçeğe öncelik vermekten ölçek, kalite ve uyumluluğu dengelemeye doğru bir geçişi temsil eder. Araştırmacılar için, büyük ölçekli ön eğitimler için tekrarlanabilir ve nispeten daha güvenli bir temel sağlar. Düzenleyiciler içinse, gizlilik ve hesap verebilirlik mekanizmalarının doğrudan veri kümesi oluşturmaya entegre edilebileceğini gösterir. LAION'un aksine, CommonPool, filtreleme kanallarının, yönetişim uygulamalarının ve kıyaslama çerçevelerinin, büyük ölçekli web verilerini çok modlu yapay zeka için teknik açıdan daha sağlam ve etik açıdan daha sorumlu bir kaynağa nasıl dönüştürebileceğini gösterir.

CommonPool'u Geleneksel Web'den Toplanan Veri Kümeleriyle Karşılaştırma

LAION-5B ( gibi daha önceki büyük ölçekli web kazınmış veri kümelerinin aksine5.85 milyar numune), COYO-700M (700 milyon örnek), ve WebLI (400 milyon örnek), CommonPool yapı, yeniden üretilebilirlik ve yönetişime önem verir. İzlenebilirliği ve kısmi lisanslama kontrollerini destekleyen URL'ler ve zaman damgaları gibi meta verileri korur. Ayrıca, düşük kaliteli veya zayıf hizalanmış resim-metin çiftlerini kaldırmak için CLIP tabanlı anlamsal filtreleme uygulayarak veri kalitesini artırır.

Karşılaştırıldığında, LAION-5B ve COYO, sınırlı filtreleme ve ayrıntılı lisanslama dokümantasyonu olmadan Common Crawl'dan derlenmiştir. Bu veri kümeleri genellikle tıbbi kayıtlar, kimlik belgeleri ve bulanıklaştırılmamış yüzler gibi hassas materyaller içerir. OpenAI tarafından dahili olarak kullanılan WebLI da şeffaflıktan yoksundur, çünkü harici inceleme veya çoğaltma için hiçbir zaman yayınlanmamıştır.

CommonPool, tam kullanıcı onayının henüz çözümlenmediğini kabul ederken, kişisel olarak tanımlanabilir bilgileri (PII) ve uygunsuz içerikleri hariç tutarak bu sorunları ele almayı amaçlamaktadır. Bu, onu önceki alternatiflere kıyasla nispeten daha güvenilir ve etik açıdan uyumlu kılmaktadır.

Alt çizgi

CommonPool'un geliştirilmesi, büyük ölçekli yapay zeka veri kümelerinin nasıl tasarlanıp yönetildiği konusunda önemli bir geçişi yansıtmaktadır. LAION-5B ve COYO gibi önceki koleksiyonlar sınırlı denetimle ölçeğe öncelik verirken, CommonPool şeffaflık, filtreleme ve yönetişimin araştırma için kullanılabilirliği tehlikeye atmadan veri kümesi oluşturmaya entegre edilebileceğini göstermektedir.

Meta verileri koruyarak, anlamsal uyum kontrolleri uygulayarak ve gizlilik önlemlerini entegre ederek, daha tekrarlanabilir ve hesap verebilir bir kaynak sunar. Aynı zamanda, bağımsız denetimler, otomatik güvenlik önlemlerinin riskleri tamamen ortadan kaldıramayacağını hatırlatarak, sürekli tetikte olma ihtiyacını vurgular.