Hızlı Mühendislik

Yüksek Lisans İnce Ayarını Anlamak: Büyük Dil Modellerini Benzersiz Gereksinimlerinize Göre Uyarlamak

Eylül 2023'te bulunduğumuz Büyük Dil Modelleri (LLM'ler) manzarası hâlâ Alpaka, Falcon, Llama 2, GPT-4 ve diğerleri.

Bu LLM'lerin potansiyelinden yararlanmanın önemli bir yönü, önceden eğitilmiş modellerin belirli görevleri hassasiyetle karşılayacak şekilde özelleştirilmesine olanak tanıyan bir strateji olan ince ayar sürecinde yatmaktadır. Bu ince ayar sayesinde bu modeller, hem yenilikçi hem de benzersiz ihtiyaçlara göre uyarlanmış çözümler sunarak kişiselleştirilmiş gereksinimlere gerçek anlamda uyum sağlayabilir.

Ancak, tüm ince ayar yollarının eşit yaratılmadığına dikkat etmek önemlidir. Örneğin, GPT-4'ün ince ayar yeteneklerine erişmenin bir bedeli var ve piyasada mevcut diğer seçeneklerle karşılaştırıldığında nispeten daha pahalı olan ücretli bir abonelik gerektiriyor. Öte yandan açık kaynak alanı, büyük dil modellerinin gücünden yararlanmaya yönelik daha erişilebilir bir yol sunan alternatiflerle dolup taşıyor. Bu açık kaynak seçenekleri, gelişmiş yapay zeka teknolojisine erişimi demokratikleştirerek hızla gelişen yapay zeka ortamında yenilikçiliği ve kapsayıcılığı teşvik ediyor.

LLM'de ince ayar yapılması neden önemlidir?

Yüksek Lisans ince ayarı teknik bir geliştirmeden daha fazlasıdır; Çeşitli görevlerde daha spesifik ve rafine bir uygulamaya olanak tanıyan LLM model geliştirmenin çok önemli bir yönüdür. İnce ayar, önceden eğitilmiş modelleri belirli veri kümelerine daha iyi uyacak şekilde ayarlar, belirli görevlerde performanslarını artırır ve daha hedefe yönelik bir uygulama sağlar. Yapay zeka uygulamalarına giderek artan ilgide hayati önem taşıyan esnekliği sergileyerek, Yüksek Lisans'ların yeni verilere uyum sağlama konusundaki olağanüstü yeteneğini ortaya çıkarıyor.

Büyük dil modellerine ince ayar yapmak birçok fırsatın önünü açarak duygu analizinden tıbbi literatür incelemelerine kadar belirli görevlerde başarılı olmalarına olanak tanır. Temel modeli belirli bir kullanım durumuna göre ayarlayarak yeni olanakların kilidini açar, modelin verimliliğini ve doğruluğunu artırırız. Üstelik, ince ayar, bir modeli sıfırdan eğitmeye kıyasla daha az hesaplama gücü gerektirdiğinden, sistem kaynaklarının daha ekonomik kullanımını kolaylaştırır.

Bu kılavuzun derinliklerine indikçe, LLM'de ince ayarların inceliklerini tartışacağız ve size bu alandaki en son gelişmelere ve en iyi uygulamalara dayanan kapsamlı bir genel bakış sunacağız.

Talimat Tabanlı İnce Ayar

İnce ayar aşaması üretken yapay zeka Aşağıdaki şekilde gösterilen yaşam döngüsü, adım adım akıl yürütme örnekleriyle birlikte talimat giriş ve çıkışlarının entegrasyonuyla karakterize edilir. Bu yaklaşım, modelin yalnızca ilgili değil, aynı zamanda kendisine beslenen spesifik talimatlarla tam olarak hizalanmış yanıtlar üretmesini kolaylaştırır. Bu aşamada, önceden eğitilmiş modeller, işlevselliklerini geliştirmek için kişiselleştirilmiş veri kümeleri kullanılarak farklı görevleri çözmek ve kullanım durumlarını çözmek üzere uyarlanır.

Tek Görevli İnce Ayar

Tek görevde ince ayar, modelin özetleme gibi belirli bir görevdeki uzmanlığını geliştirmeye odaklanır. Bu yaklaşım, yasal belgeler ve müşteri destek bildirimleri de dahil olmak üzere önemli belgeleri veya konuşma dizilerini içeren iş akışlarının optimize edilmesinde özellikle faydalıdır. Dikkat çekici bir şekilde, bu ince ayar, eğitim öncesi aşamada kullanılan milyarlarca jetonun aksine, 500 ila 1000 arasında değişen nispeten küçük bir örnek seti ile önemli performans iyileştirmeleri sağlayabilir.

LLM İnce Ayarının Temelleri LLM: Transformer Mimarisi ve Ötesi

LLM'nin ince ayarını anlama yolculuğu, LLM'leri oluşturan temel unsurların anlaşılmasıyla başlar. Bu modellerin temelinde transformatör mimarisi, kelimelerin bağlamını cümledeki yakınlıklarına göre önceliklendirmek için kişisel dikkat mekanizmalarından yararlanan bir sinir ağı. Bu yenilikçi yaklaşım, girdideki tokenlar arasındaki uzak ilişkilerin daha derinlemesine anlaşılmasını kolaylaştırır.

Transformatörlerin inceliklerini incelerken, enkoderden başlayan çok adımlı bir süreçle karşılaşıyoruz. Bu ilk aşama, girdinin simgeleştirilmesini ve girdiyi ve onun cümle içindeki konumunu temsil eden yerleştirme vektörlerinin oluşturulmasını içerir. Sonraki aşamalar, olarak bilinen matrisleri kullanan bir dizi hesaplamayı içerir. Sorgu, Özellik, ve anahtar, cümlenin farklı bölümlerine ve çeşitli belirteçlere odaklanmayı belirleyen bir kişisel dikkat puanıyla sonuçlanır.

İnce ayar, LLM'lerin geliştirilmesinde kritik bir aşama olarak duruyor; bu süreç, daha arzu edilen çıktılar elde etmek için ince ayarlamalar yapılmasını gerektiren bir süreçtir. Bu aşama, her ne kadar önemli olsa da, çok sayıda parametrenin işlenmesinden kaynaklanan hesaplama ve depolama talepleri de dahil olmak üzere bir dizi zorluğu beraberinde getirir. Parametre Verimli İnce Ayarı (PEFT), ince ayarı yapılacak parametrelerin sayısını azaltan teknikler sunarak eğitim sürecini basitleştirir.

LLM Ön Eğitimi: Güçlü Bir Temel Oluşturmak

LLM gelişiminin ilk aşamalarında, temel mimari olarak aşırı parametreli transformatörler kullanılarak ön eğitim merkezde yer alır. Bu süreç, doğal dilin çift yönlü, otoregresif veya büyük ölçekli denetimsiz bütünceler üzerinde diziden diziye gibi çeşitli şekillerde modellenmesini içerir. Buradaki amaç, göreve özgü hedeflerin tanıtılması yoluyla daha sonra belirli alt görevler için ince ayar yapılabilecek bir temel oluşturmaktır.

Bu alanda dikkate değer bir eğilim, parametre sayısıyla ölçülen, önceden eğitilmiş LLM'lerin ölçeğindeki kaçınılmaz artıştır. Ampirik veriler sürekli olarak daha büyük modellerin daha fazla veriyle birleştiğinde neredeyse her zaman daha iyi performans sağladığını göstermektedir. Örneğin, 3 milyar parametresiyle GPT-175, yüksek kaliteli doğal dil oluşturma ve çok çeşitli sıfır atışlı görevleri yetkin bir şekilde gerçekleştirme konusunda bir referans noktası oluşturdu.

İnce Ayar: Model Uyarlamasına Giden Yol

Ön eğitimin ardından LLM, belirli görevlere uyum sağlamak için ince ayardan geçer. GPT-3 gibi önceden eğitilmiş LLM'lerde bağlam içi öğrenmenin gösterdiği umut verici performansa rağmen, göreve özgü ortamlarda ince ayar üstün olmaya devam ediyor. Bununla birlikte, tam parametre ince ayarının yaygın yaklaşımı, özellikle büyük ölçekli modellerle uğraşırken, yüksek hesaplama ve bellek talepleri de dahil olmak üzere zorluklar ortaya çıkarmaktadır.

Bir milyarın üzerinde parametreye sahip büyük dil modelleri için GPU RAM'in verimli yönetimi çok önemlidir. Tam 32 bit hassasiyette tek bir model parametresi, 4 baytlık alan gerektirir; bu, yalnızca 4 milyar parametreli bir modeli yüklemek için 1 GB GPU RAM gereksinimi anlamına gelir. Gerçek eğitim süreci, optimizer durumları ve eğimler de dahil olmak üzere çeşitli bileşenleri barındırmak için daha fazla bellek gerektirir ve bu ölçekte bir model için potansiyel olarak 80 GB'a kadar GPU RAM gerektirir.

GPU RAM'in sınırlamalarını aşmak için model parametrelerinin kesinliğini azaltan ve dolayısıyla bellek gereksinimlerini azaltan bir teknik olan niceleme kullanılır. Örneğin, hassasiyeti 32 bitten 16 bit'e değiştirmek, modeli yüklemek ve eğitmek için gereken belleği yarıya indirebilir. Daha sonra bu makalede. Ayarlama için niceleme kavramını kullanan Qlora'yı öğreneceğiz.

PEFT Yöntemlerinin Kategorilerini Keşfetmek

Büyük Dil Modellerine tamamen ince ayar yapma sürecinde, yalnızca en gelişmiş modeller için artık yüzlerce gigabayt boyutlara ulaşan önemli model ağırlıklarını verimli bir şekilde yönetebilecek değil, aynı zamanda yönetebilecek bir hesaplama düzenine sahip olmak önemlidir. bir dizi başka kritik unsur. Bunlar, optimize edici durumlar için hafıza tahsisini, gradyanları yönetmeyi, ileri aktivasyonları ve eğitim prosedürünün çeşitli aşamaları sırasında geçici hafızayı kolaylaştırmayı içerir.

Katkı Yöntemi

Bu tür ayarlama, yalnızca yeni eklenen parametrelerin eğitimine odaklanarak, önceden eğitilmiş modeli ek parametreler veya katmanlarla güçlendirebilir. Parametre sayısını artırmasına rağmen bu yöntemler eğitim süresini ve alan verimliliğini artırır. Eklemeli yöntem ayrıca alt kategorilere ayrılmıştır:

- Adaptörler: Tamamen bağlı küçük ağların trafo alt katmanlarının birleştirilmesi; dikkate değer örnekler AdaMix, KronAve Kompaktör.

- Yumuşak İstemler: Modelin giriş yerleştirmelerinin bir bölümüne degrade iniş yoluyla ince ayar yapma IPT, önek ayarıve WARP öne çıkan örneklerdir.

- Diğer Eklemeli Yaklaşımlar: LeTS, AttentionFusion ve Ladder-Side Tuning gibi teknikleri içerir.

Seçici Yöntem

Seçici PEFT'ler, katman türüne ve dahili model yapısına bağlı olarak sınırlı sayıda üst katmana ince ayar yapar. Bu kategori aşağıdaki gibi yöntemleri içerir: BitFit ve LN Model önyargıları veya belirli satırlar gibi belirli öğelerin ayarlanmasına odaklanan ayarlama.

Yeniden Parametrizasyona Dayalı Yöntem

Bu yöntemler, eğitilebilir parametrelerin sayısını azaltmak için düşük dereceli temsilleri kullanır; en ünlüsü Düşük Sıralı Uyarlama veya LoRA'dır. Bu yöntem, ağırlık güncellemesini parametreleştirmek için basit bir düşük dereceli matris ayrıştırmasından yararlanır ve düşük dereceli alt uzaylarda etkili ince ayar gösterir.

1) LoRA (Düşük Dereceli Uyarlama)

LoRA, çığır açan bir PEFT tekniği olarak ortaya çıktı ve bir makalede tanıtıldı. Edward J. Hu ve diğerleri, 2021'de. Yeniden parametrelendirme kategorisinde faaliyet göstererek LLM'nin orijinal ağırlıklarını dondurur ve yeni eğitilebilir düşük dereceli matrisleri Transformer mimarisinin her katmanına entegre eder. Bu yaklaşım yalnızca eğitilebilir parametrelerin sayısını azaltmakla kalmaz, aynı zamanda gerekli eğitim süresini ve hesaplama kaynaklarını da azaltır, böylece tam ince ayara daha verimli bir alternatif sunar.

LoRA'nın mekaniğini anlamak için, giriş isteminin tokenizasyona uğradığı ve gömme vektörlere dönüştürüldüğü transformatör mimarisini yeniden ziyaret etmek gerekir. Bu vektörler, transformatörün kodlayıcı ve/veya kod çözücü bölümleri boyunca geçerek, ağırlıkları önceden eğitilmiş öz-dikkat ve ileri besleme ağlarıyla karşılaşır.

LoRA şu kavramı kullanır: Tekil Değer Ayrışımı (SVD). Temel olarak SVD, bir matrisi üç farklı matrise ayırır; bunlardan biri tekil değerleri barındıran köşegen bir matristir. Bu tekil değerler, matrislerdeki farklı boyutların önemini ölçtüğü için çok önemlidir; daha büyük değerler daha yüksek önemi belirtirken, daha küçük değerler daha az önemi ifade eder.

Bu yaklaşım, LoRA'nın boyutluluğu azaltırken verinin temel özelliklerini korumasına olanak tanır, dolayısıyla ince ayar sürecini optimize eder.

LoRA bu sürece müdahale ederek tüm orijinal model parametrelerini dondurur ve orijinal ağırlıkların yanında bir çift "derece ayrıştırma matrisi" sunar. A ve B olarak gösterilen bu daha küçük matrisler denetimli öğrenme yoluyla eğitime tabi tutulur.

Bu stratejideki en önemli unsur, düşük dereceli matrislerin boyutunu belirleyen, rütbe ('r') adı verilen parametredir. Titiz bir 'r' seçimi, daha küçük bir değerle bile etkileyici sonuçlar verebilir, böylece eğitilecek daha az parametreye sahip düşük dereceli bir matris yaratılabilir. Bu strateji, HuggingFace Transformers gibi açık kaynak kitaplıklar kullanılarak etkili bir şekilde uygulandı ve LoRA'nın çeşitli görevler için dikkate değer bir verimlilikle ince ayar yapmasını kolaylaştırdı.

2) QLoRA: LoRA Verimliliğini Daha Yükseklere Çıkarmak

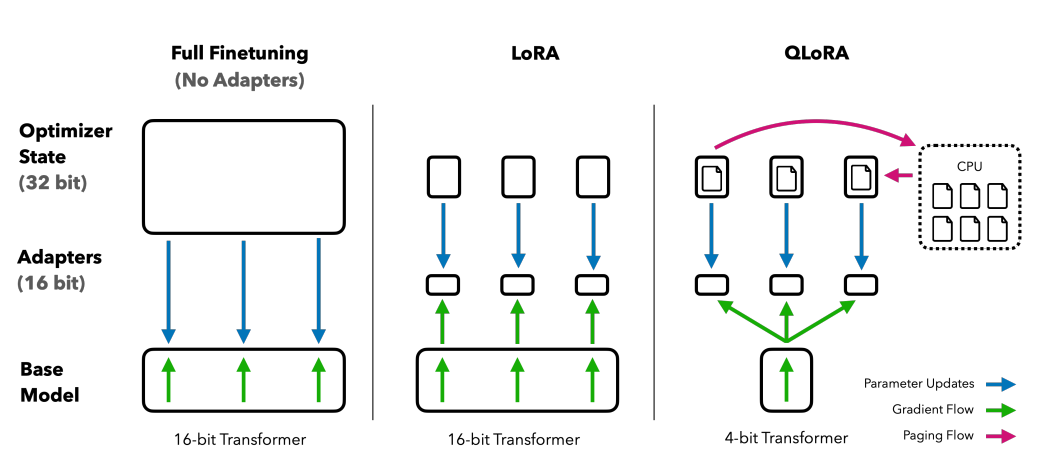

LoRA'nın attığı temel üzerine inşa edilen QLoRA, bellek gereksinimlerini daha da azaltır. Tarafından tanıtıldı 2023'te Tim Dettmers ve diğerleriolarak adlandırılan 4 bitlik bir niceleme formatı kullanarak, düşük dereceli uyarlamayı niceleme ile birleştirir. NormalKamanma or nf4. Niceleme esas olarak verileri daha yüksek bilgi içeren bir temsilden daha az bilgi içeren bir temsile geçiren bir süreçtir. Bu yaklaşım, hesaplama işlemleri sırasında gerektiği gibi 16 bitlik ağırlıkları 4 bit'e indirgeyerek 16 bitlik ince ayar yöntemlerinin etkinliğini korur.

İnce ayar yöntemlerinin karşılaştırılması: QLORA, LoRA'yı 4 bit hassas niceleme ve bellek artışı yönetimi için sayfalanmış optimize edicilerle geliştirir

QLoRA, transformatör mimarisindeki her katmanı hedef alan NumericFloat4'ten (nf4) yararlanır ve ince ayar için gereken bellek alanını daha da küçültmek üzere çift niceleme kavramını sunar. Bu, halihazırda nicelenmiş sabitler üzerinde niceleme gerçekleştirilerek elde edilir; bu strateji, disk belleği optimize edicilerin ve birleştirilmiş bellek yönetiminin kullanımı yoluyla tipik gradyan kontrol noktası bellek artışlarını önleyen bir stratejidir.

GuanakoQLORA ayarlı bir topluluk olan , açık kaynaklı sohbet robotu çözümlerinde bir referans noktası belirliyor. Sistematik insan ve otomatik değerlendirmelerle doğrulanan performansı, sahadaki hakimiyetini ve verimliliğini vurguluyor.

Guanaco'nun 65B ve 33B versiyonları, Guanaco'nun değiştirilmiş bir versiyonu kullanılarak ince ayarlanmıştır. OASST1 veri kümesi, aşağıdaki gibi ünlü modellere zorlu rakipler olarak ortaya çıkıyor: ChatGPT ve hatta GPT-4.

İnsan Geri Bildiriminden Takviyeli Öğrenmeyi kullanarak ince ayar yapma

İnsan Geri Bildiriminden Takviyeli Öğrenme (RLHF), önceden eğitilmiş dil modellerinin insan değerlerine daha yakın olacak şekilde ince ayarının yapılması sırasında devreye girer. Bu konsept, 2017 yılında Open AI tarafından tanıtıldı ve gelişmiş belge özetleme ve geliştirmenin temelini oluşturdu. talimatGPT.

RLHF'nin temelinde, bir tür makine öğrenimi tekniği olan takviyeli öğrenme paradigması bulunur. ajan nasıl davranması gerektiğini öğrenir çevre yaparak eylemler ve almak ödülleri. Bu sürekli bir döngü aksiyon ve geribeslemeTemsilcinin en yüksek ödülü sağlayacak seçimler yapmaya teşvik edildiği yer.

Bunu dil modelleri alanına tercüme edersek, ajan olduğunu model kendisi bünyesinde faaliyet gösteren çevre Belirli bir bağlam penceresinin kullanılması ve buna göre kararlar alınması belirtmek, bildirmek, bağlam penceresindeki geçerli belirteçler tarafından tanımlanır. “aksiyon alanı”, modelin seçebileceği tüm potansiyel tokenları kapsar; amaç, insan tercihlerine en yakın tokenı seçmektir.

RLHF süreci, insan geri bildirimlerinden kapsamlı bir şekilde yararlanır ve bunu bir ödül modeli eğitmek için kullanır. Bu model, ince ayar süreci sırasında önceden eğitilmiş modele rehberlik etmede önemli bir rol oynar ve onu insani değerlerle daha uyumlu çıktılar üretmeye teşvik eder. Bu, modelin, dil üretimi bağlamında bir ödüle yol açan durum ve eylemlerin sırasını tanımlamak için kullanılan bir terim olan bir dizi "kullanıma sunma" yoluyla öğrendiği dinamik ve yinelemeli bir süreçtir.

RLHF'nin dikkate değer potansiyellerinden biri, AI asistanlarında kişiselleştirmeyi teşvik etme, onları bireysel kullanıcıların tercihlerine (mizah anlayışları veya günlük rutinler) uyacak şekilde uyarlama yeteneğidir. Yalnızca teknik açıdan yetkin değil, aynı zamanda duygusal açıdan da zeki, insan iletişimindeki nüansları anlama ve bunlara yanıt verme yeteneğine sahip yapay zeka sistemleri oluşturmanın yollarını açıyor.

Ancak şunu unutmamak gerekir ki RLHF kusursuz bir çözüm değildir. Modeller, üzerinde eğitildikleri geniş ve çoğu zaman düzenlenmemiş ve önyargılı verilerin bir yansıması olan istenmeyen çıktılar üretmeye hâlâ duyarlıdır.

Sonuç

Alpaca, Falcon ve GPT-4 gibi LLM'lerin tüm potansiyelinden yararlanmada kritik bir adım olan ince ayar süreci daha rafine ve odaklanmış hale geldi ve çok çeşitli görevlere özel çözümler sunuldu.

Belirli rollerdeki modellerde uzmanlaşmış tek görevli ince ayar ve eğitim sürecini daha verimli ve uygun maliyetli hale getirmeyi amaçlayan LoRA ve QLoRA dahil Parametre Verimli İnce Ayar (PEFT) yöntemlerini gördük. Bu gelişmeler, daha geniş bir kitleye yönelik üst düzey yapay zeka işlevlerine kapı açıyor.

Ayrıca, Açık Yapay Zeka tarafından İnsan Geri Bildiriminden Takviyeli Öğrenmenin (RLHF) kullanıma sunulması, insani değerleri ve tercihleri anlayan ve bunlarla daha yakından uyum sağlayan yapay zeka sistemleri oluşturmaya yönelik bir adımdır ve yalnızca akıllı değil aynı zamanda duyarlı yapay zeka asistanları için zemin hazırlar. bireysel kullanıcının ihtiyaçları. Hem RLHF hem de PEFT, Büyük Dil Modellerinin işlevselliğini ve verimliliğini artırmak için sinerji içinde çalışır.

İşletmeler, kuruluşlar ve bireyler, bu ince ayarlı LLM'leri kendi operasyonlarına entegre etmeye çalışırken, aslında yapay zekanın bir araçtan daha fazlası olduğu bir geleceği memnuniyetle karşılıyorlar; yenilikçi ve kişiselleştirilmiş çözümler sunan, insani bağlamları anlayan ve bunlara uyum sağlayan bir ortaktır.