Yapay Zeka

StyleTTS 2: Büyük Konuşma Dili Modelleriyle İnsan Düzeyinde Metin-Konuşma

Doğal ve sentetik konuşma sentezi yaklaşımlarındaki artış nedeniyle, yapay zeka endüstrisinin son birkaç yılda elde ettiği en büyük başarılardan biri, sesli kitaplar, sanal asistanlar, sesli kitaplar dahil olmak üzere farklı endüstrilerdeki potansiyel uygulamalarla metinden konuşmaya çerçeveleri etkili bir şekilde sentezlemektir. Konuşmayla ilgili çok çeşitli görevlerde insan düzeyinde performans ve verimlilik sağlayan bazı son teknoloji modlarla anlatımlar ve daha fazlası üzerinden. Bununla birlikte, güçlü performanslarına rağmen, anlamlı ve çeşitli konuşma, sıfır atışlı metinden konuşmaya çerçevelerini optimize etmek için büyük miktarda eğitim verisi gereksinimi ve OOD veya Dağıtım Dışı metinlere yönelik sağlamlık sayesinde görevler için hala iyileştirme alanı vardır. geliştiricilerin daha sağlam ve erişilebilir bir metinden konuşmaya çerçevesi üzerinde çalışmasını istiyoruz.

Bu yazıda, StyleTTS çerçevesinin temelleri üzerine inşa edilen ve son teknoloji metinden konuşmaya sistemlerine doğru bir sonraki adımı sunmayı amaçlayan, sağlam ve yenilikçi bir metinden konuşmaya çerçevesi olan StyleTTS-2'den bahsedeceğiz. StyleTTS2 çerçevesi, konuşma stillerini gizli rastgele değişkenler olarak modeller ve bu konuşma stillerini veya rastgele değişkenleri örneklemek için olasılıksal bir yayılma modeli kullanır, böylece StyleTTS2 çerçevesinin, referans ses girişlerini kullanmadan gerçekçi konuşmayı etkili bir şekilde sentezlemesine olanak tanır. Yaklaşım sayesinde, StyleTTS2 çerçevesi daha iyi sonuçlar sunabilmekte ve mevcut en gelişmiş metinden konuşmaya çerçeveleriyle karşılaştırıldığında yüksek verimlilik göstermektedir, ancak aynı zamanda difüzyon modeli çerçeveleri tarafından sunulan çeşitli konuşma sentezinden de yararlanabilmektedir. StyleTTS2 çerçevesini daha ayrıntılı olarak tartışacağız, mimarisi ve metodolojisi hakkında konuşacağız ve aynı zamanda çerçevenin elde ettiği sonuçlara da göz atacağız. Öyleyse başlayalım.

Metinden Konuşmaya Sentez için StyleTTS2: Giriş

StyleTTS2, insan düzeyinde TTS çerçeveleri oluşturmaya yönelik bir sonraki adımı atan yenilikçi bir Metinden Konuşmaya sentez modelidir ve stil tabanlı bir metin olan StyleTTS üzerine kurulmuştur. konuşma üretici modeli. StyleTTS2 çerçevesi, konuşma stillerini gizli rastgele değişkenler olarak modeller ve bu konuşma stillerini veya rastgele değişkenleri örneklemek için olasılıksal bir yayılma modeli kullanır, böylece StyleTTS2 çerçevesinin, referans ses girişlerini kullanmadan gerçekçi konuşmayı etkili bir şekilde sentezlemesine olanak tanır. Stilleri gizli rastgele değişkenler olarak modellemek, StyleTTS2 çerçevesini selefi olan StyleTTS çerçevesinden ayıran şeydir ve referans ses girişine ihtiyaç duymadan giriş metni için en uygun konuşma stilini oluşturmayı amaçlar ve alırken etkili gizli yayılmalar elde edebilir. tarafından sunulan çeşitli konuşma sentezi yeteneklerinin avantajı difüzyon modelleri. Buna ek olarak StyleTTS2 çerçevesi, WavLM çerçevesi gibi ayırıcılar olarak önceden eğitilmiş büyük SLM veya Konuşma Dili Modelini de kullanır ve çerçeveyi uçtan uca eğitmek ve sonuçta gelişmiş doğallığa sahip konuşma üretmek için bunu kendi yeni diferansiyel süre modelleme yaklaşımıyla birleştirir. İzlediği yaklaşım sayesinde StyleTTS2 çerçevesi, konuşma oluşturma görevleri için mevcut en gelişmiş çerçevelerden daha iyi performans gösterir ve konuşmacı uyarlama görevleri için sıfır atış ayarında büyük ölçekli konuşma modellerinin ön eğitimi için en verimli çerçevelerden biridir.

StyleTTs2 çerçevesi, insan düzeyinde metinden konuşmaya sentez sağlamak için, konuşma sentezi için yayılma modelleri ve büyük konuşma dili modelleri de dahil olmak üzere mevcut çalışmalardan edinilen bilgileri birleştirir. Difüzyon modelleri, ince taneli konuşma kontrolü yetenekleri ve çeşitli konuşma örnekleme yetenekleri sayesinde genellikle konuşma sentezi görevleri için kullanılır. Bununla birlikte, difüzyon modelleri, GAN tabanlı yinelemeli olmayan çerçeveler kadar verimli değildir ve bunun ana nedeni, konuşmanın hedef süresine göre gizli temsilleri, dalga formlarını ve mel-spektrogramları yinelemeli olarak örnekleme gerekliliğidir.

Öte yandan, Büyük Konuşma Dili Modelleri etrafındaki son çalışmalar, bunların konuşma oluşturma görevlerinde metnin kalitesini artırma ve konuşmacıya iyi uyum sağlama yeteneklerini göstermiştir. Büyük Konuşma Dili Modelleri genellikle metin girişini, konuşmayı yeniden yapılandırma görevleri için önceden eğitilmiş konuşma dili çerçevelerinden türetilen nicelenmiş veya sürekli temsillere dönüştürür. Ancak bu Konuşma Dili Modellerinin özellikleri doğrudan konuşma sentezi için optimize edilmemiştir. Buna karşılık, StyleTTS2 çerçevesi, konuşma dili modellerinin özelliklerini gizli alan haritaları kullanmadan sentezlemek için çekişmeli eğitim kullanan büyük SLM çerçeveleri tarafından kazanılan bilgiden yararlanır ve bu nedenle, konuşma sentezi optimize edilmiş gizli alanı doğrudan öğrenir.

StyleTTS2: Mimari ve Metodoloji

StyleTTS2 özünde, referans sesten bir stil vektörü türetmek için bir stil kodlayıcıdan yararlanan, böylece anlamlı ve doğal konuşma oluşumuna olanak tanıyan, otoregresif olmayan bir metin-konuşma çerçevesi olan öncülü StyleTTS çerçevesi üzerine inşa edilmiştir. StyleTTS çerçevesinde kullanılan stil vektörü, AdaIN veya Uyarlanabilir Örnek Normalleştirme kullanılarak doğrudan kodlayıcıya, süreye ve öngörücülere dahil edilir, böylece StyleTTS modelinin değişen prozodi, süre ve hatta duygularla konuşma çıktıları üretmesine olanak tanır. StyleTTS çerçevesi üç kategoriye ayrılmış toplam 8 modelden oluşur

- Bir stil kodlayıcı, bir metin kodlayıcı ve bir konuşma kod çözücü içeren Akustik Modeller veya Konuşma Oluşturma Sistemi.

- Prozodi ve süre tahmincilerinden yararlanan bir Metinden Konuşmaya Tahmin Sistemi.

- Eğitim amaçlı bir metin hizalayıcı, bir perde çıkarıcı ve bir ayırıcı içeren bir Yardımcı Sistem.

Yaklaşımı sayesinde StyleTTS çerçevesi, kontrol edilebilir ve çeşitli konuşma senteziyle ilgili en gelişmiş performansı sunar. Ancak bu performansın örnek kalitesinin bozulması, ifade sınırlamaları ve gerçek zamanlı olarak konuşmayı engelleyen uygulamalara güvenilmesi gibi dezavantajları vardır.

StyleTTS çerçevesini geliştiren StyleTTS2 modeli, gelişmiş ifade gücüyle sonuçlanır. konuşma metni Geliştirilmiş dağıtım dışı performansa ve yüksek insan seviyesi kalitesine sahip görevler. StyleTTS2 çerçevesi, farklı bileşenleri çekişmeli eğitimle optimize eden ve dalga biçimi sentezini birlikte yönlendiren uçtan uca bir eğitim sürecinden yararlanır. StyleTTS çerçevesinden farklı olarak StyleTTS2 çerçevesi, konuşma stilini gizli bir değişken olarak modeller ve bunu difüzyon modelleri yoluyla örnekleyerek referans ses kullanmadan çeşitli konuşma örnekleri üretir. Gelin bu bileşenlere detaylı bir göz atalım.

Girişim için Uçtan Uca Eğitim

StyleTTS2 çerçevesinde, sabit bileşenlere dayanmak zorunda kalmadan çeşitli metin-konuşma bileşenlerini parazit açısından optimize etmek için uçtan uca bir eğitim yaklaşımı kullanılır. StyleTTS2 çerçevesi bunu, kod çözücüyü doğrudan stil vektöründen, perde ve enerji eğrilerinden ve hizalanmış gösterimlerden dalga biçimini oluşturacak şekilde değiştirerek başarır. Çerçeve daha sonra kod çözücünün son projeksiyon katmanını kaldırır ve onu bir dalga biçimi kod çözücüyle değiştirir. StyleTTS2 çerçevesi iki kodlayıcıdan yararlanır: doğrudan dalga biçimini oluşturmak için HifiGAN tabanlı kod çözücü ve daha hızlı girişim ve eğitim için dalga biçimlerine dönüştürülen faz ve büyüklük üretmek için iSTFT tabanlı kod çözücü.

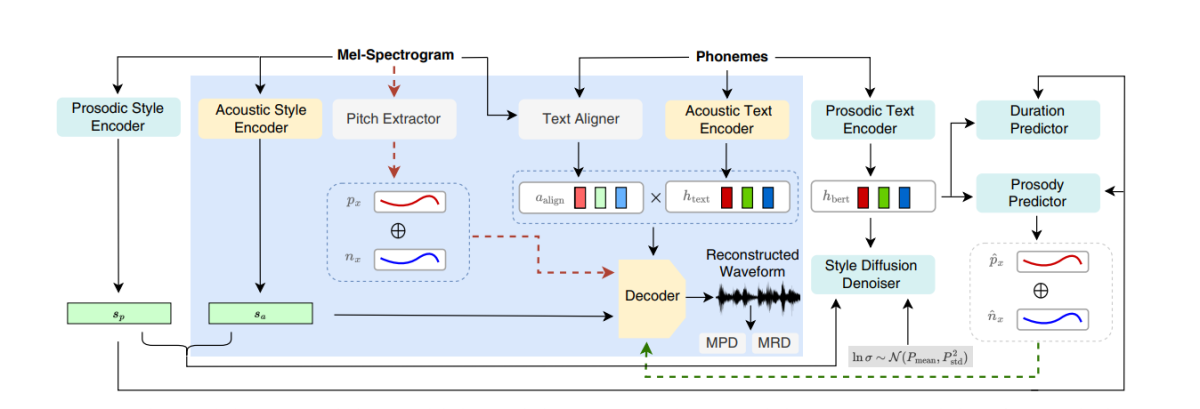

Yukarıdaki şekil ön eğitim ve ortak eğitim için kullanılan akustik modelleri temsil etmektedir. Eğitim süresini azaltmak için, modüller ilk önce eğitim öncesi aşamada optimize edilir, ardından ortak eğitim sırasında perde çıkarıcı hariç tüm bileşenlerin optimizasyonu yapılır. Ortak eğitimin perde çıkarıcıyı optimize etmemesinin nedeni, perde eğrileri için temel gerçeği sağlamak için kullanılmasıdır.

Yukarıdaki şekil, Konuşma Dili Modeli çekişmeli eğitimini ve önceden eğitilmiş ancak önceden ayarlanmamış WavLM çerçevesine müdahaleyi temsil etmektedir. Süreç, yukarıda bahsedilenden farklıdır çünkü çeşitli giriş metinleri alabilir ancak her partideki parametreleri güncellemek için degradeleri biriktirir.

Stil Yayılımı

StyleTTS2 çerçevesi, konuşmayı koşullu dağılımı takip eden gizli bir değişken aracılığıyla koşullu bir dağılım olarak modellemeyi amaçlar ve bu değişkene genelleştirilmiş konuşma stili adı verilir ve sözcüksel vurgu da dahil olmak üzere herhangi bir fonetik içeriğin kapsamı dışındaki konuşma örneğindeki herhangi bir özelliği temsil eder. prozodi, konuşma hızı ve hatta formant geçişleri.

Konuşma Dili Modeli Ayırıcıları

Konuşma Dili Modelleri, çok çeşitli semantik ve akustik yönlere ilişkin değerli bilgileri kodlamaya yönelik genel yetenekleriyle tanınır ve SLM temsilleri, üretilen sentezlenmiş konuşmanın kalitesini değerlendirmek için geleneksel olarak insan algılarını taklit edebilmiştir. StyleTTS2 çerçevesi, SLM kodlayıcılarının üretken görevleri yerine getirme yeteneğinden yararlanmak için çekişmeli bir eğitim yaklaşımı kullanır ve ayırıcı olarak 12 katmanlı bir WavLM çerçevesi kullanır. Bu yaklaşım, çerçevenin, performansı artırmaya yardımcı olabilecek OOD veya Dağıtım Dışı metinleri konusunda eğitime olanak sağlamasına olanak tanır. Ayrıca, aşırı uyum sorunlarını önlemek için çerçeve, OOD metinlerini ve dağıtımı eşit olasılıkla örnekler.

Türevlenebilir Süre Modellemesi

Geleneksel olarak, fonem süreleri üreten metinden konuşmaya çerçevelerinde bir süre tahmincisi kullanılır, ancak bu süre tahmincilerinin kullandığı üst örnekleme yöntemleri genellikle E2E eğitim süreci sırasında gradyan akışını engeller ve NaturalSpeech çerçevesi, insan seviyesi için dikkat tabanlı bir üst örnekleyici kullanır. metinden konuşmaya dönüştürme. Bununla birlikte, StyleTTS2 çerçevesi, bu yaklaşımın çekişmeli eğitim sırasında kararsız olduğunu düşünmektedir çünkü StyleTTS2, sapmalar nedeniyle uzunluktaki uyumsuzluk nedeniyle ekstra terimler kaybı olmadan, farklı çekişmeli eğitimle farklılaştırılabilir üst örnekleme kullanarak eğitim vermektedir. Yumuşak dinamik zaman bükme yaklaşımının kullanılması bu uyumsuzluğun azaltılmasına yardımcı olsa da, bunu kullanmak yalnızca hesaplama açısından pahalı olmakla kalmaz, aynı zamanda rakip hedeflerle veya mel-yeniden yapılandırma görevleriyle çalışırken istikrarı da bir endişe kaynağıdır. Bu nedenle, çekişmeli eğitimle insan düzeyinde performans elde etmek ve eğitim sürecini istikrara kavuşturmak için StyleTTC2 çerçevesi parametrik olmayan bir örnekleme yaklaşımı kullanır. Gauss yukarı örnekleme, önceden belirlenmiş Gauss çekirdeklerinin sabit uzunluğu sayesinde sınırlamaları olmasına rağmen, tahmin edilen süreleri dönüştürmek için popüler bir parametrik olmayan yukarı örnekleme yaklaşımıdır. Gauss yukarı örneklemeye yönelik bu kısıtlama, farklı uzunluklardaki hizalamaları doğru şekilde modelleme yeteneğini sınırlar.

Bu sınırlamayla karşılaşmak için StyleTTC2 çerçevesi, herhangi bir ek eğitim gerektirmeyen ve hizalamaların değişen uzunluklarını hesaba katabilen yeni bir parametrik olmayan yukarı örnekleme yaklaşımının kullanılmasını önerir. Her ses birimi için StyleTTC2 çerçevesi, hizalamayı rastgele bir değişken olarak modeller ve ses biriminin hizalandığı konuşma çerçevesinin indeksini belirtir.

Model Eğitimi ve Değerlendirmesi

StyleTTC2 çerçevesi üç veri kümesi üzerinde eğitilmiş ve denenmiştir: VTKK, LibriTTS ve LJSpeech. StyleTTS2 çerçevesinin tek hoparlörlü bileşeni, 13,000 eğitim örneğine, 12,500 doğrulama örneğine ve yaklaşık 100 test örneğine bölünmüş yaklaşık 500'den fazla ses örneğini içeren LJSpeech veri kümesi kullanılarak eğitilir ve bunların toplam çalışma süresi yaklaşık 24 saattir. Çerçevenin çok hoparlörlü bileşeni, farklı aksanlara sahip 44,000'den fazla anadili konuşan 100'den fazla ses klibinden oluşan VCTK veri kümesi üzerinde eğitilir ve 43,500 eğitim örneğine, 100 doğrulama örneğine ve yaklaşık 500 test örneğine bölünmüştür. Son olarak, çerçeveyi sıfır atış uyarlama yetenekleriyle donatmak için çerçeve, 250'den fazla ayrı hoparlörle toplam yaklaşık 1,150 saatlik sese sahip ses kliplerinden oluşan birleştirilmiş LibriTTS veri kümesi üzerinde eğitilir. Performansını değerlendirmek için model iki ölçüm kullanır: MOS-N veya Doğallık Görüş Puanı Ortalaması ve YOSUN veya Benzerlik Ortalama Görüş Puanı.

ÇIKTILAR

StyleTTS2 çerçevesinde kullanılan yaklaşım ve metodoloji, modelin özellikle NaturalSpeech veri kümesinde ve yol üzerinde birçok son teknoloji TTS çerçevesinden daha iyi performans göstermesi ve veri kümesi için yeni bir standart belirlemesi nedeniyle performansında sergilenmektedir. Ayrıca StyleTTS2 çerçevesi, VTKK veri kümesinde en gelişmiş VITS çerçevesinden daha iyi performans göstermektedir ve sonuçlar aşağıdaki şekilde gösterilmektedir.

StyleTTS2 modeli ayrıca LJSpeech veri kümesinde önceki modellerden daha iyi performans gösteriyor ve aynı ölçümlerdeki önceki çerçevelerde gösterildiği gibi OOD veya Dağıtım Dışı metinlerde herhangi bir kalite bozulması derecesi göstermiyor. Ayrıca sıfır atış ayarında StyleTTC2 modeli, benzerlik açısından geride kalsa da doğallık açısından mevcut Vall-E çerçevesinden daha iyi performans gösteriyor. Bununla birlikte, StyleTTS2 çerçevesinin, Vall-E çerçevesi için 245 saatten fazla eğitime kıyasla yalnızca 60 saatlik ses örnekleri üzerinde eğitime rağmen rekabetçi bir performans elde edebildiğini ve böylece StyleTTC2'nin veri açısından verimli bir alternatif olduğunu kanıtladığını belirtmekte fayda var. Vall-E'de kullanılan mevcut büyük ön eğitim yöntemlerine.

Duygu etiketli sesli metin verilerinin eksikliğinden dolayı StyleTTC2 çerçevesi, GPT-4 modelini kullanarak çerçevenin kendi çerçevesini kullanarak oluşturduğu stil vektörlerinin görselleştirilmesi için farklı duygularda 500'den fazla örnek oluşturur. yayılma proses.

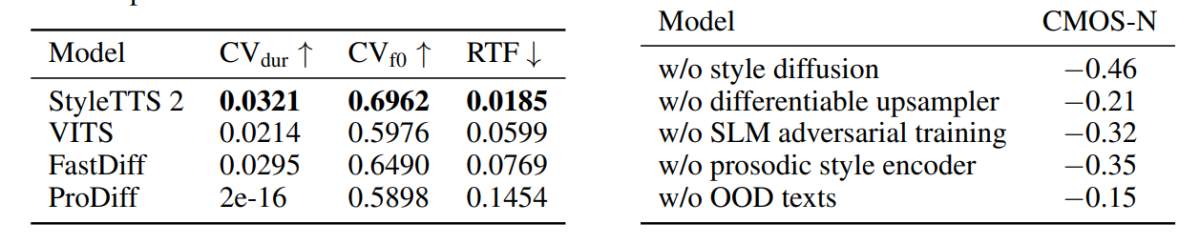

İlk şekilde, giriş metni duygularına yanıt olarak verilen duygusal stiller, LJSpeech modelindeki stil vektörleri ile gösterilmektedir ve StyleTTC2 çerçevesinin, çeşitli duygularla ifade edici konuşmayı sentezleme yeteneğini göstermektedir. İkinci şekil, beş ayrı hoparlörün her biri için farklı küme formlarını tasvir etmekte ve böylece tek bir ses dosyasından kaynaklanan geniş bir çeşitlilik aralığını tasvir etmektedir. Son şekil, konuşmacı 1'den gelen gevşek duygu kümesini göstermekte ve bazı örtüşmelere rağmen, duygu temelli kümelerin öne çıktığını ortaya koymaktadır; dolayısıyla, referans ses örneğine ve giriş tonuna bakılmaksızın bir konuşmacının duygusal melodisini manipüle etme olasılığını göstermektedir. . Difüzyon temelli bir yaklaşım kullanmasına rağmen StyleTTS2 çerçevesi, VITS, ProDiff ve FastDiff dahil olmak üzere mevcut en gelişmiş çerçevelerden daha iyi performans göstermeyi başarıyor.

Son Düşüncelerimiz

Bu makalede, StyleTTS çerçevesinin temelleri üzerine inşa edilen ve en gelişmiş metinden konuşmaya sistemlerine doğru bir sonraki adımı sunmayı amaçlayan yeni, sağlam ve yenilikçi bir metinden konuşmaya çerçevesi olan StyleTTS2'den bahsettik. StyleTTS2 çerçevesi, konuşma stillerini gizli rastgele değişkenler olarak modeller ve bu konuşma stillerini veya rastgele değişkenleri örneklemek için olasılıklı bir yayılma modeli kullanır, böylece StyleTTS2 çerçevesinin, referans ses girişlerini kullanmadan gerçekçi konuşmayı etkili bir şekilde sentezlemesine olanak tanır. StyleTTS2 çerçevesi, stil dağılımını ve SLM ayırıcılarını kullanır. metinden konuşmaya görevlerinde insan düzeyinde performans elde etmek ve çok çeşitli konuşma görevlerinde mevcut son teknoloji çerçevelerden daha iyi performans göstermeyi başarıyor.