Yapay Zeka

Perplexity AI “Sansürsüz” DeepSeek R1: Yapay Zekanın Sınırlarını Kim Belirliyor?

Birçok kişinin dikkatini çeken bir hamleyle, şaşkınlık AI yerleşik Çin sansürünü ortadan kaldıran popüler bir açık kaynaklı dil modelinin yeni bir sürümünü yayınladı. Bağımsızlık ruhunu çağrıştıran bir isim olan R1 1776 olarak adlandırılan bu değiştirilmiş model, Çin tarafından geliştirilen DeepSeek R1Orijinal DeepSeek R1, güçlü muhakeme yetenekleriyle ses getirmişti (üst düzey modellerle maliyetinin çok daha az olduğu bildiriliyordu) ancak önemli bir sınırlaması vardı: belirli hassas konuları ele almayı reddediyordu.

Neden bu konuyu mu?

Bu, şu konuda önemli soruları gündeme getiriyor: Yapay zeka gözetimi, önyargı, açıklık ve AI sistemlerinde jeopolitiğin rolü. Bu makale Perplexity'nin tam olarak ne yaptığını, modelin sansürsüzleştirilmesinin sonuçlarını ve AI şeffaflığı ve sansürü hakkındaki daha geniş sohbete nasıl uyduğunu araştırıyor.

Ne Oldu: DeepSeek R1 Sansürsüz Hale Geliyor

DeepSeek R1, Çin'de ortaya çıkan açık ağırlıklı büyük dil modelidir ve mükemmel muhakeme yetenekleriyle ün kazandı – hatta önde gelen modellerin performansına yaklaşıyor – hepsi daha hesaplamalı olarak verimliyken. Ancak, kullanıcılar hemen bir tuhaflık fark ettiler: Çin'de hassas konulara (örneğin, yetkililer tarafından tabu olarak kabul edilen siyasi tartışmalar veya tarihi olaylar) değinen sorgular olduğunda, DeepSeek R1 doğrudan yanıt vermiyordu. Bunun yerine, Çin hükümetinin sansür kurallarını yansıtan, kalıplaşmış, devlet tarafından onaylanmış ifadelerle veya açıkça reddedişlerle yanıt verdi. Bu yerleşik önyargı, modelin bu konularda açık veya ayrıntılı tartışmalar arayanlar için kullanışlılığını sınırladı.

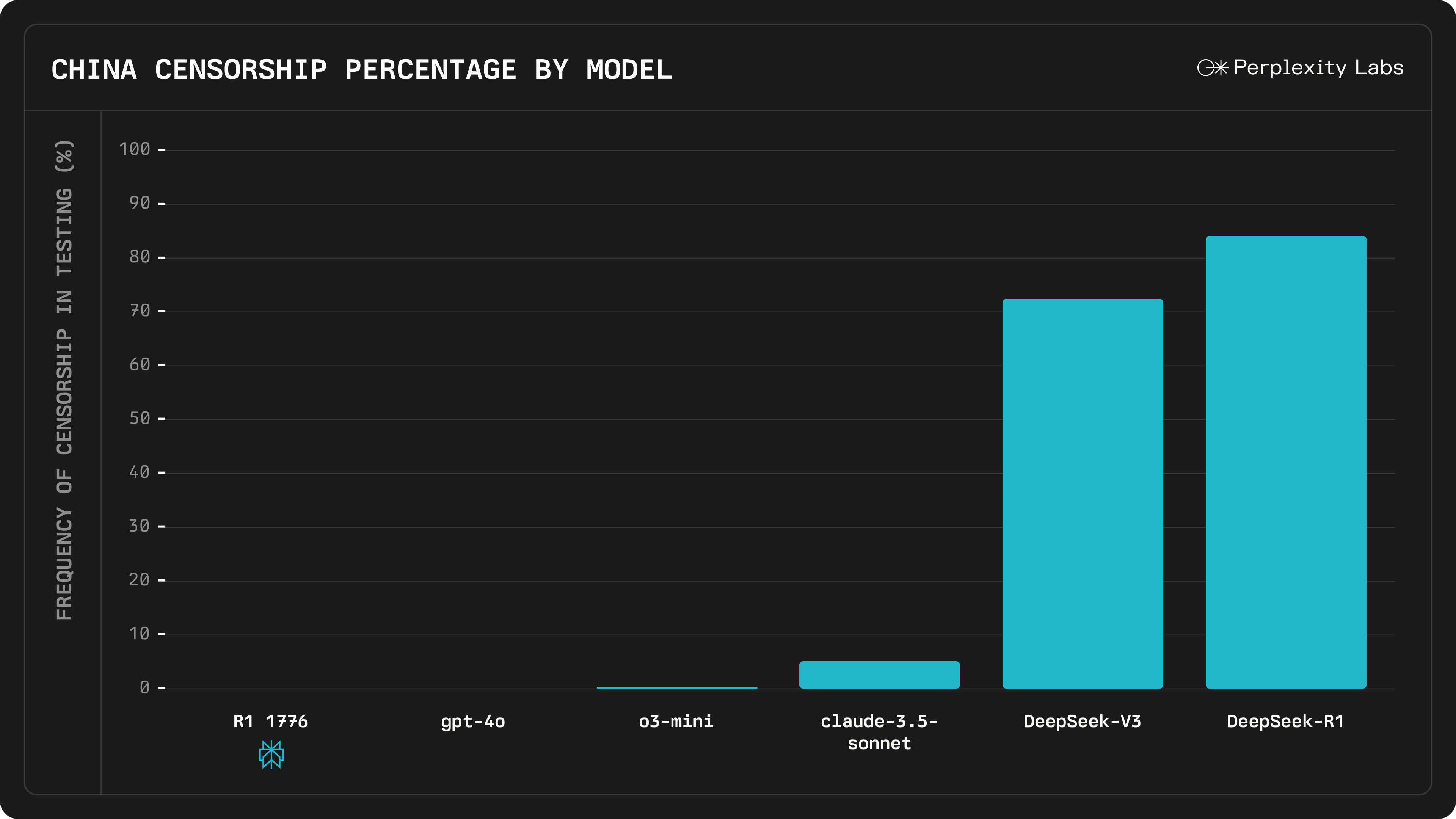

Perplexity AI'nın çözümü, kapsamlı bir eğitim sonrası süreçle modeli "sansürlemek" oldu. Şirket, DeepSeek R40,000'in daha önce sansürlediği veya kaçamak cevap verdiği soruları kapsayan 1 çok dilli istemden oluşan büyük bir veri kümesi topladı. İnsan uzmanların yardımıyla, orijinal modelin parti çizgisini izleme eğiliminde olduğu yaklaşık 300 hassas konu belirlediler. Ekip, bu tür istemlerin her biri için birden fazla dilde gerçekçi, iyi gerekçelendirilmiş cevaplar hazırladı. Bu çabalar, çok dilli bir sansür tespit ve düzeltme sistemine beslendi ve esasen modele siyasi sansür uyguladığında bunu nasıl tanıyacağını ve bunun yerine bilgilendirici bir cevapla nasıl yanıt vereceğini öğretti. Bu özel ince ayardan sonra (Perplexity'nin özgürlük temasını vurgulamak için "R1 1776" adını verdiği), model açıkça kullanılabilir hale getirildi. Perplexity, temel yeteneklerini başka şekilde değiştirmeden, DeepSeek R1'in yanıtlarından Çin sansür filtrelerini ve önyargılarını ortadan kaldırdığını iddia ediyor.

Önemli olarak, R1 1776 eskiden tabu sayılan sorularda çok farklı davranıyor. Perplexity, Tayvan'ın bağımsızlığı ve NVIDIA'nın hisse senedi fiyatı üzerindeki potansiyel etkisiyle ilgili bir soru içeren bir örnek verdi - Çin-Tayvan ilişkilerine değinen politik olarak hassas bir konu. Orijinal DeepSeek R1, ÇKP'ye uygun basmakalıp ifadelerle yanıt vererek sorudan kaçındı. Buna karşılık, R1 1776 ayrıntılı, samimi bir değerlendirme sunuyor: NVIDIA'nın hisse senedini etkileyebilecek somut jeopolitik ve ekonomik riskleri (tedarik zinciri kesintileri, piyasa oynaklığı, olası çatışma vb.) ele alıyor.

R1 1776'yı açık kaynaklı hale getirerek Perplexity, modelin ağırlıklarını ve değişikliklerini topluluk için şeffaf hale getirdi. Geliştiriciler ve araştırmacılar Hugging Face'den indirin ve hatta API aracılığıyla entegre ederek sansürün kaldırılmasının başkaları tarafından da incelenip üzerine inşa edilebilmesini sağlayabilirsiniz.

(Kaynak: Perplexity AI)

Sansürün Kaldırılmasının Sonuçları

Perplexity AI'nın DeepSeek R1'den Çin sansürünü kaldırma kararı, AI topluluğu için birkaç önemli sonuç doğuruyor:

- Gelişmiş Açıklık ve Dürüstlük: R1 1776 kullanıcıları artık daha önce yasaklanmış konularda sansürsüz, doğrudan yanıtlar alabilirler, bu da açık sorgulama için bir kazançtır. Bu, araştırmacılar, öğrenciler veya hassas jeopolitik sorulara meraklı herkes için daha güvenilir bir asistan haline getirebilir. Bilgi baskısını engellemek için açık kaynaklı AI kullanmanın somut bir örneğidir.

- Korunan Performans: Modelin sansürü kaldırmak için ayarlanmasının diğer alanlardaki performansını düşürebileceğine dair endişeler vardı. Ancak Perplexity, R1 1776'nın matematik ve mantıksal akıl yürütme gibi temel becerilerinin orijinal modelle aynı seviyede kaldığını bildiriyor. Hassas sorguların geniş bir yelpazesini kapsayan 1,000'den fazla örnek üzerinde yapılan testlerde, modelin DeepSeek R1 ile aynı düzeyde akıl yürütme doğruluğunu korurken "tamamen sansürsüz" olduğu bulundu. Bu, şunu gösteriyor: önyargıların kaldırılması (en azından bu durumda) genel istihbarat veya kabiliyet pahasına gerçekleşmedi, bu da gelecekte benzer çabaların cesaret verici bir işareti.

- Olumlu Toplum Kabulü ve İşbirliği: Perplexity, sansürsüz modeli açık kaynaklı hale getirerek AI topluluğunu çalışmalarını incelemeye ve geliştirmeye davet ediyor. Bu, şeffaflığa olan bağlılığı gösteriyor - AI'nın birinin çalışmasını göstermesine eşdeğer. Meraklılar ve geliştiriciler sansür kısıtlamalarının gerçekten ortadan kalktığını doğrulayabilir ve potansiyel olarak daha fazla iyileştirmeye katkıda bulunabilir. Bu, kapalı modellerin ve gizli moderasyon kurallarının yaygın olduğu bir sektörde güveni ve iş birliğine dayalı yeniliği teşvik eder.

- Etik ve Jeopolitik Hususlar: Öte yandan, sansürü tamamen kaldırmak karmaşık etik soruları gündeme getirir. Acil bir endişe, bu sansürsüz modelin nasıl kullanılabileceğidir sansürlenen konuların yasadışı veya tehlikeli olduğu bağlamlardaÖrneğin, Çin anakarasındaki biri R1 1776'yı kullanırsa, modelin Tiananmen Meydanı veya Tayvan hakkındaki sansürsüz yanıtları kullanıcıyı riske atabilir. Ayrıca daha geniş bir jeopolitik sinyal de var: Çin sansürüne meydan okumak için Çin kökenli bir modeli değiştiren bir Amerikan şirketi, cesur bir ideolojik duruş olarak görülebilir. "1776" adının kendisi, gözden kaçmayan bir kurtuluş temasını vurgular. Bazı eleştirmenler, bir önyargı kümesini başka bir önyargı kümesiyle değiştirmek mümkündür – esasen modelin hassas alanlarda Batı bakış açısını yansıtıp yansıtmadığını sorguluyor. Tartışma, yapay zekada sansür ile açıklığın yalnızca teknik bir sorun değil, aynı zamanda politik ve etik bir sorun olduğunu vurguluyor. Bir kişinin gördüğü yer gerekli ılımlılık, bir başkası görür sansürve doğru dengeyi bulmak zordur.

Sansürün kaldırılması, büyük ölçüde daha şeffaf ve küresel olarak faydalı yapay zeka modellerine doğru atılmış bir adım olarak kutlanıyor, ancak aynı zamanda bir yapay zekanın ne olduğunu da hatırlatıyor. meli evrensel bir mutabakat olmaksızın hassas bir soru olduğunu söyleyebiliriz.

(Kaynak: Perplexity AI)

Daha Büyük Resim: Yapay Zeka Sansürü ve Açık Kaynaklı Şeffaflık

Perplexity'nin R1 1776 lansmanı, AI topluluğunun modellerin tartışmalı içerikleri nasıl ele alması gerektiğiyle ilgili sorularla boğuştuğu bir zamanda geliyor. AI modellerinde sansür birçok yerden gelebilir. Çin'de, teknoloji şirketlerinin katı filtreler oluşturması gerekiyor ve hatta politik olarak hassas konular için sabit kodlu yanıtlar. DeepSeek R1 bunun başlıca bir örneğidir - açık kaynaklı bir modeldi, ancak eğitiminde ve ince ayarında Çin'in sansür normlarının izini açıkça taşıyordu. Buna karşılık, OpenAI'nin GPT-4'ü veya Meta'nın LLaMA'sı gibi birçok Batılı gelişmiş model, ÇKP yönergelerine bağlı değildir, ancak yine de bazı kullanıcıların "sansür" dediği (nefret söylemi, şiddet veya yanlış bilgi gibi şeyler için) moderasyon katmanlarına sahiptir. makul ölçülülük ve istenmeyen sansür Bulanık olabilir ve sıklıkla kültürel veya politik bakış açısına bağlıdır.

Perplexity AI'nın DeepSeek R1 ile yaptığı şey, açık kaynaklı modellerin farklı değer sistemlerine veya düzenleyici ortamlara uyarlanabileceği fikrini ortaya atıyor. Teoride, bir modelin birden fazla sürümü oluşturulabilir: biri Çin düzenlemelerine uygun (Çin'de kullanım için) ve diğeri tamamen açık (başka yerlerde kullanım için). R1 1776 esasen ikinci durumdur - filtrelenmemiş cevapları tercih eden küresel bir kitle için tasarlanmış sansürsüz bir çatal. Bu tür bir çatallanma yalnızca DeepSeek R1'in ağırlıklarının açıkça erişilebilir olması nedeniyle mümkün olmuştur. AI'da açık kaynağın faydasını vurgular: şeffaflık. Herkes modeli alıp, güvenlik önlemleri eklemek veya bu durumda olduğu gibi, uygulanan kısıtlamaları kaldırmak için ince ayar yapabilir. Modelin eğitim verilerinin, kodunun veya ağırlıklarının açık kaynaklı olması, topluluğun modelin nasıl değiştirildiğini denetleyebileceği anlamına da gelir. (Perplexity, sansür kaldırma için kullandığı tüm veri kaynaklarını tam olarak açıklamadı, ancak modeli yayınlayarak başkalarının davranışını gözlemlemesini ve gerekirse yeniden eğitmesini sağladı.)

Bu olay ayrıca AI gelişiminin daha geniş jeopolitik dinamiklerine de selam gönderiyor. AI için farklı yönetim modelleri arasında bir diyalog (veya çatışma) biçimi görüyoruz. Belirli yerleşik dünya görüşlerine sahip Çin tarafından geliştirilen bir model, ABD merkezli bir ekip tarafından alınıyor ve daha açık bir bilgi ethosunu yansıtacak şekilde değiştiriliyor. Bu, nasıl küresel ve sınırsız Yapay zeka teknolojisi şudur: her yerdeki araştırmacılar birbirlerinin çalışmalarını geliştirebilirler, ancak orijinal kısıtlamaları devam ettirmek zorunda değillerdir. Zamanla, bunun daha fazla örneğini görebiliriz - modeller farklı kültürel bağlamlar arasında "çevirilir" veya ayarlanır. Bu, yapay zekanın gerçekten evrensel olup olamayacağı veya yerel normlara uyan bölgeye özgü sürümlerle mi sonuçlanacağımız sorusunu gündeme getirir. Şeffaflık ve açıklık, bunun üstesinden gelmek için bir yol sağlar: eğer tüm taraflar modelleri inceleyebiliyorsa, en azından önyargı ve sansür hakkındaki konuşmalar şirket veya hükümet gizliliğinin arkasına saklanmak yerine açıkça ortaya çıkar.

Son olarak Perplexity'nin bu hamlesi, yapay zeka kontrolüyle ilgili tartışmada önemli bir noktayı vurguluyor: Bir yapay zekanın ne söyleyebileceğine veya ne söyleyemeyeceğine kim karar veriyor? Açık kaynaklı projelerde, bu güç merkezsizleşir. Topluluk - veya bireysel geliştiriciler - daha katı filtreler uygulamaya veya bunları gevşetmeye karar verebilir. R1 1776 durumunda, Perplexity sansürsüz bir modelin faydalarının risklerden daha ağır bastığına karar verdi ve bu kararı verme ve sonucu kamuoyuyla paylaşma özgürlüğüne sahiplerdi. Bu, açık AI geliştirmenin sağladığı türden deneylere dair cesur bir örnek.