Yapay Zeka

OLMo: Dil Bilimi Modellerinin Geliştirilmesi

Dil modellerinin son birkaç yıldaki gelişimi ve ilerlemesi, yalnızca NLP araştırmalarında değil, aynı zamanda ticari tekliflerde ve gerçek dünya uygulamalarında da neredeyse her yerde varlıklarını gösterdi. Ancak dil modellerine yönelik ticari talepteki artış, topluluğun büyümesini bir dereceye kadar engelledi. Bunun nedeni, en son teknolojiye sahip ve yetenekli modellerin çoğunluğunun özel arayüzlerin arkasına yerleştirilmiş olması ve bu durumun, geliştirme topluluğunun eğitim mimarisi, verileri ve geliştirme süreçlerine ilişkin hayati ayrıntılara erişmesini imkansız hale getirmesidir. Potansiyel risklere ve önyargılara erişim de dahil olmak üzere, bu eğitim ve yapısal ayrıntıların araştırma çalışmaları için hayati öneme sahip olduğu, dolayısıyla araştırma topluluğunun gerçekten açık ve güçlü bir dil modeline erişime sahip olması için bir gereklilik oluşturduğu artık inkar edilemez.

Bu gereksinimi karşılamak için geliştiriciler, son teknoloji ürünü, gerçekten açık bir dil modeli çerçevesi olan OLMo'yu oluşturdular. Bu çerçeve, araştırmacıların dil modelleri oluşturmak ve incelemek için OLMo'yu kullanmalarına olanak tanır. Yalnızca arayüz kodunu ve model ağırlıklarını yayınlayan en son teknolojiye sahip dil modellerinin aksine, OLMo çerçevesi, kamuya açık değerlendirme kodu, eğitim yöntemleri ve eğitim verileriyle gerçek anlamda açık kaynaktır. OLMo'nun öncelikli amacı açık araştırma topluluğunu ve dil modellerinin sürekli gelişimini güçlendirmek ve güçlendirmektir.

Bu makalede, mimarisini, metodolojisini ve performansını mevcut en son teknoloji çerçevelerle karşılaştırmalı olarak inceleyerek OLMo çerçevesini ayrıntılı olarak tartışacağız. Öyleyse başlayalım.

OLMo: Dil Bilimi Modellerinin Geliştirilmesi

Dil modeli, gerçek dünyadaki görevleri insan benzeri performansla yerine getirme konusundaki olağanüstü yetenekleri nedeniyle, yalnızca AI ve ML topluluğunda değil aynı zamanda teknoloji endüstrisinde de son birkaç yılın tartışmasız en sıcak trendi oldu. ChatGPT, teknoloji endüstrisindeki büyük oyuncuların ürünleriyle dil modeli entegrasyonunu araştırdığı potansiyel dil modellerinin önemli bir örneğidir.

NLP veya Doğal Dil İşleme, son birkaç yılda dil modellerini yaygın olarak kullanan sektörlerden biridir. Bununla birlikte, endüstrinin hizalama ve büyük ölçekli ön eğitim için insan açıklamalarını kullanmaya başlamasından bu yana, dil modelleri ticari uygulanabilirliklerinde hızlı bir artışa tanık oldu ve bu da en son teknolojiye sahip dil ve NLP çerçevelerinin çoğunun kısıtlanmasına neden oldu. geliştirme topluluğunun hayati ayrıntılara erişiminin olmadığı özel arayüzler.

Dil modellerinin ilerlemesini sağlamak için son teknoloji ürünü, gerçek anlamda açık bir dil modeli olan OLMo, geliştiricilere dil modellerinin geliştirilmesi, incelenmesi ve geliştirilmesi için bir çerçeve sunar. Ayrıca araştırmacılara eğitim ve değerlendirme koduna, eğitim metodolojisine, eğitim verilerine, eğitim günlüklerine ve ara model kontrol noktalarına erişim sağlar. Mevcut son teknoloji modeller değişen derecelerde açıklığa sahipken OLMo modeli, eğitimden veriye ve değerlendirme araçlarına kadar tüm çerçeveyi serbest bırakarak, aşağıdaki gibi son teknoloji modellerle karşılaştırıldığında performans açığını daraltıyor. LLaMA2 modeli.

Modelleme ve eğitim için OLMo çerçevesi, eğitim kodunu, tam model ağırlıklarını, ablasyonları, eğitim günlüklerini ve arayüz kodu biçimindeki eğitim metriklerinin yanı sıra Ağırlıklar ve Önyargılar günlüklerini içerir. Analiz ve veri kümesi oluşturma için OLMo çerçevesi, AI2'nin Dolma ve WIMBD modelleri için kullanılan tüm eğitim verilerinin yanı sıra eğitim verilerini üreten kodu da içerir. Değerlendirme amacıyla OLMo çerçevesi, aşağı yönlü değerlendirme için AI2'nin Catwalk modelini ve şaşkınlık temelli değerlendirme için Paloma modelini içerir.

OLMo : Model ve Mimari

OLMo modeli, Sinir Bilgisi İşleme Sistemlerini temel alan, yalnızca kod çözücüden oluşan bir transformatör mimarisini benimser ve şu anda geliştirilmekte olan 1 milyar parametreli bir modelle sırasıyla 7 milyar ve 65 milyar parametreli iki model sunar.

OLMo çerçevesinin mimarisi, en son teknoloji de dahil olmak üzere mimarilerindeki vanilya transformatör bileşeni de dahil olmak üzere çerçevelere göre çeşitli iyileştirmeler sunar büyük dil modelleri OpenLM, Falcon, LLaMA ve PaLM gibi. Aşağıdaki şekil, 7 milyar milyar parametreye sahip OLMo modelini neredeyse eşit sayıda parametreyle çalışan son LLM'lerle karşılaştırmaktadır.

OLMo çerçevesi, modeli donanımdaki eğitim verimi için optimize ederek hiperparametreleri seçer ve aynı zamanda yavaş sapma ve kayıp artışları riskini en aza indirir. Bununla birlikte, OLMo çerçevesinin uyguladığı ve kendisini vanilya transformatör mimarisinden ayıran başlıca değişiklikler şunlardır:

önyargı yok

Falcon, PaLM, LLaMA ve diğer dil modellerinden farklı olarak OLMo çerçevesi, eğitim kararlılığını artırmak için mimarisinde herhangi bir önyargı içermez.

Parametrik Olmayan Katman Normu

OLMo çerçevesi, katman normunun parametrik olmayan formülasyonunu mimarisinde uygular. Parametrik Olmayan Katman Normu, norm içerisinde herhangi bir afin dönüşüm sunmaz, yani herhangi bir uyarlanabilir kazanç veya önyargı sunmaz. Parametrik Olmayan Katman Normu, Parametrik Katman Normlarına göre daha fazla güvenlik sunmakla kalmaz, aynı zamanda daha hızlıdır.

SwiGLU Aktivasyon Fonksiyonu

PaLM ve LLaMA gibi dil modellerinin çoğu gibi, OLMo çerçevesi de mimarisinde ReLU etkinleştirme işlevi yerine SwiGLU etkinleştirme işlevini içerir ve verimi artırmak için gizli etkinleştirme boyutunu 128'in en yakın katına kadar artırır.

RoPE veya Döner Konumsal Gömmeler

OLMo modelleri LLaMA ve PaLM modellerini takip eder ve mutlak konumsal yerleştirmeleri RoPE veya Döner Konumsal Yerleştirmelerle değiştirir.

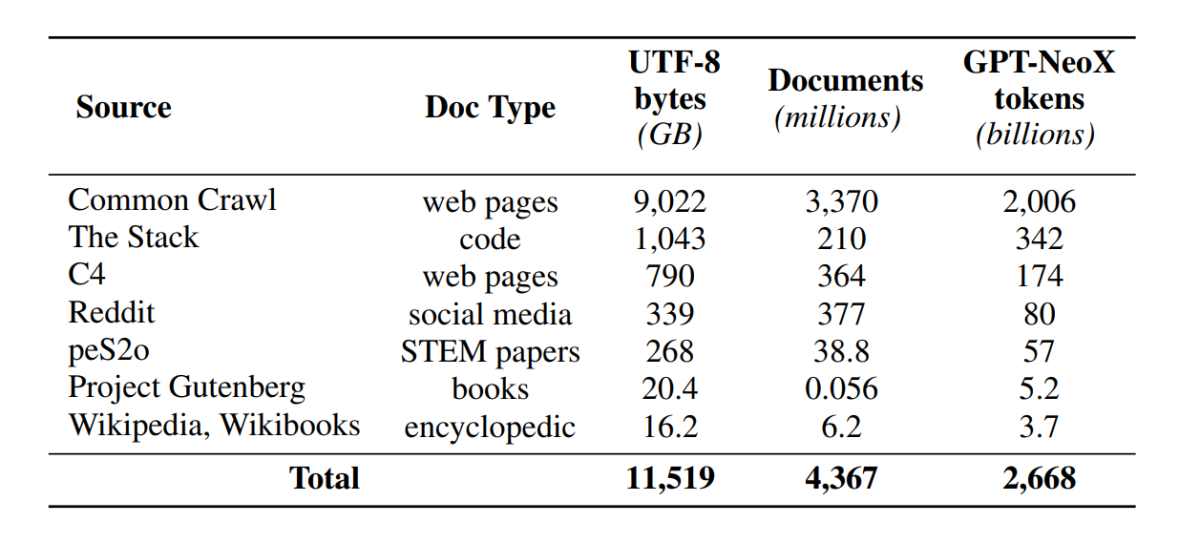

Dolma ile Ön Eğitim

Geliştirme topluluğu artık model parametrelerine gelişmiş erişime sahip olsa da, eğitim öncesi veriler kapalı modellerin veya açık modellerin yanında yayınlanmadığından eğitim öncesi veri kümelerine erişim kapıları hâlâ kapalı kalıyor. Ayrıca, bu tür verileri kapsayan teknik belgeler genellikle modeli tam olarak anlamak ve kopyalamak için gereken hayati ayrıntılardan yoksundur. Barikat, araştırmanın belirli başlıklarda ilerlemesini zorlaştırıyor dil modeli Eğitim verilerinin modelin yeteneklerini ve sınırlamalarını nasıl etkilediğinin anlaşılmasını içeren araştırma. OLMo çerçevesi, dil modeli ön eğitimi üzerine açık araştırmayı kolaylaştırmak için eğitim öncesi veri kümesi Dolma'yı oluşturup yayınladı. Dolma veri seti, güçlü, büyük ölçekli LLM'ler tarafından ön eğitim için yaygın olarak kullanılan ve genel izleyici tarafından erişilebilen, 3 farklı kaynaktan toplanan 5 milyar belgede 7 trilyondan fazla tokenden oluşan çok kaynaklı ve çeşitli bir koleksiyondur. Dolma veri kümesinin bileşimi aşağıdaki tabloda özetlenmiştir.

Dolma veri kümesi 5 bileşenden oluşan bir işlem hattı kullanılarak oluşturulmuştur: dil filtreleme, kalite filtreleme, içerik filtreleme, çok kaynaklı karıştırma, tekilleştirme ve tokenizasyon. OLMo ayrıca daha ayrıntılı bir içerik özetinin yanı sıra tasarım ilkeleri ve inşaat ayrıntılarına ilişkin daha fazla bilgi sağlayan Dolma raporunu da yayınladı. Model ayrıca, eğitim öncesi veri derlemelerinin kolay ve hızlı bir şekilde derlenmesini sağlamak için yüksek performanslı veri iyileştirme araçlarını da açık kaynak olarak kullanıyor. Modelin değerlendirilmesi, model eğitimi sırasında karar vermeye yönelik çevrimiçi değerlendirmeyle başlayan ve model kontrol noktalarından toplu bir değerlendirme için son çevrimdışı değerlendirmeyle başlayan iki aşamalı bir stratejiyi izler. Çevrimdışı değerlendirme için OLMo, çok çeşitli veri kümelerine ve görev formatlarına erişimi olan, halka açık değerlendirme aracımız olan Catwalk çerçevesini kullanır. Çerçeve, yeni şaşkınlık kriterimiz Paloma'da içsel dil modelleme değerlendirmesinin yanı sıra aşağı yönlü değerlendirme için Catwalk'u kullanıyor. OLMo daha sonra hem aşağı yönde hem de şaşkınlık değerlendirmesi için sabit değerlendirme hattını kullanarak onu çeşitli genel modellerle karşılaştırır.

OLMo, modelin eğitimi sırasında model mimarisi, başlatma, optimize ediciler, öğrenme hızı çizelgesi ve veri karışımları hakkında çeşitli değerlendirme ölçümleri çalıştırır. Geliştiriciler, eğitilen modelin kalitesine ilişkin erken ve sürekli bir sinyal vermek için her 1000 eğitim adımında (veya ∼4B eğitim belirteçlerinde) bir döngü içi yineleme olması nedeniyle buna OLMo'nun "çevrimiçi değerlendirmesi" adını veriyor. Bu değerlendirmelerin kurulumu, çevrimdışı değerlendirmemiz için kullanılan temel görevlerin ve deneme ayarlarının çoğuna bağlıdır. OLMo, yalnızca OLMo-7B'nin en iyi performans açısından diğer modellerle karşılaştırılmasını değil, aynı zamanda nasıl daha kapsamlı ve daha kontrollü bilimsel değerlendirmeye olanak sağladığını göstermeyi de amaçlamaktadır. OLMo-7B, şaşkınlık değerlendirmesi için açık arındırma özelliğine sahip en büyük Dil Modelidir.

OLMo Eğitimi

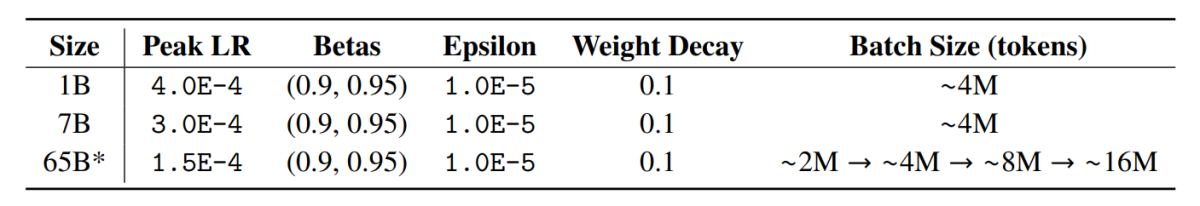

OLMo çerçeve modellerinin, FSDP çerçevesi tarafından PyTorch aracılığıyla sağlanan ve bu şekilde GPU'lar üzerinden model ağırlıklarını bölerek GPU bellek tüketimini önemli ölçüde azaltan ZeRO optimizasyon stratejisi kullanılarak eğitildiğini belirtmek önemlidir. Bu sayede, 7B ölçeğinde, donanımımızda GPU başına 4096 belirteçlik bir mikro toplu iş boyutuyla eğitim yapılabilir. OLMo-1B ve -7B modelleri için eğitim çerçevesi, yaklaşık 4M belirteçlik (her biri 2048 belirteçlik bir sıra uzunluğuna sahip 2048 örnek) küresel olarak sabit bir toplu iş boyutu kullanır. OLMo-65B modeli (şu anda eğitim aşamasında) için geliştiriciler, yaklaşık 2M belirteçle (1024 örnek) başlayan ve yaklaşık 100M belirtece (16 örnek) ulaşana kadar her 8192B belirteçte bir ikiye katlanan bir toplu iş boyutu ısınması kullanır.

Verimi artırmak için FSDP'nin yerleşik ayarları ve PyTorch'un amplifikatör modülü aracılığıyla karma duyarlıklı eğitim (Micikevicius ve diğerleri, 2017) kullanıyoruz. İkincisi, softmax gibi belirli işlemlerin kararlılığı artırmak için her zaman tam hassasiyetle çalışmasını sağlarken, diğer tüm işlemler bfloat16 formatında yarı hassasiyetle çalışır. Özel ayarlarımız altında, parçalanmış model ağırlıkları ve her bir GPU için yerel optimize edici durumu tam hassasiyette tutulur. Her bir transformatör bloğu içindeki ağırlıklar, ileri ve geri geçişler sırasında her bir GPU'da tam boyutlu parametreler gerçekleştirildiğinde yalnızca bfloat16 formatına dönüştürülür. Gradyanlar GPU'lar genelinde tam hassasiyetle azaltılır.

Doktoru

OLMo çerçevesi, AdamW optimize ediciyi aşağıdaki hiper parametrelerle kullanır.

Tüm model boyutları için, öğrenme oranı ilk 5000 adımda (∼21B jeton) maksimum değere kadar doğrusal olarak ısınır ve ardından adım sayısının ters kareköküyle belirtilen minimum öğrenme oranına doğru doğrusal olarak azalır. Isınma periyodundan sonra model, parametre gradyanlarının toplam l-normu 1.0'ı aşmayacak şekilde gradyanları keser. Aşağıdaki tablo, 7B ölçeğindeki optimize edici ayarlarımızın, AdamW'yi de kullanan diğer yeni LM'lerdeki ayarlarla karşılaştırmasını sunar.

Eğitim verileri

Eğitim, her belgenin sonuna özel bir EOS jetonu ekledikten sonra cümle parçası modeli için eğitim örneklerinin kelime ve BPE tokenizer ile tokenleştirilmesini içerir ve ardından eğitim örnekleri oluşturmak için ardışık 2048 token parçasını gruplandırırız. Eğitim örnekleri, her eğitim çalıştırması için tam olarak aynı şekilde karıştırılır. Her eğitim grubunun veri sırası ve tam bileşimi, yayınladığımız eserlerden yeniden oluşturulabilir. Piyasaya sürülen OLMo modellerinin tümü, en az 2T token (eğitim verileri üzerinde tek bir dönem) için eğitildi ve bazıları, veriler üzerinde farklı bir karıştırma sırası ile ikinci bir dönem başlatılarak bunun ötesinde eğitildi. Bunun tekrarladığı az miktarda veri göz önüne alındığında, ihmal edilebilir bir etkiye sahip olması gerekir.

ÇIKTILAR

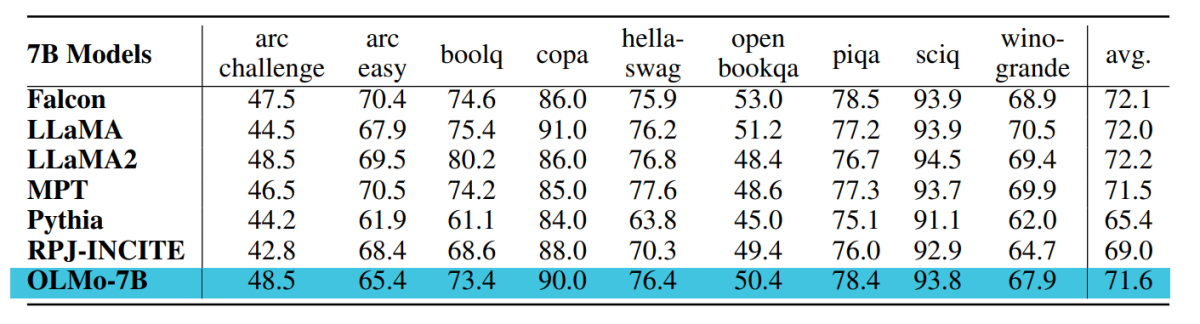

OLMo-7B'nin değerlendirilmesi için kullanılan kontrol noktası, daha önce bahsedilen doğrusal öğrenme oranı azalma çizelgesiyle Dolma veri seti üzerinde 2.46T jetona kadar eğitilir. Bu kontrol noktasının Dolma veri kümesinde doğrusal olarak azalan öğrenme oranıyla 1000 adım için 0'a daha fazla ayarlanması, daha önce açıklanan şaşkınlık ve son görev değerlendirme paketlerindeki model performansını daha da artırır. Son değerlendirme için geliştiriciler OLMo'yu halka açık diğer modellerle (LLaMA-7B, LLaMA2-7B, Pythia-6.9B, Falcon-7B ve RPJ-INCITE-7B) karşılaştırdı.

Aşağı yönde değerlendirme

Temel aşağı yönlü değerlendirme paketi aşağıdaki tabloda özetlenmiştir.

Her durumda sıralama sınıflandırma yaklaşımıyla sıfır atış değerlendirmesi yapıyoruz. Bu yaklaşımda aday metin tamamlamaları (örneğin, farklı çoktan seçmeli seçenekler) olasılığa göre sıralanır (genellikle bazı normalizasyon faktörleriyle normalleştirilir) ve tahmin doğruluğu raporlanır.

Catwalk, jeton başına normalizasyon ve karakter başına normalizasyon gibi birkaç tipik olasılık normalizasyon yöntemi kullanırken, uygulanan normalizasyon stratejileri her veri kümesi için ayrı ayrı seçilir ve yanıtın koşulsuz olasılığını içerir. Daha somut bir ifadeyle, bu, arc ve openbookqa görevleri için normalizasyon, hellaswag, piqa ve winogrande görevleri için jeton başına normalizasyon ve boolq, copa ve sciq görevleri (yani, tek bir jeton tahmin görevine yakın bir formülasyondaki görevler) için normalizasyon içermez.

Aşağıdaki şekil dokuz temel son görev için doğruluk puanının ilerlemesini göstermektedir. OLMo-7B daha fazla token üzerinde eğitildiğinden, OBQA hariç tüm görevler için doğruluk sayısında genel olarak artan bir eğilim olduğu sonucuna varılabilir. Son adım ile ikinci adımdan son adıma kadar birçok görevin doğruluğundaki keskin bir yukarı doğru ilerleme, bize son 0 eğitim adımı boyunca LR'yi doğrusal olarak 1000'a düşürmenin faydasını gösterir. Örneğin, içsel değerlendirmeler söz konusu olduğunda Paloma, her bir alandaki performansın ayrı ayrı incelenmesinden alan kombinasyonları üzerinden daha özetlenmiş sonuçlara kadar bir dizi analiz yoluyla tartışır. Sonuçları iki düzeyde ayrıntı düzeyinde raporluyoruz: Paloma'daki 11 kaynaktan 18'inin toplam performansı ve ayrıca bu kaynakların her biri için ayrı ayrı daha ayrıntılı sonuçlar.

Son Düşüncelerimiz

Bu makalede, geliştiricilere dil modellerini oluşturmak, incelemek ve geliştirmek için bir çerçeve sunmanın yanı sıra, araştırmacıların eğitim ve değerlendirme koduna, eğitim metodolojisine, eğitim verileri, eğitim günlükleri ve ara model kontrol noktaları. Mevcut son teknoloji modeller, değişen derecelerde açıklığa sahipken OLMo modeli, eğitimden verilere ve değerlendirme araçlarına kadar tüm çerçeveyi serbest bırakarak, LLaMA2 modeli gibi son teknoloji modellerle karşılaştırıldığında performanstaki farkı daraltır.