Artificiell intelligens

Stabil videodiffusion: Latenta videodiffusionsmodeller till stora datamängder

Generativ AI har varit en drivande kraft i AI-gemenskapen sedan en tid tillbaka, och de framsteg som gjorts inom området för generativ bildmodellering, särskilt med användningen av diffusionsmodeller, har hjälpt de generativa videomodellerna att utvecklas avsevärt, inte bara inom forskning, utan också i termer av verkliga applikationer. Konventionellt tränas generativa videomodeller antingen från grunden, eller så är de helt eller delvis finjusterade från förtränade bildmodeller med extra temporala lager, på en blandning av bild- och videodatauppsättningar.

I den här artikeln kommer vi att prata om framstegen inom generativa videomodeller Stabil videodiffusionsmodell, en latent videodiffusionsmodell som kan generera högupplöst, toppmodern bild till video och text till videoinnehåll. Vi kommer att prata om hur latenta diffusionsmodeller som tränats för att syntetisera 2D-bilder har förbättrat förmågan och effektiviteten hos generativa videomodeller genom att lägga till temporala lager och finjustera modellerna på små datamängder som består av videor av hög kvalitet. Vi kommer att göra en djupare dykning i arkitekturen och arbetet med den stabila videodiffusionsmodellen, och utvärdera dess prestanda på olika mätvärden och jämföra den med nuvarande toppmoderna ramverk för videogenerering. Så låt oss börja.

Stabil videodiffusionsmodell och generativa videomodeller: en introduktion

Tack vare sin nästan obegränsade potential har Generativ AI varit det primära ämnet för forskning för AI- och ML-utövare ett tag nu, och de senaste åren har det skett snabba framsteg både när det gäller effektivitet och prestanda för generativa bildmodeller. Lärdomarna från generativa bildmodeller har gjort det möjligt för forskare och utvecklare att göra framsteg på generativa videomodeller, vilket resulterar i förbättrad praktiska och verkliga tillämpningar. Men det mesta av forskningen som försöker förbättra kapaciteten hos generativa videomodeller fokuserar i första hand på det exakta arrangemanget av temporala och rumsliga skikt, med liten uppmärksamhet ägnas åt att undersöka inverkan av att välja rätt data på resultatet av dessa generativa modeller.

Tack vare framstegen med generativa bildmodeller har forskare observerat att effekten av distribution av träningsdata på prestanda hos generativa modeller verkligen är betydande och obestridd. Vidare har forskare också observerat att förträning av en generativ bildmodell på en stor och mångsidig datauppsättning följt av finjustering av den på en mindre datauppsättning med bättre kvalitet ofta resulterar i att prestandan förbättras avsevärt. Traditionellt implementerar generativa videomodeller de lärdomar som erhållits från framgångsrika generativa bildmodeller, och forskare har ännu inte studerat effekten av data, och träningsstrategier har ännu inte studerats. Den stabila videodiffusionsmodellen är ett försök att förbättra förmågan hos generativa videomodeller genom att ge sig in i tidigare okända territorier med särskilt fokus på att välja data.

Nya generativa videomodeller förlitar sig på diffusionsmodeller och tillvägagångssätt för textkonditionering eller bildkonditionering för att syntetisera flera konsekventa video- eller bildramar. Diffusionsmodeller är kända för sin förmåga att lära sig hur man gradvis försämrar ett prov från normalfördelning genom att implementera en iterativ förfiningsprocess, och de har levererat önskvärda resultat på högupplöst video och text-till-bild-syntes. Genom att använda samma princip i sin kärna tränar den stabila videodiffusionsmodellen en latent videodiffusionsmodell på sin videodatauppsättning tillsammans med användningen av Generative Adversarial Networks eller GAN, och till och med autoregressiva modeller i viss utsträckning.

Den stabila videodiffusionsmodellen följer en unik strategi som aldrig implementeras av någon generativ videomodell eftersom den bygger på latenta videodiffusionsbaslinjer med en fast arkitektur och en fast träningsstrategi följt av att bedöma effekten av att kurera data. Den stabila videodiffusionsmodellen syftar till att ge följande bidrag inom området generativ videomodellering.

- Att presentera ett systematiskt och effektivt arbetsflöde för datakurering i ett försök att omvandla en stor samling okurerade videoprover till högkvalitativ datauppsättning som sedan används av de generativa videomodellerna.

- Att träna toppmoderna bild till video och text till videomodeller som överträffar befintliga ramverk.

- Genomföra domänspecifika experiment för att undersöka 3D-förståelsen, och stark förekomst av rörelse av modellen.

Nu implementerar den stabila videodiffusionsmodellen lärdomarna från latenta videodiffusionsmodeller och datakureringstekniker i kärnan av dess grund.

Latenta videodiffusionsmodeller

Latenta videodiffusionsmodeller eller video-LDM:er följer tillvägagångssättet att träna den primära generativa modellen i ett latent utrymme med reducerad beräkningskomplexitet, och de flesta video-LDM:er implementerar en förtränad text-till-bild-modell tillsammans med tillägg av temporala blandningsskikt i förträningen arkitektur. Som ett resultat tränar de flesta Video Latent Diffusion Models antingen bara temporala lager eller hoppar över träningsprocessen helt till skillnad från den stabila videodiffusionsmodellen som finjusterar hela ramverket. Dessutom, för att syntetisera text till videodata, villkorar den stabila videodiffusionsmodellen sig själv direkt på en textprompt, och resultaten indikerar att det resulterande ramverket enkelt kan finjusteras till en multi-view-syntes eller en bild till video-modell.

Datakurering

Datakurering är en viktig komponent, inte bara i den stabila videodiffusionsmodellen, utan för generativa modeller som helhet eftersom det är viktigt att förträna stora modeller på storskaliga datauppsättningar för att öka prestanda över olika uppgifter, inklusive språkmodellering, eller diskriminerande text till bildgenerering , och mycket mer. Datakurering har implementerats framgångsrikt på generativa bildmodeller genom att utnyttja kapaciteten hos effektiva språk-bildrepresentationer, även om sådana diskussioner aldrig har fokuserats på för att utveckla generativa videomodeller. Det finns flera hinder som utvecklare möter när de kurerar data för generativa videomodeller, och för att möta dessa utmaningar implementerar den stabila videodiffusionsmodellen en träningsstrategi i tre steg, vilket resulterar i förbättrade resultat och en betydande ökning av prestanda.

Datakurering för högkvalitativ videosyntes

Som diskuterats i det föregående avsnittet implementerar den stabila videodiffusionsmodellen en träningsstrategi i tre steg, vilket resulterar i förbättrade resultat och en betydande ökning av prestanda. Steg I är en bildförträning steg som använder sig av en 2D-text-till-bild-diffusionsmodell. Steg II är för video förträning där ramverket tränar på en stor mängd videodata. Äntligen har vi Steg III för video finjustering där modellen är förfinad på en liten delmängd av högkvalitativa och högupplösta videor.

Innan den stabila videodiffusionsmodellen implementerar dessa tre steg är det dock viktigt att bearbeta och kommentera data eftersom den fungerar som basen för steg II eller videoförträningsstadiet och spelar en avgörande roll för att säkerställa optimal utdata. För att säkerställa maximal effektivitet implementerar ramverket först en kaskadavskärningsdetekteringspipeline vid 3 olika FPS- eller Frames Per Second-nivåer, och behovet av denna pipeline visas i följande bild.

Därefter kommenterar den stabila videodiffusionsmodellen varje videoklipp med hjälp av tre olika syntetiska textningsmetoder. Följande tabell jämför de datauppsättningar som används i det stabila diffusionsramverket före och efter filtreringsprocessen.

Steg I: Bildförträning

Det första steget i den trestegspipeline som implementerats i den stabila videodiffusionsmodellen är bildförträning, och för att uppnå detta grundas det initiala ramverket för stabil videodiffusionsmodell mot en förtränad bilddiffusionsmodell, nämligen Stabil diffusion 2.1 modell som utrustar den med starkare visuella representationer.

Steg II: Videoförträning

Det andra steget är Video Pre-Training-stadiet, och det bygger på resultaten att användningen av datakurering i multimodala generativa bildmodeller ofta resulterar i bättre resultat och ökad effektivitet tillsammans med kraftfull diskriminerande bildgenerering. Men på grund av bristen på liknande kraftfulla representationer från hyllan för att filtrera bort oönskade prover för generativa videomodeller, förlitar sig den stabila videodiffusionsmodellen på mänskliga preferenser som insignaler för att skapa en lämplig datauppsättning som används för att förträna ramverket. Följande figur visar den positiva effekten av att förträna ramverket på en kurerad datauppsättning som hjälper till att öka den övergripande prestandan för videoförträning på mindre datauppsättningar.

För att vara mer specifik använder ramverket olika metoder för att kurera delmängder av Latent Video Diffusion, och tar hänsyn till rangordningen av LVD-modeller som tränats på dessa datamängder. Dessutom finner ramverket för stabil videospridning också att användningen av kurerade datauppsättningar för att träna ramverket hjälper till att öka prestanda för ramverket och spridningsmodeller i allmänhet. Dessutom fungerar datakureringsstrategin också på större, mer relevanta och mycket praktiska datauppsättningar. Följande figur visar den positiva effekten av att förträna ramverket på en kurerad datauppsättning som hjälper till att öka den övergripande prestandan för videoförträning på mindre datauppsättningar.

Steg III: Finjustering av hög kvalitet

Fram till steg II fokuserar ramverket för stabil videodiffusion på att förbättra prestandan före videoförträning, och i det tredje steget lägger ramverket sin tonvikt på att optimera eller ytterligare förstärka ramverkets prestanda efter finjustering av video av hög kvalitet, och hur övergången från steg II till steg III uppnås inom ramen. I steg III bygger ramverket på träningstekniker lånade från latenta bilddiffusionsmodeller och ökar träningsexemplens upplösning. För att analysera effektiviteten av detta tillvägagångssätt jämför ramverket det med tre identiska modeller som endast skiljer sig åt när det gäller deras initialisering. Den första identiska modellen har sina vikter initialiserade, och videoträningsprocessen hoppas över medan de återstående två identiska modellerna initialiseras med vikterna lånade från andra latenta videomodeller.

Resultat och fynd

Det är dags att ta en titt på hur Stable Video Diffusion-ramverket presterar på verkliga uppgifter, och hur det jämförs med dagens toppmoderna ramverk. Ramverket för stabil videodiffusion använder först den optimala datametoden för att träna en basmodell och utför sedan finjustering för att generera flera toppmoderna modeller, där varje modell utför en specifik uppgift.

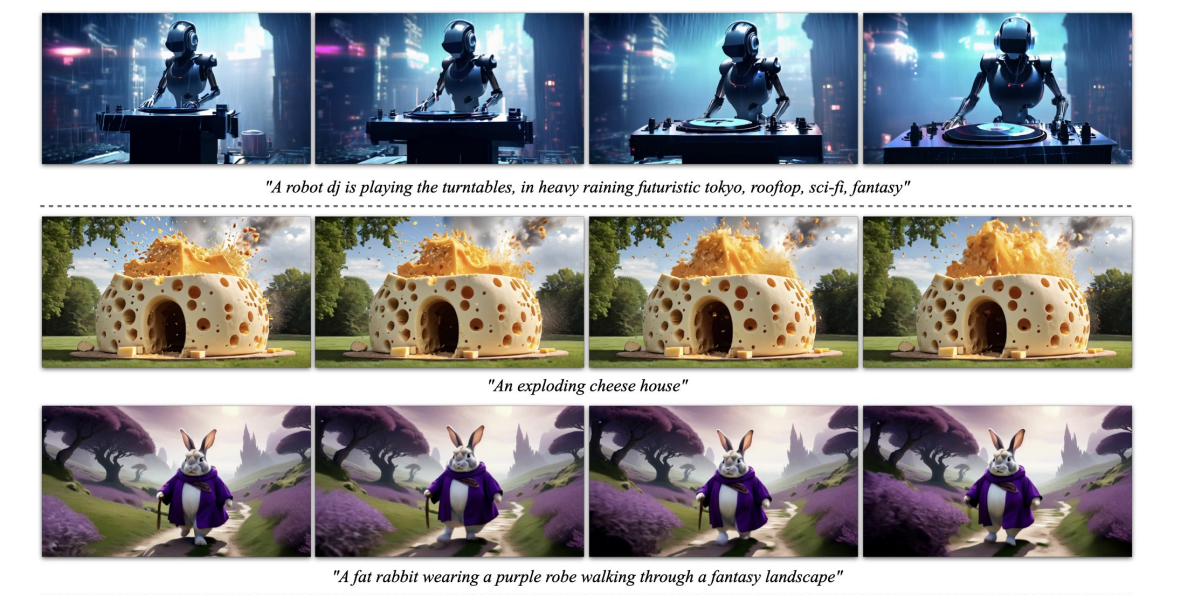

Ovanstående bild representerar de högupplösta bild-till-videosampeln som genereras av ramverket, medan följande figur visar ramverkets förmåga att generera högkvalitativ text till videosampel.

Förutbildad bas MOdel

Som diskuterats tidigare är Stable Video Diffusion-modellen byggd på Stable Diffusion 2.1-ramverket, och på grundval av de senaste rönen var det avgörande för utvecklare att anta brusschemat och öka bruset för att få bilder med bättre upplösning vid träning av bilddiffusion modeller. Tack vare detta tillvägagångssätt lär sig basmodellen Stable Video Diffusion kraftfulla rörelserepresentationer och överträffar i processen baslinjemodeller för text till videogenerering i en nollbildsinställning, och resultaten visas i följande tabell.

Frame Interpolation och Multi-View Generation

Stable Video Diffusion-ramverket finjusterar bilden till videomodellen på multi-view-datauppsättningar för att erhålla flera nya vyer av ett objekt, och denna modell är känd som SVD-MV eller Stable Video Diffusion- Multi View-modellen. Den ursprungliga SVD-modellen finjusteras med hjälp av två datauppsättningar på ett sätt att ramverket matar in en enda bild och returnerar en sekvens av flervybilder som dess utdata.

Som det kan ses på följande bilder, levererar Stable Video Diffusion Multi View-ramverket hög prestanda jämförbar med det senaste Scratch Multi View-ramverket, och resultaten är en tydlig demonstration av SVD-MV:s förmåga att dra fördel av de lärdomar som erhållits från det ursprungliga SVD-ramverket för bildgenerering med flera vyer. Dessutom indikerar resultaten också att att köra modellen för ett relativt mindre antal iterationer hjälper till att leverera optimala resultat, vilket är fallet med de flesta modeller finjusterade från SVD-ramverket.

I ovanstående figur indikeras måtten på vänster sida och som det kan ses överträffar Stable Video Diffusion Multi View-ramverket Scratch-MV och SD2.1 Multi-View-ramverket med en anständig marginal. Den andra bilden visar effekten av antalet träningsiterationer på ramverkets övergripande prestanda i termer av Clip Score, och SVD-MV-ramverken ger hållbara resultat.

Avslutande tankar

I den här artikeln har vi pratat om Stable Video Diffusion, en latent videodiffusionsmodell som kan generera högupplöst, toppmodern bild till video och text till videoinnehåll. Den stabila videodiffusionsmodellen följer en unik strategi som aldrig implementeras av någon generativ videomodell eftersom den bygger på latenta videodiffusionsbaslinjer med en fast arkitektur och en fast träningsstrategi följt av att bedöma effekten av att kurera data.

Vi har pratat om hur latenta diffusionsmodeller som tränats för att syntetisera 2D-bilder har förbättrat förmågan och effektiviteten hos generativa videomodeller genom att lägga till temporala lager och finjustera modellerna på små datamängder som består av videor av hög kvalitet. För att samla in förträningsdata genomför ramverket skalningsstudier och följer systematiska datainsamlingspraxis, och föreslår i slutändan en metod för att sammanställa en stor mängd videodata och konverterar bullriga videor till indata som är lämpliga för generativa videomodeller.

Dessutom använder ramverket för stabil videodiffusion tre distinkta utbildningssteg för videomodeller som analyseras oberoende för att bedöma deras inverkan på ramverkets prestanda. Ramverket matar slutligen ut en videorepresentation som är tillräckligt kraftfull för att finjustera modellerna för optimal videosyntes, och resultaten är jämförbara med toppmoderna videogenereringsmodeller som redan används.