Artificiell intelligens

Multimodal AI utvecklas när ChatGPT får syn med GPT-4V(ision)

I det pågående arbetet med att göra AI mer lik människor, har OpenAI:s GPT-modeller kontinuerligt flyttat gränserna. GPT-4 kan nu acceptera uppmaningar av både text och bilder.

Multimodalitet i generativ AI anger en modells förmåga att producera olika utdata som text, bilder eller ljud baserat på ingången. Dessa modeller, tränade på specifik data, lär sig underliggande mönster för att generera liknande ny data, vilket berikar AI-applikationer.

De senaste framstegen i multimodal AI

Ett nyligen anmärkningsvärt steg på detta område har setts med integrationen av DALL-E 3 i ChatGPT, en betydande uppgradering av OpenAI:s text-till-bild-teknik. Denna blandning möjliggör en smidigare interaktion där ChatGPT hjälper till att skapa exakta uppmaningar för DALL-E 3, och förvandlar användaridéer till levande AI-genererad konst. Så även om användare kan interagera direkt med DALL-E 3, gör ChatGPT i mixen processen att skapa AI-konst mycket mer användarvänlig.

Kolla in mer om DALL-E 3 och dess integration med ChatGPT här.. Det här samarbetet visar inte bara framstegen inom multimodal AI utan gör också att skapande av AI-konst blir en bris för användarna.

Googles hälsa introducerade å andra sidan Med-PaLM M i juni i år. Det är en multimodal generativ modell som är skicklig på att koda och tolka olika biomedicinska data. Detta uppnåddes genom att finjustera PaLM-E, en språkmodell, för att tillgodose medicinska domäner med hjälp av ett benchmark med öppen källkod, MultiMedBench. Detta riktmärke består av över 1 miljon prover över 7 biomedicinska datatyper och 14 uppgifter som svar på medicinska frågor och generering av radiologirapporter.

Olika industrier använder innovativa multimodala AI-verktyg för att driva på företagsexpansion, effektivisera verksamheten och öka kundengagemang. Framsteg inom röst-, video- och text-AI-kapacitet driver på multimodal AI:s tillväxt.

Företag söker multimodala AI-applikationer som kan se över affärsmodeller och processer, öppna tillväxtvägar över det generativa AI-ekosystemet, från dataverktyg till nya AI-applikationer.

Efter lanseringen av GPT-4 i mars, observerade vissa användare en minskning av dess svarskvalitet över tid, en oro som upprepades av anmärkningsvärda utvecklare och på OpenAIs forum. Ursprungligen avfärdad av en OpenAI, senare studera bekräftade problemet. Det avslöjade en minskning av GPT-4:s noggrannhet från 97.6 % till 2.4 % mellan mars och juni, vilket tyder på en minskning av svarskvaliteten med efterföljande modelluppdateringar.

Hype runt omkring Öppna AI ChatGPT är tillbaka nu. Den kommer nu med en vision-funktion GPT-4V, vilket gör det möjligt för användare att låta GPT-4 analysera bilder från dem. Detta är den senaste funktionen som har öppnats för användare.

Att lägga till bildanalys till stora språkmodeller (LLM) som GPT-4 ses av vissa som ett stort steg framåt i AI-forskning och utveckling. Denna typ av multimodal LLM öppnar nya möjligheter, tar språkmodeller bortom text för att erbjuda nya gränssnitt och lösa nya typer av uppgifter, vilket skapar nya upplevelser för användarna.

Utbildningen av GPT-4V avslutades 2022, med tidig åtkomst lanserades i mars 2023. Den visuella funktionen i GPT-4V drivs av GPT-4-teknik. Utbildningsprocessen förblev densamma. Till en början tränades modellen för att förutsäga nästa ord i en text med hjälp av en massiv datauppsättning av både text och bilder från olika källor inklusive internet.

Senare finjusterades det med mer data, med hjälp av en metod som heter förstärkningsinlärning från mänsklig feedback (RLHF), för att generera utdata som människor föredrog.

GPT-4 Vision Mekanik

GPT-4:s anmärkningsvärda synspråksförmåga, även om den är imponerande, har underliggande metoder som finns kvar på ytan.

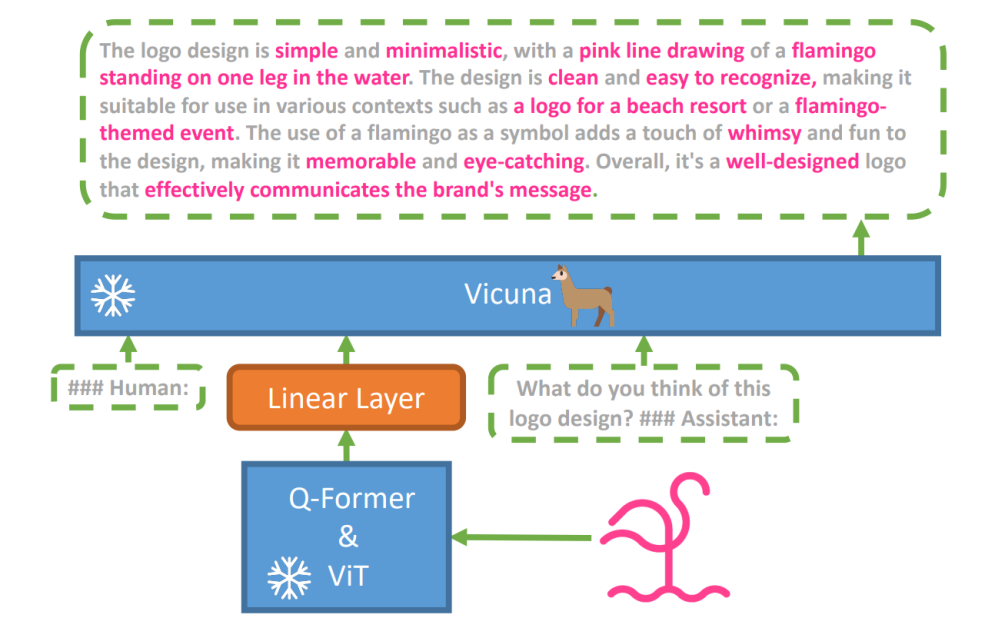

För att utforska denna hypotes, en ny vision-språkmodell, miniGPT-4 introducerades, med hjälp av en avancerad LLM som heter Vicuna. Denna modell använder en vision-kodare med förtränade komponenter för visuell perception, som anpassar kodade visuella funktioner med Vicuna-språkmodellen genom ett enda projektionslager. Arkitekturen i MiniGPT-4 är enkel men effektiv, med fokus på att anpassa visuella och språkliga funktioner för att förbättra visuella konversationsmöjligheter.

MiniGPT-4:s arkitektur inkluderar en vision-kodare med förtränad ViT och Q-Former, ett enda linjärt projektionslager och en avancerad Vicuna-storspråksmodell.

Trenden med autoregressiva språkmodeller i synspråksuppgifter har också vuxit, och drar nytta av cross-modal överföring för att dela kunskap mellan språk och multimodala domäner.

MiniGPT-4 överbryggar visuella och språkliga domäner genom att anpassa visuell information från en förtränad vision-kodare med en avancerad LLM. Modellen använder Vicuna som språkavkodare och följer en träningsmetod i två steg. Inledningsvis tränas den på en stor datamängd av bild-text-par för att förstå vision-språkkunskap, följt av finjustering på en mindre, högkvalitativ datauppsättning för att förbättra generationens tillförlitlighet och användbarhet.

För att förbättra naturligheten och användbarheten av det genererade språket i MiniGPT-4, utvecklade forskare en tvåstegs anpassningsprocess som åtgärdade bristen på adekvata datauppsättningar för anpassning av synspråk. De sammanställde en specialiserad datauppsättning för detta ändamål.

Till en början genererade modellen detaljerade beskrivningar av ingångsbilder, vilket förbättrade detaljerna genom att använda en konversationsprompt anpassad till Vicuna-språkmodellens format. Detta steg syftade till att generera mer omfattande bildbeskrivningar.

Inledande bildbeskrivningsuppmaning:

###Mänsklig: Beskriv denna bild i detalj. Ge så många detaljer som möjligt. Säg allt du ser. ###Assistent:

För efterbearbetning av data korrigerades eventuella inkonsekvenser eller fel i de genererade beskrivningarna med ChatGPT, följt av manuell verifiering för att säkerställa hög kvalitet.

Andra stegets finjusteringsuppmaning:

###Mänsklig: ###Assistent:

Denna utforskning öppnar ett fönster till att förstå mekaniken i multimodal generativ AI som GPT-4, och belyser hur syn och språkmodaliteter effektivt kan integreras för att generera sammanhängande och kontextuellt rika utdata.

Utforska GPT-4 Vision

Bestämma bildens ursprung med ChatGPT

GPT-4 Vision förbättrar ChatGPT:s förmåga att analysera bilder och lokalisera deras geografiska ursprung. Den här funktionen förvandlar användarinteraktioner från bara text till en blandning av text och bilder, och blir ett praktiskt verktyg för de som är nyfikna på olika platser genom bilddata.

Komplexa matematiska begrepp

GPT-4 Vision utmärker sig i att fördjupa sig i komplexa matematiska idéer genom att analysera grafiska eller handskrivna uttryck. Den här funktionen fungerar som ett användbart verktyg för individer som vill lösa intrikata matematiska problem, vilket markerar GPT-4 Vision som ett anmärkningsvärt hjälpmedel inom utbildnings- och akademiska områden.

Konvertera handskriven indata till LaTeX-koder

En av GPT-4V:s anmärkningsvärda förmågor är dess förmåga att översätta handskrivna indata till LaTeX-koder. Den här funktionen är en välsignelse för forskare, akademiker och studenter som ofta behöver konvertera handskrivna matematiska uttryck eller annan teknisk information till ett digitalt format. Förvandlingen från handskriven till LaTeX vidgar horisonten för dokumentdigitalisering och förenklar den tekniska skrivprocessen.

Extrahera tabelldetaljer

GPT-4V visar upp skicklighet i att extrahera detaljer från tabeller och ta itu med relaterade förfrågningar, en viktig tillgång i dataanalys. Användare kan använda GPT-4V för att sålla bland tabeller, samla in viktiga insikter och lösa datadrivna frågor, vilket gör det till ett robust verktyg för dataanalytiker och andra proffs.

Förstå visuell pekning

Den unika förmågan hos GPT-4V att förstå visuell pekning ger en ny dimension till användarinteraktion. Genom att förstå visuella ledtrådar kan GPT-4V svara på frågor med en högre kontextuell förståelse.

Bygg enkla mock-up-webbplatser med hjälp av en ritning

Motiveras av detta tweet, försökte jag skapa en mock-up för webbplatsen unite.ai.

Även om resultatet inte riktigt matchade min ursprungliga vision, här är resultatet jag uppnådde.

Begränsningar och brister hos GPT-4V(ision)

För att analysera GPT-4V genomförde Open AI-teamet kvalitativa och kvantitativa bedömningar. De kvalitativa inkluderade interna tester och externa expertrecensioner, medan de kvantitativa mätte modellvägringar och noggrannhet i olika scenarier som att identifiera skadligt innehåll, demografiskt erkännande, integritetsproblem, geolokalisering, cybersäkerhet och multimodala jailbreaks.

Ändå är modellen inte perfekt.

Smakämnen papper belyser begränsningarna hos GPT-4V, som felaktiga slutsatser och saknad text eller tecken i bilder. Det kan hallucinera eller hitta på fakta. I synnerhet är det inte lämpat för att identifiera farliga ämnen i bilder, ofta felidentifiera dem.

Inom medicinsk bildbehandling kan GPT-4V ge inkonsekventa svar och saknar medvetenhet om standardpraxis, vilket leder till potentiella feldiagnoser.

Otillförlitlig prestanda för medicinska ändamål (Källa)

Det misslyckas också med att förstå nyanserna hos vissa hatsymboler och kan generera olämpligt innehåll baserat på de visuella inputs. OpenAI avråder från att använda GPT-4V för kritiska tolkningar, särskilt i medicinska eller känsliga sammanhang.

Inslag Up

Skapad med Fast Stable Diffusion XL https://huggingface.co/spaces/google/sdxl

Ankomsten av GPT-4 Vision (GPT-4V) tar med sig ett gäng coola möjligheter och nya hinder att hoppa över. Innan det rullas ut har det lagts ner mycket arbete på att se till att risker, särskilt när det kommer till bilder på människor, är väl undersökta och reducerade. Det är imponerande att se hur GPT-4V har ökat, och visar mycket lovande inom knepiga områden som medicin och vetenskap.

Nu finns det några stora frågor på bordet. Ska dessa modeller till exempel kunna identifiera kända personer från foton? Ska de gissa en persons kön, ras eller känslor utifrån en bild? Och borde det finnas speciella justeringar för att hjälpa synskadade individer? Dessa frågor öppnar upp en burk av maskar om integritet, rättvisa och hur AI ska passa in i våra liv, vilket är något som alla borde ha att säga till om.