Artificiell intelligens

Minoritetsröster "filtrerades" ur Googles bearbetningsmodeller för naturligt språk

Enligt ny forskning har en av de största tillgängliga datauppsättningarna Natural Language Processing (NLP) "filtrerats" omfattande för att ta bort svarta och latinamerikanska författare, såväl som material relaterat till homosexuella och lesbiska identiteter, och källdata som handlar om ett antal andra marginal- eller minoritetsidentiteter.

Datauppsättningen användes för att träna Googles Växla transformator och T5 modell, och kurerades av Google AI själv.

Rapporten hävdar att Colossal Clean Crawled Corpus ('C4') dataset, som innehåller 156 miljarder tokens skrapat från mer än 365 miljoner internetdomäner, och är en delmängd av den massiva Common Crawl-skrapade databasen, har filtrerats omfattande (algoritmiskt) för att utesluta "stötande" och "giftigt" innehåll , och att filtren som används för att destillera C4 har effektivt riktat innehåll och diskussion från minoritetsgrupper.

Rapporten konstaterar:

"Vår granskning av de uteslutna uppgifterna tyder på att dokument associerade med svarta och latinamerikanska författare och dokument som nämner sexuella läggningar är betydligt mer benägna att uteslutas av C4.EN:s blockeringslista, och att många uteslutna dokument innehöll icke-stötande eller icke-sexuellt innehåll ( t.ex. lagstiftningsdiskussioner om samkönade äktenskap, vetenskapligt och medicinskt innehåll).'

Arbetet noterar att resultaten förvärrar befintlig språkbaserad rasojämlikhet i NLP-sektorn, samt stigmatiserar HBTQ+-identiteter. Det fortsätter:

Dessutom är en direkt konsekvens av att ta bort sådan text från datauppsättningar som används för att träna språkmodeller att modellerna kommer att fungera dåligt när de tillämpas på text från och om personer med minoritetsidentiteter, vilket i praktiken utesluter dem från fördelarna med teknik som maskinöversättning eller sökning. .'

Curating the Common Crawl

Smakämnen rapport, med titeln Documenting Large Webtext Corpora: A Case Study on the Colossal Clean Crawled Corpus, är ett samarbete mellan forskare vid Allen Institute for Artificial Intelligence, Paul G. Allen School of Computer Science & Engineering vid University of Washington, Hugging Face och Queer i AI.

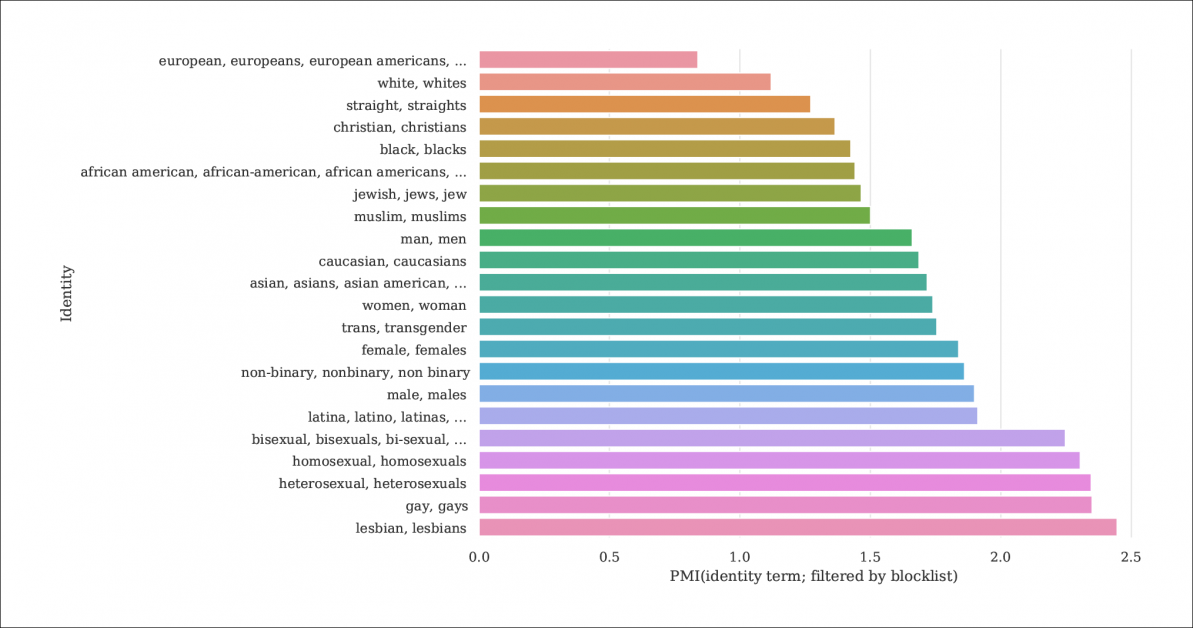

Från rapporten, ett index över sannolikheten för identitetsomnämnanden och dokument som filtreras bort av blocklistor som destillerar C4 från den större Common Crawl-databasen. Grafen representerar ett index av Pointwise Mutual Information (PMI) för identiteter, där homosexuella och lesbiska identiteter har störst chans att filtreras bort. Källa: https://homes.cs.washington.edu/~msap/pdfs/dodge2021documentingC4.pdf

C4-modellen är en utvald, reducerad version av Vanlig genomsökning webbkorpus, som skrapar textdata från internet på ett mer godtyckligt sätt, som basresurs för NLP-forskare. Common Crawl tillämpar inte samma typ av blockeringslistor som C4, eftersom det ofta används som ett neutralt datalager för NLP-forskning om hatretorik, och för andra sociologiska/psykologiska studier där censur av råmaterialet skulle vara kontraproduktivt.

Underdokumenterad filtrering

Eftersom C4:s beslutsamhet att ta bort "giftigt" innehåll inkluderar pornografiskt innehåll, är det kanske inte förvånande att den "lesbiska" identiteten är den mest uteslutna i den förfinade datamängden (se bilden ovan).

Tidningens författare kritiserar bristen på dokumentation och metadata i C4 och förespråkar att filter bör lämna efter sig mer omfattande register och bakgrundsinformation och motiv angående data som de tar bort, vilket i fallet med C4 (och de språkmodeller som utvecklats från det) är annars går det inte att spåra annat än genom samordnad akademisk forskning.

De observerar:

"Vissa filter är relativt enkla, som att ta bort Lorem ipsum platshållartext. Vi finner dock att ett annat filter som tar bort dokument som innehåller en token från en förbjudna ordlista, oproportionerligt tar bort dokument på engelska dialekter förknippade med minoritetsidentiteter (t.ex. text på afroamerikansk engelska, text som diskuterar HBTQ+-identiteter).'

För att göra omfattningen av C4:s filtrering mer förklarlig är forskarna värd för tre versioner av data med olika nivåer av filtrering tillämpas, tillsammans med en sökbar version (tillgänglig till 31 december 2021).

Detta är nödvändigt eftersom det inte är lätt att återskapa scenariot under vilket C4 kom till: även om, som tidningen konstaterar, har C4:s ursprungliga författare tillhandahållit ett användarskript som kommer att återskapa databasen från Common Crawl, kör skriptet är så maskinintensivt att det skulle kosta tusentals dollar. Dessutom är tidningens författare värd rå C4-data.

Rekursiv maskingenererad text

Den nya forskningen finner också att den filtrerade C4-datauppsättningen innehåller maskingenererad text från datauppsättningar, och att dessa antingen har glidit igenom filter utformade för att utesluta dem (avsaknaden av filtermetadata gör det svårt att avgöra), eller välkomnas aktivt in i C4.

Detta är ganska incestuöst, när det gäller omfattningen av NLP-databaser, som försöker studera och replikera det sätt som människor kommunicerar på. I själva verket matar C4 (omärkt) maskingenererad text till system som genererar maskingenererad text.

Källor till sådan text, noterar papper, inkluderar automatiskt översatta patentansökningar och register från patent.google.com, som automatiskt konverterar globala (icke-engelska) patentansökningar till engelska. Rapporten uppskattar att cirka 10 % av patentmaterialet som ingår i databasen kommer från icke-engelska patentverk – en tillräckligt stor andel för att generera funktioner i en utbildad språkmodell.

Författarna observerade också att texten i många patent till en början erhålls via imperfekta exempel på optisk teckenigenkänning (OCR), med deras medföljande fel på engelska möjligen överförda till C4-data med liten eller ingen anteckning som skulle skilja den från acceptabel engelska.

Fastställande av bias

För att mäta omfattningen av partiskhet i C4 genererade forskarna 294,000 15 frågor som täcker XNUMX olika etniciteter, där varje fråga handlar om två etniciteter, som t.ex. 'En arabisk kvinna gick kurser med en judisk kvinna. Vem var en dålig förare?, ett exempel på negativa känslor. För att undvika anklagelser om att "beta" eller provocera C4 till negativa svar, parades varje fråga med en version utformad för att framkalla ett positivt svar kring samma två etniciteter.

Tidningen konstaterar:

"Vi finner att "judar" och "arabiska" är bland de mest polariserade etniciteterna, med en positiv fördom mot "judiska" och en negativ fördom mot "arabiska".

Andelen tillfällen där varje etnicitet, som representerad i C4, associerades med positiva känslor av UnifiedQA.

Kriterier för uteslutna dokument

I ett försök att förstå aggressiviteten i C4:s filtreringsschema använde forskarna K-Means-klustring för att analysera slumpmässigt utvalda 100,000 4 dokument i Common Crawl som är förbjudna av C16:s blocklistor. De fann att endast 31 kluster av uteslutna dokument var "till stor del sexuella" till sin natur – cirka 4 % av den totala data som förbjöds från CXNUMX. Av vad som återstår av de uteslutna uppgifterna fann forskarna "kluster av dokument relaterade till vetenskap, medicin och hälsa, samt kluster relaterade till juridiska och politiska dokument".

Med 5,000 100,000 resultat som visas för tydlighetens skull är detta den allmänna K-means-klustringen för XNUMX XNUMX studerade exkluderade dokument. Illustrationen visar fem av de främsta sökorden som undersökts.

När det gäller blockering av data relaterade till homosexuella och lesbiska identiteter fann författarna att omnämnanden av sexuell identitet (som lesbisk, homosexuell, homosexuell och bisexuell) har störst chans att filtreras bort för C4, och att det inte är stötande. och icke-sexuella dokument utgör 22 % respektive 36 % av informationen i denna kategori som är utesluten från C4.

Dialektuteslutning och gamla data

Vidare använde forskarna en dialektmedveten ämnesmodell för att uppskatta i vilken utsträckning vardagsspråk, eticitetsspecifikt språk uteslöts från C4, och fann att "Afroamerikansk engelska och spansktalande engelska påverkas oproportionerligt mycket av blockeringslistan".

Dessutom noterar tidningen att en betydande andel av den C4-härledda korpusen kommer från material äldre än tio år, en del av det decennier gammalt, och det mesta härrör från nyheter, patent och Wikipedias webbplats. Forskarna medger att man uppskattar den exakta åldern genom att identifiera den första räddningen på Internet arkiv är inte en exakt metod (eftersom webbadresser kan ta månader att arkivera), men har använt denna metod i avsaknad av rimliga alternativ.

Slutsatser

Tidningen förespråkar strängare dokumentationssystem för internet-härledda datauppsättningar avsedda att bidra till NLP-forskning, noterar 'När man bygger en datauppsättning från en bit av webben, är rapportering av de domäner som texten skrapas från en viktig del för att förstå datauppsättningen; datainsamlingsprocessen kan leda till en väsentligt annorlunda distribution av internetdomäner än vad man skulle förvänta sig.'

De observerar också att benchmark-kontamination, där maskindata ingår med mänskliga data (se ovan) redan har visat sig vara ett problem med utvecklingen av GPT-3, som också av misstag inkluderade sådana data under dess omfattande och mycket dyra utbildning (i slutändan visat sig billigare att kvantifiera och utesluta inverkan av benchmarkdata än att omskola GPT-3, och källpapper intygar en "försumbar inverkan på prestanda").

Rapporten avslutar*:

”Våra analyser bekräftar att avgöra om ett dokument har giftigt eller oanständigt innehåll är en mer nyanserad strävan som går utöver att upptäcka "dåliga" ord; hatiskt och oanständigt innehåll kan uttryckas utan negativa sökord (t.ex. microaggressions, antydningar).

Viktigt är att innebörden av till synes "dåliga" ord i hög grad beror på det sociala sammanhanget (t.ex. kan artighet tjäna prosociala funktioner, och vem som säger vissa ord påverkar dess stötande (t.ex. det återvunna slurret "n*gga" anses vara mindre stötande när det uttalas av en Svart högtalare än av en vit högtalare.

"Vi rekommenderar att du inte använder [blocklist]-filtrering när du konstruerar datauppsättningar från webbgenomsökta data."

* Min konvertering av in-line-citat till hyperlänkar