Tanke ledare

Avkodning av möjligheter och utmaningar för LLM-agenter i generativ AI

Vi ser en utveckling av Generativa AI-applikationer som drivs av stora språkmodeller (LLM) från uppmaningar till RAG (Retrieval Augmented Generation) till agenter. Det talas mycket om agenter i industri- och forskningskretsar, främst för den kraft som denna teknik ger för att transformera Enterprise-applikationer och ge överlägsna kundupplevelser. Det finns vanliga mönster för byggmedel som möjliggör första steg mot artificiell allmän intelligens (AGI).

I mitt tidigare Artikeln, såg vi en stege av intelligens av mönster för att bygga LLM-drivna applikationer. Börjar med uppmaningar som fångar problemdomänen och använder LLM internminne för att generera utdata. Med RAG utökar vi prompten med extern kunskap som sökts från en vektordatabas för att kontrollera utdata. Därefter kan vi genom att kedja LLM-samtal bygga arbetsflöden för att realisera komplexa applikationer. Agenter tar detta till en nästa nivå genom att automatiskt bestämma hur dessa LLM-kedjor ska bildas. Låt oss titta i detalj.

Agenter – under huven

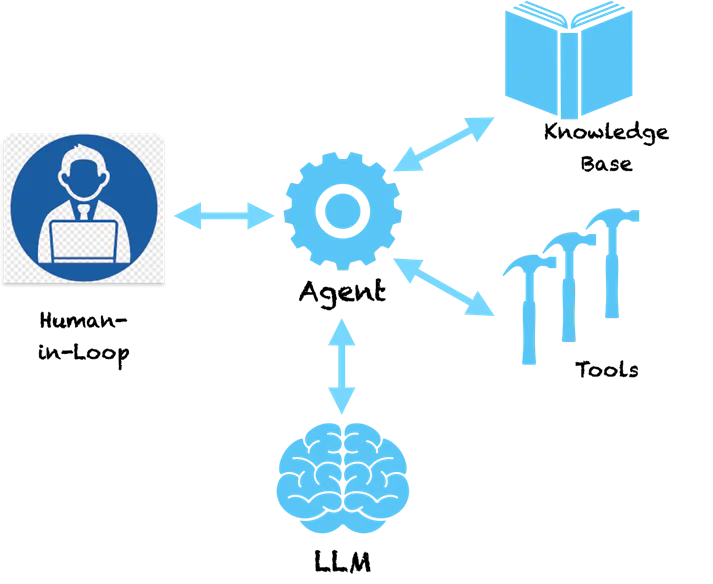

Ett nyckelmönster hos agenter är att de använder språkförståelsekraften hos LLM för att göra en plan för hur ett givet problem ska lösas. LLM förstår problemet och ger oss en sekvens av steg för att lösa problemet. Det slutar dock inte där. Agenter är inte ett rent stödsystem som ger dig rekommendationer för att lösa problemet och sedan skickar stafettpinnen till dig att vidta de rekommenderade stegen. Agenter är bemyndigade med verktyg för att gå vidare och vidta åtgärder. Skrämmande va!?

Om vi ställer en agent en grundläggande fråga som denna:

Mänskligt: Vilket företag startade uppfinnaren av telefonen?

Nedan följer ett urval av tankesteg som en agent kan vidta.

Agent (FÄNKER):

- Tanke: Jag måste söka efter telefonens uppfinnare.

- Handling: Sök [telefonens uppfinnare]

- Observation: Alexander Graham Bell

- Tanke: Jag måste söka efter ett företag som grundades av Alexander Graham Bell

- Handling: Sök [företag grundat av Alexander Graham Bell]

- Observation: Alexander Graham Bell var med och grundade American Telephone and Telegraph Company (AT&T) 1885

- Tanke: Jag har hittat svaret. Jag kommer tillbaka.

Agent (RESPONSE): Alexander Graham Bell var med och grundade AT&T 1885

Du kan se att agenten följer ett metodiskt sätt att bryta ner problemet i delproblem som kan lösas genom att vidta specifika åtgärder. Åtgärderna här rekommenderas av LLM och vi kan mappa dessa till specifika verktyg för att implementera dessa åtgärder. Vi skulle kunna aktivera ett sökverktyg för agenten så att när den inser att LLM har tillhandahållit sökning som en åtgärd, kommer den att anropa detta verktyg med parametrarna som tillhandahålls av LLM. Sökningen här är på internet men kan likaväl omdirigeras till att söka i en intern kunskapsbas som en vektordatabas. Systemet blir nu självförsörjande och kan ta reda på hur man löser komplexa problem efter en rad steg. Ramar som Langkedja och LLaMAIndex ger dig ett enkelt sätt att bygga dessa agenter och ansluta till verktyg och API. Amazon lanserade nyligen sitt ramverk för Bedrock Agents som ger ett visuellt gränssnitt för att designa agenter.

Under huven följer agenter en speciell stil att skicka uppmaningar till LLM som får dem att skapa en handlingsplan. Ovanstående tanke-handling-observationsmönster är populärt i en typ av agent som kallas ReAct (Reasoning and Acting). Andra typer av agenter inkluderar MRKL och Plan & Execute, som huvudsakligen skiljer sig åt i sin uppmaningsstil.

För mer komplexa agenter kan åtgärderna vara knutna till verktyg som orsakar förändringar i källsystem. Vi skulle till exempel kunna koppla agenten till ett verktyg som kontrollerar semestersaldo och ansöker om ledighet i ett affärssystem för en anställd. Nu kunde vi bygga en trevlig chatbot som skulle interagera med användare och via ett chattkommando ansöka om ledighet i systemet. Inga fler komplicerade skärmar för att ansöka om löv, ett enkelt enhetligt chattgränssnitt. Låter spännande!?

Varningar och behov av ansvarsfull AI

Tänk nu om vi har ett verktyg som åberopar transaktioner vid aktiehandel med ett förauktoriserat API. Du bygger en applikation där agenten studerar aktieförändringar (med hjälp av verktyg) och fattar beslut åt dig om köp och försäljning av aktier. Tänk om agenten säljer fel aktie för att den hallucinerade och fattade ett felaktigt beslut? Eftersom LLM är enorma modeller är det svårt att peka ut varför de fattar vissa beslut, därför är hallucinationer vanliga i avsaknad av ordentliga skyddsräcken.

Även om agenter alla är fascinerande skulle du förmodligen ha gissat hur farliga de kan vara. Om de hallucinerar och vidtar en felaktig åtgärd som kan orsaka stora ekonomiska förluster eller stora problem i Enterprise-system. Därför blir Ansvarsfull AI av yttersta vikt i en ålder av LLM-drivna applikationer. Principerna för Responsible AI kring reproducerbarhet, transparens och ansvarsskyldighet försöker sätta skyddsräcken för beslut som fattas av agenter och föreslår riskanalyser för att avgöra vilka åtgärder som behöver en människa-i-loopen. När mer komplexa agenter designas behöver de mer granskning, transparens och ansvarsskyldighet för att se till att vi vet vad de gör.

Slutsatser

Agenternas förmåga att skapa en väg av logiska steg med handlingar gör att de kommer riktigt nära mänskligt resonemang. Att ge dem kraftfullare verktyg kan ge dem superkrafter. Mönster som ReAct försöker efterlikna hur människor löser problemet och vi kommer att se bättre agentmönster som kommer att vara relevanta för specifika sammanhang och domäner (bank, försäkring, sjukvård, industri, etc.). Framtiden är här och tekniken bakom agenter är redo för oss att använda. Samtidigt måste vi hålla noggrann uppmärksamhet på Responsible AI-räcken för att se till att vi inte bygger Skynet!