Kunstig intelligens

UniTune: Googles alternative nevrale bilderedigeringsteknikk

Google Research, ser det ut til, angriper tekstbasert bilderedigering fra en rekke fronter, og antagelig venter på å se hva som "tar". Hot på sporet av denne ukens utgivelse av sin Imagisk papir, har søkegiganten foreslått en ekstra latent diffusjonsbasert metode for å utføre ellers umulige AI-baserte redigeringer på bilder via tekstkommandoer, denne gangen kalt UniTune.

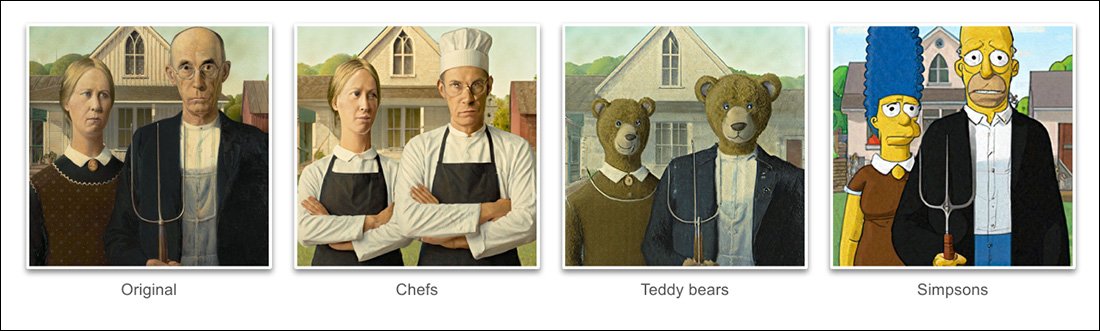

Basert på eksemplene gitt i prosjektets nytt papir, UniTune har oppnådd en ekstraordinær grad av løsrivelse av semantisk positur og idé fra faktisk hardt bildeinnhold:

UniTunes beherskelse av semantisk komposisjon er enestående. Legg merke til hvordan ansiktene til de to personene i den øverste raden med bilder ikke har blitt forvrengt av den ekstraordinære transformasjonen på resten av kildebildet (til høyre). Kilde: https://arxiv.org/pdf/2210.09477.pdf

Som Stable Diffusion-fans vil ha lært nå, kan det være en vanskelig, noen ganger umulig operasjon, å redigere deler av et bilde uten å endre resten av bildet negativt. Selv om populære distribusjoner som f.eks AUTOMATISK1111 kan lage masker for lokale og begrensede redigeringer, prosessen er kronglete og ofte uforutsigbar.

Det åpenbare svaret, i det minste for en datasynsutøver, er å legge inn et lag av semantisk segmentering som er i stand til å gjenkjenne og isolere objekter i et bilde uten brukerintervensjon, og det har faktisk vært flere nye initiativ i det siste langs denne tankegangen.

En annen mulighet for å låse rotete og sammenfiltrede nevrale bilderedigeringsoperasjoner er å utnytte OpenAIs innflytelsesrike Contrastive Language–Image Pre-training (CLIP)-modulen, som er kjernen i latente diffusjonsmodeller som DALL-E 2 og Stable Diffusion, for å fungere som et filter på punktet der en tekst-til-bilde-modell er klar til å sende en tolket gjengivelse tilbake til brukeren . I denne sammenhengen bør CLIP fungere som en vaktholds- og kvalitetskontrollmodul, som avviser misformede eller på annen måte uegnede gjengivelser. Dette er i ferd med å bli innført (Discord-lenke) på Stability.ai sin DreamStudio API-drevne portal.

Men siden CLIP uten tvil er både den skyldige og løsningen i et slikt scenario (fordi det i hovedsak også informerte om måten bildet ble utviklet på), og siden maskinvarekravene kan overstige det som sannsynligvis vil være tilgjengelig lokalt for en sluttbruker, denne tilnærmingen er kanskje ikke ideell.

Komprimert språk

Den foreslåtte UniTune 'finjusterer' i stedet en eksisterende diffusjonsmodell – i dette tilfellet Googles egen Imagen, selv om forskerne uttaler at metoden er kompatibel med andre latente diffusjonsarkitekturer – slik at en unik token injiseres i den som kan fremkalles ved å inkludere det i en tekstmelding.

Til pålydende høres dette ut som Google drømmebod, for tiden en besettelse blant Stable Diffusion-fans og utviklere, som kan injisere nye karakterer eller objekter i et eksisterende sjekkpunkt, ofte på mindre enn en time, basert på bare en håndfull kildebilder; eller lignende Tekstinversjon, som lager 'sidecar'-filer for et sjekkpunkt, som deretter behandles som om de opprinnelig ble trent inn i modellen, og kan dra nytte av modellens egne enorme ressurser ved å endre tekstklassifisereren, noe som resulterer i en liten fil (sammenlignet med minimum 2 GB beskjærte sjekkpunkter av DreamBooth).

Faktisk, hevder forskerne, avviste UniTune begge disse tilnærmingene. De fant ut at Textual Inversion utelot for mange viktige detaljer, mens DreamBooth "presterte dårligere og tok lengre tid" enn løsningen de til slutt slo seg på.

Ikke desto mindre bruker UniTune den samme innkapslede semantiske 'metaprompt'-tilnærmingen som DreamBooth, med trente endringer fremkalt av unike ord valgt av treneren, som ikke vil kollidere med noen termer som for tiden eksisterer i en møysommelig trent offentlig utgivelsesmodell.

'For å utføre redigeringsoperasjonen prøver vi de finjusterte modellene med ledeteksten "[rare_tokens] edit_prompt" (f.eks. "beikkpic to dogs in a restaurant" eller "beikkpic a minion").'

Prosessen

Selv om det er mystisk hvorfor to nesten identiske papirer, når det gjelder sluttfunksjonalitet, skulle komme fra Google i samme uke, er det, til tross for et stort antall likheter mellom de to initiativene, minst én klar forskjell mellom UniTune og Imagic – sistnevnte bruker "ukomprimerte" naturlige språkforespørsler for å veilede bilderedigeringsoperasjoner, mens UniTune trener i unike DreamBooth-stil-tokens.

Derfor, hvis du redigerte med Imagic og ønsket å gjennomføre en transformasjon av denne art...

Fra UniTune-avisen – UniTune setter seg mot Googles favoritt rivaliserende nevrale redigeringsrammeverk, SDEdit. UniTunes resultater er helt til høyre, mens den estimerte masken sees på det andre bildet fra venstre.

.. i Imagic ville du legge inn 'den tredje personen, som sitter i bakgrunnen, som et søtt furry monster'.

Den tilsvarende UniTune-kommandoen ville være «Fyr bak som [x]», Hvor x er det rare og unike ordet som var bundet til det fintrente konseptet knyttet til den lodne monsterkarakteren.

Mens en rekke bilder mates inn i enten DreamBooth eller Textual Inversion med den hensikt å skape en abstraksjon i dypfalsk stil som kan kommanderes i mange positurer, mater både UniTune og Imagic i stedet et enkelt bilde inn i systemet – det originale, uberørte bildet.

Dette ligner på måten mange av de GAN-baserte redigeringsverktøyene de siste årene har fungert – ved å konvertere et inngangsbilde til latente koder i GANs latente rom og deretter adressere disse kodene og sende dem til andre deler av den latente plass for modifikasjon (dvs. legge inn et bilde av en ung mørkhåret person og projisere det gjennom latente koder assosiert med 'gammel' eller 'blond' osv.).

Imidlertid er resultatene, i en diffusjonsmodell, og ved denne metoden, ganske oppsiktsvekkende nøyaktige ved sammenligning, og langt mindre tvetydige:

Finjusteringsprosessen

UniTune-metoden sender i hovedsak det originale bildet gjennom en diffusjonsmodell med et sett med instruksjoner om hvordan det skal modifiseres, ved å bruke de enorme lagrene av tilgjengelige data som er trent inn i modellen. Faktisk kan du gjøre dette akkurat nå med Stable Diffusion's img2img funksjonalitet – men ikke uten å vri eller på en eller annen måte endre delene av bildet du foretrekker å beholde.

Under UniTune-prosessen er systemet fin toned, som vil si at UniTune tvinger modellen til å gjenoppta treningen, med de fleste lagene ufrosne (se nedenfor). I de fleste tilfeller vil finjustering fylle overallen generell tapsverdier for en hardt vunnet høyytelsesmodell til fordel for å injisere eller foredle et annet aspekt som ønskes opprettet eller forbedret.

Med UniTune ser det imidlertid ut til at modelleksemplaret som har handlet på, selv om det kan veie flere gigabyte eller mer, vil bli behandlet som et engangssikkerhets-"husk", og kastet på slutten av prosessen, etter å ha tjent et enkelt mål. Denne typen tilfeldig datatonnasje er i ferd med å bli en daglig lagringskrise for DreamBooth-fans, hvis egne modeller, selv når de er beskjært, er på ikke mindre enn 2 GB per emne.

Som med Imagic, skjer hovedinnstillingen i UniTune ved de to nederste av de tre lagene i Imagen (base 64px, 64px>256px og 256px>1024px). I motsetning til Imagic, ser forskerne en potensiell verdi i å optimalisere tuningen også for dette siste og største superoppløsningslaget (selv om de ikke har forsøkt det ennå).

For det laveste 64px-laget er modellen forspent mot basisbildet under trening, med flere duplikatpar av bilde/tekst matet inn i systemet for 128 iterasjoner ved en batchstørrelse på 4, og med Adafaktor som tapsfunksjon, som opererer med en læringsrate på 0.0001. Selv om T5-koder alene er frosset under denne finjusteringen, fryses det også under primærtrening av Imagen

Operasjonen ovenfor gjentas deretter for 64>256px-laget, ved å bruke samme prosedyre for støyforsterkning som ble brukt i den opprinnelige opplæringen av Imagen.

sampling

Det er mange mulige prøvetakingsmetoder der endringene som er gjort kan fremkalles fra den finjusterte modellen, inkludert Classifier Free Guidance (CFG), en bærebjelke også for stabil diffusjon. CFG definerer i utgangspunktet i hvilken grad modellen er fri til å "følge sin fantasi" og utforske gjengivelsesmulighetene – ellers, ved lavere innstillinger, i hvilken grad den skal følge inndatakildedataene, og gjøre mindre omfattende eller dramatiske endringer .

I likhet med Textual Inversion (litt mindre med DreamBooth), er UniTune egnet til å bruke distinkte grafiske stiler på originale bilder, så vel som mer fotorealistiske redigeringer.

Forskerne eksperimenterte også med SDEditt's 'sen start'-teknikk, der systemet oppfordres til å bevare originale detaljer ved å bare være delvis 'støy' fra begynnelsen, men heller opprettholde sine essensielle egenskaper. Selv om forskerne bare brukte dette på det laveste av lagene (64px), tror de at det kan være en nyttig tilleggsprøvetakingsteknikk i fremtiden.

Forskerne utnyttet også ledetekst-til-spørring som en ekstra tekstbasert teknikk for å kondisjonere modellen:

«I «spørsmål»-innstillingen fant vi ut at en teknikk vi kaller promptveiledning er spesielt nyttig for å stille inn troskap og uttrykksevne.

'Spørreveiledning ligner på klassifiseringsfri veiledning, bortsett fra at grunnlinjen er en annen melding i stedet for den ubetingede modellen. Dette leder modellen mot deltaet mellom de to ledetekstene.'

Imidlertid var rask veiledning, opplyser forfatterne, bare nødvendig av og til i tilfeller der CFG ikke klarte å oppnå ønsket resultat.

En annen ny prøvetakingstilnærming som ble oppdaget under utviklingen av UniTune var interpole, hvor områder av bildet er såpass atskilte at både det originale og det endrede bildet er svært like i komposisjon, noe som gjør at en mer 'naiv' interpolasjon kan brukes.

Interpolering kan gjøre de mer anstrengte prosessene til UniTune overflødige i tilfeller der områder som skal transformeres er diskrete og med god margin.

Forfatterne foreslår at interpolering potensielt kan fungere så bra for et stort antall målkildebilder at den kan brukes som standardinnstilling, og observerer også at den har makt til å utføre ekstraordinære transformasjoner i tilfeller der komplekse okklusjoner ikke må forhandles med mer intensive metoder.

UniTune kan utføre lokale redigeringer med eller uten redigeringsmasker, men kan også bestemme ensidig hvor redigeringer skal plasseres, med en uvanlig kombinasjon av tolkningskraft og robust essensialisering av kildedataene:

I det øverste bildet i den andre kolonnen har UniTune, som har i oppgave å sette inn et "rødt tog i bakgrunnen" plassert det i en passende og autentisk posisjon. Legg merke til i de andre eksemplene hvordan semantisk integritet til kildebildet opprettholdes selv midt i ekstraordinære endringer i pikselinnholdet og kjernestilene til bildene.

Ventetid

Selv om den første gjentakelsen av et nytt system kommer til å gå sakte, og selv om det er mulig at enten samfunnsengasjement eller bedriftsengasjement (det er vanligvis ikke begge deler) til slutt vil fremskynde og optimere en ressurstung rutine, utfører både UniTune og Imagic noen ganske store maskinlæringsmanøvrer for å lage disse fantastiske redigeringene, og det er tvilsomt i hvilken grad en slik ressurskrevende prosess noen gang kan skaleres ned til innenlandsbruk, snarere enn API-drevet tilgang (selv om sistnevnte kan være mer ønskelig for Google ).

For øyeblikket er rundturen fra input til resultat omtrent 3 minutter på en T4 GPU, med rundt 30 sekunder ekstra for inferens (som i enhver inferensrutine). Forfatterne innrømmer at dette er høy latens, og neppe kvalifiserer som "interaktiv", men de bemerker også at modellen forblir tilgjengelig for ytterligere redigeringer når den først er innstilt, til brukeren er ferdig med prosessen, som reduserer tiden per redigering. .

Først publisert 21. oktober 2022.