Grafer er datastrukturer som representerer komplekse relasjoner på tvers av et bredt spekter av domener, inkludert sosiale nettverk, kunnskapsbaser, biologiske systemer og mange flere. I disse grafene er enheter representert som noder, og deres relasjoner er avbildet som kanter.

Evnen til effektivt å representere og resonnere rundt disse intrikate relasjonsstrukturene er avgjørende for å muliggjøre fremskritt innen felt som nettverksvitenskap, kjeminformatikk og anbefalingssystemer.

Graph Neural Networks (GNNs) har dukket opp som et kraftig dyplæringsrammeverk for grafiske maskinlæringsoppgaver. Ved å inkorporere graftopologien i den nevrale nettverksarkitekturen gjennom nabolagsaggregering eller grafviklinger, kan GNN-er lære lavdimensjonale vektorrepresentasjoner som koder for både nodefunksjonene og deres strukturelle roller. Dette lar GNN-er oppnå toppmoderne ytelse på oppgaver som nodeklassifisering, koblingsprediksjon og grafklassifisering på tvers av forskjellige applikasjonsområder.

Mens GNN-er har drevet betydelig fremgang, gjenstår det noen viktige utfordringer. Å skaffe merket data av høy kvalitet for opplæring av overvåkede GNN-modeller kan være dyrt og tidkrevende. I tillegg kan GNN-er slite med heterogene grafstrukturer og situasjoner der graffordelingen på testtidspunktet skiller seg betydelig fra treningsdataene (generalisering utenfor distribusjon).

Parallelt kan store språkmodeller (LLM) som GPT-4, og Samtaler har tatt verden med storm med sin utrolige naturlige språkforståelse og generasjonsevner. Opplært på massive tekstkorpuer med milliarder av parametere, viser LLM-er bemerkelsesverdige få-skudds læringsevner, generalisering på tvers av oppgaver og sunne resonnementferdigheter som en gang ble antatt å være ekstremt utfordrende for AI-systemer.

Den enorme suksessen til LLM-er har katalysert utforskninger for å utnytte kraften deres til grafiske maskinlæringsoppgaver. På den ene siden gir kunnskapen og resonneringsevnen til LLM-er muligheter for å forbedre tradisjonelle GNN-modeller. Motsatt kan de strukturerte representasjonene og faktakunnskapen som ligger i grafer, være medvirkende til å adressere noen viktige begrensninger ved LLM-er, som hallusinasjoner og mangel på tolkbarhet.

I denne artikkelen vil vi fordype oss i den nyeste forskningen i skjæringspunktet mellom grafisk maskinlæring og store språkmodeller. Vi vil utforske hvordan LLM-er kan brukes til å forbedre ulike aspekter av graf-ML, gjennomgå tilnærminger for å inkorporere grafkunnskap i LLM-er, og diskutere nye applikasjoner og fremtidige retninger for dette spennende feltet.

Graf nevrale nettverk og selvstyrt læring

For å gi den nødvendige konteksten, vil vi først kort gjennomgå kjernekonseptene og metodene i grafnevrale nettverk og selvovervåket grafrepresentasjonslæring.

Graf nevrale nettverksarkitekturer

Graph Neural Network Architecture – kilde

Nøkkelforskjellen mellom tradisjonelle dype nevrale nettverk og GNN-er ligger i deres evne til å operere direkte på grafstrukturerte data. GNN-er følger et nabolagsaggregeringsskjema, der hver node aggregerer funksjonsvektorer fra naboene for å beregne sin egen representasjon.

Tallrike GNN-arkitekturer har blitt foreslått med forskjellige instansiasjoner av meldingen og oppdateringsfunksjoner, som f.eks. Grafkonvolusjonsnettverk (GCN-er), GrafSAGE, Graph Attention Networks (GAT-er), og Graph Isomorphism Networks (GIN) blant andre.

Nylig har graftransformatorer vunnet popularitet ved å tilpasse selvoppmerksomhetsmekanismen fra transformatorer for naturlig språk til å operere på grafstrukturerte data. Noen eksempler inkluderer GraphomerTransformerog GraphFormers. Disse modellene er i stand til å fange langdistanseavhengigheter på tvers av grafen bedre enn rent nabolagsbaserte GNN-er.

Selvstyrt læring på grafer

Mens GNN-er er kraftige representasjonsmodeller, er ytelsen deres ofte flaskehalset av mangelen på store merkede datasett som kreves for veiledet opplæring. Selvovervåket læring har dukket opp som et lovende paradigme for å forhåndstrene GNN-er på umerkede grafdata ved å utnytte påskuddsoppgaver som bare krever den iboende grafstrukturen og nodefunksjonene.

Noen vanlige påskuddsoppgaver som brukes til selvovervåket GNN-foropplæring inkluderer:

- Forutsigelse av nodeegenskap: Tilfeldig maskering eller ødeleggelse av en del av nodeattributtene/funksjonene og gi GNN i oppgave å rekonstruere dem.

- Edge/Link Prediction: Lære å forutsi om det eksisterer en kant mellom et par noder, ofte basert på tilfeldig kantmaskering.

- Kontrastiv læring: Maksimere likheter mellom grafvisninger av samme grafeksempel mens du skyver fra hverandre visninger fra forskjellige grafer.

- Maksimering av gjensidig informasjon: Maksimerer den gjensidige informasjonen mellom lokale noderepresentasjoner og en målrepresentasjon som den globale grafinnbyggingen.

Påskuddsoppgaver som disse lar GNN trekke ut meningsfulle strukturelle og semantiske mønstre fra de umerkede grafdataene under forhåndstrening. Den forhåndstrente GNN-en kan deretter finjusteres på relativt små merkede undersett for å utmerke seg ved forskjellige nedstrømsoppgaver som nodeklassifisering, koblingsprediksjon og grafklassifisering.

Ved å utnytte selvtilsyn, viser GNN-er som er forhåndstrent på store umerkede datasett bedre generalisering, robusthet til distribusjonsskifter og effektivitet sammenlignet med trening fra bunnen av. Imidlertid gjenstår noen viktige begrensninger ved tradisjonelle GNN-baserte selvovervåkede metoder, som vi vil utforske å utnytte LLM-er for å ta tak i neste gang.

Forbedre Graph ML med store språkmodeller

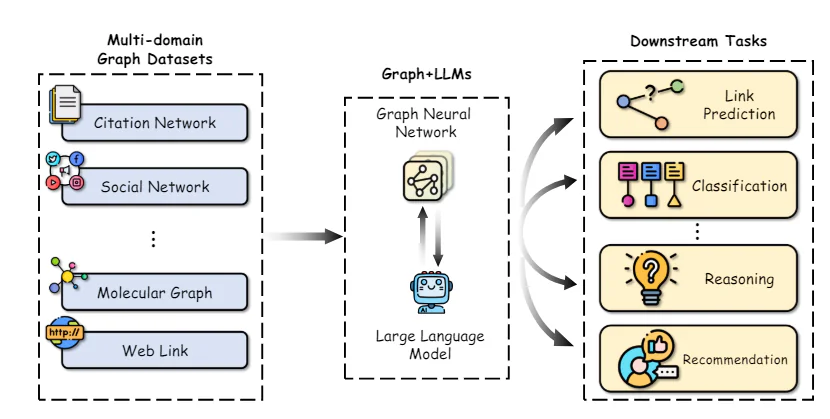

Integrasjon av grafer og LLM – kilde

De bemerkelsesverdige egenskapene til LLM-er når det gjelder å forstå naturlig språk, resonnement og få-skuddslæring gir muligheter til å forbedre flere aspekter ved grafisk maskinlæringspipelines. Vi utforsker noen sentrale forskningsretninger i dette rommet:

En nøkkelutfordring ved bruk av GNN-er er å oppnå funksjonsrepresentasjoner av høy kvalitet for noder og kanter, spesielt når de inneholder rike tekstattributter som beskrivelser, titler eller sammendrag. Tradisjonelt har man brukt enkle bag-of-words eller forhåndstrente ordinnbyggingsmodeller, som ofte ikke klarer å fange opp den nyanserte semantikken.

Nyere arbeider har demonstrert kraften i å utnytte store språkmodeller som tekstkodere for å konstruere bedre node-/kantfunksjonsrepresentasjoner før de overføres til GNN. For eksempel, Chen et al. bruke LLM-er som GPT-3 for å kode tekstlige nodeattributter, og viser betydelig ytelsesgevinst i forhold til tradisjonelle ordinnbygginger på nodeklassifiseringsoppgaver.

Utover bedre tekstkodere, kan LLM-er brukes til å generere utvidet informasjon fra de originale tekstattributtene på en semi-overvåket måte. TEIP genererer potensielle etiketter/forklaringer for noder som bruker en LLM og bruker disse som ekstra utvidede funksjoner. KEA trekker ut termer fra tekstattributter ved å bruke en LLM og innhenter detaljerte beskrivelser for disse termene for å utvide funksjonene.

Ved å forbedre kvaliteten og uttrykksevnen til inndatafunksjoner, kan LLM-er gi sine overlegne naturlige språkforståelsesevner til GNN-er, og øke ytelsen på nedstrømsoppgaver.

Lindre avhengighet av merkede data

En viktig fordel med LLM-er er deres evne til å yte rimelig godt på nye oppgaver med lite eller ingen merket data, takket være deres forhåndsopplæring på store tekstkorpora. Denne få-skudds læringsevnen kan utnyttes for å lindre avhengigheten av GNN-er på store merkede datasett.

En tilnærming er å bruke LLM-er til direkte å lage spådommer på grafoppgaver ved å beskrive grafstrukturen og nodeinformasjon i naturlig språkoppfordringer. Metoder som InstructGLM og GPT4Graph finjuster LLM-er som LLaMA og GPT-4 ved å bruke nøye utformede ledetekster som inkluderer graftopologidetaljer som nodeforbindelser, nabolag osv. De innstilte LLM-ene kan deretter generere prediksjoner for oppgaver som nodeklassifisering og koblingsprediksjon på en nullskuddsmåte under inferens.

Mens bruk av LLM-er som black-box-prediktorer har vist lovende, forringes ytelsen deres for mer komplekse grafoppgaver der eksplisitt modellering av strukturen er fordelaktig. Noen tilnærminger bruker dermed LLM-er i forbindelse med GNN-er - GNN-en koder for grafstrukturen mens LLM gir forbedret semantisk forståelse av noder fra tekstbeskrivelsene deres.

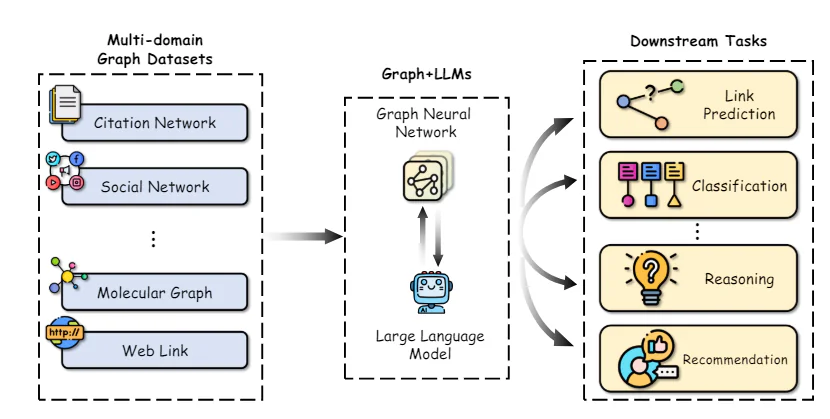

Grafforståelse med LLM Framework – kilde

GraphLLM utforsker to strategier: 1) LLMs-as-Enhancers hvor LLMs koder tekstnodeattributter før de overføres til GNN, og 2) LLMs-as-Predictors der LLM tar GNNs mellomrepresentasjoner som input for å lage endelige prediksjoner.

GLEM går videre ved å foreslå en variasjons-EM-algoritme som veksler mellom å oppdatere LLM- og GNN-komponentene for gjensidig forbedring.

Ved å redusere avhengigheten av merkede data gjennom få-shot-funksjoner og semi-overvåket utvidelse, kan LLM-forbedrede graflæringsmetoder låse opp nye applikasjoner og forbedre dataeffektiviteten.

Forbedre LLM-er med grafer

Selv om LLM-er har vært enormt vellykkede, lider de fortsatt av viktige begrensninger som hallusinasjoner (generering av ikke-faktiske utsagn), mangel på tolkbarhet i resonneringsprosessen og manglende evne til å opprettholde konsistent faktakunnskap.

Grafer, spesielt kunnskapsgrafer som representerer strukturert faktainformasjon fra pålitelige kilder, presenterer lovende veier for å løse disse manglene. Vi utforsker noen nye tilnærminger i denne retningen:

Knowledge Graph Enhanced LLM Pre-training

I likhet med hvordan LLM-er forhåndstrenes på store tekstkorpus, nyere arbeider har utforsket å forhåndstrene dem på kunnskapsgrafer for å gi bedre faktabevissthet og resonneringsevner.

Noen tilnærminger endrer inndataene ved ganske enkelt å sette sammen eller justere fakta KG-trippel med naturlig språktekst under førtrening. E-BERT justerer KG-entitetsvektorer med BERTs ordstykkeinnbygginger, mens K-BERT konstruerer trær som inneholder den opprinnelige setningen og relevante KG-trippel.

Rollen til LLM-er i grafisk maskinlæring:

Forskere har utforsket flere måter å integrere LLM i graflæringspipelinen, hver med sine unike fordeler og applikasjoner. Her er noen av de fremtredende rollene LLM-er kan spille:

- LLM som en Enhancer: I denne tilnærmingen brukes LLM-er for å berike tekstattributtene knyttet til nodene i en TAG. LLMs evne til å generere forklaringer, kunnskapsenheter eller pseudo-etiketter kan forsterke den semantiske informasjonen som er tilgjengelig for GNN, noe som fører til forbedrede noderepresentasjoner og nedstrøms oppgaveytelse.

For eksempel utnytter TAPE-modellen (Text Augmented Pre-trained Encoders) ChatGPT for å generere forklaringer og pseudo-etiketter for sitatnettverksartikler, som deretter brukes til å finjustere en språkmodell. De resulterende innebyggingene mates inn i en GNN for nodeklassifisering og koblingsprediksjonsoppgaver, og oppnår toppmoderne resultater.

- LLM som en prediktor: I stedet for å forbedre inndatafunksjonene, bruker noen tilnærminger direkte LLM som prediktorkomponent for grafrelaterte oppgaver. Dette innebærer å konvertere grafstrukturen til en tekstlig representasjon som kan behandles av LLM, som deretter genererer ønsket utgang, for eksempel nodeetiketter eller prediksjoner på grafnivå.

Et bemerkelsesverdig eksempel er GPT4Graph-modellen, som representerer grafer som bruker Graph Modeling Language (GML) og utnytter den kraftige GPT-4 LLM for nullskuddsgrafresonneringsoppgaver.

- GNN-LLM-justering: En annen forskningslinje fokuserer på å samkjøre innebyggingsrommene til GNN-er og LLM-er, noe som muliggjør en sømløs integrasjon av strukturell og semantisk informasjon. Disse tilnærmingene behandler GNN og LLM som separate modaliteter og bruker teknikker som kontrastiv læring eller destillasjon for å justere representasjonene deres.

De Molekyl STM Modellen bruker for eksempel et kontrastivt mål for å samkjøre innebyggingen av en GNN og en LLM, slik at LLM kan inkorporere strukturell informasjon fra GNN mens GNN drar nytte av LLMs semantiske kunnskap.

Utfordringer og løsninger

Selv om integreringen av LLM-er og graflæring har et enormt løfte, må flere utfordringer tas opp:

- Effektivitet og skalerbarhet: LLM-er er notorisk ressurskrevende, og krever ofte milliarder av parametere og enorm beregningskraft for trening og slutninger. Dette kan være en betydelig flaskehals for å distribuere LLM-forbedrede graflæringsmodeller i virkelige applikasjoner, spesielt på enheter med begrensede ressurser.

En lovende løsning er kunnskapsdestillasjon, hvor kunnskapen fra en stor LLM (lærermodell) overføres til en mindre, mer effektiv GNN (elevmodell).

- Datalekkasje og evaluering: LLM-er er forhåndsopplært på enorme mengder offentlig tilgjengelig data, som kan inkludere testsett fra vanlige benchmark-datasett, noe som fører til potensiell datalekkasje og overvurdert ytelse. Forskere har begynt å samle inn nye datasett eller prøvetaking av testdata fra tidsperioder etter LLMs treningsavbrudd for å redusere dette problemet.

I tillegg er det avgjørende å etablere rettferdige og omfattende evalueringsreferanser for LLM-forbedrede graflæringsmodeller for å måle deres sanne evner og muliggjøre meningsfulle sammenligninger.

- Overførbarhet og Forklarbarhet: Mens LLM-er utmerker seg med null-skudd og få-skudd-læring, er deres evne til å overføre kunnskap på tvers av ulike grafdomener og strukturer fortsatt en åpen utfordring. Å forbedre overførbarheten til disse modellene er en kritisk forskningsretning.

Videre er det avgjørende å forbedre forklarbarheten til LLM-baserte graflæringsmodeller for å bygge tillit og muliggjøre bruk av dem i høyinnsatsapplikasjoner. Utnytte de iboende resonneringsevnene til LLM-er gjennom teknikker som tankekjede kan bidra til bedre forklaringsevne.

- Multimodal integrasjon: Grafer inneholder ofte mer enn bare tekstinformasjon, med noder og kanter som potensielt er assosiert med ulike modaliteter, for eksempel bilder, lyd eller numeriske data. Å utvide integreringen av LLM-er til disse multimodale grafinnstillingene gir en spennende mulighet for fremtidig forskning.

Virkelige applikasjoner og kasusstudier

Integreringen av LLM-er og grafisk maskinlæring har allerede vist lovende resultater i ulike applikasjoner i den virkelige verden:

- Molecular Property Prediction: Innenfor beregningskjemi og legemiddeloppdagelse har LLM-er blitt brukt for å forbedre prediksjonen av molekylære egenskaper ved å inkorporere strukturell informasjon fra molekylære grafer. De LLM4Mol modell, for eksempel utnytter ChatGPT for å generere forklaringer for SMILES (Simplified Molecular-Input Line-Entry System) representasjoner av molekyler, som deretter brukes til å forbedre nøyaktigheten til egenskapsprediksjonsoppgaver.

- Kunnskapsdiagram fullføring og resonnement: Kunnskapsgrafer er en spesiell type grafstruktur som representerer virkelige enheter og deres relasjoner. LLM-er har blitt utforsket for oppgaver som fullføring av kunnskapsgrafer og resonnement, der grafstrukturen og tekstinformasjon (f.eks. enhetsbeskrivelser) må vurderes i fellesskap.

- Anbefalingssystemer: I domenet til anbefalingssystemer brukes grafstrukturer ofte for å representere bruker-element-interaksjoner, med noder som representerer brukere og elementer, og kanter angir interaksjoner eller likheter. LLM-er kan utnyttes til å forbedre disse grafene ved å generere bruker-/varesideinformasjon eller forsterke interaksjonskanter.

konklusjonen

Synergien mellom store språkmodeller og grafisk maskinlæring utgjør en spennende frontlinje innen forskning på kunstig intelligens. Ved å kombinere den strukturelle induktive skjevheten til GNN-er med de kraftige semantiske forståelsesmulighetene til LLM-er, kan vi låse opp nye muligheter i graflæringsoppgaver, spesielt for teksttilordnede grafer.

Selv om det er gjort betydelige fremskritt, gjenstår det utfordringer på områder som effektivitet, skalerbarhet, overførbarhet og forklarbarhet. Teknikker som kunnskapsdestillasjon, rettferdige evalueringsreferanser og multimodal integrasjon baner vei for praktisk distribusjon av LLM-forbedrede graflæringsmodeller i virkelige applikasjoner.