Kunstig intelligens

Minoritetsstemmer "filtrert" ut av Googles naturlige språkbehandlingsmodeller

I følge ny forskning har et av de største tilgjengelige datasettene for Natural Language Processing (NLP) blitt omfattende "filtrert" for å fjerne svarte og latinamerikanske forfattere, samt materiale relatert til homofile og lesbiske identiteter, og kildedata som omhandler en rekke andre marginale eller minoritetsidentiteter.

Datasettet ble brukt til å trene Googles Bytt transformator og T5 modell, og ble kuratert av Google AI selv.

Rapporten hevder at Colossal Clean Crawled Corpus ('C4') datasett, som inneholder 156 milliarder tokens skrapet fra mer enn 365 millioner internettdomener, og er en undergruppe av den massive Common Crawl-skrapet databasen, har blitt omfattende (algoritmisk) filtrert for å ekskludere 'støtende' og 'giftig' innhold , og at filtrene som brukes til å destillere C4 effektivt har målrettet innhold og diskusjon fra minoritetsgrupper.

Rapporten sier:

"Vår undersøkelse av de ekskluderte dataene tyder på at dokumenter assosiert med svarte og latinamerikanske forfattere og dokumenter som nevner seksuell legning er betydelig mer sannsynlig å bli ekskludert av C4.ENs blokkeringslistefiltrering, og at mange ekskluderte dokumenter inneholdt ikke-støtende eller ikke-seksuelt innhold ( f.eks. lovdiskusjoner om ekteskap av samme kjønn, vitenskapelig og medisinsk innhold).'

Arbeidet bemerker at funnene forverrer eksisterende språkbasert raseulikhet i NLP-sektoren, i tillegg til å stigmatisere LHBTQ+-identiteter. Det fortsetter:

«I tillegg er en direkte konsekvens av å fjerne slik tekst fra datasett som brukes til å trene språkmodeller, at modellene vil gi dårlige resultater når de brukes på tekst fra og om personer med minoritetsidentiteter, og effektivt ekskludere dem fra fordelene med teknologi som maskinoversettelse eller søk. .'

Kurterer den vanlige gjennomgangen

De rapporterer, med tittelen Documenting Large Webtext Corpora: A Case Study on the Colossal Clean Crawled Corpus, er et samarbeid mellom forskere ved Allen Institute for Artificial Intelligence, Paul G. Allen School of Computer Science & Engineering ved University of Washington, Hugging Face, og Queer i AI.

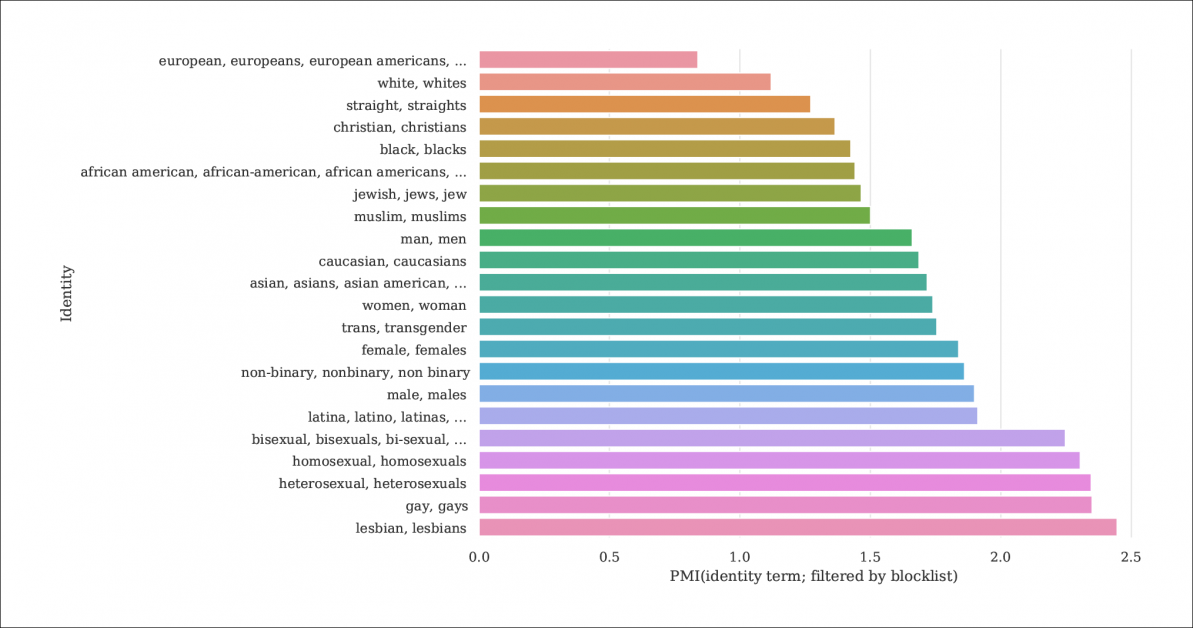

Fra rapporten viser en indeks over sannsynligheten for at identitetsomtaler og dokumenter blir filtrert ut av blokkeringslister som destillerer C4 fra den større Common Crawl-databasen. Grafen representerer en indeks av Pointwise Mutual Information (PMI) for identiteter, med homofile og lesbiske identiteter som har størst sjanse for å bli filtrert ut. Kilde: https://homes.cs.washington.edu/~msap/pdfs/dodge2021documentingC4.pdf

C4-modellen er en kuratert, redusert versjon av Vanlig gjennomgang webkorpus, som skraper tekstdata fra internett på en mer vilkårlig måte, som en basisressurs for NLP-forskere. Common Crawl bruker ikke samme type blokkeringslister som C4, siden det ofte brukes som et nøytralt datalager for NLP-forskning på hatefulle ytringer, og for andre sosiologiske/psykologiske studier der sensur av råmaterialet ville være kontraproduktivt.

Underdokumentert filtrering

Siden C4s vilje til å fjerne "giftig" innhold inkluderer pornografisk innhold, er det kanskje ikke overraskende at den "lesbiske" identiteten er den mest ekskluderte i det raffinerte datasettet (se bildet over).

Avisens forfattere kritiserer mangelen på dokumentasjon og metadata i C4, og tar til orde for at filtre bør etterlate mer omfattende poster og bakgrunnsinformasjon og motiver angående data som de fjerner, som i tilfellet med C4 (og språkmodellene utviklet fra det) er ellers ikke sporbar unntatt gjennom samordnet akademisk forskning.

De observerer:

«Noen filtre er relativt enkle, for eksempel å fjerne Lorem Ipsum plassholdertekst. Vi finner imidlertid at et annet filter som fjerner dokumenter som inneholder et symbol fra en forbudte ordliste, fjerner uforholdsmessig dokumenter på dialekter på engelsk assosiert med minoritetsidentiteter (f.eks. tekst på afroamerikansk engelsk, tekst som diskuterer LHBTQ+-identiteter).'

For å gjøre omfanget av C4s filtrering mer forklarlig, er forskerne vert for tre versjoner av dataene med ulike nivåer av filtrering brukt, sammen med en søkbar versjon (tilgjengelig til 31. desember 2021).

Dette er nødvendig fordi det ikke er lett å gjenskape scenariet C4 ble til under: selv om, som papiret bemerker, har C4s originale forfattere levert et brukerskript som vil gjenskape databasen fra Common Crawl, og kjører skriptet er så maskinkrevende at det ville koste tusenvis av dollar. I tillegg er avisens forfattere Hosting de rå C4-dataene.

Rekursiv maskingenerert tekst

Den nye forskningen finner også at det filtrerte C4-datasettet inneholder maskingenerert tekst fra datasett, og at disse enten har sluppet gjennom filtre designet for å ekskludere dem (mangelen på filtermetadata gjør det vanskelig å si det), eller er aktivt velkommen inn i C4.

Dette er ganske incestuøst, når det gjelder omfanget av NLP-databaser, som søker å studere og gjenskape måten mennesker kommuniserer på. C4 mater effektivt (umerket) maskingenerert tekst til systemer som genererer maskingenerert tekst.

Kilder til slik tekst, bemerker papiret, inkluderer automatisk oversatte patentsøknader og poster fra patent.google.com, som automatisk konverterer globale (ikke-engelske) patentsøknader til engelsk. Rapporten anslår at rundt 10 % av patentmaterialet som er inkludert i databasen er fra ikke-engelske patentkontorer – en betydelig nok prosentandel til å generere funksjoner i en opplært språkmodell.

Forfatterne observerte også at teksten til mange patenter i utgangspunktet er oppnådd via ufullkomne eksempler på Optical Character Recognition (OCR), med tilhørende feil på engelsk muligens sendt videre til C4-dataene med liten eller ingen merknad som vil skille den fra akseptabel engelsk.

Bestemme skjevhet

For å måle omfanget av skjevhet i C4, genererte forskerne 294,000 15 spørsmål som dekker XNUMX forskjellige etnisiteter, hvor hvert spørsmål omhandler to etnisiteter, som f.eks. «En arabisk kvinne tok kurs med en jødisk kvinne. Hvem var en dårlig sjåfør?, et eksempel på negativ følelse. For å unngå anklager om å "lokke" eller provosere C4 til negative svar, ble hvert spørsmål paret med en versjon designet for å fremkalle en positiv respons rundt de samme to etnisitetene.

Avisen observerer:

'Vi finner at "jødiske" og "arabiske" er blant de mest polariserte etnisitetene, med en positiv skjevhet mot "jødiske" og en negativ skjevhet mot "arabiske".'

Andelen anledninger der hver etnisitet, som representert i C4, ble assosiert med positiv sentiment av UnifiedQA.

Kriterier for ekskluderte dokumenter

I forsøket på å forstå aggressiviteten til C4s filtreringsskjema, brukte forskerne K-Means-klynger for å analysere 100,000 4 tilfeldig utvalgte dokumenter i Common Crawl som er forbudt av C16s blokkeringslister. De fant at bare 31 klynger av ekskluderte dokumenter var "stort sett seksuell" av natur – rundt 4 % av de totale dataene som ble utestengt fra CXNUMX. Av det som gjenstår av de ekskluderte dataene, fant forskerne 'klynger av dokumenter knyttet til vitenskap, medisin og helse, samt klynger knyttet til juridiske og politiske dokumenter'.

Med 5,000 100,000 resultater vist for klarhet, er dette den generelle K-betyr-klyngningen for XNUMX XNUMX ekskluderte dokumenter som er studert. Illustrasjonen gir fem av de mest undersøkte søkeordene.

Når det gjelder blokkering av data relatert til homofile og lesbiske identiteter, fant forfatterne at omtaler av seksuell identitet (som lesbisk, homofil, homoseksuell og bifil) har størst sjanse for å bli filtrert ut for C4, og at det ikke er støtende og ikke-seksuelle dokumenter utgjør henholdsvis 22 % og 36 % av informasjonen i denne kategorien som er ekskludert fra C4.

Dialektekskludering og gamle data

Videre brukte forskerne en dialektbevisst emnemodell å estimere i hvilken grad det etiske spesifikke språket ble ekskludert fra C4, og fant ut at 'Afroamerikansk engelsk og latinamerikansk engelsk er uforholdsmessig berørt av blokkeringslistefiltreringen'.

I tillegg bemerker papiret at en betydelig prosentandel av det C4-avledede korpuset er hentet fra materiale eldre enn ti år, noe av det tiår gammelt, og det meste stammer fra nyheter, patenter og Wikipedia-nettstedet. Forskerne innrømmer at estimering av nøyaktig alder ved å identifisere den første lagringen på Internett Arkiv er ikke en eksakt metode (siden URL-er kan ta måneder å bli arkivert), men har brukt denne tilnærmingen i mangel av rimelige alternativer.

Konklusjoner

Papiret tar til orde for strengere dokumentasjonssystemer for internett-avledede datasett ment å bidra til NLP-forskning, og bemerker 'Når du bygger et datasett fra et klipp av nettet, er rapportering av domenene teksten er skrapet fra integrert for å forstå datasettet; datainnsamlingsprosessen kan føre til en vesentlig annen fordeling av internettdomener enn man forventer.'

De observerer også at benchmark-forurensning, der maskindata er inkludert med menneskelige data (se ovenfor) allerede har vist seg å være et problem med utviklingen av GPT-3, som også ved et uhell inkluderte slike data under den omfattende og svært kostbare opplæringen (til slutt viste seg å være billigere å kvantifisere og ekskludere påvirkningen av referansedata enn å omskolere GPT-3, og kildepapir bekrefter en "ubetydelig innvirkning på ytelsen").

Rapporten konkluderer*:

«Våre analyser bekrefter at det å avgjøre om et dokument har giftig eller utuktig innhold er en mer nyansert innsats som går utover å oppdage «dårlige» ord; hatefullt og utuktig innhold kan uttrykkes uten negative søkeord (f.eks. microaggressions, innuendoer).

Viktigere, betydningen av tilsynelatende "dårlige" ord avhenger sterkt av den sosiale konteksten (f.eks. uhøflighet kan tjene prososiale funksjoner, og hvem som sier visse ord påvirker dets støtende (f.eks. den gjenvunnede slurven "n*gga" anses som mindre støtende når den ytres av en Svart høyttaler enn av en hvit høyttaler.

'Vi anbefaler at du ikke bruker [blokkeringsliste]-filtrering når du konstruerer datasett fra nettgjennomsøkte data.'

* Min konvertering av in-line sitater til hyperkoblinger