Anderson's hoek

Op weg naar totale controle bij het genereren van AI-video's

Videofundamentmodellen zoals Hunyuan en Wan2.1zijn weliswaar krachtig, maar bieden gebruikers niet de gedetailleerde controle die film- en tv-productie (met name VFX-productie) vereist.

In professionele studio's voor visuele effecten zijn dit soort open-sourcemodellen, samen met eerdere op afbeeldingen gebaseerde (in plaats van video) modellen zoals Stabiele diffusie, Kandinsky en Stroom, worden doorgaans gebruikt naast een reeks ondersteunende tools die hun ruwe output aanpassen om te voldoen aan specifieke creatieve behoeften. Wanneer een regisseur zegt, “Dat ziet er geweldig uit, maar kunnen we het nog iets [n] maken?” Je kunt niet zeggen dat het model niet nauwkeurig genoeg is om dergelijke verzoeken te verwerken.

In plaats daarvan zal een AI VFX-team een reeks traditionele CGI en compositietechnieken, gecombineerd met in de loop van de tijd ontwikkelde, op maat gemaakte procedures en workflows, om de grenzen van videosynthese nog wat verder te verleggen.

Een basisvideomodel is te vergelijken met een standaardinstallatie van een webbrowser als Chrome. Er is veel standaardfunctionaliteit aanwezig, maar als u wilt dat het zich aanpast aan uw behoeften, in plaats van andersom, dan hebt u een aantal plug-ins nodig.

Beheersfreaks

In de wereld van diffusiegebaseerde beeldsynthese is het belangrijkste systeem van derden ControleNet.

ControlNet is een techniek om gestructureerde controle toe te voegen aan op diffusie gebaseerde generatieve modellen, waardoor gebruikers de generatie van afbeeldingen of video's kunnen sturen met extra invoer, zoals randkaarten, diepte kaartenof pose-informatie.

De verschillende methoden van ControlNet maken het mogelijk om diepte>afbeelding (bovenste rij), semantische segmentatie>afbeelding (linksonder) en houdinggestuurde afbeeldingen van mensen en dieren te genereren (linksonder).

In plaats van uitsluitend op tekstprompts te vertrouwen, introduceert ControlNet afzonderlijke neurale netwerktakken, of adapters, die deze conditioneringssignalen verwerken terwijl de generatieve mogelijkheden van het basismodel behouden blijven.

Hierdoor zijn nauwkeurigere uitkomsten mogelijk die beter aansluiten bij de specificaties van de gebruiker. Dit is met name handig in toepassingen waarbij een nauwkeurige samenstelling, structuur of bewegingsregeling vereist is:

Met een begeleidende houding kunnen via ControlNet verschillende nauwkeurige uitvoertypen worden verkregen. Bron: https://arxiv.org/pdf/2302.05543

Echter, adapter-gebaseerde frameworks van dit soort opereren extern op een set van neurale processen die zeer intern gericht zijn. Deze benaderingen hebben verschillende nadelen.

Ten eerste worden adapters onafhankelijk getraind, wat leidt tot conflicten tussen takken wanneer meerdere adapters worden gecombineerd, kan dit leiden tot een slechtere opwekkingskwaliteit.

Ten tweede introduceren ze parameterredundantie, waardoor er voor elke adapter extra rekenkracht en geheugen nodig is, waardoor schalen inefficiënt wordt.

In de derde plaats produceren adapters, ondanks hun flexibiliteit, vaak suboptimaal resultaat vergeleken met modellen die volledig zijn fine-tuned voor multi-conditiegeneratie. Deze problemen maken adaptergebaseerde methoden minder effectief voor taken die naadloze integratie van meerdere besturingssignalen vereisen.

Idealiter zouden de capaciteiten van ControlNet getraind moeten worden native in het model geïntegreerd, op een modulaire manier die ruimte bood aan latere en langverwachte innovaties, zoals gelijktijdige video-/audiogeneratie of native lip-sync-mogelijkheden (voor externe audio).

Op dit moment vertegenwoordigt elk stukje extra functionaliteit óf een postproductietaak óf een niet-native procedure die moet navigeren door de strikt gebonden en gevoelige gewichten van het basismodel waarop het werkt.

VolledigDiT

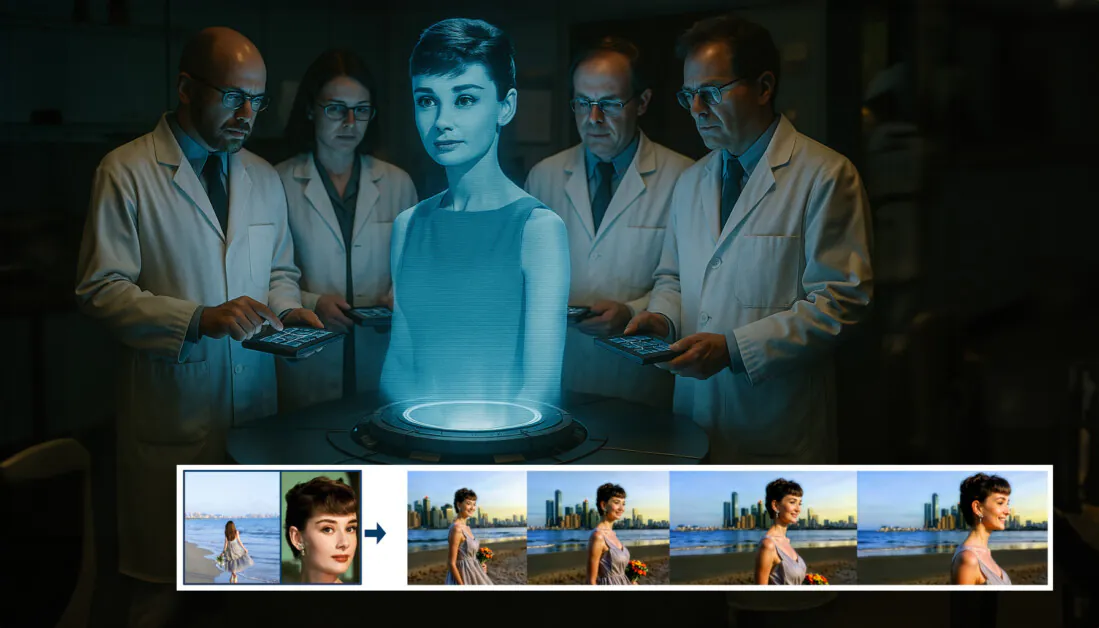

In deze patstelling is een nieuw aanbod uit China aan de orde gekomen, dat een systeem voorstelt waarbij ControlNet-achtige metingen direct in een generatief videomodel worden verwerkt tijdens de training, in plaats van dat ze als bijzaak worden beschouwd.

Uit het nieuwe artikel: de FullDiT-aanpak kan identiteitsoplegging, diepte en camerabewegingen in een native generatie integreren en kan elke combinatie hiervan in één keer oproepenBron: https://arxiv.org/pdf/2503.19907

Getiteld VolledigDiTDe nieuwe aanpak combineert multi-task omstandigheden zoals identiteitsoverdracht, dieptemapping en camerabeweging in een geïntegreerd onderdeel van een getraind generatief videomodel, waarvoor de auteurs een prototype getraind model en bijbehorende videoclips hebben geproduceerd op een project site.

In het onderstaande voorbeeld zien we generaties die camerabewegingen, identiteitsinformatie en tekstuele informatie (d.w.z. begeleidende tekstuele aanwijzingen van de gebruiker) bevatten:

Klik om te spelen. Voorbeelden van gebruikersinvoer in ControlNet-stijl met alleen een native getraind basismodel. Bron: https://fulldit.github.io/

Opgemerkt dient te worden dat de auteurs hun experimenteel getrainde model niet voorstellen als een functioneel basismodel, maar eerder als een proof-of-concept voor native tekst-naar-video (T2V) en afbeelding-naar-video (I2V) modellen die gebruikers meer controle bieden dan alleen een afbeeldings- of tekstprompt.

Omdat er nog geen soortgelijke modellen van dit type bestaan, hebben de onderzoekers een nieuwe benchmark gecreëerd met de titel VolledigeBench, voor de evaluatie van multi-task video's, en claimen state-of-the-art prestaties in de like-for-like tests die ze bedachten tegen eerdere benaderingen. Echter, aangezien FullBench door de auteurs zelf is ontworpen, is de objectiviteit ervan niet getest, en de dataset van 1,400 gevallen is mogelijk te beperkt voor bredere conclusies.

Misschien wel het meest interessante aspect van de architectuur die het artikel naar voren brengt, is het potentieel om nieuwe soorten controle te integreren. De auteurs stellen:

'In dit werk onderzoeken we alleen de controlevoorwaarden van de camera, identiteiten en diepte-informatie. We hebben andere voorwaarden en modaliteiten zoals audio, spraak, puntenwolk, object bounding boxes, optische stroming, enz. niet verder onderzocht. Hoewel het ontwerp van FullDiT andere modaliteiten naadloos kan integreren met minimale architectuuraanpassingen, is de vraag hoe bestaande modellen snel en kosteneffectief kunnen worden aangepast aan nieuwe voorwaarden en modaliteiten nog steeds een belangrijke vraag die verder onderzoek rechtvaardigt.'

Hoewel de onderzoekers FullDiT presenteren als een stap voorwaarts in het genereren van multi-task video, moet er rekening mee worden gehouden dat dit nieuwe werk voortbouwt op bestaande architecturen en geen fundamenteel nieuw paradigma introduceert.

Niettemin staat FullDiT op dit moment (voor zover ik weet) alleen als videofundamentmodel met 'hard gecodeerde' ControlNet-achtige faciliteiten. Het is goed om te zien dat de voorgestelde architectuur ook ruimte biedt aan latere innovaties.

Klik om te spelen. Voorbeelden van door de gebruiker aangestuurde camerabewegingen, vanaf de projectlocatie.

Ocuco's Medewerkers nieuw papier is getiteld FullDiT: Multi-Task Video Generative Foundation Model met volledige aandacht, en komt van negen onderzoekers van Kuaishou Technology en The Chinese University of Hong Kong. De projectpagina is hier en de nieuwe benchmarkgegevens zijn bij Hugging Face.

Methode

De auteurs beweren dat het uniforme aandachtsmechanisme van FullDiT een sterker cross-modaal representatieleerproces mogelijk maakt door zowel ruimtelijke als temporele relaties tussen omstandigheden vast te leggen:

Volgens het nieuwe artikel integreert FullDiT meerdere invoercondities via volledige zelf-aandacht, en zet ze om in een uniforme sequentie. Daarentegen gebruiken adapter-gebaseerde modellen (meest links hierboven) aparte modules voor elke invoer, wat leidt tot redundantie, conflicten en zwakkere prestaties.

In tegenstelling tot adapter-gebaseerde setups die elke invoerstroom apart verwerken, vermijdt deze gedeelde aandachtstructuur vertakkingsconflicten en vermindert parameteroverhead. Ze beweren ook dat de architectuur kan schalen naar nieuwe invoertypen zonder grote herontwerpen – en dat het modelschema tekenen vertoont van generalisatie naar conditiecombinaties die niet tijdens de training zijn gezien, zoals het koppelen van camerabewegingen aan karakteridentiteit.

Klik om te spelen. Voorbeelden van identiteitsgeneratie vanuit de projectsite.

In de architectuur van FullDiT worden alle conditionerende inputs – zoals tekst, camerabeweging, identiteit en diepte – eerst omgezet in een uniform tokenformaat. Deze tokens worden vervolgens samengevoegd tot één lange sequentie, die wordt verwerkt via een stapel transformator lagen met volledige zelf-aandacht. Deze aanpak volgt eerdere werken zoals Open-Sora-plan en Film Gen.

Dit ontwerp stelt het model in staat om temporele en ruimtelijke relaties gezamenlijk te leren over alle omstandigheden. Elk transformatorblok werkt over de gehele sequentie, wat dynamische interacties tussen modaliteiten mogelijk maakt zonder afhankelijk te zijn van afzonderlijke modules voor elke invoer – en, zoals we hebben opgemerkt, is de architectuur ontworpen om uitbreidbaar te zijn, waardoor het veel gemakkelijker wordt om in de toekomst extra besturingssignalen op te nemen, zonder grote structurele veranderingen.

De kracht van drie

FullDiT converteert elk besturingssignaal naar een gestandaardiseerd tokenformaat, zodat alle omstandigheden samen kunnen worden verwerkt in een uniform aandachtskader. Voor camerabeweging codeert het model een reeks extrinsieke parameters, zoals positie en oriëntatie, voor elk frame. Deze parameters worden voorzien van een tijdstempel en geprojecteerd in insluitvectoren die de temporele aard van het signaal weerspiegelen.

Identiteitsinformatie wordt anders behandeld, omdat het inherent ruimtelijk is in plaats van temporaal. Het model gebruikt identiteitskaarten die aangeven welke karakters aanwezig zijn in welke delen van elk frame. Deze kaarten zijn verdeeld in slaappleisters, waarbij elke patch in een inbedding die ruimtelijke identiteitsaanwijzingen vastlegt, waardoor het model specifieke regio's van het frame aan specifieke entiteiten kan koppelen.

Diepte is een spatiotemporeel signaal en het model verwerkt het door dieptevideo's te verdelen in 3D-patches die zowel ruimte als tijd overspannen. Deze patches worden vervolgens op een manier ingebed die hun structuur over frames heen behoudt.

Zodra ze zijn ingebed, worden al deze conditietokens (camera, identiteit en diepte) samengevoegd tot één lange reeks, zodat FullDiT ze samen kan verwerken met behulp van volledige zelfaandachtDeze gedeelde representatie maakt het mogelijk voor het model om interacties tussen modaliteiten en door de tijd heen te leren zonder afhankelijk te zijn van geïsoleerde verwerkingsstromen.

Gegevens en testen

De trainingsaanpak van FullDiT was gebaseerd op selectief geannoteerde datasets die waren afgestemd op elk type conditionering, in plaats van de eis dat alle omstandigheden tegelijkertijd aanwezig moesten zijn.

Voor tekstuele omstandigheden volgt het initiatief de gestructureerde ondertitelingsaanpak die in de MiraData project.

Videoverzamelings- en annotatiepijplijn van het MiraData-project. Bron: https://arxiv.org/pdf/2407.06358

Voor camerabewegingen is de Onroerend goed10K dataset was de belangrijkste gegevensbron vanwege de hoogwaardige grondwaarheidsannotaties van cameraparameters.

De auteurs merkten echter op dat training uitsluitend op statische-scène cameradatasets zoals RealEstate10K de neiging had om dynamische object- en menselijke bewegingen in gegenereerde video's te verminderen. Om dit tegen te gaan, voerden ze extra fine-tuning uit met behulp van interne datasets die meer dynamische camerabewegingen bevatten.

Identiteitsannotaties werden gegenereerd met behulp van de pijplijn die is ontwikkeld voor de ConceptMaster project, dat efficiënte filtering en extractie van gedetailleerde identiteitsinformatie mogelijk maakte.

Het ConceptMaster-framework is ontworpen om problemen met identiteitsontkoppeling aan te pakken en tegelijkertijd de conceptgetrouwheid in aangepaste video's te behouden. Bron: https://arxiv.org/pdf/2501.04698

Diepte-annotaties werden verkregen uit de Panda-70M dataset gebruikt Diepte Alles.

Optimalisatie door middel van data-ordering

De auteurs hebben ook een progressief trainingsschema geïmplementeerd, waarbij ze meer uitdagende omstandigheden hebben geïntroduceerd eerder in de training om ervoor te zorgen dat het model robuuste representaties kreeg voordat er eenvoudigere taken werden toegevoegd. De trainingsvolgorde ging van tekst naar camera omstandigheden, dan identiteiten, en tenslotte diepte, waarbij de gemakkelijkere taken over het algemeen later worden geïntroduceerd en met minder voorbeelden.

De auteurs benadrukken het belang van het ordenen van de werklast op deze manier:

'Tijdens de pre-trainingsfase merkten we op dat uitdagendere taken een langere trainingstijd vereisen en eerder in het leerproces moeten worden geïntroduceerd. Deze uitdagende taken omvatten complexe datadistributies die aanzienlijk verschillen van de outputvideo, waardoor het model voldoende capaciteit moet hebben om ze nauwkeurig vast te leggen en weer te geven.

'Omgekeerd kan het te vroeg introduceren van makkelijkere taken ertoe leiden dat het model prioriteit geeft aan het eerst leren van die taken, omdat ze directer feedback geven over de optimalisatie. Dit belemmert de convergentie van moeilijkere taken.'

Een illustratie van de volgorde waarin de onderzoekers de gegevens trainden, waarbij rood een groter datavolume aangeeft.

Na de eerste pre-training werd het model in een laatste fine-tuning-fase verder verfijnd om de visuele kwaliteit en bewegingsdynamiek te verbeteren. Daarna volgde de training die van een standaard diffusie-framework*: ruis toegevoegd aan video-latenten en het model leren voorspellen en verwijderen, waarbij de ingebedde conditietokens als leidraad worden gebruikt.

Om FullDiT effectief te evalueren en een eerlijke vergelijking te kunnen maken met bestaande methoden, en bij gebrek aan de beschikbaarheid van een andere passende benchmark, hebben de auteurs VolledigeBench, een samengestelde benchmarksuite bestaande uit 1,400 afzonderlijke testcases.

Een data explorer-exemplaar voor de nieuwe FullBench-benchmark. Bron: https://huggingface.co/datasets/KwaiVGI/FullBench

Elk gegevenspunt leverde grondwaarheidsannotaties voor verschillende conditioneringssignalen, waaronder camerabeweging, identiteiten diepte.

Metriek

De auteurs hebben FullDiT geëvalueerd met behulp van tien meetgegevens die betrekking hebben op vijf hoofdaspecten van de prestaties: tekstuitlijning, camerabesturing, identiteitsovereenkomst, dieptenauwkeurigheid en algemene videokwaliteit.

De tekstuitlijning werd gemeten met behulp van CLIP-gelijkenis, terwijl de cameracontrole werd beoordeeld via rotatiefout (RotErr), vertaalfout (TransErr), En camerabeweging consistentie (CamMC), volgens de aanpak van CamI2V (in de CameraCtrl projecten).

Identiteitsgelijkenis werd geëvalueerd met behulp van DINO-ik en CLIP-I, en de nauwkeurigheid van de dieptecontrole werd gekwantificeerd met behulp van Gemiddelde absolute fout (MAE).

De videokwaliteit werd beoordeeld met drie meetgegevens van MiraData: CLIP-gelijkenis op frameniveau voor vloeiendheid; optische stroomgebaseerde bewegingsafstand voor dynamiek; en LAION-Esthetische scores voor visuele aantrekkingskracht.

Workshops

De auteurs trainden FullDiT met behulp van een intern (niet bekendgemaakt) tekst-naar-video-diffusiemodel met ongeveer een miljard parameters. Ze kozen opzettelijk een bescheiden parametergrootte om eerlijkheid te behouden in vergelijkingen met eerdere methoden en reproduceerbaarheid te garanderen.

Omdat de trainingsvideo's in lengte en resolutie verschilden, hebben de auteurs elke video gestandaardiseerd. partij door video's te verkleinen en op te vullen tot een gemeenschappelijke resolutie, 77 frames per sequentie te bemonsteren en toegepaste aandacht en verliesmaskers om de effectiviteit van de training te optimaliseren.

Ocuco's Medewerkers Adam optimizer werd gebruikt bij een leersnelheid van 1 x 10-5 over een cluster van 64 NVIDIA H800 GPU's, voor een gecombineerd totaal van 5,120 GB VRAM (bedenk dat in de enthousiaste synthesegemeenschappen, 24GB (op een RTX 3090 wordt nog steeds als een luxe standaard beschouwd).

Het model werd getraind voor ongeveer 32,000 stappen, waarbij maximaal drie identiteiten per video werden opgenomen, samen met 20 frames met camera-omstandigheden en 21 frames met diepte-omstandigheden, beide gelijkmatig bemonsterd uit de in totaal 77 frames.

Voor de gevolgtrekking genereerde het model video's met een resolutie van 384×672 pixels (ongeveer vijf seconden bij 15 frames per seconde) met 50 diffusie-inferentiestappen en een classificatievrije begeleidingsschaal van vijf.

Eerdere methoden

Voor de camera-naar-video-evaluatie vergeleken de auteurs FullDiT met BewegingCtrl, CameraCtrl en CamI2V, waarbij alle modellen zijn getraind met behulp van de RealEstate10k-dataset om consistentie en eerlijkheid te garanderen.

Bij identiteitsgeconditioneerde generatie werd het model vergeleken met het ConceptMaster-model met 1B-parameters, omdat er geen vergelijkbare open-sourcemodellen voor meerdere identiteiten beschikbaar waren. Hierbij werd gebruikgemaakt van dezelfde trainingsgegevens en architectuur.

Voor diepte-naar-video-taken werden vergelijkingen gemaakt met Ctrl-adapter en ControleVideo.

Kwantitatieve resultaten voor single-task videogeneratie. FullDiT werd vergeleken met MotionCtrl, CameraCtrl en CamI2V voor camera-naar-videogeneratie; ConceptMaster (1B parameterversie) voor identiteit-naar-video; en Ctrl-Adapter en ControlVideo voor diepte-naar-video. Alle modellen werden geëvalueerd met behulp van hun standaardinstellingen. Voor consistentie werden 16 frames uniform bemonsterd van elke methode, overeenkomend met de uitvoerlengte van eerdere modellen.

Uit de resultaten blijkt dat FullDiT, ondanks het feit dat het meerdere conditioneringssignalen tegelijkertijd verwerkt, uitstekende prestaties levert op het gebied van metriek met betrekking tot tekst, camerabeweging, identiteit en dieptecontroles.

Wat betreft de algehele kwaliteit presteerde het systeem over het algemeen beter dan andere methoden, hoewel de soepelheid iets lager was dan die van ConceptMaster. Hier geven de auteurs commentaar:

'De smoothness van FullDiT is iets lager dan die van ConceptMaster, omdat de berekening van smoothness is gebaseerd op CLIP-overeenkomst tussen aangrenzende frames. Omdat FullDiT aanzienlijk meer dynamiek vertoont in vergelijking met ConceptMaster, wordt de smoothness-metriek beïnvloed door de grote variaties tussen aangrenzende frames.

'Omdat het beoordelingsmodel afbeeldingen in schilderstijl bevoordeelt en ControlVideo doorgaans video's in deze stijl genereert, behaalt het een hoge esthetische score.'

Wat de kwalitatieve vergelijking betreft, is het wellicht beter om te verwijzen naar de voorbeeldvideo's op de FullDiT-projectsite, aangezien de PDF-voorbeelden onvermijdelijk statisch zijn (en bovendien te groot om hier volledig te reproduceren).

Het eerste deel van de kwalitatieve resultaten in de PDF. Raadpleeg het bronartikel voor de aanvullende voorbeelden, die te uitgebreid zijn om hier te reproduceren.

De auteurs geven commentaar:

'FullDiT toont superieure identiteitsbehoud en genereert video's met betere dynamiek en visuele kwaliteit vergeleken met [ConceptMaster]. Omdat ConceptMaster en FullDiT op dezelfde backbone zijn getraind, benadrukt dit de effectiviteit van conditie-injectie met volledige aandacht.

'…De [overige] resultaten tonen de superieure controleerbaarheid en generatiekwaliteit van FullDiT aan vergeleken met bestaande diepte-naar-video- en camera-naar-video-methoden.'

Een deel van de PDF-voorbeelden van FullDiT's output met meerdere signalen. Raadpleeg het bronartikel en de projectwebsite voor meer voorbeelden.

Conclusie

Hoewel FullDiT een interessante stap is in de richting van een videofundamentmodel met meer functies, moet je je afvragen of de vraag naar ControlNet-achtige hulpmiddelen ooit de implementatie van dergelijke functies op grote schaal zal rechtvaardigen, althans voor FOSS-projecten. Zonder commerciële steun zouden deze projecten namelijk moeite hebben om de enorme hoeveelheid benodigde GPU-verwerkingskracht te verkrijgen.

De voornaamste uitdaging is dat het gebruik van systemen zoals Depth en Pose over het algemeen niet-triviale vertrouwdheid met relatief complexe gebruikersinterfaces zoals ComfyUI vereist. Daarom lijkt het erop dat een functioneel FOSS-model van dit soort waarschijnlijk het meest zal worden ontwikkeld door een groep kleinere VFX-bedrijven die niet het geld hebben (of de wil, aangezien dergelijke systemen snel verouderd raken door modelupgrades) om zo'n model achter gesloten deuren te cureren en te trainen.

Aan de andere kant kunnen API-gestuurde 'rent-an-AI'-systemen wellicht gemotiveerd zijn om eenvoudigere en gebruiksvriendelijkere interpretatiemethoden te ontwikkelen voor modellen waarin aanvullende besturingssystemen direct zijn getraind.

Klik om te spelen. Diepte- en tekstinstellingen die worden toegepast op een videogeneratie met behulp van FullDiT.

* De auteurs specificeren geen enkel bekend basismodel (d.w.z. SDXL, enz.)

Eerste publicatie donderdag 27 maart 2025