Artificial Intelligence

StyleTTS 2: Tekst-naar-spraak op menselijk niveau met grote spraaktaalmodellen

Als gevolg van een toename van natuurlijke en synthetische spraaksynthesebenaderingen is een van de belangrijkste successen die de AI-industrie de afgelopen jaren heeft bereikt het effectief synthetiseren van tekst-naar-spraak-frameworks met potentiële toepassingen in verschillende sectoren, waaronder audioboeken, virtuele assistenten, spraakherkenning en spraaksynthese. -over vertellingen en meer, waarbij enkele ultramoderne modi prestaties en efficiëntie op menselijk niveau leveren bij een breed scala aan spraakgerelateerde taken. Ondanks hun sterke prestaties is er echter nog steeds ruimte voor verbetering voor taken dankzij expressieve en diverse spraak, de vereiste voor een grote hoeveelheid trainingsgegevens voor het optimaliseren van zero-shot tekst-naar-spraak-frameworks, en robuustheid voor OOD of Out of Distribution-teksten die leiden ontwikkelaars om te werken aan een robuuster en toegankelijker tekst-naar-spraak-framework.

In dit artikel zullen we het hebben over StyleTTS-2, een robuust en innovatief tekst-naar-spraak-framework dat is gebouwd op de fundamenten van het StyleTTS-framework en tot doel heeft de volgende stap te presenteren naar geavanceerde tekst-naar-spraak-systemen. Het StyleTTS2-framework modelleert spraakstijlen als latente willekeurige variabelen en gebruikt een probabilistisch diffusiemodel om deze spraakstijlen of willekeurige variabelen te bemonsteren, waardoor het StyleTTS2-framework realistische spraak effectief kan synthetiseren zonder gebruik te maken van referentie-audio-invoer. Dankzij deze aanpak kan het StyleTTS2-framework betere resultaten opleveren en een hoge efficiëntie vertonen in vergelijking met de huidige stand van de techniek van tekst-naar-spraakframeworks, maar kan het ook profiteren van de diverse spraaksynthese die wordt geboden door diffusiemodelframeworks. We zullen het StyleTTS2-framework in meer detail bespreken en praten over de architectuur en methodologie ervan, terwijl we ook kijken naar de resultaten die door het framework worden bereikt. Dus laten we beginnen.

StyleTTS2 voor tekst-naar-spraaksynthese: een introductie

StyleTTS2 is een innovatief tekst-naar-spraak-synthesemodel dat de volgende stap zet in de richting van het bouwen van TTS-frameworks op menselijk niveau. Het is gebouwd op StyleTTS, een op stijl gebaseerde tekst om spraakgeneratief model. Het StyleTTS2-framework modelleert spraakstijlen als latente willekeurige variabelen en gebruikt een probabilistisch diffusiemodel om deze spraakstijlen of willekeurige variabelen te bemonsteren, waardoor het StyleTTS2-framework realistische spraak effectief kan synthetiseren zonder gebruik te maken van referentie-audio-invoer. Het modelleren van stijlen als latente willekeurige variabelen is wat het StyleTTS2-framework onderscheidt van zijn voorganger, het StyleTTS-framework, en heeft tot doel de meest geschikte spraakstijl voor de invoertekst te genereren zonder dat een referentie-audio-invoer nodig is, en is in staat om effectieve latente diffusies te bereiken terwijl voordeel van de diverse mogelijkheden voor spraaksynthese die worden aangeboden diffusiemodellen. Bovendien maakt het StyleTTS2-framework ook gebruik van vooraf getrainde grote SLM- of spraaktaalmodellen als discriminatoren, zoals het WavLM-framework, en koppelt het aan zijn eigen nieuwe differentiële duurmodelleringsaanpak om het raamwerk van begin tot eind te trainen en uiteindelijk spraak met verbeterde natuurlijkheid te genereren. Dankzij de aanpak die het volgt, presteert het StyleTTS2-framework beter dan de huidige state-of-the-art raamwerken voor spraakgeneratietaken, en is het een van de meest efficiënte raamwerken voor het vooraf trainen van grootschalige spraakmodellen in een zero-shot-setting voor sprekeraanpassingstaken.

Om tekst-naar-spraaksynthese op menselijk niveau te leveren, integreert het StyleTTs2-framework de lessen uit bestaande werken, waaronder diffusiemodellen voor spraaksynthese en grote spraaktaalmodellen. Diffusiemodellen worden meestal gebruikt voor spraaksynthesetaken dankzij hun vermogen tot fijnkorrelige spraakcontrole en diverse mogelijkheden voor spraakbemonstering. Diffusiemodellen zijn echter niet zo efficiënt als op GAN gebaseerde niet-iteratieve raamwerken en een belangrijke reden hiervoor is de vereiste om latente representaties, golfvormen en mel-spectrogrammen iteratief te bemonsteren op basis van de doelduur van de spraak.

Aan de andere kant hebben recente werken rond Large Speech Language Models aangetoond dat ze de kwaliteit van taken voor het genereren van tekst naar spraak kunnen verbeteren en zich goed kunnen aanpassen aan de spreker. Grote spraaktaalmodellen zetten tekstinvoer doorgaans om in gekwantiseerde of continue representaties die zijn afgeleid van vooraf getrainde spraaktaalframeworks voor spraakreconstructietaken. De kenmerken van deze spraaktaalmodellen zijn echter niet rechtstreeks geoptimaliseerd voor spraaksynthese. Het StyleTTS2-framework maakt daarentegen gebruik van de kennis die is opgedaan door grote SLM-frameworks met behulp van vijandige training om de kenmerken van spraaktaalmodellen te synthetiseren zonder gebruik te maken van latente ruimtekaarten, en daardoor direct een voor spraaksynthese geoptimaliseerde latente ruimte te leren.

StyleTTS2: Architectuur en Methodologie

In de kern is de StyleTTS2 gebouwd op zijn voorganger, het StyleTTS-framework, een niet-autoregressief tekst-naar-spraak-framework dat gebruik maakt van een stijl-encoder om een stijlvector af te leiden uit de referentieaudio, waardoor expressieve en natuurlijke spraakgeneratie mogelijk wordt gemaakt. De stijlvector die in het StyleTTS-framework wordt gebruikt, wordt rechtstreeks in de encoder, duur en voorspellers opgenomen door gebruik te maken van AdaIN of Adaptive Instance Normalization, waardoor het StyleTTS-model spraakuitvoer kan genereren met variërende prosodie, duur en zelfs emoties. Het StyleTTS-framework bestaat in totaal uit 8 modellen die zijn onderverdeeld in drie categorieën

- Akoestische modellen of spraakgeneratiesysteem met een stijl-encoder, een tekst-encoder en een spraakdecoder.

- Een tekst-naar-spraak-voorspellingssysteem dat gebruik maakt van prosodie- en duurvoorspellers.

- Een hulpprogramma met een tekstuitlijner, een toonhoogte-extractor en een discriminator voor trainingsdoeleinden.

Dankzij zijn aanpak levert het StyleTTS-framework state-of-the-art prestaties met betrekking tot bestuurbare en diverse spraaksynthese. Deze prestatie heeft echter nadelen, zoals verslechtering van de samplekwaliteit, expressieve beperkingen en afhankelijkheid van spraakbelemmerende toepassingen in realtime.

Het StyleTTS2-model is een verbetering van het StyleTTS-framework en resulteert in verbeterde expressie tekst naar spraak taken met verbeterde prestaties buiten distributie en een hoge kwaliteit op menselijk niveau. Het StyleTTS2-framework maakt gebruik van een end-to-end trainingsproces dat de verschillende componenten optimaliseert met vijandige training en directe golfvormsynthese gezamenlijk. In tegenstelling tot het StyleTTS-framework modelleert het StyleTTS2-framework de spraakstijl als een latente variabele, en bemonstert deze via diffusiemodellen, waardoor diverse spraaksamples worden gegenereerd zonder gebruik te maken van referentieaudio. Laten we deze componenten eens gedetailleerd bekijken.

End-to-end training voor interferentie

In het StyleTTS2-framework wordt een end-to-end trainingsaanpak gebruikt om verschillende tekst-naar-spraakcomponenten te optimaliseren voor interferentie zonder afhankelijk te zijn van vaste componenten. Het StyleTTS2-framework bereikt dit door de decoder aan te passen om de golfvorm rechtstreeks uit de stijlvector, pitch- en energiecurves en uitgelijnde representaties te genereren. Het raamwerk verwijdert vervolgens de laatste projectielaag van de decoder en vervangt deze door een golfvormdecoder. Het StyleTTS2-framework maakt gebruik van twee encoders: op HifiGAN gebaseerde decoder om de golfvorm rechtstreeks te genereren, en een op iSTFT gebaseerde decoder om fase en magnitude te produceren die worden omgezet in golfvormen voor snellere interferentie en training.

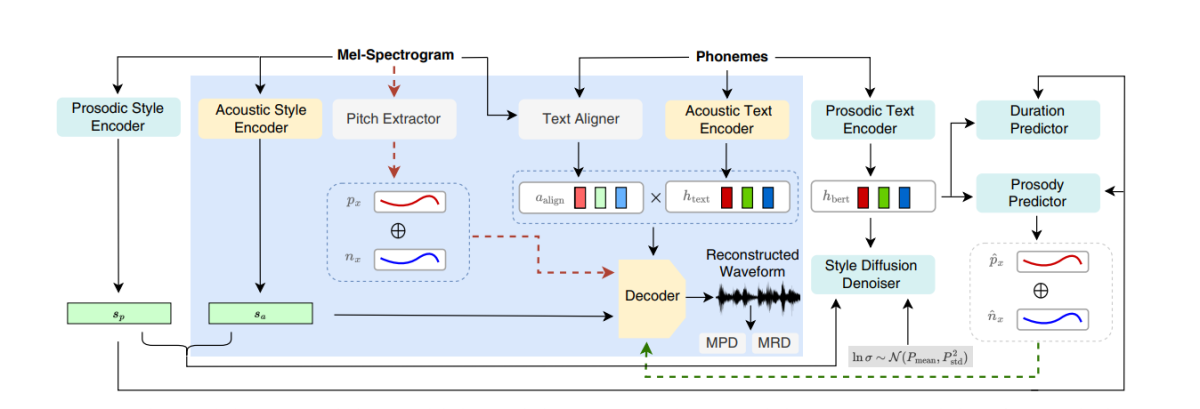

De bovenstaande afbeelding geeft de akoestische modellen weer die worden gebruikt voor pre-training en gezamenlijke training. Om de trainingstijd te verkorten, worden de modules eerst geoptimaliseerd in de pre-trainingsfase, gevolgd door de optimalisatie van alle componenten minus de veldextractor tijdens de gezamenlijke training. De reden waarom gezamenlijke training de toonhoogte-extractor niet optimaliseert, is omdat deze wordt gebruikt om de grondwaarheid voor toonhoogtecurven te verschaffen.

De bovenstaande afbeelding vertegenwoordigt de vijandige training van het Spraaktaalmodel en interferentie met het WavLM-framework, vooraf getraind maar niet vooraf afgestemd. Het proces verschilt van het hierboven genoemde proces omdat het verschillende invoerteksten kan gebruiken, maar de gradiënten accumuleert om de parameters in elke batch bij te werken.

Stijlverspreiding

Het StyleTTS2-framework heeft tot doel spraak te modelleren als een voorwaardelijke distributie via een latente variabele die de voorwaardelijke distributie volgt, en deze variabele wordt de gegeneraliseerde spraakstijl genoemd en vertegenwoordigt elk kenmerk in het spraakvoorbeeld dat buiten het bereik van enige fonetische inhoud valt, inclusief lexicale nadruk. prosodie, spreeksnelheid en zelfs formantovergangen.

Discriminatoren voor spraak-taalmodellen

Spraaktaalmodellen staan bekend om hun algemene vermogen om waardevolle informatie over een breed scala aan semantische en akoestische aspecten te coderen, en SLM-representaties zijn traditioneel in staat menselijke percepties na te bootsen om de kwaliteit van de gegenereerde gesynthetiseerde spraak te evalueren. Het StyleTTS2-framework maakt gebruik van een vijandige trainingsaanpak om gebruik te maken van het vermogen van SLM-encoders om generatieve taken uit te voeren, en gebruikt een 12-laags WavLM-framework als discriminator. Dankzij deze aanpak kan het raamwerk training over OOD- of Out Of Distribution-teksten mogelijk maken die de prestaties kunnen helpen verbeteren. Om problemen met overfitting te voorkomen, bemonstert het raamwerk bovendien OOD-teksten en in-distributie met gelijke waarschijnlijkheid.

Differentieerbare duurmodellering

Traditioneel wordt een duurvoorspeller gebruikt in tekst-naar-spraak-frameworks die de duur van foneem produceert, maar de upsampling-methoden die deze duurvoorspellers gebruiken blokkeren vaak de gradiëntstroom tijdens het E2E-trainingsproces, en het NaturalSpeech-framework maakt gebruik van een op aandacht gebaseerde upsampler voor menselijk niveau conversie van tekst naar spraak. Het StyleTTS2-framework vindt deze aanpak echter onstabiel tijdens vijandige training, omdat de StyleTTS2 traint met behulp van differentieerbare upsampling met verschillende vijandige training zonder verlies van extra termen als gevolg van mismatch in de lengte als gevolg van afwijkingen. Hoewel het gebruik van een zachte dynamische time-warping-benadering kan helpen deze mismatch te verminderen, is het gebruik ervan niet alleen computationeel duur, maar is de stabiliteit ervan ook een probleem bij het werken met vijandige doelstellingen of mel-reconstructietaken. Om prestaties op menselijk niveau te bereiken met vijandige training en het trainingsproces te stabiliseren, gebruikt het StyleTTC2-framework daarom een niet-parametrische upsampling-aanpak. Gaussiaanse upsampling is een populaire niet-parametrische upsampling-benadering voor het converteren van de voorspelde duur, hoewel deze zijn beperkingen heeft dankzij de vaste lengte van de vooraf bepaalde Gauss-kernels. Deze beperking voor Gaussiaanse upsampling beperkt het vermogen om uitlijningen met verschillende lengtes nauwkeurig te modelleren.

Om deze beperking het hoofd te bieden, stelt het StyleTTC2-framework voor om een nieuwe niet-parametrische upsampling-benadering te gebruiken zonder enige aanvullende training, en die in staat is rekening te houden met verschillende lengtes van de uitlijningen. Voor elk foneem modelleert het StyleTTC2-framework de uitlijning als een willekeurige variabele, en geeft de index aan van het spraakframe waarmee het foneem uitgelijnd is.

Modeltraining en evaluatie

Het StyleTTC2-framework is getraind en geëxperimenteerd met drie datasets: VCTK, LibriTTS en LJSpeech. De component met één luidspreker van het StyleTTS2-framework wordt getraind met behulp van de LJSpeech-dataset die ongeveer 13,000 audiofragmenten bevat, opgesplitst in 12,500 trainingsmonsters, 100 validatiemonsters en bijna 500 testmonsters, met een gecombineerde looptijd van in totaal bijna 24 uur. De multispeakercomponent van het raamwerk wordt getraind op de VCTK-dataset die bestaat uit meer dan 44,000 audioclips met meer dan 100 individuele moedertaalsprekers met verschillende accenten, en is opgesplitst in 43,500 trainingsvoorbeelden, 100 validatievoorbeelden en bijna 500 testvoorbeelden. Om het raamwerk ten slotte uit te rusten met zero-shot-aanpassingsmogelijkheden, wordt het raamwerk getraind op de gecombineerde LibriTTS-dataset die bestaat uit audiofragmenten met een totaal van ongeveer 250 uur aan audio met meer dan 1,150 individuele sprekers. Om de prestaties ervan te evalueren, maakt het model gebruik van twee statistieken: MOS-N of gemiddelde opiniescore van natuurlijkheid, en MOS of gemiddelde meningsscore van gelijkenis.

Resultaten

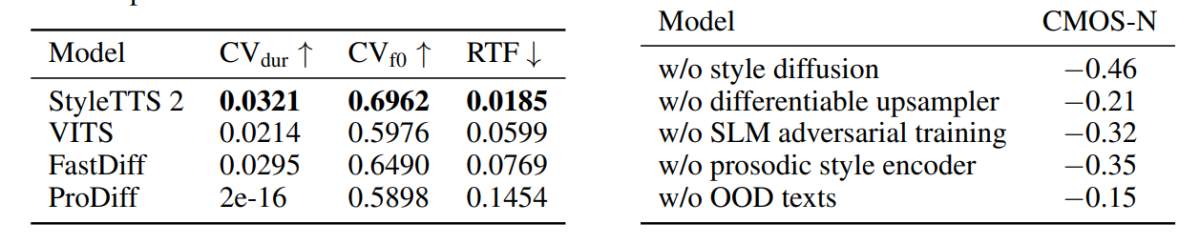

De aanpak en methodologie die in het StyleTTS2-framework wordt gebruikt, komt tot uiting in zijn prestaties, aangezien het model beter presteert dan verschillende geavanceerde TTS-frameworks, vooral op de NaturalSpeech-dataset, en onderweg, waardoor een nieuwe standaard voor de dataset wordt gezet. Bovendien presteert het StyleTTS2-framework beter dan het geavanceerde VITS-framework op de VCTK-dataset, en de resultaten worden gedemonstreerd in de volgende afbeelding.

Het StyleTTS2-model presteert ook beter dan eerdere modellen op de LJSpeech-dataset en vertoont geen enkele mate van kwaliteitsverlies op OOD- of Out of Distribution-teksten, zoals weergegeven door eerdere raamwerken met dezelfde statistieken. Bovendien presteert het StyleTTC2-model in de zero-shot-setting beter dan het bestaande Vall-E-framework wat betreft natuurlijkheid, hoewel het achterblijft in termen van gelijkenis. Het is echter vermeldenswaard dat het StyleTTS2-framework competitieve prestaties kan leveren ondanks training op slechts 245 uur aan audiosamples, vergeleken met meer dan 60 uur training voor het Vall-E-framework, wat bewijst dat StyleTTC2 een data-efficiënt alternatief is. op bestaande grote pre-trainingsmethoden zoals gebruikt in de Vall-E.

Door het gebrek aan met emoties gelabelde audiotekstgegevens gebruikt het StyleTTC2-framework het GPT-4-model om meer dan 500 instanties over verschillende emoties te genereren voor de visualisatie van stijlvectoren die het framework creëert met behulp van zijn omroep proces.

In de eerste figuur worden emotionele stijlen als reactie op ingevoerde tekstsentimenten geïllustreerd door de stijlvectoren uit het LJSpeech-model, en het demonstreert het vermogen van het StyleTTC2-framework om expressieve spraak met gevarieerde emoties te synthetiseren. De tweede afbeelding toont verschillende clusters voor elk van de vijf individuele luidsprekers, waardoor een breed scala aan diversiteit wordt weergegeven, afkomstig uit één enkel audiobestand. De laatste figuur demonstreert de losse cluster van emoties uit spreker 1, en laat zien dat, ondanks enkele overlappingen, op emoties gebaseerde clusters prominent aanwezig zijn, wat de mogelijkheid aangeeft om de emotionele melodie van een spreker te manipuleren, ongeacht het referentieaudiofragment en de invoertoon ervan. . Ondanks het gebruik van een op diffusie gebaseerde aanpak, slaagt het StyleTTS2-framework erin om beter te presteren dan bestaande state-of-the-art frameworks, waaronder VITS, ProDiff en FastDiff.

Conclusie

In dit artikel hebben we gesproken over StyleTTS2, een nieuw, robuust en innovatief tekst-naar-spraak-framework dat is gebouwd op de fundamenten van het StyleTTS-framework en tot doel heeft de volgende stap te presenteren naar geavanceerde tekst-naar-spraak-systemen. Het StyleTTS2-framework modelleert spraakstijlen als latente willekeurige variabelen en gebruikt een probabilistisch diffusiemodel om deze spraakstijlen of willekeurige variabelen te bemonsteren, waardoor het StyleTTS2-framework realistische spraak effectief kan synthetiseren zonder gebruik te maken van referentie-audio-invoer. Het StyleTTS2-framework maakt gebruik van stijldiffusie en SLM-discriminators om prestaties op menselijk niveau te bereiken bij tekst-naar-spraak-taken, en slaagt erin om beter te presteren dan de bestaande state-of-the-art raamwerken op een breed scala aan spraaktaken.