Artificial Intelligence

Stabiele videodiffusie: latente videodiffusiemodellen voor grote datasets

generatieve AI is al geruime tijd een drijvende kracht in de AI-gemeenschap, en de vooruitgang die is geboekt op het gebied van generatieve beeldmodellering, vooral met het gebruik van diffusiemodellen, heeft ertoe bijgedragen dat de generatieve videomodellen aanzienlijke vooruitgang hebben geboekt, niet alleen op het gebied van onderzoek, maar ook op het gebied van onderzoek. toepassingen in de echte wereld. Conventioneel worden generatieve videomodellen ofwel helemaal opnieuw getraind, ofwel geheel of gedeeltelijk verfijnd op basis van vooraf getrainde beeldmodellen met extra temporele lagen, op een combinatie van beeld- en videodatasets.

Als we de vooruitgang op het gebied van generatieve videomodellen voortzetten, zullen we het in dit artikel hebben over de Stabiel videoverspreidingsmodel, een latent videoverspreidingsmodel dat in staat is om ultramoderne beeld-naar-video- en tekst-naar-video-inhoud met hoge resolutie te genereren. We zullen praten over hoe latente diffusiemodellen die zijn getraind voor het synthetiseren van 2D-beelden de mogelijkheden en efficiëntie van generatieve videomodellen hebben verbeterd door tijdelijke lagen toe te voegen en de modellen te verfijnen op kleine datasets bestaande uit video's van hoge kwaliteit. We zullen dieper ingaan op de architectuur en werking van het Stable Video Diffusion Model, en de prestaties ervan op verschillende maatstaven evalueren en vergelijken met de huidige state-of-the-art raamwerken voor het genereren van video. Dus laten we beginnen.

Stabiel videodiffusiemodel en generatieve videomodellen: een inleiding

Dankzij het vrijwel onbeperkte potentieel is generatieve AI al een tijdje het belangrijkste onderzoeksonderwerp voor AI- en ML-beoefenaars, en de afgelopen jaren zijn er snelle vorderingen gemaakt, zowel op het gebied van de efficiëntie als de prestaties van generatieve beeldmodellen. De lessen uit generatieve beeldmodellen hebben onderzoekers en ontwikkelaars in staat gesteld vooruitgang te boeken op het gebied van generatieve videomodellen, wat heeft geleid tot verbeterde bruikbaarheid en toepassingen in de echte wereld. Het merendeel van het onderzoek dat probeert de mogelijkheden van generatieve videomodellen te verbeteren, richt zich echter primair op de exacte rangschikking van temporele en ruimtelijke lagen, waarbij weinig aandacht wordt besteed aan het onderzoeken van de invloed van het selecteren van de juiste gegevens op de uitkomst van deze generatieve modellen.

Dankzij de vooruitgang die is geboekt door generatieve beeldmodellen hebben onderzoekers vastgesteld dat de impact van de distributie van trainingsgegevens op de prestaties van generatieve modellen inderdaad aanzienlijk en onbetwist is. Bovendien hebben onderzoekers ook waargenomen dat het vooraf trainen van een generatief beeldmodel op een grote en diverse dataset, gevolgd door het verfijnen ervan op een kleinere dataset met betere kwaliteit, vaak resulteert in een aanzienlijke verbetering van de prestaties. Traditioneel implementeren generatieve videomodellen de lessen die zijn verkregen uit succesvolle generatieve beeldmodellen, en onderzoekers moeten het effect van data nog bestuderen, en trainingsstrategieën moeten nog worden bestudeerd. Het Stable Video Diffusion Model is een poging om de mogelijkheden van generatieve videomodellen te verbeteren door zich te begeven op voorheen onbekende gebieden, waarbij speciale aandacht wordt besteed aan het selecteren van gegevens.

Recente generatieve videomodellen zijn afhankelijk van diffusiemodellen en benaderingen van tekstconditionering of beeldconditionering om meerdere consistente video- of afbeeldingsframes te synthetiseren. Diffusiemodellen staan bekend om hun vermogen om te leren hoe ze geleidelijk de ruis van een monster uit de normale distributie kunnen verwijderen door een iteratief verfijningsproces te implementeren, en ze hebben wenselijke resultaten opgeleverd bij video met hoge resolutie en tekst-naar-beeld-synthese. Gebruikmakend van hetzelfde principe in de kern, traint het Stable Video Diffusion Model een latent videodiffusiemodel op zijn videodataset, samen met het gebruik van Generative Adversarial Networks of GAN's, en tot op zekere hoogte zelfs autoregressieve modellen.

Het Stable Video Diffusion Model volgt een unieke strategie die nooit door enig generatief videomodel is geïmplementeerd, omdat het vertrouwt op latente videodiffusiebasislijnen met een vaste architectuur en een vaste trainingsstrategie gevolgd door het beoordelen van het effect van het beheren van de gegevens. Het Stable Video Diffusion Model heeft tot doel de volgende bijdragen te leveren op het gebied van generatieve videomodellering.

- Het presenteren van een systematische en effectieve workflow voor datacuratie in een poging een grote verzameling niet-gecureerde videofragmenten om te zetten in datasets van hoge kwaliteit die vervolgens worden gebruikt door de generatieve videomodellen.

- Om geavanceerde beeld-naar-video- en tekst-naar-video-modellen te trainen die beter presteren dan de bestaande raamwerken.

- Het uitvoeren van domeinspecifieke experimenten om het 3D-begrip te onderzoeken, en een sterke voorafgaande beweging van het model.

Nu implementeert het Stable Video Diffusion Model de lessen van Latent Video Diffusion Models en datacuratietechnieken als de kern van zijn basis.

Latente videodiffusiemodellen

Latente videodiffusiemodellen of video-LDM's volgen de aanpak van het trainen van het primaire generatieve model in een latente ruimte met verminderde rekencomplexiteit, en de meeste video-LDM's implementeren een vooraf getraind tekst-naar-beeldmodel in combinatie met de toevoeging van temporele menglagen in de voortraining. architectuur. Als gevolg hiervan trainen de meeste video-latente diffusiemodellen alleen tijdelijke lagen, of slaan ze het trainingsproces helemaal over, in tegenstelling tot het stabiele video-diffusiemodel dat het hele raamwerk verfijnt. Bovendien conditioneert het Stable Video Diffusion Model zichzelf voor het synthetiseren van tekst naar videogegevens rechtstreeks op een tekstprompt, en de resultaten geven aan dat het resulterende raamwerk gemakkelijk kan worden verfijnd tot een multi-view-synthese of een beeld-naar-video-model.

Gegevenscuratie

Datacuratie is niet alleen een essentieel onderdeel van het Stable Video Diffusion Model, maar voor generatieve modellen als geheel, omdat het essentieel is om grote modellen vooraf te trainen op grootschalige datasets om de prestaties bij verschillende taken te verbeteren, waaronder taalmodellering of het genereren van onderscheid tussen tekst en afbeeldingen. , en nog veel meer. Data Curation is met succes geïmplementeerd op generatieve beeldmodellen door gebruik te maken van de mogelijkheden van efficiënte taal-beeldrepresentaties, hoewel dergelijke discussies nooit centraal zijn gesteld bij de ontwikkeling van generatieve videomodellen. Er zijn verschillende hindernissen waarmee ontwikkelaars worden geconfronteerd bij het beheren van gegevens voor generatieve videomodellen. Om deze uitdagingen aan te pakken, implementeert het Stable Video Diffusion Model een trainingsstrategie in drie fasen, wat resulteert in verbeterde resultaten en een aanzienlijke prestatieverbetering.

Gegevensbeheer voor videosynthese van hoge kwaliteit

Zoals besproken in de vorige sectie implementeert het Stable Video Diffusion Model een trainingsstrategie in drie fasen, wat resulteert in verbeterde resultaten en een aanzienlijke prestatieverbetering. Fase I is een beeld vooropleiding fase die gebruik maakt van een 2D-tekst-naar-beeld-diffusiemodel. Fase II is voor video-voortraining waarin het raamwerk traint op een grote hoeveelheid videogegevens. Tenslotte hebben we Stage III voor video-fijnafstemming waarin het model wordt verfijnd op een kleine subset van video's van hoge kwaliteit en hoge resolutie.

Voordat het Stable Video Diffusion Model deze drie fasen implementeert, is het echter van cruciaal belang om de gegevens te verwerken en te annoteren, aangezien deze dienen als basis voor fase II of de video-pre-trainingsfase en een cruciale rol spelen bij het garanderen van de optimale output. Om maximale efficiëntie te garanderen, implementeert het raamwerk eerst een gecascadeerde pijplijn voor snijdetectie op 3 verschillende FPS- of Frames Per Second-niveaus. De noodzaak van deze pijplijn wordt gedemonstreerd in de volgende afbeelding.

Vervolgens annoteert het Stable Video Diffusion Model elke videoclip met behulp van drie verschillende synthetische ondertitelingsmethoden. De volgende tabel vergelijkt de datasets die in het Stable Diffusion Framework worden gebruikt voor en na het filtratieproces.

Fase I: Image-voortraining

De eerste fase in de drietrapspijplijn die in het Stable Video Diffusion Model is geïmplementeerd, is beeldvoortraining. Om dit te bereiken is het initiële Stable Video Diffusion Model-framework gebaseerd op een vooraf getraind beeldverspreidingsmodel, namelijk het Stabiele verspreiding 2.1 model dat het uitrust met sterkere visuele representaties.

Fase II: videovooropleiding

De tweede fase is de Video Pre-Training-fase en bouwt voort op de bevindingen dat het gebruik van datacuratie in multimodale generatieve beeldmodellen vaak resulteert in betere resultaten en verbeterde efficiëntie, samen met krachtige onderscheidende beeldgeneratie. Vanwege het ontbreken van vergelijkbare krachtige standaardrepresentaties om ongewenste samples voor generatieve videomodellen uit te filteren, vertrouwt het Stable Video Diffusion Model echter op menselijke voorkeuren als invoersignalen voor het creëren van een geschikte dataset die wordt gebruikt voor het vooraf trainen van het raamwerk. De volgende afbeelding demonstreert het positieve effect van het vooraf trainen van het raamwerk op een samengestelde dataset die helpt bij het verbeteren van de algehele prestaties voor video-voortraining op kleinere datasets.

Om specifieker te zijn: het raamwerk gebruikt verschillende methoden om subsets van latente videodiffusie te beheren, en houdt rekening met de rangschikking van LVD-modellen die op deze datasets zijn getraind. Bovendien constateert het Stable Video Diffusion-framework ook dat het gebruik van samengestelde datasets voor het trainen van de frameworks helpt bij het verbeteren van de prestaties van het framework, en van diffusiemodellen in het algemeen. Bovendien werkt de datacuratiestrategie ook op grotere, relevantere en zeer praktische datasets. De volgende afbeelding laat het positieve effect zien van het vooraf trainen van het raamwerk op een samengestelde dataset, wat helpt bij het verbeteren van de algehele prestaties voor video-voortraining op kleinere datasets.

Fase III: Hoogwaardige fijnafstemming

Tot fase II richt het Stable Video Diffusion-framework zich op het verbeteren van de prestaties voorafgaand aan video-voortraining, en in de derde fase legt het raamwerk de nadruk op het optimaliseren of verder stimuleren van de prestaties van het raamwerk na hoogwaardige videoverfijning, en hoe de overgang van Fase II naar Fase III wordt in het raamwerk gerealiseerd. In fase III maakt het raamwerk gebruik van trainingstechnieken die zijn ontleend aan modellen voor latente beeldverspreiding, en verhoogt het de resolutie van de trainingsvoorbeelden. Om de effectiviteit van deze aanpak te analyseren, vergelijkt het raamwerk deze met drie identieke modellen die alleen verschillen qua initialisatie. Bij het eerste identieke model zijn de gewichten geïnitialiseerd en wordt het videotrainingsproces overgeslagen, terwijl de resterende twee identieke modellen worden geïnitialiseerd met de gewichten die zijn geleend van andere latente videomodellen.

Resultaten en bevindingen

Het is tijd om te kijken hoe het Stable Video Diffusion-framework presteert bij taken in de echte wereld, en hoe het zich verhoudt tot de huidige state-of-the-art frameworks. Het Stable Video Diffusion-framework gebruikt eerst de optimale databenadering om een basismodel te trainen en voert vervolgens verfijning uit om verschillende geavanceerde modellen te genereren, waarbij elk model een specifieke taak uitvoert.

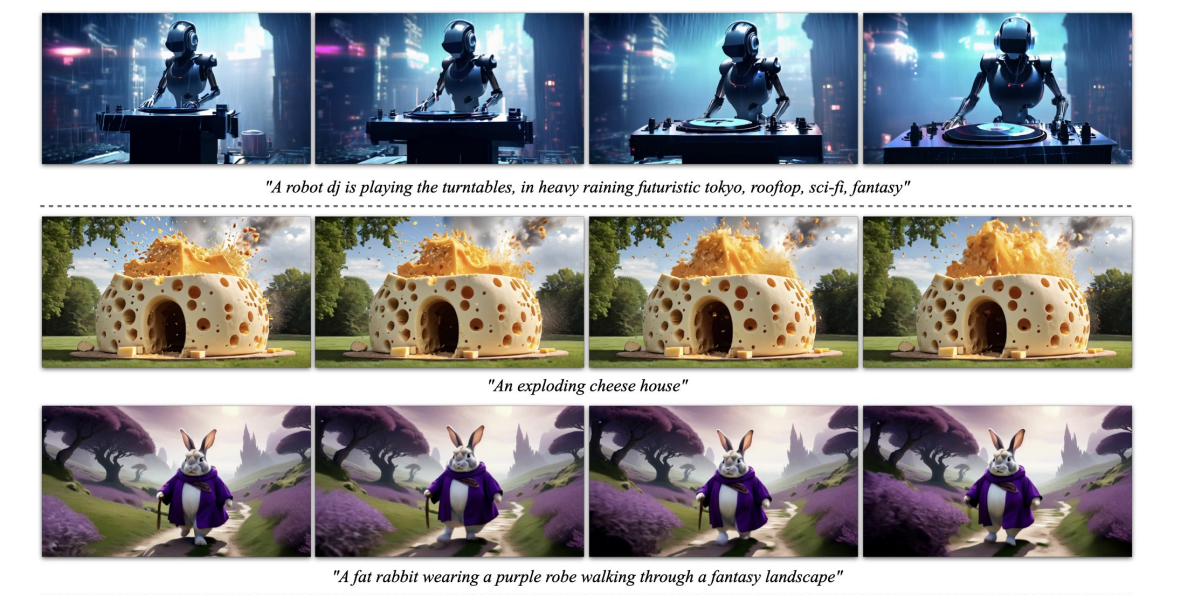

De bovenstaande afbeelding vertegenwoordigt de afbeelding met hoge resolutie voor videofragmenten die door het raamwerk zijn gegenereerd, terwijl de volgende afbeelding het vermogen van het raamwerk demonstreert om tekst van hoge kwaliteit naar videovoorbeelden te genereren.

Voorgetrainde basis Model

Zoals eerder besproken, is het Stable Video Diffusion-model gebouwd op het Stable Diffusion 2.1-framework, en op basis van recente bevindingen was het van cruciaal belang voor ontwikkelaars om het ruisschema over te nemen en de ruis te verhogen om beelden met een betere resolutie te verkrijgen bij het trainen van beeldverspreiding modellen. Dankzij deze aanpak leert het Stable Video Diffusion-basismodel krachtige bewegingsrepresentaties en presteert het daarbij beter dan de basismodellen voor sms naar videogeneratie in een zero shot-instelling, en de resultaten worden weergegeven in de volgende tabel.

Frame-interpolatie en generatie van meerdere weergaven

Het Stable Video Diffusion-framework verfijnt het beeld-naar-videomodel op multi-view datasets om meerdere nieuwe weergaven van een object te verkrijgen, en dit model staat bekend als SVD-MV of Stable Video Diffusion-Multi View-model. Het originele SVD-model is met behulp van twee datasets zodanig verfijnd dat het raamwerk één enkele afbeelding invoert en een reeks afbeeldingen met meerdere weergaven als uitvoer retourneert.

Zoals te zien is in de volgende afbeeldingen, levert het Stable Video Diffusion Multi View-framework hoge prestaties die vergelijkbaar zijn met het ultramoderne Scratch Multi View-framework, en de resultaten zijn een duidelijke demonstratie van het vermogen van SVD-MV om te profiteren van de verkregen lessen van het originele SVD-framework voor het genereren van afbeeldingen in meerdere weergaven. Bovendien geven de resultaten ook aan dat het uitvoeren van het model voor een relatief kleiner aantal iteraties helpt bij het leveren van optimale resultaten, zoals het geval is bij de meeste modellen die zijn verfijnd vanuit het SVD-framework.

In de bovenstaande afbeelding worden de statistieken aan de linkerkant aangegeven en zoals je kunt zien, presteert het Stable Video Diffusion Multi View-framework met een behoorlijke marge beter dan het Scratch-MV- en SD2.1 Multi-View-framework. De tweede afbeelding demonstreert het effect van het aantal trainingsiteraties op de algehele prestaties van het raamwerk in termen van Clip Score, en de SVD-MV-raamwerken leveren duurzame resultaten op.

Conclusie

In dit artikel hebben we gesproken over Stable Video Diffusion, een latent videodiffusiemodel dat in staat is om ultramoderne beeld-naar-video- en tekst-naar-video-inhoud met hoge resolutie te genereren. Het Stable Video Diffusion Model volgt een unieke strategie die nooit door enig generatief videomodel is geïmplementeerd, omdat het vertrouwt op latente videodiffusiebasislijnen met een vaste architectuur en een vaste trainingsstrategie gevolgd door het beoordelen van het effect van het beheren van de gegevens.

We hebben gesproken over hoe latente diffusiemodellen die zijn getraind voor het synthetiseren van 2D-beelden de mogelijkheden en efficiëntie hebben verbeterd van generatieve videomodellen door tijdelijke lagen toe te voegen en de modellen te verfijnen op kleine datasets bestaande uit video's van hoge kwaliteit. Om de pre-trainingsgegevens te verzamelen, voert het raamwerk schaalstudies uit en volgt het systematische gegevensverzamelingspraktijken, en stelt uiteindelijk een methode voor om een grote hoeveelheid videogegevens te beheren, en converteert video's met ruis naar invoergegevens die geschikt zijn voor generatieve videomodellen.

Bovendien maakt het Stable Video Diffusion-framework gebruik van drie verschillende trainingsfasen voor videomodellen die onafhankelijk worden geanalyseerd om hun impact op de prestaties van het framework te beoordelen. Het raamwerk levert uiteindelijk een videorepresentatie op die krachtig genoeg is om de modellen te verfijnen voor een optimale videosynthese, en de resultaten zijn vergelijkbaar met de modernste modellen voor het genereren van video's die al in gebruik zijn.