Artificial Intelligence

Multimodale AI evolueert naarmate ChatGPT in zicht komt met GPT-4V(ision)

In de voortdurende inspanningen om AI meer op mensen te laten lijken, hebben de GPT-modellen van OpenAI voortdurend de grenzen verlegd. GPT-4 kan nu aanwijzingen van zowel tekst als afbeeldingen accepteren.

Multimodaliteit in generatieve AI duidt op het vermogen van een model om op basis van de invoer gevarieerde resultaten te produceren, zoals tekst, afbeeldingen of audio. Deze modellen, getraind op specifieke gegevens, leren onderliggende patronen om soortgelijke nieuwe gegevens te genereren, waardoor AI-toepassingen worden verrijkt.

Recente stappen in multimodale AI

Een recente opmerkelijke sprong op dit gebied is te zien met de integratie van DALL-E 3 in ChatGPT, een aanzienlijke upgrade in de tekst-naar-beeldtechnologie van OpenAI. Deze mix zorgt voor een soepelere interactie waarbij ChatGPT helpt bij het opstellen van nauwkeurige aanwijzingen voor DALL-E 3, waardoor gebruikersideeën worden omgezet in levendige, door AI gegenereerde kunst. Dus hoewel gebruikers rechtstreeks kunnen communiceren met DALL-E 3, maakt de aanwezigheid van ChatGPT het proces van het maken van AI-kunst veel gebruiksvriendelijker.

Bekijk meer over DALL-E 3 en de integratie ervan met ChatGPT hier. Deze samenwerking toont niet alleen de vooruitgang op het gebied van multimodale AI, maar maakt het maken van AI-kunst ook een fluitje van een cent voor gebruikers.

Google's gezondheid daarentegen geïntroduceerd Med-PaLM M in juni dit jaar. Het is een multimodaal generatief model dat bedreven is in het coderen en interpreteren van diverse biomedische gegevens. Dit werd bereikt door PaLM-E, een taalmodel, te verfijnen om tegemoet te komen aan medische domeinen met behulp van een open-source benchmark, MultiMedBench. Deze benchmark bestaat uit meer dan 1 miljoen monsters in 7 soorten biomedische gegevens en 14 taken, zoals het beantwoorden van medische vragen en het genereren van radiologierapporten.

Verschillende industrieën adopteren innovatieve multimodale AI-tools om de bedrijfsuitbreiding te stimuleren, de activiteiten te stroomlijnen en de klantbetrokkenheid te vergroten. Vooruitgang op het gebied van spraak-, video- en tekst-AI-mogelijkheden stimuleert de groei van multimodale AI.

Bedrijven zijn op zoek naar multimodale AI-toepassingen die bedrijfsmodellen en -processen kunnen herzien en groeimogelijkheden kunnen openen in het generatieve AI-ecosysteem, van datatools tot opkomende AI-toepassingen.

Na de lancering van GPT-4 in maart merkten sommige gebruikers in de loop van de tijd een afname van de responskwaliteit op, een zorg die werd herhaald door vooraanstaande ontwikkelaars en op de forums van OpenAI. Aanvankelijk afgewezen door een OpenAI, een later studies bevestigde de kwestie. Het onthulde een daling in de nauwkeurigheid van GPT-4 van 97.6% naar 2.4% tussen maart en juni, wat wijst op een afname van de antwoordkwaliteit bij daaropvolgende modelupdates.

De hype rond Open AI's ChatGPT is nu terug. Het wordt nu geleverd met een vision-functie GPT-4V, waardoor gebruikers GPT-4 de door hen gegeven afbeeldingen kunnen laten analyseren. Dit is de nieuwste functie die is opengesteld voor gebruikers.

Het toevoegen van beeldanalyse aan grote taalmodellen (LLM’s) zoals GPT-4 wordt door sommigen gezien als een grote stap voorwaarts in AI-onderzoek en -ontwikkeling. Dit soort multimodale LLM opent nieuwe mogelijkheden, waarbij taalmodellen verder gaan dan alleen tekst om nieuwe interfaces te bieden en nieuwe soorten taken op te lossen, waardoor nieuwe ervaringen voor gebruikers worden gecreëerd.

De training van GPT-4V werd in 2022 afgerond en vroege toegang werd in maart 2023 uitgerold. De visuele functie in GPT-4V wordt mogelijk gemaakt door GPT-4-technologie. Het trainingsproces bleef hetzelfde. Aanvankelijk werd het model getraind om het volgende woord in een tekst te voorspellen met behulp van een enorme dataset van zowel tekst als afbeeldingen uit verschillende bronnen, waaronder internet.

Later werd het verfijnd met meer gegevens, waarbij gebruik werd gemaakt van een methode genaamd versterkend leren van menselijke feedback (RLHF), om resultaten te genereren waar mensen de voorkeur aan gaven.

GPT-4 Visiemechanica

De opmerkelijke mogelijkheden van GPT-4 op het gebied van beeldtaal, hoewel indrukwekkend, hebben onderliggende methoden die aan de oppervlakte blijven.

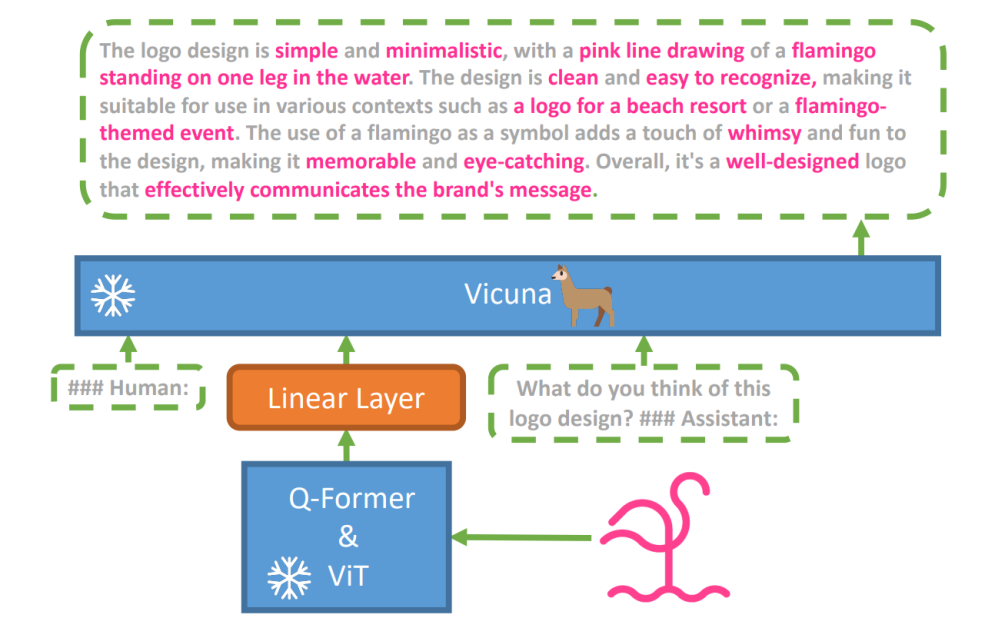

Om deze hypothese te onderzoeken, is een nieuw visie-taalmodel, miniGPT-4 werd geïntroduceerd, met behulp van een geavanceerde LLM genaamd Vicuna. Dit model maakt gebruik van een vision-encoder met vooraf getrainde componenten voor visuele perceptie, waarbij gecodeerde visuele kenmerken worden uitgelijnd met het Vicuna-taalmodel via een enkele projectielaag. De architectuur van MiniGPT-4 is eenvoudig maar effectief, met de nadruk op het afstemmen van visuele en taalkenmerken om de visuele gespreksmogelijkheden te verbeteren.

De architectuur van MiniGPT-4 omvat een vision-encoder met vooraf getrainde ViT en Q-Former, een enkele lineaire projectielaag en een geavanceerd Vicuna-groottaalmodel.

De trend van autoregressieve taalmodellen in visuele taaltaken is ook gegroeid, waarbij gebruik wordt gemaakt van cross-modale overdracht om kennis te delen tussen taal- en multimodale domeinen.

MiniGPT-4 overbrugt de visuele en taaldomeinen door visuele informatie van een vooraf getrainde vision-encoder op één lijn te brengen met een geavanceerde LLM. Het model gebruikt Vicuna als taaldecoder en volgt een trainingsaanpak in twee fasen. In eerste instantie wordt het getraind op een grote dataset van beeld-tekstparen om visie-taalkennis te begrijpen, gevolgd door verfijning op een kleinere, hoogwaardige dataset om de betrouwbaarheid en bruikbaarheid van de generatie te verbeteren.

Om de natuurlijkheid en bruikbaarheid van de gegenereerde taal in MiniGPT-4 te verbeteren, ontwikkelden onderzoekers een uit twee fasen bestaand uitlijningsproces, waarmee het gebrek aan adequate datasets voor de uitlijning van beeld en taal werd aangepakt. Hiervoor hebben ze een gespecialiseerde dataset samengesteld.

Aanvankelijk genereerde het model gedetailleerde beschrijvingen van invoerafbeeldingen, waarbij de details werden verbeterd door gebruik te maken van een conversatieprompt die was afgestemd op het formaat van het Vicuna-taalmodel. Deze fase was gericht op het genereren van uitgebreidere beeldbeschrijvingen.

Initiële beeldbeschrijving Prompt:

###Menselijk: Beschrijf dit beeld in detail. Geef zoveel mogelijk details. Zeg alles wat je ziet. ###Assistent:

Voor de naverwerking van de gegevens werden eventuele inconsistenties of fouten in de gegenereerde beschrijvingen gecorrigeerd met behulp van ChatGPT, gevolgd door handmatige verificatie om hoge kwaliteit te garanderen.

Vraag voor fijnafstelling in de tweede fase:

###Menselijk: ###Assistent:

Deze verkenning opent een venster naar het begrijpen van de mechanismen van multimodale generatieve AI zoals GPT-4, en werpt licht op hoe visie- en taalmodaliteiten effectief kunnen worden geïntegreerd om coherente en contextueel rijke resultaten te genereren.

GPT-4-visie verkennen

De oorsprong van afbeeldingen bepalen met ChatGPT

GPT-4 Vision verbetert het vermogen van ChatGPT om afbeeldingen te analyseren en hun geografische oorsprong te lokaliseren. Deze functie zet gebruikersinteracties over van alleen tekst naar een mix van tekst en beeld, waardoor het een handig hulpmiddel wordt voor mensen die nieuwsgierig zijn naar verschillende plaatsen via beeldgegevens.

Complexe wiskundige concepten

GPT-4 Vision blinkt uit in het verdiepen in complexe wiskundige ideeën door grafische of handgeschreven uitdrukkingen te analyseren. Deze functie fungeert als een handig hulpmiddel voor mensen die ingewikkelde wiskundige problemen willen oplossen, waardoor GPT-4 Vision een opmerkelijk hulpmiddel is op onderwijs- en academisch gebied.

Handgeschreven invoer converteren naar LaTeX-codes

Een van de opmerkelijke mogelijkheden van GPT-4V is de mogelijkheid om handgeschreven invoer te vertalen naar LaTeX-codes. Deze functie is een zegen voor onderzoekers, academici en studenten die vaak handgeschreven wiskundige uitdrukkingen of andere technische informatie naar een digitaal formaat moeten converteren. De transformatie van handgeschreven naar LaTeX verruimt de horizon van documentdigitalisering en vereenvoudigt het technische schrijfproces.

Tabeldetails extraheren

GPT-4V toont de vaardigheid in het extraheren van details uit tabellen en het beantwoorden van gerelateerde vragen, een essentiële troef bij data-analyse. Gebruikers kunnen GPT-4V gebruiken om tabellen te doorzoeken, belangrijke inzichten te verzamelen en datagestuurde vragen op te lossen, waardoor het een robuust hulpmiddel is voor data-analisten en andere professionals.

Visueel wijzen begrijpen

Het unieke vermogen van GPT-4V om visueel aanwijzen te begrijpen, voegt een nieuwe dimensie toe aan gebruikersinteractie. Door visuele aanwijzingen te begrijpen, kan GPT-4V reageren op vragen met een hoger contextueel begrip.

Eenvoudige mockup-websites bouwen met behulp van een tekening

Hierdoor gemotiveerd tweet, heb ik geprobeerd een mock-up te maken voor de unite.ai-website.

Hoewel het resultaat niet helemaal overeenkwam met mijn oorspronkelijke visie, is dit het resultaat dat ik heb bereikt.

Beperkingen en gebreken van GPT-4V(isie)

Om GPT-4V te analyseren, voerde het Open AI-team kwalitatieve en kwantitatieve beoordelingen uit. Kwalitatieve tests omvatten interne tests en beoordelingen door externe deskundigen, terwijl kwantitatieve tests de weigeringen en nauwkeurigheid van modellen maten in verschillende scenario's, zoals het identificeren van schadelijke inhoud, demografische herkenning, zorgen over privacy, geolocatie, cyberbeveiliging en multimodale jailbreaks.

Toch is het model niet perfect.

De papier benadrukt de beperkingen van GPT-4V, zoals onjuiste gevolgtrekkingen en ontbrekende tekst of tekens in afbeeldingen. Het kan hallucineren of feiten verzinnen. Het is met name niet geschikt voor het identificeren van gevaarlijke stoffen in afbeeldingen, waardoor deze vaak verkeerd worden geïdentificeerd.

Bij medische beeldvorming kan GPT-4V inconsistente reacties opleveren en is men zich niet bewust van de standaardpraktijken, wat tot mogelijke verkeerde diagnoses kan leiden.

Onbetrouwbare prestaties voor medische doeleinden (bron)

Het slaagt er ook niet in de nuances van bepaalde haatsymbolen te begrijpen en kan op basis van de visuele input ongepaste inhoud genereren. OpenAI raadt het gebruik van GPT-4V af voor kritische interpretaties, vooral in medische of gevoelige contexten.

Afsluiten

Gemaakt met Fast Stable Diffusion XL https://huggingface.co/spaces/google/sdxl

De komst van GPT-4 Vision (GPT-4V) brengt een heleboel coole mogelijkheden en nieuwe hindernissen met zich mee om over te springen. Voordat het op de markt werd gebracht, is er veel moeite gedaan om ervoor te zorgen dat de risico's, vooral als het om foto's van mensen gaat, goed worden onderzocht en verminderd. Het is indrukwekkend om te zien hoe GPT-4V een stap verder is gegaan en veel beloftes toont op lastige terreinen als de geneeskunde en de wetenschap.

Er liggen nu enkele grote vragen op tafel. Moeten deze modellen bijvoorbeeld beroemde mensen aan de hand van foto's kunnen identificeren? Moeten ze op basis van een foto iemands geslacht, ras of gevoelens raden? En moeten er speciale aanpassingen komen om mensen met een visuele beperking te helpen? Deze vragen openen een blik vol wormen over privacy, eerlijkheid en hoe AI in ons leven zou moeten passen, iets waar iedereen inspraak in zou moeten hebben.