Artificial Intelligence

Minder is meer: waarom het ophalen van minder documenten AI-antwoorden kan verbeteren

Retrieval-augmented generatie (RAG) is een aanpak voor het bouwen van AI-systemen die een taalmodel combineert met een externe kennisbron. Simpel gezegd zoekt de AI eerst naar relevante documenten (zoals artikelen of webpagina's) die gerelateerd zijn aan de vraag van een gebruiker, en gebruikt die documenten vervolgens om een nauwkeuriger antwoord te genereren. Deze methode is geprezen om het helpen grote taalmodellen (LLM's) Blijf feitelijk en verminder hallucinaties door hun antwoorden te baseren op echte gegevens.

Intuïtief zou je denken dat hoe meer documenten een AI ophaalt, hoe beter geïnformeerd het antwoord zal zijn. Recent onderzoek suggereert echter een verrassende wending: als het gaat om het voeden van informatie aan een AI, is minder soms meer.

Minder documenten, betere antwoorden

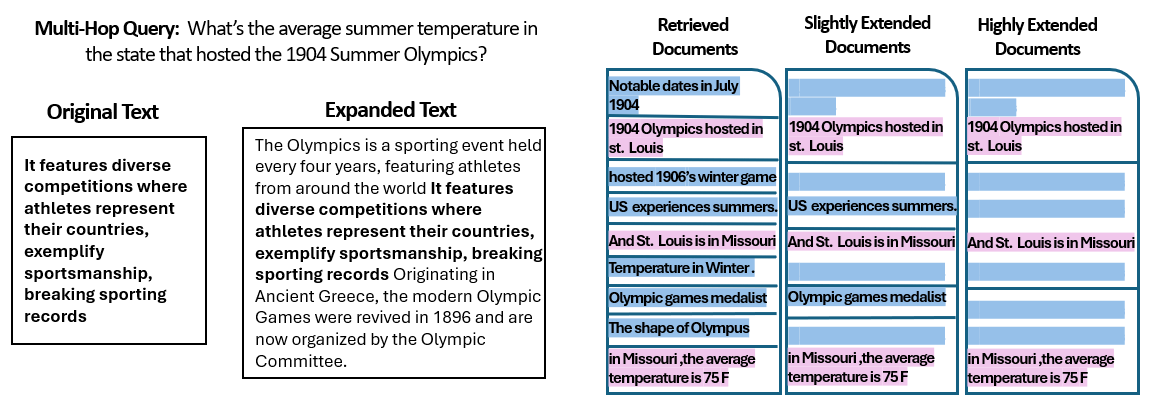

A nieuwe studie door onderzoekers aan de Hebreeuwse Universiteit van Jeruzalem onderzocht hoe de aantal van documenten die aan een RAG-systeem worden gegeven, beïnvloedt de prestaties ervan. Cruciaal is dat ze de totale hoeveelheid tekst constant hielden - wat betekent dat als er minder documenten werden verstrekt, die documenten enigszins werden uitgebreid om dezelfde lengte te vullen als veel documenten. Op deze manier konden eventuele prestatieverschillen worden toegeschreven aan de hoeveelheid documenten in plaats van simpelweg een kortere invoer.

De onderzoekers gebruikten een vraag-antwoord dataset (MuSiQue) met triviavragen, elk oorspronkelijk gekoppeld aan 20 Wikipedia-paragrafen (waarvan er slechts een paar daadwerkelijk het antwoord bevatten, terwijl de rest afleidende elementen zijn). Door het aantal documenten van 20 terug te brengen tot slechts de 2-4 echt relevante documenten – en die op te vullen met wat extra context om een consistente lengte te behouden – creëerden ze scenario's waarin de AI minder stukken materiaal had om te overwegen, maar nog steeds ongeveer hetzelfde aantal woorden om te lezen.

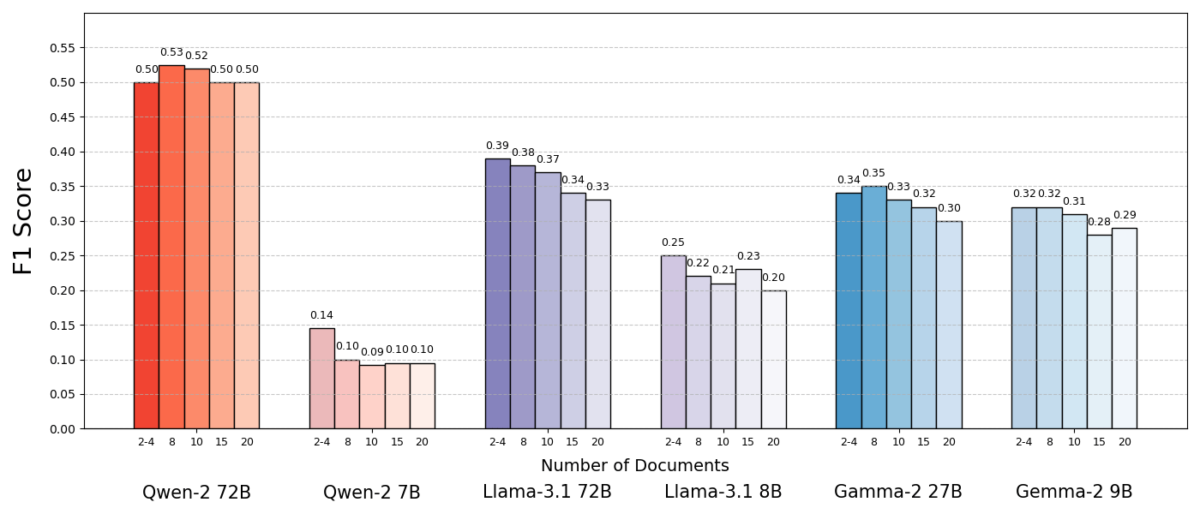

De resultaten waren opvallend. In de meeste gevallen gaven de AI-modellen nauwkeuriger antwoord als ze minder documenten kregen in plaats van de volledige set. De prestaties verbeterden aanzienlijk - in sommige gevallen met tot wel 10% in nauwkeurigheid (F1-score) toen het systeem slechts een handvol ondersteunende documenten gebruikte in plaats van een grote verzameling. Deze contra-intuïtieve boost werd waargenomen in verschillende open-source taalmodellen, waaronder varianten van Meta's Llama en andere, wat aangeeft dat het fenomeen niet aan één enkel AI-model is gekoppeld.

Een model (Qwen-2) was een opvallende uitzondering die meerdere documenten verwerkte zonder een daling in score, maar bijna alle geteste modellen presteerden beter met minder documenten in het algemeen. Met andere woorden, het toevoegen van meer referentiemateriaal naast de belangrijkste relevante stukken schaadde hun prestaties vaker dan het hielp.

Bron: Levy et al.

Waarom is dit zo verrassend? Normaal gesproken worden RAG-systemen ontworpen in de veronderstelling dat het ophalen van een bredere hoeveelheid informatie de AI alleen maar kan helpen. Als het antwoord niet in de eerste paar documenten staat, staat het misschien wel in het tiende of twintigste.

Deze studie draait dat script om en toont aan dat het lukraak opstapelen van extra documenten averechts kan werken. Zelfs als de totale tekstlengte constant werd gehouden, maakte de aanwezigheid van veel verschillende documenten (elk met zijn eigen context en eigenaardigheden) de vraag-antwoordtaak uitdagender voor de AI. Het lijkt erop dat na een bepaald punt elk extra document meer ruis dan signaal introduceerde, waardoor het model in de war raakte en het niet meer in staat was om het juiste antwoord te achterhalen.

Waarom minder meer kan zijn in RAG

Dit "less is more"-resultaat is logisch als we bedenken hoe AI-taalmodellen informatie verwerken. Wanneer een AI alleen de meest relevante documenten krijgt, is de context die hij ziet gefocust en vrij van afleidingen, net als een student die precies de juiste pagina's heeft gekregen om te studeren.

In het onderzoek presteerden modellen significant beter wanneer ze alleen de ondersteunende documenten kregen, waarbij irrelevant materiaal werd verwijderd. De resterende context was niet alleen korter, maar ook schoner: het bevatte feiten die direct naar het antwoord wezen en niets anders. Met minder documenten om mee te jongleren, kon het model zijn volledige aandacht besteden aan de relevante informatie, waardoor het minder snel afgeleid of verward raakte.

Aan de andere kant, wanneer er veel documenten werden opgehaald, moest de AI door een mix van relevante en irrelevante content heen zeven. Vaak waren deze extra documenten "vergelijkbaar maar niet gerelateerd" - ze kunnen een onderwerp of trefwoorden delen met de query, maar bevatten niet daadwerkelijk het antwoord. Dergelijke content kan het model misleiden. De AI kan moeite verspillen aan het proberen om punten te verbinden in documenten die niet daadwerkelijk leiden tot een correct antwoord, of erger nog, het kan informatie uit meerdere bronnen onjuist samenvoegen. Dit vergroot het risico op hallucinaties - gevallen waarin de AI een antwoord genereert dat aannemelijk klinkt, maar niet is gebaseerd op één enkele bron.

Wanneer u het model te veel documenten geeft, kan de bruikbare informatie verwateren en kunnen er tegenstrijdige details ontstaan. Hierdoor wordt het voor de AI moeilijker om te bepalen wat waar is.

Interessant genoeg ontdekten de onderzoekers dat als de extra documenten duidelijk irrelevant waren (bijvoorbeeld willekeurige, niet-gerelateerde tekst), de modellen ze beter konden negeren. Het echte probleem komt van afleidende data die relevant lijkt: wanneer alle opgehaalde teksten over vergelijkbare onderwerpen gaan, gaat de AI ervan uit dat ze ze allemaal moet gebruiken en kan het lastig zijn om te bepalen welke details daadwerkelijk belangrijk zijn. Dit komt overeen met de observatie van de studie dat willekeurige afleiders zorgden voor minder verwarring dan realistische afleiders in de input. De AI kan flagrante onzin eruit filteren, maar subtiel off-topic informatie is een sluwe val – het sluipt binnen onder het mom van relevantie en ontspoort het antwoord. Door het aantal documenten te beperken tot alleen de echt noodzakelijke, vermijden we dat we deze vallen in de eerste plaats opzetten.

Er is ook een praktisch voordeel: het ophalen en verwerken van minder documenten verlaagt de rekenkundige overhead voor een RAG-systeem. Elk document dat wordt opgehaald, moet worden geanalyseerd (ingebed, gelezen en bijgehouden door het model), wat tijd en rekenkracht kost. Het elimineren van overbodige documenten maakt het systeem efficiënter: het kan sneller en tegen lagere kosten antwoorden vinden. In scenario's waarin de nauwkeurigheid is verbeterd door te focussen op minder bronnen, krijgen we een win-winsituatie: betere antwoorden en een slanker, efficiënter proces.

Bron: Levy et al.

RAG heroverwegen: toekomstige richtingen

Dit nieuwe bewijs dat kwaliteit vaak kwantiteit overtreft bij het ophalen, heeft belangrijke implicaties voor de toekomst van AI-systemen die afhankelijk zijn van externe kennis. Het suggereert dat ontwerpers van RAG-systemen prioriteit moeten geven aan slimme filtering en rangschikking van documenten boven puur volume. In plaats van 100 mogelijke passages op te halen en te hopen dat het antwoord ergens in begraven ligt, is het wellicht verstandiger om alleen de paar meest relevante op te halen.

De auteurs van de studie benadrukken de noodzaak voor ophaalmethoden om "een balans te vinden tussen relevantie en diversiteit" in de informatie die ze aan een model leveren. Met andere woorden, we willen voldoende dekking van het onderwerp bieden om de vraag te beantwoorden, maar niet zo veel dat de kernfeiten verdrinken in een zee van overbodige tekst.

In de toekomst zullen onderzoekers waarschijnlijk technieken verkennen die AI-modellen helpen om meerdere documenten eleganter te verwerken. Eén aanpak is om betere retrieversystemen of re-rankers te ontwikkelen die kunnen identificeren welke documenten echt waarde toevoegen en welke alleen maar conflicten veroorzaken. Een andere invalshoek is het verbeteren van de taalmodellen zelf: als één model (zoals Qwen-2) erin slaagt om met veel documenten om te gaan zonder nauwkeurigheid te verliezen, kan het onderzoeken van hoe het is getraind of gestructureerd aanwijzingen bieden om andere modellen robuuster te maken. Misschien zullen toekomstige grote taalmodellen mechanismen bevatten om te herkennen wanneer twee bronnen hetzelfde zeggen (of elkaar tegenspreken) en zich dienovereenkomstig richten. Het doel zou zijn om modellen in staat te stellen om een rijke verscheidenheid aan bronnen te gebruiken zonder ten prooi te vallen aan verwarring - effectief het beste van beide werelden te krijgen (breedte van informatie en helderheid van focus).

Het is ook de moeite waard om op te merken dat als AI-systemen krijgen grotere contextvensters (de mogelijkheid om meer tekst tegelijk te lezen), is het simpelweg dumpen van meer data in de prompt geen wondermiddel. Grotere context betekent niet automatisch beter begrip. Deze studie toont aan dat zelfs als een AI technisch gezien 50 pagina's tegelijk kan lezen, het geven van 50 pagina's met informatie van gemengde kwaliteit mogelijk geen goed resultaat oplevert. Het model profiteert nog steeds van gecureerde, relevante content om mee te werken, in plaats van een willekeurige dump. Sterker nog, intelligent ophalen kan nog belangrijker worden in het tijdperk van gigantische contextvensters - om ervoor te zorgen dat de extra capaciteit wordt gebruikt voor waardevolle kennis in plaats van ruis.

De bevindingen van “Meer documenten, even lang” (het toepasselijk getitelde artikel) moedigen een heroverweging van onze aannames in AI-onderzoek aan. Soms is het voeden van een AI met alle data die we hebben niet zo effectief als we denken. Door ons te richten op de meest relevante stukjes informatie, verbeteren we niet alleen de nauwkeurigheid van door AI gegenereerde antwoorden, maar maken we de systemen ook efficiënter en gemakkelijker te vertrouwen. Het is een tegenintuïtieve les, maar wel een met opwindende gevolgen: toekomstige RAG-systemen kunnen zowel slimmer als slanker zijn door zorgvuldig minder, maar betere documenten te kiezen om op te halen.