Artificial Intelligence

AI-beeldmatten die scènes begrijpen

In de extra-documentaire bij de dvd-release van 2003 van Vreemd3 (1992) herinnerde de legende van visuele effecten Richard Edlund zich met afschuw het 'sumoworstelen' van fotochemische matte-extractie dat het werk aan visuele effecten domineerde tussen de laat 1930s en eind jaren tachtig. Edlund beschreef de wisselvallige aard van het proces als 'sumoworstelen', in vergelijking met de digitale blauw/groen-schermtechnieken die begin jaren negentig de overhand kregen (en hij heeft teruggekeerd naar de metafoor sindsdien).

Het extraheren van een voorgrondelement (zoals een persoon of een ruimteschipmodel) uit een achtergrond, zodat het uitgesneden beeld kan worden samengesteld tot een achtergrondplaat, werd oorspronkelijk bereikt door het voorgrondobject tegen een uniforme blauwe of groene achtergrond te filmen.

Arbeidsintensieve fotochemische extractieprocessen voor een VFX-opname van ILM voor 'Return of the Jedi' (1983). Bron: https://www.youtube.com/watch?v=qwMLOjqPmbQ

In het resulterende beeldmateriaal zou de achtergrondkleur vervolgens chemisch worden geïsoleerd en als sjabloon worden gebruikt om het object (of de persoon) op de voorgrond opnieuw af te drukken in een optische printer als een 'zwevend' object in een verder transparante filmcel.

Het proces stond bekend als kleurscheidingsoverlay (CSO) - hoewel deze term uiteindelijk meer geassocieerd zou worden met de ruwe olie 'Chromakey' video-effecten in televisie-uitvoer met een lager budget uit de jaren zeventig en tachtig, die eerder met analoge dan met chemische of digitale middelen werden bereikt.

Een demonstratie van Color Separation Overlay in 1970 voor het Britse kinderprogramma 'Blue Peter'. Bron: https://www.bbc.co.uk/archive/blue_peter_noakes_CSO/zwb9vwx

In elk geval, of het nu gaat om film- of video-elementen, kunnen de geëxtraheerde beelden daarna in elk ander beeldmateriaal worden ingevoegd.

Hoewel Disney's aanzienlijk duurdere en meer eigendomsrechten heeft natriumdamp proces (die speciaal op geel was ingetoetst, en ook was gebruikt voor Alfred Hitchcocks horrorfilm uit 1963 De vogels) gaf een betere definitie en scherpere matte, fotochemische extractie bleef nauwgezet en onbetrouwbaar.

Disney's gepatenteerde natriumdampextractieproces vereiste achtergronden die aan de gele kant van het spectrum lagen. Hier hangt Angela Lansbury aan draden tijdens de productie van een scène vol visuele effecten voor 'Bedknobs and Broomsticks' (1971). Bron

Voorbij digitale matten

In de jaren negentig maakte de digitale revolutie een einde aan de chemicaliën, maar niet aan de behoefte aan groene schermen. Het was nu mogelijk om de groene (of welke kleur dan ook) achtergrond te verwijderen door te zoeken naar pixels binnen een tolerantiebereik van die kleur, in pixelbewerkingssoftware zoals Photoshop, en een nieuwe generatie videocompositiesuites die automatisch de gekleurde achtergronden. Bijna van de ene op de andere dag, zestig jaar van de optische drukindustrie tot het verleden behoren.

De afgelopen tien jaar van GPU-versneld computer vision-onderzoek luiden de extractie van mattes een derde tijdperk in, waarbij onderzoekers worden belast met de ontwikkeling van systemen die mattes van hoge kwaliteit kunnen extraheren zonder de noodzaak van groene schermen. Alleen al bij Arxiv zijn artikelen over innovaties op het gebied van op machine learning gebaseerde voorgrondextractie een wekelijks onderdeel.

Ons in beeld brengen

Deze locus van academische en industriële interesse in AI-extractie heeft al invloed gehad op de consumentenruimte: ruwe maar werkbare implementaties zijn ons allemaal bekend in de vorm van Zoom en Skype filters die onze woonkamerachtergronden kunnen vervangen door tropische eilanden, et al, in videoconferentiegesprekken.

De beste mattes hebben echter nog steeds een groen scherm nodig, zoals Zoom opgemerkt afgelopen woensdag.

Links: een man voor een greenscreen, met haar dat goed is geëxtraheerd via de virtuele achtergrondfunctie van Zoom. Rechts: een vrouw voor een normale huiselijke scène, met haar dat algoritmisch is geëxtraheerd, minder nauwkeurig en met hogere computervereisten. Bron: https://support.zoom.us/hc/en-us/articles/210707503-Changing-your-Virtual-Background-image

A verder bericht van het Zoom Support-platform waarschuwt dat extractie zonder groen scherm ook meer rekenkracht vereist in het opnameapparaat.

De noodzaak om het uit te schakelen

Verbeteringen in kwaliteit, draagbaarheid en hulpbronnenefficiëntie voor 'in the wild' matte-extractiesystemen (d.w.z. het isoleren van mensen zonder dat er groene schermen nodig zijn) zijn relevant voor veel meer sectoren en doeleinden dan alleen videoconferentiefilters.

Voor de ontwikkeling van datasets biedt verbeterde gezichts-, hoofd- en lichaamsherkenning de mogelijkheid om ervoor te zorgen dat vreemde achtergrondelementen niet worden getraind in computervisiemodellen van menselijke proefpersonen; een nauwkeurigere isolatie zou de semantische segmentatie technieken ontworpen om domeinen te onderscheiden en te assimileren (bijv 'kat', 'persoon', 'boot'), En verbeteren VAE en transformator-gebaseerde beeldsynthesesystemen zoals de nieuwe van OpenAI DALL-E2; en betere extractie-algoritmen zouden de noodzaak van een dure handleiding verminderen rotoscoping in dure VFX-pijplijnen.

Sterker nog, het overwicht van multimodaal (meestal tekst/afbeelding) methodologieën, waarbij een domein zoals 'kat' zowel als afbeelding als met bijbehorende tekstuele verwijzingen wordt gecodeerd, vinden al hun weg naar beeldverwerking. Een recent voorbeeld is de Tekst2Live architectuur, die multimodale (tekst/beeld) training gebruikt om video's te maken van, onder talloze andere mogelijkheden, kristallen zwanen en glazen giraffen.

Scènebewuste AI-matten

Veel onderzoek naar op AI gebaseerde automatische matting heeft zich gericht op grensherkenning en evaluatie van op pixels gebaseerde groeperingen binnen een beeld- of videoframe. Nieuw onderzoek uit China biedt echter een extractiepijplijn die de afbakening en matte kwaliteit verbetert door gebruik te maken op tekst gebaseerde beschrijvingen van een scène (een multimodale benadering die de afgelopen 3-4 jaar aan populariteit heeft gewonnen in de computer vision-onderzoekssector), beweert op een aantal manieren eerdere methoden te hebben verbeterd.

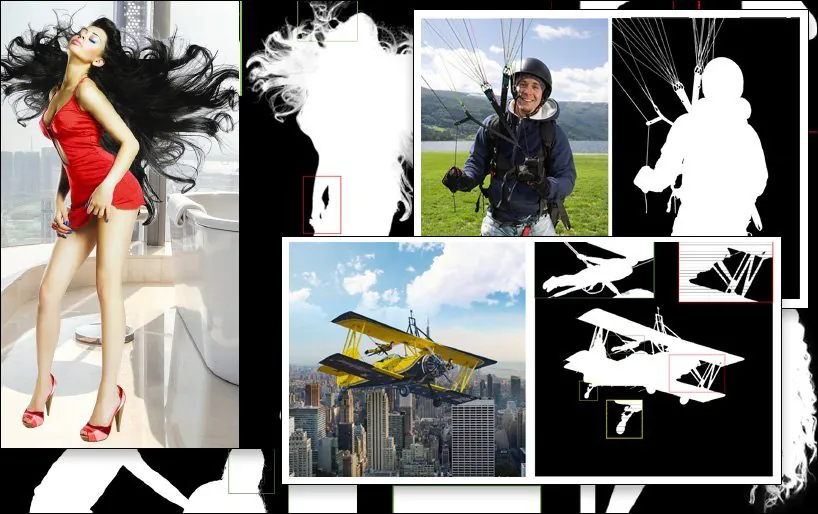

Een voorbeeld van SPG-IM-extractie (laatste afbeelding, rechtsonder), vergeleken met concurrerende eerdere methoden. Bron: https://arxiv.org/pdf/2204.09276.pdf

De uitdaging voor de subsector extractieonderzoek is om workflows te produceren die een absoluut minimum aan handmatige annotatie en menselijke tussenkomst vereisen - idealiter geen. Naast de kostenimplicaties, merken de onderzoekers van het nieuwe artikel op dat annotaties en handmatige segmentaties uitgevoerd door uitbestede crowdworkers in verschillende culturen ertoe kunnen leiden dat afbeeldingen op verschillende manieren worden gelabeld of zelfs gesegmenteerd, wat leidt tot inconsistente en onbevredigende algoritmen.

Een voorbeeld hiervan is de subjectieve interpretatie van de definitie van een 'voorgrondobject':

Uit het nieuwe artikel: eerdere methoden LFM en MODNet ('GT' staat voor Ground Truth, een 'ideaal' resultaat dat vaak handmatig of met niet-algoritmische methoden wordt bereikt) hanteren verschillende en wisselend effectieve interpretaties van de definitie van voorgrondinhoud, terwijl de nieuwe SPG-IM-methode 'nabije inhoud' effectiever afbakent via scènecontext.

Om dit aan te pakken, hebben de onderzoekers een pijplijn in twee fasen ontwikkeld met de titel Situationele perceptie Geleide beeldmatten (SPG IM). De tweetraps encoder/decoder-architectuur omvat Situational Perception Distillation (SPD) en Situational Perception Guided Matting (SPGM).

Ten eerste traint SPD visueel-naar-tekstuele kenmerktransformaties vooraf, waarbij bijschriften worden gegenereerd die passen bij de bijbehorende afbeeldingen. Hierna wordt de voorspelling van het voorgrondmasker ingeschakeld door de pijplijn te verbinden met een roman opvallende voorspelling techniek.

Vervolgens voert SPGM een geschatte alfamat uit op basis van de onbewerkte RGB-beeldinvoer en het gegenereerde masker verkregen in de eerste module.

Het doel is situationele waarnemingsbegeleiding, waarbij het systeem een contextueel begrip heeft van waar het beeld uit bestaat, waardoor het bijvoorbeeld de uitdaging kan kaderen om complexe haren uit een achtergrond te halen tegen bekende kenmerken van een dergelijke specifieke taak.

In het onderstaande voorbeeld begrijpt SPG-IM dat de koorden inherent zijn aan een 'parachute', waarbij MODNet deze details niet vasthoudt en definieert. Evenzo gaat de volledige structuur van het speeltoestel willekeurig verloren in MODNet.

De nieuwe papier is getiteld Situationele perceptie Geleide beeldmatten, en is afkomstig van onderzoekers van het OPPO Research Institute, PicUp.ai en Xmotors.

Intelligente geautomatiseerde mattes

SPG-IM biedt ook een Adaptive Focal Transformation (AFT) Refinement Network dat lokale details en globale context afzonderlijk kan verwerken, waardoor 'intelligente mattes' mogelijk worden.

Door de context van de scène te begrijpen, in dit geval 'meisje met paard', kan het extraheren van de voorgrond mogelijk eenvoudiger worden dan met eerdere methoden.

In de krant staat:

'Wij geloven dat visuele representaties van de visueel-naar-tekstuele taak, bijv Bij het ondertitelen van afbeeldingen richten we ons op meer semantisch uitgebreide signalen tussen a) object tot object en b) object tot de omgeving om beschrijvingen te genereren die zowel de globale informatie als lokale details kunnen omvatten. Bovendien kunnen tekstuele labels, vergeleken met de dure pixelannotatie van beeldmattering, massaal en tegen zeer lage kosten worden verzameld.

De SPD-tak van de architectuur is gezamenlijk voorgetraind met de Universiteit van Michigan VirTex op transformator gebaseerde tekstuele decoder, die visuele representaties leert van semantisch dichte bijschriften.

VirTex traint gezamenlijk een ConvNet en Transformers via coupletten van afbeelding en bijschrift, en brengt de verkregen inzichten over naar downstream vision-taken zoals objectdetectie. Bron: https://arxiv.org/pdf/2006.06666.pdf

Naast andere tests en ablatiestudies, testten de onderzoekers SPG-IM tegen de stand van de techniek trimap-gebaseerde methoden Deep Image Matting (DIM), IndexNet, Contextbewuste beeldmatten (CAM), begeleide contextuele aandacht (GCA) FBA, en semantische beeldtoewijzing (SIM).

Andere eerdere geteste frameworks omvatten trimap-vrije benaderingen LFM, HAttMattingen MODNetVoor een eerlijke vergelijking werden de testmethoden aangepast op basis van de verschillende methodologieën. Waar geen code beschikbaar was, werden de technieken uit het artikel overgenomen uit de beschreven architectuur.

In het nieuwe papier staat:

'Onze SPG-IM presteert ruimschoots beter dan alle concurrerende trimap-vrije methoden ([LFM], [HAttMatting] en [MODNet]). Tegelijkertijd toont ons model ook opmerkelijke superioriteit ten opzichte van de state-of-the-art (SOTA) trimap-gebaseerde en maskergestuurde methoden wat betreft alle vier de meetwaarden in de openbare datasets (d.w.z. Composition-1K, Distinction-646 en Human-2K) en onze Multi-Object-1K benchmark.'

En vervolgt:

'Het is duidelijk waarneembaar dat onze methode fijne details (bijvoorbeeld haarpuntjes, transparante texturen en grenzen) behoudt zonder trimap-begeleiding. Bovendien behoudt onze SPG-IM, vergeleken met andere concurrerende trimap-vrije modellen, een betere globale semantische volledigheid.'

Voor het eerst gepubliceerd op 24 april 2022.