Anderson's hoek

Een 'Zen'-methode om taalmodellen te laten stoppen met hallucineren

Als je ChatGPT vertelt om een willekeurig antwoord te controleren voordat het een daadwerkelijk probleem oplost, denkt het systeem beter na en krijgt het vaker het juiste antwoord – zelfs als het eerdere 'willekeurige' antwoord niets te maken heeft met je werkelijke vraag.

Een interessant nieuw artikel uit China heeft een zeer goedkope methode ontwikkeld om te voorkomen dat taalmodellen zoals ChatGPT hallucinerenen om de kwaliteit van de antwoorden te verbeteren: laat het model de antwoorden op een vraag controleren op feiten. totaal niet gerelateerd vraag eerst:

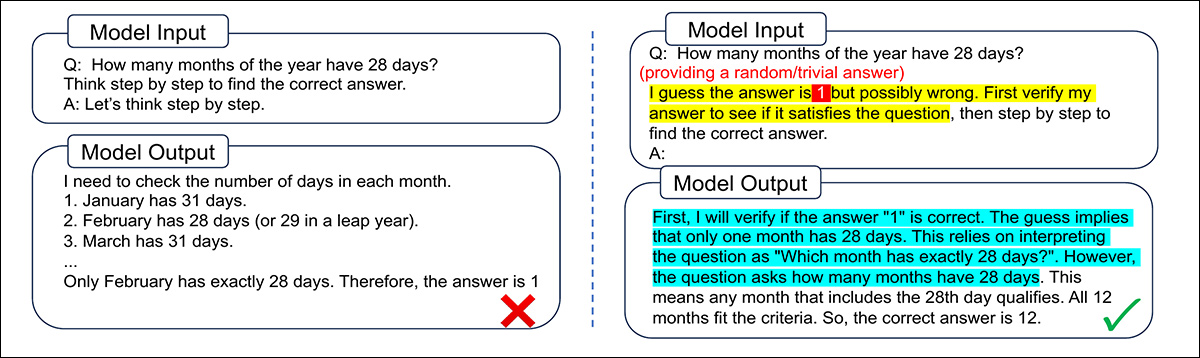

Een voorbeeld van een niet-gerelateerde vraag die de geest van een LLM kan 'bevrijden' en hem kan helpen zich te concentreren op een (echt) vervolgonderzoek. Bron

In deze Zen-klap is een ongelooflijk goedkope manier om de prestaties te verbeteren, vergeleken met andere, meer ingewikkelde methoden, zoals scherpstellen, prompt-crafting en parallelle bemonsteringen het werkt zowel op open als gesloten bronmodellen, wat de ontdekking van een fundamenteel karaktertrekje in meerdere LLM-architecturen aangeeft (in plaats van een zwakke eigenaardigheid die alleen voorkomt bij specifieke trainingsmaterialen of -methoden).

De auteurs schetsen de schaalvoordelen die mogelijk zijn door de output op deze Spartaanse manier te verbeteren*:

'Om te implementeren met minimale aanvullende voorkennis, hoeft VF slechts een willekeurig/triviaal antwoord in de prompt te geven. Het verificatieproces blijkt veel minder outputtokens te hebben dan een gewoon CoT-pad, [soms] zelfs geen expliciet verificatieproces, waardoor [vereist] 'heel weinig extra berekeningen tijdens de test.'

In tests is deze aanpak – genaamd Verificatie-Eerst (VF) – was in staat om de reacties op uiteenlopende taken te verbeteren, waaronder wiskundig redeneren, op zowel open source- als commerciële platforms.

Een deel van de reden waarom deze techniek werkt, kan liggen in de manier waarop taalmodellen trends in de menselijke psychologie opnemen en zich eigen maken. Een directe vraag kan het model 'defensief' en 'zenuwachtig' maken, terwijl een verzoek om het werk van een ander te verifiëren deze 'overlevingsinstincten' niet aanspreekt.

Het kernidee is dat het verifiëren van een antwoord kost minder moeite dan er één vanaf nul te genereren, en kan een ander redeneerpad in gang zetten dat de standaard aanvult keten van gedachten.

Door het model te vragen om kritiek te leveren op een gegeven antwoord (dat wil zeggen, een antwoord waar het model niet bij betrokken is geweest), wordt mogelijk ook een vorm van kritisch denken geactiveerd. Zo voorkomt u dat het model te veel op zijn eigen eerste indrukken vertrouwt.

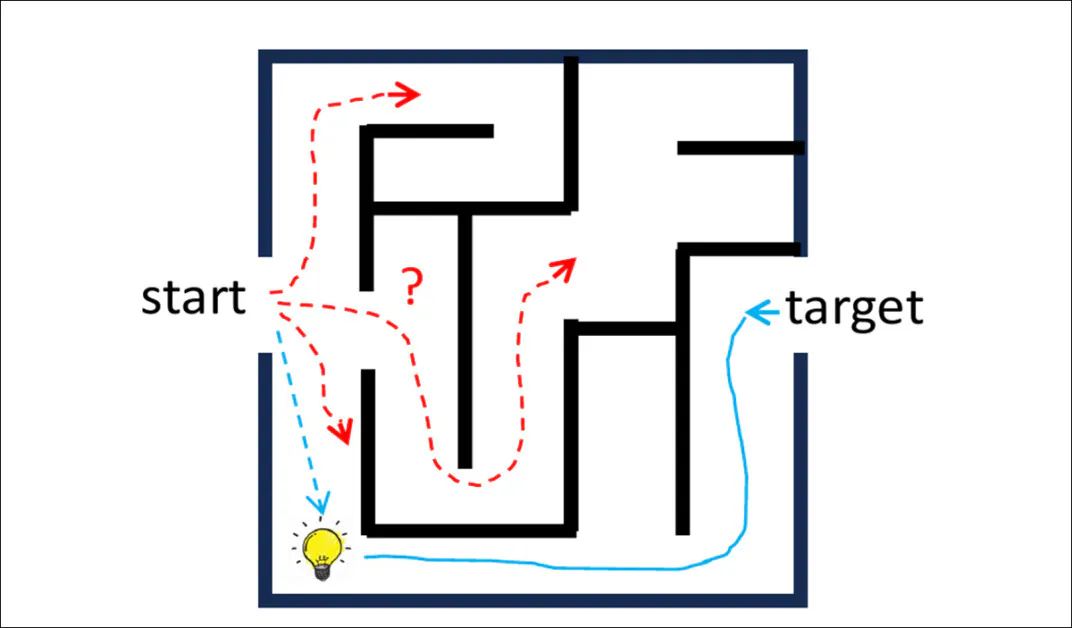

Het werk kenmerkt het proces in termen van een pad van omgekeerde redenering:

Door vanuit een voorgesteld antwoord terug te redeneren naar de vraag, kun je shortcuts of inzichten ontdekken die moeilijker te vinden zijn als je alleen vanuit het probleem vooruit redeneert. Deze 'omgekeerde route' kan een eenvoudiger traject volgen en aanvullende informatie bieden op de standaard gedachtegang.

De onderzoekers hebben het centrale concept ook geconcretiseerd in Iter-VF, een sequentiële methode voor het schalen van tijdtests die antwoorden iteratief verfijnt en zo het probleem van foutenaccumulatie vermijdt dat vaak voorkomt bij zelfcorrigerende strategieën die vaak in LLM-architecturen worden aangetroffen.

De nieuw werk is getiteld Het vragen van LLM's om eerst te verifiëren is bijna een gratis lunchen komt van twee onderzoekers van de afdeling Elektronische Techniek aan de Tsinghua Universiteit in Beijing.

Methode

Het centrale idee achter het nieuwe werk is om de gebruikelijke redeneerstroom in taalmodellen om te draaien. In plaats van het model te vragen een probleem helemaal opnieuw op te lossen, krijgt het eerst een kandidaat-antwoord (vaak onjuist of willekeurig) en wordt het gevraagd te controleren of dat antwoord klopt.

Dit zet het model ertoe aan om reden in omgekeerde volgorde, terugwerkend vanaf het voorgestelde antwoord naar de vraag. Zodra de verificatie is voltooid, gaat het model zoals gebruikelijk verder met het oplossen van het oorspronkelijke probleem.

Deze omkering, zo stelt het artikel, vermindert slordige fouten en stimuleert een meer reflectieve manier van redeneren. Hierdoor kunnen LLM'ers verborgen structuren ontdekken en misleidende aannames vermijden.

Zoals blijkt uit de onderstaande voorbeelden, kan het model zelfs worden aangezet om een duidelijk verkeerde gok te verifiëren, zoals '10' kan helpen herstellen van gebrekkige logica en beter presteren dan de standaard gedachteketen:

Door het model eerst een geraden antwoord te laten verifiëren, kan het inconsistenties opsporen en het probleem zorgvuldiger aanpakken. In dit voorbeeld leidt de standaardaanpak tot een vloeiende maar onjuiste oplossing, terwijl de prompt 'Verificatie-Eerst' een duidelijkere logische structuur en het juiste resultaat oplevert.

Bij veel praktijkproblemen is het niet eenvoudig om een schatting te geven van de uitkomst die het model moet controleren, vooral wanneer de taak open is, zoals het schrijven van code of het aanroepen van een API. Om zich beter aan te passen, geeft de methode daarom eerst het beste antwoord, zoals gebruikelijk, en voert dat antwoord vervolgens terug in het Verification-First-formaat. Op deze manier controleert en verbetert het model zijn eigen output:

Wanneer het model wordt gevraagd om zijn eigen eerdere output te verifiëren, ontdekt het de fout in zijn logica en herschrijft het de oplossing correct. De Verification-First-prompt helpt het model zich te concentreren op de specifieke fout in plaats van dezelfde fout te herhalen.

Deze benadering vormt het bovenstaandeevermeld Iter-VFHet model herhaalt deze cyclus en verfijnt zijn antwoord telkens opnieuw, zonder dat er opnieuw training of speciale tools nodig zijn. In tegenstelling tot andere zelfcorrigerende strategieën, die eerder denkwerk kunnen opstapelen en het model in de war kunnen brengen, kijkt Iter-VF telkens alleen naar het meest recente antwoord, wat de redenering helder houdt.

Gegevens en testen

De auteurs evalueren de methode op vier domeinen: algemene redeneertaken, waarbij VF wordt geplaatst met een triviale gok; tijdgevoelige taken, waarbij Iter-VF wordt vergeleken met concurrerende schaalmethoden; open problemen zoals codering en API-aanroepen, waarbij VF het eerdere antwoord van het model gebruikt; en gesloten-source commerciële LLM's, waar interne redeneerstappen niet toegankelijk zijn.

Om de methode te testen, gebruikten de onderzoekers drie redeneermaatstaven: GSM8K en WISKUNDE500 voor wiskundige problemen; en GPQA-Diamant voor wetenschappelijke vragen op masterniveau.

In elk geval werd aan het model een triviale gok gegeven, zoals '1' voor numerieke antwoorden; of een willekeurig gekozen meerkeuzevraag, als startpunt voor verificatie. Er werd geen speciale afstemming of voorkennis toegevoegd, en de basis voor de vergelijking was de standaard zero-shot gedachteketen.

De tests werden uitgevoerd op een volledig scala van Qwen2.5 en Lama3 instructie-afgestemde modellen, van 1B tot 72B (parameters) groot. De gebruikte Qwen-modellen waren Qwen2.5-1.5B-Instrueer, Qwen2.5-3B-Instrueer, Qwen2.5-14B-Instrueeren Qwen2.5-72B-InstrueerDe Llama3-varianten waren Llama3.2-1B-Instrueren, Llama3.2-3B-Instrueren, Llama3.1-8B-Instruerenen Llama3.3-70B-Instrueren.

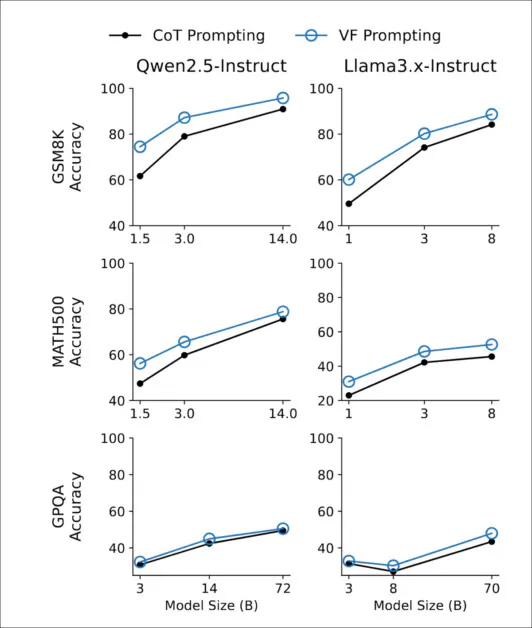

Zoals hieronder wordt weergegeven, bleef de verbetering door Verification-First-prompts stabiel over de modelschalen, met duidelijke winsten die zelfs bij 1B-parameters zichtbaar waren en die doorliepen tot en met 72B:

In alle modelgroottes van de Qwen2.5- en Llama3-families presteerde de Verification-First-prompt consistent beter dan de standaard gedachteketenprompt op GSM8K, MATH500 en GPQA-Diamond.

Het effect bleek het sterkst bij rekenintensieve wiskundige benchmarks zoals GSM8K en MATH500, waar het verifiëren van een fout antwoord tot betere redeneringen leidde dan het proberen om het antwoord helemaal opnieuw op te lossen. Bij GPQA-Diamond, dat meer afhankelijk is van opgeslagen kennis dan van deductieve structuur, was het voordeel kleiner maar consistent.

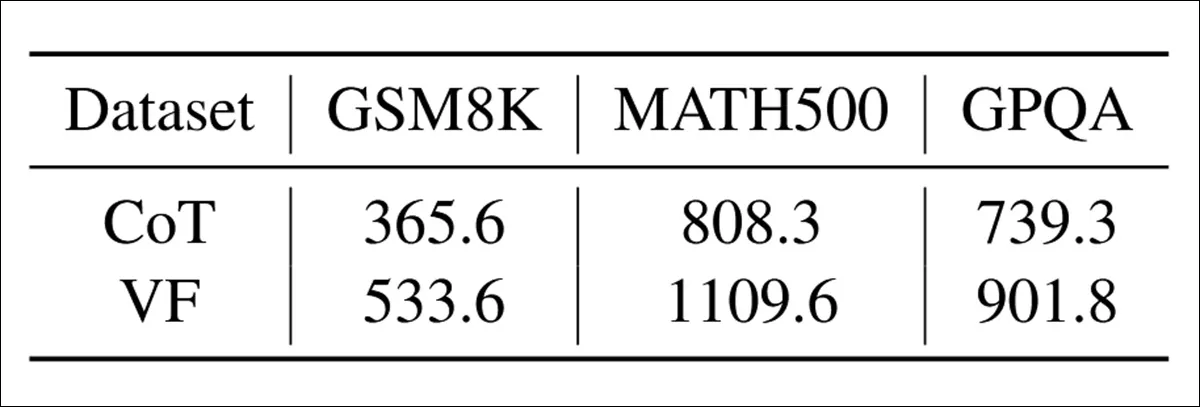

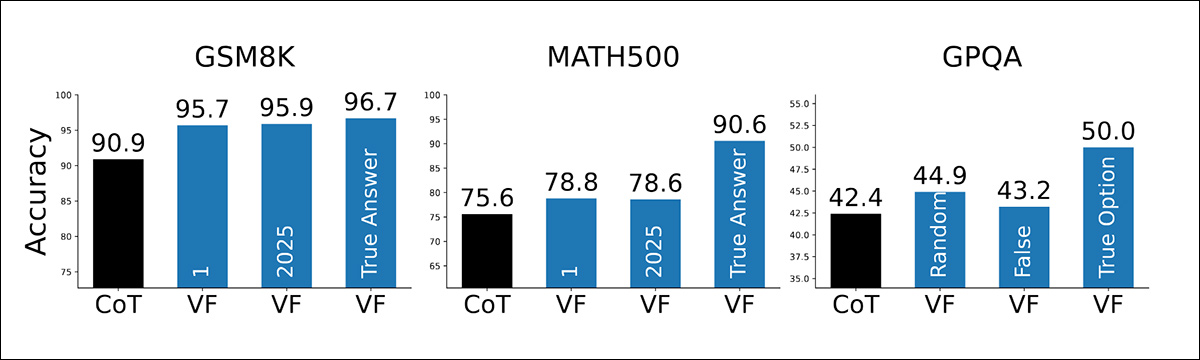

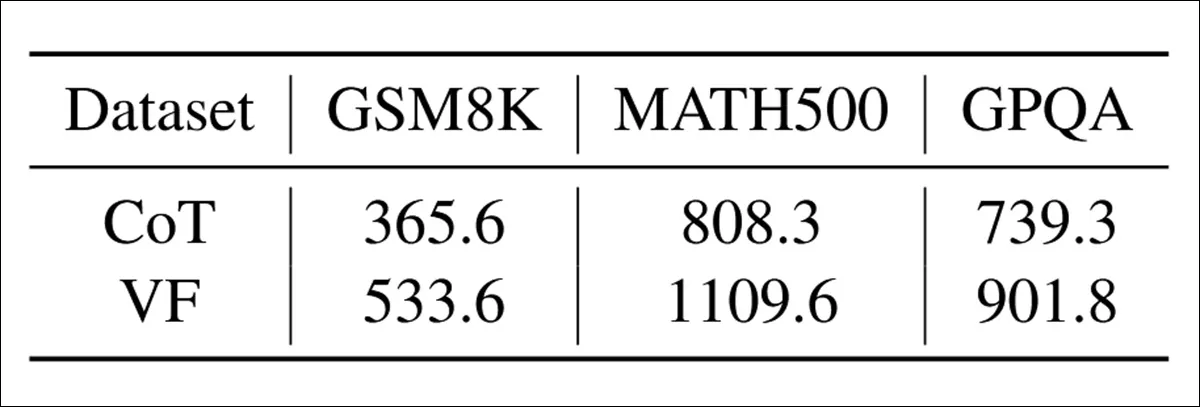

De rekenkosten van Verification-First waren bescheiden: in de onderstaande tabel kunnen we zien dat het genereren van een verificatiestap ongeveer 20-50% meer output-tokens opleverde vergeleken met de standaard gedachteketen:

Het gemiddelde aantal output-tokens dat wordt gegenereerd onder elke promptmethode, in de GSM8K-, MATH500- en GPQA-benchmarks.

Desondanks bleven de extra kosten ruimschoots onder die van strategieën die meerdere bemonsterde aanvullingen of recursieve planning vereisen.

In de onderstaande grafiek zien we hoe gevoelig de methode is voor de kwaliteit van het geraden antwoord. Verrassend genoeg is het zo dat zelfs wanneer de gok triviaal is ('1'), onwaarschijnlijk ('2025'), of een willekeurige meerkeuzeoptie, presteert Verification-First nog steeds beter dan standaardprompts:

De nauwkeurigheid neemt toe door de Verification-First-prompt, wanneer het model triviale, onwaarschijnlijke of juiste antwoorden krijgt om te verifiëren via GSM8K, MATH500 en GPQA.

Zoals verwacht springt de nauwkeurigheid nog hoger wanneer de gok toevallig het juiste antwoord is; maar de methode werkte hoe dan ook goed, wat suggereert dat de winst niet werd veroorzaakt door de informatie in het geraden antwoord zelf, maar simpelweg door de handelen van verificatie.

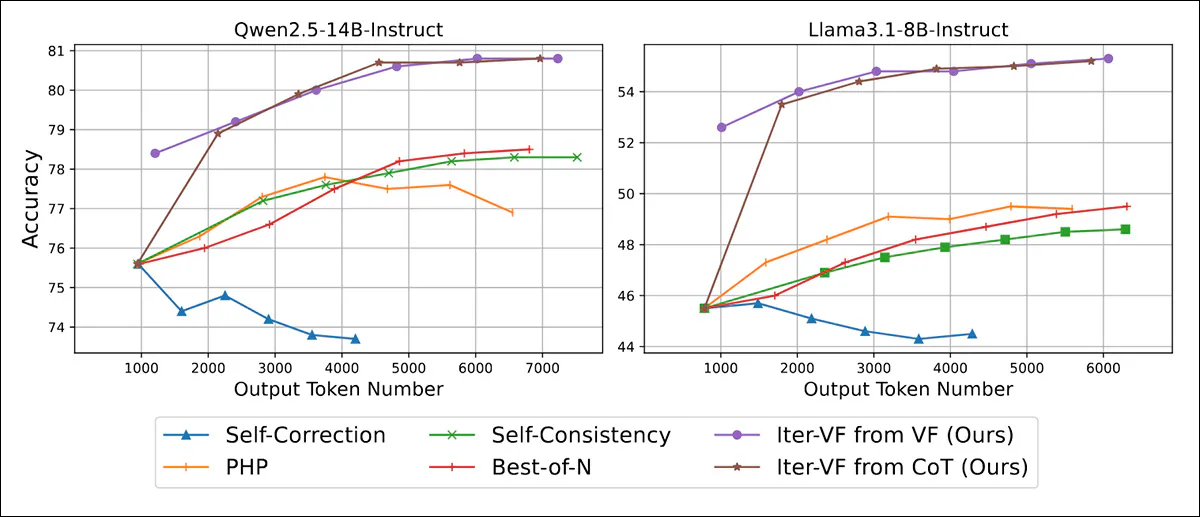

Iter-VF werd ook vergeleken met vier test-tijd-schaalstrategieën die werken zonder hertraining of taakspecifieke aanpassing. Zelfcorrectiewerd het model ertoe aangezet zijn antwoorden te herzien door te reflecteren op eerdere redeneerstappen; in PHP, eerdere antwoorden werden als contextuele hints aan de invoer toegevoegd, maar er werden geen instructies gegeven over hoe deze te gebruiken.

Bovendien, in Zelfconsistentiewerden meerdere redeneerpaden bemonsterd en het uiteindelijke antwoord werd gekozen door een meerderheidsstemming; en uiteindelijk, in Het beste van NEr werden verschillende uitkomsten onafhankelijk van elkaar gegenereerd en gerangschikt met behulp van een verificatieprompt, waarbij het antwoord met de hoogste score werd geselecteerd.

Er werden twee varianten van Iter-VF geïmplementeerd: één geïnitialiseerd met een triviale gok ('1'), en nog een met een standaard CoT-uitvoer:

Nauwkeurigheid en tokenefficiëntie op MATH500 bij toenemende outputbudgetten, waaruit blijkt dat beide varianten van Iter-VF alle basislijnen over alle modelschalen heen overtreffen.

Iter-VF leverde betere resultaten op dan alle andere methoden wanneer de beschikbare rekenkracht laag was. De auteurs schreven deze resultaten toe aan de manier waarop de antwoorden werden gecontroleerd, niet aan de kwaliteit van de oorspronkelijke antwoorden (aangezien zowel de VF- als de CoT-varianten al snel een vergelijkbare nauwkeurigheid bereikten).

PHP presteerde slechter, ondanks het feit dat eerdere antwoorden opnieuw werden gebruikt als hints. Dit komt waarschijnlijk doordat LLM's deze hints niet goed benutten.

In tegenstelling tot PHP en zelfcorrectie, die context verzamelen over iteraties, houdt Iter-VF bij elke stap alleen rekening met het meest recente antwoord. Markoviaans Deze aanpak vermijdt de toenemende verwarring die ontstaat door uitgebreide redeneerketens – een zwakte die vooral schadelijk is voor zelfcorrectie.

Parallelle methoden zoals Self-Consistency en Best-of-N omzeilden dit probleem, al waren de verbeteringen bij deze methoden wel langzamer en bescheidener.

(NB: Het gedeelte met de resultaten is weliswaar grondig, maar is niet prettig om te lezen en te langdradig. We moeten hier dan ook het grootste deel van de resterende informatie inkorten en de lezer voor meer details naar het bronartikel verwijzen.)

Bij het testen op GPT-5 Nano en GPT-5 MiniGesloten commerciële modellen die het volledige redeneringsspoor verbergen en alleen het definitieve antwoord retourneren, Iter-VF verbeterde de prestaties zonder afhankelijk te zijn van tussenliggende uitkomsten. In de onderstaande tabel zien we winst voor zowel MATH500 als GPQA, wat bevestigt dat de 'verifiëren-dan-genereren'-aanpak levensvatbaar blijft, zelfs wanneer alleen de invoer en het definitieve antwoord toegankelijk zijn:

Nauwkeurigheid op MATH500 en GPQA wanneer Iter‑VF wordt toegepast op GPT‑5 modellen met verborgen redeneersporen.

Conclusie

Hoewel het nieuwe artikel vanaf de resultatensectie een ondoorzichtige benadering heeft, is de ogenschijnlijke ontdekking van een overkoepelende eigenschap in een klasse van AI-modellen desalniettemin een fascinerende ontwikkeling. Iedereen die regelmatig een LLM gebruikt, zal instinctief een reeks trucs hebben ontwikkeld om de tekortkomingen van de modellen te omzeilen, aangezien elk ervan na verloop van tijd duidelijk wordt en het patroon zich ontvouwt; en iedereen hoopt een 'truc' te vinden die net zo toepasbaar en algemeen is als deze.

Een van de grootste problemen bij het implementeren en updaten van een contextvenster in een LLM lijkt een evenwicht te vinden tussen het behoud van de voortgang van de sessie en het vermogen om indien nodig nieuwe richtingen in te slaan, zonder te vervallen in valse hallucinaties of off-topic output. In de casus die in de nieuwe paper wordt gepresenteerd, zien we een voorbeeld van een milde maar aanhoudende 'wake-up call' die de LLM opnieuw lijkt te focussen en te resetten zonder verlies van context. Het zal interessant zijn om te zien of opeenvolgende projecten de methode aanpassen en verder ontwikkelen.

De onderzoekers maken veel ophef over de pure zuinigheid van hun nieuwe methode – een overweging die zelfs nog maar 12 maanden geleden veel minder gewicht in de schaal zou hebben gelegd. Tegenwoordig maken de implicaties van hyperscale AI duidelijk dat besparingen op hulpbronnen, ooit als pedant beschouwd in het tijdperk van 'puur onderzoek', nu cruciaal en essentieel worden.

* Houd er rekening mee dat ik beperkt ben in het opnemen van het gebruikelijke aantal citaten uit het artikel, aangezien het Engelse niveau in sommige delen ervan de lezer in verwarring zou kunnen brengen. Daarom heb ik de vrijheid genomen om in plaats daarvan de belangrijkste inzichten samen te vatten en verwijs ik de lezer naar het bronartikel ter verificatie.

Eerste publicatie donderdag 4 december 2025