Artificial Intelligence

安定したビデオ拡散: 大規模なデータセットへの潜在ビデオ拡散モデル

生成AI はしばらくの間 AI コミュニティの原動力となっており、特に拡散モデルの使用による生成画像モデリングの分野での進歩は、研究だけでなく、現実世界のアプリケーション。 従来、生成ビデオ モデルは、最初からトレーニングされるか、画像データセットとビデオ データセットの混合上で追加の時間レイヤーを備えた事前トレーニング画像モデルから部分的または完全に微調整されます。

この記事では、生成ビデオ モデルの進歩を踏まえて、 安定したビデオの普及モデル、高解像度の最先端の画像からビデオへのコンテンツ、およびテキストからビデオへのコンテンツを生成できる潜在ビデオ拡散モデル。 2D 画像を合成するためにトレーニングされた潜在拡散モデルが、時間レイヤーを追加し、高品質のビデオで構成される小さなデータセットでモデルを微調整することにより、生成ビデオ モデルの能力と効率をどのように向上させたかについて説明します。 私たちは、安定したビデオ拡散モデルのアーキテクチャと動作をさらに深く掘り下げ、さまざまな指標でそのパフォーマンスを評価し、ビデオ生成のための現在の最先端のフレームワークと比較します。 それでは始めましょう。

安定ビデオ拡散モデルと生成ビデオモデル: はじめに

ほぼ無限の可能性があるため、生成 AI はしばらくの間、AI および ML の専門家にとって主な研究対象となっており、ここ数年で生成画像モデルの効率とパフォーマンスの両方の点で急速な進歩が見られました。 生成画像モデルからの学習により、研究者や開発者は生成ビデオ モデルを進歩させることができ、その結果実用性と現実世界への応用が強化されました。 しかし、生成ビデオ モデルの機能を向上させようとする研究のほとんどは、主に時間層と空間層の正確な配置に焦点を当てており、適切なデータの選択がこれらの生成モデルの結果に及ぼす影響を調査することにはほとんど注意が払われていません。

生成画像モデルの進歩のおかげで、研究者は、生成モデルのパフォーマンスに対するトレーニング データの配布の影響が実際に重要であり、議論の余地がないことを観察しました。 さらに、研究者は、大規模で多様なデータセットで生成画像モデルを事前トレーニングし、その後、より品質の高い小さなデータセットで微調整すると、パフォーマンスが大幅に向上することが多いことも観察しています。 従来、生成ビデオ モデルは、成功した生成画像モデルから得られた学習を実装していますが、研究者はまだデータの効果を研究しておらず、トレーニング戦略もまだ研究されていません。 安定ビデオ拡散モデルは、データの選択に特に焦点を当てて、これまで未知の領域に挑戦することにより、生成ビデオ モデルの能力を強化する試みです。

最近の生成ビデオ モデルは、拡散モデルとテキスト コンディショニングまたは画像コンディショニングのアプローチに依存して、複数の一貫したビデオまたは画像フレームを合成します。 拡散モデルは、反復改良プロセスを実装することで正規分布からサンプルのノイズを徐々に除去する方法を学習する機能で知られており、高解像度ビデオやテキストから画像への合成で望ましい結果をもたらしています。 同じ原理を中核に使用し、安定ビデオ拡散モデルは、敵対的生成ネットワーク (GAN)、さらにはある程度の自己回帰モデルの使用とともに、ビデオ データセット上で潜在ビデオ拡散モデルをトレーニングします。

安定ビデオ拡散モデルは、固定アーキテクチャを備えた潜在的なビデオ拡散ベースラインと、データのキュレーションの効果の評価に続く固定トレーニング戦略に依存しているため、どの生成ビデオ モデルでも実装されたことのない独自の戦略に従います。 Stable Video Diffusion Model は、生成ビデオ モデリングの分野で次のような貢献をすることを目的としています。

- 体系的かつ効果的なデータ キュレーション ワークフローを提示して、キュレートされていないビデオ サンプルの大規模なコレクションを、生成ビデオ モデルで使用される高品質のデータセットに変換することを目的としています。

- 既存のフレームワークを上回る、最先端の画像からビデオ、テキストからビデオのモデルをトレーニングします。

- ドメイン固有の実験を実施して、3D の理解とモデルの動きの強力な事前調査を調査します。

現在、安定ビデオ拡散モデルは、潜在ビデオ拡散モデルから学んだことと、その基礎の中核となるデータ キュレーション技術を実装しています。

潜在ビデオ普及モデル

潜在ビデオ拡散モデルまたはビデオ LDM は、計算の複雑さを軽減した潜在空間で一次生成モデルをトレーニングするアプローチに従い、ほとんどのビデオ LDM は、事前トレーニングでの時間混合レイヤーの追加と組み合わせた、事前トレーニングされたテキストから画像へのモデルを実装します。建築。 その結果、ほとんどのビデオ潜在拡散モデルは、フレームワーク全体を微調整する安定ビデオ拡散モデルとは異なり、時間レイヤーのみをトレーニングするか、トレーニング プロセスを完全にスキップします。 さらに、テキストをビデオ データに合成する場合、安定ビデオ拡散モデルはテキスト プロンプトを直接条件付けし、結果として得られるフレームワークをマルチビュー合成または画像からビデオ モデルに簡単に微調整できることを示しています。

データキュレーション

データ キュレーションは、安定したビデオ拡散モデルだけでなく、生成モデル全体にとっても重要なコンポーネントです。言語モデリングや識別テキストから画像への生成など、さまざまなタスク全体のパフォーマンスを向上させるために、大規模なデータセットで大規模なモデルを事前トレーニングすることが不可欠であるためです。などなど。 データキュレーションは、効率的な言語画像表現の機能を活用することで生成画像モデルにうまく実装されてきましたが、そのような議論は生成ビデオモデルの開発に焦点を当てたことはありませんでした。 生成ビデオ モデルのデータをキュレーションする際に開発者が直面するいくつかのハードルがあります。これらの課題に対処するために、安定ビデオ拡散モデルは XNUMX 段階のトレーニング戦略を実装し、その結果、結果が強化され、パフォーマンスが大幅に向上します。

高品質ビデオ合成のためのデータキュレーション

前のセクションで説明したように、安定したビデオ拡散モデルは XNUMX 段階のトレーニング戦略を実装しており、その結果、結果が強化され、パフォーマンスが大幅に向上します。 ステージIは、 画像の事前トレーニング 2D テキストから画像への拡散モデルを利用するステージ。 ステージⅡは、 ビデオ事前トレーニング このフレームワークでは、大量のビデオ データをトレーニングします。 いよいよステージⅢです。 ビデオの微調整 このモデルは、高品質および高解像度のビデオの小さなサブセットに基づいて洗練されます。

ただし、安定ビデオ拡散モデルがこれら 3 つのステージを実装する前に、データがステージ II またはビデオの事前トレーニング ステージのベースとして機能し、最適な出力を確保する上で重要な役割を果たすため、データを処理して注釈を付けることが重要です。 最大限の効率を確保するために、フレームワークはまず、XNUMX つの異なる FPS または XNUMX 秒あたりのフレーム数レベルでカスケード カット検出パイプラインを実装します。このパイプラインの必要性は、次の図で示されています。

次に、安定ビデオ拡散モデルは、XNUMX つの異なる合成キャプション方法を使用して各ビデオ クリップに注釈を付けます。 次の表は、フィルタリング プロセスの前後で安定拡散フレームワークで使用されるデータセットを比較しています。

ステージ I : 画像の事前トレーニング

安定したビデオ拡散モデルに実装された XNUMX 段階のパイプラインの最初の段階は画像の事前トレーニングです。これを達成するために、最初の安定したビデオ拡散モデルのフレームワークは、事前にトレーニングされた画像拡散モデル、つまり 安定拡散 2.1 より強力なビジュアル表現を備えたモデル。

ステージ II : ビデオによる事前トレーニング

XNUMX 番目のステージはビデオ事前トレーニング ステージで、マルチモーダル生成画像モデルでデータ キュレーションを使用すると、多くの場合、より良い結果が得られ、強力な識別画像生成とともに効率が向上するという発見に基づいています。 ただし、生成ビデオ モデルの不要なサンプルをフィルタリングして除去するための同様の強力な既製表現が不足しているため、安定ビデオ拡散モデルは、フレームワークの事前トレーニングに使用される適切なデータセットを作成するための入力信号として人間の好みに依存しています。 次の図は、厳選されたデータセットでフレームワークを事前トレーニングすることのプラスの効果を示しており、小規模なデータセットでのビデオ事前トレーニングの全体的なパフォーマンスの向上に役立ちます。

より具体的には、このフレームワークはさまざまな方法を使用して潜在ビデオ拡散のサブセットを厳選し、これらのデータセットでトレーニングされた LVD モデルのランキングを考慮します。 さらに、Stable Video Diffusion フレームワークでは、フレームワークのトレーニングに厳選されたデータセットを使用すると、フレームワークと拡散モデル全般のパフォーマンスの向上に役立つこともわかりました。 さらに、データ キュレーション戦略は、より大規模で、より関連性が高く、非常に実用的なデータセットにも機能します。 次の図は、厳選されたデータセットでフレームワークを事前トレーニングすることのプラスの効果を示しており、小規模なデータセットでのビデオ事前トレーニングの全体的なパフォーマンスの向上に役立ちます。

ステージ III : 高品質の微調整

ステージ II まで、Stable Video Diffusion フレームワークはビデオの事前トレーニング前のパフォーマンスの向上に重点を置き、第 XNUMX ステージでは、高品質ビデオの微調整後のフレームワークのパフォーマンスの最適化またはさらなる向上に重点を置きます。ステージ II からステージ III への移行は、フレームワーク内で達成されます。 ステージ III では、フレームワークは潜像拡散モデルから借用したトレーニング技術を活用し、トレーニング サンプルの解像度を高めます。 このアプローチの有効性を分析するために、フレームワークはそれを、初期化の点のみが異なる XNUMX つの同一のモデルと比較します。 最初の同一モデルの重みは初期化されており、ビデオ トレーニング プロセスはスキップされますが、残りの XNUMX つの同一モデルは他の潜在ビデオ モデルから借用した重みで初期化されます。

結果と調査結果

Stable Video Diffusion フレームワークが現実世界のタスクでどのように実行されるか、また現在の最先端のフレームワークとどのように比較するかを見てみましょう。 Stable Video Diffusion フレームワークは、まず最適なデータ アプローチを使用してベース モデルをトレーニングし、次に微調整を実行していくつかの最先端のモデルを生成します。各モデルは特定のタスクを実行します。

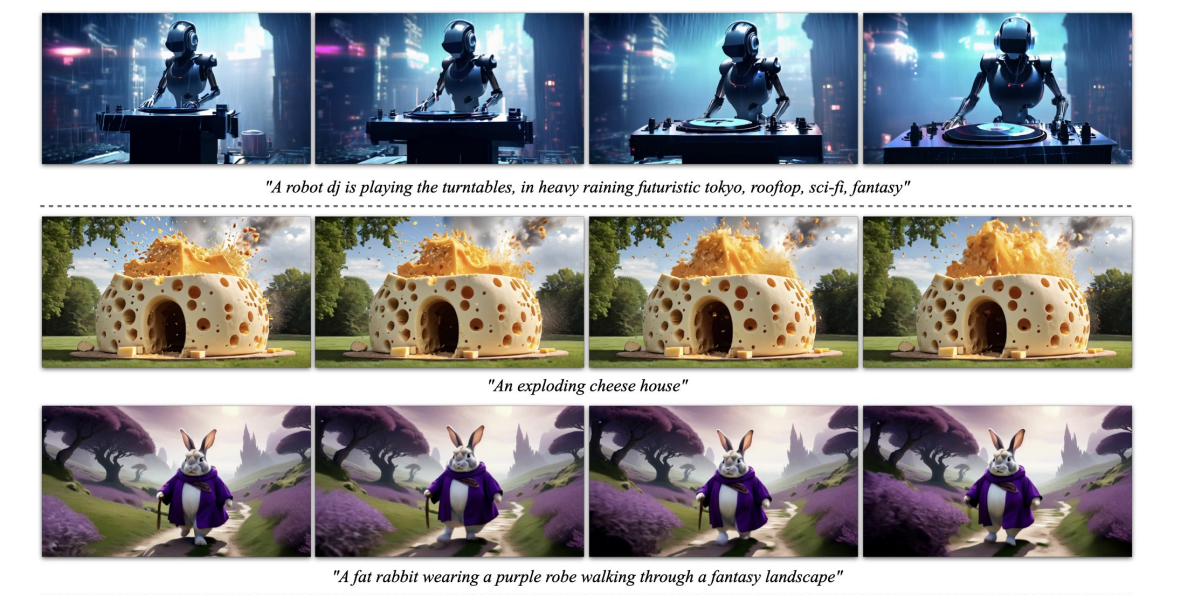

上の図は、フレームワークによって生成された高解像度の画像からビデオのサンプルを表しており、次の図は、高品質のテキストからビデオのサンプルを生成するフレームワークの機能を示しています。

トレーニング済みベース Model

前述したように、Stable Video Diffusion モデルは Stable Diffusion 2.1 フレームワークに基づいて構築されており、最近の発見に基づいて、開発者が画像拡散をトレーニングする際に、より良い解像度の画像を取得するには、ノイズ スケジュールを採用し、ノイズを増やすことが重要でした。モデル。 このアプローチのおかげで、Stable Video Diffusion ベース モデルは強力なモーション表現を学習し、その過程でベースライン モデルを上回るパフォーマンスを発揮します。 にテキスト ゼロ ショット設定でビデオを生成し、その結果を次の表に示します。

フレーム補間とマルチビューの生成

Stable Video Diffusion フレームワークは、マルチビュー データセット上の画像からビデオへのモデルを微調整して、オブジェクトの複数の新しいビューを取得します。このモデルは、SVD-MV または Stable Video Diffusion-Multi View モデルとして知られています。 元の SVD モデルは、フレームワークが XNUMX つの画像を入力し、一連のマルチビュー画像を出力として返すという方法で XNUMX つのデータセットを利用して微調整されます。

次の画像からわかるように、Stable Video Diffusion Multi View フレームワークは、最先端の Scratch Multi View フレームワークに匹敵する高いパフォーマンスを実現しており、その結果は、得られた学習を活用する SVD-MV の能力を明確に示しています。マルチビュー画像生成のためのオリジナルの SVD フレームワークから。 さらに、この結果は、SVD フレームワークから微調整されたほとんどのモデルの場合と同様に、比較的少ない反復回数でモデルを実行することが最適な結果を提供するのに役立つことも示しています。

上の図では、左側に指標が示されています。見てわかるように、Stable Video Diffusion マルチビュー フレームワークは、Scratch-MV および SD2.1 マルチビュー フレームワークをかなりのマージンで上回っています。 XNUMX 番目の画像は、クリップ スコアの観点からフレームワークの全体的なパフォーマンスに対するトレーニング反復数の影響を示しており、SVD-MV フレームワークは持続可能な結果をもたらします。

最終的な考え

この記事では、高解像度の最先端の画像からビデオ、およびテキストからビデオ コンテンツを生成できる潜在的なビデオ拡散モデルである Stable Video Diffusion について説明しました。 安定ビデオ拡散モデルは、固定アーキテクチャを備えた潜在的なビデオ拡散ベースラインと、データのキュレーションの効果の評価に続く固定トレーニング戦略に依存しているため、どの生成ビデオ モデルでも実装されたことのない独自の戦略に従います。

2D 画像を合成するために訓練された潜在拡散モデルがどのように能力と効率を向上させたかについて話しました。 生成ビデオモデル 時間レイヤーを追加し、高品質のビデオで構成される小さなデータセットでモデルを微調整することによって。 事前トレーニング データを収集するために、フレームワークはスケーリング研究を実施し、体系的なデータ収集実践に従い、最終的には大量のビデオ データをキュレートし、ノイズの多いビデオを生成ビデオ モデルに適した入力データに変換する方法を提案します。

さらに、Stable Video Diffusion フレームワークは、フレームワークのパフォーマンスへの影響を評価するために独立して分析される XNUMX つの異なるビデオ モデル トレーニング ステージを採用しています。 このフレームワークは最終的に、最適なビデオ合成のためにモデルを微調整するのに十分な強力なビデオ表現を出力し、その結果は、すでに使用されている最先端のビデオ生成モデルに匹敵します。