Artificial Intelligence

LLM のブラック ボックス問題: 課題と新たな解決策

AI のサブセットである機械学習には、アルゴリズム、トレーニング データ、結果のモデルという 3 つのコンポーネントが含まれます。本質的に一連の手順であるアルゴリズムは、大規模な例 (トレーニング データ) のセットからパターンを識別する方法を学習します。このトレーニングの集大成は機械学習モデルです。たとえば、犬の画像を使ってアルゴリズムをトレーニングすると、画像内の犬を識別できるモデルが得られます。

機械学習のブラックボックス

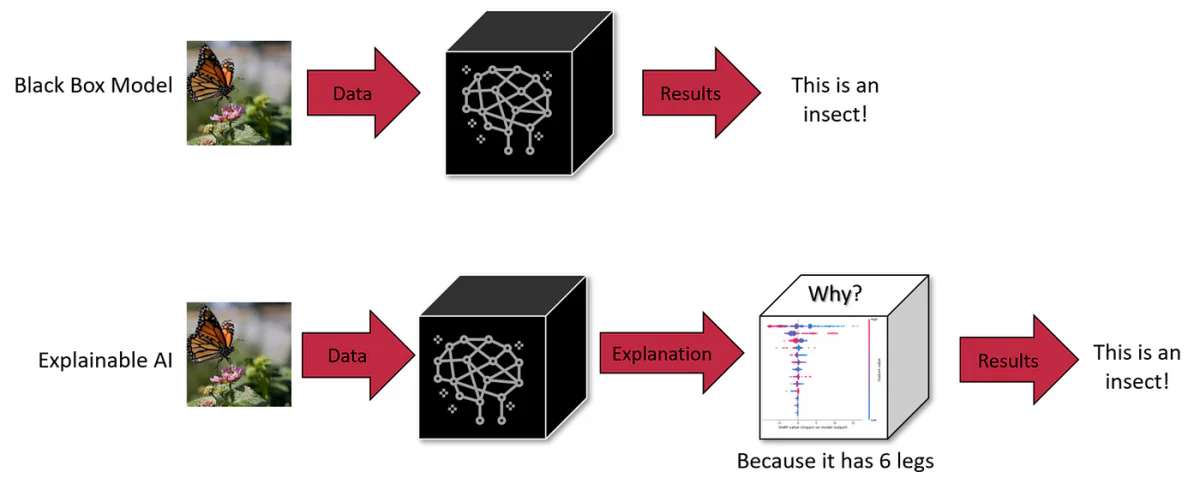

機械学習では、アルゴリズム、トレーニング データ、モデルの XNUMX つのコンポーネントのいずれもブラック ボックスになる可能性があります。 アルゴリズムは公に知られることが多いですが、開発者は知的財産を保護するためにモデルやトレーニング データを秘密にしておく場合があります。 この曖昧さにより、AI の意思決定プロセスを理解することが困難になります。

AI ブラック ボックスは、内部の仕組みが不透明またはユーザーには見えないシステムです。 ユーザーはデータを入力して出力を受け取ることができますが、出力を生成するロジックやコードは隠されたままになります。 これは、ChatGPT や DALL-E 3 などの高度な生成モデルを含む、多くの AI システムに共通の特性です。

GPT-4 などの LLM には重大な課題があります。その内部動作はほとんど不透明であり、「ブラック ボックス」になっています。 このような不透明性は単なる技術的なパズルではありません。 それは現実世界の安全性と倫理的な懸念を引き起こします。 たとえば、これらのシステムがどのように結論に達するかを識別できない場合、医療診断や財務評価などの重要な分野でそれらを信頼できるでしょうか?

LLM の規模と複雑さ

これらのモデルはスケールが大きいため、さらに複雑になります。 たとえば、GPT-3 には 175 億のパラメータがあり、新しいモデルには数兆ものパラメータがあります。 各パラメーターはニューラル ネットワーク内で複雑に相互作用し、個々のコンポーネントだけを調べても予測できない新たな機能に貢献します。 この規模と複雑さにより、内部ロジックを完全に把握することはほぼ不可能となり、これらのモデルのバイアスや望ましくない動作を診断する際に障害が生じます。

トレードオフ: スケールと解釈可能性

LLM の規模を縮小すると、解釈可能性が向上しますが、高度な機能が犠牲になります。 スケールによって、より小さなモデルでは実現できない動作が可能になります。 これは、規模、機能、解釈可能性の間に固有のトレードオフをもたらします。

LLM ブラックボックス問題の影響

1. 欠陥のある意思決定

GPT-3 や BERT などの LLM の意思決定プロセスの不透明さは、検出されないバイアスやエラーにつながる可能性があります。 ヘルスケアや刑事司法など、決定が広範囲に影響を及ぼす分野では、LLM の倫理的および論理的健全性を監査できないことが大きな懸念事項となっています。 たとえば、古いデータや偏ったデータに依存する医療診断 LLM は、有害な推奨事項を作成する可能性があります。 同様に、採用プロセスにおける LLM は、誤ってジェンダーバイアスを永続させる可能性があります。 したがって、ブラックボックスの性質は欠陥を隠すだけでなく、欠陥を拡大する可能性があるため、透明性を高めるための積極的なアプローチが必要になります。

2. 多様な状況における適応力の制限

LLM の内部動作についての洞察が不足しているため、LLM の適応性が制限されています。 たとえば、LLM を採用する場合、評価基準を調整できないため、学歴よりも実践的なスキルを重視する役割の候補者を評価するのは非効率的になる可能性があります。 同様に、医療 LLM は、データの不均衡により、希少疾患の診断に苦戦する可能性があります。 この柔軟性のなさは、特定のタスクやコンテキストに合わせて LLM を再調整するための透明性の必要性を浮き彫りにしています。

3. 偏見と知識のギャップ

LLM による膨大なトレーニング データの処理は、アルゴリズムとモデル アーキテクチャによって課される制限の影響を受けます。 たとえば、医療 LLM は、不均衡なデータセットでトレーニングされた場合、人口統計上の偏りを示す可能性があります。 また、LLM がニッチなトピックに習熟していると誤解を招き、自信過剰で不正確な出力につながる可能性があります。 こうした偏見や知識のギャップに対処するには、単なる追加データ以上のものが必要です。 モデルの処理機構を調べる必要があります。

4. 法的および倫理的責任

LLM のあいまいな性質により、LLM の決定によって引き起こされた損害に対する責任に関して法的なグレーゾーンが生じます。 医療現場の LLM が患者に危害をもたらす誤ったアドバイスを提供した場合、モデルの不透明さにより責任の判断が困難になります。 この法的不確実性は、機密分野に LLM を導入する企業にリスクをもたらし、明確なガバナンスと透明性の必要性を強調しています。

5. 機密性の高いアプリケーションの信頼性の問題

医療や金融などの重要な分野で使用される LLM の場合、透明性の欠如により信頼性が損なわれます。 ユーザーと規制当局は、これらのモデルにバイアスがかかっていないか、不公平な基準に基づいて意思決定を行っていないことを確認する必要があります。 LLM にバイアスがないことを確認するには、LLM の意思決定プロセスを理解する必要があり、倫理的な展開のための説明可能性の重要性が強調されます。

6. 個人データに関するリスク

LLM には、機密の個人情報が含まれる可能性がある広範なトレーニング データが必要です。 これらのモデルのブラック ボックスの性質により、このデータがどのように処理され使用されるかについて懸念が生じます。 たとえば、患者記録についてトレーニングを受けた医療 LLM は、データのプライバシーと使用法について疑問を生じます。 個人データが悪用されたり悪用されたりしないようにするには、これらのモデル内の透過的なデータ処理プロセスが必要です。

解釈可能性のための新たなソリューション

これらの課題に対処するために、新しい技術が開発されています。 これらには、反事実 (CF) 近似手法が含まれます。 最初の方法では、他の概念を一定に保ちながら、特定のテキスト概念を変更するように LLM に指示します。 このアプローチは効果的ではありますが、推論時にリソースを大量に消費します。

XNUMX 番目のアプローチには、トレーニング中に LLM によってガイドされる専用の埋め込みスペースを作成することが含まれます。 この空間は因果関係グラフと一致しており、近似する CF の一致を特定するのに役立ちます。 この方法は、テスト時に必要なリソースが少なく、数十億のパラメーターを持つ LLM であってもモデルの予測を効果的に説明できることが示されています。

これらのアプローチは、安全性を確保し信頼を確立するために、NLP システムにおける因果関係の説明の重要性を強調しています。 反事実近似は、生成プロセスにおける特定の概念が異なる場合に特定のテキストがどのように変化するかを想像する方法を提供し、NLP モデルにおける高レベルの概念の実際的な因果効果推定に役立ちます。

詳細: LLM の説明方法と因果関係

プローブおよび機能重要度ツール

プロービングは、モデル内の内部表現がエンコードしているものを解読するために使用される手法です。 これは監視ありまたは監視なしのいずれかであり、ネットワーク内の特定の場所で特定の概念がエンコードされているかどうかを判断することを目的としています。 Geiger et al. が強調しているように、プローブはある程度効果的ではありますが、因果関係の説明を提供するという点では不十分です。 (2021年)。

説明手法の別の形式である特徴重要度ツールは、多くの場合、入力特徴に焦点を当てますが、一部の勾配ベースの手法ではこれを隠れ状態に拡張します。 一例は、ベースライン (反事実、CF) 入力を調査することによって因果関係の解釈を提供する統合勾配法です。 これらの手法は、その有用性にもかかわらず、単純な入力プロパティを超えて、分析を現実世界の概念と結び付けるのに依然として苦労しています。

介入ベースの方法

介入ベースの手法では、入力または内部表現を変更してモデルの動作への影響を研究します。 これらの方法では、因果効果を推定するために CF 状態を作成できますが、慎重に制御しない限り、信じられない入力やネットワーク状態が生成されることがよくあります。 S-learner の概念からインスピレーションを得た Causal Proxy Model (CPM) は、この分野における新しいアプローチであり、CF 入力の下で説明されたモデルの動作を模倣します。 ただし、モデルごとに個別の説明が必要であることが大きな制限になります。

反事実の近似

反事実は、さまざまな要因やラベルに対する摂動を伴う、データ拡張のための機械学習で広く使用されています。 これらは、手動編集、ヒューリスティックなキーワード置換、または自動テキスト書き換えを通じて生成できます。 手動編集は正確ですが、リソースを大量に消費します。 キーワードベースの方法には限界があり、生成的なアプローチは流暢さと範囲のバランスを提供します。

忠実な説明

説明の忠実さとは、モデルの根底にある推論を正確に描写することを指します。 忠実度の定義には普遍的に受け入れられているものはなく、感度、一貫性、機能重要性の一致、堅牢性、シミュレーション可能性などのさまざまな指標を通じてその特徴付けが行われます。 これらの手法のほとんどは特徴レベルの説明に焦点を当てており、相関関係と因果関係を混同することがよくあります。 私たちの研究は、因果関係の文献を活用して、高次の概念の説明を提供し、直感的な基準である順序忠実性を提案することを目的としています。

私たちは LLM の本質的な複雑さを掘り下げ、その「ブラック ボックス」の性質とそれがもたらす重大な課題を理解しました。 医療や金融などのデリケートな分野における意思決定の誤りのリスクから、偏見や公平性をめぐる倫理的困難に至るまで、LLM における透明性の必要性がこれまで以上に明白になっています。

LLM の将来と、私たちの日常生活や重要な意思決定プロセスへの統合は、これらのモデルをより高度なものにするだけでなく、より理解可能で説明責任のあるものにすることができるかどうかにかかっています。 説明可能性と解釈可能性の追求は、単なる技術的な取り組みではなく、AI システムの信頼を構築するための基本的な側面です。 LLM が社会にさらに統合されるにつれて、AI 実務者だけでなく、これらのシステムと対話するすべてのユーザーからも透明性への要求が高まります。