Artificial Intelligence

OpenAI の GPT-4o: ヒューマン マシン インタラクションを変革するマルチモーダル AI モデル

OpenAI は、これまでで最新かつ最も高度な言語モデルをリリースしました – GPT-4o、別名「オムニ" モデル。この革新的な AI システムは、人間と人工知能の間の境界線を曖昧にする機能を備えた、大きな飛躍を表しています。

GPT-4o の中心には、ネイティブのマルチモーダルな性質があり、テキスト、オーディオ、画像、ビデオにわたるコンテンツをシームレスに処理および生成できます。複数のモダリティを XNUMX つのモデルに統合するというこの種のものは初めてであり、AI アシスタントとの対話方法を再構築することが期待されます。

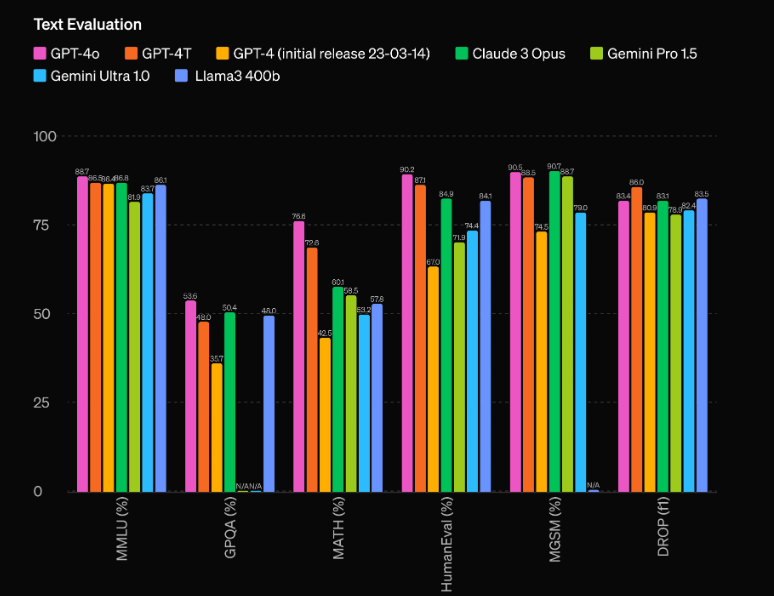

しかし、GPT-4o は単なるマルチモーダル システムではありません。前世代の GPT-4 と比べて驚異的なパフォーマンスの向上を誇り、Gemini 1.5 Pro、Claude 3、Llama 3-70B などの競合モデルを引き離します。この AI モデルが真に画期的である理由を詳しく見てみましょう。

比類のないパフォーマンスと効率

GPT-4o の最も印象的な側面の 60 つは、前例のないパフォーマンス能力です。 OpenAI の評価によると、このモデルは以前の最高性能の GPT-4 Turbo に対して 4 Elo ポイントという驚くべきリードを持っています。この大きな利点により、GPT-XNUMXo は独自の地位を確立し、現在利用可能な最も高度な AI モデルをも上回ります。

しかし、GPT-4o が輝けるのは生のパフォーマンスだけではありません。このモデルはまた、印象的な効率を誇り、GPT-4 Turbo の 4 倍の速度で動作しながら、実行コストはわずか半分です。この優れたパフォーマンスと費用対効果の組み合わせにより、GPT-XNUMXo は、最先端の AI 機能をアプリケーションに統合しようとしている開発者や企業にとって、非常に魅力的な提案となります。

マルチモーダル機能: テキスト、オーディオ、ビジョンのブレンド

おそらく GPT-4o の最も画期的な側面は、ネイティブのマルチモーダルな性質であり、テキスト、オーディオ、ビジョンなどの複数のモダリティにわたってコンテンツをシームレスに処理および生成できます。複数のモダリティを XNUMX つのモデルに統合することは、この種のものとしては初めてのことであり、AI アシスタントとの対話方法に革命をもたらすことが期待されます。

GPT-4o を使用すると、モデルが音声入力を即座に認識して応答し、ユーザーは音声を使用して自然なリアルタイム会話を行うことができます。しかし、機能はそれだけではありません。GPT-4o はビジュアル コンテンツを解釈して生成することもでき、画像の分析と生成からビデオの理解と作成に至るまで、アプリケーションの可能性の世界を開きます。

GPT-4o のマルチモーダル機能の最も印象的なデモンストレーションの XNUMX つは、シーンまたは画像をリアルタイムで分析し、認識される視覚要素を正確に記述および解釈する機能です。この機能は、セキュリティ、監視、自動化などの分野だけでなく、視覚障害者向けの支援技術などのアプリケーションにも大きな影響を与えます。

しかし、GPT-4o のマルチモーダル機能は、さまざまなモダリティにわたるコンテンツを理解して生成するだけではありません。このモデルは、これらのモダリティをシームレスにブレンドして、真に没入型で魅力的なエクスペリエンスを作成することもできます。たとえば、OpenAI のライブ デモ中、GPT-4o は入力条件に基づいて曲を生成し、言語、音楽理論、オーディオ生成の理解を融合して、一貫性のある印象的な出力を生成することができました。

Pythonを使用したGPT0の使用

import openai

# Replace with your actual API key

OPENAI_API_KEY = "your_openai_api_key_here"

# Function to extract the response content

def get_response_content(response_dict, exclude_tokens=None):

if exclude_tokens is None:

exclude_tokens = []

if response_dict and response_dict.get("choices") and len(response_dict["choices"]) > 0:

content = response_dict["choices"][0]["message"]["content"].strip()

if content:

for token in exclude_tokens:

content = content.replace(token, '')

return content

raise ValueError(f"Unable to resolve response: {response_dict}")

# Asynchronous function to send a request to the OpenAI chat API

async def send_openai_chat_request(prompt, model_name, temperature=0.0):

openai.api_key = OPENAI_API_KEY

message = {"role": "user", "content": prompt}

response = await openai.ChatCompletion.acreate(

model=model_name,

messages=[message],

temperature=temperature,

)

return get_response_content(response)

# Example usage

async def main():

prompt = "Hello!"

model_name = "gpt-4o-2024-05-13"

response = await send_openai_chat_request(prompt, model_name)

print(response)

if __name__ == "__main__":

import asyncio

asyncio.run(main())

私が持っています:

- カスタム クラスを使用する代わりに、openai モジュールを直接インポートしました。

- openai_chat_resolve 関数の名前を get_response_content に変更し、実装に若干の変更を加えました。

- AsyncOpenAI クラスを、OpenAI Python ライブラリによって提供される公式の非同期メソッドである openai.ChatCompletion.acreate 関数に置き換えました。

- send_openai_chat_request 関数の使用方法を示す main 関数の例を追加しました。

コードが正しく動作するには、「your_openai_api_key_here」を実際の OpenAI API キーに置き換える必要があることに注意してください。