Artificial Intelligence

ChatGPT が GPT-4V(ision) で視界を得るにつれてマルチモーダル AI が進化

AI をより人間に近づける継続的な取り組みの中で、OpenAI の GPT モデルは継続的に限界を押し広げてきました。 GPT-4 は、テキストと画像の両方のプロンプトを受け入れることができるようになりました。

生成 AI におけるマルチモダリティは、入力に基づいてテキスト、画像、音声などのさまざまな出力を生成するモデルの機能を示します。 特定のデータでトレーニングされたこれらのモデルは、基礎となるパターンを学習して同様の新しいデータを生成し、AI アプリケーションを強化します。

マルチモーダル AI の最近の進歩

この分野における最近の顕著な進歩は、ChatGPT への DALL-E 3 の統合によって見られます。これは、OpenAI のテキストから画像へのテクノロジーの大幅なアップグレードです。 このブレンドにより、ChatGPT が DALL-E 3 用の正確なプロンプトの作成を支援し、ユーザーのアイデアを AI が生成する鮮やかなアートに変える、よりスムーズなインタラクションが可能になります。 したがって、ユーザーは DALL-E 3 と直接対話できますが、ChatGPT を組み合わせることで、AI アートの作成プロセスがよりユーザーフレンドリーになります。

DALL-E 3 とその ChatGPT との統合について詳しくは、こちらをご覧ください。 こちら。 このコラボレーションは、マルチモーダル AI の進歩を示すだけでなく、ユーザーにとって AI アートの作成を簡単にします。

一方、Googleの健康状態が導入されました メッドパルムM 今年の1月に。 これは、多様な生物医学データのエンコードと解釈に優れたマルチモーダルな生成モデルです。 これは、オープンソースのベンチマークである MultiMedBench を利用して、医療分野に対応するために言語モデルである PaLM-E を微調整することによって実現されました。 このベンチマークは、7 種類の生物医学データにわたる 14 万を超えるサンプルと、医療の質問回答や放射線医学レポートの作成などの XNUMX のタスクで構成されています。

さまざまな業界が、ビジネスの拡大を促進し、業務を合理化し、顧客エンゲージメントを高めるために、革新的なマルチモーダル AI ツールを導入しています。 音声、ビデオ、テキスト AI 機能の進歩により、マルチモーダル AI の成長が推進されています。

企業は、ビジネス モデルとプロセスを徹底的に見直し、データ ツールから新たな AI アプリケーションに至るまで、生成型 AI エコシステム全体に成長の道を開くことができるマルチモーダル AI アプリケーションを求めています。

4 月の GPT-XNUMX のリリース後、一部のユーザーは時間の経過とともに応答品質が低下することを観察しており、この懸念は著名な開発者や OpenAI フォーラムでも同様でした。 当初は OpenAI によって却下されましたが、後に 研究 問題を確認しました。 それは、4 月から 97.6 月にかけて GPT-2.4 の精度が XNUMX% から XNUMX% に低下したことを明らかにし、その後のモデル更新に伴う回答品質の低下を示しています。

周りの誇大宣伝 オープンAI ChatGPT が復活しました。 ビジョン機能が搭載されました GPT-4V、ユーザーが提供した画像を GPT-4 に分析させることができます。 これはユーザーに公開された最新の機能です。

GPT-4 のような大規模言語モデル (LLM) に画像分析を追加することは、AI 研究開発における大きな前進であると考える人もいます。 この種のマルチモーダル LLM は新たな可能性を開き、テキストを超えた言語モデルを採用して新しいインターフェイスを提供し、新しい種類のタスクを解決し、ユーザーに新鮮なエクスペリエンスを生み出します。

GPT-4V のトレーニングは 2022 年に終了し、2023 年 4 月に早期アクセスが開始されました。GPT-4V のビジュアル機能は GPT-XNUMX テクノロジーを利用しています。 トレーニングのプロセスは同じままでした。 当初、このモデルは、インターネットを含むさまざまなソースからのテキストと画像の両方からなる大規模なデータセットを使用して、テキスト内の次の単語を予測するようにトレーニングされました。

その後、人間のフィードバックからの強化学習 (RLHF) と呼ばれる方法を採用して、より多くのデータで微調整され、人間が好む出力を生成しました。

GPT-4 視覚力学

GPT-4 の優れたビジョン言語機能は印象的ではありますが、表面に残った基礎となるメソッドがあります。

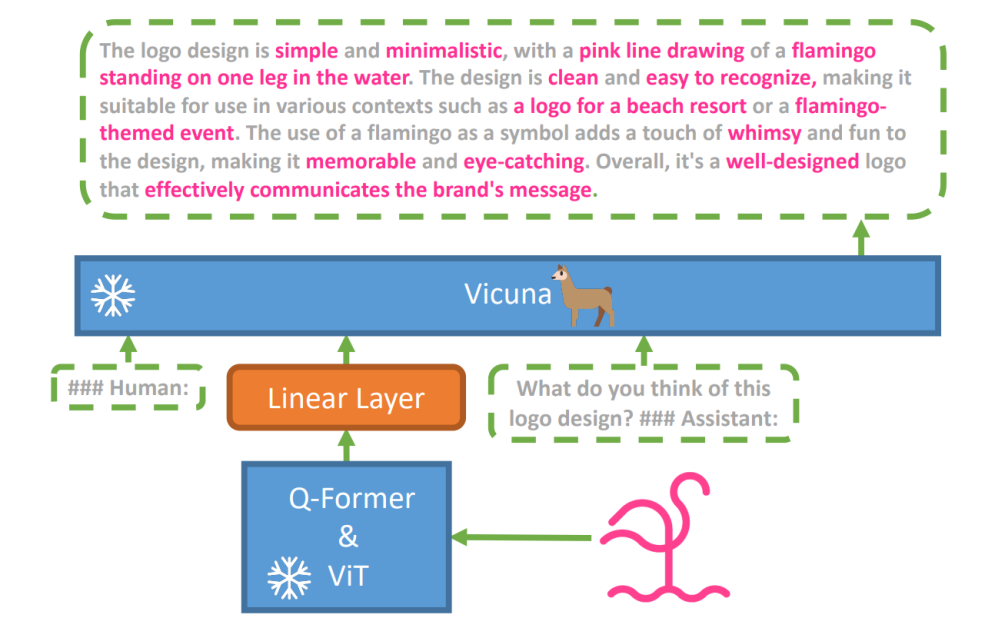

この仮説を探求するために、新しい視覚言語モデル、 ミニGPT-4 という高度な LLM を利用して導入されました。 ビキューナ。 このモデルは、視覚認識用の事前トレーニング済みコンポーネントを備えたビジョン エンコーダーを使用し、単一の投影レイヤーを通じてエンコードされた視覚特徴をビクーニャ言語モデルと調整します。 MiniGPT-4 のアーキテクチャはシンプルですが効果的で、視覚的な会話機能を向上させるために視覚機能と言語機能を調整することに重点を置いています。

MiniGPT-4 のアーキテクチャには、事前トレーニングされた ViT と Q-Former を備えたビジョン エンコーダー、単一の線形投影レイヤー、および高度な Vicuna 大規模言語モデルが含まれています。

視覚言語タスクにおける自己回帰言語モデルの傾向も成長しており、クロスモーダル転送を利用して言語ドメインとマルチモーダルドメインの間で知識を共有しています。

MiniGPT-4 は、事前トレーニングされたビジョン エンコーダーからの視覚情報を高度な LLM と調整することで、視覚領域と言語領域の橋渡しをします。 このモデルは言語デコーダーとして Vicuna を利用し、XNUMX 段階のトレーニング アプローチに従います。 最初は、視覚言語の知識を把握するために画像とテキストのペアの大規模なデータセットでトレーニングされ、次に、生成の信頼性と使いやすさを向上させるために、より小規模で高品質のデータセットで微調整されます。

MiniGPT-4 で生成された言語の自然さと使いやすさを向上させるために、研究者は、適切な視覚言語アライメント データセットの欠如に対処する XNUMX 段階のアライメント プロセスを開発しました。 彼らはこの目的のために特化したデータセットを厳選しました。

当初、モデルは入力画像の詳細な説明を生成し、Vicuna 言語モデルの形式に合わせた会話プロンプトを使用して詳細を強化しました。 この段階では、より包括的な画像の説明を生成することを目的としています。

初期画像説明プロンプト:

###人間: この画像を詳しく説明してください。 できるだけ多くの詳細をお知らせください。 目に見えるものすべてを言ってください。 ###アシスタント:

データの後処理では、生成された説明の不一致やエラーが ChatGPT を使用して修正され、その後手動で検証されて高品質が保証されました。

第 XNUMX 段階の微調整プロンプト:

###人間: ###アシスタント:

この探求は、GPT-4 のようなマルチモーダル生成 AI の仕組みを理解するための窓を開き、視覚と言語のモダリティを効果的に統合して、一貫した文脈に富んだ出力を生成する方法を明らかにします。

GPT-4 ビジョンの探求

ChatGPT を使用した画像の起源の特定

GPT-4 Vision は、画像を分析し、その地理的起源を特定する ChatGPT の機能を強化します。 この機能は、ユーザー インタラクションをテキストだけからテキストとビジュアルの組み合わせに移行し、画像データを通じてさまざまな場所に興味がある人にとって便利なツールになります。

複雑な数学の概念

GPT-4 Vision は、グラフィックや手書きの表現を分析することで、複雑な数学的アイデアを掘り下げることに優れています。 この機能は、複雑な数学的問題を解決したいと考えている人にとって便利なツールとして機能し、GPT-4 Vision が教育および学術分野で注目に値します。

手書き入力を LaTeX コードに変換する

GPT-4V の注目すべき機能の XNUMX つは、手書き入力を LaTeX コードに変換する機能です。 この機能は、手書きの数式やその他の技術情報をデジタル形式に変換する必要が多い研究者、学者、学生にとって有益です。 手書きから LaTeX への変換により、文書デジタル化の範囲が広がり、テクニカル ライティング プロセスが簡素化されます。

テーブルの詳細の抽出

GPT-4V は、データ分析における重要な資産である、テーブルから詳細を抽出し、関連する問い合わせに対処するスキルを示します。 ユーザーは GPT-4V を利用してテーブルを調べ、重要な洞察を収集し、データ駆動型の質問を解決できるため、データ アナリストやその他の専門家にとって強力なツールとなります。

視覚的なポインティングを理解する

視覚的なポインティングを理解する GPT-4V のユニークな機能は、ユーザー インタラクションに新しい次元を追加します。 GPT-4V は、視覚的な手がかりを理解することで、より高度な文脈を理解してクエリに応答できます。

図面を使用して簡単なモックアップ Web サイトを構築する

これをきっかけに ツイート, Unite.ai Webサイトのモックアップを作成してみました。

結果は私の当初のビジョンと完全には一致しませんでしたが、私が達成した結果は次のとおりです。

GPT-4V(ision)の制限と欠点

GPT-4V を分析するために、Open AI チームは定性的および定量的評価を実施しました。 定性的なものには内部テストと外部の専門家のレビューが含まれ、定量的なものでは、有害なコンテンツの特定、人口統計上の認識、プライバシーの懸念、位置情報、サイバーセキュリティ、マルチモーダルジェイルブレイクなどのさまざまなシナリオにおけるモデルの拒否と精度が測定されました。

それでもモデルは完璧ではありません。

紙 誤った推論や画像内のテキストや文字の欠落など、GPT-4V の制限を強調します。 幻覚を示したり、事実をでっち上げたりする場合があります。 特に画像内の危険物を識別するのには適しておらず、誤認することが多い。

医用画像処理では、GPT-4V は一貫性のない応答を提供する可能性があり、標準的な実践方法を認識していないため、誤診の可能性があります。

医療用途としては信頼できない性能 (ソース)

また、特定のヘイトシンボルのニュアンスを把握できず、視覚的な入力に基づいて不適切なコンテンツを生成する可能性があります。 OpenAI は、特に医療や機密性の高い文脈において、重要な解釈に GPT-4V を使用しないようアドバイスしています。

アップラッピング

Fast Stable Diffusion XL を使用して作成 https://huggingface.co/spaces/google/sdxl

GPT-4 Vision (GPT-4V) の登場により、数多くの素晴らしい可能性と、飛び越えなければならない新たなハードルがもたらされました。 これを展開する前に、特に人物の写真に関するリスクを十分に調査し、軽減するために多大な努力が払われました。 GPT-4V がいかに進歩し、医学や科学などの難しい分野で多くの可能性を示しているのは印象的です。

さて、テーブルにはいくつかの大きな質問があります。 たとえば、これらのモデルは写真から有名人を識別できなければなりませんか? 写真から人の性別、人種、感情を推測すべきでしょうか? また、視覚障害者を支援するための特別な調整が必要でしょうか? これらの質問は、プライバシー、公平性、そして AI が私たちの生活にどのように適合するかについての虫の缶を開きますが、これについては誰もが発言する必要があります。