Rekayasa Cepat

ChatGPT & Rekayasa Cepat Lanjutan: Mengemudi Evolusi AI

OpenAI telah berperan penting dalam mengembangkan alat revolusioner seperti OpenAI Gym, yang dirancang untuk algoritme penguatan pelatihan, dan model GPT-n. Sorotan juga ada pada DALL-E, model AI yang membuat gambar dari input tekstual. Salah satu model yang mendapat banyak perhatian adalah OpenAI ChatGPT, contoh cemerlang di ranah Model Bahasa Besar.

GPT-4: Rekayasa Cepat

ChatGPT telah mengubah lanskap chatbot, menawarkan tanggapan seperti manusia terhadap input pengguna dan memperluas aplikasinya di seluruh domain – mulai dari pengembangan dan pengujian perangkat lunak hingga komunikasi bisnis, dan bahkan pembuatan puisi.

Di tangan bisnis dan individu, GPT-4, misalnya, dapat berfungsi sebagai reservoir pengetahuan yang tidak ada habisnya, mahir dalam mata pelajaran mulai dari Matematika dan Biologi hingga Studi Hukum. Model AI yang canggih dan mudah diakses siap untuk mendefinisikan ulang masa depan pekerjaan, pembelajaran, dan kreativitas.

Model generatif seperti GPT-4 dapat menghasilkan data baru berdasarkan input yang ada. Atribut yang membedakan ini memungkinkan mereka melakukan beragam tugas, termasuk membuat teks, gambar, musik, dan video.

Dalam konteks model ChatGPT dan OpenAI, prompt adalah input yang diberikan pengguna ke model, biasanya dalam bentuk teks. Anjuran berfungsi sebagai sarana utama untuk mengontrol keluaran yang dihasilkan oleh model ini, menjadikannya penting untuk percakapan yang sukses dan relevan.

Dampak Kualitas Cepat

Menggunakan prompt yang terdefinisi dengan baik adalah kunci untuk terlibat dalam percakapan yang bermanfaat dan bermakna dengan sistem AI. Prompt yang didefinisikan dengan buruk dapat menghasilkan keluaran yang tidak membantu pengguna dan bahkan dapat menyebabkan konten yang menyesatkan.

Untuk mendemonstrasikan pengaruh kualitas prompt, mari bandingkan dua prompt berbeda yang diberikan ke ChatGPT. Perintah pertama, yang didefinisikan dengan buruk dan mengasumsikan pengetahuan sebelumnya, menghasilkan respons yang berpotensi tidak membantu bagi pengguna. Di sisi lain, prompt kedua memberikan lebih banyak konteks dan contoh, memastikan respons yang lebih relevan dan dapat dipahami.

Perintah 1: “Ceritakan tentang Convolutional Neural Networks.”

Tanggapan 1: “Convolutional Neural Networks (CNNs) adalah jaringan perceptron multi-lapisan yang terdiri dari lapisan yang terhubung sepenuhnya dan lapisan penyatuan. Mereka biasanya digunakan dalam tugas pengenalan gambar. Prosesnya melibatkan penerapan filter untuk memasukkan gambar dan menurunkannya menggunakan lapisan penyatuan.

Perintah 2: “Saya ingin belajar tentang Jaringan Syaraf Konvolusional, tetapi saya tidak memiliki pengetahuan sebelumnya tentang Jaringan Syaraf Tiruan. Bisakah Anda memberikan penjelasan yang ramah bagi pemula dan contoh bagaimana CNN digunakan dalam pengenalan gambar?”

Tanggapan 2: “Convolutional Neural Networks (CNNs) adalah jenis jaringan saraf yang terutama digunakan untuk tugas pengenalan gambar. Tidak seperti jaringan saraf lainnya, mereka memanfaatkan lapisan konvolusional dan lapisan penyatuan untuk memproses gambar. Bayangkan Anda memiliki gambar kucing. CNN dapat mengidentifikasi berbagai fitur dalam gambar, seperti kumis, telinga, dan ekor, dengan menerapkan filter dan melakukan downsampling pada gambar menggunakan pooling layer. Proses ini membuat CNN sangat efektif untuk mengenali objek dalam gambar.”

Dengan membandingkan kedua respons, terbukti bahwa prompt yang terdefinisi dengan baik menghasilkan respons yang lebih relevan dan mudah digunakan. Desain dan rekayasa cepat adalah disiplin ilmu yang berkembang yang bertujuan untuk mengoptimalkan kualitas keluaran model AI seperti ChatGPT.

Pada bagian berikut dari artikel ini, kami akan mempelajari bidang metodologi lanjutan yang ditujukan untuk menyempurnakan Model Bahasa Besar (LLM), seperti teknik dan taktik teknik yang cepat. Ini termasuk pembelajaran beberapa tembakan, ReAct, rangkaian pemikiran, RAG, dan banyak lagi.

Teknik Rekayasa Lanjutan

Sebelum kita melanjutkan, penting untuk memahami masalah utama dengan LLM, yang disebut sebagai 'halusinasi'. Dalam konteks LLM, 'halusinasi' menandakan kecenderungan model-model ini untuk menghasilkan keluaran yang tampaknya masuk akal tetapi tidak berakar pada realitas faktual atau konteks masukan yang diberikan.

Masalah ini sangat disorot dalam kasus pengadilan baru-baru ini di mana pengacara pembela digunakan ChatGPT untuk penelitian hukum. Alat AI, goyah karena masalah halusinasinya, mengutip kasus hukum yang tidak ada. Salah langkah ini memiliki akibat yang signifikan, menyebabkan kebingungan dan merusak kredibilitas selama persidangan. Insiden ini berfungsi sebagai pengingat nyata akan kebutuhan mendesak untuk mengatasi masalah 'halusinasi' dalam sistem AI.

Eksplorasi kami ke dalam teknik rekayasa cepat bertujuan untuk meningkatkan aspek LLM ini. Dengan meningkatkan efisiensi dan keamanannya, kami membuka jalan bagi aplikasi inovatif seperti ekstraksi informasi. Selain itu, ini membuka pintu untuk mengintegrasikan LLM dengan alat eksternal dan sumber data secara mulus, memperluas jangkauan potensi penggunaannya.

Pembelajaran Nol dan Sedikit Tembakan: Mengoptimalkan dengan Contoh

Generative Pretrained Transformers (GPT-3) menandai titik balik penting dalam pengembangan model AI Generatif, karena memperkenalkan konsep 'pembelajaran dengan beberapa pukulan.' Metode ini adalah pengubah permainan karena kemampuannya beroperasi secara efektif tanpa perlu penyetelan yang menyeluruh. Kerangka kerja GPT-3 dibahas dalam makalah, “Model Bahasa adalah Sedikit Pembelajar Tertembak” di mana penulis mendemonstrasikan bagaimana model unggul dalam berbagai kasus penggunaan tanpa memerlukan kumpulan data atau kode khusus.

Tidak seperti fine-tuning, yang menuntut usaha terus-menerus untuk menyelesaikan berbagai kasus penggunaan, model pengambilan gambar yang sedikit menunjukkan kemampuan adaptasi yang lebih mudah ke rangkaian aplikasi yang lebih luas. Sementara fine-tuning mungkin memberikan solusi yang kuat dalam beberapa kasus, itu bisa mahal dalam skala besar, membuat penggunaan model beberapa tembakan menjadi pendekatan yang lebih praktis, terutama ketika diintegrasikan dengan rekayasa cepat.

Bayangkan Anda mencoba menerjemahkan bahasa Inggris ke bahasa Prancis. Dalam pembelajaran beberapa langkah, Anda akan memberi GPT-3 beberapa contoh terjemahan seperti "berang-berang laut -> loutre de mer". GPT-3, sebagai model lanjutannya, kemudian dapat terus memberikan terjemahan yang akurat. Dalam pembelajaran zero-shot, Anda tidak akan memberikan contoh apa pun, dan GPT-3 masih dapat menerjemahkan bahasa Inggris ke bahasa Prancis secara efektif.

Istilah 'few-shot learning' berasal dari gagasan bahwa model diberikan sejumlah contoh untuk 'belajar'. Penting untuk diperhatikan bahwa 'belajar' dalam konteks ini tidak melibatkan pembaruan parameter atau bobot model, melainkan memengaruhi kinerja model.

Pembelajaran zero-shot membawa konsep ini selangkah lebih maju. Dalam pembelajaran zero-shot, tidak ada contoh penyelesaian tugas yang disediakan dalam model. Model ini diharapkan bekerja dengan baik berdasarkan pelatihan awalnya, membuat metodologi ini ideal untuk skenario penjawaban pertanyaan domain terbuka seperti ChatGPT.

Dalam banyak contoh, model yang mahir dalam pembelajaran zero-shot dapat bekerja dengan baik jika diberikan contoh beberapa tembakan atau bahkan satu tembakan. Kemampuan untuk beralih antara skenario pembelajaran nol, tunggal, dan beberapa tembakan menggarisbawahi kemampuan beradaptasi model besar, meningkatkan aplikasi potensial mereka di berbagai domain.

Metode pembelajaran zero-shot menjadi semakin lazim. Metode ini dicirikan oleh kemampuannya untuk mengenali objek yang tidak terlihat selama pelatihan. Berikut adalah contoh praktis dari Prompt Sedikit Tembakan:

"Translate the following English phrases to French:

'sea otter' translates to 'loutre de mer'

'sky' translates to 'ciel'

'What does 'cloud' translate to in French?'"

Dengan memberikan beberapa contoh kepada model dan kemudian mengajukan pertanyaan, kita dapat memandu model secara efektif untuk menghasilkan keluaran yang diinginkan. Dalam hal ini, GPT-3 kemungkinan besar akan menerjemahkan 'awan' menjadi 'nuage' dengan benar dalam bahasa Prancis.

Kami akan mempelajari lebih dalam berbagai nuansa rekayasa cepat dan peran pentingnya dalam mengoptimalkan performa model selama inferensi. Kita juga akan melihat bagaimana ini dapat digunakan secara efektif untuk membuat solusi yang hemat biaya dan dapat diskalakan di berbagai kasus penggunaan.

Saat kami mengeksplorasi lebih lanjut kompleksitas teknik rekayasa cepat dalam model GPT, penting untuk menyoroti pos terakhir kami 'Panduan Penting untuk Rekayasa Prompt di ChatGPT'. Panduan ini memberikan wawasan tentang strategi untuk menginstruksikan model AI secara efektif di berbagai kasus penggunaan.

Dalam diskusi kami sebelumnya, kami mempelajari metode cepat mendasar untuk model bahasa besar (LLM) seperti pembelajaran zero-shot dan few-shot, serta instruksi instruksi. Menguasai teknik-teknik ini sangat penting untuk menavigasi tantangan yang lebih kompleks dari rekayasa cepat yang akan kita jelajahi di sini.

Pembelajaran dengan sedikit tembakan dapat dibatasi karena jendela konteks terbatas dari sebagian besar LLM. Selain itu, tanpa perlindungan yang sesuai, LLM dapat disesatkan untuk menghasilkan keluaran yang berpotensi berbahaya. Plus, banyak model berjuang dengan tugas penalaran atau mengikuti instruksi multi-langkah.

Mengingat kendala ini, tantangannya terletak pada memanfaatkan LLM untuk menangani tugas-tugas kompleks. Solusi yang jelas mungkin untuk mengembangkan LLM yang lebih maju atau menyempurnakan yang sudah ada, tetapi itu bisa memerlukan upaya yang substansial. Jadi, muncul pertanyaan: bagaimana kita dapat mengoptimalkan model saat ini untuk pemecahan masalah yang lebih baik?

Yang tak kalah menarik adalah eksplorasi tentang bagaimana teknik ini berinteraksi dengan aplikasi kreatif di 'Unite AI'Menguasai Seni AI: Panduan Ringkas untuk Perjalanan Tengah dan Rekayasa Cepat' yang menggambarkan bagaimana perpaduan seni dan AI dapat menghasilkan seni yang menakjubkan.

Dorongan rantai pemikiran

Dorongan rantai pemikiran memanfaatkan sifat auto-regresif yang melekat pada model bahasa besar (LLM), yang unggul dalam memprediksi kata berikutnya dalam urutan tertentu. Dengan mendorong sebuah model untuk menjelaskan proses pemikirannya, ini mendorong generasi ide yang lebih menyeluruh dan metodis, yang cenderung selaras dengan informasi yang akurat. Penyelarasan ini berasal dari kecenderungan model untuk memproses dan menyampaikan informasi dengan cara yang bijaksana dan teratur, mirip dengan ahli manusia yang mengajak pendengar melalui konsep yang kompleks. Pernyataan sederhana seperti "pandu saya melalui langkah demi langkah bagaimana ..." seringkali cukup untuk memicu keluaran yang lebih bertele-tele dan mendetail ini.

Perintah Rantai Pemikiran Tanpa Tembakan

Sementara bisikan CoT konvensional memerlukan pra-pelatihan dengan demonstrasi, area yang muncul adalah bisikan CoT zero-shot. Pendekatan ini, diperkenalkan oleh Kojima et al. (2022), secara inovatif menambahkan frasa "Mari berpikir selangkah demi selangkah" ke prompt aslinya.

Mari buat prompt lanjutan di mana ChatGPT ditugaskan untuk meringkas kesimpulan utama dari makalah penelitian AI dan NLP.

Dalam demonstrasi ini, kami akan menggunakan kemampuan model untuk memahami dan meringkas informasi kompleks dari teks akademik. Dengan menggunakan pendekatan pembelajaran beberapa langkah, mari ajarkan ChatGPT untuk meringkas temuan utama dari makalah penelitian AI dan NLP:

1. Paper Title: "Attention Is All You Need"

Key Takeaway: Introduced the transformer model, emphasizing the importance of attention mechanisms over recurrent layers for sequence transduction tasks.

2. Paper Title: "BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding"

Key Takeaway: Introduced BERT, showcasing the efficacy of pre-training deep bidirectional models, thereby achieving state-of-the-art results on various NLP tasks.

Now, with the context of these examples, summarize the key findings from the following paper:

Paper Title: "Prompt Engineering in Large Language Models: An Examination"

Prompt ini tidak hanya mempertahankan rantai pemikiran yang jelas tetapi juga memanfaatkan pendekatan pembelajaran beberapa langkah untuk memandu model. Ini terkait dengan kata kunci kami dengan berfokus pada domain AI dan NLP, yang secara khusus menugaskan ChatGPT untuk melakukan operasi kompleks yang terkait dengan rekayasa cepat: meringkas makalah penelitian.

Bereaksi Prompt

React, atau “Reason and Act”, diperkenalkan oleh Google di koran “ReAct: Menyinergikan Penalaran dan Akting dalam Model Bahasa“, dan merevolusi bagaimana model bahasa berinteraksi dengan tugas, mendorong model untuk secara dinamis menghasilkan jejak penalaran verbal dan tindakan khusus tugas.

Bayangkan seorang koki manusia di dapur: mereka tidak hanya melakukan serangkaian tindakan (memotong sayuran, merebus air, mengaduk bahan) tetapi juga terlibat dalam penalaran verbal atau ucapan batin ("sekarang sayuran sudah dipotong, saya harus meletakkan panci di atas kompor”). Dialog mental yang berkelanjutan ini membantu menyusun strategi proses, beradaptasi dengan perubahan mendadak (“Saya kehabisan minyak zaitun, saya akan menggunakan mentega sebagai gantinya”), dan mengingat urutan tugas. React meniru kemampuan manusia ini, memungkinkan model dengan cepat mempelajari tugas-tugas baru dan membuat keputusan yang kuat, seperti yang dilakukan manusia dalam keadaan baru atau tidak pasti.

React dapat mengatasi halusinasi, masalah umum dengan sistem Chain-of-Thought (CoT). CoT, meskipun merupakan teknik yang efektif, tidak memiliki kapasitas untuk berinteraksi dengan dunia luar, yang berpotensi menyebabkan halusinasi fakta dan penyebaran kesalahan. Namun, React mengkompensasi hal ini dengan berinteraksi dengan sumber informasi eksternal. Interaksi ini memungkinkan sistem tidak hanya memvalidasi penalarannya tetapi juga memperbarui pengetahuannya berdasarkan informasi terbaru dari dunia luar.

Cara kerja dasar React dapat dijelaskan melalui sebuah instance dari HotpotQA, sebuah tugas yang membutuhkan penalaran tingkat tinggi. Saat menerima pertanyaan, model React memecah pertanyaan menjadi bagian-bagian yang dapat dikelola dan membuat rencana tindakan. Model menghasilkan jejak penalaran (pemikiran) dan mengidentifikasi tindakan yang relevan. Mungkin memutuskan untuk mencari informasi tentang Apple Remote pada sumber eksternal, seperti Wikipedia (tindakan), dan memperbarui pemahamannya berdasarkan informasi yang diperoleh (pengamatan). Melalui beberapa langkah pengamatan-tindakan-pengamatan, ReAct dapat mengambil informasi untuk mendukung penalarannya sambil menyempurnakan apa yang perlu diambil selanjutnya.

Catatan:

HotpotQA adalah kumpulan data, berasal dari Wikipedia, terdiri dari 113k pasangan pertanyaan-jawaban yang dirancang untuk melatih sistem AI dalam penalaran kompleks, karena pertanyaan memerlukan penalaran atas banyak dokumen untuk dijawab. Di samping itu, Akal sehatQA 2.0, dibuat melalui gamifikasi, mencakup 14,343 pertanyaan ya/tidak dan dirancang untuk menantang pemahaman akal sehat AI, karena pertanyaan sengaja dibuat untuk menyesatkan model AI.

Prosesnya bisa terlihat seperti ini:

- Pikir: “Saya perlu mencari Apple Remote dan perangkat yang kompatibel.”

- Tindakan: Mencari “perangkat yang kompatibel dengan Apple Remote” pada sumber eksternal.

- Observasi: Memperoleh daftar perangkat yang kompatibel dengan Apple Remote dari hasil pencarian.

- Pikir: “Berdasarkan hasil pencarian, beberapa perangkat, selain Apple Remote, dapat mengontrol program yang awalnya dirancang untuk berinteraksi dengannya.”

Hasilnya adalah proses berbasis penalaran yang dinamis yang dapat berkembang berdasarkan informasi yang berinteraksi dengannya, yang mengarah ke respons yang lebih akurat dan andal.

Visualisasi komparatif dari empat metode dorongan – Standar, Rantai Pemikiran, Hanya Tindakan, dan Bereaksi, dalam menyelesaikan HotpotQA dan AlfWorld (https://arxiv.org/pdf/2210.03629.pdf)

Merancang agen React adalah tugas khusus, mengingat kemampuannya untuk mencapai tujuan yang rumit. Misalnya, agen percakapan, dibangun di atas model React dasar, menggabungkan memori percakapan untuk menyediakan interaksi yang lebih kaya. Namun, kerumitan tugas ini disederhanakan oleh alat seperti Langchain, yang telah menjadi standar untuk merancang agen ini.

Anjuran sesuai konteks

Kertas 'Anjuran Sesuai Konteks untuk Model Bahasa Besar' menggarisbawahi bahwa sementara LLM telah menunjukkan kesuksesan besar dalam tugas-tugas NLP yang digerakkan oleh pengetahuan, ketergantungan mereka yang berlebihan pada pengetahuan parametrik dapat menyesatkan mereka dalam tugas-tugas yang sensitif konteks. Misalnya, ketika sebuah model bahasa dilatih pada fakta-fakta yang sudah ketinggalan zaman, model tersebut dapat menghasilkan jawaban yang salah jika mengabaikan petunjuk kontekstual.

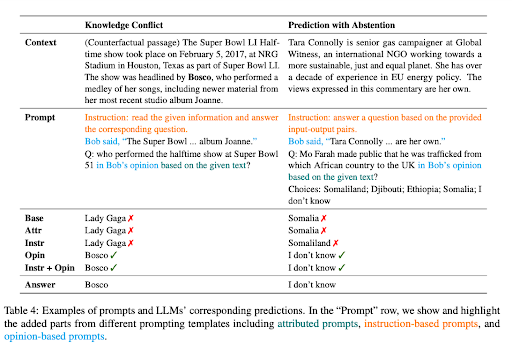

Masalah ini terlihat dalam contoh konflik pengetahuan, di mana konteksnya mengandung fakta yang berbeda dari pengetahuan LLM yang sudah ada sebelumnya. Pertimbangkan contoh di mana Model Bahasa Besar (LLM), yang dilengkapi dengan data sebelum Piala Dunia 2022, diberi konteks yang menunjukkan bahwa Prancis memenangkan turnamen. Namun, LLM dengan mengandalkan pengetahuan pra-latihannya tetap menegaskan bahwa juara sebelumnya yakni tim yang menjuarai Piala Dunia 2018 tetap menjadi juara bertahan. Ini menunjukkan kasus klasik 'konflik pengetahuan'.

Intinya, konflik pengetahuan dalam LLM muncul ketika informasi baru yang diberikan dalam konteks bertentangan dengan pengetahuan yang sudah ada sebelumnya yang telah dilatih oleh model tersebut. Kecenderungan model untuk bersandar pada pelatihan sebelumnya daripada konteks yang baru disediakan dapat menghasilkan output yang salah. Di sisi lain, halusinasi dalam LLM adalah menghasilkan respons yang mungkin tampak masuk akal tetapi tidak berakar pada data pelatihan model atau konteks yang disediakan.

Masalah lain muncul ketika konteks yang diberikan tidak berisi informasi yang cukup untuk menjawab pertanyaan secara akurat, situasi yang dikenal sebagai prediksi dengan abstain. Misalnya, jika LLM ditanya tentang pendiri Microsoft berdasarkan konteks yang tidak memberikan informasi ini, idealnya jangan menebak-nebak.

Untuk meningkatkan kesetiaan kontekstual LLM dalam skenario ini, para peneliti mengusulkan berbagai strategi dorongan. Strategi-strategi ini bertujuan untuk membuat respons LLM lebih selaras dengan konteks daripada mengandalkan pengetahuan yang disandikan.

Salah satu strategi tersebut adalah membingkai prompt sebagai pertanyaan berbasis opini, di mana konteksnya ditafsirkan sebagai pernyataan narator, dan pertanyaan tersebut berkaitan dengan opini narator tersebut. Pendekatan ini memfokuskan kembali perhatian LLM ke konteks yang disajikan daripada beralih ke pengetahuan yang sudah ada sebelumnya.

Menambahkan demonstrasi kontrafaktual ke prompt juga telah diidentifikasi sebagai cara yang efektif untuk meningkatkan kesetiaan dalam kasus konflik pengetahuan. Demonstrasi ini menampilkan skenario dengan fakta palsu, yang memandu model untuk lebih memperhatikan konteks guna memberikan respons yang akurat.

Instruksi fine-tuning

Penyempurnaan instruksi adalah fase pembelajaran terawasi yang memanfaatkan penyediaan model dengan instruksi khusus, misalnya, "Jelaskan perbedaan antara matahari terbit dan matahari terbenam." Instruksi dipasangkan dengan jawaban yang tepat, kira-kira seperti, “Matahari terbit mengacu pada saat matahari muncul di atas cakrawala di pagi hari, sedangkan matahari terbenam menandai titik ketika matahari menghilang di bawah cakrawala di malam hari.” Melalui metode ini, model dasarnya belajar bagaimana mematuhi dan menjalankan instruksi.

Pendekatan ini secara signifikan memengaruhi proses mendorong LLM, yang mengarah ke perubahan radikal dalam gaya mendorong. Instruksi LLM yang disetel dengan baik memungkinkan eksekusi langsung dari tugas tanpa tembakan, memberikan kinerja tugas yang mulus. Jika LLM belum disempurnakan, pendekatan pembelajaran beberapa langkah mungkin diperlukan, menggabungkan beberapa contoh ke dalam permintaan Anda untuk memandu model menuju respons yang diinginkan.

"Penyetelan Instruksi dengan GPT-4′ membahas upaya untuk menggunakan GPT-4 untuk menghasilkan data yang mengikuti instruksi untuk menyempurnakan LLM. Mereka menggunakan kumpulan data yang kaya, terdiri dari 52,000 entri mengikuti instruksi unik dalam bahasa Inggris dan Mandarin.

Dataset memainkan peran penting dalam penyetelan instruksi model LLaMA, serangkaian LLM sumber terbuka, menghasilkan peningkatan kinerja zero-shot pada tugas baru. Proyek penting seperti Alpaka Stanford telah secara efektif menggunakan penyetelan Instruksi Mandiri, metode yang efisien untuk menyelaraskan LLM dengan niat manusia, memanfaatkan data yang dihasilkan oleh model guru yang disesuaikan dengan instruksi lanjutan.

Tujuan utama penelitian penyetelan instruksi adalah untuk meningkatkan kemampuan generalisasi nol dan sedikit tembakan dari LLM. Penskalaan data dan model lebih lanjut dapat memberikan wawasan yang berharga. Dengan ukuran data GPT-4 saat ini pada 52K dan ukuran model LLaMA dasar pada 7 miliar parameter, ada potensi besar untuk mengumpulkan lebih banyak data yang mengikuti instruksi GPT-4 dan menggabungkannya dengan sumber data lain yang mengarah ke pelatihan model LLaMA yang lebih besar untuk kinerja yang unggul.

STAR: Penalaran Bootstrap Dengan Penalaran

Potensi LLM sangat terlihat dalam tugas penalaran yang kompleks seperti matematika atau menjawab pertanyaan dengan akal sehat. Namun, proses mendorong model bahasa untuk menghasilkan alasan—serangkaian pembenaran langkah demi langkah atau "rangkaian pemikiran"—memiliki serangkaian tantangan. Ini sering membutuhkan konstruksi kumpulan data rasional yang besar atau pengorbanan dalam akurasi karena ketergantungan hanya pada inferensi beberapa tembakan.

“Penalaran Otodidak” (Bintang) menawarkan solusi inovatif untuk tantangan ini. Ini menggunakan loop sederhana untuk terus meningkatkan kemampuan penalaran model. Proses berulang ini dimulai dengan menghasilkan alasan untuk menjawab banyak pertanyaan menggunakan beberapa contoh rasional. Jika jawaban yang dihasilkan salah, model mencoba lagi untuk menghasilkan alasan, kali ini memberikan jawaban yang benar. Model tersebut kemudian disesuaikan dengan semua alasan yang menghasilkan jawaban yang benar, dan prosesnya berulang.

Metodologi STAR, mendemonstrasikan loop fine-tuning dan contoh pembuatan alasan pada dataset CommonsenseQA (https://arxiv.org/pdf/2203.14465.pdf)

Untuk mengilustrasikan hal ini dengan contoh praktis, pertimbangkan pertanyaan “Apa yang dapat digunakan untuk membawa anjing kecil?” dengan pilihan jawaban mulai dari kolam renang hingga keranjang. Model STaR menghasilkan sebuah alasan, mengidentifikasi bahwa jawabannya haruslah sesuatu yang mampu membawa seekor anjing kecil dan mendarat pada kesimpulan bahwa sebuah keranjang, yang dirancang untuk menampung barang, adalah jawaban yang benar.

Pendekatan STAR unik karena memanfaatkan kemampuan penalaran model bahasa yang sudah ada sebelumnya. Ini menggunakan proses pembuatan sendiri dan penyempurnaan alasan, secara iteratif mem-bootstrap kemampuan penalaran model. Namun, loop STAR memiliki keterbatasan. Model mungkin gagal memecahkan masalah baru dalam set pelatihan karena tidak menerima sinyal pelatihan langsung untuk masalah yang gagal dipecahkan. Untuk mengatasi masalah ini, STAR memperkenalkan rasionalisasi. Untuk setiap masalah model gagal menjawab dengan benar, itu menghasilkan pemikiran baru dengan memberikan model jawaban yang benar, yang memungkinkan model untuk alasan mundur.

STAR, oleh karena itu, berdiri sebagai metode bootstrap yang dapat diskalakan yang memungkinkan model belajar menghasilkan pemikiran mereka sendiri sambil juga belajar memecahkan masalah yang semakin sulit. Penerapan STaR telah menunjukkan hasil yang menjanjikan dalam tugas-tugas yang melibatkan aritmatika, soal cerita matematika, dan penalaran akal sehat. Pada CommonsenseQA, STaR meningkat pada baseline beberapa tembakan dan baseline yang disesuaikan untuk memprediksi jawaban secara langsung dan bekerja sebanding dengan model yang berukuran 30x lebih besar.

Perintah Konteks yang Ditandai

Konsep 'Perintah Konteks yang Ditandai' berkisar menyediakan model AI dengan lapisan konteks tambahan dengan menandai informasi tertentu di dalam input. Tag ini pada dasarnya bertindak sebagai rambu untuk AI, membimbingnya tentang cara menginterpretasikan konteks secara akurat dan menghasilkan respons yang relevan dan faktual.

Bayangkan Anda sedang bercakap-cakap dengan seorang teman tentang topik tertentu, katakanlah 'catur'. Anda membuat pernyataan dan kemudian menandainya dengan referensi, seperti '(sumber: Wikipedia)'. Sekarang, teman Anda yang dalam hal ini adalah model AI tahu persis dari mana informasi Anda berasal. Pendekatan ini bertujuan untuk membuat respons AI lebih andal dengan mengurangi risiko halusinasi, atau munculnya fakta palsu.

Aspek unik dari petunjuk konteks yang diberi tag adalah potensinya untuk meningkatkan 'kecerdasan kontekstual' model AI. Misalnya, makalah ini mendemonstrasikan hal ini menggunakan beragam rangkaian pertanyaan yang diambil dari berbagai sumber, seperti ringkasan artikel Wikipedia tentang berbagai subjek dan bagian dari buku yang baru diterbitkan. Pertanyaan diberi tag, memberikan model AI konteks tambahan tentang sumber informasi.

Lapisan konteks ekstra ini terbukti sangat bermanfaat dalam menghasilkan respons yang tidak hanya akurat tetapi juga mematuhi konteks yang disediakan, menjadikan keluaran AI lebih andal dan dapat dipercaya.

Kesimpulan: Pandangan ke Teknik yang Menjanjikan dan Arah Masa Depan

ChatGPT OpenAI menampilkan potensi Model Bahasa Besar (LLM) yang belum dipetakan dalam menangani tugas-tugas kompleks dengan efisiensi luar biasa. Teknik canggih seperti pembelajaran beberapa langkah, ReAct prompting, rangkaian pemikiran, dan STAR, memungkinkan kami untuk memanfaatkan potensi ini di banyak aplikasi. Saat kami menggali lebih dalam nuansa metodologi ini, kami menemukan bagaimana mereka membentuk lanskap AI, menawarkan interaksi yang lebih kaya dan lebih aman antara manusia dan mesin.

Terlepas dari tantangan seperti konflik pengetahuan, ketergantungan yang berlebihan pada pengetahuan parametrik, dan potensi halusinasi, model AI ini, dengan rekayasa cepat yang tepat, telah terbukti sebagai alat transformatif. Penyempurnaan instruksi, dorongan sesuai konteks, dan integrasi dengan sumber data eksternal semakin memperkuat kemampuan mereka untuk bernalar, belajar, dan beradaptasi.