Artificial Intelligence

बड़े भाषा मॉडलों को फाइन-ट्यूनिंग करने के लिए एक पूर्ण मार्गदर्शिका

By

आयुष मित्तलविषय - सूची

बड़े भाषा मॉडल (एलएलएम) जैसे जीपीटी-4, लाएमडीए, पीएएलएम और अन्य ने विषयों की एक विस्तृत श्रृंखला पर मानव-जैसे पाठ को समझने और उत्पन्न करने की अपनी उल्लेखनीय क्षमता से दुनिया में तूफान ला दिया है। ये मॉडल इंटरनेट, किताबों और अन्य स्रोतों से अरबों शब्दों वाले विशाल डेटासेट पर पूर्व-प्रशिक्षित हैं।

यह पूर्व-प्रशिक्षण चरण मॉडलों को भाषा, विषयों, तर्क क्षमताओं और यहां तक कि प्रशिक्षण डेटा में मौजूद कुछ पूर्वाग्रहों के बारे में व्यापक सामान्य ज्ञान से भर देता है। हालाँकि, उनकी अविश्वसनीय व्यापकता के बावजूद, इन पूर्व-प्रशिक्षित एलएलएम में विशिष्ट डोमेन या कार्यों के लिए विशेष विशेषज्ञता का अभाव है।

यहीं पर फाइन-ट्यूनिंग आती है - किसी विशेष एप्लिकेशन या उपयोग-मामले में उत्कृष्टता प्राप्त करने के लिए पूर्व-प्रशिक्षित एलएलएम को अनुकूलित करने की प्रक्रिया। एक छोटे, कार्य-विशिष्ट डेटासेट पर मॉडल को और अधिक प्रशिक्षित करके, हम उस डोमेन की बारीकियों और आवश्यकताओं के साथ संरेखित करने के लिए इसकी क्षमताओं को ट्यून कर सकते हैं।

फाइन-ट्यूनिंग एक उच्च शिक्षित सामान्यज्ञ के व्यापक ज्ञान को एक निश्चित क्षेत्र में विशेषज्ञ विषय विशेषज्ञ तैयार करने के लिए स्थानांतरित करने के समान है। इस गाइड में, हम एलएलएम को बेहतर बनाने के क्या, क्यों और कैसे का पता लगाएंगे।

फ़ाइन-ट्यूनिंग क्या है?

मूलतः, फ़ाइन ट्यूनिंग इसमें एक बड़ा पूर्व-प्रशिक्षित मॉडल लेना और आपके लक्ष्य कार्य या डोमेन के अनुरूप डेटासेट पर दूसरे प्रशिक्षण चरण का उपयोग करके उसके मापदंडों को अपडेट करना शामिल है। यह मॉडल को उस संकीर्ण क्षेत्र के लिए विशिष्ट बारीकियों, पैटर्न और उद्देश्यों को सीखने और आंतरिक बनाने की अनुमति देता है।

जबकि पूर्व-प्रशिक्षण एक विशाल और विविध पाठ संग्रह से व्यापक भाषा समझ प्राप्त करता है, फाइन-ट्यूनिंग उस सामान्य योग्यता में विशेषज्ञता रखती है। यह एक पुनर्जागरण व्यक्ति को लेने और उन्हें एक उद्योग विशेषज्ञ के रूप में ढालने के समान है।

पूर्व-प्रशिक्षित मॉडल के वजन, जो उसके सामान्य ज्ञान को कूटबद्ध करते हैं, का उपयोग फ़ाइन-ट्यूनिंग प्रक्रिया के लिए शुरुआती बिंदु या आरंभीकरण के रूप में किया जाता है। इसके बाद मॉडल को आगे प्रशिक्षित किया जाता है, लेकिन इस बार अंतिम अनुप्रयोग के लिए सीधे प्रासंगिक उदाहरणों पर।

इस विशेष डेटा वितरण के लिए मॉडल को उजागर करके और तदनुसार मॉडल मापदंडों को ट्यून करके, हम लक्ष्य उपयोग के मामले में एलएलएम को अधिक सटीक और प्रभावी बनाते हैं, जबकि नींव के रूप में व्यापक पूर्व-प्रशिक्षित क्षमताओं से अभी भी लाभान्वित होते हैं।

फाइन-ट्यून एलएलएम क्यों?

ऐसे कई प्रमुख कारण हैं जिनकी वजह से आप एक बड़े भाषा मॉडल को बेहतर बनाना चाहते हैं:

- डोमेन अनुकूलन: कानूनी से लेकर चिकित्सा से लेकर सॉफ्टवेयर इंजीनियरिंग तक हर क्षेत्र की अपनी सूक्ष्म भाषा परंपराएं, शब्दजाल और संदर्भ हैं। फाइन-ट्यूनिंग आपको विशिष्ट डोमेन के अनुरूप पाठ को समझने और तैयार करने के लिए एक सामान्य मॉडल को अनुकूलित करने की अनुमति देता है।

- कार्य विशेषज्ञता: एलएलएम को विभिन्न प्राकृतिक भाषा प्रसंस्करण कार्यों जैसे पाठ सारांश, मशीनी अनुवाद, प्रश्न उत्तर आदि के लिए ठीक किया जा सकता है। यह विशेषज्ञता लक्ष्य कार्य पर प्रदर्शन को बढ़ाती है।

- डेटा अनुपालन: स्वास्थ्य देखभाल और वित्त जैसे उच्च विनियमित उद्योगों में डेटा गोपनीयता की सख्त आवश्यकताएं हैं। फाइन-ट्यूनिंग संवेदनशील जानकारी की सुरक्षा करते हुए एलएलएम को मालिकाना संगठनात्मक डेटा पर प्रशिक्षण देने की अनुमति देता है।

- सीमित लेबल वाला डेटा: प्रारंभ से ही प्रशिक्षण मॉडल के लिए बड़े लेबल वाले डेटासेट प्राप्त करना चुनौतीपूर्ण हो सकता है। फाइन-ट्यूनिंग पूर्व-प्रशिक्षित मॉडल की क्षमताओं का लाभ उठाकर सीमित पर्यवेक्षित उदाहरणों से मजबूत कार्य प्रदर्शन प्राप्त करने की अनुमति देता है।

- मॉडल अद्यतनीकरण: जैसे ही किसी डोमेन में समय के साथ नया डेटा उपलब्ध होता है, आप नवीनतम ज्ञान और क्षमताओं को शामिल करने के लिए मॉडल को और बेहतर बना सकते हैं।

- पूर्वाग्रहों को कम करना: एलएलएम व्यापक पूर्व-प्रशिक्षण डेटा से सामाजिक पूर्वाग्रहों को उठा सकते हैं। क्यूरेटेड डेटासेट पर फ़ाइन-ट्यूनिंग इन अवांछनीय पूर्वाग्रहों को कम करने और ठीक करने में मदद कर सकती है।

संक्षेप में, फाइन-ट्यूनिंग एक सामान्य, व्यापक मॉडल और एक विशेष एप्लिकेशन की केंद्रित आवश्यकताओं के बीच अंतर को पाटता है। यह लक्षित उपयोग के मामलों के लिए मॉडल आउटपुट की सटीकता, सुरक्षा और प्रासंगिकता को बढ़ाता है।

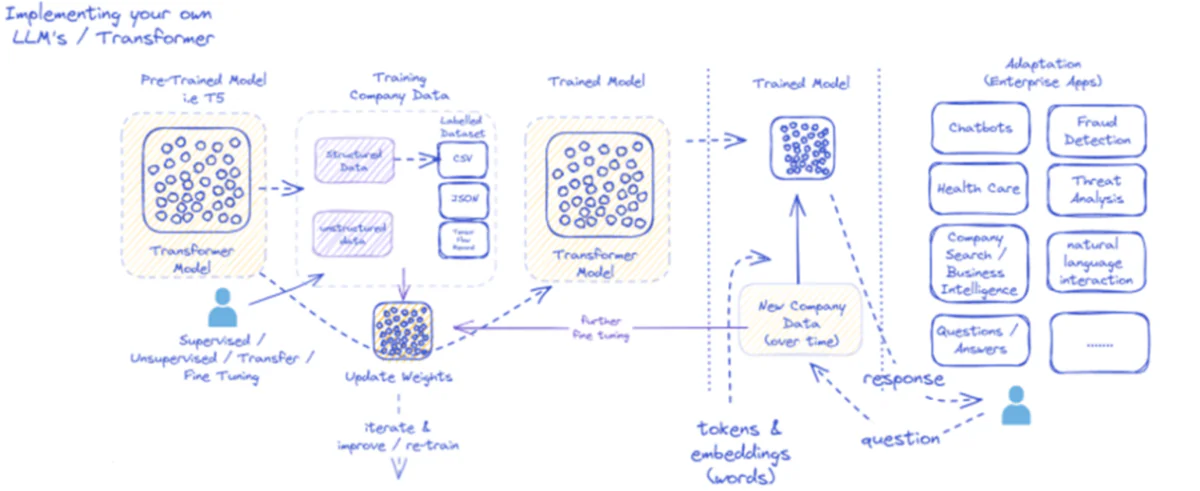

प्रदान किया गया आरेख विशेष रूप से एंटरप्राइज़ अनुप्रयोगों के लिए बड़े भाषा मॉडल (एलएलएम) को लागू करने और उपयोग करने की प्रक्रिया को रेखांकित करता है। प्रारंभ में, T5 जैसे पूर्व-प्रशिक्षित मॉडल को संरचित और असंरचित कंपनी डेटा खिलाया जाता है, जो CSV या JSON जैसे विभिन्न प्रारूपों में आ सकता है। यह डेटा कंपनी की विशिष्ट आवश्यकताओं के लिए मॉडल की प्रासंगिकता को बढ़ाते हुए, पर्यवेक्षित, गैर-पर्यवेक्षित या स्थानांतरण फाइन-ट्यूनिंग प्रक्रियाओं से गुजरता है।

एक बार जब मॉडल कंपनी डेटा के साथ ठीक हो जाता है, तो उसके वजन को तदनुसार अपडेट किया जाता है। प्रशिक्षित मॉडल फिर आगे के प्रशिक्षण चक्रों के माध्यम से पुनरावृत्त होता है, समय के साथ नए कंपनी डेटा के साथ अपनी प्रतिक्रियाओं में लगातार सुधार करता है। यह प्रक्रिया पुनरावृत्तीय और गतिशील है, जिसमें बदलते डेटा पैटर्न के अनुकूल मॉडल सीखना और पुनः प्रशिक्षण करना शामिल है।

इस प्रशिक्षित मॉडल का आउटपुट - शब्दों का प्रतिनिधित्व करने वाले टोकन और एम्बेडिंग - को फिर विभिन्न उद्यम अनुप्रयोगों के लिए तैनात किया जाता है। ये एप्लिकेशन चैटबॉट्स से लेकर हेल्थकेयर तक हो सकते हैं, प्रत्येक के लिए मॉडल को उद्योग-विशिष्ट प्रश्नों को समझने और उनका जवाब देने की आवश्यकता होती है। वित्त में, अनुप्रयोगों में धोखाधड़ी का पता लगाना और खतरे का विश्लेषण शामिल है; स्वास्थ्य देखभाल में, मॉडल रोगी की पूछताछ और निदान में सहायता कर सकते हैं।

समय के साथ नए कंपनी डेटा को संसाधित करने और उस पर प्रतिक्रिया करने के लिए प्रशिक्षित मॉडल की क्षमता यह सुनिश्चित करती है कि इसकी उपयोगिता कायम रहे और बढ़े। परिणामस्वरूप, एंटरप्राइज़ उपयोगकर्ता अनुप्रयोगों के माध्यम से मॉडल के साथ बातचीत कर सकते हैं, प्रश्न पूछ सकते हैं और सूचित प्रतिक्रियाएं प्राप्त कर सकते हैं जो डोमेन-विशिष्ट डेटा पर मॉडल के प्रशिक्षण और फाइन-ट्यूनिंग को दर्शाते हैं।

यह बुनियादी ढांचा उद्यम अनुप्रयोगों की एक विस्तृत श्रृंखला का समर्थन करता है, जो व्यावसायिक संदर्भ में उचित रूप से कार्यान्वित और बनाए रखने पर एलएलएम की बहुमुखी प्रतिभा और अनुकूलनशीलता को प्रदर्शित करता है।

फाइन-ट्यूनिंग दृष्टिकोण

जब बड़े भाषा मॉडल को बेहतर बनाने की बात आती है तो दो प्राथमिक रणनीतियाँ होती हैं:

1) पूर्ण मॉडल फ़ाइन-ट्यूनिंग

पूर्ण फाइन-ट्यूनिंग दृष्टिकोण में, पूर्व-प्रशिक्षित मॉडल के सभी पैरामीटर (वजन और पूर्वाग्रह) दूसरे प्रशिक्षण चरण के दौरान अपडेट किए जाते हैं। मॉडल कार्य-विशिष्ट लेबल वाले डेटासेट के संपर्क में है, और मानक प्रशिक्षण प्रक्रिया उस डेटा वितरण के लिए पूरे मॉडल को अनुकूलित करती है।

यह मॉडल को अधिक व्यापक समायोजन करने और लक्ष्य कार्य या डोमेन के लिए समग्र रूप से अनुकूलित करने की अनुमति देता है। हालाँकि, पूर्ण फाइन-ट्यूनिंग के कुछ नुकसान भी हैं:

- इसे प्रशिक्षण के लिए पूर्व-प्रशिक्षण चरण के समान ही महत्वपूर्ण कम्प्यूटेशनल संसाधनों और समय की आवश्यकता होती है।

- भंडारण आवश्यकताएँ अधिक हैं, क्योंकि आपको प्रत्येक कार्य के लिए मॉडल की एक अलग सुव्यवस्थित प्रतिलिपि बनाए रखने की आवश्यकता होती है।

- "विनाशकारी भूलने" का जोखिम होता है, जहां फाइन-ट्यूनिंग के कारण मॉडल पूर्व-प्रशिक्षण के दौरान सीखी गई कुछ सामान्य क्षमताओं को खो देता है।

इन सीमाओं के बावजूद, जब संसाधन अनुमति देते हैं और लक्ष्य कार्य सामान्य भाषा से महत्वपूर्ण रूप से भिन्न होता है, तो पूर्ण फाइन-ट्यूनिंग एक शक्तिशाली और व्यापक रूप से उपयोग की जाने वाली तकनीक बनी हुई है।

2) कुशल फ़ाइन-ट्यूनिंग विधियाँ

पूर्ण फाइन-ट्यूनिंग की कम्प्यूटेशनल चुनौतियों पर काबू पाने के लिए, शोधकर्ताओं ने कुशल रणनीतियाँ विकसित की हैं जो फाइन-ट्यूनिंग के दौरान मॉडल के मापदंडों के केवल एक छोटे उपसमूह को अपडेट करती हैं। ये पैरामीट्रिक रूप से कुशल तकनीकें विशेषज्ञता और संसाधन आवश्यकताओं को कम करने के बीच संतुलन बनाती हैं।

कुछ लोकप्रिय कुशल फ़ाइन-ट्यूनिंग विधियों में शामिल हैं:

उपसर्ग-ट्यूनिंग: यहां, लक्ष्य कार्य के लिए पूर्व-प्रशिक्षित मॉडल का ध्यान आकर्षित करने के लिए छोटी संख्या में कार्य-विशिष्ट वैक्टर या "उपसर्ग" पेश किए जाते हैं और प्रशिक्षित किए जाते हैं। फाइन-ट्यूनिंग के दौरान केवल इन उपसर्गों को अद्यतन किया जाता है।

लोरा (निम्न-रैंक अनुकूलन): लोरा फ़ाइन-ट्यूनिंग के दौरान पूर्व-प्रशिक्षित मॉडल की प्रत्येक परत में प्रशिक्षित निम्न-रैंक मैट्रिसेस को इंजेक्ट करता है। ये छोटे रैंक समायोजन पूर्ण फाइन-ट्यूनिंग की तुलना में बहुत कम प्रशिक्षण योग्य मापदंडों के साथ मॉडल को विशेषज्ञ बनाने में मदद करते हैं।

निश्चित रूप से, मैं गणितीय सूत्रीकरण और कोड उदाहरणों के साथ लोआरए (लो-रैंक अनुकूलन) का विस्तृत विवरण प्रदान कर सकता हूं। लोरा एक लोकप्रिय पैरामीटर-कुशल फाइन-ट्यूनिंग (पीईएफटी) तकनीक है जिसने बड़े भाषा मॉडल (एलएलएम) अनुकूलन के क्षेत्र में महत्वपूर्ण लोकप्रियता हासिल की है।

लोरा क्या है?

लोआरए एक फाइन-ट्यूनिंग विधि है जो पूर्व-प्रशिक्षित एलएलएम में प्रशिक्षण योग्य मापदंडों की एक छोटी संख्या पेश करती है, जो मूल मॉडल के अधिकांश ज्ञान को संरक्षित करते हुए डाउनस्ट्रीम कार्यों के लिए कुशल अनुकूलन की अनुमति देती है। एलएलएम के सभी मापदंडों को ठीक करने के बजाय, लोआरए मॉडल की परतों में कार्य-विशिष्ट निम्न-रैंक मैट्रिक्स को इंजेक्ट करता है, जिससे फाइन-ट्यूनिंग प्रक्रिया के दौरान महत्वपूर्ण कम्प्यूटेशनल और मेमोरी बचत सक्षम होती है।

गणितीय सूत्रीकरण

LoRA (लो-रैंक एडाप्टेशन) बड़े भाषा मॉडल (एलएलएम) के लिए एक फाइन-ट्यूनिंग विधि है जो वेट मैट्रिसेस के लिए निम्न-रैंक अपडेट पेश करती है। वजन मैट्रिक्स के लिए 0∈W0Στρατός Assault - Παίξτε Funny Games∈Rd×k, LoRA एक निम्न-रैंक मैट्रिक्स जोड़ता है BA, साथ में A∈Rr×k और B∈Rd×r, जहां r रैंक है. यह दृष्टिकोण प्रशिक्षण योग्य मापदंडों की संख्या को काफी कम कर देता है, जिससे न्यूनतम कम्प्यूटेशनल संसाधनों के साथ डाउनस्ट्रीम कार्यों में कुशल अनुकूलन सक्षम हो जाता है। अद्यतन वजन मैट्रिक्स द्वारा दिया गया है W=W0Στρατός Assault - Παίξτε Funny Games+B⋅A.

इस निम्न-रैंक अद्यतन को निम्न-रैंक मैट्रिक्स $BA$ जोड़कर मूल भार मैट्रिक्स $W_{0}$ को संशोधित करने के रूप में समझा जा सकता है। इस फॉर्मूलेशन का मुख्य लाभ यह है कि $W_{0}$ में सभी $d \times k$ पैरामीटर्स को अपडेट करने के बजाय, LoRA को केवल $A$ और $B में $r \times (d + k)$ पैरामीटर्स को ऑप्टिमाइज़ करने की आवश्यकता है। $, प्रशिक्षण योग्य मापदंडों की संख्या को काफी कम कर देता है।

यहां पायथन में इसका उपयोग करने का एक उदाहरण दिया गया है peft पाठ वर्गीकरण के लिए पूर्व-प्रशिक्षित एलएलएम में लोआरए लागू करने के लिए पुस्तकालय:

</div> <div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color="">from</span> transformers <span class="token" data-darkreader-inline-color="">import</span> AutoModelForSequenceClassification </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color="">from</span> peft <span class="token" data-darkreader-inline-color="">import</span> get_peft_model<span class="token" data-darkreader-inline-color="">,</span> LoraConfig<span class="token" data-darkreader-inline-color="">,</span> TaskType </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Load pre-trained model</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">model <span class="token" data-darkreader-inline-color="">=</span> AutoModelForSequenceClassification<span class="token" data-darkreader-inline-color="">.</span>from_pretrained<span class="token" data-darkreader-inline-color="">(</span><span class="token" data-darkreader-inline-color="">"bert-base-uncased"</span><span class="token" data-darkreader-inline-color="">,</span> num_labels<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">2</span><span class="token" data-darkreader-inline-color="">)</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Define LoRA configuration</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">peft_config <span class="token" data-darkreader-inline-color="">=</span> LoraConfig<span class="token" data-darkreader-inline-color="">(</span>task_type<span class="token" data-darkreader-inline-color="">=</span>TaskType<span class="token" data-darkreader-inline-color="">.</span>SEQ_CLS<span class="token" data-darkreader-inline-color="">, </span>r<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">8</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color=""># Rank of the low-rank update</span> lora_alpha<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">16</span><span class="token" data-darkreader-inline-color="">,</span></code><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Scaling factor for the low-rank update</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""> target_modules<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">[</span><span class="token" data-darkreader-inline-color="">"q_lin"</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color="">"v_lin"</span><span class="token" data-darkreader-inline-color="">]</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color=""># Apply LoRA to the query and value layers</span> <span class="token" data-darkreader-inline-color="">)</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Create the LoRA-enabled model</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">model <span class="token" data-darkreader-inline-color="">=</span> get_peft_model<span class="token" data-darkreader-inline-color="">(</span>model<span class="token" data-darkreader-inline-color="">,</span> peft_config<span class="token" data-darkreader-inline-color="">)</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Fine-tune the model with LoRA</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># ... (training code omitted for brevity)</span></code></div> </div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">

इस उदाहरण में, हम अनुक्रम वर्गीकरण के लिए एक पूर्व-प्रशिक्षित BERT मॉडल लोड करते हैं और LoRA कॉन्फ़िगरेशन को परिभाषित करते हैं। r पैरामीटर निम्न-रैंक अद्यतन की रैंक निर्दिष्ट करता है, और lora_alpha अद्यतन के लिए एक स्केलिंग कारक है। target_modules पैरामीटर इंगित करता है कि मॉडल की किन परतों को निम्न-रैंक अपडेट प्राप्त होना चाहिए। LoRA-सक्षम मॉडल बनाने के बाद, हम मानक प्रशिक्षण प्रक्रिया का उपयोग करके फाइन-ट्यूनिंग प्रक्रिया के साथ आगे बढ़ सकते हैं।

एडाप्टर परतें: LoRA के समान, लेकिन निम्न-रैंक अपडेट के बजाय, पूर्व-प्रशिक्षित मॉडल के प्रत्येक ट्रांसफार्मर ब्लॉक के भीतर पतली "एडेप्टर" परतें डाली जाती हैं। केवल इन कुछ नई कॉम्पैक्ट परतों के मापदंडों को प्रशिक्षित किया जाता है।

शीघ्र ट्यूनिंग: यह दृष्टिकोण पूर्व-प्रशिक्षित मॉडल को पूरी तरह से स्थिर रखता है। इसके बजाय, लक्ष्य कार्य के लिए मॉडल के पूर्व-प्रशिक्षित ज्ञान को सक्रिय करने के लिए प्रशिक्षित "प्रॉम्प्ट" एम्बेडिंग को इनपुट के रूप में पेश किया जाता है।

ये कुशल विधियाँ पूर्ण फाइन-ट्यूनिंग की तुलना में 100x तक की गणना में कमी प्रदान कर सकती हैं, साथ ही कई कार्यों पर प्रतिस्पर्धी प्रदर्शन भी प्राप्त कर सकती हैं। वे पूर्ण मॉडल दोहराव से बचकर भंडारण आवश्यकताओं को भी कम करते हैं।

हालाँकि, उनका प्रदर्शन उन कार्यों के लिए पूर्ण फाइन-ट्यूनिंग से पीछे हो सकता है जो सामान्य भाषा से काफी भिन्न हैं या जिनके लिए अधिक समग्र विशेषज्ञता की आवश्यकता होती है।

फाइन-ट्यूनिंग प्रक्रिया

फाइन-ट्यूनिंग रणनीति के बावजूद, एलएलएम में विशेषज्ञता की समग्र प्रक्रिया एक सामान्य ढांचे का पालन करती है:

- डेटासेट तैयार करना: आपको एक लेबल डेटासेट प्राप्त करने या बनाने की आवश्यकता होगी जो आपके लक्षित कार्य के लिए वांछित आउटपुट के लिए इनपुट (संकेत) को मैप करता है। सारांशीकरण जैसे पाठ निर्माण कार्यों के लिए, यह सारांशित आउटपुट जोड़े में इनपुट पाठ होगा।

- डेटासेट विभाजन: सर्वोत्तम प्रथाओं का पालन करते हुए, अपने लेबल किए गए डेटासेट को ट्रेन, सत्यापन और परीक्षण सेट में विभाजित करें। यह मॉडल प्रशिक्षण, हाइपरपैरामीटर ट्यूनिंग और अंतिम मूल्यांकन के लिए डेटा को अलग करता है।

- हाइपरपरमेटर ट्यूनिंग: आपके डेटा पर सबसे प्रभावी फाइन-ट्यूनिंग के लिए सीखने की दर, बैच आकार और प्रशिक्षण कार्यक्रम जैसे मापदंडों को समायोजित करने की आवश्यकता है। इसमें आमतौर पर एक छोटा सत्यापन सेट शामिल होता है।

- मॉडल प्रशिक्षण: ट्यून किए गए हाइपरपैरामीटर का उपयोग करके, पूर्ण प्रशिक्षण सेट पर फाइन-ट्यूनिंग अनुकूलन प्रक्रिया तब तक चलाएं जब तक कि सत्यापन सेट पर मॉडल का प्रदर्शन सुधारना बंद न कर दे (प्रारंभिक रोक)।

- मूल्यांकन: वास्तविक दुनिया की प्रभावकारिता का अनुमान लगाने के लिए, लक्ष्य उपयोग के मामले के लिए आदर्श रूप से वास्तविक दुनिया के उदाहरणों को शामिल करते हुए, आयोजित परीक्षण सेट पर सुव्यवस्थित मॉडल के प्रदर्शन का आकलन करें।

- तैनाती और निगरानी: एक बार संतोषजनक होने पर, नए इनपुट पर अनुमान लगाने के लिए फाइन-ट्यून मॉडल को तैनात किया जा सकता है। अवधारणा के बहाव के लिए समय के साथ इसके प्रदर्शन और सटीकता की निगरानी करना महत्वपूर्ण है।

हालाँकि यह समग्र प्रक्रिया की रूपरेखा प्रस्तुत करता है, कई बारीकियाँ किसी विशेष एलएलएम या कार्य के लिए सफलता को बेहतर बनाने पर प्रभाव डाल सकती हैं। पाठ्यक्रम सीखना, मल्टी-टास्क फाइन-ट्यूनिंग और कुछ-शॉट प्रॉम्प्टिंग जैसी रणनीतियाँ प्रदर्शन को और बढ़ावा दे सकती हैं।

इसके अतिरिक्त, कुशल फ़ाइन-ट्यूनिंग विधियों में अतिरिक्त विचार शामिल होते हैं। उदाहरण के लिए, LoRA को एक संयोजन परत के माध्यम से पूर्व-प्रशिक्षित मॉडल आउटपुट को कंडीशनिंग करने जैसी तकनीकों की आवश्यकता होती है। प्रॉम्प्ट ट्यूनिंग के लिए सही व्यवहार को सक्रिय करने के लिए सावधानीपूर्वक डिज़ाइन किए गए संकेतों की आवश्यकता होती है।

उन्नत फाइन-ट्यूनिंग: मानव प्रतिक्रिया को शामिल करना

जबकि लेबल किए गए डेटासेट का उपयोग करके मानक पर्यवेक्षित फ़ाइन-ट्यूनिंग प्रभावी है, एक रोमांचक सीमा मानव प्राथमिकताओं और प्रतिक्रिया का उपयोग करके सीधे एलएलएम को प्रशिक्षित करना है। यह मानव-इन-द-लूप दृष्टिकोण सुदृढीकरण सीखने की तकनीकों का लाभ उठाता है:

पीपीओ (समीपस्थ नीति अनुकूलन): यहां, एलएलएम को एक सुदृढीकरण शिक्षण एजेंट के रूप में माना जाता है, जिसके आउटपुट "क्रियाएं" हैं। इन आउटपुट के लिए मानव रेटिंग या गुणवत्ता स्कोर की भविष्यवाणी करने के लिए एक इनाम मॉडल को प्रशिक्षित किया जाता है। पीपीओ फिर इनाम मॉडल के स्कोर को अधिकतम करने वाले आउटपुट उत्पन्न करने के लिए एलएलएम को अनुकूलित करता है।

आरएलएचएफ (मानव प्रतिक्रिया से सुदृढीकरण सीखना): यह सीखने की प्रक्रिया में मानवीय प्रतिक्रिया को सीधे शामिल करके पीपीओ का विस्तार करता है। एक निश्चित इनाम मॉडल के बजाय, पुरस्कार फाइन-ट्यूनिंग के दौरान एलएलएम के आउटपुट पर पुनरावृत्त मानव मूल्यांकन से आते हैं।

कम्प्यूटेशनल रूप से गहन होने के बावजूद, ये विधियां एलएलएम व्यवहार को मनुष्यों द्वारा मूल्यांकन की गई वांछित विशेषताओं के आधार पर अधिक सटीक रूप से ढालने की अनुमति देती हैं, जो कि स्थिर डेटासेट में कैप्चर की जा सकती हैं।

एंथ्रोपिक जैसी कंपनियों ने क्लाउड जैसे अपने भाषा मॉडल को कार्य क्षमता से परे बेहतर सत्यता, नैतिकता और सुरक्षा जागरूकता के साथ जोड़ने के लिए आरएलएचएफ का उपयोग किया।

संभावित जोखिम और सीमाएँ

बेहद शक्तिशाली होने के बावजूद, एलएलएम को बेहतर बनाना जोखिमों से रहित नहीं है, जिसे सावधानीपूर्वक प्रबंधित किया जाना चाहिए:

पूर्वाग्रह प्रवर्धन: यदि फाइन-ट्यूनिंग डेटा में लिंग, नस्ल, उम्र या अन्य विशेषताओं के आसपास सामाजिक पूर्वाग्रह शामिल हैं, तो मॉडल इन अवांछनीय पूर्वाग्रहों को बढ़ा सकता है। प्रतिनिधि और निष्पक्ष डेटासेट को क्यूरेट करना महत्वपूर्ण है।

तथ्यात्मक बहाव: उच्च-गुणवत्ता वाले डेटा पर फाइन-ट्यूनिंग के बाद भी, भाषा मॉडल लंबी बातचीत या संकेतों पर प्रशिक्षण उदाहरणों के साथ असंगत गलत तथ्यों या आउटपुट को "मतिभ्रम" कर सकते हैं। तथ्य पुनर्प्राप्ति विधियों की आवश्यकता हो सकती है।

स्केलेबिलिटी चुनौतियां: GPT-3 जैसे विशाल मॉडलों की पूर्ण फाइन-ट्यूनिंग के लिए विशाल कंप्यूटिंग संसाधनों की आवश्यकता होती है जो कई संगठनों के लिए संभव नहीं हो सकते हैं। कुशल फाइन-ट्यूनिंग इसे आंशिक रूप से कम कर देती है लेकिन इसमें कुछ समस्याएं हैं।

विनाशकारी विस्मृति: पूर्ण फाइन-ट्यूनिंग के दौरान, मॉडल भयावह भूल का अनुभव कर सकते हैं, जहां वे पूर्व-प्रशिक्षण के दौरान सीखी गई कुछ सामान्य क्षमताओं को खो देते हैं। बहु-कार्य सीखने की आवश्यकता हो सकती है।

आईपी और गोपनीयता जोखिम: फाइन-ट्यूनिंग के लिए उपयोग किया जाने वाला मालिकाना डेटा सार्वजनिक रूप से जारी भाषा मॉडल आउटपुट में लीक हो सकता है, जिससे जोखिम पैदा हो सकता है। विभेदक गोपनीयता और सूचना जोखिम शमन तकनीक अनुसंधान के सक्रिय क्षेत्र हैं।

कुल मिलाकर, असाधारण रूप से उपयोगी होते हुए भी, फाइन-ट्यूनिंग एक सूक्ष्म प्रक्रिया है जिसमें डेटा गुणवत्ता, पहचान संबंधी विचारों, जोखिमों को कम करने और उपयोग के मामले की आवश्यकताओं के आधार पर प्रदर्शन-दक्षता ट्रेड-ऑफ को संतुलित करने की देखभाल की आवश्यकता होती है।

भविष्य: बड़े पैमाने पर भाषा मॉडल अनुकूलन

आगे देखते हुए, विभिन्न अनुप्रयोगों और डोमेन में बड़े भाषा मॉडल की पूरी क्षमता को अनलॉक करने के लिए फाइन-ट्यूनिंग और मॉडल अनुकूलन तकनीकों में प्रगति महत्वपूर्ण होगी।

सीमित संसाधनों के साथ PaLM जैसे बड़े मॉडलों को भी बेहतर बनाने में सक्षम अधिक कुशल तरीके पहुंच को लोकतांत्रिक बना सकते हैं। डेटासेट निर्माण पाइपलाइनों और शीघ्र इंजीनियरिंग को स्वचालित करने से विशेषज्ञता को सुव्यवस्थित किया जा सकता है।

लेबल के बिना कच्चे डेटा को ठीक करने की स्व-पर्यवेक्षित तकनीकें नई सीमाएं खोल सकती हैं। और विभिन्न कार्यों या डेटा पर प्रशिक्षित सुव्यवस्थित उप-मॉडलों को संयोजित करने के लिए संरचनागत दृष्टिकोण मांग पर अत्यधिक अनुरूप मॉडल बनाने की अनुमति दे सकते हैं।

अंततः, जैसे-जैसे एलएलएम अधिक सर्वव्यापी होते जा रहे हैं, प्रत्येक कल्पनीय उपयोग के मामले के लिए उन्हें निर्बाध रूप से अनुकूलित और विशेषज्ञ बनाने की क्षमता महत्वपूर्ण होगी। फाइन-ट्यूनिंग और संबंधित मॉडल अनुकूलन रणनीतियाँ हर क्षेत्र और प्रयास में मानवीय क्षमताओं को बढ़ाने वाले लचीले, सुरक्षित और शक्तिशाली एआई सहायकों के रूप में बड़े भाषा मॉडल के दृष्टिकोण को साकार करने में महत्वपूर्ण कदम हैं।

मैंने पिछले पांच साल मशीन लर्निंग और डीप लर्निंग की आकर्षक दुनिया में डूबने में बिताए हैं। मेरे जुनून और विशेषज्ञता ने मुझे एआई/एमएल पर विशेष ध्यान देने के साथ 50 से अधिक विविध सॉफ्टवेयर इंजीनियरिंग परियोजनाओं में योगदान करने के लिए प्रेरित किया है। मेरी निरंतर जिज्ञासा ने मुझे प्राकृतिक भाषा प्रसंस्करण की ओर भी आकर्षित किया है, एक ऐसा क्षेत्र जिसे मैं और अधिक जानने के लिए उत्सुक हूं।

शायद तुम पसंद करोगे

लामा 3 के बारे में वह सब कुछ जो आपको जानना आवश्यक है | अभी तक का सबसे शक्तिशाली ओपन-सोर्स मॉडल | उपयोग की अवधारणाएँ

ब्लैकमाम्बा: राज्य-अंतरिक्ष मॉडल के लिए विशेषज्ञों का मिश्रण

PostgreSQL डेटाबेस के लिए AI GPT: क्या वे काम कर सकते हैं?

बकरी (अंकगणित कार्यों में अच्छा): भाषा दक्षता से गणित प्रतिभा तक

ओपन सोर्स बनाम क्लोज्ड सोर्स लैंग्वेज मॉडल की लड़ाई: एक तकनीकी विश्लेषण

बड़े भाषा मॉडल का मूल्यांकन: एक तकनीकी मार्गदर्शिका

Recent Posts

- मैक्सडिफ़ आरएल एल्गोरिदम "डिज़ाइन किए गए रैंडमनेस" के साथ रोबोटिक लर्निंग में सुधार करता है

- lalal.ai समीक्षा: #1 AI बैकग्राउंड नॉइज़ रिमूवर?

- बड़े एक्शन मॉडल (एलएएम): एआई-पावर्ड इंटरेक्शन में अगला फ्रंटियर

- डॉ. पांडुरंग कामत, मुख्य प्रौद्योगिकी अधिकारी, पर्सिस्टेंट सिस्टम्स - साक्षात्कार श्रृंखला

- स्कालाहोस्टिंग समीक्षा: आपकी वेबसाइट के लिए सर्वश्रेष्ठ उच्च-प्रदर्शन होस्ट?