Intelligence Artificielle

Zero123++ : une image unique pour un modèle de base de diffusion multi-vues cohérent

Ces dernières années ont été témoins d’une progression rapide des performances, de l’efficacité et des capacités génératives des romans émergents. Modèles génératifs d'IA qui exploitent de vastes ensembles de données et des pratiques de génération de diffusion 2D. Aujourd'hui, les modèles d'IA générative sont extrêmement capables de générer différentes formes de contenu multimédia 2D et, dans une certaine mesure, 3D, notamment du texte, des images, des vidéos, des GIF, etc.

Dans cet article, nous parlerons du framework Zero123++, un modèle d'IA génératif de diffusion conditionné par l'image dans le but de générer des images à vues multiples cohérentes en 3D à l'aide d'une seule entrée de vue. Pour maximiser l'avantage tiré des modèles génératifs pré-entraînés antérieurs, le framework Zero123++ met en œuvre de nombreux schémas de formation et de conditionnement pour minimiser l'effort nécessaire pour affiner les modèles d'images de diffusion disponibles dans le commerce. Nous approfondirons l'architecture, le fonctionnement et les résultats du framework Zero123++, et analyserons ses capacités à générer des images cohérentes à vues multiples de haute qualité à partir d'une seule image. Alors, commençons.

Zero123 et Zero123++ : une introduction

Le framework Zero123++ est un modèle d'IA génératif de diffusion conditionné par l'image qui vise à générer des images à vues multiples cohérentes en 3D à l'aide d'une seule entrée de vue. Le framework Zero123++ est une continuation du framework Zero123 ou Zero-1-to-3 qui exploite une nouvelle technique de synthèse d'images de vue zéro-shot pour être un pionnier des conversions open source d'image unique en 3D. Bien que le framework Zero123++ offre des performances prometteuses, les images générées par le framework présentent des incohérences géométriques visibles, et c'est la principale raison pour laquelle l'écart entre les scènes 3D et les images multi-vues existe toujours.

Le framework Zero-1-to-3 sert de base à plusieurs autres frameworks, notamment SyncDreamer, One-2-3-45, Consistent123 et bien d'autres, qui ajoutent des couches supplémentaires au framework Zero123 pour obtenir des résultats plus cohérents lors de la génération d'images 3D. D'autres frameworks comme ProlificDreamer, DreamFusion, DreamGaussian et bien d'autres suivent une approche basée sur l'optimisation pour obtenir des images 3D en distillant une image 3D à partir de divers modèles incohérents. Bien que ces techniques soient efficaces et génèrent des images 3D satisfaisantes, les résultats pourraient être améliorés avec la mise en œuvre d'un modèle de diffusion de base capable de générer des images multi-vues de manière cohérente. En conséquence, le framework Zero123++ prend le Zero-1 à-3 et peaufine un nouveau modèle de diffusion de base multi-vues de Stable Diffusion.

Dans le cadre zéro-1-à-3, chaque nouvelle vue est générée indépendamment, et cette approche conduit à des incohérences entre les vues générées car les modèles de diffusion ont une nature d'échantillonnage. Pour résoudre ce problème, le framework Zero123++ adopte une approche de disposition en mosaïque, l'objet étant entouré de six vues en une seule image, et garantit la modélisation correcte pour la distribution conjointe des images multi-vues d'un objet.

Un autre défi majeur auquel sont confrontés les développeurs travaillant sur le framework Zero-1-to-3 est qu'il sous-utilise les capacités offertes par Diffusion stable cela conduit finalement à l’inefficacité et à des coûts supplémentaires. Il existe deux raisons principales pour lesquelles le framework Zero-1-to-3 ne peut pas maximiser les capacités offertes par Stable Diffusion.

- Lors de l'entraînement avec des conditions d'image, le cadre Zero-1-to-3 n'intègre pas efficacement les mécanismes de conditionnement locaux ou globaux offerts par Stable Diffusion.

- Pendant la formation, le framework Zero-1-to-3 utilise une résolution réduite, une approche dans laquelle la résolution de sortie est réduite en dessous de la résolution de formation, ce qui peut réduire la qualité de génération d'images pour les modèles de diffusion stable.

Pour résoudre ces problèmes, le framework Zero123++ implémente un ensemble de techniques de conditionnement qui maximisent l'utilisation des ressources offertes par Stable Diffusion et maintiennent la qualité de génération d'images pour les modèles de diffusion stable.

Améliorer le conditionnement et les cohérences

Dans le but d'améliorer le conditionnement des images et la cohérence des images multi-vues, le framework Zero123++ a mis en œuvre différentes techniques, l'objectif principal étant de réutiliser des techniques antérieures provenant du modèle de diffusion stable pré-entraîné.

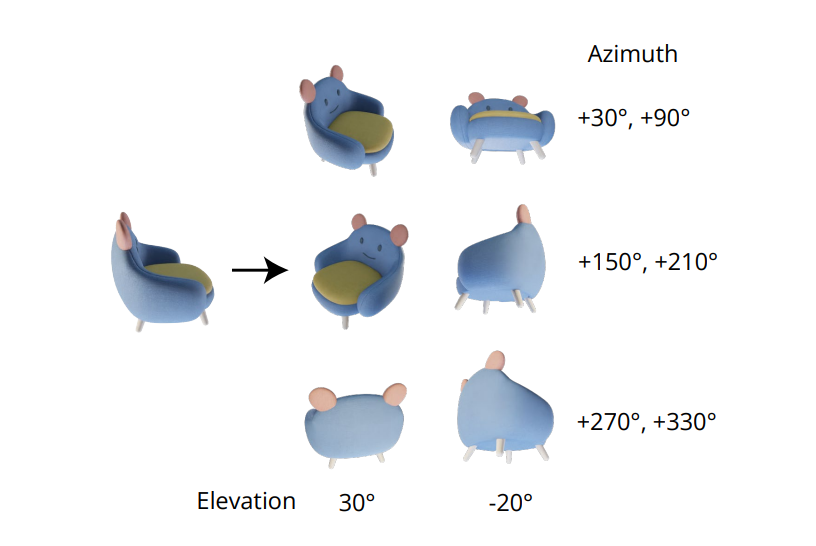

Génération multi-vues

La qualité indispensable pour générer des images multi-vues cohérentes réside dans la modélisation correcte de la distribution conjointe de plusieurs images. Dans le cadre Zero-1-to-3, la corrélation entre les images multi-vues est ignorée car pour chaque image, le cadre modélise la distribution marginale conditionnelle de manière indépendante et séparée. Cependant, dans le framework Zero123++, les développeurs ont opté pour une approche de disposition en mosaïque qui regroupe 6 images en une seule image/image pour une génération multi-vues cohérente, et le processus est démontré dans l'image suivante.

De plus, il a été remarqué que les orientations des objets ont tendance à lever l'ambiguïté lors de l'entraînement du modèle sur les poses de la caméra, et pour éviter cette ambiguïté, le cadre Zero-1-to-3 entraîne les poses de la caméra avec des angles d'élévation et un azimut relatif par rapport à l'entrée. Pour mettre en œuvre cette approche, il est nécessaire de connaître l'angle d'élévation de la vue de l'entrée qui est ensuite utilisé pour déterminer la pose relative entre les nouvelles vues d'entrée. Pour tenter de connaître cet angle d'élévation, les frameworks ajoutent souvent un module d'estimation d'élévation, et cette approche se fait souvent au prix d'erreurs supplémentaires dans le pipeline.

Horaire de bruit

Programme linéaire à échelle, le programme de bruit original pour la diffusion stable se concentre principalement sur les détails locaux, mais comme on peut le voir dans l'image suivante, il comporte très peu d'étapes avec un SNR ou un rapport signal/bruit plus faible.

Ces étapes de faible rapport signal sur bruit se produisent tôt lors de la phase de débruitage, une étape cruciale pour déterminer la structure globale des basses fréquences. La réduction du nombre d'étapes pendant l'étape de débruitage, que ce soit pendant les interférences ou pendant l'entraînement, entraîne souvent une plus grande variation structurelle. Bien que cette configuration soit idéale pour la génération d'images uniques, elle limite la capacité du framework à garantir une cohérence globale entre les différentes vues. Pour surmonter cet obstacle, le framework Zero123++ affine un modèle LoRA sur le framework de prédiction v Stable Diffusion 2 pour effectuer une tâche de jouet, et les résultats sont démontrés ci-dessous.

Avec le programme de bruit linéaire et mis à l'échelle, le modèle LoRA ne surajuste pas, mais blanchit seulement légèrement l'image. À l'inverse, lorsque vous travaillez avec le programme de bruit linéaire, le cadre LoRA génère avec succès une image vierge quelle que soit l'invite de saisie, signifiant ainsi l'impact du programme de bruit sur la capacité du cadre à s'adapter aux nouvelles exigences à l'échelle mondiale.

Attention de référence adaptée aux conditions locales

L'entrée de vue unique ou les images de conditionnement dans le cadre Zero-1-to-3 sont concaténées avec les entrées bruitées dans la dimension caractéristique à bruiter pour le conditionnement d'image.

Cette concaténation conduit à une correspondance spatiale incorrecte au niveau des pixels entre l'image cible et l'entrée. Pour fournir une entrée de conditionnement local appropriée, le framework Zero123++ utilise une attention de référence mise à l'échelle, une approche dans laquelle l'exécution d'un modèle UNet de débruitage est référencée sur une image de référence supplémentaire, suivie de l'ajout de matrices de valeurs et d'une clé d'auto-attention de la référence. image aux couches d'attention respectives lorsque l'entrée du modèle est débruitée, et cela est démontré dans la figure suivante.

L'approche Reference Attention est capable de guider le modèle de diffusion pour générer des images partageant une texture ressemblant à l'image de référence et un contenu sémantique sans aucun réglage fin. Avec un réglage fin, l’approche Reference Attention fournit des résultats supérieurs avec la mise à l’échelle du latent.

Conditionnement global : FlexDiffuse

Dans l'approche originale de diffusion stable, les incorporations de texte sont la seule source d'incorporations globales, et l'approche utilise le framework CLIP comme encodeur de texte pour effectuer des examens croisés entre les incorporations de texte et les latents du modèle. Par conséquent, les développeurs sont libres d'utiliser l'alignement entre les espaces de texte et les images CLIP résultantes pour l'utiliser pour le conditionnement global des images.

Le framework Zero123++ propose d'utiliser une variante entraînable du mécanisme de guidage linéaire pour intégrer le conditionnement global de l'image dans le framework avec un minimum de réglage fin nécessaire, et les résultats sont démontrés dans l’image suivante. Comme on peut le constater, sans présence d'un conditionnement global de l'image, la qualité du contenu généré par le framework est satisfaisante pour les régions visibles qui correspondent à l'image d'entrée. Cependant, la qualité de l'image générée par le cadre pour les régions invisibles connaît une détérioration significative, principalement due à l'incapacité du modèle à déduire la sémantique globale de l'objet.

Architecture du modèle

Le framework Zero123++ est formé avec le modèle Stable Diffusion 2v comme base en utilisant les différentes approches et techniques mentionnées dans l'article. Le framework Zero123++ est pré-entraîné sur l'ensemble de données Objaverse qui est rendu avec un éclairage HDRI aléatoire. Le cadre adopte également l'approche du calendrier de formation par étapes utilisée dans le cadre des variations d'image de diffusion stable dans le but de minimiser davantage la quantité de réglage fin requis et de préserver autant que possible la diffusion stable précédente.

Le fonctionnement ou l'architecture du framework Zero123++ peut être divisé en étapes ou phases séquentielles. La première phase voit le cadre affiner les matrices KV des couches d'attention croisée et les couches d'auto-attention de Stable Diffusion avec AdamW comme optimiseur, 1000 étapes d'échauffement et le programme de taux d'apprentissage du cosinus maximisant à 7 × 10.-5. Dans la deuxième phase, le cadre utilise un taux d'apprentissage constant très conservateur avec 2000 XNUMX séries d'échauffement et utilise l'approche Min-SNR pour maximiser l'efficacité pendant la formation.

Zero123++ : Comparaison des résultats et des performances

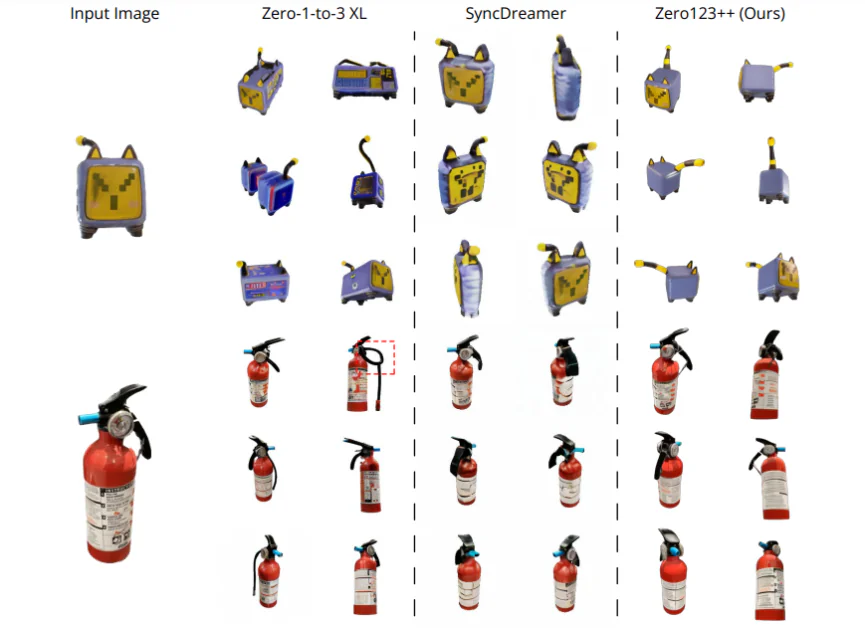

Performances qualitatives

Pour évaluer les performances du framework Zero123++ sur la base de sa qualité générée, il est comparé à SyncDreamer et Zero-1-to-3-XL, deux des meilleurs frameworks de pointe pour la génération de contenu. Les cadres sont comparés à quatre images d'entrée avec une portée différente. La première image est un chat jouet électrique, tirée directement de l'ensemble de données Objaverse, et présente une grande incertitude à l'arrière de l'objet. La deuxième est l'image d'un extincteur et la troisième est l'image d'un chien assis sur une fusée, générée par le modèle SDXL. L'image finale est une illustration animée. Les étapes d'élévation requises pour les cadres sont obtenues à l'aide de la méthode d'estimation d'élévation du cadre One-2-3-4-5, et la suppression de l'arrière-plan est obtenue à l'aide du cadre SAM. Comme on peut le voir, le framework Zero123++ génère de manière cohérente des images multi-vues de haute qualité et est capable de se généraliser également à l'illustration 2D hors domaine et aux images générées par l'IA.

Analyse quantitative

Pour comparer quantitativement le framework Zero123++ aux frameworks de pointe Zero-1-to-3 et Zero-1to-3 XL, les développeurs évaluent le score LPIPS (Learned Perceptual Image Patch Similarity) de ces modèles sur les données fractionnées de validation, un sous-ensemble du jeu de données Objaverse. Pour évaluer les performances du modèle en matière de génération d'images multi-vues, les développeurs juxtaposent respectivement les images de référence de vérité terrain et 6 images générées, puis calculent le score LPIPS (Learned Perceptual Image Patch Similarity). Les résultats sont démontrés ci-dessous et comme on peut le voir clairement, le framework Zero123++ obtient les meilleures performances sur l'ensemble fractionné de validation.

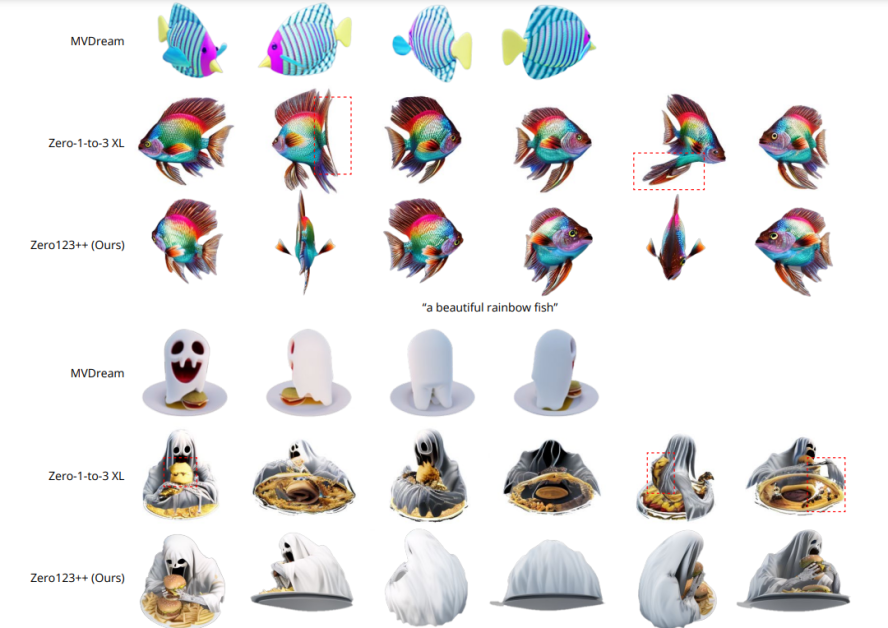

Texte vers évaluation multi-vues

Pour évaluer la capacité du framework Zero123++ à générer du contenu Text to Multi-View, les développeurs utilisent d'abord le framework SDXL avec des invites de texte pour générer une image, puis utilisent le framework Zero123++ pour l'image générée. Les résultats sont démontrés dans l'image suivante, et comme on peut le voir, comparé au framework Zero-1-to-3 qui ne peut pas garantir une génération multi-vue cohérente, le framework Zero123++ renvoie des multi-vues cohérentes, réalistes et très détaillées. afficher les images en implémentant le texte en image vers multi-vue approche ou pipeline.

Zero123++ Contrôle de profondeurNet

En plus du framework de base Zero123++, les développeurs ont également publié Depth ControlNet Zero123++, une version contrôlée en profondeur du framework original construit à l'aide de l'architecture ControlNet. Les images linéaires normalisées sont rendues dans le respect des images RVB ultérieures, et un cadre ControlNet est formé pour contrôler la géométrie du cadre Zero123++ à l'aide de la perception de la profondeur.

Conclusion

Dans cet article, nous avons parlé de Zero123++, un modèle d'IA génératif de diffusion conditionné par l'image dans le but de générer des images à vues multiples cohérentes en 3D à l'aide d'une seule entrée de vue. Pour maximiser l'avantage tiré des modèles génératifs pré-entraînés antérieurs, le framework Zero123++ met en œuvre de nombreux schémas de formation et de conditionnement pour minimiser l'effort nécessaire pour affiner les modèles d'images de diffusion disponibles dans le commerce. Nous avons également discuté des différentes approches et améliorations mises en œuvre par le framework Zero123++ qui l'aident à atteindre des résultats comparables, voire dépassant ceux obtenus par les frameworks de pointe actuels.

Cependant, malgré son efficacité et sa capacité à générer des images multi-vues de haute qualité de manière cohérente, le cadre Zero123++ peut encore être amélioré, les domaines de recherche potentiels étant un

- Modèle de raffineur à deux étages cela pourrait résoudre l'incapacité de Zero123++ à répondre aux exigences mondiales de cohérence.

- Mises à l'échelle supplémentaires pour améliorer encore la capacité de Zero123++ à générer des images de qualité encore supérieure.