Angle d'Anderson

Vers un contrôle total dans la génération de vidéos IA

Modèles de fondation vidéo tels que Hunyuan et Wan2.1, bien que puissants, n'offrent pas aux utilisateurs le type de contrôle granulaire que la production cinématographique et télévisuelle (en particulier la production d'effets visuels) exige.

Dans les studios d'effets visuels professionnels, des modèles open source comme ceux-ci, ainsi que des modèles antérieurs basés sur l'image (plutôt que sur la vidéo) tels que Diffusion stable, Kandinsky et Flux, sont généralement utilisés avec une gamme d'outils d'accompagnement qui adaptent leur production brute à des besoins créatifs spécifiques. Lorsqu'un réalisateur dit : « Ça a l’air génial, mais est-ce qu’on pourrait le rendre un peu plus [n] ? » vous ne pouvez pas répondre en disant que le modèle n'est pas suffisamment précis pour gérer de telles demandes.

Au lieu de cela, une équipe d'effets visuels d'IA utilisera une gamme de méthodes traditionnelles CGI et des techniques de composition, alliées à des procédures et des flux de travail personnalisés développés au fil du temps, afin de tenter de repousser un peu plus loin les limites de la synthèse vidéo.

Ainsi, par analogie, un modèle vidéo de base ressemble beaucoup à une installation par défaut d'un navigateur Web comme Chrome ; il fait beaucoup de choses prêtes à l'emploi, mais si vous voulez qu'il s'adapte à vos besoins, plutôt que l'inverse, vous aurez besoin de quelques plugins.

Les maniaques du contrôle

Dans le monde de la synthèse d’images par diffusion, le système tiers le plus important est ContrôleNet.

ControlNet est une technique permettant d'ajouter un contrôle structuré aux modèles génératifs basés sur la diffusion, permettant aux utilisateurs de guider la génération d'images ou de vidéos avec des entrées supplémentaires telles que cartes de bord, cartes de profondeur, ou informations sur la pose.

Les différentes méthodes de ControlNet permettent la génération d'images guidées par la profondeur (rangée supérieure), la segmentation sémantique (rangée inférieure gauche) et la génération d'images guidées par la pose des humains et des animaux (rangée inférieure gauche).

Au lieu de s'appuyer uniquement sur des invites textuelles, ControlNet introduit des branches de réseau neuronal distinctes, ou adaptateurs, qui traitent ces signaux de conditionnement tout en préservant les capacités génératives du modèle de base.

Cela permet des sorties affinées qui adhèrent plus étroitement aux spécifications de l'utilisateur, ce qui le rend particulièrement utile dans les applications où une composition, une structure ou un contrôle de mouvement précis sont requis :

Avec une pose de guidage, une variété de types de sortie précis peuvent être obtenus via ControlNet. Source : https://arxiv.org/pdf/2302.05543

Cependant, les cadres basés sur des adaptateurs de ce type opèrent de manière externe sur un ensemble de processus neuronaux fortement centrés sur l'interne. Ces approches présentent plusieurs inconvénients.

Premièrement, les adaptateurs sont formés de manière indépendante, ce qui conduit à conflits de branches lorsque plusieurs adaptateurs sont combinés, ce qui peut entraîner une dégradation de la qualité de génération.

Deuxièmement, ils introduisent redondance des paramètres, nécessitant des calculs et de la mémoire supplémentaires pour chaque adaptateur, ce qui rend la mise à l'échelle inefficace.

Troisièmement, malgré leur flexibilité, les adaptateurs produisent souvent sous-optimal résultats par rapport aux modèles entièrement affiné Pour la génération multi-conditions. Ces problèmes rendent les méthodes basées sur des adaptateurs moins efficaces pour les tâches nécessitant une intégration transparente de plusieurs signaux de contrôle.

Idéalement, les capacités de ControlNet devraient être formées nativement dans le modèle, de manière modulaire, qui pourrait accueillir des innovations évidentes ultérieures et très attendues telles que la génération simultanée de vidéo/audio ou des capacités natives de synchronisation labiale (pour l'audio externe).

Dans l'état actuel des choses, chaque élément de fonctionnalité supplémentaire représente soit une tâche de post-production, soit une procédure non native qui doit naviguer dans les pondérations étroitement liées et sensibles du modèle de fondation sur lequel elle fonctionne.

FullDiT

Dans cette impasse, une nouvelle offre chinoise propose un système dans lequel les mesures de type ControlNet sont intégrées directement dans un modèle vidéo génératif au moment de la formation, au lieu d'être reléguées à une réflexion après coup.

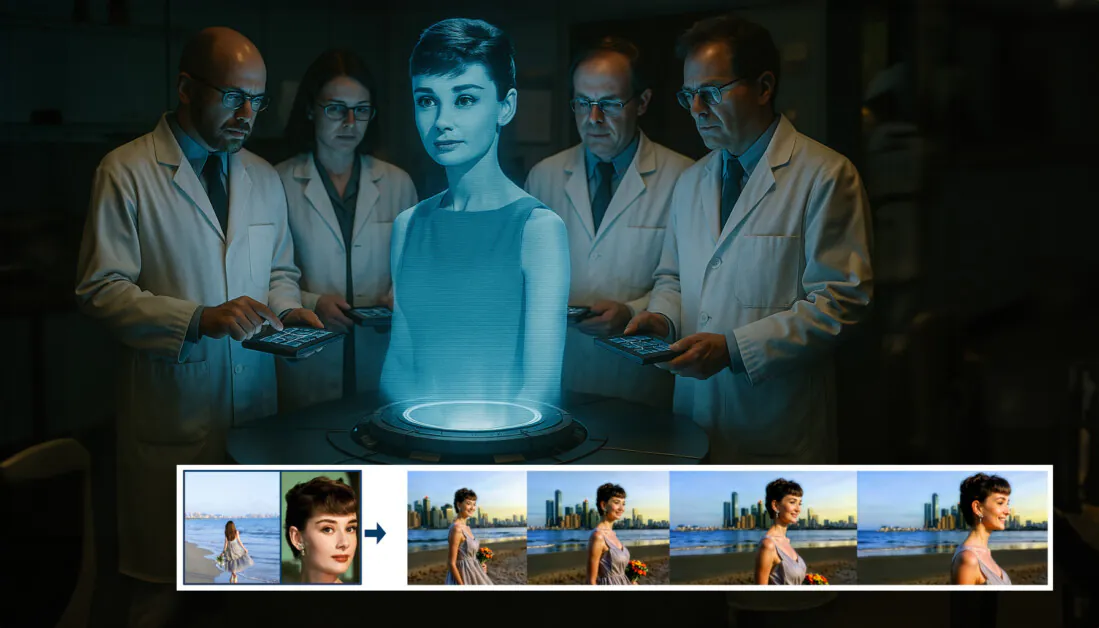

D'après le nouveau document : l'approche FullDiT peut intégrer l'imposition d'identité, la profondeur et le mouvement de la caméra dans une génération native, et peut invoquer n'importe quelle combinaison de ces éléments à la fois. Source : https://arxiv.org/pdf/2503.19907

Titré FullDiT, la nouvelle approche fusionne des conditions multitâches telles que le transfert d'identité, la cartographie de profondeur et le mouvement de la caméra dans une partie intégrée d'un modèle vidéo génératif entraîné, pour lequel les auteurs ont produit un prototype de modèle entraîné et des clips vidéo d'accompagnement à un site du projet.

Dans l'exemple ci-dessous, nous voyons des générations qui intègrent le mouvement de la caméra, les informations d'identité et les informations textuelles (c'est-à-dire les invites textuelles de guidage de l'utilisateur) :

Cliquez pour jouer. Exemples d'imposition d'utilisateur de style ControlNet avec uniquement un modèle de base formé en natif. Source : https://fulldit.github.io/

Il convient de noter que les auteurs ne proposent pas leur modèle expérimental formé comme un modèle de base fonctionnel, mais plutôt comme une preuve de concept pour les modèles natifs de texte en vidéo (T2V) et d'image en vidéo (I2V) qui offrent aux utilisateurs plus de contrôle qu'une simple invite d'image ou une invite de texte.

Comme il n’existe pas encore de modèles similaires de ce type, les chercheurs ont créé une nouvelle référence intitulée FullBench, pour l'évaluation de vidéos multitâches, et revendiquent des performances de pointe lors des tests comparables qu'ils ont conçus par rapport aux approches précédentes. Cependant, FullBench ayant été conçu par les auteurs eux-mêmes, son objectivité n'a pas été testée et son ensemble de données de 1,400 XNUMX cas pourrait être trop limité pour permettre des conclusions plus larges.

L'aspect le plus intéressant de l'architecture présentée dans l'article est peut-être sa capacité à intégrer de nouveaux types de contrôle. Les auteurs affirment :

« Dans ce travail, nous explorons uniquement les conditions de contrôle de la caméra, les identités et les informations de profondeur. Nous n'avons pas approfondi d'autres conditions et modalités telles que l'audio, la parole, le nuage de points, les cadres de délimitation d'objets, le flux optique, etc. Bien que FullDiT puisse intégrer de manière transparente d'autres modalités avec une modification architecturale minimale, l'adaptation rapide et économique des modèles existants aux nouvelles conditions et modalités reste une question importante qui mérite d'être approfondie. »

Bien que les chercheurs présentent FullDiT comme une avancée dans la génération de vidéos multitâches, il faut considérer que ce nouveau travail s'appuie sur des architectures existantes plutôt que d'introduire un paradigme fondamentalement nouveau.

Néanmoins, FullDiT est actuellement le seul (à ma connaissance) à être un modèle de fondation vidéo avec des fonctionnalités de style ControlNet « codées en dur » – et il est bon de voir que l'architecture proposée peut également accueillir des innovations ultérieures.

Cliquez pour jouer. Exemples de mouvements de caméra contrôlés par l'utilisateur, depuis le site du projet.

Le nouveau papier est intitulé FullDiT : Modèle de fondation génératif vidéo multitâche avec attention totale, et provient de neuf chercheurs de Kuaishou Technology et de l'Université chinoise de Hong Kong. La page du projet est ici et les nouvelles données de référence sont à Hugging Face.

Méthode

Les auteurs soutiennent que le mécanisme d'attention unifiée de FullDiT permet un apprentissage de représentation intermodale plus fort en capturant les relations spatiales et temporelles entre les conditions :

Selon la nouvelle étude, FullDiT intègre plusieurs conditions d'entrée grâce à une auto-attention totale, les convertissant en une séquence unifiée. En revanche, les modèles basés sur des adaptateurs (à gauche ci-dessus) utilisent des modules distincts pour chaque entrée, ce qui entraîne redondance, conflits et baisse des performances.

Contrairement aux configurations basées sur des adaptateurs qui traitent chaque flux d'entrée séparément, cette structure d'attention partagée évite les conflits de branches et réduit la surcharge des paramètres. Ils affirment également que l'architecture peut s'adapter à de nouveaux types d'entrées sans refonte majeure, et que le schéma du modèle montre des signes de généralisation à des combinaisons de conditions non observées lors de l'apprentissage, comme l'association du mouvement de la caméra à l'identité du personnage.

Cliquez pour jouer. Exemples de génération d'identité à partir du site du projet.

Dans l'architecture de FullDiT, toutes les entrées de conditionnement – telles que le texte, le mouvement de la caméra, l'identité et la profondeur – sont d'abord converties en un format de jeton unifié. Ces jetons sont ensuite concaténés en une seule longue séquence, traitée par une pile de transformateur couches en utilisant l'auto-attention totale. Cette approche s'inscrit dans la lignée de travaux antérieurs tels que Plan Open-Sora et Génération de films.

Cette conception permet au modèle d'apprendre conjointement les relations temporelles et spatiales dans toutes les conditions. Chaque bloc transformateur fonctionne sur l'ensemble de la séquence, permettant des interactions dynamiques entre les modalités sans recourir à des modules distincts pour chaque entrée. De plus, comme nous l'avons vu, l'architecture est conçue pour être extensible, facilitant ainsi l'intégration ultérieure de signaux de contrôle supplémentaires, sans modifications structurelles majeures.

Le pouvoir des trois

FullDiT convertit chaque signal de contrôle en un format de jeton standardisé afin que toutes les conditions puissent être traitées ensemble dans un cadre d'attention unifié. Pour le mouvement de la caméra, le modèle encode une séquence de paramètres extrinsèques, tels que la position et l'orientation, pour chaque image. Ces paramètres sont horodatés et projetés dans des vecteurs d'intégration qui reflètent la nature temporelle du signal.

Les informations d'identité sont traitées différemment, car elles sont intrinsèquement spatiales plutôt que temporelles. Le modèle utilise des cartes d'identité qui indiquent quels caractères sont présents dans quelles parties de chaque image. Ces cartes sont divisées en patchs, avec chaque patch projeté dans un enrobage qui capture les indices d'identité spatiale, permettant au modèle d'associer des régions spécifiques du cadre à des entités spécifiques.

La profondeur est un signal spatiotemporel, et le modèle la gère en divisant les vidéos de profondeur en zones 3D couvrant à la fois l'espace et le temps. Ces zones sont ensuite intégrées de manière à préserver leur structure d'une image à l'autre.

Une fois intégrés, tous ces jetons de condition (caméra, identité et profondeur) sont concaténés en une seule longue séquence, permettant à FullDiT de les traiter ensemble en utilisant la technologie complète. attention à soiCette représentation partagée permet au modèle d’apprendre les interactions entre les modalités et dans le temps sans s’appuyer sur des flux de traitement isolés.

Données et tests

L'approche de formation de FullDiT s'appuyait sur des ensembles de données annotés de manière sélective et adaptés à chaque type de conditionnement, plutôt que d'exiger que toutes les conditions soient présentes simultanément.

Pour les conditions textuelles, l'initiative suit l'approche de sous-titrage structuré décrite dans le MiraData .

Pipeline de collecte et d'annotation de vidéos du projet MiraData. Source : https://arxiv.org/pdf/2407.06358

Pour le mouvement de la caméra, le Immobilier10K L'ensemble de données était la principale source de données, en raison de ses annotations de vérité terrain de haute qualité des paramètres de la caméra.

Cependant, les auteurs ont observé qu'un entraînement exclusivement basé sur des jeux de données de caméras statiques, comme RealEstate10K, tendait à réduire les mouvements dynamiques des objets et des personnes dans les vidéos générées. Pour remédier à ce problème, ils ont procédé à des ajustements supplémentaires à l'aide de jeux de données internes incluant des mouvements de caméra plus dynamiques.

Les annotations d'identité ont été générées à l'aide du pipeline développé pour le ConceptMaster projet qui a permis un filtrage et une extraction efficaces d'informations d'identité à granularité fine.

Le cadre ConceptMaster est conçu pour résoudre les problèmes de découplage d'identité tout en préservant la fidélité des concepts dans les vidéos personnalisées. Source : https://arxiv.org/pdf/2501.04698

Les annotations de profondeur ont été obtenues à partir du Panda-70M ensemble de données utilisant Profondeur N'importe quoi.

Optimisation par l'ordonnancement des données

Les auteurs ont également mis en œuvre un programme d’entraînement progressif, introduisant des conditions plus difficiles plus tôt dans la formation pour garantir que le modèle acquière des représentations robustes avant l'ajout de tâches plus simples. L'ordre d'apprentissage s'est déroulé comme suit : texte à appareil photo conditions, alors identités, et enfin profondeur, avec des tâches plus faciles généralement introduites plus tard et avec moins d'exemples.

Les auteurs soulignent l’intérêt d’ordonner la charge de travail de cette manière :

Lors de la phase de pré-formation, nous avons constaté que les tâches plus complexes nécessitent un temps de formation plus long et doivent être introduites plus tôt dans le processus d'apprentissage. Ces tâches complexes impliquent des distributions de données complexes qui diffèrent considérablement de la vidéo de sortie, ce qui nécessite que le modèle possède une capacité suffisante pour les capturer et les représenter avec précision.

« À l’inverse, introduire des tâches plus faciles trop tôt peut amener le modèle à donner la priorité à leur apprentissage en premier, car elles fournissent un retour d’optimisation plus immédiat, ce qui entrave la convergence de tâches plus difficiles. »

Une illustration de l’ordre de formation des données adopté par les chercheurs, le rouge indiquant un volume de données plus important.

Après un pré-entraînement initial, une dernière étape de mise au point a permis d'affiner le modèle afin d'améliorer la qualité visuelle et la dynamique du mouvement. L'entraînement a ensuite suivi celui d'un cadre de diffusion standard* : du bruit a été ajouté aux latentes vidéo, et le modèle a été mis au point. apprendre à le prédire et à le supprimer, en utilisant les jetons de condition intégrés comme guide.

Pour évaluer efficacement FullDiT et fournir une comparaison équitable avec les méthodes existantes, et en l'absence de disponibilité de toute autre référence appropriée, les auteurs ont introduit FullBench, une suite de tests de référence organisée composée de 1,400 XNUMX cas de test distincts.

Une instance d'explorateur de données pour le nouveau benchmark FullBench. Source : https://huggingface.co/datasets/KwaiVGI/FullBench

Chaque point de données a fourni des annotations de vérité fondamentale pour divers signaux de conditionnement, notamment mouvement de la caméra, identité et profondeur.

Métrique

Les auteurs ont évalué FullDiT à l’aide de dix mesures couvrant cinq aspects principaux de la performance : l’alignement du texte, le contrôle de la caméra, la similarité d’identité, la précision de la profondeur et la qualité vidéo générale.

L'alignement du texte a été mesuré à l'aide de Similitude CLIP, tandis que le contrôle de la caméra a été évalué à travers erreur de rotation (RotErr), erreur de traduction (TransErr), Et cohérence du mouvement de la caméra (CamMC), suivant l'approche de CamI2V (dans le CaméraCtrl projet).

La similarité d’identité a été évaluée à l’aide de DINO-I et CLIP-I, et la précision du contrôle de la profondeur a été quantifiée à l'aide Erreur absolue moyenne (MAE).

La qualité vidéo a été jugée à l'aide de trois mesures de MiraData : la similarité CLIP au niveau de l'image pour la fluidité ; la distance de mouvement basée sur le flux optique pour la dynamique ; et LAION-Scores esthétiques pour l'attrait visuel.

Formation

Les auteurs ont entraîné FullDiT à l'aide d'un modèle interne (non divulgué) de diffusion texte-vidéo contenant environ un milliard de paramètres. Ils ont volontairement choisi une taille de paramètre modeste afin de préserver l'équité des comparaisons avec les méthodes antérieures et d'assurer la reproductibilité.

Les vidéos de formation différant en longueur et en résolution, les auteurs ont standardisé chaque vidéo. lot en redimensionnant et en remplissant les vidéos à une résolution commune, en échantillonnant 77 images par séquence et en utilisant l'attention appliquée et masques de perte pour optimiser l'efficacité de la formation.

Le Adam l'optimiseur a été utilisé à un taux d'apprentissage de 1 × 10-5 sur un cluster de 64 GPU NVIDIA H800, pour un total combiné de 5,120 XNUMX Go de VRAM (considérez que dans les communautés de synthèse passionnées, 24GB sur une RTX 3090 est toujours considéré comme un standard luxueux).

Le modèle a été formé pendant environ 32,000 20 étapes, intégrant jusqu'à trois identités par vidéo, ainsi que 21 images de conditions de caméra et 77 images de conditions de profondeur, toutes deux échantillonnées uniformément à partir des XNUMX images au total.

Pour l’inférence, le modèle a généré des vidéos à une résolution de 384 × 672 pixels (environ cinq secondes à 15 images par seconde) avec 50 étapes d’inférence de diffusion et une échelle de guidage sans classificateur de cinq.

Méthodes antérieures

Pour l'évaluation caméra-vidéo, les auteurs ont comparé FullDiT à MotionCtrl, CameraCtrl et CamI2V, avec tous les modèles formés à l'aide de l'ensemble de données RealEstate10k pour garantir la cohérence et l'équité.

Dans la génération conditionnée par l'identité, étant donné qu'aucun modèle multi-identité open source comparable n'était disponible, le modèle a été comparé au modèle ConceptMaster à 1 B paramètres, en utilisant les mêmes données de formation et la même architecture.

Pour les tâches de profondeur à vidéo, des comparaisons ont été faites avec Adaptateur Ctrl et ContrôleVidéo.

Résultats quantitatifs pour la génération vidéo monotâche. FullDiT a été comparé à MotionCtrl, CameraCtrl et CamI2V pour la génération caméra-vidéo ; ConceptMaster (version à paramètres 1B) pour la génération identité-vidéo ; et Ctrl-Adapter et ControlVideo pour la génération profondeur-vidéo. Tous les modèles ont été évalués avec leurs paramètres par défaut. Par souci de cohérence, 16 images ont été échantillonnées uniformément pour chaque méthode, correspondant à la longueur de sortie des modèles précédents.

Les résultats indiquent que FullDiT, malgré la gestion simultanée de plusieurs signaux de conditionnement, a atteint des performances de pointe dans les mesures liées au texte, au mouvement de la caméra, à l'identité et aux contrôles de profondeur.

En termes de qualité globale, le système a généralement surpassé les autres méthodes, même si sa fluidité était légèrement inférieure à celle de ConceptMaster. Voici le commentaire des auteurs :

La fluidité de FullDiT est légèrement inférieure à celle de ConceptMaster, car son calcul repose sur la similarité CLIP entre images adjacentes. Comme FullDiT présente une dynamique nettement supérieure à celle de ConceptMaster, la métrique de fluidité est impactée par les importantes variations entre images adjacentes.

« Pour le score esthétique, étant donné que le modèle de notation privilégie les images de style peinture et que ControlVideo génère généralement des vidéos dans ce style, il obtient un score élevé en esthétique. »

Concernant la comparaison qualitative, il serait peut-être préférable de se référer aux exemples de vidéos sur le site du projet FullDiT, car les exemples PDF sont inévitablement statiques (et également trop volumineux pour être entièrement reproduits ici).

Première partie des résultats qualitatifs du PDF. Veuillez vous référer à l'article source pour les exemples supplémentaires, trop nombreux pour être reproduits ici.

Les auteurs commentent :

FullDiT démontre une meilleure préservation de l'identité et génère des vidéos avec une dynamique et une qualité visuelle supérieures à celles de ConceptMaster. ConceptMaster et FullDiT étant formés sur la même infrastructure, cela souligne l'efficacité de l'injection de conditions avec une attention totale.

« … Les [autres] résultats démontrent la contrôlabilité et la qualité de génération supérieures de FullDiT par rapport aux méthodes existantes de profondeur vers vidéo et de caméra vers vidéo. »

Extrait du PDF présentant des exemples de sortie FullDiT avec plusieurs signaux. Veuillez consulter l'article source et le site du projet pour d'autres exemples.

Conclusion

Bien que FullDiT soit une incursion passionnante dans un type de modèle de fondation vidéo plus complet, on peut se demander si la demande d'instruments de type ControlNet justifiera un jour la mise en œuvre de telles fonctionnalités à grande échelle, au moins pour les projets FOSS, qui auraient du mal à obtenir l'énorme quantité de puissance de traitement GPU nécessaire, sans soutien commercial.

Le principal défi réside dans le fait que l'utilisation de systèmes tels que Depth et Pose requiert généralement une familiarité non négligeable avec des interfaces utilisateur relativement complexes comme ComfyUI. Il semble donc qu'un modèle FOSS fonctionnel de ce type soit très probablement développé par un groupe de petites sociétés d'effets visuels, manquant de moyens (ou de volonté, étant donné que ces systèmes deviennent rapidement obsolètes avec les mises à niveau des modèles) pour concevoir et entraîner un tel modèle en coulisses.

D'un autre côté, les systèmes de « location d'IA » pilotés par API pourraient être bien motivés pour développer des méthodes d'interprétation plus simples et plus conviviales pour les modèles dans lesquels des systèmes de contrôle auxiliaires ont été directement formés.

Cliquez pour jouer. Contrôles de profondeur + texte imposés à une génération vidéo utilisant FullDiT.

* Les auteurs ne précisent aucun modèle de base connu (c'est-à-dire SDXL, etc.)

Première publication le jeudi 27 mars 2025