Éthique

La base de données des incidents d'IA vise à rendre les algorithmes d'IA plus sûrs

Tout système suffisamment grand contiendra des erreurs, et une partie de la correction de ces erreurs consiste à disposer d'une base de données qui peut être analysée pour les impacts et les causes potentielles. Tout comme la FDA tient une base de données sur les effets indésirables des médicaments, ou le National Transportation Safety Board tient une base de données sur les accidents d'aviation, la base de données des incidents d'IA est une base de données destiné à cataloguer les défaillances des systèmes d'IA et pour aider les chercheurs en IA à concevoir de nouvelles méthodes pour éviter ces échecs. Les créateurs de la base de données AI Incident Database (AIID) espèrent qu'elle aidera les entreprises d'IA à développer une IA plus sûre et plus éthique.

Qu'est-ce que l'AIID ?

L'AIID est le produit de l'organisation Partnership on AI (PAI). PAI a été initialement fondée en 2016 par des membres d'équipes de recherche en IA de grandes entreprises technologiques telles que Facebook, Apple, Amazon, Google, IBM et Microsoft. Depuis lors, l'organisation a recruté des membres de nombreuses autres organisations, y compris diverses organisations à but non lucratif. En 2018, PAI a entrepris de créer une norme de classification cohérente pour les défaillances de l'IA. Cependant, il n'y avait pas de collecte d'incidents d'IA sur lesquels fonder cette classification. Pour cette raison, PAI a créé l'AIID.

Selon TechTalks, le format de l'AIID s'inspire de la structure de la base de données sur les accidents d'aviation gérée par le National Transportation Safety Board. Depuis le début de la collecte des rapports en 1996, le système de transport aérien commercial a réussi à accroître la sécurité de l'industrie aéronautique en archivant et en analysant les incidents. L'espoir est qu'un référentiel similaire d'incidents d'IA puisse rendre les systèmes d'IA plus sûrs, plus éthiques et plus fiables. AIID s'est également inspiré de la base de données Common Vulnerabilities and Exposures, qui est un référentiel de défaillances logicielles notables qui couvrent une variété d'industries et de disciplines différentes.

Sean McGregor est le consultant technique principal chez IBM pour Watson AI XPRIZE. McGregor est également chargé de superviser le développement de la base de données actuelle de l'AIID. McGregor a expliqué que l'objectif de l'AIID est en fin de compte d'empêcher les systèmes d'IA de causer des dommages, ou du moins de réduire la gravité des incidents indésirables. Comme l'a souligné McGregor, les systèmes d'apprentissage automatique sont nettement plus complexes et imprévisibles que les systèmes logiciels traditionnels et, par conséquent, ils ne peuvent pas être testés de la même manière que d'autres logiciels. Les systèmes d’apprentissage automatique peuvent modifier leur comportement de manière inattendue. McGregor note que la capacité d’apprentissage des systèmes d’apprentissage profond peut signifier que « les dysfonctionnements sont plus probables, plus compliqués et plus dangereux » lorsqu’ils entrent dans un monde non structuré.

Plus de 1,000 XNUMX incidents liés à l'IA enregistrés

Depuis la création initiale de l'AIID, plus de 1,000 XNUMX incidents liés à l'IA ont été enregistrés dans la base de données. Parmi tous les incidents répertoriés dans la base de données, les problèmes d'équité en matière d'IA étaient le type d'incident indésirable le plus courant. Bon nombre de ces incidents d'équité impliquent l'utilisation d'algorithmes de reconnaissance faciale par des agences gouvernementales. McGregor note également qu'il y a un nombre croissant d'incidents impliquant la robotique ajoutés à la base de données.

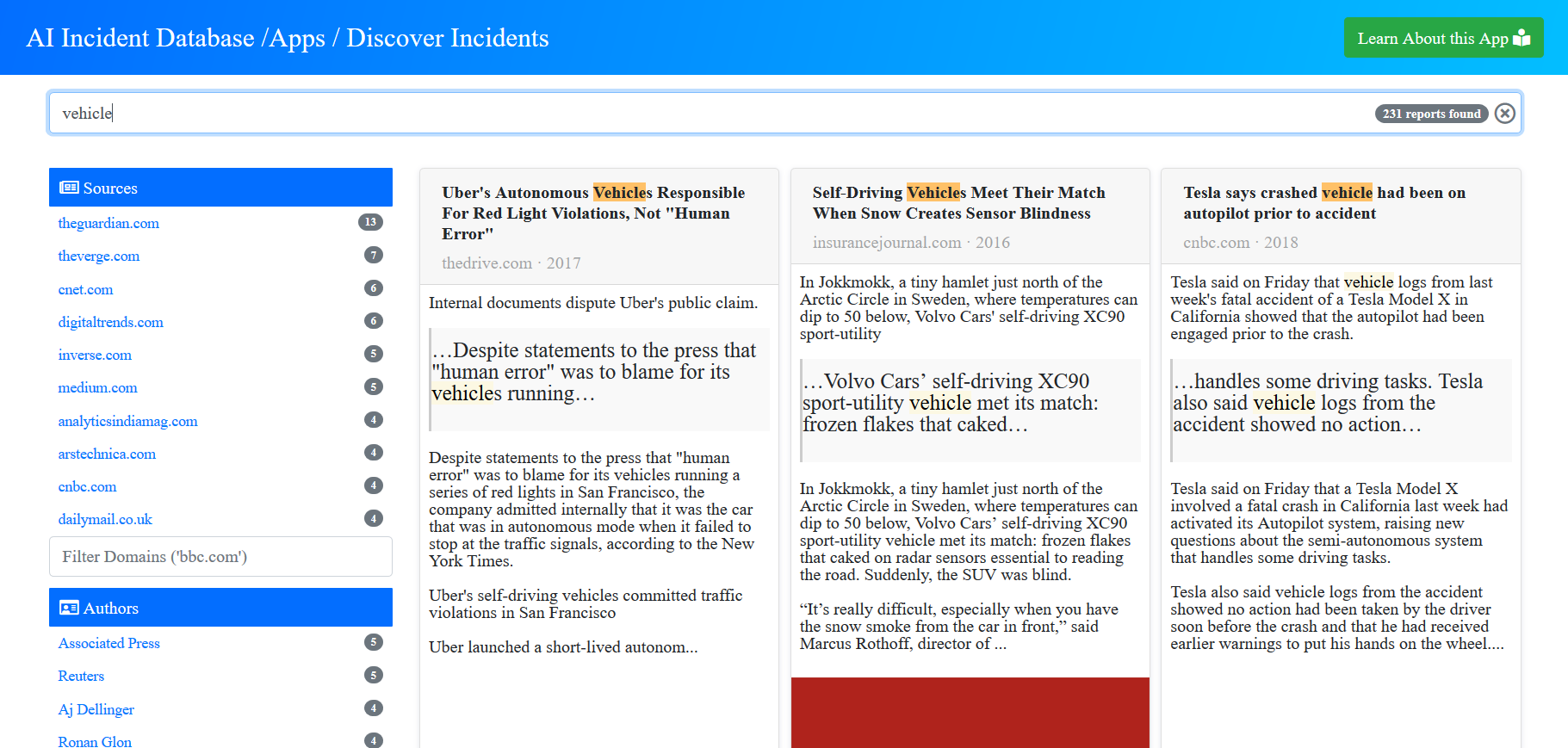

Les visiteurs de la base de données peuvent exécuter des requêtes, rechercher des incidents dans la base de données en fonction de critères tels que des mots clés, l'ID d'incident, la source ou l'auteur. Par exemple, lancer une recherche sur « Deepfake » renvoie 7 rapports, tandis que la recherche de « robots » renvoie 158 rapports.

Une base de données centralisée pour les incidents de dysfonctionnement et de fonctionnement inattendu de l'IA peut aider les chercheurs, les ingénieurs et les éthiciens à superviser le développement et le déploiement des systèmes d'IA. Les chefs de produit des entreprises technologiques pourraient utiliser l'AIID pour voir s'il y a des problèmes potentiels avant d'utiliser des systèmes de recommandation d'IA, ou un ingénieur en IA pourrait avoir une idée des biais potentiels qui doivent être corrigés lors de la création de l'application d'IA. De même, les agents des risques pourraient utiliser la base de données pour déterminer les effets secondaires négatifs potentiels associés à un modèle d'IA, leur permettant de planifier à l'avance et d'élaborer des mesures pour atténuer les dommages potentiels.

L'architecture sous-jacente à AIID est censée être flexible, car elle permet la création de nouveaux outils pour interroger la base de données et extraire des informations significatives. Le Partenariat sur l'IA et McGregor collaboreront pour concevoir une taxonomie flexible qui peut être utilisée pour classer toutes les différentes formes d'incidents liés à l'IA. L'équipe espère qu'une fois la taxonomie flexible créée, elle pourra être combinée avec un système automatisé qui enregistrera automatiquement les incidents d'IA.

"La communauté de l'IA a commencé à partager des enregistrements d'incidents entre eux pour motiver des modifications de leurs produits, procédures de contrôle et programmes de recherche", McGregor expliqué via TechTalks. "Le site a été rendu public en novembre, nous commençons donc à peine à réaliser les avantages du système."