Intelligence Artificielle

StyleTTS 2 : synthèse vocale au niveau humain avec de grands modèles de langage vocal

En raison de l'augmentation des approches de synthèse vocale naturelle et synthétique, l'une des réalisations majeures de l'industrie de l'IA au cours des dernières années est de synthétiser efficacement des cadres de synthèse vocale avec des applications potentielles dans différents secteurs, notamment les livres audio, les assistants virtuels, la voix. -sur des narrations et bien plus encore, avec certains modes de pointe offrant des performances et une efficacité de niveau humain dans un large éventail de tâches liées à la parole. Cependant, malgré leurs bonnes performances, les tâches peuvent encore être améliorées grâce à un discours expressif et diversifié, à la nécessité d'une grande quantité de données de formation pour optimiser les cadres de synthèse vocale zéro-shot et à la robustesse des textes OOD ou hors distribution. les développeurs doivent travailler sur un cadre de synthèse vocale plus robuste et plus accessible.

Dans cet article, nous parlerons de StyleTTS-2, un cadre de synthèse vocale robuste et innovant qui repose sur les fondations du cadre StyleTTS et vise à présenter la prochaine étape vers des systèmes de synthèse vocale de pointe. Le framework StyleTTS2 modélise les styles de parole en tant que variables aléatoires latentes et utilise un modèle de diffusion probabiliste pour échantillonner ces styles de parole ou variables aléatoires, permettant ainsi au framework StyleTTS2 de synthétiser efficacement une parole réaliste sans utiliser d'entrées audio de référence. Grâce à cette approche, le framework StyleTTS2 est capable de fournir de meilleurs résultats et fait preuve d'une grande efficacité par rapport aux frameworks de synthèse vocale de pointe actuels, mais est également capable de tirer parti de la diversité de synthèse vocale offerte par les frameworks de modèles de diffusion. Nous discuterons plus en détail du framework StyleTTS2, parlerons de son architecture et de sa méthodologie tout en examinant les résultats obtenus par le framework. Alors, commençons.

StyleTTS2 pour la synthèse texte-parole : une introduction

StyleTTS2 est un modèle innovant de synthèse de synthèse vocale qui franchit la prochaine étape vers la création de cadres TTS au niveau humain. Il est construit sur StyleTTS, un texte basé sur le style pour modèle générateur de parole. Le framework StyleTTS2 modélise les styles de parole en tant que variables aléatoires latentes et utilise un modèle de diffusion probabiliste pour échantillonner ces styles de parole ou variables aléatoires, permettant ainsi au framework StyleTTS2 de synthétiser efficacement une parole réaliste sans utiliser d'entrées audio de référence. La modélisation des styles en tant que variables aléatoires latentes est ce qui différencie le framework StyleTTS2 de son prédécesseur, le framework StyleTTS, et vise à générer le style de parole le plus approprié pour le texte d'entrée sans avoir besoin d'une entrée audio de référence, et est capable d'obtenir des diffusions latentes efficaces tout en prenant profiter des diverses capacités de synthèse vocale offertes par modèles de diffusion. De plus, le framework StyleTTS2 utilise également un grand modèle SLM ou Speech Language Model pré-entraîné comme discriminateurs comme le framework WavLM, et l'associe à sa propre nouvelle approche de modélisation de durée différentielle pour entraîner le framework de bout en bout et finalement générer une parole avec un naturel amélioré. Grâce à l'approche qu'il suit, le framework StyleTTS2 surpasse les frameworks de pointe actuels pour les tâches de génération de parole et constitue l'un des frameworks les plus efficaces pour pré-entraîner des modèles de parole à grande échelle dans un réglage zéro pour les tâches d'adaptation du locuteur.

Pour continuer, pour fournir une synthèse texte-parole au niveau humain, le cadre StyleTTs2 intègre les enseignements des travaux existants, notamment des modèles de diffusion pour la synthèse vocale et de grands modèles de langage vocal. Les modèles de diffusion sont généralement utilisés pour les tâches de synthèse vocale grâce à leurs capacités de contrôle précis de la parole et à leurs diverses capacités d'échantillonnage vocal. Cependant, les modèles de diffusion ne sont pas aussi efficaces que les cadres non itératifs basés sur le GAN et l'une des principales raisons en est la nécessité d'échantillonner les représentations latentes, les formes d'onde et les spectrogrammes Mel de manière itérative jusqu'à la durée cible de la parole.

D'autre part, des travaux récents autour des grands modèles de langage vocal ont indiqué leur capacité à améliorer la qualité des tâches de génération de synthèse vocale et à bien s'adapter au locuteur. Les grands modèles de langage vocal convertissent généralement la saisie de texte en représentations quantifiées ou continues dérivées de cadres de langage vocal pré-entraînés pour les tâches de reconstruction de la parole. Cependant, les fonctionnalités de ces modèles de langage vocal ne sont pas optimisées directement pour la synthèse vocale. En revanche, le framework StyleTTS2 tire parti des connaissances acquises par les grands frameworks SLM en utilisant la formation contradictoire pour synthétiser les caractéristiques des modèles de langage vocal sans utiliser de cartes d'espace latent, et par conséquent, en apprenant directement un espace latent optimisé pour la synthèse vocale.

StyleTTS2 : Architecture et méthodologie

À la base, le StyleTTS2 est construit sur son prédécesseur, le framework StyleTTS, qui est un framework de synthèse vocale non autorégressif qui utilise un encodeur de style pour dériver un vecteur de style à partir de l'audio de référence, permettant ainsi une génération de parole expressive et naturelle. Le vecteur de style utilisé dans le framework StyleTTS est incorporé directement dans l'encodeur, la durée et les prédicteurs en utilisant AdaIN ou Adaptive Instance Normalization, permettant ainsi au modèle StyleTTS de générer des sorties vocales avec une prosodie, une durée et même des émotions variables. Le framework StyleTTS se compose de 8 modèles au total répartis en trois catégories

- Modèles acoustiques ou système de génération vocale avec un encodeur de style, un encodeur de texte et un décodeur vocal.

- Un système de prédiction de synthèse vocale utilisant des prédicteurs de prosodie et de durée.

- Un système utilitaire comprenant un aligneur de texte, un extracteur de hauteur et un discriminateur à des fins de formation.

Grâce à son approche, le framework StyleTTS offre des performances de pointe liées à une synthèse vocale contrôlable et diversifiée. Cependant, ces performances présentent des inconvénients tels qu'une dégradation de la qualité des échantillons, des limitations d'expression et le recours à des applications gênant la parole en temps réel.

Améliorant le framework StyleTTS, le modèle StyleTTS2 permet d'améliorer l'expression texte à la parole tâches avec une performance hors distribution améliorée et une qualité humaine élevée. Le framework StyleTTS2 utilise un processus de formation de bout en bout qui optimise les différents composants avec une formation contradictoire et une synthèse directe de forme d'onde conjointement. Contrairement au framework StyleTTS, le framework StyleTTS2 modélise le style de parole en tant que variable latente et l'échantillonne via des modèles de diffusion, générant ainsi divers échantillons de parole sans utiliser d'audio de référence. Examinons en détail ces composants.

Formation de bout en bout pour les interférences

Dans le cadre StyleTTS2, une approche de formation de bout en bout est utilisée pour optimiser divers composants de synthèse vocale pour les interférences sans avoir à s'appuyer sur des composants fixes. Le framework StyleTTS2 y parvient en modifiant le décodeur pour générer la forme d'onde directement à partir du vecteur de style, des courbes de hauteur et d'énergie et des représentations alignées. Le framework supprime ensuite la dernière couche de projection du décodeur et la remplace par un décodeur de forme d'onde. Le framework StyleTTS2 utilise deux encodeurs : un décodeur basé sur HifiGAN pour générer directement la forme d'onde, et un décodeur basé sur iSTFT pour produire la phase et l'amplitude qui sont converties en formes d'onde pour des interférences et un entraînement plus rapides.

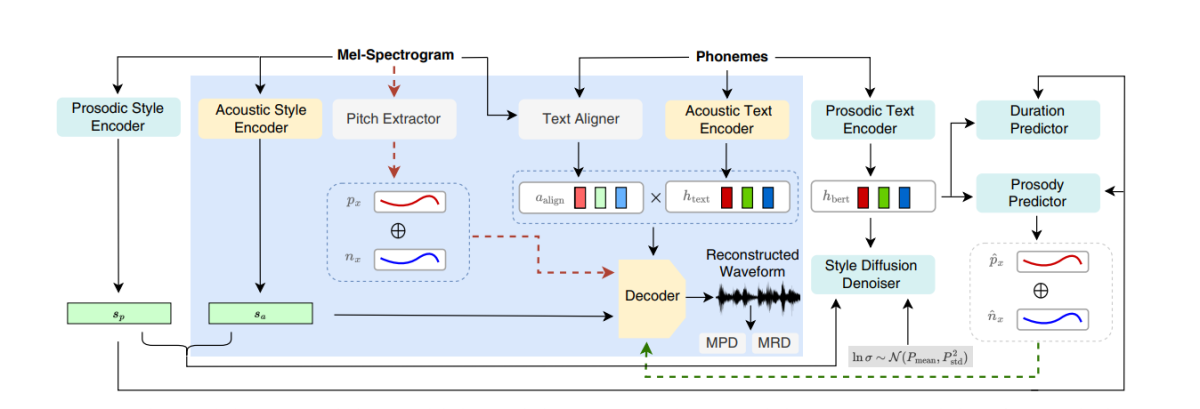

La figure ci-dessus représente les modèles acoustiques utilisés pour la pré-formation et la formation conjointe. Pour réduire le temps de formation, les modules sont d'abord optimisés dans la phase de pré-formation suivi de l'optimisation de tous les composants moins l'extracteur de pitch lors de la formation conjointe. La raison pour laquelle l’entraînement conjoint n’optimise pas l’extracteur de pitch est qu’il est utilisé pour fournir la vérité terrain pour les courbes de pitch.

La figure ci-dessus représente la formation contradictoire du modèle de langage vocal et l'interférence avec le cadre WavLM pré-entraîné mais non pré-réglé. Le processus diffère de celui mentionné ci-dessus car il peut nécessiter différents textes d'entrée mais accumule les dégradés pour mettre à jour les paramètres dans chaque lot.

Diffusion de styles

Le cadre StyleTTS2 vise à modéliser la parole comme une distribution conditionnelle via une variable latente qui suit la distribution conditionnelle, et cette variable est appelée style de parole généralisé et représente toute caractéristique de l'échantillon de parole au-delà de la portée de tout contenu phonétique, y compris l'accent lexical. prosodie, débit de parole et même transitions de formants.

Discriminateurs du modèle de langage vocal

Les modèles de langage vocal sont réputés pour leurs capacités générales à coder des informations précieuses sur un large éventail d'aspects sémantiques et acoustiques, et les représentations SLM sont traditionnellement capables d'imiter les perceptions humaines pour évaluer la qualité de la parole synthétisée générée. Le framework StyleTTS2 utilise une approche de formation contradictoire pour utiliser la capacité des encodeurs SLM à effectuer des tâches génératives et utilise un framework WavLM à 12 couches comme discriminateur. Cette approche permet au cadre de permettre une formation sur des textes OOD ou hors distribution qui peuvent aider à améliorer les performances. De plus, pour éviter les problèmes de surajustement, le cadre échantillonne les textes OOD et la distribution avec une probabilité égale.

Modélisation de durée différenciable

Traditionnellement, un prédicteur de durée est utilisé dans les cadres de synthèse vocale qui produisent des durées de phonèmes, mais les méthodes de suréchantillonnage utilisées par ces prédicteurs de durée bloquent souvent le flux graduel pendant le processus de formation E2E, et le cadre NaturalSpeech utilise un suréchantillonneur basé sur l'attention pour le niveau humain. conversion texte-parole. Cependant, le cadre StyleTTS2 trouve cette approche instable pendant la formation contradictoire, car le StyleTTS2 s'entraîne en utilisant un suréchantillonnage différentiable avec différentes formations contradictoires sans perte de termes supplémentaires en raison d'une inadéquation de longueur due à des écarts. Bien que l'utilisation d'une approche de déformation temporelle dynamique douce puisse aider à atténuer ce décalage, son utilisation est non seulement coûteuse en termes de calcul, mais sa stabilité est également une préoccupation lorsque l'on travaille avec des objectifs contradictoires ou des tâches de reconstruction mel. Par conséquent, pour atteindre des performances au niveau humain avec une formation contradictoire et stabiliser le processus de formation, le cadre StyleTTC2 utilise une approche de suréchantillonnage non paramétrique. Le suréchantillonnage gaussien est une approche de suréchantillonnage non paramétrique populaire pour convertir les durées prédites bien qu'elle ait ses limites grâce à la longueur fixe des noyaux gaussiens prédéterminés. Cette restriction pour le suréchantillonnage gaussien limite sa capacité à modéliser avec précision des alignements de différentes longueurs.

Pour répondre à cette limitation, le framework StyleTTC2 propose d'utiliser une nouvelle approche de suréchantillonnage non paramétrique sans aucune formation supplémentaire, et capable de prendre en compte différentes longueurs d'alignements. Pour chaque phonème, le framework StyleTTC2 modélise l'alignement comme une variable aléatoire et indique l'index du cadre vocal avec lequel le phonème s'aligne.

Modèle de formation et d'évaluation

Le framework StyleTTC2 est formé et expérimenté sur trois ensembles de données : VCTK, LibriTTS et LJSpeech. Le composant à haut-parleur unique du framework StyleTTS2 est formé à l'aide de l'ensemble de données LJSpeech qui contient environ 13,000 12,500+ échantillons audio répartis en 100 500 échantillons d'entraînement, 24 échantillons de validation et près de 44,000 échantillons de test, avec leur durée d'exécution combinée totalisant près de 100 heures. Le composant multi-locuteurs du framework est formé sur l'ensemble de données VCTK composé de plus de 43,500 100 clips audio avec plus de 500 locuteurs natifs individuels avec des accents variés, et est divisé en 250 1,150 échantillons d'apprentissage, XNUMX échantillons de validation et près de XNUMX échantillons de test. Enfin, pour doter le framework de capacités d'adaptation zéro-shot, le framework est formé sur l'ensemble de données combiné LibriTTS qui se compose de clips audio totalisant environ XNUMX heures d'audio avec plus de XNUMX XNUMX haut-parleurs individuels. Pour évaluer ses performances, le modèle utilise deux métriques : MOS-N ou score d'opinion moyen de naturalité, et MOUSSE ou score d'opinion moyen de similarité.

Résultats

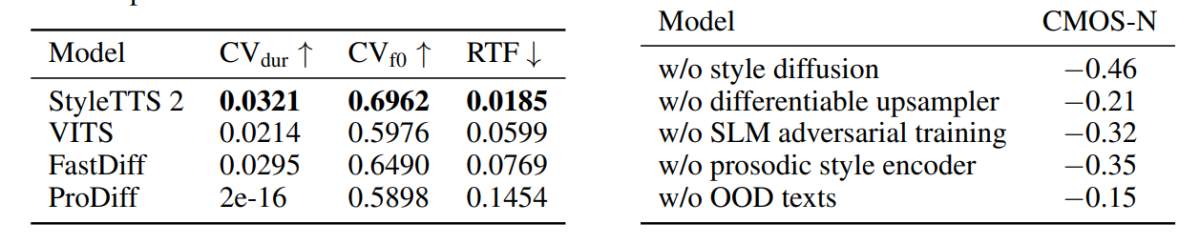

L'approche et la méthodologie utilisées dans le framework StyleTTS2 sont mises en valeur dans leurs performances, car le modèle surpasse plusieurs frameworks TTS de pointe, en particulier sur l'ensemble de données NaturalSpeech, et en route, établissant une nouvelle norme pour l'ensemble de données. De plus, le framework StyleTTS2 surpasse le framework VITS de pointe sur l'ensemble de données VCTK, et les résultats sont démontrés dans la figure suivante.

Le modèle StyleTTS2 surpasse également les modèles précédents sur l'ensemble de données LJSpeech, et il n'affiche aucun degré de dégradation de la qualité sur les textes OOD ou hors distribution comme l'affichaient les frameworks précédents sur les mêmes métriques. De plus, en mode zéro tir, le modèle StyleTTC2 surpasse le framework Vall-E existant en termes de naturel, bien qu'il soit à la traîne en termes de similitude. Cependant, il convient de noter que le framework StyleTTS2 est capable d'atteindre des performances compétitives malgré une formation uniquement sur 245 heures d'échantillons audio, contre plus de 60 2 heures de formation pour le framework Vall-E, prouvant ainsi que StyleTTCXNUMX est une alternative efficace en matière de données. aux grandes méthodes de pré-formation existantes telles qu'utilisées dans le Vall-E.

En progressant, en raison du manque de données de texte audio étiquetées sur les émotions, le framework StyleTTC2 utilise le modèle GPT-4 pour générer plus de 500 instances à travers différentes émotions pour la visualisation des vecteurs de style que le framework crée à l'aide de son la diffusion processus.

Dans la première figure, les styles émotionnels en réponse aux sentiments du texte saisi sont illustrés par les vecteurs de style du modèle LJSpeech, et démontre la capacité du framework StyleTTC2 à synthétiser un discours expressif avec des émotions variées. La deuxième figure représente la forme de groupes distincts pour chacun des cinq haut-parleurs individuels, décrivant ainsi un large éventail de diversité provenant d'un seul fichier audio. La figure finale montre le groupe d'émotions du locuteur 1 et révèle que, malgré certains chevauchements, les groupes basés sur les émotions sont prédominants, indiquant ainsi la possibilité de manipuler la mélodie émotionnelle d'un locuteur quel que soit l'échantillon audio de référence et sa tonalité d'entrée. . Malgré l'utilisation d'une approche basée sur la diffusion, le framework StyleTTS2 parvient à surpasser les frameworks de pointe existants, notamment VITS, ProDiff et FastDiff.

Réflexions finales

Dans cet article, nous avons parlé de StyleTTS2, un cadre de synthèse vocale novateur, robuste et innovant qui repose sur les fondations du cadre StyleTTS et vise à présenter la prochaine étape vers des systèmes de synthèse vocale de pointe. Le framework StyleTTS2 modélise les styles de parole en tant que variables aléatoires latentes et utilise un modèle de diffusion probabiliste pour échantillonner ces styles de parole ou variables aléatoires, permettant ainsi au framework StyleTTS2 de synthétiser efficacement une parole réaliste sans utiliser d'entrées audio de référence. Le framework StyleTTS2 utilise la diffusion de styles et les discriminateurs SLM. pour atteindre des performances de niveau humain sur les tâches de synthèse vocale, et parvient à surpasser les cadres de pointe existants sur un large éventail de tâches vocales.