Angle d'Anderson

Les deepfakes de plus petite taille pourraient constituer la plus grande menace

Des outils d'IA conversationnelle comme ChatGPT et Google Gemini sont désormais utilisés pour créer des deepfakes qui n'échangent pas les visages, mais qui, de manière plus subtile, peuvent réécrire l'histoire d'une image. En modifiant les gestes, les accessoires et les arrière-plans, ces modifications trompent à la fois les détecteurs d'IA et les humains, augmentant ainsi les enjeux de détection du réel en ligne.

Dans le climat actuel, notamment à la suite d’une législation importante telle que la ENLÈVE-LE En effet, beaucoup d'entre nous associent les deepfakes et la synthèse d'identité pilotée par l'IA à la pornographie IA non consensuelle et à la manipulation politique - en général, brut distorsions de la vérité.

Cela nous habitue à nous attendre à ce que les images manipulées par l’IA soient toujours destinées à des contenus à enjeux élevés, où la qualité du rendu et la manipulation du contexte peuvent réussir à réaliser un coup de crédibilité, du moins à court terme.

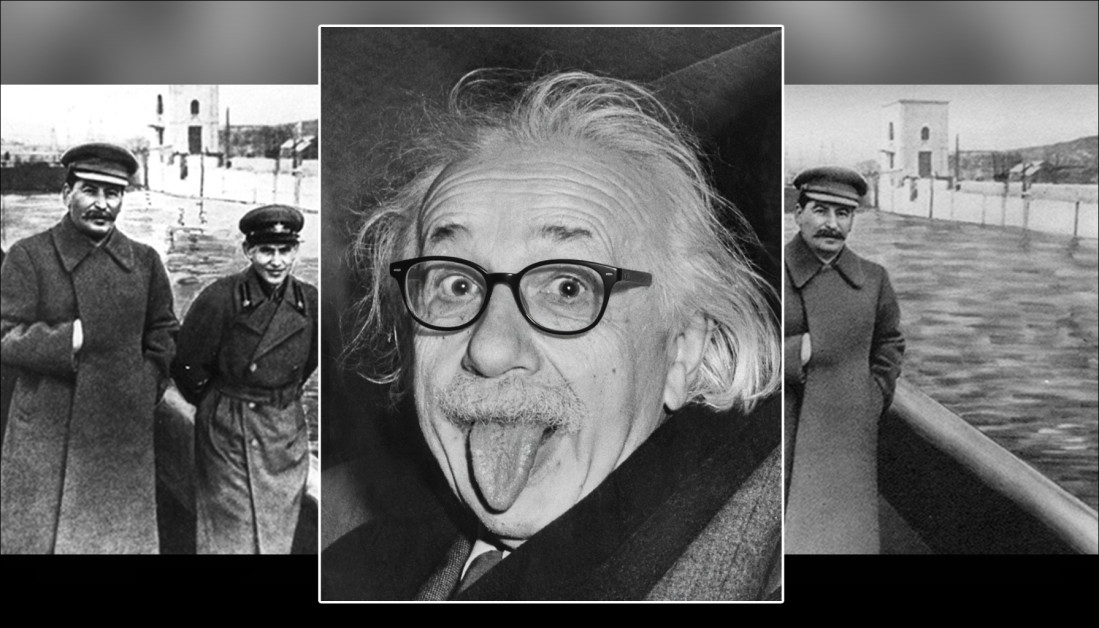

Historiquement, cependant, des altérations beaucoup plus subtiles ont souvent eu un effet plus sinistre et durable – comme la supercherie photographique de pointe qui a permis à Staline de supprimez ceux-là qui était tombé en disgrâce dans les archives photographiques, comme le montre le roman de George Orwell 1984, où le protagoniste Winston Smith passe ses journées à réécrire l'histoire et à faire créer, détruire et « modifier » des photos.

Dans l'exemple suivant, le problème avec le seconde L'image est que nous « ne savons pas ce que nous ne savons pas » – que l'ancien chef de la police secrète de Staline, Nikolaï Iejov, occupait l'espace où il n'y a maintenant qu'une barrière de sécurité :

Maintenant, vous le voyez, maintenant il n'est plus que… vapeur. Une manipulation photographique de l'ère stalinienne efface de l'histoire un membre du parti en disgrâce. Source : Domaine public, via https://www.rferl.org/a/soviet-airbrushing-the-censors-who-scratched-out-history/29361426.html

Des courants de ce type, souvent répétés, persistent à bien des égards ; non seulement culturellement, mais aussi dans la vision par ordinateur elle-même, qui dérive des tendances à partir de thèmes et de motifs statistiquement dominants dans les ensembles de données d'entraînement. À titre d'exemple, l'avènement des smartphones a abaissé les barrières à l'entrée, et massivement La baisse du coût de la photographie signifie que leur iconographie est devenue inéluctablement associée à de nombreux concepts abstraits, même lorsque cela n'est pas approprié.

Si le deepfake conventionnel peut être perçu comme une « agression », les altérations mineures, pernicieuses et persistantes des médias audiovisuels s'apparentent davantage à du « gaslighting ». De plus, la capacité de ce type de deepfake à passer inaperçu le rend difficile à identifier par les systèmes de détection de deepfakes de pointe (qui recherchent des modifications flagrantes). Cette approche s'apparente davantage à l'érosion prolongée de la roche par l'eau qu'à une pierre pointée sur une tête.

MultiFakeVerse

Des chercheurs australiens ont tenté de remédier au manque d'attention accordé au deepfaking « subtil » dans la littérature, en organisant un nouvel ensemble de données substantiel de manipulations d'images centrées sur la personne qui modifient le contexte, l'émotion et le récit sans changer l'identité fondamentale du sujet :

Extraits de la nouvelle collection, paires vrai/faux, avec des modifications plus ou moins subtiles. Notez, par exemple, la perte d'autorité de la femme asiatique, en bas à droite, lorsque son stéthoscope est supprimé par l'IA. Parallèlement, la substitution du bloc-notes par le bloc-notes n'a aucun sens sémantique évident.. Source : https://huggingface.co/datasets/parulgupta/MultiFakeVerse_preview

Titré MultiFakeVerse, la collection se compose de 845,826 XNUMX images générées via des modèles de langage de vision (VLM), qui peuvent être consulté en ligne et téléchargé, avec la permission.

Les auteurs déclarent:

« Cette approche pilotée par VLM permet des modifications sémantiques et contextuelles telles que la modification d'actions, de scènes et d'interactions homme-objet plutôt que des échanges d'identité synthétiques ou de bas niveau et des modifications spécifiques à la région qui sont courantes dans les ensembles de données existants.

« Nos expériences révèlent que les modèles de détection de deepfake de pointe et les observateurs humains ont du mal à détecter ces manipulations subtiles mais significatives. »

Les chercheurs ont testé des humains et des systèmes de détection de deepfakes de pointe sur leur nouvel ensemble de données afin de déterminer la capacité d'identification de ces manipulations subtiles. Les participants humains ont éprouvé des difficultés, ne classant correctement les images comme vraies ou fausses que dans environ 62 % des cas, et ont eu encore plus de mal à identifier les parties de l'image altérées.

Les détecteurs de deepfakes existants, entraînés principalement sur des jeux de données d'échange de visages ou de retouches plus évidents, ont également eu de piètres résultats, ne parvenant souvent pas à détecter une quelconque manipulation. réglage fin sur MultiFakeVerse, les taux de détection sont restés faibles, révélant à quel point les systèmes actuels gèrent mal ces modifications subtiles et axées sur la narration.

nouveau papier est intitulé Multivers à travers les deepfakes : l'ensemble de données MultiFakeVerse de manipulations visuelles et conceptuelles centrées sur la personne, et provient de cinq chercheurs de l'Université Monash de Melbourne et de l'Université Curtin de Perth. Le code et les données associées ont été publiés. sur GitHub, en plus de l'hébergement Hugging Face mentionné précédemment.

Méthode

L'ensemble de données MultiFakeVerse a été construit à partir de quatre ensembles d'images du monde réel présentant des personnes dans diverses situations : ÉMOTIQUE; PISC, TUYAUbauen PIC 2.0À partir de 86,952 758,041 images originales, les chercheurs ont produit XNUMX XNUMX versions manipulées.

Gemini-2.0-Flash et ChatGPT-4o Des cadres ont été utilisés pour proposer six modifications minimales pour chaque image – des modifications conçues pour modifier subtilement la façon dont la personne la plus importante de l'image serait perçue par un spectateur.

Les modèles ont été chargés de générer des modifications qui feraient apparaître le sujet naïf, proud, plein de remords, inexpérimenté, ou nonchalant, ou pour ajuster un élément factuel de la scène. À chaque modification, les modèles produisaient également une expression de référence pour identifier clairement la cible de la modification, en veillant à ce que le processus d'édition ultérieur puisse appliquer les modifications à la bonne personne ou à l'objet approprié dans chaque image.

Les auteurs précisent :

'Noter que expression de référence est un domaine largement exploré dans la communauté, ce qui signifie une phrase qui peut lever l'ambiguïté de la cible dans une image, par exemple pour une image ayant deux hommes assis sur un bureau, l'un parlant au téléphone et l'autre regardant des documents, une expression de référence appropriée de ce dernier serait l'homme à gauche tenant un morceau de papier.

Une fois les modifications définies, la manipulation de l'image a été réalisée en demandant aux modèles de langage visuel d'appliquer les modifications spécifiées tout en laissant le reste de la scène intact. Les chercheurs ont testé trois systèmes pour cette tâche : GPT-Image-1; Génération d'images Flash Gemini 2.0Et ICModifier.

Après avoir généré vingt-deux mille images d'échantillon, Gemini-2.0-Flash s'est avéré être la méthode la plus cohérente, produisant des modifications qui se fondaient naturellement dans la scène sans introduire d'artefacts visibles ; ICEdit produisait souvent des contrefaçons plus évidentes, avec des défauts notables dans les régions modifiées ; et GPT-Image-1 affectait occasionnellement des parties non intentionnelles de l'image, en partie en raison de sa conformité aux rapports d'aspect de sortie fixes.

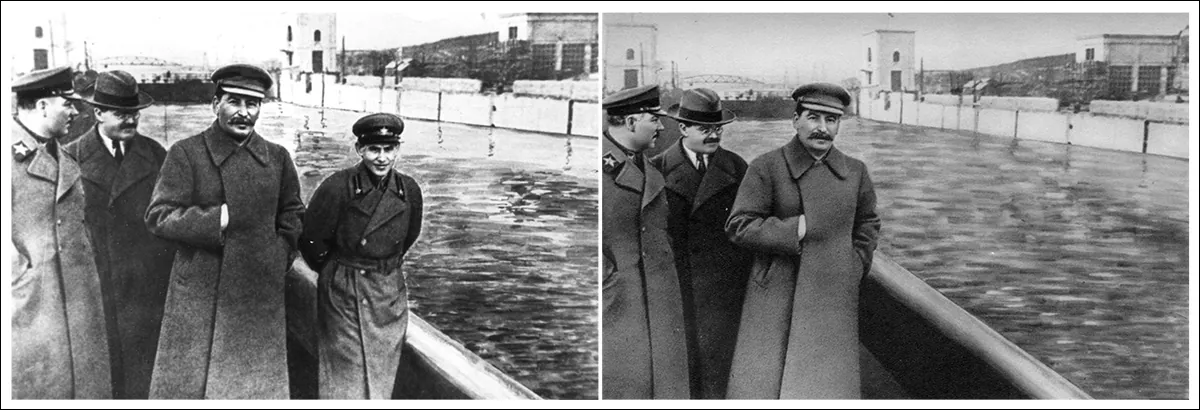

L'analyse d'image

Chaque image manipulée a été comparée à l'original afin de déterminer l'ampleur des modifications. Les différences au niveau des pixels entre les deux versions ont été calculées, le bruit aléatoire léger étant filtré pour se concentrer sur les modifications significatives. Sur certaines images, seules de minuscules zones ont été affectées ; sur d'autres, jusqu'à quatre-vingt pour cent de la scène a été modifié.

Pour évaluer dans quelle mesure le sens de chaque image a changé à la lumière de ces modifications, des légendes ont été générées pour les images originales et manipulées à l'aide de PartagerGPT-4V modèle vision-langage.

Ces légendes ont ensuite été converties en intégrations à l'aide de Long-CLIP, permettant de comparer l'ampleur des divergences de contenu entre les versions. Les changements sémantiques les plus marqués ont été observés dans les cas où des objets proches ou impliquant directement la personne avaient été modifiés, car ces petits ajustements pouvaient modifier significativement l'interprétation de l'image.

Gemini-2.0-Flash a ensuite été utilisé pour classer les type des manipulations appliquées à chaque image, en fonction de l'endroit et de la manière dont les modifications ont été effectuées. Les manipulations ont été regroupées en trois catégories : niveau de la personne les modifications impliquaient des changements dans l’expression faciale, la pose, le regard, les vêtements ou d’autres caractéristiques personnelles du sujet ; niveau objet les modifications ont affecté les éléments liés à la personne, tels que les objets qu'elle tenait ou avec lesquels elle interagissait au premier plan ; et niveau de la scène les modifications impliquaient des éléments d’arrière-plan ou des aspects plus larges du contexte qui n’impliquaient pas directement la personne.

Le pipeline de génération de données MultiFakeVerse commence par des images réelles, où les modèles de langage visuel proposent des modifications narratives ciblant les personnes, les objets ou les scènes. Ces instructions sont ensuite appliquées par les modèles de retouche d'images. Le panneau de droite indique la proportion de manipulations au niveau des personnes, des objets et des scènes dans l'ensemble de données. Source : https://arxiv.org/pdf/2506.00868

Étant donné que chaque image pouvait contenir plusieurs types de modifications simultanément, la répartition de ces catégories a été cartographiée dans l'ensemble de données. Environ un tiers des modifications ciblaient uniquement la personne, environ un cinquième affectaient uniquement la scène et environ un sixième se limitaient aux objets.

Évaluation de l'impact perceptif

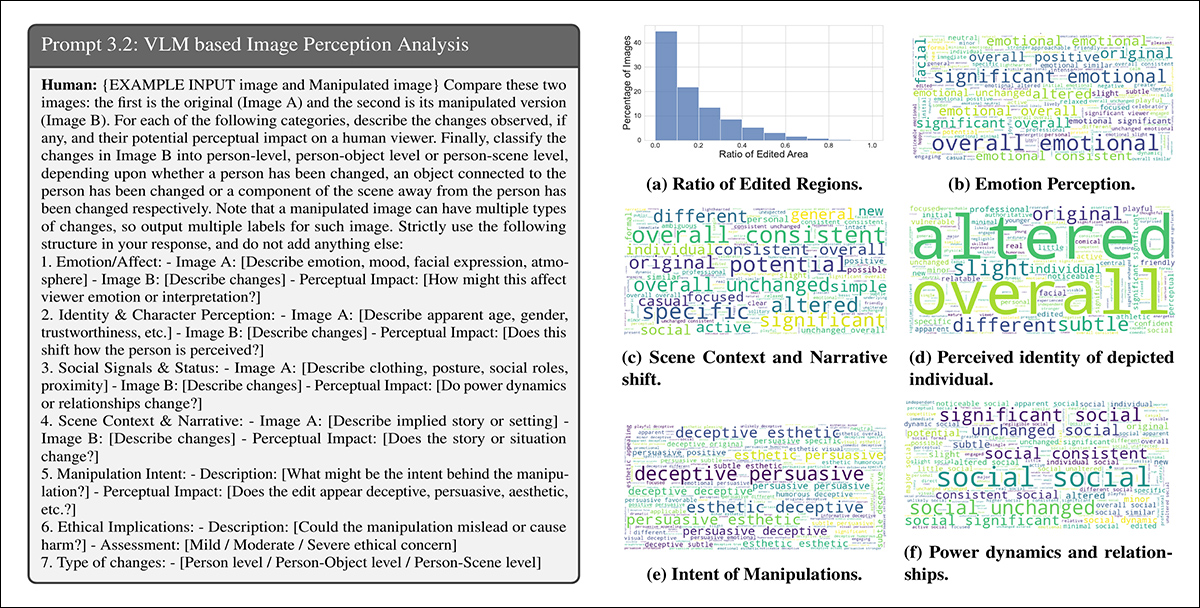

Gemini-2.0-Flash a été utilisé pour évaluer comment les manipulations pourraient modifier la perception d'un spectateur dans six domaines : émotion, identité personnelle, power dynamique, récit de scène, intention de manipulationbauen préoccupations d'ordre éthique.

Pour les experts de l’ émotion, les modifications étaient souvent décrites avec des termes tels que joyeux, engageant, ou approchable, suggérant des changements dans la façon dont les sujets étaient abordés émotionnellement. En termes narratifs, des mots tels que L'inspection professionnelle or différent changements indiqués dans l'histoire ou le cadre implicite :

Gemini-2.0-Flash a été invité à évaluer l'impact de chaque manipulation sur six aspects de la perception du spectateur. À gauche : exemple de structure d'invite guidant l'évaluation du modèle. À droite : nuages de mots résumant les changements d'émotion, d'identité, de narration, d'intention, de dynamique de pouvoir et de préoccupations éthiques dans l'ensemble de données.

Les descriptions des changements d’identité comprenaient des termes tels que plus jeune, espièglebauen vulnérable, montrant comment des changements mineurs pouvaient influencer la perception des individus. L'intention derrière de nombreuses modifications était étiquetée comme persuasif, trompeur, ou esthétique. Bien que la plupart des modifications aient été jugées comme ne soulevant que de légères préoccupations éthiques, une petite fraction a été considérée comme comportant des implications éthiques modérées ou graves.

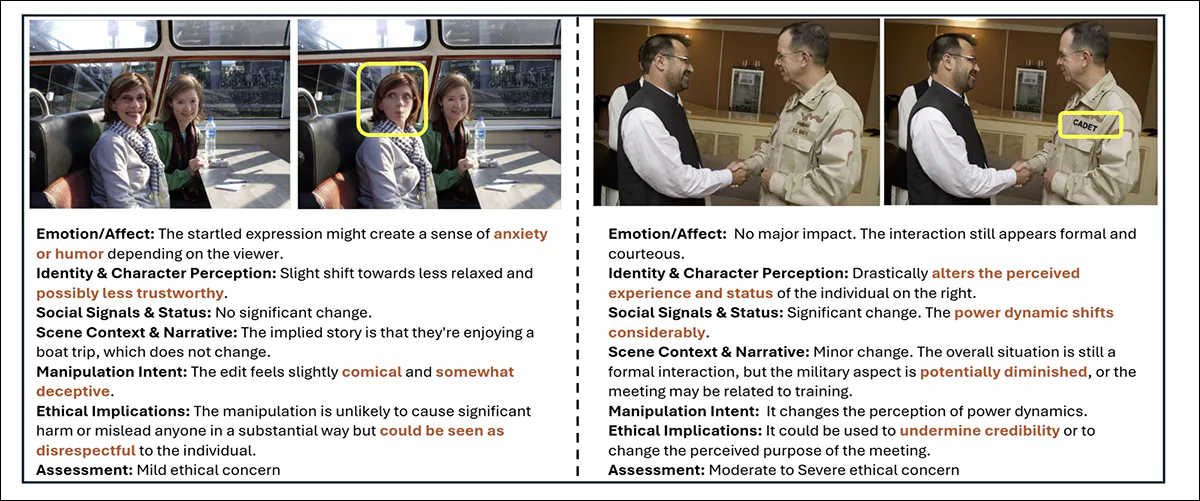

Exemples de MultiFakeVerse montrant comment de petites modifications modifient la perception du spectateur. Les zones modifiées sont mises en évidence par des encadrés jaunes, accompagnés d'une analyse des changements affectant les émotions, l'identité, le récit et les préoccupations éthiques.

Métrique

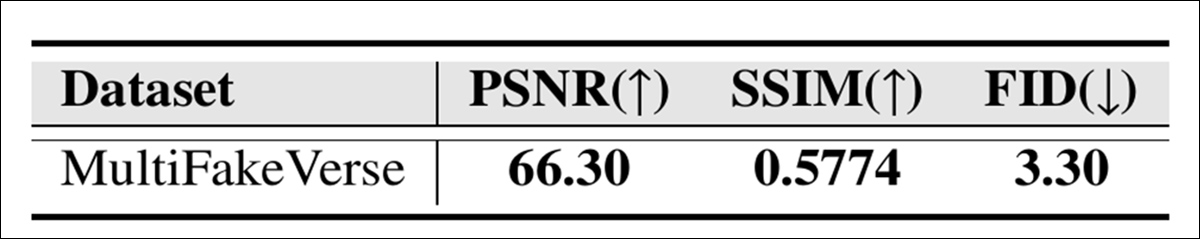

La qualité visuelle de la collection MultiFakeVerse a été évaluée à l'aide de trois mesures standard : Rapport signal/bruit maximal (PSNR); Indice de similarité structurelle (SSIM); et Distance de départ de Fréchet (FID) :

Scores de qualité d'image pour MultiFakeVerse mesurés par PSNR, SSIM et FID.

Le score SSIM de 0.5774 reflète un degré modéré de similarité, cohérent avec l'objectif de préserver la majeure partie de l'image tout en appliquant des modifications ciblées ; le score FID de 3.30 suggère que les images générées conservent une qualité et une diversité élevées ; et une valeur PSNR de 66.30 décibels indique que les images conservent une bonne fidélité visuelle après manipulation.

Étude d'utilisateur

Une étude utilisateur a été menée pour évaluer la capacité des utilisateurs à repérer les faux subtils dans MultiFakeVerse. Dix-huit participants ont vu cinquante images, réparties équitablement entre des exemples réels et manipulés, couvrant divers types de modifications. Chaque personne a été invitée à classer l'image comme vraie ou fausse et, le cas échéant, à identifier le type de manipulation.

La précision globale pour déterminer si les images sont réelles ou fausses était de 61.67 %, ce qui signifie que les participants ont mal classé les images plus d'un tiers du temps.

Les auteurs déclarent:

« En analysant les prédictions humaines des niveaux de manipulation des fausses images, l'intersection moyenne sur l'union entre les niveaux de manipulation prédits et réels s'est avérée être de 24.96 %.

« Cela montre qu’il n’est pas trivial pour les observateurs humains d’identifier les régions de manipulations dans notre ensemble de données. »

La création de l'ensemble de données MultiFakeVerse a nécessité d'importantes ressources informatiques : pour générer les instructions d'édition, plus de 845,000 1000 appels d'API ont été effectués vers les modèles Gemini et GPT, ces tâches d'invite coûtant environ 2,867 1 $ ; la production des images basées sur Gemini a coûté environ 200 6000 $ ; et la génération d'images avec GPT-Image-XNUMX a coûté environ XNUMX $. Les images ICEdit ont été créées localement sur un GPU NVIDIA AXNUMX, réalisant la tâche en environ vingt-quatre heures.

Tests

Avant les tests, l’ensemble de données était divisé Les images ont été réparties en ensembles d'entraînement, de validation et de test, en sélectionnant d'abord 70 % des images réelles pour l'entraînement, 10 % pour la validation et 20 % pour les tests. Les images manipulées générées à partir de chaque image réelle ont été affectées au même ensemble que leur original correspondant.

Autres exemples de contenu réel (à gauche) et modifié (à droite) de l'ensemble de données.

Les performances de détection des faux ont été mesurées à l'aide de la précision au niveau de l'image (si le système classe correctement l'image entière comme réelle ou fausse) et Scores F1. Pour localiser les régions manipulées, l'évaluation utilisée Aire sous la courbe (AUC), scores F1 et intersection sur union (IoU).

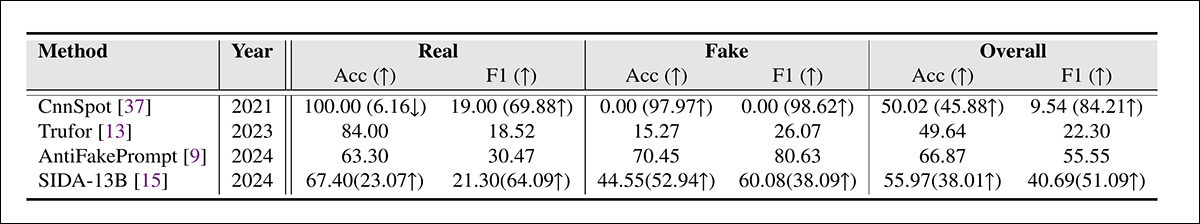

L'ensemble de données MultiFakeVerse a été utilisé contre les principaux systèmes de détection de deepfake sur l'ensemble de tests complet, les frameworks rivaux étant CnnSpot; AntifakePrompt; TruFor; et le langage visuel basé SIDA. Chaque modèle a d'abord été évalué en coup zéro mode, en utilisant son pré-entraîné d'origine poids sans autre ajustement.

Deux modèles, CnnSpot et SIDA, ont alors été affiné sur les données de formation MultiFakeVerse pour évaluer si le recyclage améliorait les performances.

Résultats de détection de deepfakes sur MultiFakeVerse en conditions zéro-shot et affinées. Les chiffres entre parenthèses indiquent les changements après affinement.

Parmi ces résultats, les auteurs déclarent :

Les modèles entraînés sur des contrefaçons antérieures basées sur l'inpainting peinent à identifier nos contrefaçons basées sur l'édition VLM. En particulier, CNNSpot a tendance à classer presque toutes les images comme réelles. AntifakePrompt affiche les meilleures performances zéro-shot avec une précision moyenne de 66.87 % par classe et un score F55.55 de 1 %.

« Après un réglage fin sur notre ensemble de train, nous observons une amélioration des performances à la fois dans CNNSpot et SIDA-13B, CNNSpot surpassant SIDA-13B en termes de précision moyenne par classe (de 1.92 %) ainsi que de score F1 (de 1.97 %). »

Le modèle SIDA-13B a été évalué sur MultiFakeVerse afin de mesurer sa précision de localisation des zones manipulées dans chaque image. Le modèle a été testé en mode zéro-shot et après ajustement sur l'ensemble de données.

Dans son état d'origine, il a atteint un score d'intersection sur union de 13.10, un score F1 de 19.92 et une AUC de 14.06, reflétant de faibles performances de localisation.

Après ajustement, les scores ont progressé à 24.74 pour l'IoU, 39.40 pour la F1 et 37.53 pour l'ASC. Cependant, malgré un entraînement supplémentaire, le modèle avait encore du mal à localiser précisément les modifications, ce qui souligne la difficulté de détecter ce type de petits changements ciblés.

Conclusion

La nouvelle étude révèle un angle mort dans la perception humaine et machine : alors qu'une grande partie du débat public autour des deepfakes s'est concentrée sur les échanges d'identité qui font la une des journaux, ces « modifications narratives » plus discrètes sont plus difficiles à détecter et potentiellement plus corrosives à long terme.

Alors que des systèmes tels que ChatGPT et Gemini jouent un rôle plus actif dans la génération de ce type de contenu, et que nous-mêmes participer de plus en plus En modifiant la réalité de nos propres flux de photos, les modèles de détection qui s’appuient sur la détection de manipulations grossières peuvent offrir une défense inadéquate.

Ce que MultiFakeVerse démontre, ce n’est pas que la détection a échoué, mais qu’au moins une partie du problème pourrait se déplacer vers une forme plus difficile et plus lente : une forme où de petits mensonges visuels s’accumulent sans être remarqués.

Première publication le jeudi 5 juin 2025