Angle d'Anderson

Près de 80 % des ensembles de données de formation peuvent constituer un risque juridique pour l'IA d'entreprise

Un article récent de LG AI Research suggère que les ensembles de données soi-disant « ouverts » utilisés pour la formation des modèles d'IA peuvent offrir un faux sentiment de sécurité – constatant que près de quatre ensembles de données d'IA sur cinq étiquetés comme « commercialement utilisables » contiennent en réalité des risques juridiques cachés.

Ces risques vont de l'inclusion de contenus protégés par des droits d'auteur non divulgués à des conditions de licence restrictives profondément ancrées dans les dépendances d'un ensemble de données. Si les conclusions de l'étude sont exactes, les entreprises qui s'appuient sur des ensembles de données publics pourraient devoir reconsidérer leurs pipelines d'IA actuels, sous peine de poursuites judiciaires en aval.

Les chercheurs proposent une solution radicale et potentiellement controversée : des agents de conformité basés sur l’IA capables d’analyser et d’auditer l’historique des ensembles de données plus rapidement et avec plus de précision que les avocats humains.

Le papier déclare:

« Cet article soutient que le risque juridique des ensembles de données de formation de l'IA ne peut pas être déterminé uniquement en examinant les conditions de licence au niveau de la surface ; une analyse approfondie de bout en bout de la redistribution des ensembles de données est essentielle pour garantir la conformité.

« Étant donné que ces analyses dépassent les capacités humaines en raison de leur complexité et de leur ampleur, les agents d’IA peuvent combler cette lacune en les effectuant avec plus de rapidité et de précision. Sans automatisation, les risques juridiques critiques restent largement ignorés, ce qui compromet le développement éthique de l’IA et le respect de la réglementation. »

« Nous exhortons la communauté de recherche en IA à reconnaître l’analyse juridique de bout en bout comme une exigence fondamentale et à adopter des approches basées sur l’IA comme voie viable vers la conformité des ensembles de données évolutifs. »

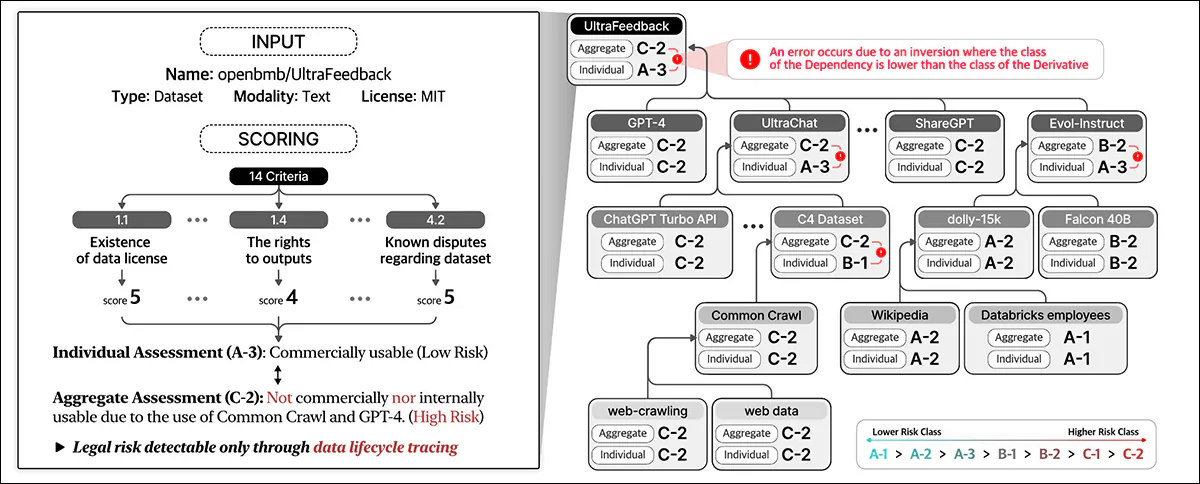

En examinant 2,852 605 ensembles de données populaires qui semblaient commercialement utilisables en fonction de leurs licences individuelles, le système automatisé des chercheurs a constaté que seulement 21 (environ XNUMX %) étaient réellement légalement sûrs pour la commercialisation une fois que tous leurs composants et dépendances avaient été tracés.

Quand vous vous déconnectez, votre profil nouveau papier est intitulé Ne faites pas confiance aux licences que vous voyez : la conformité des ensembles de données nécessite un traçage du cycle de vie à grande échelle alimenté par l'IA, et provient de huit chercheurs de LG AI Research.

Droits et torts

Les auteurs soulignent les globaux Les entreprises qui progressent dans le développement de l'IA dans un paysage juridique de plus en plus incertain sont confrontées à des défis de plus en plus complexes, alors que l'ancienne mentalité académique d'« utilisation équitable » autour de la formation aux ensembles de données cède la place à un environnement fracturé où les protections juridiques ne sont pas claires et où la sphère de sécurité n'est plus garantie.

En tant que publication unique a souligné Récemment, les entreprises sont devenues de plus en plus sur la défensive quant aux sources de leurs données de formation. Commentaires de l'auteur Adam Buick* :

« [Alors que] OpenAI a dévoilé les principales sources de données pour GPT-3, le document présentant GPT-4 révélé seulement que les données sur lesquelles le modèle avait été formé étaient un mélange de « données accessibles au public (telles que les données Internet) et de données sous licence de fournisseurs tiers ».

« Les motivations derrière cet éloignement de la transparence n'ont pas été articulées de manière particulièrement détaillée par les développeurs d'IA, qui dans de nombreux cas n'ont donné aucune explication.

« De son côté, OpenAI a justifié sa décision de ne pas divulguer davantage de détails concernant GPT-4 par des inquiétudes concernant « le paysage concurrentiel et les implications en matière de sécurité des modèles à grande échelle », sans autre explication dans le rapport. »

La transparence peut être un terme fallacieux – ou tout simplement erroné ; par exemple, le produit phare d’Adobe Luciole Le modèle génératif, formé à partir de données de stock qu'Adobe avait le droit d'exploiter, était censé offrir aux clients des garanties quant à la légalité de leur utilisation du système. Plus tard, certains des preuves ont émergé que le pot de données Firefly s'était « enrichi » de données potentiellement protégées par le droit d'auteur provenant d'autres plateformes.

Comme nous l'avons discuté plus tôt cette semaine, des initiatives se multiplient pour garantir la conformité des licences dans les ensembles de données, notamment une qui ne récupérera que les vidéos YouTube avec des licences Creative Commons flexibles.

Le problème est que les licences elles-mêmes peuvent être erronées ou accordées par erreur, comme semble l’indiquer la nouvelle recherche.

Examen des ensembles de données open source

Il est difficile de développer un système d'évaluation tel que celui proposé par les auteurs dans un contexte en constante évolution. Par conséquent, l'article indique que le cadre de conformité des données NEXUS repose sur « divers précédents et fondements juridiques à ce stade ».

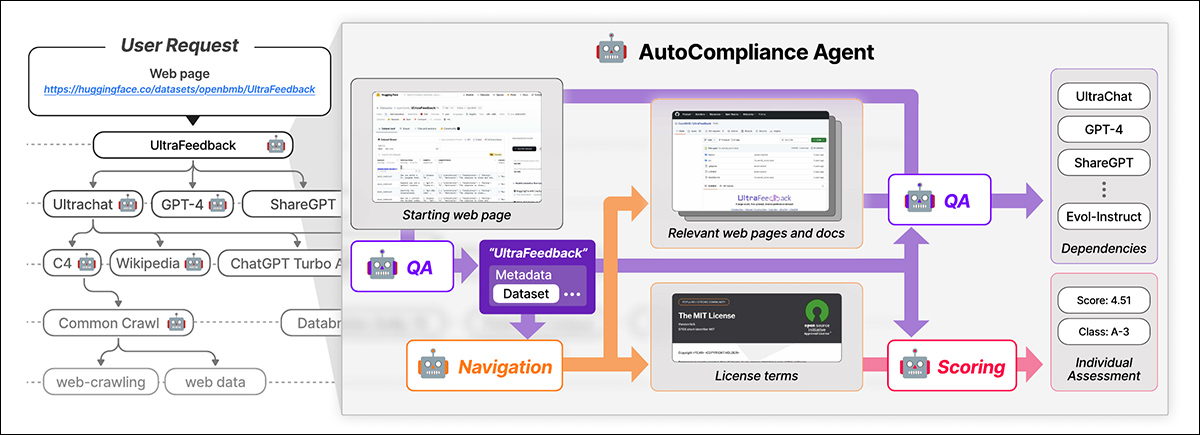

NEXUS utilise un agent piloté par l'IA appelé Auto-conformité pour la conformité automatisée des données. AutoCompliance comprend trois modules clés : un module de navigation pour l'exploration Web, un module de questions-réponses (QA) pour l'extraction d'informations et un module de notation pour l'évaluation des risques juridiques.

AutoCompliance commence par une page Web fournie par l'utilisateur. L'IA extrait les détails clés, recherche des ressources associées, identifie les conditions de licence et les dépendances et attribue un score de risque juridique. Source : https://arxiv.org/pdf/2503.02784

Ces modules sont alimentés par des modèles d'IA affinés, notamment EXAONE-3.5-32B-Instruct modèle, formé sur des données synthétiques et étiquetées par l'homme. AutoCompliance utilise également une base de données pour la mise en cache des résultats afin d'améliorer l'efficacité.

AutoCompliance démarre avec une URL de jeu de données fournie par l'utilisateur et la traite comme l'entité racine, en recherchant ses conditions de licence et ses dépendances, et en traçant de manière récursive les jeux de données liés pour créer un graphique de dépendance de licence. Une fois toutes les connexions mappées, il calcule les scores de conformité et attribue des classifications de risque.

Le cadre de conformité des données décrit dans le nouveau travail identifie divers† types d'entités impliqués dans le cycle de vie des données, y compris ensembles de données, qui constituent l’essentiel des données d’entrée pour la formation de l’IA ; logiciels de traitement de données et modèles d'IA, qui sont utilisés pour transformer et utiliser les données ; et Fournisseurs de services de plateforme, qui facilitent le traitement des données.

Le système évalue de manière holistique les risques juridiques en prenant en compte ces différentes entités et leurs interdépendances, allant au-delà de l'évaluation par cœur des licences des ensembles de données pour inclure un écosystème plus large des composants impliqués dans le développement de l'IA.

Data Compliance évalue le risque juridique tout au long du cycle de vie des données. Il attribue des scores en fonction des détails de l'ensemble de données et de 14 critères, en classant les entités individuelles et en agrégeant les risques sur l'ensemble des dépendances.

Formation et mesures

Les auteurs ont extrait les URL des 1,000 216 ensembles de données les plus téléchargés sur Hugging Face, en sous-échantillonnant aléatoirement XNUMX éléments pour constituer un ensemble de test.

Le modèle EXAONE était affiné sur l'ensemble de données personnalisé des auteurs, avec le module de navigation et le module de questions-réponses utilisant données synthétiqueset le module de notation utilisant des données étiquetées par l'homme.

Les étiquettes de vérité fondamentale ont été créées par cinq experts juridiques formés pendant au moins 31 heures à des tâches similaires. Ces experts humains ont identifié manuellement les dépendances et les conditions de licence pour 216 cas de test, puis ont agrégé et affiné leurs conclusions par le biais de discussions.

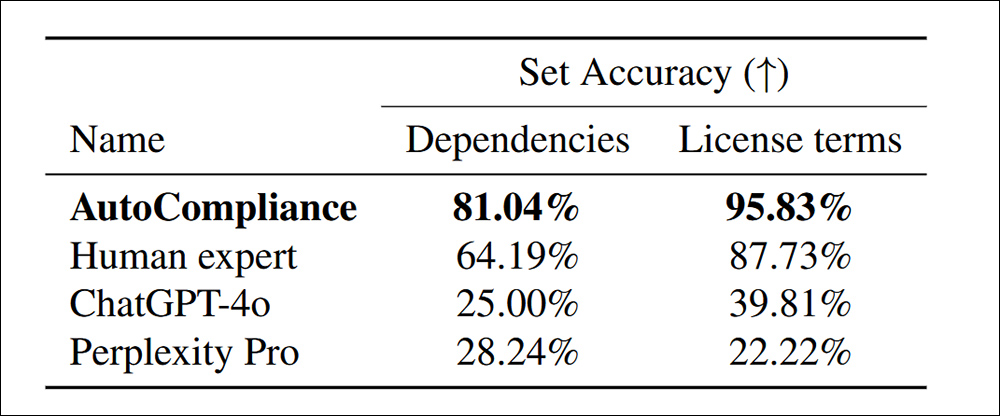

Avec le système AutoCompliance formé et calibré par l'homme, testé contre ChatGPT-4o et Perplexité Pro, notablement plus de dépendances ont été découvertes dans les termes de la licence :

Précision dans l’identification des dépendances et des conditions de licence pour 216 ensembles de données d’évaluation.

Le papier déclare:

« L'AutoCompliance surpasse considérablement tous les autres agents et experts humains, atteignant une précision de 81.04 % et 95.83 % dans chaque tâche. En revanche, ChatGPT-4o et Perplexity Pro affichent une précision relativement faible pour les tâches Source et Licence, respectivement.

« Ces résultats soulignent les performances supérieures de l'AutoCompliance, démontrant son efficacité dans la gestion des deux tâches avec une précision remarquable, tout en indiquant également un écart de performance substantiel entre les modèles basés sur l'IA et les experts humains dans ces domaines. »

En termes d’efficacité, l’approche AutoCompliance n’a pris que 53.1 secondes à exécuter, contre 2,418 XNUMX secondes pour une évaluation humaine équivalente sur les mêmes tâches.

De plus, l’évaluation a coûté 0.29 USD, contre 207 USD pour les experts humains. Il convient toutefois de noter que ce chiffre est basé sur la location mensuelle d’un nœud GCP a2-megagpu-16gpu à un tarif de 14,225 XNUMX USD par mois, ce qui signifie que ce type de rentabilité est principalement lié à une opération à grande échelle.

Enquête sur les ensembles de données

Pour l'analyse, les chercheurs ont sélectionné 3,612 3,000 ensembles de données combinant les 612 2023 ensembles de données les plus téléchargés de Hugging Face avec XNUMX ensembles de données de XNUMX Initiative sur la provenance des données.

Le papier déclare:

« À partir des 3,612 17,429 entités cibles, nous avons identifié un total de 13,817 XNUMX entités uniques, dont XNUMX XNUMX entités apparaissaient comme dépendances directes ou indirectes des entités cibles.

« Pour notre analyse empirique, nous considérons qu'une entité et son graphique de dépendance de licence ont une structure à une seule couche si l'entité n'a aucune dépendance et une structure à plusieurs couches si elle a une ou plusieurs dépendances.

« Sur les 3,612 2,086 ensembles de données cibles, 57.8 1,526 (42.2 %) avaient des structures multicouches, tandis que les XNUMX XNUMX autres (XNUMX %) avaient des structures monocouches sans dépendances. »

Les ensembles de données protégés par le droit d'auteur ne peuvent être redistribués qu'avec une autorisation légale, qui peut provenir d'une licence, d'exceptions à la loi sur le droit d'auteur ou de clauses contractuelles. Une redistribution non autorisée peut entraîner des conséquences juridiques, notamment une violation du droit d'auteur ou des violations de contrat. Il est donc essentiel d'identifier clairement les cas de non-conformité.

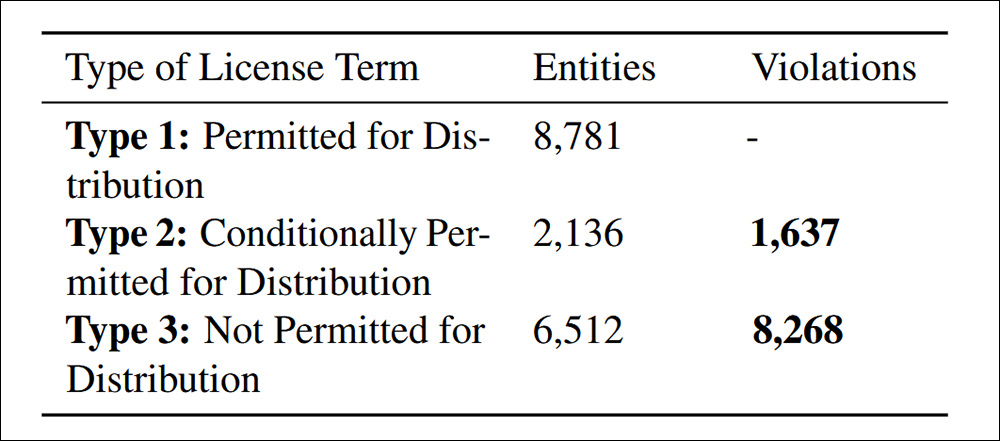

Des violations de distribution ont été constatées conformément au critère 4.4 de conformité des données cité dans le document.

L'étude a révélé 9,905 83.5 cas de redistribution non conforme d'ensembles de données, répartis en deux catégories : 16.5 % étaient explicitement interdits par les conditions de licence, ce qui faisait de la redistribution une violation légale claire ; et XNUMX % impliquaient des ensembles de données avec des conditions de licence contradictoires, où la redistribution était autorisée en théorie mais ne respectait pas les conditions requises, créant un risque juridique en aval.

Les auteurs admettent que les critères de risque proposés dans NEXUS ne sont pas universels et peuvent varier selon la juridiction et l’application de l’IA, et que les améliorations futures devraient se concentrer sur l’adaptation à l’évolution des réglementations mondiales tout en affinant l’examen juridique piloté par l’IA.

Conclusion

Il s’agit d’un document prolixe et largement hostile, mais il aborde peut-être le plus grand facteur retardant dans l’adoption actuelle de l’IA par l’industrie – la possibilité que des données apparemment « ouvertes » soient plus tard revendiquées par diverses entités, individus et organisations.

En vertu du DMCA, les violations peuvent légalement entraîner des amendes massives. par cas Lorsque les violations peuvent atteindre des millions de dollars, comme dans les cas découverts par les chercheurs, la responsabilité juridique potentielle est véritablement importante.

De plus, les entreprises dont on peut prouver qu’elles ont bénéficié des données en amont ne peuvent pas (comme d'habitude) invoquent l'ignorance comme excuse, du moins sur le marché influent des États-Unis. Ils ne disposent pas non plus actuellement d'outils réalistes leur permettant de pénétrer les implications labyrinthiques enfouies dans des accords de licence de jeux de données soi-disant open source.

Le problème de la formulation d’un système tel que NEXUS est qu’il serait déjà assez difficile de le calibrer sur une base étatique aux États-Unis, ou nationale au sein de l’UE ; la perspective de créer un cadre véritablement mondial (une sorte d’« Interpol pour la provenance des ensembles de données ») est compromise non seulement par les motivations contradictoires des divers gouvernements impliqués, mais aussi par le fait que ces gouvernements et l’état de leurs lois actuelles à cet égard sont en constante évolution.

* Ma substitution d'hyperliens aux citations des auteurs.

† Six types sont prescrits dans le document, mais les deux derniers ne sont pas définis.

Première publication le vendredi 7 mars 2025