Intelligence Artificielle

GOTCHA– Un système CAPTCHA pour les deepfakes en direct

De nouvelles recherches de l'Université de New York s'ajoutent aux indications croissantes selon lesquelles nous pourrions bientôt devoir passer l'équivalent deepfake d'un « test d'ivresse » afin de nous authentifier, avant de commencer un appel vidéo sensible - comme une vidéoconférence professionnelle, ou tout autre scénario sensible susceptible d'attirer les fraudeurs. deepfake en temps réel logiciel de streaming.

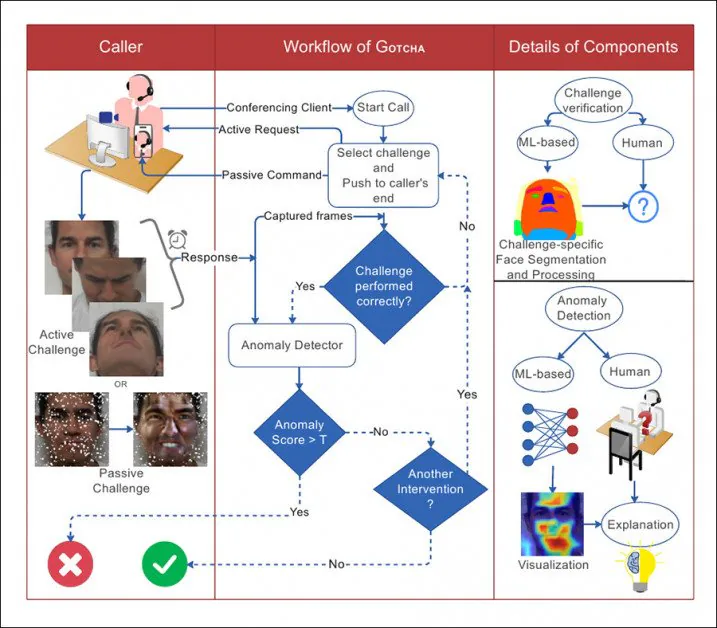

Certains défis actifs et passifs sont appliqués aux scénarios d'appel vidéo dans GOTCHA. L'utilisateur doit les relever et les réussir, tandis que d'autres méthodes « passives » (comme tenter de surcharger un système de deepfake potentiel) sont utilisées, sur lesquelles le participant n'a aucune influence. Source : http://export.arxiv.org/pdf/2210.06186

Le système proposé est intitulé GOTCHA - un hommage aux systèmes CAPTCHA qui sont devenus un obstacle croissant à la navigation sur le Web au cours des 10 à 15 dernières années, dans lequel les systèmes automatisés obligent l'utilisateur à effectuer des tâches pour lesquelles les machines sont mauvaises, telles que l'identification des animaux. ou déchiffrer un texte brouillé (et, ironiquement, ces défis tournent souvent l'utilisateur dans un libre AMT-style annotateur externalisé).

En substance, GOTCHA prolonge le mois d'août 2022 DF-Captcha article de l'Université Ben Gourion, qui a été le premier à proposer de faire sauter la personne à l'autre bout de l'appel à travers quelques cerceaux visuellement sémantiques afin de prouver son authenticité.

L'article d'août 2022 de l'Université Ben Gourion a proposé pour la première fois une gamme de tests interactifs pour un utilisateur, y compris l'occlusion de son visage, ou même la dépression de sa peau - des tâches que même des systèmes de deepfake en direct bien formés n'auraient peut-être pas anticipé ou ne pourraient pas faire face de manière photoréaliste. . Source : https://arxiv.org/pdf/2208.08524.pdf

Notamment, GOTCHA ajoute des méthodologies « passives » à une « cascade » de tests proposés, notamment la superposition automatique d'éléments irréels sur le visage de l'utilisateur et la « surcharge » d'images transitant par le système source. Cependant, seules les tâches réactives à l'utilisateur peuvent être évaluées sans autorisations spéciales d'accès au système local de l'utilisateur – qui, vraisemblablement, prendraient la forme de modules locaux ou d'extensions pour des systèmes populaires tels que Skype et Zoom, voire d'un logiciel propriétaire dédié spécifiquement chargé d'éliminer les imposteurs.

De l'article, une illustration de l'interaction entre l'appelant et le système dans GOTCHA, avec des lignes pointillées comme flux de décision.

Les chercheurs ont validé le système sur un nouvel ensemble de données contenant plus de 2.5 millions d'images vidéo de 47 participants, chacun ayant relevé 13 défis de GOTCHA. Ils affirment que le système induit une réduction « constante et mesurable » de la qualité des contenus deepfake pour les utilisateurs frauduleux, mettant à rude épreuve le système local jusqu'à ce que des artefacts évidents rendent la tromperie évidente à l'œil nu (bien que GOTCHA intègre également des méthodes d'analyse algorithmique plus subtiles).

Le nouveau papier est intitulé Gotcha : un système de défi-réponse pour la détection de deepfake en temps réel (le nom du système est en majuscule dans le corps du texte mais pas le titre de la publication, bien qu'il ne s'agisse pas d'un acronyme).

Une gamme de défis

Conformément à l'article de Ben Gourion, les défis réels auxquels sont confrontés les utilisateurs sont divisés en plusieurs types de tâches.

Pour occlusion, l'utilisateur est obligé soit de masquer son visage avec sa main, soit avec d'autres objets, soit de présenter son visage sous un angle qui n'a probablement pas été formé dans un modèle deepfake (généralement en raison d'un manque de données de formation pour les poses « étranges » - voir la gamme d'images dans la première illustration ci-dessus).

Outre les actions que l'utilisateur peut effectuer lui-même conformément aux instructions, GOTCHA peut superposer des découpes faciales aléatoires, des autocollants et des filtres de réalité augmentée afin de « corrompre » le flux de visages attendu par un modèle deepfake local, entraînant ainsi son échec. Comme indiqué précédemment, bien que ce processus soit « passif » pour l'utilisateur, il est intrusif pour le logiciel, qui doit pouvoir intervenir directement dans le flux du correspondant final.

Ensuite, l'utilisateur peut être amené à poser son visage dans des expressions faciales inhabituelles qui sont susceptibles d'être absentes ou sous-représentées dans tout ensemble de données de formation, ce qui entraîne une baisse de la qualité de la sortie deepfaked (image « b », deuxième colonne à partir de la gauche, dans la première illustration ci-dessus).

Dans le cadre de ce volet de tests, l'utilisateur peut être amené à lire un texte ou à engager une conversation conçue pour défier un système local de deepfake en direct, qui n'a peut-être pas formé une gamme adéquate de phonèmes ou d'autres types de données buccales à un niveau où il peut reconstituer le mouvement précis des lèvres sous un tel examen.

Enfin (et cela semble mettre à l'épreuve les talents d'acteur du correspondant final), dans cette catégorie, l'utilisateur peut être invité à effectuer une « micro-expression » – une expression faciale brève et involontaire qui trahit une émotion. L'article précise à ce sujet. « [cela] dure généralement de 0.5 à 4.0 secondes et est difficile à simuler ».

Bien que l'article ne décrive pas comment extraire une micro-expression, la logique suggère que la seule façon de le faire est de créer une émotion appropriée chez l'utilisateur final, peut-être avec une sorte de contenu surprenant qui lui est présenté dans le cadre de la routine du test.

Distorsion faciale, éclairage et Invités inattendus

De plus, conformément aux suggestions du document d'août, le nouveau travail propose de demander à l'utilisateur final d'effectuer des distorsions et des manipulations faciales inhabituelles, telles que presser son doigt sur sa joue, interagir avec son visage et/ou ses cheveux, et effectuer d'autres mouvements qu'aucun système de deepfake en direct actuel n'est susceptible de pouvoir gérer correctement, car il s'agit d'actions marginales - même si elles étaient présentes dans l'ensemble de données de formation, leur reproduction serait probablement de faible qualité, conformément à d'autres données « aberrantes ».

Un sourire, mais ce « visage déprimé » n'est pas bien traduit par un système local de deepfake en direct.

Un défi supplémentaire réside dans la modification des conditions d'éclairage dans lesquelles se trouve l'utilisateur final, car il est possible que la formation d'un modèle deepfake ait été optimisée pour des situations d'éclairage de vidéoconférence standard, ou même pour les conditions d'éclairage exactes dans lesquelles l'appel se déroule.

Ainsi, l'utilisateur peut être invité à braquer la torche de son téléphone portable sur son visage ou à modifier l'éclairage d'une autre manière (et il convient de noter que cette tactique est la proposition centrale de un autre papier de détection de deepfake en direct sorti cet été).

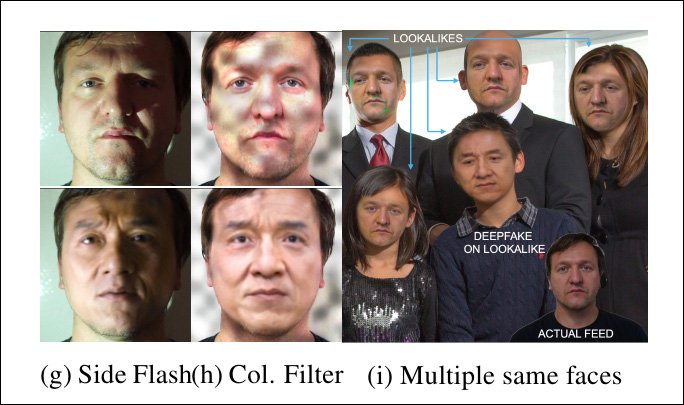

Les systèmes de deepfake en direct sont mis au défi par un éclairage inattendu – et même par plusieurs personnes dans le flux, alors qu'il n'attendait qu'un seul individu.

Dans le cas où le système proposé aurait la capacité de s'interposer dans le flux d'utilisateurs local (qui est soupçonné d'héberger un intermédiaire deepfake), l'ajout de modèles inattendus (voir la colonne du milieu dans l'image ci-dessus) peut compromettre la capacité de l'algorithme deepfake à maintenir une simulation.

De plus, bien qu'il ne soit pas raisonnable de s'attendre à ce qu'un correspondant ait des personnes supplémentaires à disposition pour l'aider à s'authentifier, le système peut interjecter des visages supplémentaires (image la plus à droite ci-dessus) et voir si un système deepfake local commet l'erreur de détourner l'attention - ou même d'essayer de les falsifier tous (les systèmes deepfake à auto-encodeur n'ont pas de capacités de « reconnaissance d'identité » qui pourraient maintenir l'attention concentrée sur un seul individu dans ce scénario).

Stéganographie et surcharge

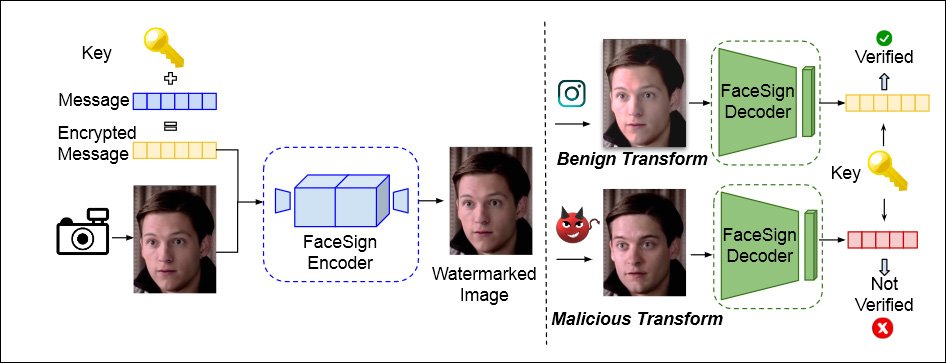

GOTCHA intègre également une approche premier proposé Créé par l'UC San Diego en avril dernier, ce logiciel utilise la stéganographie pour chiffrer un message dans le flux vidéo local de l'utilisateur. Les routines deepfake détruiront complètement ce message, entraînant un échec d'authentification.

D'après un article d'avril 2022 de l'Université de Californie à San Diego et de l'Université d'État de San Diego, une méthode permettant de déterminer l'identité authentique consiste à vérifier si un signal stéganographique envoyé dans le flux vidéo d'un utilisateur survit intact à la boucle locale - si ce n'est pas le cas, une supercherie de deepfaking peut être à portée de main. Source : https://arxiv.org/pdf/2204.01960.pdf

De plus, GOTCHA est capable de surcharger le système local (accès et autorisation donnés), en dupliquant un flux et en présentant des données « excessives » à n'importe quel système local, conçu pour provoquer un échec de réplication dans un système deepfake local.

Le système contient d'autres tests (voir l'article pour plus de détails), y compris un défi, dans le cas d'un correspondant sur smartphone, de retourner son téléphone, ce qui déformera un système deepfake local :

Encore une fois, ce genre de chose ne fonctionnerait qu'avec un cas d'utilisation convaincant, où l'utilisateur est obligé d'accorder un accès local au flux, et ne peut pas être mis en œuvre par une simple évaluation passive de la vidéo de l'utilisateur, contrairement aux tests interactifs (comme appuyer un doigt sur son visage).

Praticité

Le document aborde brièvement la mesure dans laquelle des tests de cette nature peuvent gêner l'utilisateur final, ou bien le gêner d'une manière ou d'une autre - par exemple, en obligeant l'utilisateur à avoir à portée de main un certain nombre d'objets qui peuvent être nécessaires pour les tests, comme les lunettes de soleil.

Il reconnaît également qu'il peut être difficile d'amener des correspondants puissants à se conformer aux routines de test. En ce qui concerne le cas d'un appel vidéo avec un PDG, les auteurs déclarent :

« La convivialité est ici essentielle. Les défis informels ou futiles (comme les déformations ou les expressions faciales) peuvent donc être inappropriés. Les défis utilisant des objets physiques externes peuvent également être déconseillés. Le contexte est ici adapté en conséquence et GOTCHA adapte sa série de défis en conséquence. »

Données et tests

GOTCHA a été testé contre quatre souches de systèmes deepfakes locaux en direct, y compris deux variantes du très populaire créateur de deepfakes à encodeur automatique. Laboratoire DeepFace (« DFL », bien que, étonnamment, le document ne mentionne pas DeepFaceLive, qui a été, depuis août 2021, l'implémentation « en direct » de DeepFaceLab, et semble être la ressource initiale la plus probable pour un faussaire potentiel).

Les quatre systèmes ont été entraînés DFL « légèrement » sur une personne non célèbre participant à des tests et une célébrité appariée ; DFL a été entraîné plus complètement, sur plus de 2 millions d'itérations ou d'étapes, où l'on s'attendrait à un modèle beaucoup plus performant ; Animateur d'images latentes (LIA); et Réseau antagoniste génératif d'échange de visages (FSGAN).

Pour les données, les chercheurs ont capturé et organisé les clips vidéo susmentionnés, mettant en vedette 47 utilisateurs effectuant 13 défis actifs, chaque utilisateur produisant environ 5 à 6 minutes de vidéo 1080p à 60 ips. Les auteurs précisent également que ces données seront éventuellement rendues publiques.

La détection d'anomalies peut être effectuée soit par un observateur humain, soit par algorithme. Pour cette dernière option, le système a été entraîné sur 600 faces depuis le Ensemble de données FaceForensics. La fonction de perte de régression était le puissant Learned Perceptual Image Patch Similarity (LPIPS), tandis que l'entropie croisée binaire était utilisée pour former le classifieur. Caméra propre a été utilisé pour visualiser les poids du détecteur.

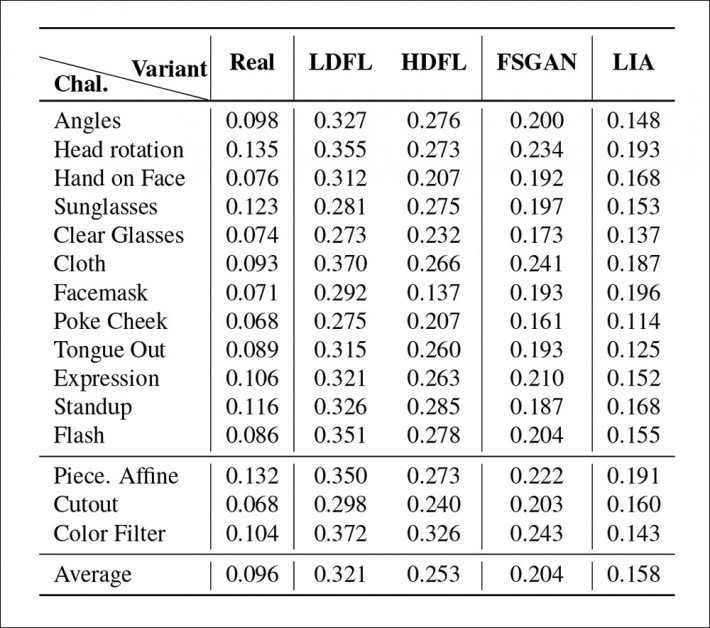

Principaux résultats des tests pour GOTCHA.

Les chercheurs ont découvert que pour la cascade complète de tests sur les quatre systèmes, le nombre et la gravité les plus faibles d'anomalies (c'est-à-dire d'artefacts révélant la présence d'un système deepfake) étaient obtenus par la distribution DFL la plus entraînée. La version moins entraînée a notamment eu du mal à recréer des mouvements de lèvres complexes (qui occupent très peu de cadre, mais qui reçoivent une grande attention humaine), tandis que FSGAN occupait le juste milieu entre les deux versions DFL, et LIA s'est avéré totalement inadéquat à la tâche. , les chercheurs estimant que LIA échouerait dans un déploiement réel.

Première publication le 17 octobre 2022.