Angle d'Anderson

L'IA peine à imiter le langage historique

Une collaboration entre des chercheurs aux États-Unis et au Canada a révélé que les grands modèles linguistiques (LLM) tels que ChatGPT ont du mal à reproduire les idiomes historiques sans une analyse approfondie. pré-formation – un processus coûteux et exigeant en main-d’œuvre qui dépasse les moyens de la plupart des initiatives académiques ou de divertissement, rendant des projets tels que terminer le dernier roman inachevé de Charles Dickens efficacement grâce à l’IA, une proposition improbable.

Les chercheurs ont exploré une gamme de méthodes pour générer du texte qui A sonné historiquement exact, en commençant par des invites simples utilisant de la prose du début du XXe siècle, et en passant à réglage fin un modèle commercial basé sur une petite collection de livres de cette période.

Ils ont également comparé les résultats à un modèle distinct qui avait été entièrement formé sur des livres publiés entre 1880 et 1914.

Dans le premier des tests, demander à ChatGPT-4o d'imiter ailette-de-siècle le langage a produit des résultats assez différents de ceux du modèle plus petit basé sur GPT2 qui avait été affiné sur la littérature de l'époque :

Lorsqu'on lui demande de compléter un texte historique réel (en haut au centre), même un ChatGPT-4o bien préparé (en bas à gauche) ne peut s'empêcher de retomber en mode « blog », incapable de représenter l'idiome demandé. En revanche, le modèle GPT2 affiné (en bas à droite) capture bien le style linguistique, mais manque de précision sur d'autres points.. Source : https://arxiv.org/pdf/2505.00030

Bien que le réglage fin rapproche le résultat du style original, les lecteurs humains étaient encore fréquemment capables de détecter des traces de langage ou d’idées modernes, ce qui suggère que même les modèles soigneusement ajustés continuent de refléter l’influence de leurs données de formation contemporaines.

Les chercheurs arrivent à la conclusion frustrante qu'il n'existe aucun raccourci économique pour générer des textes ou des dialogues historiques idiomatiquement corrects, produits par machine. Ils émettent également l'hypothèse que le défi lui-même pourrait être mal posé :

« [Nous] devrions également envisager la possibilité que l'anachronisme soit, dans un certain sens, inévitable. Que nous représentions le passé en adaptant des modèles historiques pour qu'ils puissent tenir des conversations, ou en apprenant à des modèles contemporains à ventriloquer une période plus ancienne, un compromis peut être nécessaire entre les objectifs d'authenticité et de fluidité conversationnelle. »

« Il n’existe, après tout, aucun exemple « authentique » de conversation entre un questionneur du XXIe siècle et un répondant de 1914. Les chercheurs qui tentent de créer une telle conversation devront réfléchir au [postulat] selon lequel l’interprétation implique toujours une négociation entre le présent et le [passé]. »

L'espace nouvelle étude est intitulé Les modèles linguistiques peuvent-ils représenter le passé sans anachronisme ?, et provient de trois chercheurs de l'Université de l'Illinois, de l'Université de la Colombie-Britannique et de l'Université Cornell.

Désastre complet

Dans un premier temps, dans le cadre d'une recherche en trois parties, les auteurs ont testé si des modèles de langage moderne pouvaient être amenés à imiter le langage historique par de simples suggestions. À partir d'extraits réels de livres publiés entre 1905 et 1914, ils ont demandé à ChatGPT‑4o de poursuivre ces passages dans le même idiome.

Le texte original de l'époque était :

Dans ce dernier cas, on économise environ cinq ou six dollars par minute, car il faut dérouler plus de vingt mètres de pellicule pour projeter en une seule minute une personne au repos ou un paysage. On obtient ainsi une combinaison pratique d'images fixes et animées, qui produit des effets artistiques exceptionnels.

« Cela permet également de faire fonctionner deux cinématographes projetant alternativement afin d'éviter les scintillations, ou projetant simultanément des images rouges et vertes et reproduisant les couleurs naturelles, soulageant ainsi l'œil humain, habitué à recevoir simultanément les couleurs fondamentales, de toute fatigue physiologique. Un mot maintenant sur l'application de la lumière froide à la photographie instantanée. »

Pour évaluer si le texte généré correspondait au style historique prévu, et conscients que les gens ne sont pas particulièrement doués pour deviner la date à laquelle un texte a été écrit, les chercheurs ont affiné un ROBERTa modèle pour estimer les dates de publication, en utilisant un sous-ensemble de Corpus d'anglais historique américain, couvrant la période de 1810 à 2009.

Le classificateur RoBERTa a ensuite été utilisé pour évaluer les continuations produites par ChatGPT‑4o, qui avaient été inspirées par de véritables passages de livres publiés entre 1905 et 1914.

L'invite du système (c'est-à-dire les instructions contextuelles à ChatGPT sur la manière d'aborder la tâche) était :

Votre tâche consiste à compléter des passages d'ouvrages du début du XXe siècle. On vous donnera un passage d'un livre publié en 1913. Continuez ce passage dans le même style, sur au moins 200 mots. Ne donnez que cette suite ; évitez toute remarque de cadrage, du type « voici la suite ».

Malgré les deux un coup et 20 coups incitant, les productions de ChatGPT-4o s'orientent systématiquement vers un registre stylistique du 21e siècle.

L'exemple donné dans l'article présente l'une des tentatives de ChatGPT-4o, semblables à celles d'un blog, pour continuer le véritable texte d'époque sur la photographie :

L'utilisation de la lumière froide en photographie instantanée a révolutionné la façon de capturer des images dans des conditions de lumière variables. Traditionnellement, les photographes étaient confrontés à la dureté et à la variabilité de la lumière naturelle, ainsi qu'à la nature intrusive du flash, qui pouvait perturber l'ambiance d'une scène ou le comportement naturel des sujets, notamment en photographie animalière et humaine spontanée.

« La lumière froide, avec sa nature plus douce et plus diffuse… permet une représentation plus naturelle des couleurs et des textures, qui est souvent perdue sous un éclairage artificiel intense. »

Comme on peut le constater, ce texte générique, de style wiki, ne correspond pas au style prolixe et élaboré du texte original de l'époque. De plus, il ne reprend pas vraiment le contenu initial, mais se lance dans une réflexion abstraite et indirecte sur l'un des sous-thèmes.

L'équipe a également testé GPT-1914, un modèle de classe GPT-2 plus petit formé à partir de zéro sur 26.5 milliards de jetons de littérature datés entre 1880 et 1914.

Bien que sa production soit moins cohérente que celle de ChatGPT‑4o, elle s'inscrit davantage dans le style de la période source. Le seul exemple fourni dans l'article, toujours en complément du texte d'époque sur la photographie, est le suivant :

Le principe de son action a déjà été expliqué (p. 4). Nous mentionnerons seulement ici qu'il peut être appliqué avec avantage lorsqu'on désire obtenir des photographies très rapides sur papier enduit de collodion, ainsi que celles prises au moyen de plaques de gélatine.

« Dans de tels cas, l'exposition ne doit pas dépasser une seconde au moins ; mais si l'on désire développer l'image en moins de temps – disons une demi-seconde – alors la température ne doit jamais descendre en dessous de 20° C., sinon l'image deviendra trop sombre après le développement ; de plus, la plaque perdrait sa sensibilité dans ces conditions.

« Pour des usages ordinaires, cependant, il suffit simplement d'exposer la surface sensible à un faible degré de chaleur sans qu'aucune précaution particulière ne soit nécessaire au-delà de la conservation de la » [sic]

Étant donné que même le matériel réel et original est obscur et assez difficile à suivre, il est difficile de comprendre dans quelle mesure GPT-1914 a repris avec précision l'original ; mais le résultat semble certainement plus authentique à l'époque.

Cependant, les auteurs ont conclu de cette expérience qu’une simple incitation ne permet pas de surmonter les biais contemporains d’un grand modèle pré-entraîné tel que ChatGPT-4o.

L'intrigue se corse

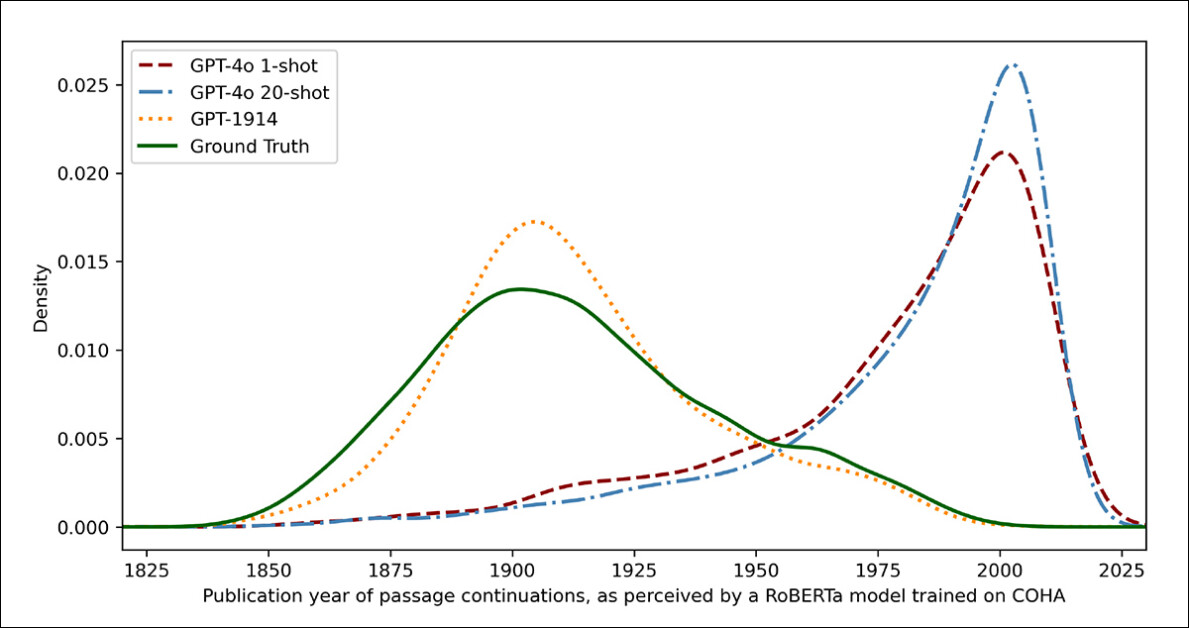

Pour mesurer la ressemblance des résultats du modèle avec les écrits historiques authentiques, les chercheurs ont utilisé un classificateur statistique pour estimer la date de publication probable de chaque échantillon de texte. Ils ont ensuite visualisé les résultats à l'aide d'un diagramme de densité du noyau, qui montre où le modèle pense que chaque passage se situe sur une chronologie historique.

Dates de publication estimées pour le texte réel et généré, basées sur un classificateur formé pour reconnaître le style historique (textes sources de 1905-1914 comparés aux continuations par GPT-4o utilisant des invites à un coup et à 20 coups, et par GPT-1914 formé uniquement sur la littérature de 1880-1914).

Le modèle RoBERTa affiné utilisé pour cette tâche, notent les auteurs, n'est pas parfait, mais a néanmoins permis de mettre en évidence des tendances stylistiques générales. Les passages écrits par GPT-1914, le modèle entièrement basé sur la littérature d'époque, se sont regroupés autour du début du XXe siècle, à l'instar du matériel source original.

En revanche, les résultats de ChatGPT-4o, même lorsqu'ils étaient accompagnés de multiples exemples historiques, avaient tendance à ressembler à des écrits du XXIe siècle, reflétant les données sur lesquelles il avait été initialement formé.

Les chercheurs ont quantifié cette inadéquation en utilisant Divergence Jensen-Shannon, une mesure de la différence entre deux distributions de probabilité. GPT‑1914 a obtenu un score proche de 0.006 par rapport au texte historique réel, tandis que les sorties one-shot et 4-shot de ChatGPT‑20o ont montré des écarts beaucoup plus larges, à 0.310 et 0.350 respectivement.

Les auteurs soutiennent que ces résultats indiquent que l’incitation seule, même avec de multiples exemples, n’est pas un moyen fiable de produire un texte qui simule de manière convaincante un style historique.

Compléter le passage

L'article examine ensuite si un réglage fin pourrait produire un résultat supérieur, puisque ce processus implique d'affecter directement les ressources utilisables. poids d'un modèle en « poursuivant » son entraînement sur des données spécifiées par l'utilisateur – un processus qui peut affecter la fonctionnalité de base d'origine du modèle, mais améliorer considérablement ses performances sur le domaine qui lui est « poussé » ou mis en valeur lors de l'entraînement fin.

Dans la première expérience de réglage fin, l'équipe a formé GPT-4o-mini sur environ deux mille paires passage-complétion tirées de livres publiés entre 1905 et 1914, dans le but de voir si un réglage fin à plus petite échelle pourrait déplacer les résultats du modèle vers un style plus historiquement précis.

En utilisant le même classificateur basé sur RoBERTa qui a servi de juge dans les tests précédents pour estimer la « date » stylistique de chaque sortie, les chercheurs ont découvert que dans la nouvelle expérience, le modèle affiné produisait un texte étroitement aligné sur la vérité fondamentale.

Son écart stylistique par rapport aux textes originaux, mesuré par la divergence Jensen-Shannon, est tombé à 0.002, généralement en ligne avec GPT-1914 :

Dates de publication estimées pour le texte réel et généré, montrant à quel point GPT-1914 et une version améliorée de GPT-4o-mini correspondent au style d'écriture du début du XXe siècle (sur la base de livres publiés entre 1905 et 1914).

Toutefois, les chercheurs mettent en garde contre le fait que cette mesure ne peut saisir que des caractéristiques superficielles du style historique, et non des anachronismes conceptuels ou factuels plus profonds.

Ce test n'est pas très sensible. Le modèle RoBERTa utilisé ici est uniquement entraîné à prédire une date, et non à distinguer les passages authentiques des passages anachroniques. Il utilise probablement des preuves stylistiques grossières pour effectuer cette prédiction. Des lecteurs humains, ou des modèles plus vastes, pourraient néanmoins être capables de détecter du contenu anachronique dans des passages qui, à première vue, semblent « d'époque ».

Contact humain

Enfin, les chercheurs ont mené des tests d’évaluation humaine en utilisant 250 passages sélectionnés à la main dans des livres publiés entre 1905 et 1914, et ils ont observé que beaucoup de ces textes seraient probablement interprétés très différemment aujourd’hui de ce qu’ils étaient à l’époque de leur rédaction :

Notre liste comprenait, par exemple, une entrée d'encyclopédie sur l'Alsace (alors partie de l'Allemagne) et une autre sur le béribéri (qui était alors souvent expliqué comme une maladie fongique plutôt que comme une carence nutritionnelle). Bien qu'il s'agisse de différences factuelles, nous avons également sélectionné des passages présentant des différences plus subtiles d'attitude, de rhétorique ou d'imagination.

« Par exemple, les descriptions de lieux non européens au début du XXe siècle tendent à glisser vers une généralisation raciale. Une description du lever de soleil sur la lune, écrite en 1913, évoque des phénomènes chromatiques riches, car personne n'avait encore vu de photographies d'un monde sans atmosphère. »

Les chercheurs ont créé des questions courtes auxquelles chaque passage historique pouvait répondre de manière plausible, puis ont affiné GPT-4o-mini sur ces paires question-réponse. Pour renforcer l'évaluation, ils ont entraîné cinq versions distinctes du modèle, chacune étant tenir une partie différente des données à tester.

Ils ont ensuite produit des réponses en utilisant à la fois les versions par défaut de GPT-4o et GPT-4o-mini, ainsi que les variantes affinées, chacune évaluée sur la partie qu'elle n'avait pas vue pendant la formation.

Perdue dans le temps

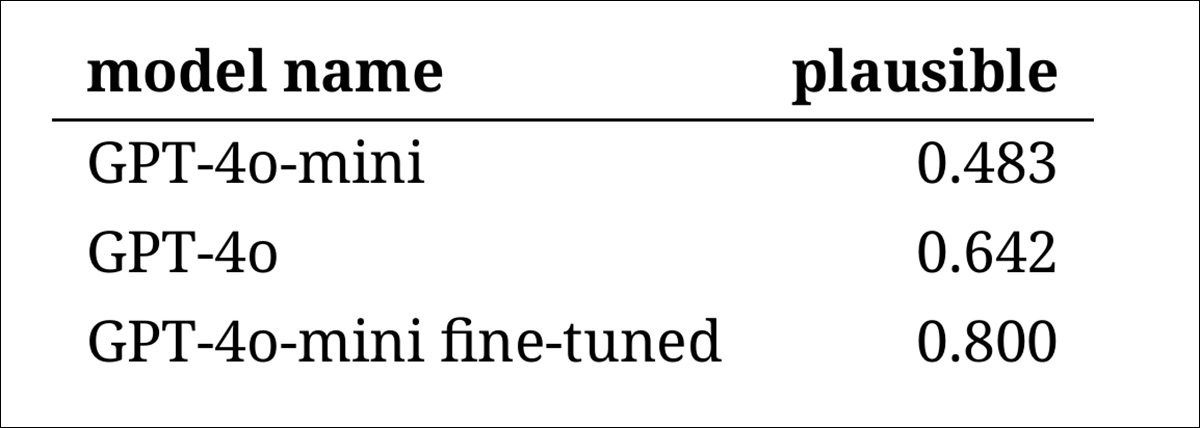

Pour évaluer dans quelle mesure les modèles pouvaient imiter de manière convaincante le langage historique, les chercheurs ont demandé à trois annotateurs experts d’examiner 120 complétions générées par l’IA et de juger si chacune d’entre elles semblait plausible pour un écrivain en 1914.

Cette approche d'évaluation directe s'est avérée plus difficile que prévu : bien que les annotateurs aient été d'accord sur leurs évaluations dans près de quatre-vingts pour cent des cas, le déséquilibre dans leurs jugements (avec « plausible » choisi deux fois plus souvent que « non plausible ») signifiait que leur niveau réel d'accord n'était que modéré, tel que mesuré par un Le score kappa de Cohen de 0.554.

Les évaluateurs eux-mêmes ont décrit la tâche comme difficile, nécessitant souvent des recherches supplémentaires pour évaluer si une déclaration correspondait à ce qui était connu ou cru en 1914.

Certains passages soulevaient des questions difficiles sur le ton et la perspective – par exemple, si une réponse était suffisamment limitée dans sa vision du monde pour refléter ce qui aurait été typique en 1914. Ce type de jugement dépendait souvent du niveau de ethnocentrisme (c'est-à-dire la tendance à considérer les autres cultures à travers les hypothèses ou les préjugés de sa propre culture).

Dans ce contexte, le défi consistait à déterminer si un passage exprimait juste assez de parti pris culturel pour paraître historiquement plausible sans paraître trop moderne, ou trop ouvertement offensant selon les critères actuels. Les auteurs soulignent que même pour les spécialistes familiers de l'époque, il était difficile de tracer une ligne nette entre un langage perçu comme historiquement exact et un langage reflétant les idées contemporaines.

Néanmoins, les résultats ont montré un classement clair des modèles, la version affinée du GPT-4o-mini étant jugée globalement la plus plausible :

Évaluations des annotateurs sur la plausibilité des résultats de chaque modèle

Que ce niveau de performance, évalué plausible Dans quatre-vingt pour cent des cas, la fiabilité des textes historiques reste incertaine, notamment parce que l’étude n’incluait pas de mesure de référence de la fréquence à laquelle les textes authentiques de l’époque pourraient être mal classés.

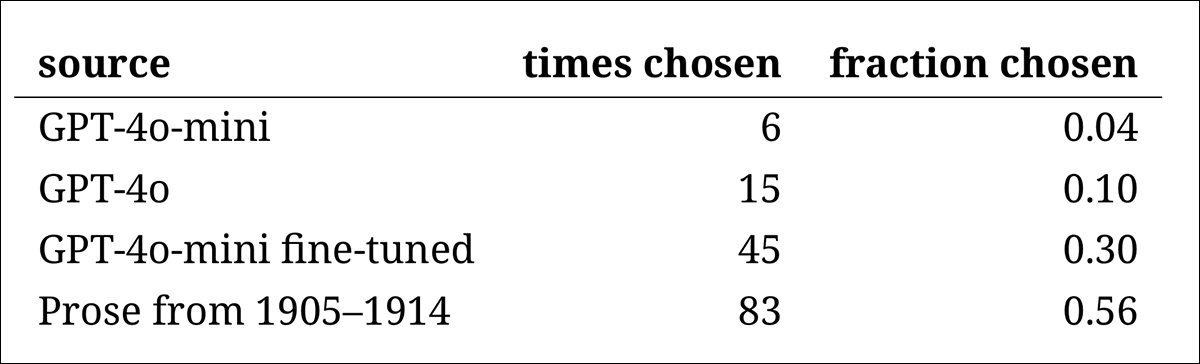

Alerte intrus

Ensuite, un « test d'intrusion » a été réalisé, au cours duquel des annotateurs experts ont pu voir quatre passages anonymes répondant à la même question historique. Trois des réponses provenaient de modèles linguistiques, tandis que la troisième était un extrait authentique d'une source du début du XXe siècle.

La tâche consistait à identifier quel passage était l’original, réellement écrit à cette époque.

Cette approche ne demandait pas aux annotateurs d’évaluer directement la plausibilité, mais mesurait plutôt la fréquence à laquelle le passage réel se démarquait des réponses générées par l’IA, testant ainsi si les modèles pouvaient tromper les lecteurs en leur faisant croire que leur production était authentique.

Le classement des modèles correspondait aux résultats de la tâche de jugement précédente : la version améliorée du GPT-4o-mini était la plus convaincante parmi les modèles, mais restait encore en deçà de la réalité.

La fréquence à laquelle chaque source a été correctement identifiée comme le passage historique authentique.

Ce test a également servi de référence utile, car, le passage authentique étant identifié plus de la moitié du temps, l’écart entre la prose authentique et la prose synthétique restait perceptible pour les lecteurs humains.

Une analyse statistique connue sous le nom de test de McNemar ont confirmé que les différences entre les modèles étaient significatives, sauf dans le cas des deux versions non réglées (GPT-4o et GPT-4o-mini), qui ont eu des performances similaires.

L'avenir du passé

Les auteurs ont constaté que le fait d’inciter les modèles de langage moderne à adopter une voix historique ne produisait pas de résultats convaincants de manière fiable : moins des deux tiers des résultats étaient jugés plausibles par les lecteurs humains, et même ce chiffre surestime probablement les performances.

Dans de nombreux cas, les réponses comprenaient des signaux explicites indiquant que le modèle parlait d’un point de vue actuel – des phrases telles que « en 1914, on ne sait pas encore que… » or « En 1914, je ne connais pas… » Ces avertissements étaient suffisamment fréquents pour apparaître dans près d'un cinquième des achèvements. De tels avertissements montraient clairement que le modèle simulait l'histoire de l'extérieur, plutôt que de l'écrire de l'intérieur.

Les auteurs déclarent:

« Les faibles performances de l'apprentissage contextuel sont regrettables, car ces méthodes sont les plus simples et les moins coûteuses pour la recherche historique basée sur l'IA. Nous soulignons que nous n'avons pas exploré ces approches de manière exhaustive. »

« Il se pourrait que l'apprentissage en contexte soit adéquat – aujourd'hui ou à l'avenir – pour un sous-ensemble de domaines de recherche. Mais nos premières données ne sont pas encourageantes. »

Les auteurs concluent que si l'affinement d'un modèle commercial basé sur des passages historiques peut produire un résultat stylistiquement convaincant à moindre coût, il n'élimine pas totalement les traces de perspective moderne. Pré-entraîner un modèle entièrement basé sur des éléments d'époque évite les anachronismes, mais exige des ressources bien plus importantes et produit un résultat moins fluide.

Aucune de ces méthodes n'offre de solution complète et, pour l'instant, toute tentative de simulation de voix historiques semble impliquer un compromis entre authenticité et cohérence. Les auteurs concluent que des recherches supplémentaires seront nécessaires pour clarifier la meilleure façon de gérer cette tension.

Conclusion

L'une des questions les plus intéressantes soulevées par ce nouvel article est peut-être celle de l'authenticité. Bien qu'il ne s'agisse pas d'outils parfaits, les fonctions de perte et les mesures telles que LIPS et SSIM donner aux chercheurs en vision par ordinateur au moins une méthodologie similaire pour évaluer par rapport à la vérité fondamentale.

En revanche, lorsqu'on crée un nouveau texte dans le style d'une époque révolue, il n'y a pas de vérité fondamentale, seulement une tentative d'habiter une perspective culturelle disparue. Tenter de reconstruire cet état d'esprit à partir de traces littéraires est en soi un acte de quantification, puisque de telles traces ne sont que des preuves, tandis que la conscience culturelle dont elles émergent reste au-delà de toute inférence, et probablement au-delà de toute imagination.

Sur le plan pratique également, les fondements des modèles linguistiques modernes, façonnés par les normes et les données actuelles, risquent de réinterpréter ou de supprimer des idées qui auraient semblé raisonnables ou banales à un lecteur édouardien, mais qui sont désormais perçues comme des artefacts (souvent offensants) de préjugés, d’inégalité ou d’injustice.

On se demande donc, même si nous pouvions créer un tel colloque, s’il ne pourrait pas nous rebuter.

Première publication le vendredi 2 mai 2025