Tekoäly

LoReFT: Representation Finetuning for Language Models

Parametritehokkaat hienosäätö- tai PeFT-menetelmät pyrkivät mukauttamaan suuria kielimalleja päivitysten avulla pieneen painomäärään. Suurin osa olemassa olevista tulkintatyöstä on kuitenkin osoittanut, että esitykset koodaavat semanttista rikasta tietoa, mikä viittaa siihen, että se voisi olla parempi ja tehokkaampi vaihtoehto muokata näitä esityksiä. Valmiiksi koulutetut suuret mallit hienosäädetään usein käytettäviksi uusiin verkkotunnuksiin tai tehtäviin, ja hienosäätöprosessin aikana yksi perusmalli voidaan mukauttaa monenlaisiin tehtäviin, vaikka käytettävissä on vain pieniä määriä verkkotunnuksen sisäistä dataa. malliin. Koko mallin hienosäätöprosessi on kuitenkin resursseja vievää ja kallista, etenkin kielimalleissa, joissa kokoa ja parametreja on huomattavasti enemmän.

Parametritehokkaat hienosäätö- tai PeFT-menetelmät ehdottavat koko mallin hienosäätöön liittyvien korkeiden kustannusten poistamista päivittämällä vain pieni osa käytettävissä olevista kokonaispainoista. Tämä prosessi auttaa vähentämään harjoitusaikaa ja muistin käyttöä. Vielä tärkeämpää on, että parametritehokkaat hienosäätö- tai PeFT-menetelmät ovat osoittaneet samanlaista suorituskykyä kuin hienosäätö useissa käytännön asetuksissa. Adapterit, yleinen parametritehokkaiden hienosäätö- tai PeFT-menetelmien perhe, oppivat muokkauksen, joka voidaan lisätä ylimääräiseen painosarjaan, joka toimii jäädytetyn perusmallin rinnalla. Viimeaikaiset sovittimet, kuten LoRA, vähentävät opittujen parametrien määrää. painopäivitykset käyttämällä matala-arvoisia likiarvoja täyden painon matriisien sijaan, kun harjoittelet sovittimia.

Aikaisemmissa töissä, joissa esityksiä esittelevät editoinnit saattavat olla parempi vaihtoehto parametritehokkaille hienosäätö- tai PeFT-menetelmille, tässä artikkelissa puhumme esityksen hienosäätö- tai ReFT-menetelmistä, jotka toimivat jäädytetyllä mallilla, ja opimme tehtäväkohtaisia interventioita piilotettuihin esityksiin. Tämän artikkelin tarkoituksena on kattaa ReFt tai Representation Fine-tuning -kehys perusteellisesti, ja tutkimme mekanismia, metodologiaa, kehyksen arkkitehtuuria sekä sen vertailua uusimpien kehysten kanssa. Joten aloitetaan.

ReFT: Esityksen hienosäätö kielimalleille

Yritetään omaksua esikoulutettuja kielimalleja uusille aloille ja tehtäviin, nykyiset viitekehykset hienosäätävät näitä esikoulutettuja kielimalleja usein, koska toteutetun hienosäätöprosessin yhteydessä yksi perusmalli voidaan mukauttaa useisiin tehtäviin jopa kun työskentelet pienen verkkotunnuksen sisäisen datamäärän kanssa. Vaikka hienosäätöprosessi parantaa kokonaissuorituskykyä, se on kallis prosessi varsinkin, jos kielimallissa on merkittävästi paljon parametreja. Voit ratkaista tämän ongelman ja vähentää siihen liittyviä kustannuksia käyttämällä PeFT- tai parametritehokasta hienosäätää kehyksiä päivittää vain pieni osa kokonaispainoista, prosessi, joka ei vain vähennä harjoitusaikaa, vaan vähentää myös muistin käyttöä, jolloin PeFT-kehykset voivat saavuttaa samanlaisen suorituskyvyn verrattuna täydellisiin hienosäätömenetelmiin käytännön skenaarioissa. Adapterit, yleinen PEFT-perhe, toimivat oppimalla muokkauksen, joka voidaan lisätä ylimääräiseen painosarjaan, sekä painojen osajoukkoa, joka toimii yhdessä perusmallin kanssa, jossa on jäädytetyt painot. Viimeaikaiset sovitinkehykset, kuten LoRA ja QLoRA ovat osoittaneet, että on mahdollista kouluttaa täyden tarkkuuden sovittimia heikomman tarkkuuden mallien päälle vaikuttamatta suorituskykyyn. Sovittimet ovat yleensä tehokkaampia ja tehokkaampia verrattuna muihin menetelmiin, jotka tuovat käyttöön uusia mallikomponentteja.

Parametritehokkaiden hienosäätökehysten tärkein kohokohta on se, että ne muokkaavat esityksiä, vaan muokkaavat painoja. Tulkittavuutta käsittelevät viitekehykset ovat kuitenkin osoittaneet, että esitykset koodaavat rikasta semanttista tietoa, mikä viittaa siihen, että esitysten muokkaaminen voisi olla parempi ja tehokkaampi lähestymistapa verrattuna painopäivityksiin. Tämä oletus, että esitysten muokkaus on parempi lähestymistapa, muodostaa perustan ReFT- tai Representation Fine-tuning -kehykselle, joka kouluttaa interventioita mallin painojen mukauttamisen sijaan, jolloin malli voi manipuloida pientä osaa kaikista esityksistä yrittääkseen ohjata mallin käyttäytymistä. ratkaisemaan loppupään tehtäviä päättelyn aikana. ReFT- tai edustushienosäätömenetelmät korvaavat painopohjaisia PeFT- tai parametritehokkaita hienosäätökehyksiä. ReFT-lähestymistapa ammentaa inspiraatiota viimeaikaisista malleista, jotka toimivat suurella mallin tulkittavuudella, joka puuttuu esityksiin löytääkseen uskollisia kausaalimekanismeja ja ohjaa mallin käyttäytymistä päättelyn aikana, ja siksi sitä voidaan pitää esitysten muokkausmallien yleistyksenä. Samalle pohjautuva LoReFT tai Low-Rank Subspace ReFT on vahva ja tehokas ReFT:n ilmentymä, ja se on ReFT:n parametrointi, joka puuttuu piilotettuihin esityksiin lineaarissa avaruudessa, joka kattaa matalan tason projektiomatriisin, ja rakentuu suoraan DAS:iin. tai Distributed Alignment Search -kehys.

Edistyessään, toisin kuin täydellinen hienosäätö, PeFT- tai Parameter-tehokas hienosäätökehys kouluttaa vain pienen osan mallin parametreista ja onnistuu mukauttamaan mallin loppupään tehtäviin. Parametritehokas hienosäätökehys voidaan luokitella kolmeen pääluokkaan:

- Adapteripohjaiset menetelmät: Adapteriin perustuvat menetelmät kouluttavat lisämoduuleja, kuten täysin yhdistettyjä kerroksia esikoulutetun mallin päälle jäädytetyillä painoilla. Sarjan sovittimet lisäävät komponentteja monikerroksisen perceptronin tai MLP:n ja LM:n tai suurten mallien huomiokerrosten väliin, kun taas rinnakkaiset sovittimet lisäävät moduuleja olemassa olevien komponenttien rinnalle. Koska sovittimet lisäävät uusia komponentteja, joita ei voida helposti taittaa olemassa oleviin mallipainoihin, ne muodostavat ylimääräisen taakan päättelyn aikana.

- LoRA: LoRA uusimpien muunnelmiensa kanssa likimääräisiä lisäpainoja harjoittelun aikana käyttämällä matala-arvoisia matriiseja, eivätkä ne vaadi ylimääräisiä yleiskustannuksia päättelyn aikana, koska painopäivitykset voidaan yhdistää malliin, ja siksi niitä pidetään ajankohtaisina. vahvimmat PeFT-kehykset.

- Pikapohjaiset menetelmät: Kehotuspohjaiset menetelmät lisäävät syötteeseen satunnaisesti alustettuja soft-tokeneita ja harjoittelevat niiden upotuksia pitäen samalla kielimallin painot lukittuina. Näiden menetelmien tarjoama suorituskyky ei useinkaan ole tyydyttävä verrattuna muihin PeFT-lähestymistapoihin, ja niillä on myös merkittävät yleiskustannukset.

Painojen päivittämisen sijaan ReFT-kehys oppii interventioita, joilla muokataan pientä osaa esityksistä. Lisäksi viimeaikaiset esityssuunnittelua ja aktivointiohjausta koskevat työt ovat osoittaneet, että kiinteiden ohjausvektorien lisääminen jäännösvirtaan saattaa helpottaa esikoulutettujen suurten mallisukupolvien hallintaa vaatimatta resurssiintensiivistä hienosäätö. Muut viitekehykset ovat osoittaneet, että esitysten muokkaaminen opitulla skaalaus- ja käännösoperaatiolla voi yrittää vastata, mutta ei ylittää LoRA-sovittimien tarjoamaa suorituskykyä useissa tehtävissä, joissa on vähemmän opittuja parametreja. Lisäksi näiden viitekehysten menestys useissa eri tehtävissä on osoittanut, että esikoulutetuilla kielimalleilla käyttöön otetuilla esityksillä on rikas semantiikka, vaikka näiden mallien suorituskyky ei ole optimaalinen, minkä seurauksena PEFT:t jatkavat uusinta lähestymistapaa. ilman ylimääräistä päättelytaakkaa.

ReFT: Metodologia ja arkkitehtuuri

Jotta tyylin säilytysprosessi olisi yksinkertainen, ReFT-kehys olettaa kohdemallinaan muuntajapohjaisen suuren mallin, joka pystyy tuottamaan kontekstuaalisen esityksen merkkijonoista. Tietylle sekvenssille, jossa on n määrä syöttötunnisteita, ReFT-kehys upottaa ensin nämä syöttötunnisteet esitysluetteloon, jonka jälkeen m kerrosta laskevat piilotettujen esitysten luettelon peräkkäin edellisen piilotettujen esitysten luettelon funktiona. Jokainen piilotettu esitys on vektori, ja kielimalli käyttää lopullisia piilotettuja esityksiä ennusteiden tuottamiseen. ReFT-kehys ottaa huomioon sekä maskatut kielimallit että autoregressiiviset kielimallit. Nyt lineaarisen esitystavan hypoteesin mukaan hermoverkoissa käsitteet koodataan esitysten lineaarisiin aliavaruuksiin. Viimeaikaiset mallit ovat havainneet tämän väitteen pitävän paikkansa hermoverkkomalleissa, jotka on koulutettu luonnollisella kielellä yhdessä muiden syötejakaumien kanssa.

Lisäksi tulkintatutkimuksissa satunnainen abstraktiokehys käyttää vaihtointerventioita määrittääkseen hermoverkkokomponenttien roolin satunnaisesti toteutettaessa tiettyjä käyttäytymismalleja. Vaihtotoimien taustalla oleva logiikka on, että jos esitys korjataan siihen, mikä se olisi ollut kontrafaktuaalisyötteelle, ja tämä interventio vaikuttaa mallin tuottoon johdonmukaisesti samalla tavalla kuin ReFT-kehyksen esittämät väitteet tuottamisesta vastaavasta komponentista. Tämä esitys, komponentilla on kausaalinen rooli käyttäytymisessä. Vaikka on olemassa muutamia menetelmiä, hajautettu vaihtointerventio on ihanteellinen tapa testata, onko käsite koodattu esityksen lineaariseen aliavaruuteen, kuten lineaarisen esityksen hypoteesi väittää. Lisäksi DAS-menetelmää on käytetty aiemmin etsimään kielimalleista entiteettiattribuuttien, tunteiden, kielellisten piirteiden ja matemaattisen päättelyn lineaarista esitystä. Useat kokeet ovat kuitenkin osoittaneet, että DAS-menetelmä on erittäin ekspressiivinen ja sillä on kyky löytää kausaalisia tehokkaita aliavaruuksia, vaikka muuntajan kielimalli on alustettu satunnaisesti, ja siksi se ei vielä opi mitään tehtäväkohtaisia esityksiä, mikä johtaa keskustella siitä, onko DAS riittävän tehokas ja vastuullinen tulkintatehtävissä.

DAS:n tarjoama ilmaisukyky viittaa siihen, että lähestymistapa voisi olla ihanteellinen työkalu kielimallin käyttäytymisen ohjaamiseen sekä sen ohjattavaan generointiin ja vastuulliseen muokkaamiseen. Siksi kielimallien mukauttamiseksi alavirran tehtäviin ReFT-kehys käyttää hajautettua tiedonsiirtotoimintaa uuden parametritehokkaan menetelmän luomiseksi. Lisäksi ReFT-menetelmä on joukko interventioita, ja viitekehys pakottaa sen, että kaikissa kahdessa samalla tasolla toimivassa interventiossa interventioasemien on oltava hajallaan kaikkien interventiotoimintojen parametrien ollessa riippumattomina. Tämän seurauksena ReFT on yleinen kehys, joka kattaa interventiot piilotettuihin esityksiin mallin eteenpäinsiirron aikana.

ReFT: Kokeilut ja tulokset

Arvioidakseen suorituskykyään verrattuna olemassa oleviin PEFT-kehikkoihin ReFT-kehys suorittaa kokeita neljällä erilaisella luonnollisen kielen käsittelyn vertailuarvolla ja kattaa yli 20 tietojoukkoa. Ensisijaisena tavoitteena on tarjota rikas kuva siitä, kuinka LoReFT-kehys toimii eri skenaarioissa. Lisäksi, kun LoReFT-kehys otetaan käyttöön tosielämässä, kehittäjien on päätettävä, kuinka monta interventiota he oppivat sekä syöttöpaikat ja tasot, joihin niitä sovelletaan. Tehtävän suorittamiseksi ReFT-kehys virittää neljä hyperparametria.

- Niiden etuliitepaikkojen määrä, joihin puututaan.

- Niiden päätepaikkojen määrä, joihin puututaan.

- Mihin kerroksiin puututaan.

- Sidotaanko interventioparametrit saman kerroksen eri kohtiin.

Näin tekemällä ReFT-kehys yksinkertaistaa hyperparametrien hakuavaruutta ja varmistaa vain kiinteän lisäpäätelmäkustannuk- sen, joka ei skaalaudu kehotteen pituuden mukaan.

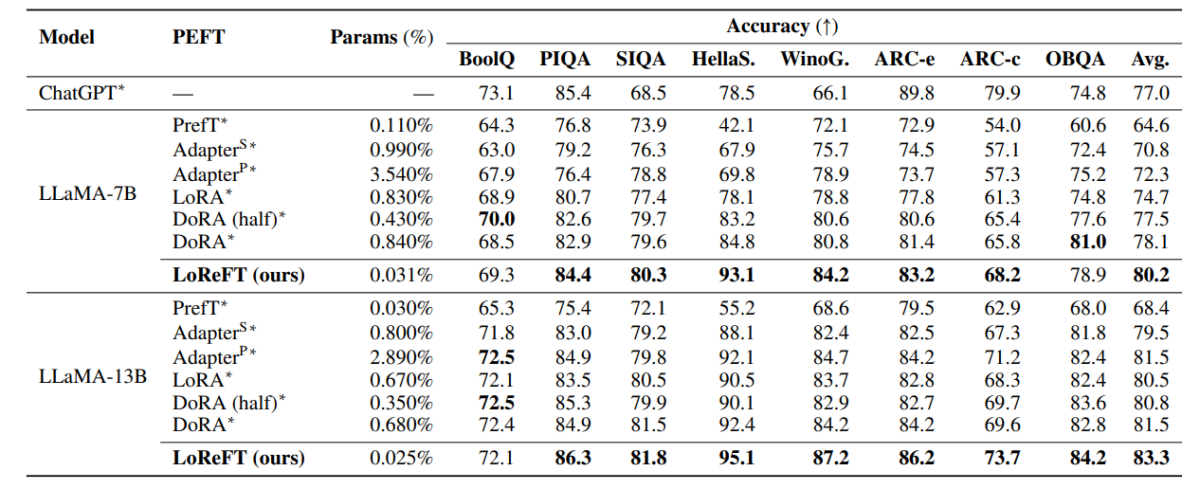

Yllä olevassa taulukossa verrataan LLaMA-7B- ja LLaMA-13B-kehysten tarkkuutta olemassa oleviin PEFT-malleihin 8:n järkevän päättelyn tietojoukossa. Kuten voidaan havaita, LoReFT-malli ylittää olemassa olevat PEFT-lähestymistavat kohtuullisella marginaalilla, vaikka sillä on paljon vähemmän parametreja, ja kolmen ajon keskimääräinen suorituskyky raportoidaan erillisillä parametrien siemenillä LoReFT-mallille. Parametri(%) lasketaan jakamalla koulutettavien parametrien määrä suuren perusmallin kokonaisparametrien lukumäärällä.

Yllä olevassa taulukossa on yhteenveto LLaMA-7B- ja LLaMA-13B-kehysten tarkkuusvertailusta olemassa oleviin PEFT-malleihin neljässä eri aritmeettisen päättelyn tietojoukossa, ja viitekehys raportoi kolmen ajon keskimääräisen suorituskyvyn erillisillä satunnaisilla siemenillä. Kuten voidaan havaita, huolimatta siitä, että sillä on paljon vähemmän parametreja (%), LoReFT-kehys ylittää olemassa olevat PEFT-kehykset huomattavalla marginaalilla.

Yllä olevassa taulukossa on yhteenveto RoBERTa-base- ja RoBERTa-large-kehysten tarkkuusvertailusta olemassa oleviin PEFT-malleihin GLUE-benchmarkissa, ja viitekehys raportoi viiden ajon keskimääräisen suorituskyvyn erillisillä satunnaisilla siemenillä. Kuten voidaan havaita, huolimatta siitä, että sillä on paljon vähemmän parametreja (%), LoReFT-kehys ylittää olemassa olevat PEFT-kehykset huomattavalla marginaalilla.

Loppuajatukset

Tässä artikkelissa olemme puhuneet LoReFT:stä, tehokkaasta vaihtoehdosta olemassa oleville PEFT-kehyksille, joka saavuttaa vahvan suorituskyvyn neljän eri toimialueen vertailuarvoissa samalla kun se tarjoaa jopa 50 kertaa tehokkaamman tehokkuuden, jonka aiemmat PEFT-mallit tarjoavat. Valmiiksi koulutetut suuret mallit hienosäädetään usein käytettäviksi uusiin verkkotunnuksiin tai tehtäviin, ja hienosäätöprosessin aikana yksi perusmalli voidaan mukauttaa monenlaisiin tehtäviin, vaikka käytettävissä on vain pieniä määriä verkkotunnuksen sisäistä dataa. malliin. Koko mallin hienosäätöprosessi on kuitenkin resursseja vievää ja kallista, etenkin kielimalleissa, joissa kokoa ja parametreja on huomattavasti enemmän. Parametritehokkaat hienosäätö- tai PeFT-menetelmät ehdottavat koko mallin hienosäätöön liittyvien korkeiden kustannusten poistamista päivittämällä vain pieni osa käytettävissä olevista kokonaispainoista. Tämä prosessi auttaa vähentämään harjoitusaikaa ja muistin käyttöä. Erityisesti LoReFT luo uuden huippuluokan suorituskyvyn tervejärkisen päättelyn, ohjeiden seuraamisen ja luonnollisen kielen ymmärtämisen suhteen vahvimpia PEFT:itä vastaan.