Tekoäly

Distentanglement on seuraava Deepfake Revolution

CGI-tietojen lisäystä käytetään uudessa projektissa syväfake-kuvien hallitsemiseksi paremmin. Vaikka et vieläkään voi käyttää CGI-päitä tehokkaasti täyttämään puuttuvia aukkoja syvässä väärennetyissä kasvotietosarjoissa, uusi tutkimusaalto identiteetin erottamiseksi kontekstista tarkoittaa, että pian sinun ei ehkä tarvitse tehdä sitä.

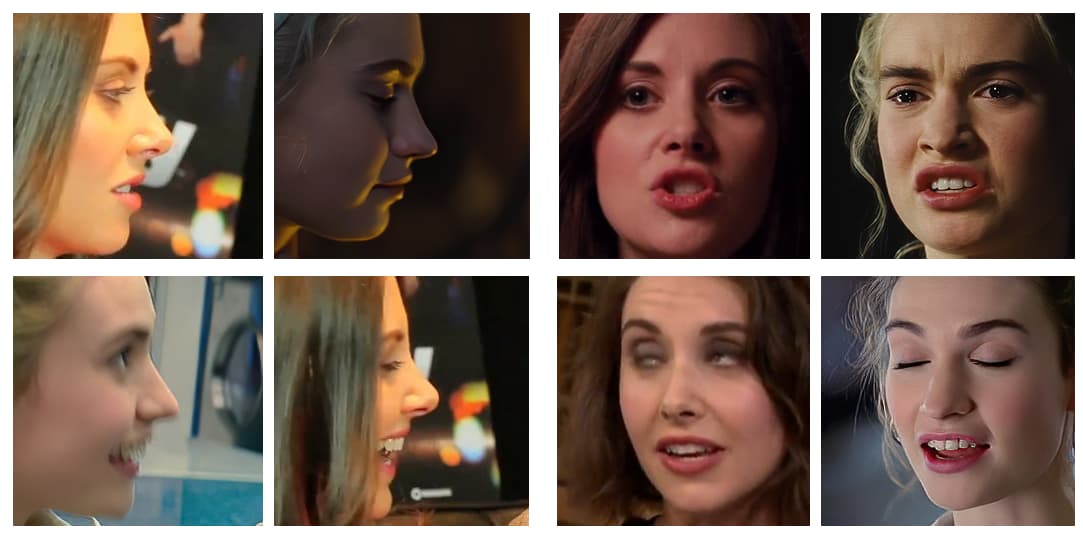

Eräiden viime vuosien menestyneimpien virusten syväfake-videoiden tekijät valitsevat lähdevideonsa erittäin huolellisesti välttäen pitkiä profiilikuvia (eli poliisin pidätysmenettelyissä suosittuja sivukuvia), teräviä kulmia ja epätavallisia tai liioiteltuja ilmaisuja. . Yhä useammin virusten deepfakerien tuottamat esittelyvideot ovat editoituja kokoelmia, jotka valitsevat "helppoimmat" kuvakulmat ja ilmaisut deepfakea varten.

Itse asiassa kaikkein mukautuvin kohdevideo, johon voit lisätä syvälle väärennetty julkkis, on sellainen, jossa alkuperäinen henkilö (jonka henkilöllisyyden syväfake pyyhkii) katsoo suoraan kameraan minimaalisella ilmaisuvalikoimalla.

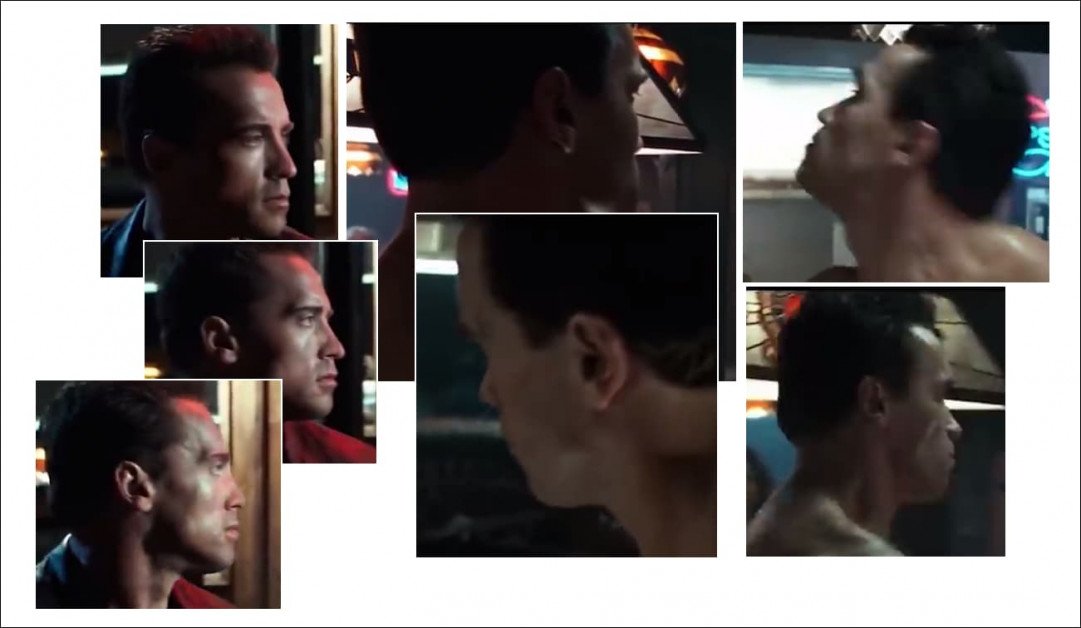

Suurin osa viime vuosien suosituista syväväärennöksistä on osoittanut kohteet suoraan kameraan päin, ja niissä on joko vain suosittuja ilmaisuja (kuten hymyileviä), jotka voidaan helposti poimia punaisen maton paparazzitulostuksesta, tai (kuten Sylvester Stallonen 2019 väärennöksessä kuten terminaattori, kuvassa vasemmalla), mieluiten ilman ilmaisua, koska neutraalit ilmaisut ovat erittäin yleisiä, joten ne on helppo sisällyttää syvään fake-malleihin.

Koska deepfake-tekniikat, kuten DeepFaceLab ja kasvojen vaihto Suorita nämä yksinkertaisemmat vaihdot erittäin hyvin, olemme tarpeeksi hämmentyneitä heidän saavutuksistaan, jotta emme huomaa, mihin he eivät kykene, emmekä usein edes yritä:

Nappaa kehutusta deepfake-videosta, jossa Arnold Schwarzenegger muuttuu Sylvester Stalloneksi – elleivät kuvakulmat ole liian hankalia. Profiilit ovat edelleen pysyvä ongelma nykyisissä syvänväärennösmenetelmissä, osittain siksi, että avoimen lähdekoodin ohjelmistoa, jota käytetään kasvojen asentojen määrittämiseen deepfake-kehyksessä, ei ole optimoitu sivukuvauksille, mutta pääasiassa siksi, että jommassakummassa tai molemmissa tarvittavista kohteista on pulaa sopivaa lähdemateriaalia. tietojoukot. Lähde: https://www.youtube.com/watch?v=AQvCmQFScMA

Uusi tutkimus Israelista ehdottaa uutta menetelmää synteettisten tietojen, kuten CGI-päiden, käyttämiseksi syväfakingin tuomiseksi 2020-luvulle erottamalla todella kasvojen identiteetit (eli "Tom Cruisen" olennaiset kasvojen ominaisuudet kaikista näkökulmista) kontekstistaan (esim. katse ylös, sivuttain katsoen, hymyillen, kumartaen pimeässä, kulmakarvat rypistyneet, silmät kiinni, Jne.).

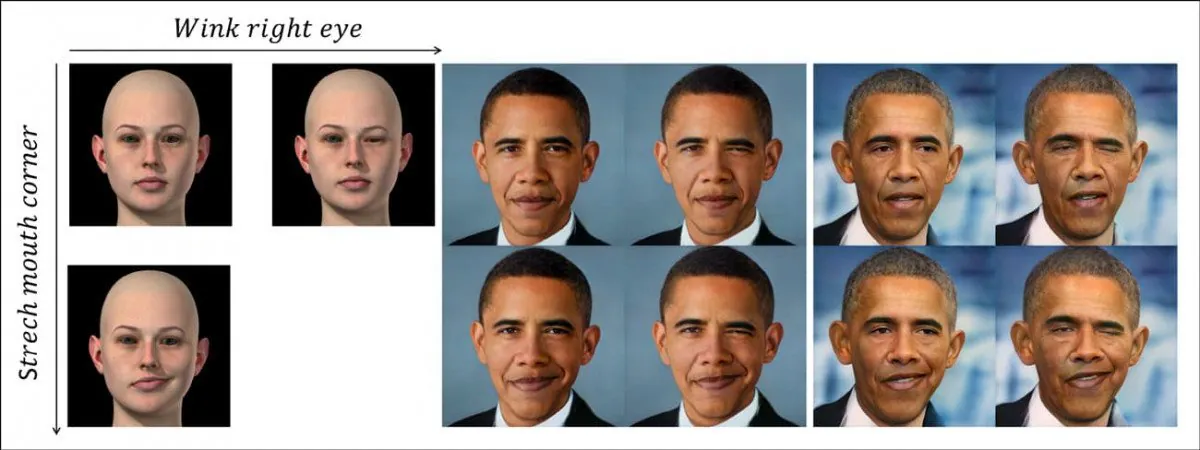

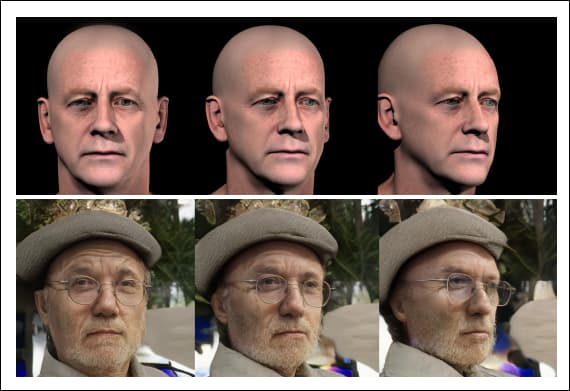

Uusi järjestelmä erottaa asennon ja kontekstin (eli silmänräpäyksen) yksilöllisesti yksilön identiteettikoodauksesta käyttämällä toisiinsa liittymättömiä synteettisiä kasvotietoja (kuvassa vasemmalla). Ylärivillä näemme Barack Obaman henkilöllisyyteen siirretyn "silmäniskun", joka on saanut GAN:n piilevän avaruuden opitun epälineaarisen polun, jota edustaa vasemmalla oleva CGI-kuva. Alla olevalla rivillä näemme venytetyn suun kulman puoliskon siirtyneenä entiselle presidentille. Alhaalla oikealla näemme molempia ominaisuuksia käytettynä samanaikaisesti. Lähde: https://arxiv.org/pdf/2111.08419.pdf

Tämä ei ole pelkkää Deepfake pää-nukketeatteri, tekniikka, joka sopii paremmin avatareihin ja osittaiseen kasvojen huulten synkronointiin, ja jolla on rajalliset mahdollisuudet täysimittaisiin syväfake-videomuunnoksiin.

Pikemminkin tämä edustaa tietä eteenpäin välineiden perustavanlaatuiseen erottamiseen (kuten "muuta pään kulmaa", 'luo rypistys').

Uusi lehti on nimeltään Delta-GAN-Encoder: semanttisten muutosten koodaus eksplisiittistä kuvankäsittelyä varten, käyttäen muutamia synteettisiä näytteitä, ja tulee Technion – Israel Institute of Technologyn tutkijoilta.

Ymmärtääksemme, mitä teos tarkoittaa, katsotaanpa, kuinka syväväärennöksiä tuotetaan tällä hetkellä kaikkialla deepfake-pornosivustoista Teollinen valo ja taikuus (koska avoimen lähdekoodin DeepFaceLab-arkisto on tällä hetkellä hallitseva sekä "amatööri"- että ammattimainen deepfaking).

Mikä estää nykyistä Deepfake-tekniikkaa?

Deepfakeja luodaan tällä hetkellä harjoittelemalla an kooderi/dekooderi koneoppimismalli kahdelle kasvokuvakansiolle – henkilölle, jonka haluat "maalata päälle" (aikaisemmassa esimerkissä se on Arnie) ja henkilölle, jonka haluat lisätä materiaaliin (Sly).

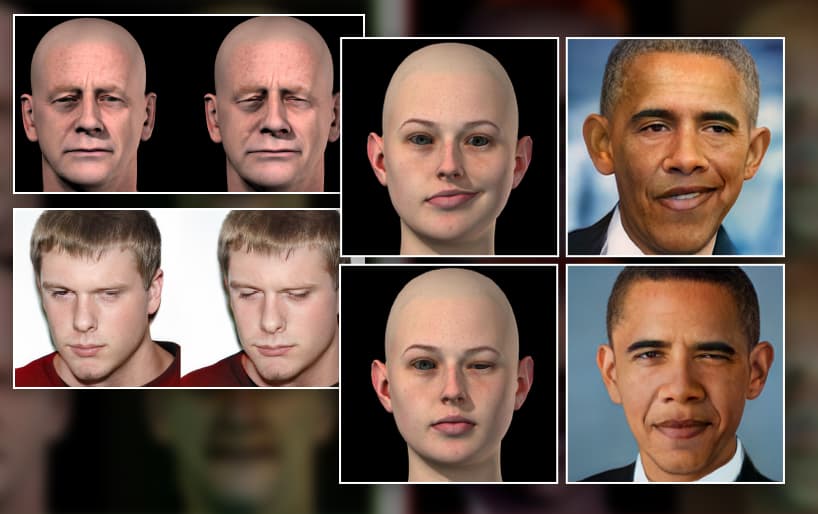

Esimerkkejä vaihtelevista asennoista ja valaistusolosuhteista kahdessa eri kasvoryhmässä. Huomaa sarakkeen A kolmannen rivin lopussa oleva erottuva lauseke, jolla ei todennäköisesti ole läheistä vastinetta toisessa tietojoukossa.

Enkooderi/dekooderijärjestelmä sitten vertaa jokaista kuvaa kussakin kansiossa toisilleen ylläpitäen, parantaen ja toistaen tätä toimintoa satojen tuhansien iteraatioiden ajan (usein jopa viikon ajan), kunnes se ymmärtää molempien identiteettien olennaiset ominaisuudet riittävän hyvin vaihtaakseen niitä mielensä mukaan.

Deepfake-arkkitehtuuri oppii identiteetistä jokaiselle kahdelle henkilölle, jotka vaihdetaan prosessissa kietoutunut kontekstiin. Se ei voi oppia ja soveltaa periaatteita yleisestä asennosta "hyvin ja kaikesta", mutta se tarvitsee runsaasti esimerkkejä koulutustietojoukosta jokaiselle kasvojen vaihtoon osallistuvalle identiteetille.

Siksi, jos haluat vaihtaa kaksi identiteettiä, jotka tekevät jotain epätavallisempaa kuin vain hymyilevät tai katsovat suoraan kameraan, tarvitset monet tapauksia kyseisestä asennosta/identiteetistä kahdessa kasvoryhmässä:

Koska kasvojen tunnistaminen ja asennon ominaisuudet ovat tällä hetkellä niin kietoutuneet toisiinsa, tarvitaan laaja-alainen ilme, pään asento ja (vähemmässä määrin) valaistus kahdessa kasvotietojoukossa tehokkaan syvän väärennösmallin opettamiseksi DeepFaceLabin kaltaisille järjestelmille. Mitä vähemmän tiettyä kokoonpanoa (kuten "sivunäkymä/hymyilevä/auringonvalo") esiintyy molemmissa kasvoryhmissä, sitä epätarkemmin se hahmonnetaan tarvittaessa syvässä fake-videossa.

Jos sarja A sisältää epätavallisen asennon, mutta sarjasta B puuttuu se, olet melko epäonninen; riippumatta siitä, kuinka kauan koulutat mallia, se ei koskaan opi toistamaan sitä asentoa hyvin identiteettien välillä, koska sillä oli vain puolet tarvittavista tiedoista, kun sitä koulutettiin.

Vaikka sinulla olisikin yhteensopivia kuvia, se ei ehkä riitä: jos sarjassa A on vastaava asento, mutta jyrkän sivuvalaistuksen kanssa verrattuna tasaiseen valaistuun vastaavaan asentoon toisessa kasvosarjassa, vaihdon laatu voitti. ei ole niin hyvä kuin jos jokaisella olisi yhteiset valaistusominaisuudet.

Miksi tiedot ovat niukat

Ellei sinua pidätetä säännöllisesti, sinulla ei todennäköisesti ole niin montaa sivuprofiilia itsestäsi. Kaikki, mikä tuli esiin, todennäköisesti heitit pois. Koska kuvatoimistot tekevät samoin, profiilikuvia on vaikea saada.

Deepfakerit sisällyttävät usein useita kopioita rajoitetuista sivunäkymäprofiilitiedoista, jotka heillä on identiteettiä varten kasvosarjaan, jotta asento saa vähintään vähän huomiota ja aikaa harjoittelun aikana sen sijaan, että se olisi alennettu poikkeama.

Mutta on olemassa paljon enemmän mahdollisia sivunäkymän kasvokuvia kuin mitä todennäköisesti on saatavilla tietojoukkoon sisällytettäviksi – hymyilevä, rypistää kulmiaan, kirkuva, huutava, pimeästi valaistu, halveksiva, kyllästynyt, iloinen, salamavalaistu, katse ylös, alaspäin katsova, silmät auki, silmät kiinni…ja niin edelleen. Mikä tahansa näistä asennoista useissa yhdistelmissä voi olla tarpeen kohdevideossa.

Ja se on vain profiileja. Kuinka monta kuvaa sinulla on itsestäsi suoraan ylöspäin? Onko sinulla tarpeeksi laajasti edustaa 10,000 XNUMX mahdollista ilmaisua saatat olla päälläsi pitäessäsi juuri tuossa asennossa tarkasta kamerakulmasta, peittäen ainakin osan miljoona mahdollista valaistusympäristöä?

Todennäköisesti sinulla ei ole sitäkään yksi kuva itsestäsi katsomassa ylös. Ja se on vain kaksi kulmaa sadasta tai useammasta, jotka tarvitaan täydelliseen peittoon.

Vaikka olisi mahdollista luoda täydellinen peitto kasvoista kaikista kulmista erilaisissa valaistusolosuhteissa, tuloksena oleva tietojoukko olisi aivan liian suuri koulutettavaksi, satojen tuhansien kuvien luokkaa; ja vaikka se voisi Koulutusprosessin luonne nykyisten deepfake-kehysten osalta heittäisi pois suurimman osan tästä ylimääräisestä tiedosta rajoitetun määrän johdettujen ominaisuuksien hyväksi, koska nykyiset puitteet ovat redukcionistisia eivätkä kovin skaalautuvia.

Synteettinen korvaaminen

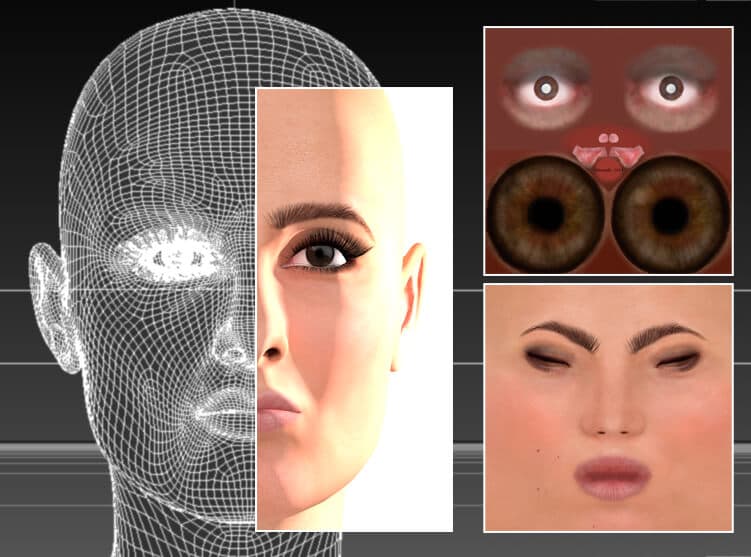

Deepfakejen aamunkoitosta lähtien deepfakerit ovat kokeilleet CGI-tyylisten kuvien käyttämistä, 3D-sovelluksissa, kuten Cinema4D:ssä ja Mayassa, tehtyjä päitä näiden "puuttuvien asentojen" luomiseen.

Tekoälyä ei tarvita; näyttelijä luodaan uudelleen perinteisessä CGI-ohjelmassa, Cinema 4D:ssä, käyttämällä verkkoja ja bittikarttakuvioita – tekniikkaa, joka juontaa juurensa 1960-luvulle, vaikka se on yleistynyt vasta 1990-luvulta lähtien. Teoriassa tätä kasvomallia voitaisiin käyttää luomaan syvää väärennettyä lähdetietoa epätavallisille asennoille, valaistustyyleille ja ilmeille. Todellisuudessa siitä on ollut rajallista tai ei ollenkaan hyötyä syväfakingissa, koska renderöityjen "fakeness" pyrkii vuotamaan läpi vaihdetuissa videoissa. Lähde: Tämän artikkelin kirjoittajan kuva osoitteessa https://rossdawson.com/futurist/implications-of-ai/comprehensive-guide-ai-artificial-intelligence-visual-effects-vfx/

Uudet deepfake-harjoittajat hylkäävät tämän menetelmän yleensä varhaisessa vaiheessa, koska vaikka se voi tarjota asentoja ja ilmaisuja, jotka eivät muuten ole käytettävissä, CGI-kasvojen synteettinen ulkoasu kulkee yleensä swapeihin johtuen ID- ja kontekstuaalisen/semanttisen tiedon sotkeutumisesta.

Tämä voi johtaa "uncanny Valley" -kasvojen äkilliseen välkkymiseen muuten vakuuttavassa deepfake-videossa, kun algoritmi alkaa hyödyntää ainoita tietoja, jotka sillä voi olla epätavallista asentoa tai ilmettä varten – ilmeisen väärennettyjä kasvoja.

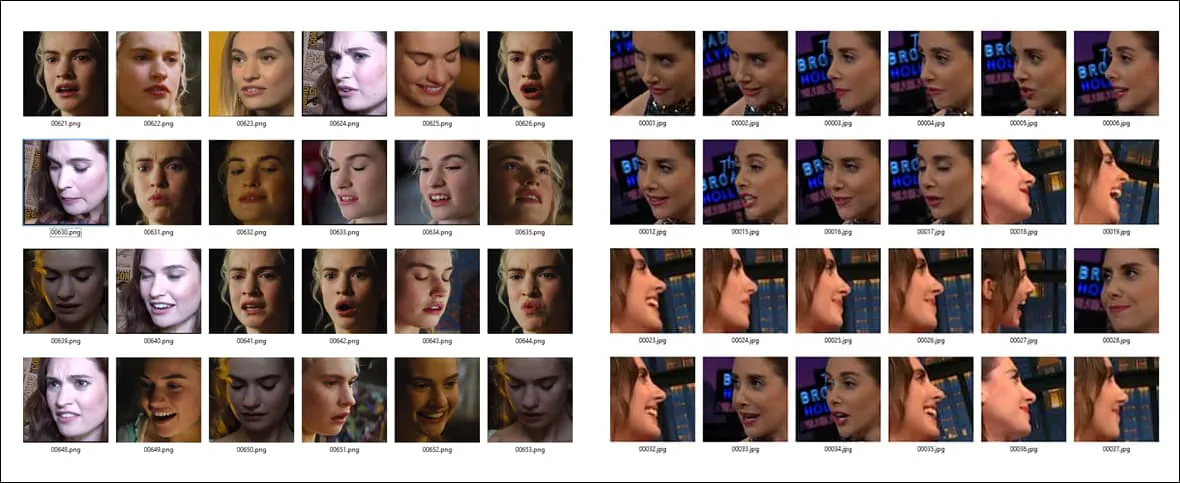

Deepfakerien suosituimpia aiheita on australialaisen näyttelijän Margot Robbien 3D-deepfake-algoritmi. mukana oletusasennuksessa DeepFaceLive, DeepFaceLab-versio, joka voi tehdä syväväärennöksiä suorassa lähetyksessä, kuten verkkokameraistunnossa. Yllä olevan kuvan mukaista CGI-versiota voitaisiin käyttää epätavallisten "puuttuvien" kulmien saamiseksi syväväärennöstietosarjoista. Source: https://sketchfab.com/3d-models/margot-robbie-bust-for-full-color-3d-printing-98d15fe0403b4e64902332be9cfb0ace

CGI Faces erillisenä, käsitteellisenä ohjeena

Sen sijaan israelilaisten tutkijoiden uusi Delta-GAN Encoder (DGE) -menetelmä on tehokkaampi, koska CGI-kuvien asento- ja kontekstitiedot on erotettu kokonaan kohteen "identiteettitiedoista".

Näemme tämän periaatteen toiminnassa alla olevassa kuvassa, jossa erilaisia pään suuntauksia on saatu käyttämällä CGI-kuvia ohjeena. Koska identiteetin piirteet eivät liity kontekstuaalisiin piirteisiin, CGI-kasvojen väärennetyn näköinen synteettinen ulkonäkö tai siinä kuvattu identiteetti ei näy läpi:

Uuden menetelmän avulla sinun ei tarvitse löytää kolmea erillistä tosielämän lähdekuvaa tehdäksesi syvän väärennöksen useista kulmista – voit vain kiertää CGI-päätä, jonka korkean tason abstraktit piirteet asetetaan identiteettiin ilman, että tunnistetta vuotaa. tiedot.

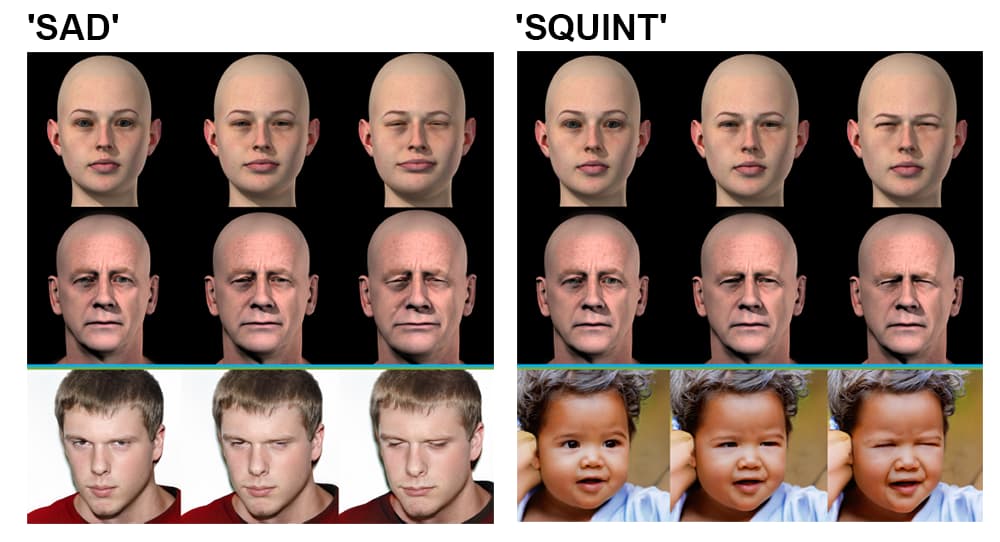

Delta-GAN-kooderi. Ylävasen ryhmä: lähdekuvan kulmaa voidaan muuttaa sekunnissa, jolloin saadaan uusi lähdekuva, joka heijastuu ulostulossa; yläoikea ryhmä: valaistus on myös erotettu identiteetistä, mikä mahdollistaa valaistustyylien päällekkäisyyden; alavasen ryhmä: useita kasvojen yksityiskohtia muutetaan "surullisen" ilmeen luomiseksi; alaoikea ryhmä: yksittäinen ilmeen yksityiskohta muutetaan niin, että silmät siristelevät.

Tämä identiteetin ja kontekstin erottaminen saavutetaan koulutusvaiheessa. Uuden deepfake-arkkitehtuurin putkisto etsii piilevää vektoria esikoulutetussa GAN-verkossa (Generative Adversarial Network), joka vastaa muunnettavaa kuvaa – Sim2Real-metodologia, joka perustuu vuoden 2018 malliin. projekti IBM:n AI-tutkimusosastosta.

Tutkijat havaitsevat:

"Vain muutamalla näytteellä, jotka eroavat tietyn ominaisuuden suhteen, voidaan oppia esikoulutetun kietoutuvan generatiivisen mallin irrotettu käyttäytyminen. Tämän tavoitteen saavuttamiseksi ei tarvita tarkkoja reaalimaailman näytteitä, mikä ei välttämättä ole mahdollista.

"Käyttämällä epärealistisia datanäytteitä sama tavoite voidaan saavuttaa koodattujen latenttien vektoreiden semantiikan hyödyntämisen ansiosta. Haluttujen muutosten soveltaminen olemassa oleviin tietonäytteisiin voidaan tehdä ilman erityistä piilevän avaruuden käyttäytymisen tutkimista.

Tutkijat odottavat, että hankkeessa tutkitut irrotuksen ydinperiaatteet voitaisiin siirtää muille alueille, kuten sisustusarkkitehtuurin simulaatioihin, ja että Delta-GAN-Encoderiin hyväksytty Sim2Real-menetelmä voisi lopulta mahdollistaa syvän väärennösinstrumenttien, jotka perustuvat pelkkään luonnokseen. CGI-tyylinen syöttö.

Voidaan väittää, että se, missä määrin uusi israelilainen järjestelmä voi tai ei pysty syntetisoimaan deepfake-videoita, on paljon vähemmän merkittävää kuin tutkimuksen edistyminen kontekstin irrottamisessa identiteetistä, jolloin saadaan enemmän hallintaa piilevää tilaa kohtaan. GAN:sta.

Disetanglement on aktiivinen kuvasynteesin tutkimusala; tammikuussa 2021 Amazonin johtama tutkimus paperi osoitti samanlaista asennonhallintaa ja irrottamista, ja vuonna 2018 a paperi Kiinan tiedeakatemian Shenzhenin edistyneen teknologian instituuteista edistyi mielivaltaisten näkökulmien luomisessa GANissa.