Tehisintellekt

Laama 2: sügav sukeldumine avatud lähtekoodiga Challengeri ChatGPT-sse

Suured keelemudelid (LLM-id), mis on võimelised täitma keerulisi arutlusülesandeid, on osutunud paljulubavaks spetsiaalsetes valdkondades, nagu programmeerimine ja loominguline kirjutamine. LLM-ide maailm ei ole aga lihtsalt plug-and-play paradiis; väljakutseid on kasutatavuse, ohutuse ja arvutusnõuete osas. Selles artiklis sukeldume sügavale selle võimalustesse Laama 2, pakkudes samal ajal üksikasjalikku ülevaadet selle suure jõudlusega LLM-i seadistamiseks Google Colabi Hugging Face ja T4 GPU-de kaudu.

Meta koostöös Microsoftiga välja töötatud avatud lähtekoodiga suure keelemudeli eesmärk on uuesti määratleda generatiivse AI ja loomuliku keele mõistmise valdkonnad. Llama 2 ei ole lihtsalt järjekordne statistiline mudel, mis on treenitud terabaitidel andmetel; see on filosoofia kehastus. Üks, mis rõhutab avatud lähtekoodiga lähenemisviisi kui AI arendamise selgroogu, eriti generatiivses AI-ruumis.

Llama 2 ja selle dialoogi jaoks optimeeritud aseaine Llama 2-Chat on varustatud kuni 70 miljardi parameetriga. Need läbivad peenhäälestusprotsessi, mille eesmärk on viia need tihedalt vastavusse inimeste eelistustega, muutes need turvalisemaks ja tõhusamaks kui paljud teised avalikult kättesaadavad mudelid. See peenhäälestuse detailsuse tase on sageli reserveeritud suletud "toote" LLM-idele, nagu näiteks ChatGPT ja BARD, mis pole üldiselt avalikuks kontrolliks ega kohandamiseks saadaval.

Laama 2 tehniline sügavsukeldumine

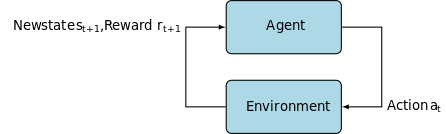

Llama 2 mudeli treenimiseks; nagu tema eelkäijad, kasutab see autoregressiivset trafo arhitektuur, mis on eelnevalt koolitatud ulatusliku isejärelevalve andmekogu põhjal. Siiski lisab see täiendava keerukuse kihi, kasutades inimtagasiside abil õppimist (RLHF), et paremini kooskõlastada inimeste käitumist ja eelistusi. See on arvutuslikult kulukas, kuid oluline mudeli ohutuse ja tõhususe parandamiseks.

Eelkoolitus ja andmete tõhusus

Llama 2 põhiline uuendus seisneb treeningueelses režiimis. Mudel võtab oma eelkäija Llama 1 näpunäiteid, kuid sisaldab mitmeid olulisi täiustusi selle jõudluse tõstmiseks. Eelkõige paistavad silma treenitud žetoonide koguarvu 40% suurenemine ja konteksti pikkuse kahekordne suurenemine. Lisaks kasutab mudel grupeeritud päringu tähelepanu (GQA), et võimendada järelduste skaleeritavust.

Järelevalve peenhäälestus (SFT) ja tugevdav õpe inimese tagasisidega (RLHF)

Llama-2-vestlust on põhjalikult viimistletud nii SFT kui ka RLHF-i (Inforcement Learning with Human Feedback) abil. Selles kontekstis on SFT RLHF-i raamistiku lahutamatu osa, täpsustades mudeli vastuseid, et need oleksid tihedalt vastavuses inimeste eelistuste ja ootustega.

OpenAI on esitanud põhjaliku illustratsiooni, mis selgitab InstructGPT-s kasutatavaid SFT ja RLHF metoodikaid. Sarnaselt LLaMa 2-ga kasutab InstructGPT ka neid täiustatud koolitustehnikaid oma mudeli jõudluse optimeerimiseks.

Alloleval pildil olev 1. samm keskendub kontrollitud peenhäälestamisele (SFT), samas kui järgnevad sammud viivad lõpule inimese tagasisidest õppimise tugevdamise (RLHF) protsessi.

Järelevalve peenhäälestus (SFT) on spetsiaalne protsess, mille eesmärk on optimeerida eelkoolitatud Large Language Model (LLM) konkreetse allavoolu ülesande jaoks. Erinevalt järelevalveta meetoditest, mis ei nõua andmete valideerimist, kasutab SFT andmestikku, mis on eelnevalt valideeritud ja märgistatud.

Üldiselt on nende andmekogumite koostamine kulukas ja aeganõudev. Laama 2 lähenemine oli kvaliteet kvantiteedi ees. Vaid 27,540 XNUMX annotatsiooniga saavutas Meta meeskond jõudlustaseme, mis on konkurentsivõimeline inimannotaatoritega. See ühtib hästi hiljutised uuringud näitab, et isegi piiratud, kuid puhtad andmestikud võivad anda kvaliteetseid tulemusi.

SFT-protsessis puutub eelkoolitatud LLM kokku märgistatud andmekogumiga, kus mängu tulevad juhendatud õppealgoritmid. Mudeli sisemised kaalud kalibreeritakse ümber ülesandespetsiifilise kadufunktsiooni põhjal arvutatud gradientide põhjal. See kadufunktsioon kvantifitseerib lahknevused mudeli prognoositud väljundite ja tegelike tõepõhiste siltide vahel.

See optimeerimine võimaldab LLM-il mõista keerukaid mustreid ja nüansse, mis on manustatud märgistatud andmekogumisse. Järelikult ei ole mudel lihtsalt üldistatud tööriist, vaid see areneb spetsiaalseks varaks, mis suudab sihtülesande suure täpsusega täita.

Tugevdamine õppimine on järgmine samm, mille eesmärk on viia mudeli käitumine paremini vastavusse inimeste eelistustega.

Häälestamise faas kasutas RLHF-i (Inforcement Learning from Human Feedback), kasutades selliseid tehnikaid nagu Tähtsuse valimi võtmine ja Proksimaalne poliitika optimeerimine Algoritmilise müra sisseviimiseks, vältides seeläbi kohalikku optimumit. See iteratiivne peenhäälestus mitte ainult ei parandanud mudelit, vaid viis selle väljundi vastavusse ka inimeste ootustega.

Llama 2-Chat kasutas inimeste eelistuste andmete kogumiseks binaarset võrdlusprotokolli, mis tähistas märkimisväärset suundumust kvalitatiivsemate lähenemisviiside poole. See mehhanism teavitas preemiamudeleid, mida seejärel kasutatakse vestlusliku AI mudeli täpsustamiseks.

Ghost Attention: mitme pöördega dialoogid

Meta tutvustas uut funktsiooni Ghost Attention (GAtt), mis on loodud suurendama Llama 2 jõudlust mitme pöördega dialoogides. See lahendab tõhusalt pideva konteksti kadumise probleemi käimasolevates vestlustes. GAtt toimib nagu ankur, ühendades esialgsed juhised kõigi järgnevate kasutajateadetega. Koos tugevdavate õppemeetoditega aitab see pikemate dialoogide ajal luua järjepidevaid, asjakohaseid ja kasutajale kohandatud vastuseid.

Meta Giti hoidlast, kasutades download.sh

- Külastage Meta veebisaiti: Navigeerimine Meta ametlik Llama 2 sait ja klõpsake nuppu "Laadi mudel alla"

- Täitke üksikasjad: jätkamiseks lugege läbi ja nõustuge tingimustega.

- e-maili kinnitus: kui vorm on esitatud, saate Metalt meili lingiga mudeli allalaadimiseks nende git-hoidlast.

- Käivitage download.sh: Kloonige Giti hoidla ja käivitage

download.shstsenaarium. See skript palub teil autentida, kasutades Meta URL-i, mis aegub 24 tunni pärast. Samuti saate valida mudeli suuruse – 7B, 13B või 70B.

Kallistavast näost

- Saate vastuvõtumeili: Pärast Meta juurdepääsu saamist minge aadressile Kallistav nägu.

- Taotle juurdepääsu: valige soovitud mudel ja esitage juurdepääsu andmise taotlus.

- Kinnitus: oodake "antud juurdepääsu" meili 1–2 päeva jooksul.

- Juurdepääsulubade loomine: Juurdepääsulubade loomiseks liikuge oma Hugging Face'i kontol jaotisse "Seaded".

Transformers 4.31 väljalase ühildub täielikult LLaMa 2-ga ja avab Hugging Face ökosüsteemis palju tööriistu ja funktsioone. Tööriistakomplekt on ulatuslik, alates treenimisest ja järeldusskriptidest kuni 4-bitise kvantiseerimiseni bittide ja baitide ja parameetritõhusa peenhäälestusega (PEFT). Alustamiseks veenduge, et kasutaksite uusimat Transformeri väljalaset ja logiksite sisse oma Hugging Face kontole.

Siin on lihtsustatud juhend LLaMa 2 mudeli järelduste tegemiseks a google colab keskkond, kasutades GPU käitusaega:

Paketi paigaldamine

!pip install transformers !huggingface-cli login

Importige vajalikud Pythoni teegid.

from transformers import AutoTokenizer import transformers import torch

Mudeli ja tokenisaatori lähtestamine

Selles etapis määrake, millist Llama 2 mudelit kasutate. Selle juhendi jaoks kasutame meta-llama/Llama-2-7b-chat-hf.

model = "meta-llama/Llama-2-7b-chat-hf" tokenizer = AutoTokenizer.from_pretrained(model)

Seadistage torujuhe

Kasutage konkreetsete sätetega teksti genereerimiseks Hugging Face torujuhet.

pipeline = transformers.pipeline(

"text-generation",

model=model,

torch_dtype=torch.float16,

device_map="auto")

Loo tekstijadasid

Lõpuks käivitage konveier ja looge sisendi põhjal tekstijada:

sequences = pipeline(

'Who are the key contributors to the field of artificial intelligence?\n',

do_sample=True,

top_k=10,

num_return_sequences=1,

eos_token_id=tokenizer.eos_token_id,

max_length=200)

for seq in sequences:

print(f"Result: {seq['generated_text']}")

A16Z kasutajaliides LLaMa 2 jaoks

Andreessen Horowitz (A16Z) tõi hiljuti turule tipptasemel Streamliti-põhise vestlusroti liidese, mis on kohandatud Llama 2 jaoks. GitHubis hostitud kasutajaliides säilitab seansi vestluste ajaloo ja pakub ka paindlikkust, et valida mitme Llama 2 API lõpp-punkti vahel, mida hostitakse Korda. Selle kasutajakeskse disaini eesmärk on lihtsustada suhtlemist Llama 2-ga, muutes selle ideaalseks tööriistaks nii arendajatele kui ka lõppkasutajatele. Neile, kes on sellest huvitatud, on reaalajas demo saadaval aadressil Llama2.ai.

Llama 2: mille poolest see erineb GPT mudelitest ja selle eelkäijast Llama 1-st?

Skaala mitmekesisus

Erinevalt paljudest keelemudelitest, mis pakuvad piiratud skaleeritavust, pakub Llama 2 teile hunniku erinevaid võimalusi erinevate parameetritega mudelite jaoks. Mudel ulatub 7 miljardist 70 miljardi parameetrini, pakkudes seeläbi mitmesuguseid konfiguratsioone, mis vastavad erinevatele arvutusvajadustele.

Täiustatud konteksti pikkus

Mudelil on suurem kontekstipikkus 4K märgid kui Llama 1-l. See võimaldab säilitada rohkem teavet, parandades seeläbi selle võimet mõista ja luua keerukamat ja ulatuslikumat sisu.

Rühmitatud päringu tähelepanu (GQA)

Arhitektuur kasutab kontseptsiooni GQA, mille eesmärk on kiirendada tähelepanu arvutamise protsessi, salvestades vahemällu varasemad märgipaarid. See parandab tõhusalt mudeli järelduste skaleeritavust, et parandada juurdepääsetavust.

Jõudluskriteeriumid

LLama 2 on seadnud jõudlusmõõdikutes uue standardi. See mitte ainult ei ületa oma eelkäijat LLama 1, vaid pakub märkimisväärset konkurentsi ka teistele mudelitele, nagu Falcon ja GPT-3.5.

Llama 2-Chati suurim mudel 70B ületab samuti ChatGPT-d 36% juhtudest ja vastab jõudlusele veel 31.5% juhtudest. Allikas: Paber

Avatud lähtekoodiga: kogukonna jõud

Meta ja Microsoft kavatsevad, et Llama 2 oleks midagi enamat kui lihtsalt toode; nad näevad seda kogukonna juhitud tööriistana. Llama 2 on tasuta juurdepääsetav nii teadusuuringuteks kui ka mitteärilistel eesmärkidel. Nende eesmärk on demokratiseerida tehisintellekti võimekust, muutes selle kättesaadavaks idufirmadele, teadlastele ja ettevõtetele. Avatud lähtekoodiga paradigma võimaldab mudeli nn rahvapõhise tõrkeotsingut. Arendajad ja tehisintellekti eetikud saavad kiiremas tempos stressitestida, tuvastada haavatavusi ja pakkuda lahendusi.

Kuigi LLaMa 2 litsentsitingimused on üldiselt lubavad, erandid on olemas. Suured ettevõtted, millel on üle 700 miljoni igakuise kasutaja, nagu Google, nõuavad selle kasutamiseks Meta selgesõnalist luba. Lisaks keelab litsents LLaMa 2 kasutamise teiste keelemudelite täiustamiseks.

Praegused väljakutsed Llama 2-ga

- Andmete üldistamine: Nii Llama 2 kui ka GPT-4 on mõnikord ebaühtlaselt kõrge jõudlusega erinevates ülesannetes. Andmete kvaliteet ja mitmekesisus on nende stsenaariumide puhul sama olulised kui maht.

- Mudeli läbipaistvus: Võttes arvesse varasemaid tagasilööke, kui tehisintellekt toodab eksitavaid väljundeid, on nende keeruliste mudelite taga olevate otsuste tegemise põhjuste uurimine ülimalt oluline.

Code Llama – Meta uusim lanss

Meta teatas hiljuti Koodlaama mis on programmeerimisele spetsialiseerunud suur keelemudel, mille parameetrite suurus on vahemikus 7B kuni 34B. Sarnane ChatGPT kooditõlk; Code Llama saab arendaja töövoogusid sujuvamaks muuta ja programmeerimise ligipääsetavamaks muuta. See mahutab erinevaid programmeerimiskeeli ja on saadaval spetsiaalsetes variatsioonides, näiteks Code Llama–Python Pythoni spetsiifiliste ülesannete jaoks. Mudel pakub ka erinevaid jõudlustasemeid, et vastata erinevatele latentsusnõuetele. Avatud litsentsiga Code Llama kutsub kogukonda pidevalt täiustama.

Tutvustame kodeerimiseks mõeldud tehisintellekti tööriista Code Llama

Järeldus

See artikkel juhendab teid, kuidas seadistada Llama 2 mudel teksti genereerimiseks Google Colabis koos Kallistava näo toega. Llama 2 jõudlust soodustavad mitmed täiustatud tehnikad alates autoregressiivsetest trafoarhitektuuridest kuni inimtagasiside abil õppimiseni (RLHF). Kuni 70 miljardi parameetri ja funktsiooniga, nagu Ghost Attention, ületab see mudel teatud valdkondades praegusi tööstusstandardeid ning oma avatud olemusega sillutab teed loomuliku keele mõistmise ja generatiivse AI uuele ajastule.