Tehisintellekt

Täielik juhend suurte keelemudelite peenhäälestamiseks

Sisukord

Suured keelemudelid (LLM-id), nagu GPT-4, LaMDA, PaLM ja teised, on maailma vallutanud oma tähelepanuväärse võimega mõista ja luua inimsarnast teksti paljudel teemadel. Need mudelid on eelnevalt koolitatud tohutute andmekogumite jaoks, mis sisaldavad miljardeid sõnu Internetist, raamatutest ja muudest allikatest.

See koolituseelne faas annab mudelitele ulatuslikud üldised teadmised keele, teemade, arutlusvõime ja isegi teatud koolitusandmetes esinevate eelarvamuste kohta. Vaatamata nende uskumatule laiusele puudub neil eelkoolitatud LLM-idel aga eriteadmised konkreetsete domeenide või ülesannete jaoks.

Siin tulebki sisse peenhäälestus – eelkoolitatud LLM-i kohandamise protsess, et see eristuks konkreetse rakenduse või kasutusjuhtumiga. Mudeli edasiõppimisel väiksemal ülesandespetsiifilisel andmekogumil saame häälestada selle võimalusi selle domeeni nüansside ja nõuetega vastavusse viimiseks.

Peenhäälestus on analoogne kõrgelt haritud generalisti laiaulatuslike teadmiste ülekandmisega teatud valdkonnale spetsialiseerunud aineeksperdi meisterdamiseks. Selles juhendis uurime LLM-ide peenhäälestamist, mida, miks ja kuidas.

Mis on peenhäälestus?

Selle põhiosas peenhäälestus hõlmab suure eelkoolitatud mudeli võtmist ja selle parameetrite värskendamist, kasutades teist koolitusetappi teie sihtülesandele või domeenile kohandatud andmekogumil. See võimaldab mudelil õppida ja sisestada selle kitsama valdkonna nüansse, mustreid ja eesmärke.

Kui eelkoolitus haarab laiaulatusliku keeleoskuse suurest ja mitmekesisest tekstikorpusest, siis peenhäälestus spetsialiseerub sellele üldisele pädevusele. See sarnaneb renessansiajastu mehe võtmisega ja temast tööstuse eksperdi vormimisega.

Peenhäälestusprotsessi lähtepunktina või lähtepunktina kasutatakse eelkoolitatud mudeli kaalusid, mis kodeerivad selle üldteadmisi. Seejärel koolitatakse mudelit edasi, kuid seekord lõpprakendusega otseselt seotud näidete põhjal.

Mudeli selle spetsiaalse andmejaotuse eksponeerimisega ja mudeli parameetrite vastavalt häälestamisega muudame LLM-i sihtotstarbelise kasutusjuhtumi jaoks täpsemaks ja tõhusamaks, saades samas kasu laiaulatuslikest eelkoolitatud võimalustest.

Miks Fine-Tune LLM-id?

Suure keelemudeli viimistlemiseks on mitu peamist põhjust.

- Domeeni kohandamine: Igal valdkonnal õigusteadusest meditsiini ja tarkvaratehnikani on oma nüansirikkad keelereeglid, žargoon ja kontekst. Peenhäälestus võimaldab teil kohandada üldist mudelit, et mõista ja luua konkreetsele domeenile kohandatud teksti.

- Ülesande spetsialiseerumine: LLM-e saab peenhäälestada erinevate loomuliku keele töötlemise ülesannete jaoks, nagu teksti kokkuvõte, masintõlge, küsimustele vastamine ja nii edasi. See spetsialiseerumine suurendab jõudlust sihtülesande täitmisel.

- Andmete vastavus: rangelt reguleeritud tööstusharudel, nagu tervishoid ja rahandus, kehtivad ranged andmekaitsenõuded. Peenhäälestus võimaldab koolitada LLM-e varaliste organisatsiooniandmete alal, kaitstes samal ajal tundlikku teavet.

- Piiratud märgistatud andmed: Suurte märgistatud andmekogumite hankimine koolitusmudelite jaoks nullist võib olla keeruline. Peenhäälestus võimaldab saavutada tugevat ülesannete jõudlust piiratud järelevalvega näidete põhjal, kasutades selleks eelnevalt koolitatud mudeli võimalusi.

- Mudeli värskendamine: kui domeenis muutuvad aja jooksul kättesaadavaks uued andmed, saate mudeleid veelgi täpsustada, et kaasata uusimad teadmised ja võimalused.

- Eelarvamuste leevendamine: LLM-id saavad laiaulatuslikest koolituseelsetest andmetest välja tuua ühiskondlikud eelarvamused. Kureeritud andmekogumite peenhäälestus võib aidata neid soovimatuid eelarvamusi vähendada ja parandada.

Sisuliselt ületab peenhäälestus lõhe üldise, laiaulatusliku mudeli ja spetsiaalse rakenduse keskendunud nõuete vahel. See suurendab mudeli väljundite täpsust, ohutust ja asjakohasust sihtotstarbeliste kasutusjuhtude jaoks.

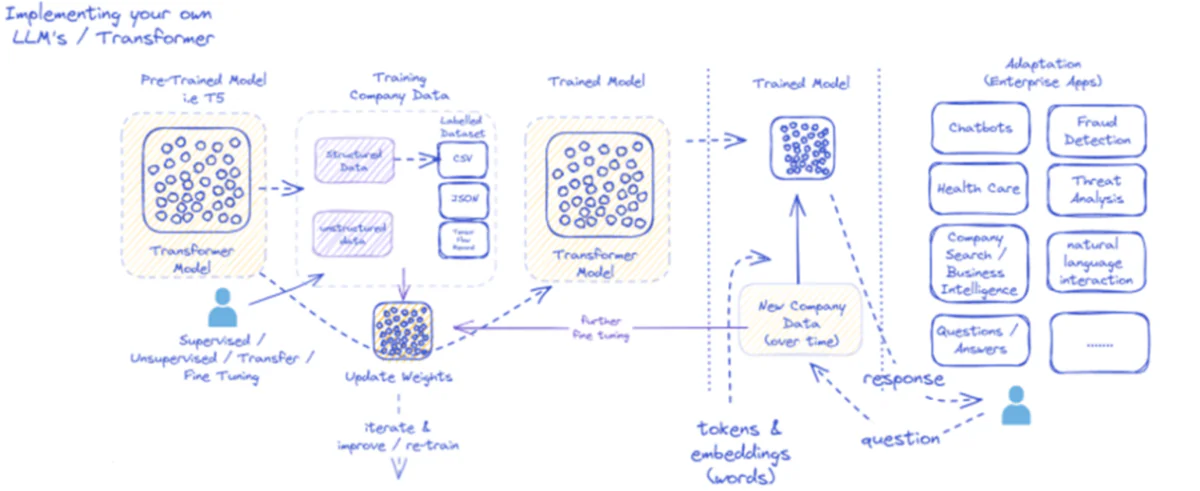

Kaasasolev diagramm kirjeldab suurte keelemudelite (LLM) juurutamise ja kasutamise protsessi, mis on mõeldud spetsiaalselt ettevõtte rakenduste jaoks. Esialgu toidetakse eelkoolitatud mudelile nagu T5 struktureeritud ja struktureerimata ettevõtte andmeid, mis võivad olla erinevates vormingutes, nagu CSV või JSON. Need andmed läbivad järelevalve all, järelevalveta või ülekandmise peenhäälestusprotsesse, suurendades mudeli vastavust ettevõtte konkreetsetele vajadustele.

Kui mudel on ettevõtte andmetega peenhäälestatud, värskendatakse selle kaalusid vastavalt. Koolitatud mudel kordub seejärel edasiste koolitustsüklite kaudu, parandades aja jooksul pidevalt oma vastuseid uute ettevõtteandmetega. Protsess on iteratiivne ja dünaamiline koos mudeli õppimise ja ümberõppega, et kohaneda arenevate andmemustritega.

Selle koolitatud mudeli väljundit – sõnu esindavad märgid ja manustused – kasutatakse seejärel mitmesugustes ettevõtte rakendustes. Need rakendused võivad ulatuda vestlusrobotidest kuni tervishoiuteenusteni, millest igaüks nõuab, et mudel mõistaks tööstusharu spetsiifilisi päringuid ja vastaks neile. Rahanduses hõlmavad rakendused pettuste tuvastamist ja ohtude analüüsi; tervishoius võivad mudelid aidata patsiendi päringuid ja diagnostikat.

Koolitatud mudeli suutlikkus aja jooksul uusi ettevõtte andmeid töödelda ja neile reageerida tagab selle kasulikkuse püsimise ja kasvu. Selle tulemusena saavad ettevõtte kasutajad mudeliga rakenduste kaudu suhelda, küsida küsimusi ja saada teadlikke vastuseid, mis kajastavad mudeli koolitust ja domeenispetsiifiliste andmete peenhäälestamist.

See infrastruktuur toetab laias valikus ettevõtte rakendusi, mis näitab LLM-ide mitmekülgsust ja kohanemisvõimet, kui neid õigesti rakendatakse ja ärikontekstis hooldatakse.

Peenhäälestusmeetodid

Suurte keelemudelite viimistlemisel on kaks peamist strateegiat:

1) Mudeli täielik peenhäälestus

Täieliku peenhäälestusmeetodi korral värskendatakse teise treeningfaasi ajal kõiki eelkoolitatud mudeli parameetreid (kaalud ja nihked). Mudel puutub kokku ülesandepõhise märgistatud andmekogumiga ja standardne koolitusprotsess optimeerib kogu mudeli selle andmejaotuse jaoks.

See võimaldab mudelil teha põhjalikumaid kohandusi ja kohaneda terviklikult sihtülesande või domeeniga. Täielikul peenhäälestamisel on aga mõned varjuküljed:

- Selle treenimiseks on vaja märkimisväärseid arvutusressursse ja aega, sarnaselt koolituseelsele etapile.

- Salvestusnõuded on kõrged, kuna iga ülesande jaoks peate säilitama mudeli eraldi viimistletud koopia.

- Esineb „katastroofilise unustamise“ oht, kus peenhäälestuse tõttu kaotab mudel mõningad eelkoolituse käigus õpitud üldised võimed.

Nendest piirangutest hoolimata jääb täielik peenhäälestus võimsaks ja laialdaselt kasutatavaks tehnikaks, kui ressursid seda võimaldavad ja sihtülesanne erineb oluliselt üldkeelest.

2) Tõhusad peenhäälestusmeetodid

Täieliku peenhäälestusega seotud arvutuslike väljakutsete ületamiseks on teadlased välja töötanud tõhusad strateegiad, mis värskendavad peenhäälestuse ajal ainult väikest mudeli parameetrite alamhulka. Need parameetriliselt tõhusad tehnikad loovad tasakaalu spetsialiseerumise ja ressursivajaduse vähendamise vahel.

Mõned populaarsed tõhusad peenhäälestusmeetodid on järgmised:

Prefiksi häälestamine: Siin tutvustatakse ja treenitakse väikest arvu ülesandespetsiifilisi vektoreid või "eesliiteid", et suunata eelkoolitatud mudeli tähelepanu sihtülesandele. Peenhäälestuse käigus värskendatakse ainult neid eesliiteid.

LoRA (madala asetusega kohanemine): LoRA süstib peenhäälestuse käigus eelnevalt treenitud mudeli igasse kihti treenitavad madala astme maatriksid. Need väikesed kohandused aitavad spetsialiseeruda mudelile, millel on palju vähem treenitavaid parameetreid kui täielik peenhäälestus.

Muidugi võin anda LoRA (madala taseme kohanemise) üksikasjaliku selgituse koos matemaatilise sõnastuse ja koodinäidetega. LoRA on populaarne parameetripõhise peenhäälestuse (PEFT) tehnika, mis on suure keelemudeli (LLM) kohandamise valdkonnas saavutanud märkimisväärse tõmbe.

Mis on LoRA?

LoRA on peenhäälestusmeetod, mis tutvustab eelkoolitatud LLM-ile väikest arvu treenitavaid parameetreid, võimaldades tõhusalt kohaneda järgnevate ülesannetega, säilitades samal ajal suurema osa algse mudeli teadmistest. Selle asemel, et kõiki LLM-i parameetreid peenhäälestada, sisestab LoRA mudeli kihtidesse ülesandespetsiifilised madala asetusega maatriksid, mis võimaldab peenhäälestusprotsessi ajal märkimisväärset arvutus- ja mälusäästu.

Matemaatiline formuleerimine

LoRA (Low-Rank Adaptation) on suurte keelemudelite (LLM) peenhäälestusmeetod, mis tutvustab kaalumaatriksite madala astme värskendust. Kaalumaatriksi jaoks 0∈W0∈Rd×k, lisab LoRA madala astme maatriksi BAKoos A∈Rr×k ja B∈Rd×r, Kus r on auaste. Selline lähenemine vähendab oluliselt treenitavate parameetrite arvu, võimaldades minimaalsete arvutusressurssidega tõhusalt kohaneda järgnevate ülesannetega. Uuendatud kaalumaatriksi annab W=W0+B⋅A.

Seda madala asetusega värskendust võib tõlgendada kui algse kaalumaatriksi $W_{0}$ muutmist, lisades madala asetusega maatriksi $BA$. Selle sõnastuse peamine eelis on see, et kõigi $d \times k$ parameetrite värskendamise asemel $W_{0}$, peab LoRA optimeerima ainult $r \times (d + k)$ parameetrid $A$ ja $B $, vähendades oluliselt treenitavate parameetrite arvu.

Siin on näide Pythonis, kasutades peft raamatukogu, et rakendada LoRA-d teksti klassifitseerimiseks eelkoolitatud LLM-ile:

</div> <div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color="">from</span> transformers <span class="token" data-darkreader-inline-color="">import</span> AutoModelForSequenceClassification </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color="">from</span> peft <span class="token" data-darkreader-inline-color="">import</span> get_peft_model<span class="token" data-darkreader-inline-color="">,</span> LoraConfig<span class="token" data-darkreader-inline-color="">,</span> TaskType </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Load pre-trained model</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">model <span class="token" data-darkreader-inline-color="">=</span> AutoModelForSequenceClassification<span class="token" data-darkreader-inline-color="">.</span>from_pretrained<span class="token" data-darkreader-inline-color="">(</span><span class="token" data-darkreader-inline-color="">"bert-base-uncased"</span><span class="token" data-darkreader-inline-color="">,</span> num_labels<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">2</span><span class="token" data-darkreader-inline-color="">)</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Define LoRA configuration</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">peft_config <span class="token" data-darkreader-inline-color="">=</span> LoraConfig<span class="token" data-darkreader-inline-color="">(</span>task_type<span class="token" data-darkreader-inline-color="">=</span>TaskType<span class="token" data-darkreader-inline-color="">.</span>SEQ_CLS<span class="token" data-darkreader-inline-color="">, </span>r<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">8</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color=""># Rank of the low-rank update</span> lora_alpha<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">16</span><span class="token" data-darkreader-inline-color="">,</span></code><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Scaling factor for the low-rank update</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""> target_modules<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">[</span><span class="token" data-darkreader-inline-color="">"q_lin"</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color="">"v_lin"</span><span class="token" data-darkreader-inline-color="">]</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color=""># Apply LoRA to the query and value layers</span> <span class="token" data-darkreader-inline-color="">)</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Create the LoRA-enabled model</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">model <span class="token" data-darkreader-inline-color="">=</span> get_peft_model<span class="token" data-darkreader-inline-color="">(</span>model<span class="token" data-darkreader-inline-color="">,</span> peft_config<span class="token" data-darkreader-inline-color="">)</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Fine-tune the model with LoRA</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># ... (training code omitted for brevity)</span></code></div> </div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">

Selles näites laadime järjestuse klassifitseerimiseks eelkoolitatud BERT-mudeli ja määratleme LoRA konfiguratsiooni. The r parameeter määrab madala asetusega värskenduse auastme ja lora_alpha on värskenduse skaleerimistegur. The target_modules parameeter näitab, millised mudeli kihid peaksid saama madala taseme värskendusi. Pärast LoRA-toega mudeli loomist saame jätkata peenhäälestusprotsessi, kasutades standardset koolitusprotseduuri.

Adapterikihid: Sarnaselt LoRA-ga, kuid madala tasemega värskenduste asemel sisestatakse eelkoolitatud mudeli igasse trafoplokki õhukesed „adapteri” kihid. Treenitakse ainult nende mõne uue kompaktse kihi parameetreid.

Kiire häälestamine: Selline lähenemine hoiab eelkoolitatud mudeli täielikult külmununa. Selle asemel võetakse sisendina kasutusele koolitatavad "viipased" manustused, et aktiveerida mudeli eelkoolitatud teadmised sihtülesande jaoks.

Need tõhusad meetodid võivad täieliku peenhäälestusega võrreldes vähendada arvutusi kuni 100 korda, saavutades samas paljude ülesannete puhul konkurentsivõimelise jõudluse. Nad vähendavad ka salvestusvajadusi, vältides mudeli täielikku dubleerimist.

Kuid nende toimivus võib jääda maha täielikust peenhäälestusest ülesannete jaoks, mis erinevad oluliselt üldkeelest või nõuavad terviklikumat spetsialiseerumist.

Peenhäälestusprotsess

Sõltumata peenhäälestusstrateegiast järgib LLM-i spetsialiseerumise üldine protsess üldist raamistikku:

- Andmestiku ettevalmistamine: peate hankima või looma märgistatud andmestiku, mis vastendab sisendid (viibad) teie sihtülesande soovitud väljunditega. Teksti genereerimise ülesannete (nt kokkuvõte) puhul oleks see sisendtekst kokkuvõtlike väljundpaaride jaoks.

- Andmekogumi poolitamine: parimaid tavasid järgides jagage oma märgistatud andmestik rongi-, valideerimis- ja testikomplektideks. See eraldab andmed mudeli koolituse, hüperparameetrite häälestamise ja lõpliku hindamise jaoks.

- Hüperparameetrite häälestamine: Andmete kõige tõhusamaks peenhäälestamiseks tuleb häälestada parameetreid, nagu õppimiskiirus, partii suurus ja treeningu ajakava. Tavaliselt hõlmab see väikest valideerimiskomplekti.

- Mudelikoolitus: Kasutades häälestatud hüperparameetreid, käivitage täieliku treeningkomplekti optimeerimise peenhäälestusprotsess, kuni mudeli jõudlus valideerimiskomplektis lakkab paranemast (varajane peatumine).

- Hindamine: Hinnake peenhäälestatud mudeli toimivust väljalükatud testikomplektis, mis ideaaljuhul sisaldab sihtotstarbelise kasutusjuhtumi jaoks reaalseid näiteid, et hinnata tegelikku tõhusust.

- Kasutuselevõtt ja seire: kui see on rahuldav, saab peenhäälestatud mudelit kasutada uute sisendite kohta järelduste tegemiseks. Kontseptsiooni muutmiseks on ülioluline jälgida selle jõudlust ja täpsust aja jooksul.

Kuigi see kirjeldab üldist protsessi, võivad paljud nüansid mõjutada konkreetse LLM-i või ülesande edukust. Sellised strateegiad nagu õppekava õppimine, mitme ülesandega peenhäälestus ja mõne võttega viipamine võivad jõudlust veelgi suurendada.

Lisaks hõlmavad tõhusad peenhäälestusmeetodid lisakaalutlusi. Näiteks nõuab LoRA selliseid tehnikaid nagu eelkoolitatud mudeliväljundite konditsioneerimine läbi kombineeritud kihi. Kiire häälestamine vajab õige käitumise aktiveerimiseks hoolikalt kavandatud viipasid.

Täiustatud peenhäälestus: inimeste tagasiside kaasamine

Kuigi standardne järelevalvega peenhäälestus märgistatud andmekogumite abil on tõhus, on põnevaks piiriks LLM-ide koolitamine otse, kasutades inimeste eelistusi ja tagasisidet. See in-the-loop lähenemisviis kasutab tugevdamise õppimise tehnikaid:

PPO (Proksimaalne poliitika optimeerimine): Siin käsitletakse LLM-i kui tugevdavat õppeagenti, mille väljundid on "tegevused". Preemiamudel on koolitatud ennustama nende väljundite inimeste hinnanguid või kvaliteediskoore. Seejärel optimeerib PPO LLM-i, et genereerida väljundid, mis maksimeerivad tasu mudeli skoori.

RLHF (Inimeste tagasisidest õppimise tugevdamine): See laiendab PPO-d, kaasates õppeprotsessi otseselt inimeste tagasisidet. Fikseeritud tasu mudeli asemel saadakse tasu LLM-i väljundite iteratiivsetest inimhinnangutest peenhäälestuse käigus.

Ehkki need meetodid on arvutusmahukad, võimaldavad need LLM-i käitumist täpsemalt kujundada, lähtudes inimeste poolt hinnatud soovitud omadustest, lisaks sellele, mida saab staatilises andmekogumis salvestada.

Sellised ettevõtted nagu Anthropic kasutasid RLHF-i, et oma keelemudeleid, nagu Claude, täiustada tõepärasuse, eetika- ja ohutusteadlikkusega peale lihtsalt ülesannete pädevuse.

Võimalikud riskid ja piirangud

Kuigi LLM-id on tohutult võimsad, ei ole nende peenhäälestus riskideta, mida tuleb hoolikalt hallata:

Kallutatuse võimendus: kui peenhäälestusandmed sisaldavad ühiskondlikke eelarvamusi soo, rassi, vanuse või muude atribuutide osas, võib mudel neid soovimatuid eelarvamusi võimendada. Esinduslike ja kallutatud andmekogumite kureerimine on ülioluline.

Faktiline triiv: Isegi pärast kvaliteetsete andmete peenhäälestamist võivad keelemudelid pikemate vestluste või viipade käigus "hallutsineerida" ebaõigeid fakte või koolitusnäidetega vastuolus olevaid väljundeid. Vaja võib olla faktiotsingu meetodeid.

Skaleeritavuse väljakutsed: tohutute mudelite, nagu GPT-3, täielik viimistlemine nõuab tohutuid arvutusressursse, mis ei pruugi paljude organisatsioonide jaoks olla teostatavad. Tõhus peenhäälestus leevendab seda osaliselt, kuid sellel on kompromisse.

Katastroofiline unustamine: Täieliku peenhäälestuse käigus võivad mudelid kogeda katastroofilist unustamist, kus nad kaotavad mõned eelkoolituse käigus õpitud üldised võimed. Vajalik võib olla mitme ülesandega õpe.

IP ja privaatsusriskid: Peenhäälestamiseks kasutatavad varalised andmed võivad lekkida avalikult avaldatud keelemudelite väljunditesse, mis kujutab endast riske. Erinevad privaatsus- ja teabeohtude vähendamise tehnikad on aktiivsed uurimisvaldkonnad.

Üldiselt, kuigi erakordselt kasulik, on peenhäälestus nüansirikas protsess, mis nõuab andmete kvaliteedi, identiteedi kaalutluste, riskide maandamise ja jõudluse ja tõhususe kompromisside tasakaalustamist kasutusjuhtumite nõuete alusel.

Tulevik: keelemudeli kohandamine ulatuslikult

Tulevikku vaadates on peenhäälestus- ja mudeli kohandamise tehnikate edusammud otsustava tähtsusega suurte keelemudelite täieliku potentsiaali vallandamiseks erinevates rakendustes ja valdkondades.

Tõhusamad meetodid, mis võimaldavad piiratud ressurssidega veelgi suuremaid mudeleid, nagu PaLM, viimistleda, võivad juurdepääsu demokratiseerida. Andmekogumi loomise torujuhtmete automatiseerimine ja kiire projekteerimine võivad spetsialiseerumist sujuvamaks muuta.

Enesejärelevalve tehnikad ilma siltideta töötlemata andmete peenhäälestamiseks võivad avada uusi piire. Ja kompositsioonilised lähenemisviisid erinevate ülesannete või andmete jaoks koolitatud peenhäälestatud alammudelite kombineerimiseks võivad võimaldada nõudmisel koostada väga kohandatud mudeleid.

Lõppkokkuvõttes, kuna LLM-id muutuvad kõikjale levivamaks, on kriitilise tähtsusega võimalus neid sujuvalt kohandada ja spetsialiseeruda iga mõeldava kasutusjuhtumi jaoks. Peenhäälestus ja sellega seotud mudeli kohandamise strateegiad on pöördelised sammud, et realiseerida nägemus suurtest keelemudelitest kui paindlikest, ohututest ja võimsatest tehisintellekti abilistest, mis suurendavad inimese võimeid igas valdkonnas ja ettevõtmises.

Olen viimased viis aastat veetnud masinõppe ja süvaõppe põnevasse maailma sukeldudes. Minu kirg ja teadmised on pannud mind panustama enam kui 50 erinevasse tarkvaratehnoloogia projekti, keskendudes eelkõige AI/ML-ile. Minu jätkuv uudishimu on tõmmanud mind ka loomuliku keele töötlemise poole, valdkonda, mida ma innukalt edasi uurin.

Võib meeldida

Kõik, mida peate Llama 3 kohta teadma | Seni võimsaim avatud lähtekoodiga mudel | Kasutamise kontseptsioonid

BlackMamba: Ekspertide segu osariigi-ruumi mudelite jaoks

AI GPT-d PostgreSQL-i andmebaasi jaoks: kas need võivad töötada?

KITS (hea aritmeetikaülesannetes): keeleoskusest matemaatikageeniuseni

Lahing avatud lähtekoodiga ja suletud lähtekoodiga keelemudelite vahel: tehniline analüüs

Suurte keelemudelite hindamine: tehniline juhend

Viimased postitused

- 5. aasta 2024 parimat AI SOP (standardse tööprotseduuri) generaatorit

- SIMA: tehisintellekti agentide suurendamine erinevates virtuaalmaailmades erinevate rakenduste jaoks

- Fredrik Danielsson, Tiny – intervjuusarja peatootejuht

- MaxDiff RL algoritm parandab robotiõpet "kavandatud juhuslikkusega"

- Lalal.ai ülevaade: #1 AI taustamüra eemaldaja?