Inteligencia Artificial

Enrutadores de modelos y la trampa de la retroalimentación: cómo la IA aprende de sí misma

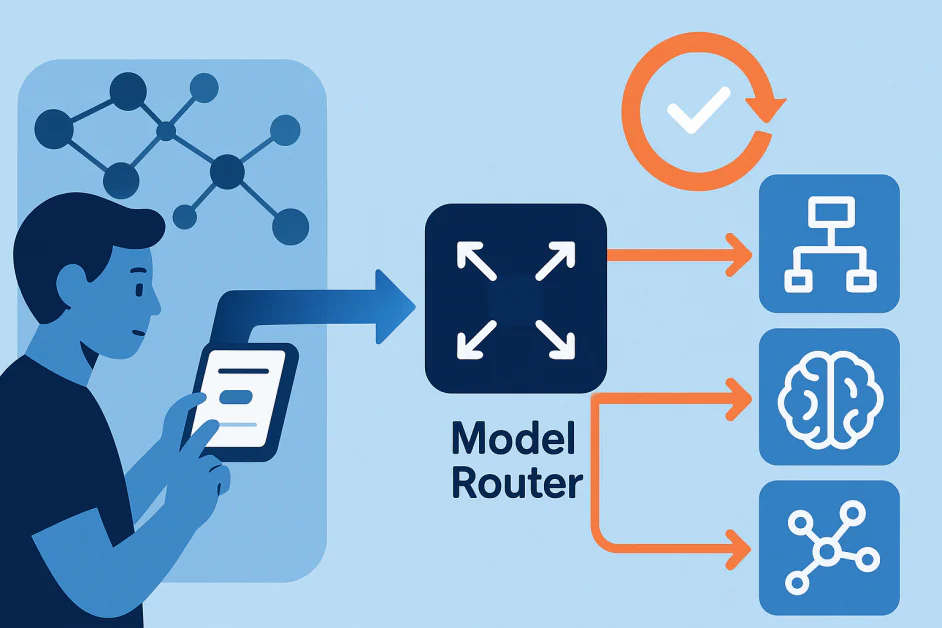

Los sistemas de IA modernos ya no se basan en un único modelo que gestiona todas las tareas. En su lugar, se basan en conjuntos de modelos, cada uno diseñado para fines específicos. En el centro de esta configuración se encuentra el enrutador de modelos, un componente que interpreta la solicitud del usuario y decide qué modelo debe gestionarla. Por ejemplo, en sistemas como GPT-5 de OpenAIUn enrutador podría enviar una consulta simple a un modelo liviano para mayor velocidad y al mismo tiempo enrutar tareas de razonamiento complejas a un modelo más avanzado.

Los enrutadores no son simples administradores de tráfico. Aprenden del comportamiento del usuario, por ejemplo, cuando cambian de modelo o prefieren ciertas respuestas. Esto crea un ciclo: el enrutador asigna la consulta, el modelo genera una respuesta, las reacciones del usuario proporcionan retroalimentación y el enrutador actualiza sus decisiones. Cuando estos ciclos operan silenciosamente en segundo plano, pueden formar bucles de retroalimentación ocultos. Estos bucles pueden amplificar el sesgo, reforzar patrones erróneos o reducir gradualmente el rendimiento de maneras difíciles de detectar.

Este artículo analiza cómo funcionan los enrutadores modelo, cómo surgen los bucles de retroalimentación y qué riesgos plantean a medida que los sistemas de IA continúan evolucionando.

Comprensión de los enrutadores de modelos en IA

A modelo de enrutador Es la capa de toma de decisiones en un sistema de IA multimodelo. Su función es determinar qué modelo se adapta mejor a una tarea. La elección depende de factores como la complejidad de la consulta, la intención del usuario, el contexto y el equilibrio entre coste, precisión y velocidad.

A diferencia de los sistemas que siguen reglas fijas, la mayoría de los enrutadores de modelos son sistemas de aprendizaje automático. Se entrenan con señales del mundo real y se adaptan con el tiempo. Pueden aprender del comportamiento del usuario, como cambiar entre modelos, calificar respuestas o reformular indicaciones, así como de evaluaciones automatizadas que miden la calidad de los resultados.

Esta adaptabilidad hace que los enrutadores sean potentes, pero también arriesgados. Mejoran la eficiencia y brindan una mejor experiencia de usuario, pero los mismos procesos de retroalimentación que refinan sus decisiones también pueden crear bucles de refuerzo. Con el tiempo, estos bucles pueden afectar no solo las estrategias de enrutamiento, sino también el comportamiento del sistema de IA en general.

Cómo se forman los bucles de retroalimentación

A Bucle de retroalimentación ocurre cuando la salida de un sistema influye en los datos de los que aprende más tarde. Un ejemplo sencillo es un sistema de recomendación: si hace clic en un video deportivo, el sistema le muestra más contenido deportivo, lo que determina lo que verá a continuación. Con el tiempo, el sistema refuerza sus propios patrones. Otro ejemplo para comprender el bucle de retroalimentación es la vigilancia policial predictiva. Un algoritmo puede pronosticar un mayor nivel de delincuencia en ciertos vecindarios, lo que podría llevar a más patrullas. El aumento de patrullas descubre más incidentes, que luego confirman la predicción del algoritmo. El sistema parece preciso, pero los datos están sesgados por su propia influencia. Los bucles de retroalimentación pueden ser directos u ocultos. Los bucles directos son fáciles de reconocer, como un recomendador que se reentrena con sus propias sugerencias. Los bucles ocultos son más sutiles porque surgen cuando diferentes partes de un sistema se influyen indirectamente entre sí.

Los enrutadores de modelos pueden crear bucles similares. La decisión de un enrutador determina qué modelo produce la respuesta. Esa respuesta determina el comportamiento del usuario, que se convierte en retroalimentación para el enrutador. Con el tiempo, el enrutador puede empezar a reforzar patrones que funcionaron en el pasado en lugar de elegir constantemente el mejor modelo. Estos bucles son difíciles de detectar y pueden impulsar silenciosamente a los sistemas de IA en direcciones no deseadas.

Por qué los bucles de retroalimentación en los enrutadores son riesgosos

Si bien los bucles de retroalimentación ayudan a los enrutadores a mejorar la asignación de tareas, también conllevan riesgos que pueden distorsionar el comportamiento del sistema. Un riesgo es reforzar los sesgos iniciales. Si un enrutador envía repetidamente un tipo de consulta al Modelo A, la mayor parte de la retroalimentación provendrá de las salidas del Modelo A. El enrutador puede entonces asumir que el Modelo A siempre es el mejor, dejando de lado al Modelo B, incluso si a veces podría tener un mejor rendimiento. Este uso desigual puede volverse auto-reforzado. Los modelos que funcionan bien en las tareas enrutadas atraen más solicitudes, lo que refuerza sus fortalezas. Los modelos infrautilizados tienen menos oportunidades de mejorar, lo que genera desequilibrio y reduce la diversidad.

Los sesgos también pueden provenir de los modelos de evaluación utilizados para juzgar la corrección. Si el modelo de "juez" presenta puntos ciegos, sus sesgos se transmiten directamente al enrutador, que optimiza según los valores del juez en lugar de las necesidades reales del usuario. El comportamiento del usuario añade otro nivel de complejidad. Si un enrutador tiende a devolver ciertos estilos de respuestas, los usuarios pueden adaptar sus consultas para que coincidan con esos patrones, reforzándolos aún más. Con el tiempo, esto puede limitar tanto el comportamiento del usuario como las respuestas del sistema. Los enrutadores también pueden aprender a asociar ciertos patrones de consulta o datos demográficos con modelos específicos. Esto puede generar experiencias sistemáticamente diferentes entre grupos, lo que podría reforzar y amplificar los sesgos sociales existentes.

Otra preocupación clave es la desviación a largo plazo. Las decisiones que toma un enrutador hoy influyen en los datos de entrenamiento que se utilizarán mañana. Si los modelos se reentrenan con resultados influenciados por el enrutamiento, podrían aprender las preferencias del enrutador en lugar de enfoques independientes. Esto puede uniformizar las respuestas de los modelos e incorporar sesgos que persisten en el tiempo.

Estrategias para romper el ciclo

Reducir el riesgo de bucles ocultos requiere un diseño y una supervisión activos. El entrenamiento debe utilizar diversas fuentes de datos, no solo clics o cambios de usuario. El enrutamiento aleatorio ocasional también puede evitar que un modelo monopolice un tipo de tarea. La monitorización es esencial. Las auditorías periódicas pueden revelar si un enrutador se desvía hacia ciertos patrones o si depende excesivamente de un solo modelo. La transparencia en las decisiones sobre enrutadores ayuda a los investigadores a detectar sesgos de forma temprana.

Los enrutadores también deben reentrenarse periódicamente con datos actualizados y equilibrados para evitar que se consoliden los sesgos antiguos. Incorporar supervisión humana, especialmente en dominios sensibles, añade un nivel adicional de responsabilidad. Los humanos pueden identificar cuándo un enrutador favorece sistemáticamente un modelo o clasifica erróneamente ciertas consultas.

La clave es considerar el enrutador como un modelo sujeto a retroalimentación, no como un componente fijo o neutral. Al reconocer cómo los datos que generan influyen en los enrutadores, los investigadores y desarrolladores pueden diseñar sistemas que se mantengan justos, adaptables y fiables a lo largo del tiempo.

Lo más importante es...

Los enrutadores de modelos ofrecen claras ventajas en eficiencia y adaptabilidad, pero también conllevan riesgos ocultos. Los bucles de retroalimentación dentro de estos sistemas pueden amplificar discretamente el sesgo, limitar la diversidad de respuestas y limitar los modelos a patrones de comportamiento estrechos. A medida que estas arquitecturas se generalicen, reconocer y abordar estos riesgos de forma temprana será clave para construir sistemas de IA que se mantengan justos, fiables y verdaderamente adaptativos.