Inteligencia Artificial

Mistral AI: estableciendo nuevos puntos de referencia más allá de Llama2 en el espacio de código abierto

Los modelos de lenguajes grandes (LLM) han ocupado recientemente un lugar central, gracias a artistas destacados como ChatGPT. Cuando Meta presentó sus modelos Llama, despertó un renovado interés en los LLM de código abierto. ¿El objetivo? Crear LLM asequibles y de código abierto que sean tan buenos como los modelos de primer nivel como GPT-4, pero sin el alto precio ni la complejidad.

Esta combinación de asequibilidad y eficiencia no sólo abrió nuevas vías para investigadores y desarrolladores, sino que también sentó las bases para una nueva era de avances tecnológicos en el procesamiento del lenguaje natural.

Recientemente, las nuevas empresas de IA generativa han estado en racha con financiación. Juntos recaudó $ 20 millones, con el objetivo de dar forma a la IA de código abierto. Anthropic también recaudó la impresionante cantidad de 450 millones de dólares, y Cohere, en asociación con Google Cloud, asegurado $ 270 millones En junio de este año.

Introducción a Mistral 7B: tamaño y disponibilidad

Mistral AI, con sede en París y cofundada por alumnos de DeepMind y Meta de Google, anunció su primer modelo de lenguaje grande: Mistral 7B. Cualquiera puede descargar este modelo fácilmente desde GitHub e incluso a través de un Torrente de 13.4 gigabytes.

Esta startup logró asegurar una financiación inicial sin precedentes incluso antes de lanzar un producto. El primer modo Mistral AI con un modelo de 7 mil millones de parámetros supera el rendimiento de llamas 2 13B en todas las pruebas y supera a Llama 1 34B en muchas métricas.

En comparación con otros modelos como Llama 2, Mistral 7B ofrece capacidades similares o superiores, pero con menor consumo computacional. Si bien los modelos básicos como GPT-4 pueden lograr más, son más costosos y no tan intuitivos, ya que se accede principalmente a ellos mediante API.

Cuando se trata de tareas de codificación, Mistral 7B ofrece CódigoLlama 7B Una competencia decente. Además, es lo suficientemente compacto (13.4 GB) como para funcionar en máquinas estándar.

Además, Mistral 7B Instruct, optimizado específicamente para conjuntos de datos de instrucción en Abrazando la cara, ha mostrado un gran desempeño. Supera a otros modelos 7B en MT-Bench y está hombro con hombro con los modelos de chat 13B.

Abrazando Cara Mistral 7B Ejemplo

Benchmarking de rendimiento

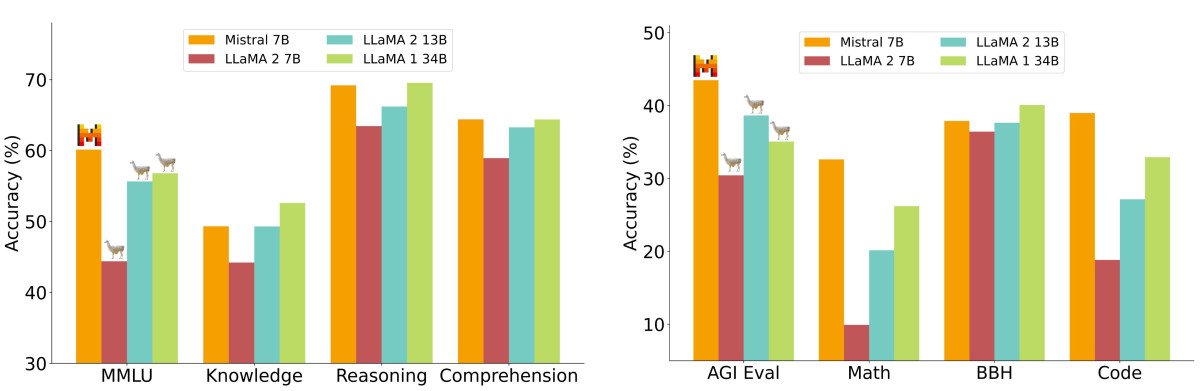

En un análisis de rendimiento detallado, el Mistral 7B se comparó con los modelos de la familia Llama 2. Los resultados fueron claros: el Mistral 7B superó sustancialmente al Llama 2 13B en todos los puntos de referencia. De hecho, igualó el rendimiento de Llama 34B, destacándose especialmente en las pruebas comparativas de código y razonamiento.

Los puntos de referencia se organizaron en varias categorías, como Razonamiento de Sentido Común, Conocimiento del Mundo, Comprensión Lectora, Matemáticas y Código, entre otras. Una observación particularmente destacable fue la métrica de costo-rendimiento de Mistral 7B, denominada "tamaños de modelo equivalentes". En áreas como razonamiento y comprensión, Mistral 7B demostró un rendimiento similar al de un modelo Llama 2 tres veces más grande, lo que implica un potencial ahorro de memoria y un aumento en el rendimiento. Sin embargo, en los puntos de referencia de conocimiento, Mistral 7B se alineó estrechamente con Llama 2 13B, lo que probablemente se deba a las limitaciones de sus parámetros que afectan la compresión del conocimiento.

¿Qué es lo que realmente hace que el modelo Mistral 7B sea mejor que la mayoría de los otros modelos de lenguaje?

Simplificando los mecanismos de atención

Si bien las sutilezas de los mecanismos de atención son técnicas, su idea fundamental es relativamente simple. Imagínese leer un libro y resaltar frases importantes; esto es análogo a cómo los mecanismos de atención "resaltan" o dan importancia a puntos de datos específicos en una secuencia.

En el contexto de los modelos lingüísticos, estos mecanismos permiten que el modelo se centre en las partes más relevantes de los datos de entrada, garantizando que el resultado sea coherente y contextualmente preciso.

En los transformadores estándar, los puntajes de atención se calculan con la fórmula:

La fórmula para estas puntuaciones implica un paso crucial: la multiplicación de matrices de Q y K. El desafío aquí es que a medida que crece la longitud de la secuencia, ambas matrices se expanden en consecuencia, lo que lleva a un proceso computacional intensivo. Esta preocupación por la escalabilidad es una de las principales razones por las que los transformadores estándar pueden ser lentos, especialmente cuando se trata de secuencias largas.

La atención multiconsulta (MQA) agiliza el proceso al usar un conjunto de encabezados "clave-valor", pero a veces sacrifica la calidad. Ahora bien, quizá se pregunte: ¿por qué no combinar la velocidad de la MQA con la calidad de la atención multiconsulta? Aquí es donde entra en juego la atención de consultas agrupadas (GQA).

Atención de consultas agrupadas (GQA)

GQA es una solución intermedia. En lugar de usar solo uno o varios cabezales "clave-valor", los agrupa. De esta forma, GQA logra un rendimiento cercano a la atención detallada de múltiples cabezales, pero con la velocidad de MQA. Para modelos como Mistral, esto se traduce en un rendimiento eficiente sin comprometer demasiado la calidad.

Atención de ventana deslizante (SWA)

El ventana deslizante es otro método utilizado para procesar secuencias de atención. Este método utiliza una ventana de atención de tamaño fijo alrededor de cada token de la secuencia. Con múltiples capas acumulando esta atención en ventana, las capas superiores eventualmente obtienen una perspectiva más amplia, abarcando información de toda la entrada. Este mecanismo es análogo a los campos receptivos que se ven en las redes neuronales convolucionales (CNN).

Por otro lado, la “atención de ventana deslizante dilatada” del modelo de Longformer, que es conceptualmente similar al método de ventana deslizante, calcula sólo unas pocas diagonales de la matriz. Este cambio da como resultado que el uso de la memoria aumente linealmente en lugar de cuadráticamente, lo que lo convierte en un método más eficiente para secuencias más largas.

Preocupaciones sobre la transparencia y la seguridad de Mistral AI en la descentralización

En su anuncio, Mistral AI también enfatizó la transparencia con la declaración: "Sin trucos, sin datos propietarios". Sin embargo, su único modelo disponible actualmente, 'Mistral-7B-v0.1', es un modelo base preentrenado, por lo que puede generar una respuesta a cualquier consulta sin moderación, lo que plantea posibles problemas de seguridad. Si bien modelos como GPT y Llama cuentan con mecanismos para discernir cuándo responder, la naturaleza totalmente descentralizada de Mistral podría ser explotada por actores maliciosos.

Sin embargo, la descentralización de los modelos de lenguajes grandes tiene sus ventajas. Si bien algunos pueden hacer un mal uso de ella, las personas pueden aprovechar su poder para el bien social y hacer que la inteligencia sea accesible para todos.

Flexibilidad de implementación

Uno de los puntos fuertes es que Mistral 7B está disponible bajo la licencia Apache 2.0. Esto significa que no existen barreras reales para su uso, ya sea para fines personales, para una gran corporación o incluso para una entidad gubernamental. Solo necesita el sistema adecuado para ejecutarlo, o podría tener que invertir en recursos en la nube.

Si bien existen otras licencias, como la licencia MIT más simple y la cooperativa CC BY-SA-4.0, que exige crédito y licencias similares para derivados, Apache 2.0 proporciona una base sólida para proyectos a gran escala.

Conclusión

El auge de los Modelos de Lenguaje Grandes de código abierto, como Mistral 7B, supone un cambio fundamental en la industria de la IA, al hacer que los modelos de lenguaje de alta calidad sean accesibles a un público más amplio. Los enfoques innovadores de Mistral AI, como la atención a consultas agrupadas y la atención de ventana deslizante, prometen un rendimiento eficiente sin comprometer la calidad.

Si bien la naturaleza descentralizada de Mistral plantea ciertos desafíos, su flexibilidad y sus licencias de código abierto subrayan el potencial para democratizar la IA. A medida que el panorama evolucione, la atención se centrará inevitablemente en equilibrar el poder de estos modelos con consideraciones éticas y mecanismos de seguridad.

¿Qué le espera a Mistral? El modelo 7B fue solo el comienzo. El equipo planea lanzar pronto modelos aún más grandes. Si estos nuevos modelos igualan el rendimiento del 7B, Mistral podría consolidarse rápidamente como una de las empresas líderes del sector, todo durante su primer año.