Inteligencia Artificial

MINT-1T: Ampliar datos multimodales de código abierto 10 veces

El entrenamiento de grandes modelos multimodales (LMM) de frontera requiere conjuntos de datos a gran escala con secuencias entrelazadas de imágenes y texto en forma libre. Aunque los LMM de código abierto han evolucionado rápidamente, todavía existe una gran falta de conjuntos de datos intercalados multimodales a escala que sean de código abierto. No se puede subestimar la importancia de estos conjuntos de datos, ya que forman la base para la creación de sistemas avanzados de inteligencia artificial capaces de comprender y generar contenido en diferentes modalidades. Sin un suministro suficiente de conjuntos de datos completos e intercalados, el potencial para desarrollar LMM más sofisticados y capaces se ve significativamente obstaculizado. Estos conjuntos de datos permiten que los modelos aprendan de una amplia gama de entradas, lo que los hace más versátiles y efectivos en diversas aplicaciones. Además, la escasez de dichos conjuntos de datos plantea un desafío para la comunidad de código abierto, que depende de recursos compartidos para impulsar la innovación y la colaboración.

Los LMM de código abierto han avanzado significativamente en los últimos años, pero su crecimiento se ve obstaculizado por la disponibilidad limitada de conjuntos de datos intercalados a gran escala. Para superar este obstáculo, se requieren esfuerzos concertados para seleccionar, anotar y publicar conjuntos de datos más completos que respalden el desarrollo y el perfeccionamiento continuos de los modelos multimodales. Además, la creación y difusión de estos conjuntos de datos implica superar varios obstáculos técnicos y logísticos. La recopilación de datos debe ser extensa y representativa de los diversos contextos en los que se implementarán los LMM. La anotación requiere una cuidadosa consideración para garantizar que las secuencias intercaladas de imágenes y texto estén alineadas de forma que mejoren las capacidades de aprendizaje del modelo. Asimismo, garantizar que los conjuntos de datos sean de código abierto implica abordar consideraciones legales y éticas relacionadas con la privacidad de los datos y los derechos de uso. Ampliar la disponibilidad de conjuntos de datos intercalados multimodales de alta calidad a gran escala es esencial para el futuro de la investigación y el desarrollo de la IA. Al abordar la escasez actual, la comunidad de IA puede fomentar una mayor innovación y colaboración, lo que lleva a la creación de LMM más potentes y versátiles capaces de abordar problemas complejos del mundo real.

A partir de esa nota, MINT-1T, el conjunto de datos de código abierto intercalado multimodal más grande y diverso hasta la fecha. MINT-1T: una escala 10 veces mayor, que incluye un billón de tokens de texto y 3.4 millones de imágenes que los conjuntos de datos de código abierto existentes. El conjunto de datos MINT-1T también presenta fuentes nunca expuestas, como archivos PDF y documentos ArXiv. Dado que los conjuntos de datos intercalados multimodales no se escalan fácilmente, es importante que el conjunto de datos MINT-1T comparta el proceso de curación de datos para que otros también puedan realizar experimentos con variantes ricas en información. El conjunto de datos MINT-1T demuestra que su método; Los modelos LM entrenados en MINT-1T son competitivos (aunque algo) con respecto a los OBELICS de última generación anteriores.

MINT-1T: un conjunto de datos multimodal con un billón de tokens

Los grandes conjuntos de datos previos al entrenamiento de código abierto han sido fundamentales para que la comunidad de investigación explore la ingeniería de datos y entrene modelos transparentes de código abierto. En el dominio del texto, los primeros trabajos como C4 y The Pile desempeñaron un papel crucial al permitir a la comunidad entrenar el primer conjunto de grandes modelos de lenguaje de código abierto como GPT-J, GPT-Neo y otros. Estos esfuerzos fundamentales también allanaron el camino para mejoras posteriores en los métodos de filtrado y escalado de datos. De manera similar, en el espacio de imágenes y textos, los conjuntos de datos de código abierto a gran escala han estimulado innovaciones en mejores métodos de curación de datos, como las redes de filtrado de datos y T-MARS. Hay un cambio notable de los laboratorios de frontera hacia la formación. Grandes modelos multimodales (LMM) que requieren extensos conjuntos de datos intercalados multimodales que comprenden secuencias de imágenes y texto de forma libre. A medida que las capacidades de los modelos de frontera avanzan rápidamente, está surgiendo una brecha significativa en los datos de entrenamiento multimodal entre los modelos de código cerrado y abierto. Los conjuntos de datos intercalados multimodales de código abierto actuales son más pequeños y menos diversos que sus contrapartes de solo texto, y provienen principalmente de documentos HTML, lo que limita la amplitud y variedad de los datos. Esta limitación impide el desarrollo de LMM robustos de código abierto y crea una disparidad entre las capacidades de los modelos de código abierto y cerrado.

Para abordar esta brecha, se creó MINT-1T como el conjunto de datos intercalados multimodales de código abierto más grande y diverso hasta la fecha. MINT-1T contiene un total de un billón de tokens de texto y tres mil millones de imágenes, procedentes de diversos orígenes, como HTML, PDF y ArXiv. Antes de MINT-1T, el conjunto de datos de código abierto más grande en esta área era OBELICS, que incluía 115 mil millones de tokens de texto y 353 millones de imágenes, todos provenientes de HTML.

Las aportaciones de MINT-1T son las siguientes:

- Ingeniería de datos: Escalar estos datos entrelazados multimodales presenta un desafío de ingeniería mayor que construir conjuntos de datos de solo texto o de pares de imagen y texto. Es fundamental manejar tamaños de documentos mucho más grandes y preservar el orden original de imágenes y texto.

- Diversidad: MINT-1T es el primero en el espacio intercalado multimodal que recopila documentos multimodales de alta calidad a gran escala de fuentes como PDF de CommonCrawl y ArXiv.

- Experimentos modelo: Los experimentos muestran que los LMM entrenados en MINT-1T no solo igualan sino que potencialmente superan el rendimiento de los modelos entrenados en el mejor conjunto de datos de código abierto existente, OBELICS, al tiempo que ofrecen una escala diez veces mayor.

MINT-1T: Construcción del conjunto de datos

MINT-1T gestiona un conjunto de datos de código abierto a gran escala que utiliza diversas fuentes de documentos intercalados, como archivos PDF y artículos de ArXiv. Esta sección detalla los métodos de MINT-1T para obtener documentos multimodales, filtrar contenido de baja calidad, desduplicar datos y eliminar material no apto para el trabajo o NSFW, así como material no deseado. El conjunto de datos final comprende 922 mil millones de tokens HTML, 106 mil millones de tokens PDF y 9 mil millones de tokens ArXiv.

Adquisición de grandes cantidades de documentos multimodales

Canalización HTML

MINT-1T sigue el método de OBELICS para extraer documentos multimodales intercalados de archivos CommonCrawl WARC analizando el árbol DOM de cada entrada WARC. Si bien OBELICS solo procesó documentos desde febrero de 2020 hasta febrero de 2023 volcados CommonCrawl, MINT-1T ha ampliado el grupo de documentos para incluir documentos HTML desde mayo de 2017 hasta abril de 2024 (con volcados completos de octubre de 2018 a abril de 2024 y volcados parciales de años anteriores). Al igual que OBELICS, MINT-1T filtra documentos que no contienen imágenes, más de treinta imágenes o cualquier imagen con URL que incluyan subcadenas inapropiadas como logotipo, avatar, pornografía y xxx.

Canalización de PDF

MINT-1T obtiene documentos PDF de archivos WAT de CommonCrawl desde los volcados de febrero de 2023 a abril de 2024. Inicialmente, todos los enlaces PDF se extraen de estos volcados. Luego, MINT-1T intenta descargar y leer archivos PDF utilizando PyMuPDF, descartando los PDF de más de 50 MB (que probablemente contengan imágenes grandes) y los de más de 50 páginas. Se excluyen las páginas sin texto, y se establece un orden de lectura para las páginas restantes. El orden de lectura se determina buscando el cuadro delimitador de todos los bloques de texto en una página, agrupando los bloques según columnas y ordenándolos de arriba a la izquierda a abajo a la derecha. Las imágenes se integran en la secuencia en función de su proximidad a los bloques de texto de la misma página.

Canalización ArXiv

MINT-1T crea documentos entrelazados ArXiv a partir del código fuente LaTeX utilizando TexSoup para encontrar etiquetas de figuras e intercalar imágenes con el texto en papel. Para documentos de varios archivos, MINT-1T identifica el archivo Tex principal y reemplaza las etiquetas de entrada con el contenido de sus archivos. El código LaTeX se limpia eliminando importaciones, bibliografía, tablas y etiquetas de citas. Dado que ArXiv ya es una fuente de datos altamente seleccionada, no se realizan filtros ni deduplicaciones adicionales.

Filtrado de calidad de texto

MINT-1T evita el uso de heurísticas basadas en modelos para el filtrado de texto, siguiendo las prácticas establecidas por RefinedWeb, Dolma y FineWeb. Inicialmente, los documentos que no están en inglés se eliminan utilizando el modelo de identificación de idioma de Fasttext (con un umbral de confianza de 0.65). Los documentos con URL que contienen subcadenas NSFW también se eliminan para excluir contenido pornográfico e indeseable. Se aplican métodos de filtrado de texto de RefinedWeb, eliminando específicamente documentos con n-gramas duplicados excesivos o aquellos identificados como de baja calidad mediante reglas de MassiveText.

Filtrado de imagen

Después de seleccionar archivos PDF y HTML, MINT-1T intenta descargar todas las URL de imágenes en el conjunto de datos HTML, descartando enlaces no recuperables y eliminando documentos sin enlaces de imágenes válidos. Las imágenes de menos de 150 píxeles se descartan para evitar imágenes ruidosas como logotipos e iconos, y las imágenes de más de 20,000 píxeles también se eliminan, ya que normalmente corresponden a imágenes fuera de tema. Para los documentos HTML, las imágenes con una relación de aspecto superior a dos se eliminan para filtrar imágenes de baja calidad, como pancartas publicitarias. Para los archivos PDF, el umbral se ajusta a tres para preservar figuras y tablas científicas.

La figura anterior representa cómo MINT-1T incluye de forma única datos de documentos PDF y ArXiv más allá de las fuentes HTML.

Filtrado de seguridad

- Filtrado de imágenes NSFW: MINT-1T aplica un detector de imágenes NSFW a todas las imágenes del conjunto de datos. Si un documento contiene una única imagen NSFW, se descarta todo el documento.

- Eliminación de información de identificación personal: para mitigar el riesgo de filtración de datos personales, las direcciones de correo electrónico y las direcciones IP en los datos de texto se anonimizan. Los correos electrónicos se reemplazan con plantillas como "[email protected]”e IP con IP no funcionales generadas aleatoriamente.

Deduplicación

MINT-1T realiza la deduplicación de texto de párrafos y documentos dentro de cada instantánea de CommonCrawl y la deduplicación de imágenes para eliminar imágenes repetitivas y no informativas, como iconos y logotipos. Todos los pasos de deduplicación se llevan a cabo por separado para cada fuente de datos.

Deduplicación de párrafos y documentos

Siguiendo la metodología de Dolma, MINT-1T utiliza un filtro Bloom para una deduplicación de texto eficiente, estableciendo la tasa de falsos positivos en 0.01 y deduplicando párrafos de 13 gramos (indicados mediante delimitadores de nueva línea doble) de cada documento. Si más del 80% de los párrafos de un documento están duplicados, se descarta todo el documento.

Eliminación de texto repetitivo común

Después de la deduplicación de párrafos, MINT-1T elimina oraciones breves y comunes en documentos HTML, como "Saltar al contenido" o "Archivo del blog". Esto se hace ejecutando una deduplicación exacta de párrafos en el 2% de cada instantánea de CommonCrawl, de acuerdo con las prácticas de CCNet, lo que garantiza principalmente la eliminación del texto repetitivo común.

La figura anterior demuestra el proceso de filtrado para MINT-1T y muestra cómo se eliminan los tokens a lo largo del proceso de datos para documentos HTML, PDF y ArXiv.

Deduplicación de imágenes

Dentro de cada instantánea de CommonCrawl, MINT-1T elimina las imágenes que aparecen con frecuencia según hashes SHA256. En lugar de una deduplicación estricta, solo se eliminan las imágenes que aparecen más de diez veces en una instantánea, siguiendo las prácticas Multimodal-C4. De acuerdo con OBELICS, las imágenes repetidas dentro de un solo documento se eliminan y se conserva solo la primera aparición.

Infraestructura

A lo largo del procesamiento de datos, MINT-1T tuvo acceso a un promedio de 2,350 núcleos de CPU de una combinación de nodos de 190 y 90 procesadores. En total, se utilizaron aproximadamente 4.2 millones de horas de CPU para crear este conjunto de datos.

Comparación de la composición de documentos en MINT-1T con OBELICS

Al evaluar la composición de conjuntos de datos entrelazados, se examinan dos características clave: la distribución de tokens de texto por documento y el número de imágenes por documento. Para este análisis, se tomaron muestras aleatorias de 50,000 documentos tanto de OBELICS como de cada fuente de datos en MINT-1T. GPT-2 Se utilizó tokenizer para calcular el número de tokens de texto. Los valores atípicos se eliminaron excluyendo los documentos que estaban fuera del rango intercuartil de 1.5 para la cantidad de tokens de texto e imágenes. Como se muestra en la siguiente figura, el subconjunto HTML de MINT-1T se alinea estrechamente con la distribución de tokens que se ve en OBELICS. Sin embargo, los documentos obtenidos de PDF y ArXiv tienden a ser más largos que los documentos HTML en promedio, lo que resalta los beneficios de obtener datos de diversas fuentes. La Figura 5 examina la densidad de imágenes en todos los documentos, revelando que los documentos PDF y ArXiv contienen más imágenes en comparación con los documentos HTML, siendo las muestras de ArXiv las más densas en imágenes.

¿Cómo mejoran las diferentes fuentes de datos la diversidad de los documentos?

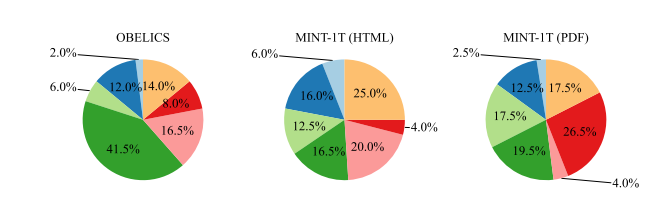

Una motivación importante para ampliar el conjunto de documentos multimodales más allá del HTML es la mejora de la cobertura del dominio. Para cuantificar la diversidad y profundidad de esta cobertura, se entrenó un modelo de asignación latente de Dirichlet (LDA) en 100,000 documentos muestreados del conjunto de datos OBELICS, el subconjunto HTML de MINT-1T y el subconjunto PDF (excluyendo ArXiv) de MINT-1T para obtener 200 temas. Luego se utilizó GPT-4 para clasificar el conjunto de palabras para identificar los dominios dominantes, como Salud y Medicina, Ciencias, Negocios, Humanidades, Historia, etc., según los dominios MMMU. El análisis revela distintas tendencias en la distribución de dominios:

- OBÉLICOS: Este conjunto de datos muestra una concentración pronunciada en “Humanidades y Ciencias Sociales”. Esto puede atribuirse a su proceso de construcción de datos, que implica filtrar documentos que no se parecen a los artículos de Wikipedia, alterando así potencialmente la distribución hacia conocimientos más generales y contenido centrado en las humanidades.

- Subconjunto HTML de MINT-1T: A diferencia de OBELICS, el subconjunto HTML de MINT-1T no está fuertemente sesgado hacia ningún dominio específico, lo que sugiere una representación de dominio más amplia y equilibrada.

- Subconjunto PDF de MINT-1T: Hay una mayor proporción de documentos de “Ciencia y Tecnología” dentro de los documentos PDF de MINT-1T. Es probable que esta tendencia se deba a la naturaleza de la comunicación científica, donde los archivos PDF son el formato preferido para compartir artículos de investigación e informes técnicos detallados.

MINT-1T: Resultados y Experimentos

Para todos los experimentos, MINT-1T entrena el modelo en un 50% de lotes de subtítulos de imagen y texto y un 50% de lotes intercalados multimodales. Se muestrea un máximo de 2048 tokens multimodales de cada documento intercalado y 340 tokens de cada muestra de imagen-texto. De manera similar a Flamingo, se agrega un token de "fin" para indicar el final de una secuencia de imagen-texto adyacente. Durante la capacitación, el 50% de los documentos intercalados de una sola imagen se eliminan aleatoriamente para muestrear documentos con varias imágenes. El conjunto de datos de imagen y texto se compone de una mezcla de conjuntos de datos de subtítulos seleccionados internamente. La capacidad del modelo para razonar sobre secuencias intercaladas multimodales se evalúa a través de sus capacidades de aprendizaje en contexto y su rendimiento de razonamiento de múltiples imágenes.

La figura anterior ilustra el porcentaje de documentos de cada dominio en MMMU para OBELICS y subconjuntos de MINT-1T.

Aprendizaje en contexto: Los modelos se evalúan en función del rendimiento del aprendizaje en contexto de cuatro y ocho disparos en varios puntos de referencia de subtítulos (COCO (prueba de Karpathy) y TextCaps (validación)) y conjuntos de datos de respuesta visual a preguntas (VQAv2 (validación), OK-VQA (validación) , TextVQA (validación) y VizWiz (validación)). Las demostraciones se seleccionan aleatoriamente del conjunto de entrenamiento. Las puntuaciones se promedian en múltiples ejecuciones de evaluación, con demostraciones aleatorias para tener en cuenta la sensibilidad a las indicaciones elegidas. Se eliminan diferentes indicaciones para cada tarea para seleccionar las de mejor rendimiento.

Razonamiento de múltiples imágenes: Los modelos se evalúan en MMMU (que contiene preguntas de una sola imagen y de múltiples imágenes) y Mantis-Eval (todas las preguntas de múltiples imágenes) para probar las habilidades de razonamiento de múltiples imágenes más allá de las evaluaciones de aprendizaje en contexto.

Capacitación en Documentos HTML

Inicialmente, la porción HTML de MINT-1T se compara con OBELICS, ya que OBELICS es el conjunto de datos intercalado líder anterior, también seleccionado a partir de documentos HTML. Se entrenan dos modelos en las partes HTML de MINT-1T y OBELICS para un total de 10 mil millones de tokens multimodales. Se evalúa su desempeño en el aprendizaje en contexto. La siguiente tabla presenta el rendimiento de 4 y 8 disparos en puntos de referencia comunes; el modelo entrenado en documentos HTML MINT-1T funciona mejor que OBELICS en tareas VQA pero peor en pruebas comparativas de subtítulos. En promedio, OBELICS funciona ligeramente mejor que MINT-1T (HTML).

Agregar documentos PDF y ArXiv

Posteriormente, se lleva a cabo capacitación sobre las fuentes de datos completas de MINT-1T, con una combinación de documentos HTML, PDF y ArXiv. Los documentos intercalados se toman como muestra en un 50 % de HTML, un 45 % de archivos PDF y un 5 % de ArXiv. El modelo está entrenado para un total de 10 mil millones de tokens multimodales. Como se ve en la tabla anterior, el modelo entrenado con la combinación completa de datos MINT-1T supera a OBELICS y MINT-1T (HTML) en la mayoría de los puntos de referencia de aprendizaje en contexto. En puntos de referencia de razonamiento multimodal más complejos, el modelo MINT-1T supera a OBELICS en MMMU pero tiene un peor rendimiento en Mantis-Eval.

Tendencias detalladas

¿Cómo se amplía el rendimiento del aprendizaje en contexto con las demostraciones?

El rendimiento del aprendizaje en contexto se evalúa cuando se le solicita con de una a ocho demostraciones. Se ejecuta una única prueba por recuento de disparos para cada punto de referencia de evaluación. Como se ve en la siguiente figura, el modelo entrenado en MINT-1T supera al modelo entrenado en el subconjunto HTML de MINT-1T y OBELICS en todas las tomas. El modelo MINT-1T (HTML) tiene un rendimiento ligeramente peor que OBELICS.

Rendimiento en tareas de subtítulos y respuesta visual a preguntas

La siguiente figura presenta el rendimiento promedio del aprendizaje en contexto en los puntos de referencia de subtítulos y respuesta visual a preguntas (VQA). OBELICS supera a todas las variantes de MINT-1T en pruebas comparativas de subtítulos de cuatro disparos y tiene un rendimiento ligeramente peor en comparación con MINT-1T en subtítulos de ocho disparos. Sin embargo, MINT-1T supera significativamente ambas líneas de base en los puntos de referencia VQA. MINT-1T (HTML) también supera a OBELICS en tareas VQA.

Rendimiento en diferentes dominios

La inclusión de diversos dominios en MINT-1T tiene como objetivo mejorar la generalización del modelo. La figura anterior desglosa el rendimiento en MMMU para cada dominio. Excepto en el dominio Empresarial, MINT-1T supera a OBELICS y MINT-1T (HTML). El aumento del rendimiento en los dominios de ciencia y tecnología para MINT-1T se atribuye a la prevalencia de estos dominios en documentos ArXiv y PDF.

Conclusión

En este artículo hemos hablado de MINT-1T, el conjunto de datos de código abierto intercalado multimodal más grande y diverso hasta la fecha. MINT-1T: una escala 10 veces mayor, que incluye un billón de tokens de texto y 3.4 millones de imágenes que los conjuntos de datos de código abierto existentes. El conjunto de datos MINT-1T también presenta fuentes nunca expuestas, como archivos PDF y documentos ArXiv. Dado que los conjuntos de datos intercalados multimodales no se escalan fácilmente, es importante que el conjunto de datos MINT-1T comparta el proceso de curación de datos para que otros también puedan realizar experimentos con variantes ricas en información. El conjunto de datos MINT-1T demuestra que su método; Los modelos LM entrenados en MINT-1T son competitivos (aunque algo) con respecto a los OBELICS de última generación anteriores.