El ángulo de Anderson

Las IA codificadoras tienden a sufrir el efecto Dunning-Kruger

Una nueva investigación muestra que las IA de codificación como ChatGPT sufren el efecto Dunning-Kruger, ya que a menudo actúan con mayor confianza cuando son menos competentes. Al abordar lenguajes de programación desconocidos o complejos, afirman tener una alta certeza incluso cuando sus respuestas fallan. El estudio vincula el exceso de confianza del modelo con un rendimiento deficiente y la falta de datos de entrenamiento, lo que plantea nuevas inquietudes sobre cuánto saben realmente estos sistemas sobre lo que hacen. no Saber.

Cualquiera que haya pasado incluso una cantidad moderada de tiempo interactuando con grandes modelos de lenguaje sobre cuestiones fácticas ya sabrá que los LLM suelen estar dispuestos a dar una con confianza equivocada respuesta a una consulta del usuario.

Junto con formas más evidentes de alucinaciónLa razón de esta jactancia vacía no está del todo clara. Una investigación publicada durante el verano sugiere que los modelos dan respuestas seguras. Incluso cuando saben que están equivocados, por ejemplo; aunque otras teorías atribuyen el exceso de confianza a opciones arquitectónicas, entre otras posibilidades.

De lo que el usuario final puede estar seguro es que la experiencia es increíblemente frustrante, ya que estamos programados para confiar en de las personas estimaciones de sus propias capacidades (sobre todo porque en tales casos hay consecuencias, legales y de otro tipo, para una persona que promete demasiado y cumple poco); y una especie de transferencia antropomórfica significa que tendemos a replicar este comportamiento con sistemas de IA conversacionales.

Pero un LLM es una entidad no responsable que puede y efectivamente devolverá un ¡Ups! ¡Manos de Mantequilla! después de haber ayudado al usuario a destruir sin darse cuenta algo importante, o al menos perder una tarde de su tiempo; suponiendo que así será. admitir responsabilidad en absoluto.

Peor aún, esta falta de prudente circunspección parece imposible de eliminar, al menos en ChatGPT, que tranquilizará ampliamente al usuario sobre la validez de su consejo y explicará las fallas de su razonamiento solo después de que el daño ya esté hecho. Ni actualizar el sistema memoria persistente, ni el uso de indicaciones repetitivas parecen tener mucho impacto en el problema.

Las personas también pueden ser obstinadas y autoengañarse, aunque cualquiera que cometiera errores tan profundos y frecuentes probablemente sería despedido prematuramente. Quienes padecen el síndrome del impostor (donde un empleado teme haber sido ascendido por encima de sus capacidades) sufren lo contrario: Efecto Dunning Kruger, donde una persona significativamente sobrestima su capacidad para realizar una tarea.

El costo de la inflación

Un nuevo estudio de Microsoft examina el valor del efecto Dunning-Kruger en relación con el rendimiento efectivo de las arquitecturas de codificación asistidas por IA (como la propia de Redmond). Copilot), en un esfuerzo de investigación que es el primero en abordar específicamente este subsector de los LLM.

El trabajo analiza la confianza con la que estas IAs que escriben código evalúan sus propias respuestas en comparación con su desempeño real, en docenas de lenguajes de programación. Los resultados muestran un claro patrón similar al humano: cuando los modelos eran menos capaces, mostraban mayor seguridad en sí mismos.

El efecto fue más fuerte en idiomas oscuros o con pocos recursos, donde los datos de entrenamiento eran escasos: cuanto más débil el modelo o más raro el idioma, mayor el ilusión de habilidad:

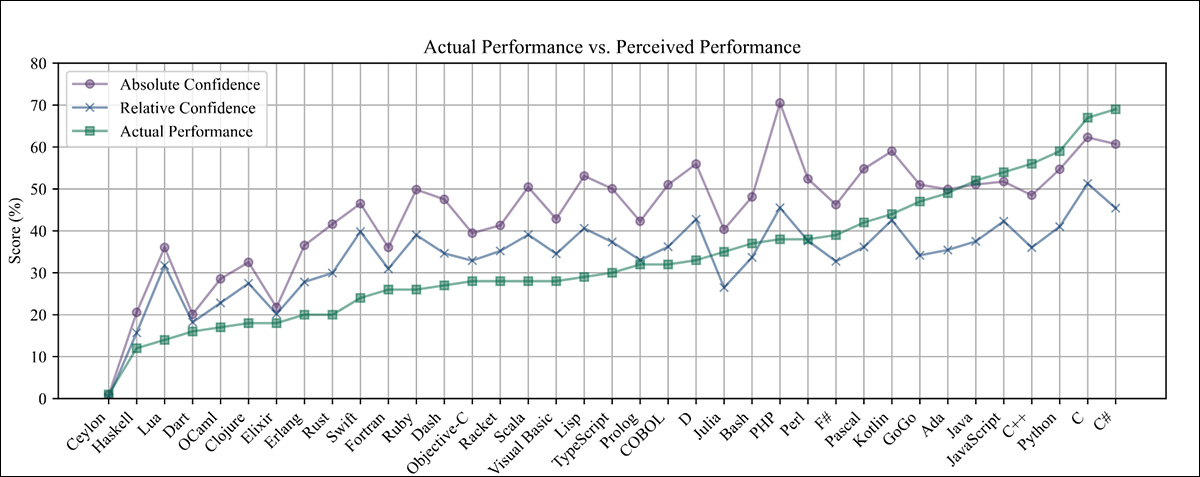

Rendimiento real y percibido de GPT-4o en distintos lenguajes de programación, ordenado por rendimiento real. Fuente: https://arxiv.org/pdf/2510.05457

Los cuatro autores, todos ellos colaboradores iguales que trabajan para Microsoft, sostienen que el trabajo plantea nuevas preguntas sobre hasta qué punto se puede confiar en estas herramientas para juzgar sus propios resultados, y afirman:

'Al analizar la confianza y el rendimiento del modelo en un conjunto diverso de lenguajes de programación, revelamos que los modelos de IA reflejan patrones humanos de exceso de confianza, especialmente en dominios desconocidos o de bajos recursos.

Nuestros experimentos demuestran que los modelos menos competentes y aquellos que operan en lenguajes de programación poco comunes presentan un sesgo similar al de DKE más fuerte, lo que sugiere que la intensidad del sesgo es proporcional a la competencia de los modelos. Esto coincide con los experimentos con humanos para este sesgo.

Los investigadores contextualizan esta línea de estudio como una forma de entender cómo la confianza del modelo se vuelve poco confiable cuando el rendimiento es débil, y para probar si los sistemas de IA muestran el mismo tipo de exceso de confianza que se observa en los humanos, con implicaciones posteriores para la confianza y la implementación práctica.

Aunque el nuevo documento desafía La ley de los titulares de Betteridge, todavía se titula ¿Los modelos de código sufren el efecto Dunning-Kruger?Si bien los autores afirman que se ha publicado el código para el trabajo, la preimpresión actual no contiene ningún detalle al respecto.

Método

El estudio probó con qué precisión las IA de codificación podían juzgar sus propias respuestas al darles miles de preguntas de programación de opción múltiple, cada una perteneciente a un dominio de lenguaje específico, desde Python y Java hasta Perl y COBOL:

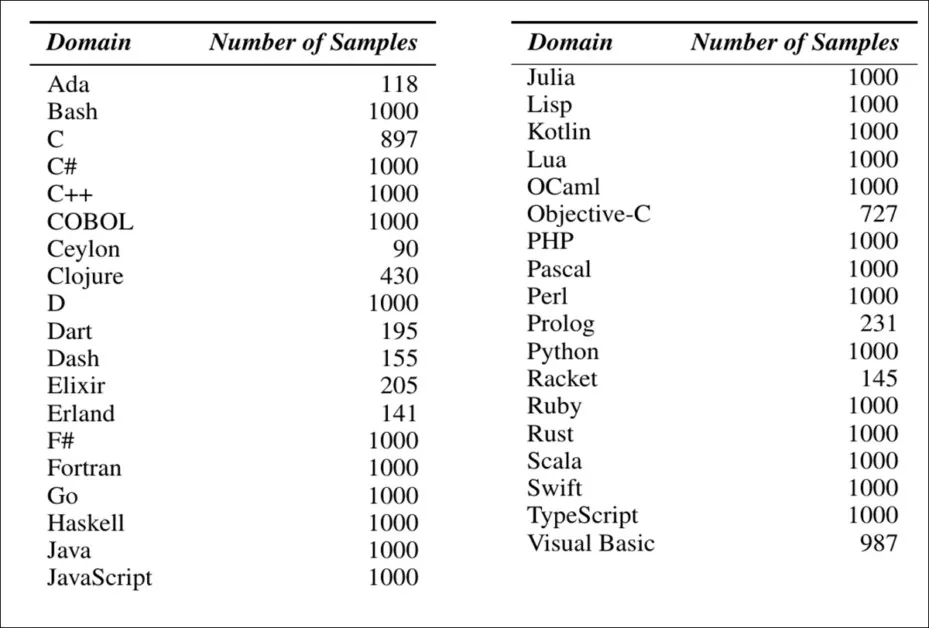

Dominios del lenguaje de programación utilizados en el estudio, junto con el número de preguntas de codificación de opción múltiple muestreadas para cada dominio.

Los modelos tenían que elegir la opción correcta y luego estimar qué tan seguros estaban de su elección; su desempeño real se medía por la frecuencia con la que acertaban la respuesta, y su confianza autoevaluada indicaba qué tan buenos eran. creído Lo eran. Comparar estas dos métricas permitió a los investigadores ver dónde divergían la confianza y la competencia.

Para medir qué tan confiables parecían ser los modelos, el estudio utilizó dos métodos: confianza absoluta y confianza relativaEn el primero, se le pidió al modelo que otorgara una puntuación de cero a uno junto a cada respuesta, y su confianza para un idioma determinado se definió mediante el promedio de esas puntuaciones en las preguntas en ese idioma.

El segundo método analizó qué tan seguro estaba el modelo cuando elegir entre dos preguntasPara cada par, el modelo debía indicar cuál le resultaba más seguro. Estas elecciones se calificaron mediante sistemas de clasificación diseñados originalmente. para juegos competitivosCada pregunta se trató como si fuera un jugador en un partido. Las puntuaciones finales se normalizaron y promediaron para cada idioma para obtener una puntuación de confianza relativa.

En el artículo se examinan dos formas establecidas del efecto Dunning-Kruger: una que rastrea cómo un solo modelo juzga erróneamente su desempeño en diferentes dominios; y otra que compara los niveles de confianza entre modelos más débiles y más fuertes.

La primera forma, llamada DKE intraparticipante, analiza si un modelo único se vuelve más confiado en los idiomas donde tiene un rendimiento deficiente. El segundo, DKE entre participantes, pregunta si los modelos que obtienen peores resultados en general también tienden a calificarse mejor a sí mismos.

En ambos casos, la brecha entre la confianza y el desempeño real se utiliza para medir el exceso de confianza; las brechas más grandes en entornos de bajo desempeño apuntan a un comportamiento similar al de DKE.

Resultados

El estudio prueba el efecto Dunning-Kruger en seis grandes modelos lingüísticos: Mistral; Phi‑3; DeepSeek‑Distill; Phi‑4; GPT‑0.1, y GPT‑4o.

Cada modelo fue probado en preguntas de programación de opción múltiple de la base de datos pública disponible. Conjunto de datos de CodeNet, con 37 idiomas* representados para revelar cómo la confianza y la precisión variaban entre dominios de codificación familiares y desconocidos.

El análisis intermodelo muestra un claro patrón Dunning-Kruger:

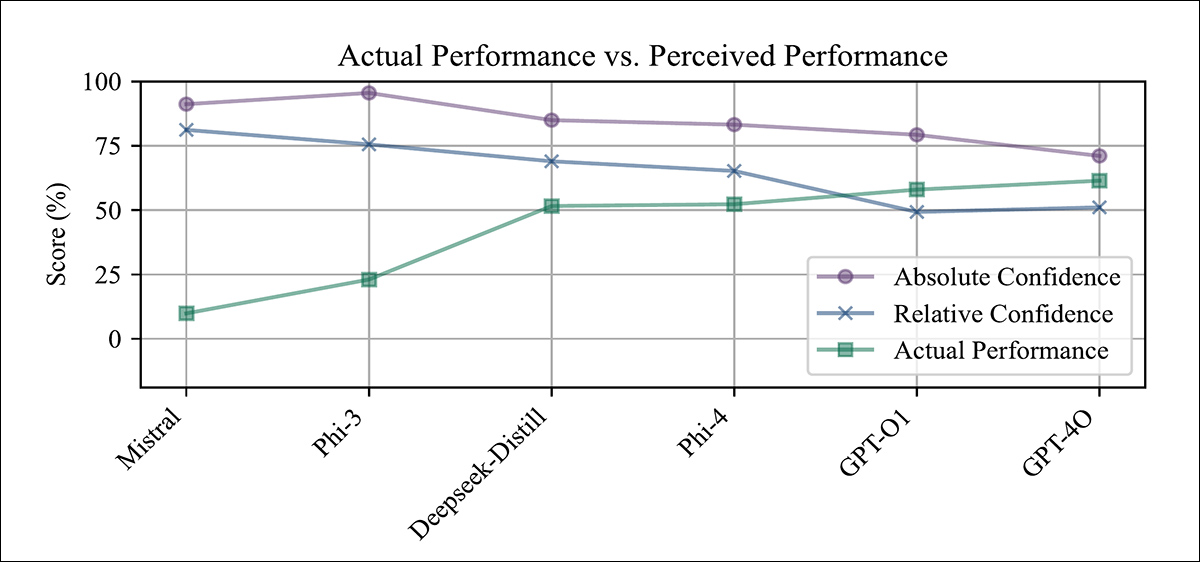

Rendimiento real versus rendimiento percibido en seis modelos de código, que muestra cómo los modelos de menor rendimiento, como Mistral y Phi-3, muestran una alta confianza a pesar de una precisión deficiente, mientras que los modelos más fuertes, como GPT-4o, muestran un comportamiento más calibrado o incluso menos confiable.

Los modelos con menor precisión, incluidos Mistral y Phi‑3, tendían a sobreestimar sus propias capacidades, mientras que los sistemas de mayor rendimiento, como GPT‑4o, mostraban niveles de confianza que coincidían más estrechamente con su desempeño real, en particular cuando se los juzgaba por la confianza relativa.

Los resultados también indican que los modelos más capaces a veces pueden subestimarse a sí mismos (un patrón que los puntajes de confianza absoluta no logran capturar).

Los resultados también indican que el análisis intramodelo también respalda la presencia del efecto Dunning-Kruger. En el gráfico de resultados que se muestra al inicio del artículo, se observa el rendimiento de cada modelo en diferentes lenguajes de programación, ordenados según su rendimiento real.

En lenguajes donde los modelos obtuvieron puntuaciones bajas, especialmente en aquellos poco comunes o con pocos recursos, como COBOL, Prolog y Ceylon, su confianza fue notablemente mayor de lo que justificaban sus resultados. En lenguajes conocidos como Python y JavaScript, su confianza se ajustó más a su precisión real, e incluso en ocasiones fue inferior.

Este patrón apareció tanto en las medidas de confianza absoluta como relativa, lo que sugiere que Los modelos son menos conscientes de sus propios límites cuando operan en dominios de codificación desconocidos.

El tratamiento de los modelos como participantes introdujo algunas limitaciones, ya que el pequeño número de modelos en juego afecta la diversidad, se ignoran las diferencias dentro de los resultados de un solo modelo y la distribución de datos puede no reflejar la de los participantes humanos reales.

Para tener esto en cuenta, el estudio probó tres configuraciones alternativas: en primer lugar, a cada modelo se le asignó una personalidad distinta; en segundo lugar, las respuestas se muestrearon a un nivel más alto. temperatura para crear más variación; en tercer lugar, las indicaciones se parafrasearon varias veces y cada versión se trató como un participante separado:

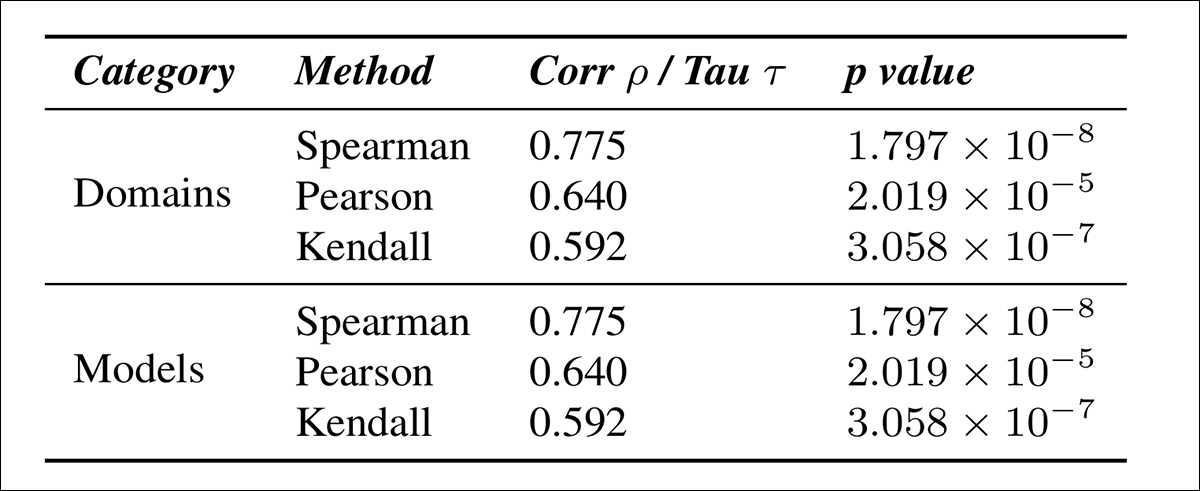

Correlación entre el exceso de confianza y el rendimiento real en diferentes configuraciones experimentales, que muestra que el patrón de Dunning-Kruger permanece consistente en todas las condiciones y es más fuerte cuando se toman muestras de múltiples respuestas diversas del mismo modelo.

La tabla de resultados que se muestra arriba indica con qué fuerza se manifiesta el efecto Dunning-Kruger en estas condiciones, permaneciendo presente en todos los casos; y que el DKE fue más pronunciado cuando se muestrearon múltiples respuestas del mismo modelo a alta temperatura.

Para entender mejor cómo el desempeño percibido difiere del desempeño real, el estudio comparó estimaciones de confianza absoluta y relativa, calculando cuánto sobreestimó cada modelo su propia capacidad (específicamente, la diferencia entre su puntaje de confianza y su precisión real), y luego midiendo cómo esa sobreestimación se relacionaba con el desempeño real del modelo:

Correlación entre el exceso de confianza (medido como confianza absoluta menos confianza relativa) y la precisión real en los dominios de programación y tipos de modelos, que muestra que una mayor sobreestimación se asocia sistemáticamente con un menor rendimiento.

La tabla de resultados anterior ilustra cómo la sobreestimación se relaciona con el rendimiento real, tanto en los dominios de programación como en los modelos. En ambos casos, se observa que los modelos con menor precisión tienden a mostrar un mayor exceso de confianza.

Además, los modelos especializados entrenados en dominios más estrechos mostraron efectos DKE más fuertes que los generalistas:

Correlación entre la sobreestimación y el rendimiento real para modelos especializados de base, de dominio único y de múltiples dominios, que muestra efectos DKE más fuertes a medida que aumenta la especialización.

Usando el Conjunto de datos MultiPL-E En ocho lenguajes de programación, los autores descubrieron que el entrenamiento de dominio único generaba un mayor exceso de confianza que las configuraciones de dominio múltiple o base, lo que sugiere que La DKE empeora con una mayor especialización.

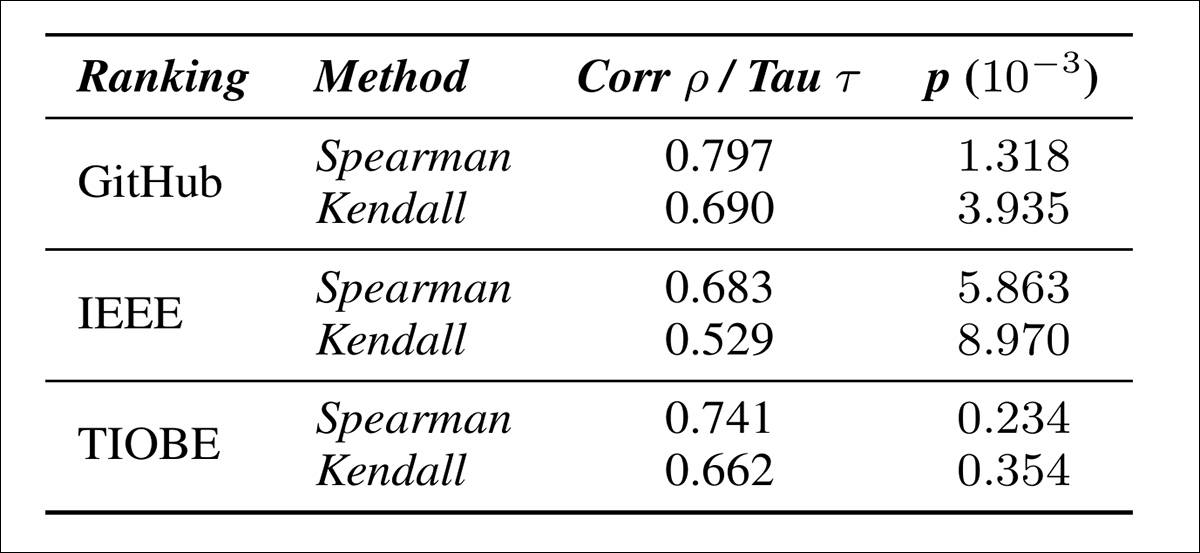

Las pruebas también encontraron que los modelos tienden a ser más confiados en lenguajes de programación poco comunes. GitHub, IEEE y TÍOBE En las clasificaciones, la rareza se correlaciona fuertemente con una mayor confianza percibida, alcanzando un máximo de 0.797:

Correlación entre el exceso de confianza en el modelo y la rareza del idioma, utilizando tres clasificaciones de popularidad. Los idiomas menos comunes se asocian con un mayor rendimiento percibido.

Finalmente, los autores probaron si el efecto Dunning-Kruger aparece en la generación de código, evaluando modelos en el conjunto de datos MultiPL-E en los lenguajes Ada, Dart, Prolog, Swift, C++, Python, C# y Elixir.

Aunque el efecto todavía estaba presente, era notablemente más débil que en el entorno de preguntas de opción múltiple, probablemente reflejando la mayor dificultad para evaluar la confianza y la corrección en tareas abiertas:

Correlación entre la sobreestimación y el rendimiento real en la generación de código abierto, basada en los resultados de MultiPL-E en ocho lenguajes de programación.

Al considerar la explicación aún controvertida del efecto Dunning-Kruger, los autores concluyen:

'Una posible explicación que puede ser común tanto a los humanos como a los modelos de IA es la explicación metacognitiva, que establece que evaluar la calidad del desempeño de una habilidad es una parte crucial de la adquisición de esa habilidad.

Esta explicación podría probarse experimentalmente en modelos de IA mediante un estudio controlado de diferentes estrategias de entrenamiento y determinar si todas ellas conducen a mejoras simultáneas en el rendimiento y en la capacidad de evaluar la calidad del mismo. Sin embargo, este estudio queda significativamente fuera del alcance de este artículo y lo dejamos para trabajos futuros.

Conclusión

Incluso en su dominio nativo, el efecto Dunning-Kruger (como señala el artículo) puede atribuirse a una causa estadística o cognitiva. Si se debe a una causa estadística, la aplicación de un síndrome, hasta ahora exclusivamente humano, al contexto del aprendizaje automático es bastante válida.

Aunque los autores especulan que la causa podría ser "cognitiva" en ambos casos, eso requeriría un punto de vista ligeramente más metafísico.

Tal vez el hallazgo más interesante del artículo es hasta qué punto varios LLM en codificación tienden a redoblar esfuerzos en sus circunstancias menos favorables, es decir, exhibiendo máxima confianza cuando tratan con los lenguajes más escasos o menos conocidos, lo que sería una estratagema casi inmediatamente contraproducente en un entorno de trabajo del mundo real.

* Los lenguajes de programación utilizados fueron Ada, Bash, C, C#, C++, COBOL, Ceylon, Clojure, D, Dart, Dash, Elixir, Erland, F#, Fortran, Go, Haskell, Java, JavaScript, Julia, Lisp, Kotlin, Lua, OCaml, Objective-C, PHP, Pascal, Perl, Prolog, Python, Racket, Ruby, Rust, Scala, Swift, TypeScript y Visual Basic.

Publicado por primera vez el miércoles 8 de octubre de 2025