Inteligencia Artificial

AI Image Matting que entiende las escenas

En el documental de extras que acompaña al lanzamiento en DVD de 2003 de Alien3 (1992), la leyenda de los efectos visuales Richard Edlund recordó con horror la 'lucha de sumo' de la extracción mate fotoquímica que dominó el trabajo de efectos visuales entre los 1930s finales y finales de los años 1980. Edlund describió la naturaleza irregular del proceso como 'lucha de sumo', en comparación con las técnicas digitales de pantalla azul/verde que se impusieron a principios de los años 1990 (y ha devuelto a la metáfora desde entonces).

La extracción de un elemento de primer plano (como una persona o un modelo de nave espacial) de un fondo, de modo que la imagen recortada se pueda componer en una placa de fondo, se logró originalmente filmando el objeto de primer plano contra un fondo azul o verde uniforme.

Laboriosos procesos de extracción fotoquímica para un VFX filmado por ILM para 'El retorno del Jedi' (1983). Fuente: https://www.youtube.com/watch?v=qwMLOjqPmbQ

En el metraje resultante, el color de fondo se aislaría químicamente y se usaría como plantilla para reimprimir el objeto (o persona) en primer plano en un impresora óptica como un objeto "flotante" en una celda de película por lo demás transparente.

El proceso se conocía como superposición de separación de color (CSO), aunque este término eventualmente se asociaría más con el crudo 'Cromakey' efectos de video en la producción televisiva de bajo presupuesto de las décadas de 1970 y 1980, que se lograron con medios analógicos en lugar de químicos o digitales.

Una demostración de la superposición de separación de colores en 1970 para el programa infantil británico 'Blue Peter'. Fuente: https://www.bbc.co.uk/archive/blue_peter_noakes_CSO/zwb9vwx

En cualquier caso, ya sea para elementos fílmicos o de vídeo, a partir de ese momento el metraje extraído podría insertarse en cualquier otro metraje.

Aunque el negocio de Disney es notablemente más caro y exclusivo proceso de vapor de sodio (que tecleó en amarillo, específicamente, y también fue usado para la película de terror de Alfred Hitchcock de 1963 Los pájaros) dio una mejor definición y mates más nítidos, la extracción fotoquímica siguió siendo laboriosa y poco confiable.

El proceso patentado de extracción de vapor de sodio de Disney requería fondos cerca del extremo amarillo del espectro. Aquí, Angela Lansbury está suspendida de cables durante la producción de una secuencia repleta de efectos visuales para "Bedknobs and Broomsticks" (1971). Fuente

Más allá de los tapetes digitales

En la década de 1990, la revolución digital prescindió de los productos químicos, pero no de la necesidad de pantallas verdes. Ahora era posible eliminar el fondo verde (o cualquier color) simplemente buscando píxeles dentro de un rango de tolerancia de ese color, en un software de edición de píxeles como Photoshop y una nueva generación de suites de composición de video que podían eliminar automáticamente los fondos de colores. Casi toda la noche, sesenta años de la industria de la impresión óptica quedaron relegados a la historia.

Los últimos diez años de investigación en visión por computadora acelerada por GPU están llevando la extracción de mates a una tercera era, asignando a los investigadores el desarrollo de sistemas que puedan extraer mates de alta calidad sin la necesidad de pantallas verdes. Solo en Arxiv, los artículos relacionados con innovaciones en la extracción de primer plano basada en aprendizaje automático son una característica semanal.

Poniéndonos en la imagen

Este lugar de interés académico y de la industria en la extracción de IA ya ha impactado el espacio del consumidor: las implementaciones crudas pero viables nos son familiares a todos en forma de por Zoom Skype filtros que pueden reemplazar los fondos de nuestra sala de estar con islas tropicales, etc., en llamadas de videoconferencia.

Sin embargo, los mejores mates todavía requieren una pantalla verde, como Zoom anotado el miércoles pasado.

A la izquierda, un hombre frente a una pantalla verde, con el cabello bien extraído mediante la función de fondo virtual de Zoom. A la derecha, una mujer frente a una escena doméstica normal, con el cabello extraído algorítmicamente, con menor precisión y con mayores requisitos computacionales. Fuente: https://support.zoom.us/hc/en-us/articles/210707503-Changing-your-Virtual-Background-image

A publicación adicional desde la plataforma Zoom Support advierte que la extracción sin pantalla verde también requiere una mayor potencia de cómputo en el dispositivo de captura.

La necesidad de cortarlo

Las mejoras en la calidad, portabilidad y economía de recursos para los sistemas de extracción mate "en la naturaleza" (es decir, aislar a las personas sin la necesidad de pantallas verdes) son relevantes para muchos más sectores y actividades que los simples filtros de videoconferencia.

Para el desarrollo de conjuntos de datos, un reconocimiento facial, de cabeza completa y de cuerpo completo mejorado ofrece la posibilidad de garantizar que elementos de fondo extraños no se entrenen en modelos de visión por computadora de sujetos humanos; un aislamiento más preciso mejoraría enormemente segmentación semántica técnicas diseñadas para distinguir y asimilar dominios (es decir, 'gato', 'persona', 'bote'), y mejorar VAE transformador-sistemas de síntesis de imágenes basados en la nube como el nuevo de OpenAI DALL-E2; y mejores algoritmos de extracción reducirían la necesidad de costosos manuales rotoscopia en costosas canalizaciones de VFX.

De hecho, el ascenso de multimodal Las metodologías (generalmente de texto/imagen), donde un dominio como "gato" se codifica como imagen y con referencias textuales asociadas, ya están incursionando en el procesamiento de imágenes. Un ejemplo reciente es el Texto2Live arquitectura, que utiliza entrenamiento multimodal (texto/imagen) para crear videos de, entre muchas otras posibilidades, cisnes de cristal y jirafas de cristal.

Esteras de IA conscientes de la escena

Gran parte de la investigación sobre el matizado automático basado en IA se ha centrado en el reconocimiento de límites y la evaluación de agrupaciones basadas en píxeles dentro de un cuadro de imagen o video. Sin embargo, una nueva investigación de China ofrece una tubería de extracción que mejora la delineación y la calidad del mate al aprovechar descripciones basadas en texto de una escena (un enfoque multimodal que ha ganado terreno en el sector de la investigación de la visión artificial durante los últimos 3 o 4 años), afirmando haber mejorado los métodos anteriores de varias maneras.

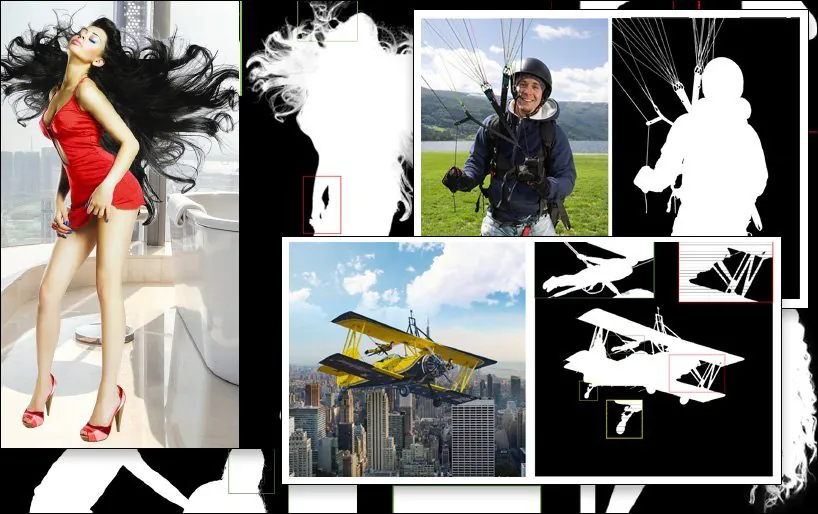

Un ejemplo de extracción SPG-IM (última imagen, abajo a la derecha), en comparación con métodos anteriores de la competencia. Fuente: https://arxiv.org/pdf/2204.09276.pdf

El desafío planteado para el subsector de investigación de extracción es producir flujos de trabajo que requieran un mínimo de anotación manual e intervención humana; idealmente, ninguna. Además de las implicaciones de costos, los investigadores del nuevo artículo observan que las anotaciones y las segmentaciones manuales realizadas por trabajadores externos subcontratados en varias culturas pueden causar que las imágenes se etiqueten o incluso se segmenten de diferentes maneras, lo que lleva a algoritmos inconsistentes e insatisfactorios.

Un ejemplo de esto es la interpretación subjetiva de lo que define un “objeto en primer plano”:

Del nuevo artículo: métodos anteriores LFM MODNET ('GT' significa Ground Truth, un resultado 'ideal' que a menudo se logra de forma manual o mediante métodos no algorítmicos) tienen enfoques distintos y de variada efectividad en la definición del contenido del primer plano, mientras que el nuevo método SPG-IM delinea de manera más efectiva el 'contenido cercano' a través del contexto de la escena.

Para abordar esto, los investigadores han desarrollado una tubería de dos etapas titulada Imagen guiada de percepción situacional (SPG-IM). La arquitectura de codificador/descodificador de dos etapas comprende la destilación de percepción situacional (SPD) y la estera guiada por percepción situacional (SPGM).

Primero, SPD entrena previamente las transformaciones de características visuales a textuales, generando subtítulos apropiados para sus imágenes asociadas. Después de esto, la predicción de la máscara de primer plano se habilita conectando la canalización a una novela predicción de prominencia la técnica.

Luego, SPGM genera un mate alfa estimado basado en la entrada de imagen RGB sin procesar y la máscara generada obtenida en el primer módulo.

El objetivo es la guía de percepción situacional, en la que el sistema tiene una comprensión contextual de en qué consiste la imagen, lo que le permite enmarcar, por ejemplo, el desafío de extraer un cabello complejo de un fondo contra las características conocidas de una tarea tan específica.

En el ejemplo siguiente, SPG-IM entiende que las cuerdas son intrínsecas a un "paracaídas", mientras que MODNet no logra retener ni definir estos detalles. De igual manera, la estructura completa del aparato de juego se pierde arbitrariamente en MODNet.

El nuevo se titula Imagen guiada de percepción situacional, y proviene de investigadores del Instituto de Investigación OPPO, PicUp.ai y Xmotors.

Mates automatizados inteligentes

SPG-IM también ofrece una red de refinamiento de transformación focal adaptativa (AFT) que puede procesar detalles locales y el contexto global por separado, lo que facilita "materias inteligentes".

Comprender el contexto de la escena, en este caso "la niña con el caballo", puede potencialmente hacer que la extracción del primer plano sea más fácil que con los métodos anteriores.

El documento dice:

'Creemos que las representaciones visuales de la tarea de visual a textual, p. El subtítulo de imágenes se centra en señales semánticamente más completas entre a) objeto a objeto y b) objeto a entorno ambiental para generar descripciones que cubran tanto la información global como los detalles locales. Además, en comparación con la costosa anotación de píxeles del matizado de imágenes, las etiquetas textuales se pueden recopilar masivamente a un costo muy bajo.

La rama SPD de la arquitectura está entrenada conjuntamente con la Universidad de Michigan VirTex decodificador textual basado en transformadores, que aprende representaciones visuales a partir de subtítulos semánticamente densos.

VirTex entrena conjuntamente a ConvNet y Transformers a través de coplas de leyendas de imágenes y transfiere los conocimientos obtenidos a tareas de visión posteriores, como la detección de objetos. Fuente: https://arxiv.org/pdf/2006.06666.pdf

Entre otras pruebas y estudios de ablación, los investigadores probaron SPG-IM contra recortar-métodos basados en Deep Image Matting (OSCURO), ÍndiceNet, Esteras de imágenes sensibles al contexto (FAO), Atención Contextual Guiada (GCA), FBA, y Mapeo Semántico de Imágenes (SI).

Otros marcos anteriores probados incluyeron enfoques sin recortes LFM, HAttEsterasy MODNETPara una comparación justa, los métodos de prueba se adaptaron en función de las diferentes metodologías; cuando el código no estaba disponible, se reprodujeron las técnicas del artículo a partir de la arquitectura descrita.

El nuevo documento dice:

Nuestro SPG-IM supera ampliamente a todos los métodos sin trimap de la competencia ([LFM], [HAttMatting] y [MODNet]). Además, nuestro modelo también muestra una notable superioridad sobre los métodos de vanguardia (SOTA) basados en trimap y guiados por máscaras en las cuatro métricas de los conjuntos de datos públicos (Composition-1K, Distinction-646 y Human-2K) y nuestro benchmark Multi-Object-1K.

Y continúa:

Se puede observar claramente que nuestro método conserva detalles finos (por ejemplo, la ubicación de las puntas de los cabellos, las texturas transparentes y los límites) sin la guía de trimap. Además, en comparación con otros modelos de la competencia sin trimap, nuestro SPG-IM puede mantener una mejor integridad semántica global.

Publicado por primera vez el 24 de abril de 2022.