Kunstig intelligens

LoReFT: Repræsentationsfinjustering for sprogmodeller

Parametereffektiv finjustering eller PeFT-metoder søger at tilpasse store sprogmodeller via opdateringer til et lille antal vægte. Imidlertid har et flertal af eksisterende fortolkningsarbejde vist, at repræsentationer koder for semantisk rig information, hvilket tyder på, at det kan være et bedre og mere kraftfuldt alternativ til at redigere disse repræsentationer. Foruddannede store modeller er ofte finjusteret til at blive brugt til nye domæner eller opgaver, og under finjusteringsprocessen kan en enkelt basismodel tilpasses til en bred vifte af opgaver selv med kun små mængder af in-domæne data tilgængelige til modellen. Processen med at finjustere en hel model er imidlertid ressourcekrævende og dyr, især for sprogmodeller med et væsentligt større antal størrelser og parametre.

Parametereffektive finjusteringer eller PeFT-metoder foreslår at tackle de høje omkostninger forbundet med finjustering af hele modellen ved kun at opdatere en lille mængde af de samlede tilgængelige vægte, en proces, der hjælper med at reducere træningstid sammen med hukommelsesforbrug. Hvad der er mere vigtigt er, at parametereffektiv finjustering eller PeFT-metoder har vist lignende ydeevne som finjustering i flere praktiske indstillinger. Adaptere, en fælles familie af parametereffektive finjusteringer eller PeFT-metoder, lærer en redigering, der kan føjes til et ekstra sæt vægte, der fungerer sammen med den frosne basismodel, med nyere adaptere som LoRA, der reducerer antallet af oplærbare parametre i indlærte vægtopdateringer ved at bruge tilnærmelser med lav rang i stedet for matricer med fuld vægt, når du træner adapterne.

Med tidligere værker, der demonstrerer, at redigering af repræsentationer kan være et bedre alternativ til parametereffektiv finjustering eller PeFT-metoder, vil vi i denne artikel tale om Repræsentationsfinjustering eller ReFT-metoder, der fungerer på en frossen model, og lære opgavespecifikke indgreb på skjulte repræsentationer. Denne artikel har til formål at dække ReFt- eller Representation Fine-tuning-rammerne i dybden, og vi udforsker mekanismen, metodologien, arkitekturen af rammen sammen med dens sammenligning med state-of-the-art rammer. Så lad os komme i gang.

ReFT: Repræsentationsfinjustering for sprogmodeller

I et forsøg på at anvende præ-trænede sprogmodeller til nye domæner og opgaver, finjusterer nuværende rammer disse præ-trænede sprogmodeller ofte, da med finjusteringsprocessen implementeret, kan en enkelt basismodel tilpasses til en række opgaver, selv når du arbejder med en lille mængde in-domæne data. Selvom finjusteringsprocessen øger den samlede ydeevne, er det en dyr proces, især hvis sprogmodellen har et betydeligt højt antal parametre. For at tackle dette problem og reducere de tilknyttede omkostninger, PeFT eller Parameter-effektiv finjustering af rammer opdatere kun en lille brøkdel af de samlede vægte, en proces, der ikke kun reducerer træningstiden, men også reducerer hukommelsesforbruget, hvilket gør det muligt for PeFT-rammerne at opnå lignende ydeevne sammenlignet med fuld finjusteringstilgange i praktiske scenarier. Adaptere, en almindelig familie af PeFT'er, fungerer ved at lære en redigering, der kan føjes til et ekstra sæt vægte sammen med et undersæt af vægte, der fungerer i forening med basismodellen med frosne vægte. Nylige adapterrammer som LoRA og QLoRA har vist, at det er muligt at træne fuldpræcisionsadaptere oven på modeller med reduceret præcision uden at påvirke ydeevnen. Adaptere er normalt mere effektive og effektive sammenlignet med andre metoder, der introducerer nye modelkomponenter.

Et væsentligt højdepunkt ved den nuværende topmoderne Parametereffektive finjusteringsrammer er, at de i stedet for at modificere repræsentationer ændrer vægte. Rammer, der beskæftiger sig med fortolkning, har imidlertid vist, at repræsentationer koder for rig semantisk information, hvilket tyder på, at repræsentationsredigering kan være en bedre og en mere kraftfuld tilgang sammenlignet med vægtopdateringer. Denne antagelse om, at repræsentationsredigering er den bedre tilgang, er det, der danner grundlaget for ReFT eller Representation Fine-tuning framework, der træner interventioner i stedet for at tilpasse modelvægte, hvilket gør det muligt for modellen at manipulere en lille brøkdel af alle repræsentationerne i et forsøg på at styre modellens adfærd. at løse downstream-opgaver under inferens. ReFT eller Repræsentation Finjusteringsmetoder er drop-in erstatninger for vægtbaserede PeFT eller parametereffektive finjusteringsrammer. ReFT-tilgangen henter inspiration fra nyere modeller, der arbejder med stor modelfortolkning, der griber ind på repræsentationer for at finde trofaste årsagsmekanismer og styrer modellens adfærd under inferens, og derfor kan ses som en generalisering af repræsentationsredigeringsmodellerne. Med udgangspunkt i det samme er LoReFT eller Low-Rank Subspace ReFT en stærk og effektiv forekomst af ReFT og er en parameterisering af ReFT, der griber ind på skjulte repræsentationer i det lineære rum spændt over af lav-rangs projektionsmatrix og bygger direkte på DAS eller Distributed Alignment Search framework.

I modsætning til fuld finjustering træner PeFT eller Parameter-efficient finjusteringsramme kun en lille brøkdel af modellens parametre og formår at tilpasse modellen til downstream-opgaver. Den parametereffektive finjusteringsramme kan klassificeres i tre hovedkategorier:

- Adapterbaserede metoder: Adapterbaserede metoder træner yderligere moduler som fuldt forbundne lag oven på den fortrænede model med frosne vægte. Serieadaptere indsætter komponenter mellem flerlagsperceptronen eller MLP og LM eller store model opmærksomhedslag, hvorimod parallelle adaptere tilføjer moduler sammen med eksisterende komponenter. Da adaptere tilføjer nye komponenter, der ikke let kan foldes ind i eksisterende modelvægte, udgør de en ekstra byrde under konklusioner.

- LoRA: LoRA sammen med dens seneste varianter tilnærmer additive vægte under træning ved at bruge lav-rang matricer, og de kræver ikke yderligere overhead under inferens, da vægtopdateringerne kan flettes ind i modellen, og det er grunden til, at de anses for at være de nuværende stærkeste PeFT-rammer.

- Prompt-baserede metoder: Prompt-baserede metoder tilføjer bløde tokens, der initialiseres tilfældigt i inputtet, og træner deres indlejringer, mens vægtene af sprogmodellen holdes fastfrosset. Ydeevnen, der tilbydes af disse metoder, er ofte ikke tilfredsstillende sammenlignet med andre PeFT-tilgange, og de bærer også en betydelig slutningsomkostninger.

I stedet for at opdatere vægtene lærer ReFT-rammen interventioner til at ændre en lille brøkdel af de samlede repræsentationer. Desuden har nyere værker om repræsentationsteknik og aktiveringsstyring vist, at tilføjelse af faste styrevektorer til reststrømmen kan lette en vis grad af kontrol over fortrænede store modelgenerationer uden at kræve ressourcekrævende finjustering. Andre rammer har vist, at redigering af repræsentationer med en indlært skalerings- og oversættelsesoperation kan forsøge at matche, men ikke overgå den ydeevne, som LoRA-adaptere tilbyder på en bred vifte af opgaver med færre indlærte parametre. Ydermere har succesen med disse rammer på tværs af en række opgaver vist, at repræsentationer introduceret af præ-trænede sprogmodeller bærer rig semantik, selvom ydeevnen af disse modeller er suboptimal, hvilket resulterer i, at PeFT'er fortsætter som den nyeste tilgang. uden yderligere slutningsbyrde.

ReFT : Metodik og arkitektur

For at holde stilbevarelsesprocessen enkel, antager ReFT-rammen en transformer-baseret stor model som sin målmodel, der er i stand til at producere kontekstualiseret repræsentation af sekvensen af tokens. For en given sekvens med n antal input-tokens, indlejrer ReFT-rammen først disse input-tokens i en liste af repræsentationer, hvorefter de m lag beregner listen over skjulte repræsentationer successivt som en funktion af den tidligere liste over skjulte repræsentationer. Hver skjult repræsentation er en vektor, og sprogmodellen bruger de endelige skjulte repræsentationer til at producere forudsigelserne. ReFT-rammen overvejer både maskerede sprogmodeller og autoregressive sprogmodeller. Nu, ifølge den lineære repræsentationshypotese, er begreber i neurale netværk kodet inden for repræsentationernes lineære underrum. Nylige modeller har fundet denne påstand at være sand i neurale netværksmodeller trænet på naturligt sprog sammen med andre inputdistributioner.

I fortolkningsstudier bruger den tilfældige abstraktionsramme desuden udvekslingsinterventioner til at fastslå rollen af neurale netværkskomponenter tilfældigt, når de implementerer bestemt adfærd. Logikken bag udvekslingsintervention er, at hvis man fikserer en repræsentation til, hvad den ville have været for et kontrafaktisk input, og denne intervention påvirker outputtet af modellen konsekvent på den måde, som påstandene fra ReFT-rammen om den komponent, der er ansvarlig for at producere den repræsentation, så spiller komponenten en kausal rolle i adfærden. Selvom der er nogle få metoder, er distribueret udvekslingsintervention den ideelle tilgang til at teste, om et koncept er kodet i et lineært underrum af en repræsentation, som hævdet af den lineære repræsentationshypotese. Desuden er DAS-metoden tidligere blevet brugt til at finde lineær repræsentation i sprogmodeller af entitetsattributter, følelser, sproglige træk og matematisk ræsonnement. Flere eksperimenter har dog indikeret, at DAS-metoden er meget ekspressiv, og den besidder evnen til at finde kausale effektive underrum, selv når transformatorsprogmodellen er blevet initialiseret tilfældigt, og derfor endnu ikke har lært nogen opgavespecifikke repræsentationer, hvilket resulterer i diskutere, om DAS er effektiv og ansvarlig nok for fortolkningsopgaver.

Den ekspressivitet, som DAS tilbyder, tyder på, at tilgangen kunne være et ideelt værktøj til at kontrollere sprogmodellens adfærd sammen med dens arbejde med kontrollerbar generering og ansvarlig redigering. Derfor, for at tilpasse sprogmodeller til downstream-opgaver, bruger ReFT-rammen den distribuerede udvekslingsinterventionsoperation til at lave en ny parametereffektiv metode. Endvidere er ReFT-metoden et sæt af interventioner, og rammen håndhæver, at for alle to interventioner, der opererer på samme lag, skal interventionspositionerne være usammenhængende, idet parametrene for alle interventionsfunktioner forbliver uafhængige. Som et resultat heraf er ReFT en generisk ramme, der omfatter indgreb på skjulte repræsentationer under modellens fremadgående pass.

ReFT: Eksperimenter og resultater

For at evaluere dens ydeevne i forhold til eksisterende PEFT-rammeværker, udfører ReFT-rammerne eksperimenter på tværs af fire forskellige benchmarks for behandling af naturligt sprog og dækker over 20 datasæt, med det primære mål at give et rigt billede af, hvordan LoReFT-rammeværket fungerer i forskellige scenarier. Ydermere, når LoReFT-rammen implementeres i det virkelige liv, skal udviklere beslutte, hvor mange interventioner der skal læres sammen med inputpositionerne og lagene, de skal anvende hver enkelt på. For at fuldføre opgaven tuner ReFT-rammen fire hyperparametre.

- Antallet af præfikspositioner at gribe ind på.

- Antallet af suffikspositioner at gribe ind på.

- Hvilket sæt lag at gribe ind på.

- Hvorvidt man skal binde interventionsparametre på tværs af forskellige positioner i det samme lag.

Ved at gøre dette forenkler ReFT-rammerne hyperparametersøgerummet og sikrer kun en fast ekstra slutningsomkostning, der ikke skalerer med længden af prompten.

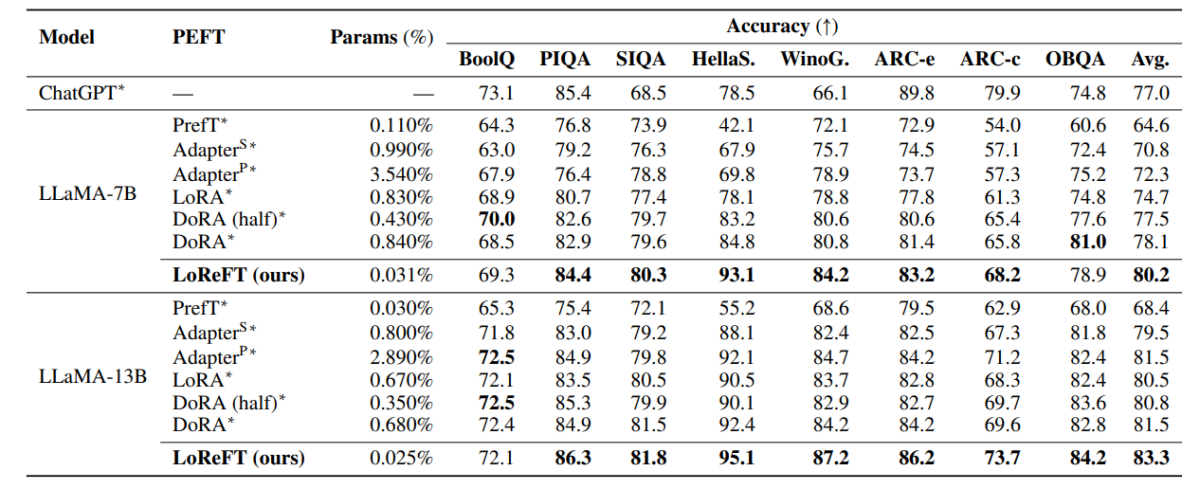

Ovenstående tabel sammenligner nøjagtigheden af LLaMA-7B- og LLaMA-13B-rammerne med eksisterende PEFT-modeller på tværs af 8 commonsense-ræsonneringsdatasæt. Som det kan observeres, udkonkurrerer LoReFT-modellen eksisterende PEFT-tilgange med en anstændig margin, på trods af at den har meget færre parametre, idet den gennemsnitlige ydeevne af tre kørsler rapporteres med forskellige parameter-seeds for LoReFT-modellen. Param(%) beregnes ved at dividere antallet af trænede parametre med antallet af samlede parametre for den store basismodel.

Ovenstående tabel opsummerer nøjagtighedssammenligningen af LLaMA-7B- og LLaMA-13B-rammerne mod eksisterende PEFT-modeller på tværs af 4 forskellige aritmetiske ræsonnementdatasæt, hvor rammen rapporterer den gennemsnitlige ydeevne af tre kørsler med forskellige tilfældige frø. Som det kan ses, på trods af at have meget færre params (%), udkonkurrerer LoReFT-rammerne eksisterende PEFT-rammeværker med en betydelig margin.

Ovenstående tabel opsummerer nøjagtighedssammenligningen af RoBERTa-base- og RoBERTa-large-rammerne med eksisterende PEFT-modeller på tværs af GLUE-benchmark, hvor rammen rapporterer den gennemsnitlige ydeevne af fem kørsler med distinkte tilfældige frø. Som det kan ses, på trods af at have meget færre params (%), udkonkurrerer LoReFT-rammerne eksisterende PEFT-rammeværker med en betydelig margin.

Afsluttende tanker

I denne artikel har vi talt om LoReFT, et kraftfuldt alternativ til eksisterende PEFT-frameworks, der opnår stærk ydeevne på tværs af benchmarks fra fire forskellige domæner, samtidig med at den tilbyder op til 50 gange den effektivitet, der tilbydes af tidligere topmoderne PEFT-modeller. Foruddannede store modeller er ofte finjusteret til at blive brugt til nye domæner eller opgaver, og under finjusteringsprocessen kan en enkelt basismodel tilpasses til en bred vifte af opgaver selv med kun små mængder af in-domæne data tilgængelige til modellen. Processen med at finjustere en hel model er imidlertid ressourcekrævende og dyr, især for sprogmodeller med et væsentligt større antal størrelser og parametre. Parametereffektive finjusteringer eller PeFT-metoder foreslår at tackle de høje omkostninger forbundet med finjustering af hele modellen ved kun at opdatere en lille mængde af de samlede tilgængelige vægte, en proces, der hjælper med at reducere træningstid sammen med hukommelsesforbrug. Navnlig etablerer LoReFT ny state-of-the-art ydeevne på sund fornuft ræsonnement, instruktionsfølelse og naturlig sprogforståelse mod de stærkeste PEFT'er.