Изкуствен интелект

UniTune: Алтернативната техника на Google за редактиране на невронни изображения

Google Research, изглежда, атакува базираното на текст редактиране на изображения от редица фронтове и, вероятно, чака да види какво е необходимо. По следите на тазседмичното издание на своя Хартия с изображения, гигантът за търсене предложи допълнителен метод, базиран на латентна дифузия, за извършване на иначе невъзможни редакции, базирани на AI, върху изображения чрез текстови команди, този път наречен UniTune.

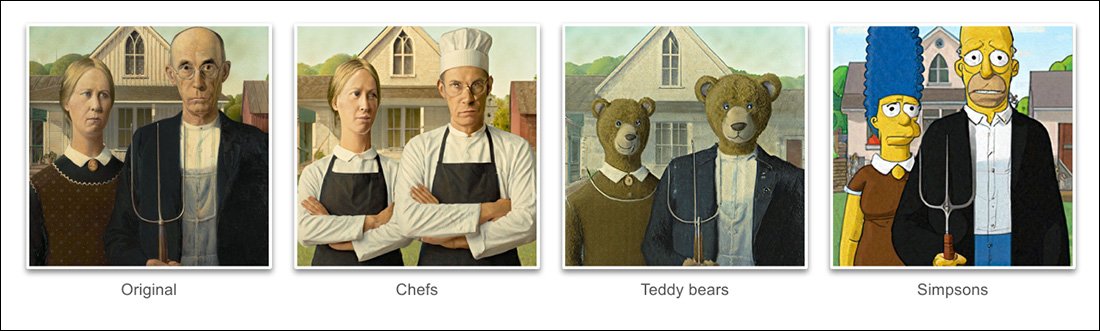

Въз основа на примерите, дадени в проекта нова хартия, UniTune постигна изключителна степен на разплитане на семантична поза и идея от действително твърдо съдържание на изображението:

Командата на UniTune за семантична композиция е изключителна. Обърнете внимание как в най-горния ред от снимки лицата на двамата не са били изкривени от необикновената трансформация на останалата част от изходното изображение (вдясно). Източник: https://arxiv.org/pdf/2210.09477.pdf

Както феновете на Stable Diffusion вече са научили, прилагането на редакции към частични участъци от картина, без да се променя неблагоприятно останалата част от изображението, може да бъде трудна, понякога невъзможна операция. Въпреки че популярни дистрибуции като АВТОМАТИЧЕН1111 може да създава маски за локални и ограничени редакции, процесът е труден и често непредвидим.

Очевидният отговор, поне за специалист по компютърно зрение, е да се постави слой от семантична сегментация който е способен да разпознава и изолира обекти в изображение без намеса на потребителя и наистина напоследък имаше няколко нови инициативи в тази посока.

Друг възможност за блокиране на разхвърляни и заплетени невронни операции за редактиране на изображения е да се използва влиятелният Contrastive Language–Image Pre-training на OpenAI (CLIP), който е в основата на моделите на латентна дифузия като DALL-E 2 и Stable Diffusion, за да действа като филтър в точката, в която модел текст към изображение е готов да изпрати интерпретиран рендер обратно на потребителя . В този контекст CLIP трябва да действа като контролен модул и модул за контрол на качеството, като отхвърля деформирани или по друг начин неподходящи рендове. Това е предстои да бъде образувано (Връзка към Discord) в портала, управляван от API на DreamStudio на Stability.ai.

Въпреки това, тъй като CLIP вероятно е както виновникът, така и решението в такъв сценарий (тъй като по същество също така информира начина, по който изображението е еволюирало), и тъй като хардуерните изисквания може да надхвърлят това, което е вероятно да бъде достъпно локално за крайния потребител, този подход може да не е идеален.

Компресиран език

Предложеният UniTune вместо това „финно настройва“ съществуващ дифузионен модел – в този случай собствен Imagen на Google, въпреки че изследователите твърдят, че методът е съвместим с други латентни дифузионни архитектури – така че в него да се инжектира уникален токен, който може да бъде извикан като го включите в текстова подкана.

По номинална стойност това звучи като Google будка за сънища, понастоящем мания сред феновете и разработчиците на Stable Diffusion, която може да инжектира нови герои или обекти в съществуваща контролна точка, често за по-малко от час, въз основа на шепа изходни изображения; или иначе като Текстова инверсия, който създава файлове „sidecar“ за контролна точка, които след това се третират така, сякаш първоначално са били обучени в модела, и може да се възползва от собствените огромни ресурси на модела, като модифицира неговия текстов класификатор, което води до малък файл (в сравнение с минимум 2GB съкратени контролни точки на DreamBooth).

Всъщност, твърдят изследователите, UniTune отхвърли и двата подхода. Те откриха, че Textual Inversion пропуска твърде много важни подробности, докато DreamBooth „работи по-зле и отне повече време“ отколкото решението, на което най-накрая се спряха.

Независимо от това, UniTune използва същия капсулиран семантичен 'metaprompt' подход като DreamBooth, с обучени промени, извикани от уникални думи, избрани от обучителя, които няма да се сблъскат с никакви термини, които понастоящем съществуват в трудоемко обучен модел за публично пускане.

„За да изпълним операцията за редактиране, ние вземаме проби от фино настроените модели с подканата „[rare_tokens] edit_prompt“ (напр. „beikkpic two dogs in a restaurant“ или „beikkpic a minion“).'

Процеса

Въпреки че е загадъчно защо два почти идентични документа, по отношение на крайната им функционалност, трябва да пристигнат от Google в една и съща седмица, въпреки огромния брой прилики между двете инициативи, има поне една ясна разлика между UniTune и Imagic – последният използва подкани на "некомпресиран" естествен език, за да ръководи операциите за редактиране на изображения, докато UniTune тренира в уникални токени в стил DreamBooth.

Ето защо, ако редактирате с Imagic и желаете да осъществите трансформация от такова естество...

От доклада на UniTune – UniTune се противопоставя на любимата конкурентна невронна рамка за редактиране на Google, SDEdit. Резултатите на UniTune са най-вдясно, докато изчислената маска се вижда на второто изображение отляво.

.. в Imagic бихте въвели „третото лице, седнало на заден план, като сладко космато чудовище“.

Еквивалентната команда UniTune би била „Човек отзад като [x]“, Където x е каквато и да е странна и уникална дума, свързана с фино обучената концепция, свързана с героя на косматото чудовище.

Докато редица изображения се подават или в DreamBooth, или в Textual Inversion с намерението да се създаде абстракция в стил deepfake, която може да бъде управлявана в много пози, UniTune и Imagic вместо това подават едно изображение в системата – оригиналното, девствено изображение.

Това е подобно на начина, по който работят много от базираните на GAN инструменти за редактиране от последните няколко години – чрез преобразуване на входно изображение в латентни кодове в латентното пространство на GAN и след това адресиране на тези кодове и изпращането им до други части на латентния пространство за модификация (т.е. въвеждане на снимка на млад тъмнокос човек и прожектирането й чрез латентни кодове, свързани със „стари“ или „руси“ и т.н.).

Въпреки това, резултатите в модел на дифузия и по този метод са доста изумително точни в сравнение и далеч по-малко двусмислени:

Процесът на фина настройка

Методът UniTune по същество изпраща оригиналното изображение чрез дифузионен модел с набор от инструкции как трябва да бъде модифицирано, използвайки огромните хранилища от налични данни, обучени в модела. Всъщност можете да направите това точно сега със Stable Diffusion's img2img функционалност – но не без изкривяване или по някакъв начин промяна на частите от изображението, които бихте предпочели да запазите.

По време на процеса UniTune системата е фина настройкаd, което означава, че UniTune принуждава модела да възобнови обучението, като повечето от неговите слоеве са незамразени (вижте по-долу). В повечето случаи фината настройка ще извади всичко общ стойности на загуба на трудно спечелен високоефективен модел в полза на инжектиране или усъвършенстване на някакъв друг аспект, който се желае да бъде създаден или подобрен.

Въпреки това, с UniTune изглежда, че копието на модела, върху което е действано, въпреки че може да тежи няколко гигабайта или повече, ще бъде третирано като обезпечение за еднократна употреба и ще бъде изхвърлено в края на процеса, след като е изпълнило една единствена цел. Този вид случаен тонаж от данни се превръща в ежедневна криза за съхранение за феновете на DreamBooth, чиито собствени модели, дори когато са съкратени, са не по-малко от 2 GB на тема.

Както при Imagic, основната настройка в UniTune се извършва на долните два от трите слоя в Imagen (основа 64px, 64px>256px и 256px>1024px). За разлика от Imagic, изследователите виждат известна потенциална стойност в оптимизирането на настройката и за този последен и най-голям слой със супер разделителна способност (въпреки че все още не са го опитали).

За най-долния слой от 64 пиксела, моделът е предубеден към основното изображение по време на обучение, с множество дублиращи се двойки изображение/текст, подавани в системата за 128 итерации при партиден размер 4 и с Адафактор като функция на загуба, работеща при скорост на обучение от 0.0001. Въпреки че T5 енкодер само е замразен по време на тази фина настройка, той също е замразен по време на първоначалното обучение на Imagen

След това горната операция се повтаря за слоя 64>256px, като се използва същата процедура за увеличаване на шума, използвана при първоначалното обучение на Imagen.

Вземането на проби

Има много възможни методи за вземане на проби, чрез които направените промени могат да бъдат извлечени от фино настроения модел, включително насоки без класификатор (CFG), опора и на стабилната дифузия. CFG основно определя степента, до която моделът е свободен да „следва въображението си“ и да изследва възможностите за изобразяване – или в противен случай, при по-ниски настройки, степента, до която трябва да се придържа към данните от входния източник и да прави по-малко мащабни или драматични промени .

Подобно на Textual Inversion (малко по-малко с DreamBooth), UniTune е податлив на прилагане на различни графични стилове към оригинални изображения, както и на по-фотореалистични редакции.

Изследователите също експериментираха с SDEditТехниката на „късен старт“, при която системата се насърчава да запази оригиналните детайли, като е само частично „шум“ от самото начало, но по-скоро запазва основните си характеристики. Въпреки че изследователите са използвали това само на най-долния от слоевете (64px), те вярват, че това може да бъде полезна допълнителна техника за вземане на проби в бъдеще.

Изследователите също експлоатираха подкана към подкана като допълнителна текстово базирана техника за кондициониране на модела:

„При настройката „от подкана до подкана“ открихме, че техника, която наричаме Бързо насочване, е особено полезна за настройка на точността и изразителността.

„Бързото насочване е подобно на Безплатното насочване на класификатора, с изключение на това, че базовата линия е различна подкана вместо безусловния модел. Това насочва модела към делтата между двете подкани.'

Въпреки това, бързите насоки, твърдят авторите, са били необходими само от време на време в случаите, когато CFG не успя да постигне желания резултат.

Друг нов подход за вземане на проби, открит по време на разработването на UniTune, беше интерполация, където областите на изображението са достатъчно различни, така че както оригиналното, така и промененото изображение да са много сходни по композиция, което позволява да се използва по-„наивна“ интерполация.

Интерполацията може да направи процесите с по-голямо усилие на UniTune излишни в случаите, когато областите, които трябва да се трансформират, са дискретни и добре ограничени.

Авторите предполагат, че интерполацията може потенциално да работи толкова добре за голям брой целеви изходни изображения, че може да се използва като настройка по подразбиране, и отбелязват също, че има силата да осъществи изключителни трансформации в случаите, когато сложните оклузии не го правят трябва да се преговаря с по-интензивни методи.

UniTune може да извършва локални редакции със или без маски за редактиране, но също така може да решава едностранно къде да позиционира редакциите, с необичайна комбинация от интерпретативна сила и стабилна есенциализация на изходните входни данни:

В най-горното изображение във втората колона UniTune, натоварен да вмъкне „червен влак на заден план“, го е поставил на подходящо и автентично място. Обърнете внимание в другите примери как семантичната цялост на изходното изображение се поддържа дори в средата на извънредни промени в пикселното съдържание и основните стилове на изображенията.

латентност

Въпреки че първата итерация на всяка нова система ще бъде бавна и въпреки че е възможно или участието на общността, или корпоративен ангажимент (обикновено не са и двете) в крайна сметка да ускорят и оптимизират ресурсоемка рутина, както UniTune, така и Imagic изпълняват някои доста големи маневри за машинно обучение, за да се създадат тези невероятни редакции, и е под въпрос до каква степен такъв жаден за ресурси процес би могъл някога да бъде сведен до домашна употреба, а не до управляван от API достъп (макар че последното може да е по-желателно за Google ).

В момента обиколката от входа до резултата е около 3 минути на T4 GPU, с около 30 секунди допълнително за извод (съгласно всяка рутина за извод). Авторите признават, че това е голямо забавяне и едва ли се квалифицира като „интерактивно“, но също така отбелязват, че моделът остава достъпен за допълнителни редакции след първоначалната настройка, докато потребителят приключи с процеса, което намалява времето за редактиране .

Първо публикувано на 21 октомври 2022 г.