Kunsmatige Intelligensie

Ontwikkeling is die volgende diepvalse revolusie

CGI-datavergroting word in 'n nuwe projek gebruik om groter beheer oor diepvals beelde te verkry. Alhoewel jy steeds nie CGI-koppe effektief kan gebruik om die ontbrekende leemtes in diepvervalsde gesigdatastelle aan te vul nie, beteken 'n nuwe golf van navorsing oor die ontknoping van identiteit uit konteks dat jy binnekort nie hoef te doen nie.

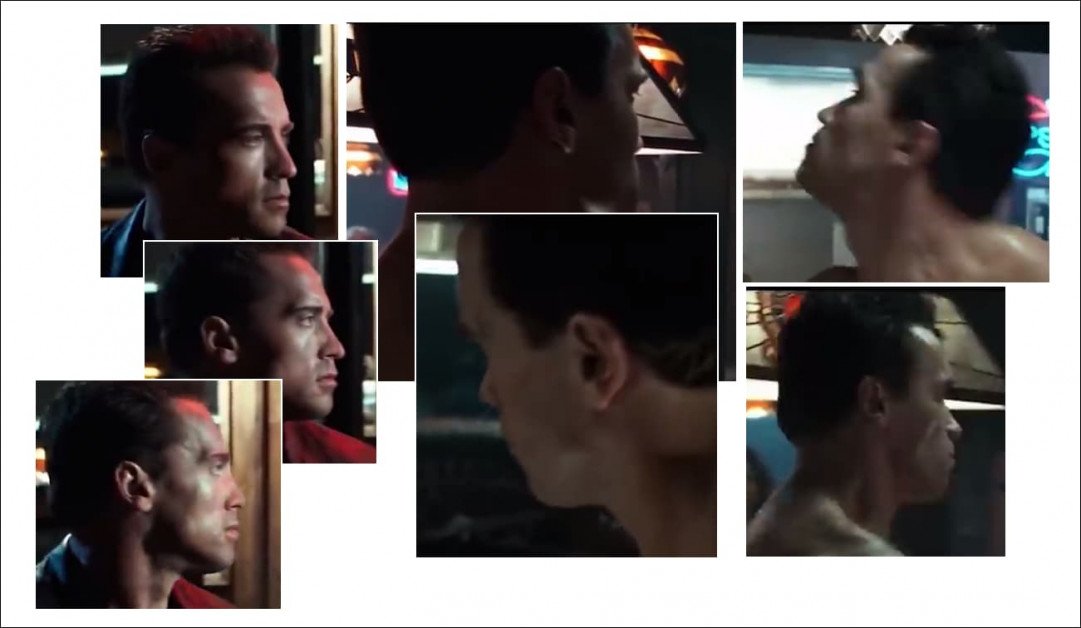

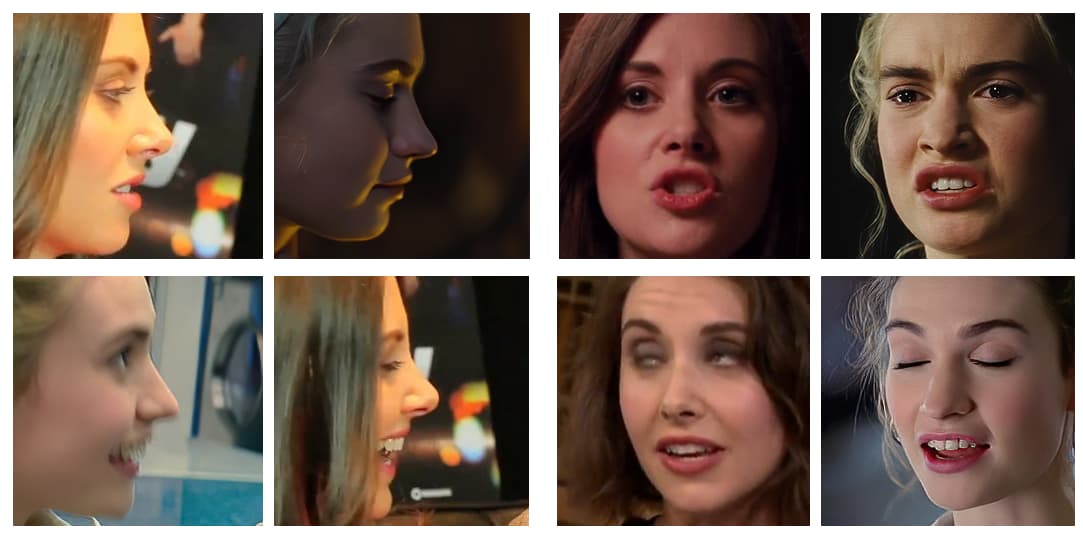

Die skeppers van sommige van die mees suksesvolle virale diepnep-video's van die afgelope paar jaar kies hul bronvideo's baie noukeurig, en vermy volgehoue profielskote (dws die soort kantfoto's wat deur polisie-inhegtenisprosedures gewild gemaak word), skerp hoeke en ongewone of oordrewe uitdrukkings . Die demonstrasievideo's wat deur virale deepfakers vervaardig word, is toenemend geredigeerde samestellings wat die 'maklikste' hoeke en uitdrukkings kies om diepvervals te word.

Trouens, die mees akkommoderende teikenvideo waarin 'n diepvervalste beroemdheid ingevoeg kan word, is een waar die oorspronklike persoon (wie se identiteit deur die diepvals uitgevee sal word) reguit na die kamera kyk, met 'n minimale reeks uitdrukkings.

Die meeste gewilde diepvals van onlangse jare het onderwerpe gewys wat direk na die kamera kyk, en óf slegs gewilde uitdrukkings (soos glimlag), wat maklik uit rooitapyt-paparazzi-uitset onttrek kan word, óf (soos met die 2019-nep van Sylvester Stallone) as die Terminator, links op die foto), ideaal met geen uitdrukking nie, aangesien neutrale uitdrukkings uiters algemeen is, wat dit maklik maak om in diepvals modelle in te sluit.

Omdat deepfake tegnologieë soos DeepFaceLab en gesig ruil hierdie eenvoudiger ruiltransaksies baie goed uitvoer, ons is genoeg verblind deur wat hulle bereik om nie te sien waartoe hulle nie in staat is nie, en – dikwels – probeer nie eers nie:

Gryp uit 'n bekroonde diepvals video waar Arnold Schwarzenegger in Sylvester Stallone omskep word - tensy die hoeke te moeilik is. Profiele bly 'n blywende probleem met huidige diepvals benaderings, deels omdat die oopbronsagteware wat gebruik word om gesigsposisies in diepvals raamwerke te definieer nie vir syaansigte geoptimaliseer is nie, maar hoofsaaklik weens die gebrek aan geskikte bronmateriaal in een of albei van die nodige datastelle. Bron: https://www.youtube.com/watch?v=AQvCmQFScMA

nuwe navorsing van Israel stel 'n nuwe metode voor om sintetiese data, soos CGI-koppe, te gebruik om diepvervalsing in die 2020's te bring, deur werklik gesigsidentiteite (dws die noodsaaklike gesigskenmerke van 'Tom Cruise', vanuit alle hoeke) van hul konteks te skei (bv. opsoek, sywaarts kyk, fronsend, fronsend in die donker, wenkbroue gegrou, oë toe, Ens.)

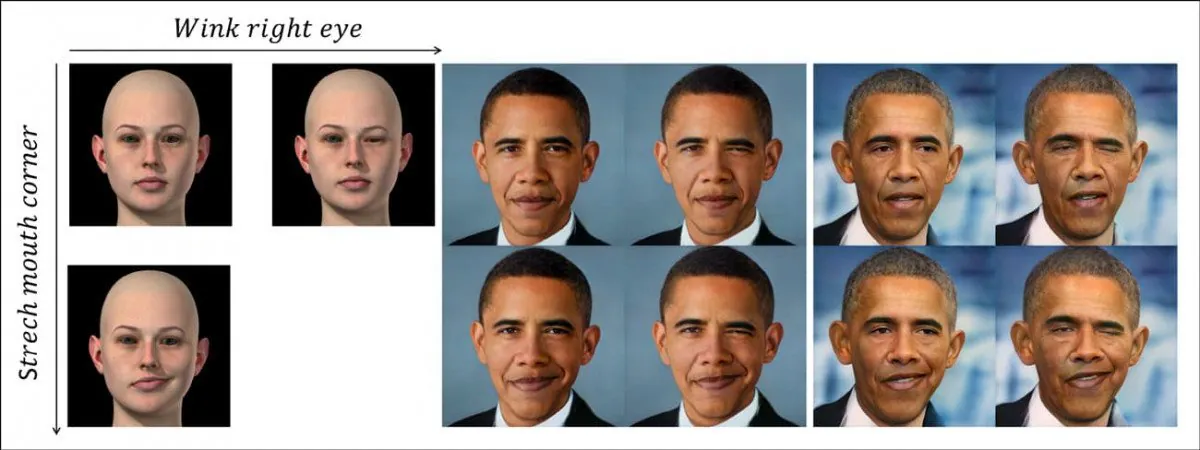

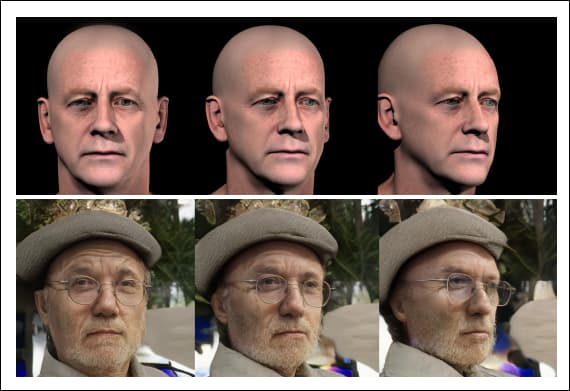

Die nuwe stelsel skei houding en konteks (dws 'n oogknip) diskreet van die individu se identiteitskodering deur onverwante sintetiese gesigdata (foto links) te gebruik. In die boonste ry sien ons 'n 'knipoog' wat na die identiteit van Barack Obama oorgedra word, aangespoor deur die geleerde nie-lineêre pad van 'n GAN se latente ruimte, voorgestel deur die CGI-beeld aan die linkerkant. In die ry hieronder sien ons die uitgerekte mondhoekfaset wat op die oudpres. Regs onder sien ons dat beide eienskappe gelyktydig toegepas word. Bron: https://arxiv.org/pdf/2111.08419.pdf

Dit is nie bloot nie diep valse koppoppespel, 'n tegniek wat meer geskik is vir avatars en gedeeltelike-gesig lip-sinchronisasie, en wat beperkte potensiaal het vir volwaardige diepvalse video-transformasies.

Dit verteenwoordig eerder 'n pad vorentoe vir 'n fundamentele skeiding van instrumentaliteit (soos 'verander die hoek van die kop', 'skep 'n frons') van identiteit, en bied 'n pad na 'n hoëvlak eerder as 'afgeleide' beeldsintese-gebaseerde diepvals raamwerk.

Die nuwe referaat is getitel Delta-GAN-enkodeerder: kodering van semantiese veranderinge vir eksplisiete beeldredigering, met behulp van min sintetiese monsters, en kom van navorsers by Technion – Israel Institute of Technology.

Om te verstaan wat die werk beteken, kom ons kyk hoe diepvals tans oral geproduseer word, van diepvalse pornografiese werwe tot Industriële lig en magie (aangesien die DeepFaceLab oopbronbewaarplek tans dominant is in beide 'amateur' en professionele diepvervalsing).

Wat hou huidige Deepfake-tegnologie terug?

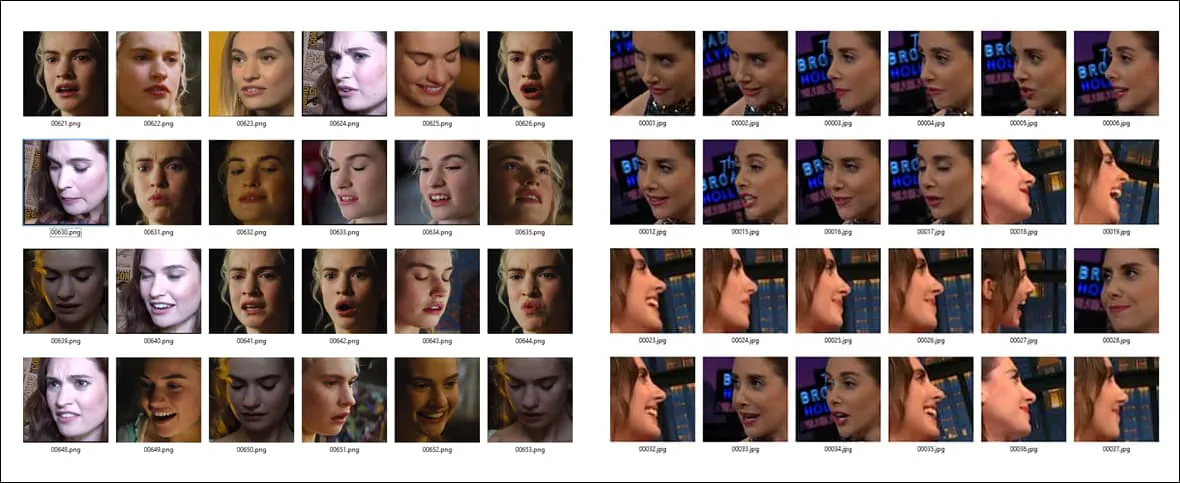

Deepfakes word tans geskep deur opleiding 'n enkodeerder/dekodeerder masjienleermodel op twee vouers van gesigbeelde – die persoon wat jy wil 'oorverf' (in die vorige voorbeeld is dit Arnie) en die persoon wat jy in die beeldmateriaal wil plaas (Sly).

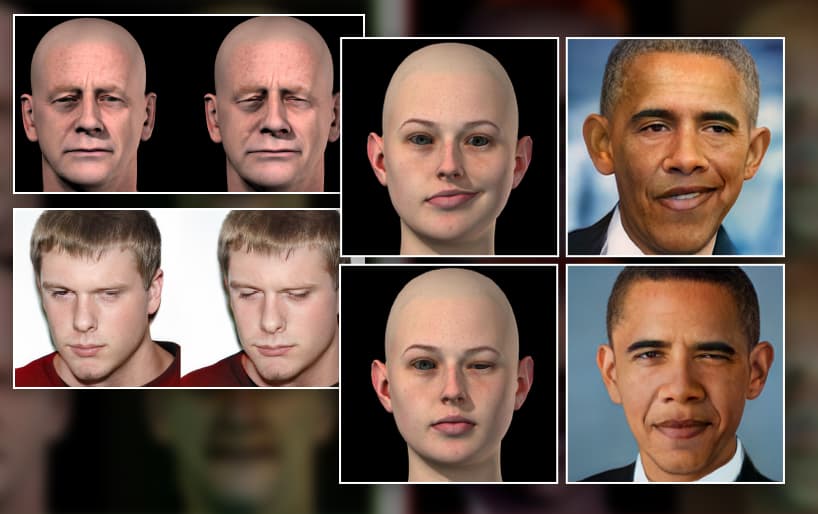

Voorbeelde van verskillende houdings en beligtingstoestande oor twee verskillende gesigstelle. Let op die kenmerkende uitdrukking aan die einde van die derde ry in kolom A, wat waarskynlik nie 'n gelyke ekwivalent in die ander datastel sal hê nie.

Die enkodeerder/dekodeerderstelsel dan vergelyk elke enkele prent in elke vouer na mekaar, onderhou, verbeter en herhaal hierdie operasie vir honderde duisende herhalings (dikwels vir so lank as 'n week), totdat dit die noodsaaklike kenmerke van beide identiteite goed genoeg verstaan om hulle na goeddunke om te ruil.

Vir elk van die twee mense wat in die proses omgeruil word, is wat die diepvals argitektuur oor identiteit leer verstrengel met konteks. Dit kan nie beginsels leer en toepas oor 'n generiese houding 'vir goed en alles' nie, maar benodig oorvloedige voorbeelde in die opleidingsdatastel, vir elke identiteit wat by die gesigsruil betrokke gaan wees.

As jy dus twee identiteite wil omruil wat iets meer ongewoon doen as om net te glimlag of reguit na die kamera te kyk, gaan jy nodig hê baie gevalle van daardie spesifieke houding/identiteit oor die twee gesigstelle:

Omdat gesig-ID en pose-eienskappe tans so verweef is, is 'n wye verskeidenheid van uitdrukking, kopposisie en (tot 'n mindere mate) beligting oor twee gesigdatastelle nodig om 'n effektiewe diepvals model op stelsels soos DeepFaceLab op te lei. Hoe minder 'n spesifieke konfigurasie (soos 'syaansig/glimlag/sonlig') in beide gesigstelle verskyn, hoe minder akkuraat sal dit in 'n diepvals video weergee, indien nodig.

As stel A die ongewone houding bevat, maar stel B dit ontbreek, is jy redelik ongelukkig; maak nie saak hoe lank jy die model oplei nie, dit sal nooit leer om daardie pose goed tussen die identiteite weer te gee nie, want dit het net die helfte van die nodige inligting gehad toe dit opgelei is.

Selfs al het jy bypassende beelde, is dit dalk nie genoeg nie: as stel A die bypassende houding het, maar met harde kantbeligting, in vergelyking met die platverligte ekwivalente pose in die ander gesigstel, het die kwaliteit van die ruil gewen nie so goed wees asof elkeen gemeenskaplike beligtingeienskappe gedeel het nie.

Waarom die data skaars is

Tensy jy gereeld gearresteer word, het jy waarskynlik nie soveel syprofielfoto's van jouself nie. Enige wat opgekom het, het jy waarskynlik weggegooi. Aangesien foto-agentskappe dieselfde doen, is profielgesigskote moeilik om te bekom.

Deepfakers sluit dikwels veelvuldige kopieë van die beperkte syaansig-profieldata in wat hulle vir 'n identiteit in 'n gesigstel het, net sodat daardie houding ten minste 'n min aandag en tyd tydens opleiding, in plaas daarvan om as 'n uitskieter.

Maar daar is baie meer moontlike tipes syaansig gesigfoto's as wat waarskynlik beskikbaar sal wees vir insluiting in 'n datastel - glimlag, frons, skree, huil, donker verlig, smalend, verveeld, vrolike, flits verlig, opsoek, afkyk, oë oop, oë toe…en so aan. Enige van hierdie posisies, in veelvuldige kombinasies, kan nodig wees in 'n teiken diepvals teikenvideo.

En dit is net profiele. Hoeveel foto's het jy van jouself wat soek regop? Het jy genoeg om breedweg die 10,000 XNUMX moontlike uitdrukkings jy kan dalk dra terwyl jy daardie presiese houding vanuit daardie presiese kamerahoek hou, wat ten minste sommige van die dek een miljoen moontlike beligtingsomgewings?

Die kans is groot dat jy nie eens het nie 1 foto van jouself wat opkyk. En dit is net twee hoeke uit die honderd of meer wat nodig is vir volle dekking.

Selfs as dit moontlik was om volle dekking van 'n gesig vanuit alle hoeke onder 'n reeks beligtingstoestande te genereer, sou die resulterende datastel heeltemal te groot wees om op te lei, in die orde van honderdduisende prente; en selfs al is dit kon opgelei word, sal die aard van die opleidingsproses vir huidige diepvals raamwerke die oorgrote meerderheid van daardie ekstra data weggooi ten gunste van 'n beperkte aantal afgeleide kenmerke, omdat die huidige raamwerke reduksionisties is en nie baie skaalbaar is nie.

Sintetiese vervanging

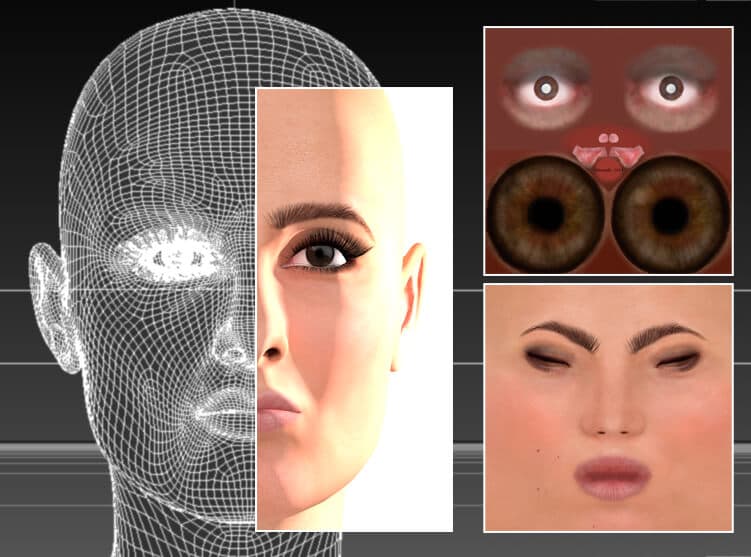

Sedert die begin van deepfakes, het deepfakers geëksperimenteer met die gebruik van CGI-styl beelde, koppe gemaak in 3D-toepassings soos Cinema4D en Maya, om daardie 'ontbrekende poses' te genereer.

Geen KI nodig nie; 'n aktrise word herskep in 'n tradisionele CGI-program, Cinema 4D, deur gebruik te maak van meshes en bitmap-teksture – tegnologie wat terugdateer na die 1960's, hoewel dit eers vanaf die 1990's wydverspreide gebruik bereik het. In teorie kan hierdie gesigmodel gebruik word om diepvals brondata vir ongewone houdings, beligtingstyle en gesigsuitdrukkings te genereer. In werklikheid was dit van beperkte of geen nut in diepvervalsing nie, aangesien die 'valsheid' van die weergawes geneig is om deur te bloei in omgeruilde video's. Bron: Hierdie artikel se skrywer se beeld by https://rossdawson.com/futurist/implications-of-ai/comprehensive-guide-ai-artificial-intelligence-visual-effects-vfx/

Hierdie metode word oor die algemeen vroeg laat vaar deur nuwe deepfake praktisyns, want alhoewel dit houdings en uitdrukkings kan verskaf wat andersins nie beskikbaar is nie, bloei die sintetiese voorkoms van die CGI gesigte gewoonlik deur na die swaps as gevolg van verstrengeling van ID en kontekstuele/semantiese inligting.

Dit kan lei tot die skielike flits van 'uncanny valley'-gesigte in 'n andersins oortuigende diepvals video, aangesien die algoritme begin gebruik maak van die enigste data wat dit mag hê vir 'n ongewone houding of uitdrukking - duidelik vals gesigte.

Een van die gewildste onderwerpe vir deepfakers, is 'n 3D-diepfake-algoritme vir die Australiese aktrise Margot Robbie ingesluit in die verstekinstallasie van DeepFaceLive, 'n weergawe van DeepFaceLab wat diepvals in 'n regstreekse stroom kan uitvoer, soos 'n webkamerasessie. 'n CGI-weergawe, soos hierbo afgebeeld, kan gebruik word om ongewone 'ontbrekende' hoeke in diepvals datastelle te verkry. Source: https://sketchfab.com/3d-models/margot-robbie-bust-for-full-color-3d-printing-98d15fe0403b4e64902332be9cfb0ace

CGI gesigte as 'n losstaande, konseptuele riglyne

In plaas daarvan is die nuwe Delta-GAN Encoder (DGE) metode van die Israeliese navorsers meer effektief, omdat die pose en kontekstuele inligting van die CGI beelde heeltemal geskei is van die 'identiteit' inligting van die teiken.

Ons kan hierdie beginsel in aksie sien in die prent hieronder, waar verskeie koporiëntasies verkry is deur die CGI-beelde as 'n riglyn te gebruik. Aangesien die identiteitskenmerke nie verband hou met die kontekstuele kenmerke nie, is daar geen deurbloeding van die sintetiese voorkoms van die CGI-gesig of die identiteit wat daarin uitgebeeld word nie:

Met die nuwe metode hoef jy nie drie afsonderlike werklike bronprente te vind om 'n diepvals uit verskeie hoeke uit te voer nie – jy kan net die CGI-kop draai, waarvan die hoëvlak abstrakte kenmerke op die identiteit afgedwing word sonder om enige ID te lek inligting.

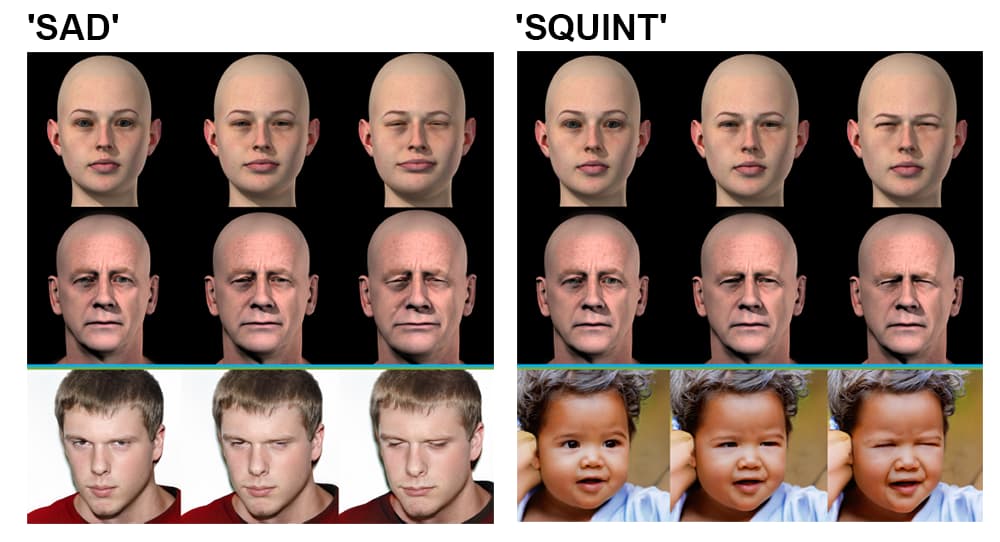

Delta-GAN-enkodeerder. Links bo-groep: die hoek van 'n bronbeeld kan binne 'n sekonde verander word om 'n nuwe bronbeeld weer te gee, wat in die uitvoer weerspieël word; groep regs bo: beligting word ook van identiteit ontstrengel, wat die superimponering van beligtingstyle moontlik maak; groep links onder: veelvuldige gesigsbesonderhede word verander om 'n 'hartseer' uitdrukking te skep; groep regs onder: een enkele gesigsuitdrukkingsdetail word verander, sodat die oë skeel.

Hierdie skeiding van identiteit en konteks word in die opleidingstadium bereik. Die pyplyn vir die nuwe diepvals argitektuur soek die latente vektor in 'n voorafopgeleide Generative Adversarial Network (GAN) wat ooreenstem met die beeld wat getransformeer moet word - 'n Sim2Real-metodologie wat voortbou op 'n 2018 projek van IBM se KI-navorsingsafdeling.

Die navorsers neem waar:

'Met slegs 'n paar steekproewe, wat volgens 'n spesifieke eienskap verskil, kan 'n mens die verstrengelde gedrag van 'n vooraf-opgeleide verstrengelde generatiewe model leer. Daar is geen behoefte aan presiese werklike monsters om daardie doel te bereik nie, wat nie noodwendig haalbaar is nie.

'Deur nie-realistiese datamonsters te gebruik, kan dieselfde doel bereik word danksy die gebruik van die semantiek van die geënkodeerde latente vektore. Die toepassing van verlangde veranderinge oor bestaande datamonsters kan gedoen word sonder eksplisiete verkenning van latente ruimtegedrag.'

Die navorsers voorsien dat die kernbeginsels van ontknoping wat in die projek ondersoek is na ander domeine oorgedra kan word, soos binne-argitektuursimulasies, en dat die Sim2Real-metode wat vir Delta-GAN-Encoder aangeneem is, uiteindelik diepvals instrumentaliteit kan moontlik maak gebaseer op blote sketse, eerder as CGI-styl invoer.

Daar kan geargumenteer word dat die mate waarin die nuwe Israeliese stelsel moontlik of nie in staat is om diepvalse video's te sintetiseer, veel minder betekenisvol is as die vordering wat die navorsing gemaak het in die ontwarring van konteks van identiteit, in die proses om meer beheer oor die latente ruimte te verkry. van 'n GAN.

Ontwikkeling is 'n aktiewe veld van navorsing in beeldsintese; in Januarie 2021, 'n Amazon-geleide navorsing papier soortgelyke houdingsbeheer en ontknoping getoon, en in 2018 a papier van die Shenzhen Institutes of Advanced Technology by die Chinese Academy of Sciences het vordering gemaak met die generering van arbitrêre standpunte in 'n GAN.