Kunsmatige Intelligensie

Multimodale AI ontwikkel soos ChatGPT sig kry met GPT-4V (ision)

In die voortdurende poging om KI meer soos mense te maak, het OpenAI se GPT-modelle voortdurend die grense verskuif. GPT-4 is nou in staat om opdragte van beide teks en beelde te aanvaar.

Multimodaliteit in generatiewe KI dui op 'n model se vermoë om gevarieerde uitsette soos teks, beelde of oudio te produseer gebaseer op die invoer. Hierdie modelle, opgelei op spesifieke data, leer onderliggende patrone om soortgelyke nuwe data te genereer, wat KI-toepassings verryk.

Onlangse vordering in multimodale KI

'n Onlangse noemenswaardige sprong in hierdie veld word gesien met die integrasie van DALL-E 3 in ChatGPT, 'n beduidende opgradering in OpenAI se teks-na-beeld-tegnologie. Hierdie versnit maak voorsiening vir 'n gladder interaksie waar ChatGPT help om presiese aanwysings vir DALL-E 3 te skep, wat gebruikersidees in aanskoulike KI-gegenereerde kuns omskep. Dus, terwyl gebruikers direk met DALL-E 3 kan kommunikeer, maak ChatGPT in die mengsel die proses om KI-kuns te skep baie meer gebruikersvriendelik.

Kyk meer na DALL-E 3 en die integrasie daarvan met ChatGPT na hierdie skakel. Hierdie samewerking wys nie net die vooruitgang in multimodale KI nie, maar maak ook KI-kunsskepping 'n briesie vir gebruikers.

Google se gesondheid aan die ander kant bekendgestel Med-PaLM M in Junie vanjaar. Dit is 'n multimodale generatiewe model wat vaardig is in die enkodering en interpretasie van diverse biomediese data. Dit is bereik deur PaLM-E, 'n taalmodel, te verfyn om voorsiening te maak vir mediese domeine deur 'n oopbron-maatstaf, MultiMedBench, te gebruik. Hierdie maatstaf bestaan uit meer as 1 miljoen monsters oor 7 biomediese datatipes en 14 take soos mediese vrae-antwoord en generering van radiologieverslag.

Verskeie nywerhede neem innoverende multimodale KI-instrumente aan om besigheidsuitbreiding aan te wakker, bedrywighede te stroomlyn en kliëntebetrokkenheid te verhoog. Vordering in stem-, video- en teks-KI-vermoëns dryf die groei van multimodale KI aan.

Ondernemings soek multimodale KI-toepassings wat in staat is om sakemodelle en prosesse op te knap, wat groeipaaie oor die generatiewe KI-ekosisteem oopmaak, van datahulpmiddels tot opkomende KI-toepassings.

Na die bekendstelling van GPT-4 in Maart, het sommige gebruikers 'n afname in sy reaksiekwaliteit met verloop van tyd waargeneem, 'n bekommernis wat deur noemenswaardige ontwikkelaars en op OpenAI se forums weerklink. Aanvanklik afgedank deur 'n OpenAI, 'n later bestudeer het die kwessie bevestig. Dit het 'n daling in GPT-4 se akkuraatheid van 97.6% tot 2.4% tussen Maart en Junie aan die lig gebring, wat 'n afname in antwoordkwaliteit met daaropvolgende modelopdaterings aandui.

Die hype rondom Maak KI's oop ChatGPT is nou terug. Dit kom nou met 'n visie-funksie GPT-4V, wat gebruikers toelaat om GPT-4 beelde te laat ontleed wat deur hulle gegee word. Dit is die nuutste kenmerk wat vir gebruikers oopgestel is.

Om beeldanalise by groot taalmodelle (LLM's) soos GPT-4 te voeg, word deur sommige gesien as 'n groot stap vorentoe in KI-navorsing en -ontwikkeling. Hierdie soort multimodale LLM maak nuwe moontlikhede oop en neem taalmodelle verder as teks om nuwe koppelvlakke te bied en nuwe soorte take op te los, wat vars ervarings vir gebruikers skep.

Die opleiding van GPT-4V is in 2022 voltooi, met vroeë toegang wat in Maart 2023 uitgerol is. Die visuele kenmerk in GPT-4V word aangedryf deur GPT-4-tegnologie. Die opleidingsproses het dieselfde gebly. Aanvanklik is die model opgelei om die volgende woord in 'n teks te voorspel deur 'n massiewe datastel van beide teks en beelde uit verskeie bronne, insluitend die internet, te gebruik.

Later is dit verfyn met meer data, deur gebruik te maak van 'n metode genaamd versterkingsleer uit menslike terugvoer (RLHF), om uitsette te genereer wat mense verkies het.

GPT-4 Visie Meganika

GPT-4 se merkwaardige visietaalvermoëns, hoewel indrukwekkend, het onderliggende metodes wat op die oppervlak bly.

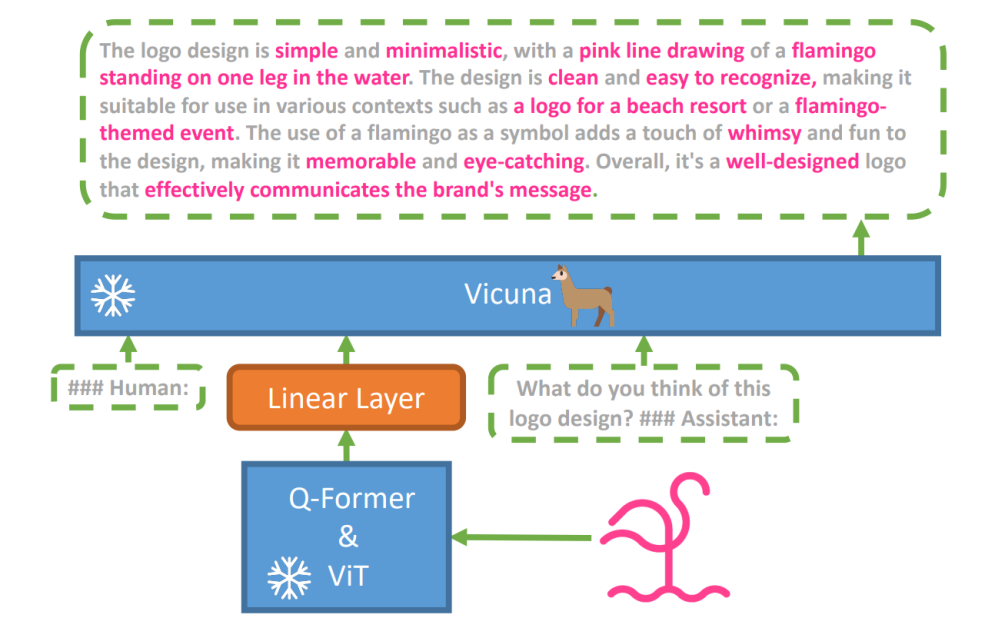

Om hierdie hipotese te verken, 'n nuwe visie-taalmodel, miniGPT-4 is bekendgestel, met behulp van 'n gevorderde LLM genaamd Vicuna. Hierdie model gebruik 'n visie-enkodeerder met vooraf-opgeleide komponente vir visuele persepsie, wat geënkodeerde visuele kenmerke in lyn bring met die Vicuna-taalmodel deur 'n enkele projeksielaag. Die argitektuur van MiniGPT-4 is eenvoudig maar doeltreffend, met die fokus op die aanpassing van visuele en taalkenmerke om visuele gespreksvermoëns te verbeter.

MiniGPT-4 se argitektuur sluit 'n visie-enkodeerder in met vooraf-opgeleide ViT en Q-Former, 'n enkele lineêre projeksielaag en 'n gevorderde Vicuna-groottaalmodel.

Die neiging van outoregressiewe taalmodelle in visietaaltake het ook gegroei, en kapitaliseer op kruismodale oordrag om kennis tussen taal en multimodale domeine te deel.

MiniGPT-4 oorbrug die visuele en taaldomeine deur visuele inligting van 'n vooraf-opgeleide visie-enkodeerder met 'n gevorderde LLM in lyn te bring. Die model gebruik Vicuna as die taaldekodeerder en volg 'n twee-stadium opleidingsbenadering. Aanvanklik is dit opgelei op 'n groot datastel van beeld-teks-pare om visie-taalkennis te begryp, gevolg deur fyn-instelling op 'n kleiner, hoë-gehalte datastel om generasie betroubaarheid en bruikbaarheid te verbeter.

Om die natuurlikheid en bruikbaarheid van gegenereerde taal in MiniGPT-4 te verbeter, het navorsers 'n twee-stadium-belyningsproses ontwikkel, wat die gebrek aan voldoende visie-taal-belyningsdatastelle aanspreek. Hulle het 'n gespesialiseerde datastel vir hierdie doel saamgestel.

Aanvanklik het die model gedetailleerde beskrywings van insetbeelde gegenereer, wat die detail verbeter deur 'n gespreksaanvraag te gebruik wat in lyn is met die Vicuna-taalmodel se formaat. Hierdie stadium was daarop gemik om meer omvattende beeldbeskrywings te genereer.

Aanvanklike prentbeskrywing-aanvraag:

###Mens: Beskryf hierdie beeld in detail. Gee soveel besonderhede as moontlik. Sê alles wat jy sien. ###Assistent:

Vir data-na-verwerking is enige teenstrydighede of foute in die gegenereerde beskrywings reggestel met behulp van ChatGPT, gevolg deur handverifikasie om hoë gehalte te verseker.

Tweede-stadium fyninstelling-aanvraag:

###Mens: ###Assistent:

Hierdie verkenning maak 'n venster oop om die meganika van multimodale generatiewe KI soos GPT-4 te verstaan, en werp lig op hoe visie- en taalmodaliteite effektief geïntegreer kan word om samehangende en kontekstueel ryk uitsette te genereer.

Verken GPT-4 Visie

Bepaal beeldoorsprong met ChatGPT

GPT-4 Vision verbeter ChatGPT se vermoë om beelde te ontleed en hul geografiese oorsprong vas te stel. Hierdie kenmerk verander gebruikersinteraksies van net teks na 'n mengsel van teks en beeldmateriaal, en word 'n handige hulpmiddel vir diegene wat nuuskierig is oor verskillende plekke deur beelddata.

Komplekse wiskundige konsepte

GPT-4 Vision blink uit in die delf in komplekse wiskundige idees deur grafiese of handgeskrewe uitdrukkings te ontleed. Hierdie kenmerk dien as 'n nuttige hulpmiddel vir individue wat ingewikkelde wiskundige probleme wil oplos, wat GPT-4 Vision as 'n noemenswaardige hulpmiddel in opvoedkundige en akademiese velde merk.

Omskakeling van handgeskrewe invoer na LaTeX-kodes

Een van GPT-4V se merkwaardige vermoëns is sy vermoë om handgeskrewe insette in LaTeX-kodes te vertaal. Hierdie kenmerk is 'n seën vir navorsers, akademici en studente wat dikwels handgeskrewe wiskundige uitdrukkings of ander tegniese inligting in 'n digitale formaat moet omskakel. Die transformasie van handgeskrewe na LaTeX brei die horison van dokumentdigitalisering uit en vereenvoudig die tegniese skryfproses.

Onttrek tabelbesonderhede

GPT-4V toon vaardigheid om besonderhede uit tabelle te onttrek en verwante navrae aan te spreek, 'n belangrike bate in data-analise. Gebruikers kan GPT-4V gebruik om deur tabelle te sif, sleutelinsigte in te samel en datagedrewe vrae op te los, wat dit 'n robuuste hulpmiddel maak vir data-ontleders en ander professionele persone.

Begrip visuele wys

Die unieke vermoë van GPT-4V om visuele wys te verstaan, voeg 'n nuwe dimensie aan gebruikersinteraksie toe. Deur visuele leidrade te verstaan, kan GPT-4V op navrae reageer met 'n hoër kontekstuele begrip.

Bou eenvoudige mock-up-webwerwe deur 'n tekening te gebruik

Hierdeur gemotiveer tweet, Ek het probeer om 'n mock-up vir die unite.ai webwerf te skep.

Alhoewel die uitslag nie heeltemal ooreenstem met my aanvanklike visie nie, hier is die resultaat wat ek bereik het.

Beperkings en gebreke van GPT-4V(ision)

Om GPT-4V te ontleed, het Open AI-span kwalitatiewe en kwantitatiewe assesserings uitgevoer. Kwalitatiewe toetse het interne toetse en eksterne deskundige resensies ingesluit, terwyl kwantitatiewe modelweierings en akkuraatheid in verskeie scenario's gemeet het, soos die identifisering van skadelike inhoud, demografiese erkenning, privaatheidskwessies, geoligging, kuberveiligheid en multimodale tronkbrekings.

Tog is die model nie perfek nie.

Die papier beklemtoon beperkings van GPT-4V, soos verkeerde afleidings en ontbrekende teks of karakters in beelde. Dit mag dalk hallusineer of feite uitdink. Veral, dit is nie geskik vir die identifisering van gevaarlike stowwe in beelde, dikwels verkeerd identifiseer hulle.

In mediese beeldvorming kan GPT-4V inkonsekwente reaksies verskaf en 'n gebrek aan bewustheid van standaardpraktyke, wat lei tot potensiële verkeerde diagnoses.

Onbetroubare prestasie vir mediese doeleindes (Bron)

Dit slaag ook nie daarin om die nuanses van sekere haatsimbole te begryp nie en kan onvanpaste inhoud op grond van die visuele insette genereer. OpenAI raai af om GPT-4V vir kritiese interpretasies te gebruik, veral in mediese of sensitiewe kontekste.

Wikkel

Geskep met behulp van Fast Stable Diffusion XL https://huggingface.co/spaces/google/sdxl

Die koms van GPT-4 Vision (GPT-4V) bring 'n klomp koel moontlikhede en nuwe hekkies om oor te spring. Voordat dit uitgerol word, is baie moeite gedoen om seker te maak dat risiko's, veral wanneer dit by foto's van mense kom, goed ondersoek en verminder word. Dit is indrukwekkend om te sien hoe GPT-4V verbeter het, en toon baie belofte in moeilike gebiede soos medisyne en wetenskap.

Nou is daar 'n paar groot vrae op die tafel. Moet hierdie modelle byvoorbeeld bekende mense vanaf foto's kan identifiseer? Moet hulle 'n persoon se geslag, ras of gevoelens uit 'n foto raai? En moet daar spesiale aanpassings wees om gesiggestremde individue te help? Hierdie vrae maak 'n blikkie wurms oop oor privaatheid, regverdigheid en hoe KI in ons lewens moet inpas, waaroor almal 'n sê moet hê.