Kunsmatige Intelligensie

LoReFT: Verstelling van verteenwoordiging vir taalmodelle

Parameterdoeltreffende fyninstelling of PeFT-metodes poog om groot taalmodelle via opdaterings aan te pas by 'n klein aantal gewigte. Die meerderheid van bestaande interpreteerbaarheidswerk het egter getoon dat voorstellings semantiese ryk inligting kodeer, wat daarop dui dat dit 'n beter en kragtiger alternatief kan wees om hierdie voorstellings te redigeer. Vooraf opgeleide groot modelle is dikwels fyn ingestel om vir nuwe domeine of take gebruik te word, en tydens die fyninstellingsproses kan 'n enkele basismodel aangepas word vir 'n wye verskeidenheid take, selfs met slegs klein hoeveelhede binne-domeindata beskikbaar na die model. Die proses om 'n hele model te verfyn is egter hulpbronrowend en duur, veral vir taalmodelle met 'n aansienlik groter aantal groottes en parameters.

Parameterdoeltreffende fyninstelling of PeFT-metodes stel voor om die hoë koste verbonde aan die fyninstelling van die hele model aan te pak deur slegs 'n klein hoeveelheid van die totale beskikbare gewigte by te werk, 'n proses wat help om oefentyd te verminder saam met geheuegebruik. Wat meer belangrik is, is dat parameter-doeltreffende fyninstelling of PeFT-metodes soortgelyke werkverrigting as fyninstelling in verskeie praktiese instellings getoon het. Adapters, 'n algemene familie van parameter-doeltreffende fyninstelling of PeFT-metodes, leer 'n wysiging wat bygevoeg kan word by 'n bykomende stel gewigte wat saam met die bevrore basismodel werk, met onlangse adapters soos LoRA verminder die aantal opleibare parameters in geleerde gewigopdaterings deur lae-rangbenaderings in plaas van volgewigmatrikse te gebruik wanneer die adapters opgelei word.

Met vorige werke wat wysiging van voorstellings demonstreer, kan 'n beter alternatief vir parameterdoeltreffende fyninstelling of PeFT-metodes wees, in hierdie artikel sal ons praat oor Representation Fine-tuning of ReFT-metodes wat op 'n bevrore model werk, en leer taakspesifieke intervensies op verborge voorstellings. Hierdie artikel het ten doel om die ReFt of Representation Fine-tuning-raamwerk in diepte te dek, en ons ondersoek die meganisme, die metodologie, die argitektuur van die raamwerk tesame met die vergelyking daarvan met moderne raamwerke. So kom ons begin.

ReFT: Verstelling van verteenwoordiging vir taalmodelle

In 'n poging om vooraf-opgeleide taalmodelle na nuwe domeine en take aan te neem, verfyn huidige raamwerke hierdie voorafopgeleide taalmodelle gereeld, aangesien met die fynverstellingsproses wat geïmplementeer is, 'n enkele basismodel aangepas kan word vir 'n verskeidenheid take, selfs wanneer jy met 'n klein hoeveelheid in-domein data werk. Alhoewel die fynverstellingsproses wel die algehele werkverrigting 'n hupstoot gee, is dit 'n duur proses, veral as die taalmodel 'n aansienlik hoë aantal parameters het. Om hierdie probleem aan te pak, en die gepaardgaande koste te verminder, PeFT of Parameter-doeltreffend raamwerke fyn instel werk slegs 'n klein fraksie van die totale gewigte op, 'n proses wat nie net die oefentyd verminder nie, maar ook die geheueverbruik verminder, wat die PeFT-raamwerke toelaat om soortgelyke prestasie te behaal in vergelyking met volledige fyn-instellingsbenaderings in praktiese scenario's. Adapters, 'n algemene familie van PeFT's, werk deur 'n wysiging aan te leer wat by 'n bykomende stel gewigte gevoeg kan word saam met 'n subset van gewigte wat in harmonie met die basismodel met bevrore gewigte werk. Onlangse adapter raamwerke soos LoRA en QLoRA het gedemonstreer dat dit moontlik is om volpresisie-adapters bo-op modelle met verminderde presisie op te lei sonder om werkverrigting te beïnvloed. Adapters is gewoonlik meer doeltreffend en doeltreffend in vergelyking met ander metodes wat nuwe modelkomponente bekendstel.

'n Groot hoogtepunt van huidige stand van die kuns Parameterdoeltreffende fynverstellingsraamwerke is dat in plaas daarvan om voorstellings te wysig, hulle gewigte verander. Raamwerke wat handel oor interpreteerbaarheid het egter getoon dat voorstellings ryk semantiese inligting kodeer, wat daarop dui dat voorstellingsredigering 'n beter en 'n kragtiger benadering kan wees in vergelyking met gewigopdaterings. Hierdie aanname dat voorstellingsredigering die beter benadering is, vorm die grondslag van ReFT of Representation Fine-tuning-raamwerk wat intervensies oplei in plaas van modelgewigte aan te pas, wat die model toelaat om 'n klein fraksie van al die voorstellings te manipuleer in 'n poging om modelgedrag te stuur om stroomaf take tydens afleiding op te los. ReFT of Representation Fyn-instelling metodes is drop-in plaasvervangers vir gewig-gebaseerde PeFT of Parameter-doeltreffende fyn-instelling raamwerke. Die ReFT-benadering put inspirasie uit onlangse modelle wat met groot-model-interpreteerbaarheid werk wat op voorstellings ingryp om getroue oorsaaklike meganismes te vind, en die gedrag van die model tydens afleiding stuur, en daarom kan dit gesien word as 'n veralgemening van die representasie-redigeringsmodelle. Voortbou op dieselfde, LoReFT of Low-Rank Subspace ReFT is 'n sterk en effektiewe voorbeeld van ReFT, en is 'n parameterisering van ReFT wat ingryp op verborge voorstellings in die lineêre ruimte wat deur lae-rang projeksie matriks gespan word, en bou direk op die DAS of Verspreide Belyning Soekraamwerk.

Deur voort te beweeg, in teenstelling met volle fyninstelling, lei die PeFT of Parameter-doeltreffende fyninstellingsraamwerk slegs 'n klein fraksie van die parameters van die model op, en slaag daarin om die model aan te pas by stroomaf take. Die parameterdoeltreffende fyninstellingsraamwerk kan in drie hoofkategorieë geklassifiseer word:

- Adapter-gebaseerde metodes: Adapter-gebaseerde metodes lei addisionele modules op soos volledig gekoppelde lae bo-op die vooraf-opgeleide model met bevrore gewigte. Reeksadapters plaas komponente tussen die meerlaagperceptron of MLP en LM of groot model aandaglae, terwyl parallelle adapters modules langs bestaande komponente byvoeg. Aangesien adapters nuwe komponente byvoeg wat nie maklik in bestaande modelgewigte ingevou kan word nie, vorm dit 'n bykomende las tydens afleiding.

- LoRA: LoRA, tesame met sy onlangse variante, benader additiewe gewigte tydens opleiding deur laerangmatrikse te gebruik, en hulle benodig nie bykomende bokoste tydens afleiding nie, aangesien die gewigopdaterings in die model saamgevoeg kan word, en dit is die rede waarom hulle as die huidige beskou word. sterkste PeFT-raamwerke.

- Vinnige gebaseerde metodes: Vinnige gebaseerde metodes voeg sagte tekens wat lukraak geïnisialiseer word in die invoer, en oefen hul inbeddings terwyl die gewigte van die taalmodel gevries word. Die prestasie wat deur hierdie metodes aangebied word, is dikwels nie bevredigend in vergelyking met ander PeFT-benaderings nie, en dit dra ook 'n aansienlike afleidingsbokoste.

In plaas daarvan om die gewigte op te dateer, leer die ReFT-raamwerk intervensies om 'n klein fraksie van die totale voorstellings te verander. Verder het onlangse werke oor voorstellingsingenieurswese en aktiveringsstuur getoon dat die byvoeging van vaste stuurvektore by die oorblywende stroom 'n mate van beheer oor vooraf-opgeleide groot modelgenerasies kan vergemaklik sonder dat dit hulpbronintensief benodig. fyn instelling. Ander raamwerke het getoon dat die redigeer van voorstellings met 'n aangeleerde skaal- en vertaalbewerking kan probeer om die werkverrigting wat LoRA-adapters bied op 'n wye verskeidenheid take met minder aangeleerde parameters te pas, maar nie te oortref nie. Verder het die sukses van hierdie raamwerke oor 'n reeks take getoon dat voorstellings wat deur vooraf-opgeleide taalmodelle ingestel is ryk semantiek dra, hoewel die prestasie van hierdie modelle sub-optimaal is, wat daartoe lei dat PeFT's voortgaan as die moderne benadering. met geen bykomende afleidingslas nie.

ReFT: Metodologie en Argitektuur

Om die stylbewaringsproses eenvoudig te hou, aanvaar die ReFT-raamwerk 'n transformator-gebaseerde groot model as sy teikenmodel wat in staat is om gekontekstualiseerde voorstelling van die volgorde van tekens te produseer. Vir 'n gegewe volgorde met n aantal invoertekens, bederf die ReFT-raamwerk eers hierdie invoertekens in 'n lys voorstellings waarna die m lae die lys van versteekte voorstellings opeenvolgend bereken as 'n funksie van die vorige lys versteekte voorstellings. Elke versteekte voorstelling is 'n vektor, en die taalmodel gebruik die finale versteekte voorstellings om die voorspellings te produseer. Die ReFT-raamwerk oorweeg beide gemaskerde taalmodelle en outoregressiewe taalmodelle. Nou, volgens die lineêre voorstellinghipotese, word konsepte in neurale netwerke binne die lineêre subruimtes van voorstellings geënkodeer. Onlangse modelle het gevind dat hierdie aanspraak waar is in neurale netwerkmodelle wat op natuurlike taal opgelei is, saam met ander insetverspreidings.

Verder, in interpreteerbaarheidstudies, gebruik die toevallige abstraksieraamwerk uitruilintervensies om die rol van neurale netwerkkomponente terloops vas te stel wanneer bepaalde gedrag geïmplementeer word. Die logika agter uitruilingryping is dat as 'n mens 'n voorstelling vasstel aan wat dit vir 'n kontrafeitelike inset sou gewees het, en hierdie ingryping die uitset van die model konsekwent beïnvloed op die manier waarop die aansprake wat deur die ReFT-raamwerk gemaak word oor die komponent wat verantwoordelik is vir die vervaardiging van daardie voorstelling, dan speel die komponent 'n oorsaaklike rol in die gedrag. Alhoewel daar 'n paar metodes is, is verspreide uitruilintervensie die ideale benadering om te toets of 'n konsep in 'n lineêre subruimte van 'n voorstelling geënkodeer is, soos deur die lineêre voorstellinghipotese beweer word. Verder is die DAS-metode voorheen gebruik om lineêre voorstelling in taalmodelle van entiteitseienskappe, sentiment, linguistiese kenmerke en wiskundige redenasie te vind. Verskeie eksperimente het egter aangedui dat die DAS-metode hoogs ekspressief is, en dit beskik oor die vermoë om oorsaaklike doeltreffende subruimtes te vind, selfs wanneer die transformatortaalmodel lukraak geïnisialiseer is, en dus nog geen taakspesifieke voorstellings moet leer nie, wat lei tot die debatteer of DAS effektief en verantwoordelik genoeg is vir interpreteerbaarheidstake.

Die ekspressiwiteit wat DAS bied, dui daarop dat die benadering 'n ideale hulpmiddel kan wees om die gedrag van die taalmodel te beheer tesame met sy werk aan beheerbare generering en verantwoordelike redigering. Daarom, om taalmodelle vir stroomaf take aan te pas, gebruik die ReFT-raamwerk die verspreide uitruilintervensie-operasie om 'n nuwe parameter doeltreffende metode te maak. Verder is die ReFT-metode 'n stel intervensies, en die raamwerk dwing af dat vir enige twee intervensies wat op dieselfde laag werk, die intervensieposisies onsamehangend moet wees, met die parameters van alle intervensiefunksies wat onafhanklik bly. As gevolg hiervan is die ReFT 'n generiese raamwerk wat intervensies op verborge voorstellings insluit tydens die model vorentoe-aangee.

ReFT: Eksperimente en resultate

Om sy prestasie teen bestaande PEFT-raamwerke te evalueer, voer die ReFT-raamwerk eksperimente uit oor vier uiteenlopende natuurlike taalverwerkingsmaatstawwe, en dek meer as 20 datastelle, met die primêre doelwit om 'n ryk prentjie te gee van hoe die LoReFT-raamwerk in verskillende scenario's presteer. Verder, wanneer die LoReFT-raamwerk in die werklike lewe geïmplementeer word, moet ontwikkelaars besluit op hoeveel intervensies om te leer saam met die insetposisies en lae om elkeen op toe te pas. Om die taak te voltooi, stel die ReFT-raamwerk vier hiperparameters in.

- Die aantal voorvoegselsposisies om op in te gryp.

- Die aantal agtervoegselposisies om op in te gryp.

- Op watter stel lae om in te gryp.

- Of intervensieparameters oor verskillende posisies in dieselfde laag gekoppel moet word of nie.

Deur dit te doen, vereenvoudig die ReFT-raamwerk die hiperparameter-soekruimte, en verseker slegs 'n vaste bykomende afleidingskoste wat nie skaal met die lengte van die prompt nie.

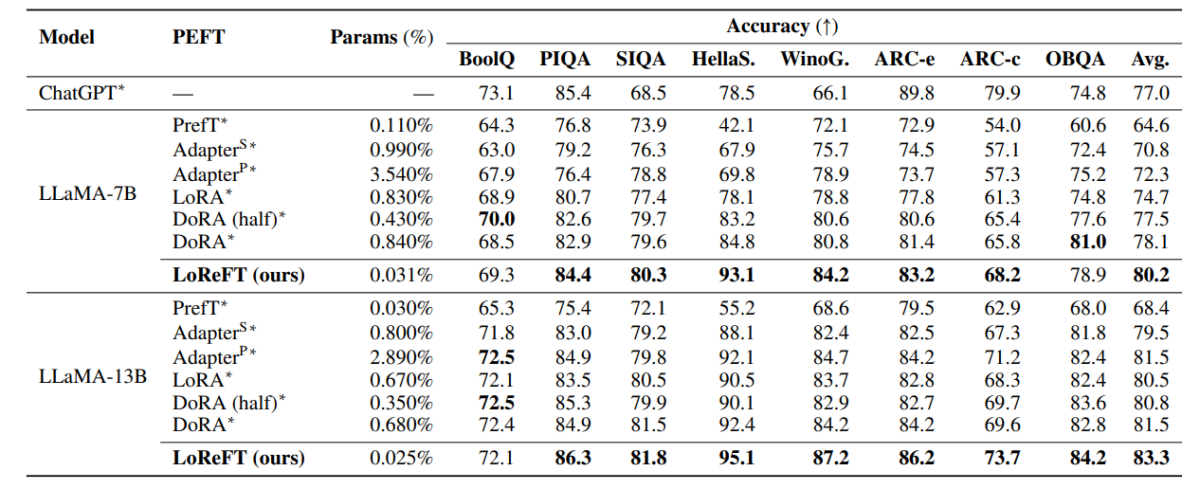

Die tabel hierbo vergelyk die akkuraatheid van die LLaMA-7B- en LLaMA-13B-raamwerke met bestaande PEFT-modelle oor 8 gesonde verstand-redenasiedatastel. Soos waargeneem kan word, presteer die LoReFT-model bestaande PEFT-benaderings met 'n ordentlike marge, ten spyte daarvan dat dit baie minder parameters het, met die gemiddelde prestasie van drie lopies wat gerapporteer word met duidelike parametersade vir die LoReFT-model. Die param(%) word bereken deur die aantal opleibare parameters te deel met die aantal totale parameters van die basis groot model.

Die tabel hierbo gee 'n opsomming van die akkuraatheidsvergelyking van die LLaMA-7B en LLaMA-13B-raamwerke teen bestaande PEFT-modelle oor 4 verskillende rekenkundige redenasiedatastelle, met die raamwerk wat die gemiddelde prestasie van drie lopies met duidelike ewekansige sade rapporteer. Soos waargeneem kan word, presteer die LoReFT-raamwerk, ten spyte van baie minder params (%), bestaande PEFT-raamwerke met 'n aansienlike marge.

Die tabel hierbo gee 'n opsomming van die akkuraatheidsvergelyking van die RoBERTa-basis en RoBERTa-groot raamwerke met bestaande PEFT-modelle oor die GLUE-maatstaf, met die raamwerk wat die gemiddelde prestasie van vyf lopies met duidelike ewekansige sade rapporteer. Soos waargeneem kan word, presteer die LoReFT-raamwerk, ten spyte van baie minder params (%), bestaande PEFT-raamwerke met 'n aansienlike marge.

Harde Gedagtes

In hierdie artikel het ons gepraat oor LoReFT, 'n kragtige alternatief vir bestaande PEFT-raamwerke wat sterk prestasie behaal oor maatstawwe van vier verskillende domeine terwyl dit tot 50 keer die doeltreffendheid bied wat deur vorige moderne PEFT-modelle aangebied word. Vooraf opgeleide groot modelle is dikwels fyn ingestel om vir nuwe domeine of take gebruik te word, en tydens die fyninstellingsproses kan 'n enkele basismodel aangepas word vir 'n wye verskeidenheid take, selfs met slegs klein hoeveelhede binne-domeindata beskikbaar na die model. Die proses om 'n hele model te verfyn is egter hulpbronrowend en duur, veral vir taalmodelle met 'n aansienlik groter aantal groottes en parameters. Parameterdoeltreffende fyninstelling of PeFT-metodes stel voor om die hoë koste verbonde aan die fyninstelling van die hele model aan te pak deur slegs 'n klein hoeveelheid van die totale beskikbare gewigte by te werk, 'n proses wat help om oefentyd te verminder saam met geheuegebruik. Veral, LoReFT vestig nuwe, moderne prestasie op gesonde verstand redenering, instruksies volg, en natuurlike taal begrip teen die sterkste PEFTs.