Anderson'ın Açısı

Yapay Zeka Video Üretiminde Tam Kontrole Doğru

Video temelli modeller gibi Hunyuan ve Geniş 2.1Güçlü olmalarına rağmen, kullanıcılara film ve TV prodüksiyonunun (özellikle VFX prodüksiyonunun) talep ettiği türden ayrıntılı kontrol sunmuyor.

Profesyonel görsel efekt stüdyolarında, bu tür açık kaynaklı modeller, video tabanlı (video yerine) daha önceki modellerle birlikte, Kararlı Difüzyon, Kandinsky ve Akı, genellikle ham çıktılarını belirli yaratıcı ihtiyaçları karşılayacak şekilde uyarlayan bir dizi destekleyici araçla birlikte kullanılır. Bir yönetmen, "Harika görünüyor, ama biraz daha [n] yapabilir miyiz?" Bu tür istekleri karşılayabilecek kadar hassas bir model olmadığını söyleyerek yanıt veremezsiniz.

Bunun yerine bir AI VFX ekibi bir dizi geleneksel yöntem kullanacaktır CGI ve kompozisyon teknikleri, zamanla geliştirilen özel prosedürler ve iş akışlarıyla birleştirilerek, video sentezinin sınırlarını biraz daha zorlamaya çalışıldı.

Benzer şekilde, bir temel video modeli, Chrome gibi bir web tarayıcısının varsayılan kurulumuna çok benzer; kullanıma hazır olarak çok şey yapar, ancak tam tersi değil de, ihtiyaçlarınıza göre uyarlanmasını istiyorsanız, bazı eklentilere ihtiyacınız olacak.

Kontrol manyağı

Difüzyon tabanlı görüntü sentezi dünyasında, bu tür üçüncü taraf sistemlerinin en önemlisi şudur: Kontrol Ağı.

ControlNet, difüzyon tabanlı üretken modellere yapılandırılmış kontrol eklemek için kullanılan bir tekniktir ve kullanıcıların görüntü veya video üretimini ek girdilerle yönlendirmesine olanak tanır. kenar haritaları, derinlik haritalarıya da poz bilgisi.

ControlNet'in çeşitli yöntemleri derinlik>görüntü (üst sıra), anlamsal segmentasyon>görüntü (sol alt) ve insan ve hayvanların poz rehberliğinde görüntü oluşturulmasına (sol alt) olanak tanır.

ControlNet, yalnızca metin istemlerine güvenmek yerine ayrı sinir ağı dalları veya adaptörlerBu koşullandırma sinyallerini, temel modelin üretken yeteneklerini koruyarak işleyen.

Bu, kullanıcı özelliklerine daha yakın ince ayarlı çıktılar elde edilmesini sağlar ve bu da özellikle hassas kompozisyon, yapı veya hareket kontrolünün gerekli olduğu uygulamalarda oldukça kullanışlıdır:

Rehber bir pozla ControlNet üzerinden çeşitli doğru çıktı tipleri elde edilebilir. Kaynak: https://arxiv.org/pdf/2302.05543

Ancak, bu tür adaptör tabanlı çerçeveler, çok içsel odaklı bir dizi sinirsel süreç üzerinde harici olarak çalışır. Bu yaklaşımların birkaç dezavantajı vardır.

İlk olarak, adaptörler bağımsız olarak eğitilir ve bu da şube çatışmaları Birden fazla adaptörün birleştirilmesi, üretim kalitesinin düşmesine neden olabilir.

İkincisi, tanıtıyorlar parametre yedekliliği, her bağdaştırıcı için ekstra hesaplama ve bellek gerektirerek ölçeklemeyi verimsiz hale getirir.

Üçüncüsü, esnekliklerine rağmen, adaptörler genellikle standart altı Sonuçlar tamamen modellere kıyasla ince ayar çoklu koşul üretimi için. Bu sorunlar, adaptör tabanlı yöntemleri, çoklu kontrol sinyallerinin sorunsuz entegrasyonunu gerektiren görevler için daha az etkili hale getirir.

İdeal olarak, ControlNet kapasiteleri eğitilmelidir doğal Modele, daha sonra ortaya çıkacak ve çok beklenen eş zamanlı video/ses üretimi veya yerel dudak senkronizasyonu yetenekleri (harici ses için) gibi belirgin yenilikleri barındırabilecek modüler bir şekilde eklendi.

Mevcut haliyle, her bir ekstra işlevsellik parçası, üzerinde çalıştığı temel modelin sıkı sıkıya bağlı ve hassas ağırlıklarında gezinmesi gereken bir post prodüksiyon görevini veya yerel olmayan bir prosedürü temsil eder.

TamDiT

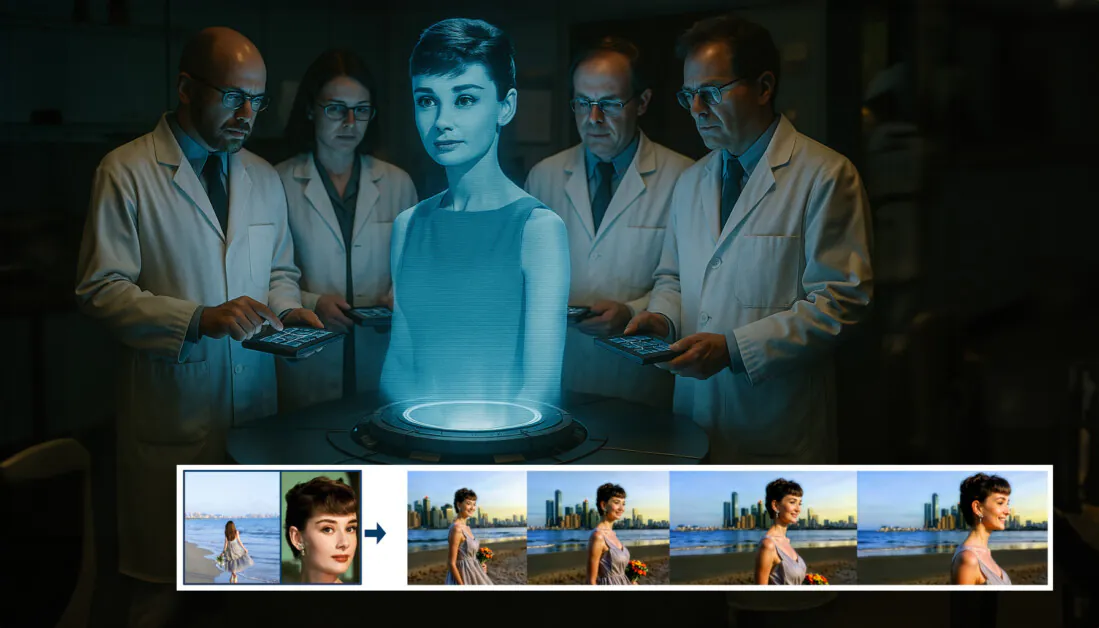

Bu çıkmaza Çin'den yeni bir teklif geliyor. Bu teklif, ControlNet tarzı ölçümlerin eğitim sırasında doğrudan üretken bir video modeline dahil edildiği ve sonradan akla gelen bir şey olmaktan çıkarıldığı bir sistem öneriyor.

Yeni makaleden: FullDiT yaklaşımı, kimlik dayatma, derinlik ve kamera hareketini yerel bir jenerasyona dahil edebilir ve bunların herhangi bir kombinasyonunu aynı anda çağırabilirKaynak: https://arxiv.org/pdf/2503.19907

Başlıklı TamDiT, yeni yaklaşım, kimlik transferi, derinlik haritalama ve kamera hareketi gibi çoklu görev koşullarını, yazarların prototip olarak eğitilmiş bir model ürettiği ve buna eşlik eden video klipleri ürettiği eğitilmiş bir üretken video modelinin entegre bir parçası haline getiriyor proje sitesi.

Aşağıdaki örnekte, kamera hareketi, kimlik bilgisi ve metin bilgisi (yani, kullanıcıya yol gösteren metin istemleri) içeren nesilleri görüyoruz:

Oynatmak için tıklayın. Yalnızca yerel olarak eğitilmiş bir temel modelle ControlNet tarzı kullanıcı dayatmasının örnekleri. Kaynak: https://fulldit.github.io/

Yazarların deneysel olarak eğitilmiş modellerini işlevsel bir temel model olarak değil, kullanıcılara yalnızca bir resim veya metin isteminden daha fazla kontrol sunan yerel metinden videoya (T2V) ve görüntüden videoya (I2V) modeller için bir kavram kanıtı olarak önerdikleri belirtilmelidir.

Bu türde henüz benzer bir model olmadığından, araştırmacılar yeni bir kıyaslama modeli oluşturdular. Tam Sıra, çoklu görev videolarının değerlendirilmesi için ve önceki yaklaşımlara karşı tasarladıkları benzer testlerde en son teknoloji performansını iddia ediyorlar. Ancak, FullBench yazarların kendileri tarafından tasarlandığından, nesnelliği test edilmemiştir ve 1,400 vakadan oluşan veri kümesi daha geniş sonuçlar için çok sınırlı olabilir.

Makalenin öne sürdüğü mimarinin belki de en ilginç yönü, yeni kontrol türlerini dahil etme potansiyelidir. Yazarlar şunları belirtiyor:

'Bu çalışmada, yalnızca kameranın kontrol koşullarını, kimlikleri ve derinlik bilgilerini inceliyoruz. Ses, konuşma, nokta bulutu, nesne sınırlayıcı kutular, optik akış vb. gibi diğer koşulları ve yöntemleri daha fazla araştırmadık. FullDiT tasarımı, diğer yöntemleri minimum mimari değişiklikle sorunsuz bir şekilde entegre edebilse de, mevcut modellerin yeni koşullara ve yöntemlere nasıl hızlı ve uygun maliyetli bir şekilde uyarlanacağı, daha fazla araştırmayı hak eden önemli bir soru olmaya devam ediyor.'

Araştırmacılar FullDiT'i çoklu görev video üretiminde ileri bir adım olarak sunsalar da, bu yeni çalışmanın temelde yeni bir paradigmayı tanıtmaktan ziyade mevcut mimariler üzerine inşa edildiği düşünülmelidir.

Bununla birlikte, FullDiT şu anda (bildiğim kadarıyla) 'sabit kodlu' ControlNet tarzı olanaklara sahip bir video temel modeli olarak tek başına duruyor ve önerilen mimarinin daha sonraki yenilikleri de barındırabildiğini görmek güzel.

Oynatmak için tıklayın. Proje alanından kullanıcı kontrollü kamera hareketlerine dair örnekler.

MKS yeni kağıt başlıklı FullDiT: Tam Dikkatle Çok Görevli Video Üretken Temel Modelive Kuaishou Teknolojisi ve Hong Kong Çin Üniversitesi'ndeki dokuz araştırmacıdan geliyor. Proje sayfası okuyun ve yeni kıyaslama verileri Hugging Face'te.

Yöntem

Yazarlar, FullDiT'in birleşik dikkat mekanizmasının, koşullar arasında hem mekansal hem de zamansal ilişkileri yakalayarak daha güçlü bir çapraz-modal temsil öğrenimine olanak sağladığını ileri sürüyorlar:

Yeni makaleye göre, FullDiT, tam öz-dikkat yoluyla birden fazla giriş koşulunu entegre ederek bunları birleşik bir diziye dönüştürür. Buna karşılık, adaptör tabanlı modeller (en soldaki yukarıda) her giriş için ayrı modüller kullanır ve bu da yedekliliğe, çatışmalara ve daha zayıf performansa yol açar.

Her giriş akışını ayrı ayrı işleyen adaptör tabanlı kurulumların aksine, bu paylaşımlı dikkat yapısı dal çatışmalarını önler ve parametre yükünü azaltır. Ayrıca mimarinin büyük bir yeniden tasarıma gerek kalmadan yeni giriş türlerine ölçeklenebileceğini ve model şemasının eğitim sırasında görülmeyen koşul kombinasyonlarına genelleme belirtileri gösterdiğini iddia ediyorlar, örneğin kamera hareketini karakter kimliğiyle ilişkilendirmek gibi.

Oynatmak için tıklayın. Proje sahasından kimlik oluşturma örnekleri.

FullDiT mimarisinde, tüm koşullandırma girdileri (metin, kamera hareketi, kimlik ve derinlik gibi) önce birleşik bir belirteç biçimine dönüştürülür. Bu belirteçler daha sonra tek bir uzun diziye birleştirilir ve bu dizi bir yığın aracılığıyla işlenir. transformatör katmanları tam öz dikkat kullanarak. Bu yaklaşım, önceki çalışmaları takip eder, örneğin Açık-Sora Planı ve Film Gen.

Bu tasarım, modelin tüm koşullar arasında zamansal ve mekansal ilişkileri birlikte öğrenmesini sağlar. Her bir transformatör bloğu, her bir giriş için ayrı modüllere güvenmeden modaliteler arasında dinamik etkileşimler sağlayarak tüm dizi boyunca çalışır ve belirttiğimiz gibi mimari, gelecekte büyük yapısal değişiklikler olmadan ek kontrol sinyallerinin dahil edilmesini çok daha kolay hale getirecek şekilde genişletilebilir olacak şekilde tasarlanmıştır.

Üçün Gücü

FullDiT, tüm koşulların birleşik bir dikkat çerçevesinde birlikte işlenebilmesi için her kontrol sinyalini standartlaştırılmış bir belirteç biçimine dönüştürür. Kamera hareketi için model, her kare için konum ve yönelim gibi bir dizi dışsal parametreyi kodlar. Bu parametreler zaman damgalıdır ve sinyalin zamansal doğasını yansıtan gömme vektörlerine yansıtılır.

Kimlik bilgisi, doğası gereği zamansal olmaktan çok mekansal olduğu için farklı şekilde ele alınır. Model, her karenin hangi bölümlerinde hangi karakterlerin bulunduğunu gösteren kimlik haritalarını kullanır. Bu haritalar şu şekilde ayrılır: yamalarher yama bir katıştırma Mekansal kimlik ipuçlarını yakalayan ve modelin karenin belirli bölgelerini belirli varlıklarla ilişkilendirmesine olanak tanıyan

Derinlik, uzaysal-zamansal bir sinyaldir ve model, derinlik videolarını hem uzayı hem de zamanı kapsayan 3B yamalar halinde bölerek bunu ele alır. Bu yamalar daha sonra yapılarını kareler boyunca koruyacak şekilde gömülür.

Bir kez yerleştirildiğinde, tüm bu koşul belirteçleri (kamera, kimlik ve derinlik) tek bir uzun diziye birleştirilir ve FullDiT'in bunları tam olarak kullanarak birlikte işlemesine olanak tanır Kendi kendine dikkatBu paylaşılan gösterim, modelin izole işlem akışlarına güvenmeden, farklı modaliteler ve zamanlar arasında etkileşimleri öğrenmesini mümkün kılar.

Veriler ve Testler

FullDiT'in eğitim yaklaşımı, tüm koşulların aynı anda mevcut olmasını gerektirmek yerine, her koşullandırma türüne göre uyarlanmış, seçici olarak ek açıklamalı veri kümelerine dayanıyordu.

Metinsel koşullar için girişim, aşağıda özetlenen yapılandırılmış altyazı yaklaşımını takip eder: Mira Verisi projesi.

MiraData projesinden video toplama ve açıklama hattı. Kaynak: https://arxiv.org/pdf/2407.06358

Kamera hareketi için, Emlak10K Veri seti, kamera parametrelerinin yüksek kaliteli gerçek zemin açıklamaları nedeniyle ana veri kaynağıydı.

Ancak yazarlar, RealEstate10K gibi yalnızca statik sahne kamera veri kümeleri üzerinde eğitim almanın, oluşturulan videolarda dinamik nesne ve insan hareketlerini azaltma eğiliminde olduğunu gözlemlediler. Bunu engellemek için, daha dinamik kamera hareketleri içeren dahili veri kümelerini kullanarak ek ince ayar yaptılar.

Kimlik açıklamaları, geliştirilen boru hattı kullanılarak oluşturuldu KonseptUstası kimlik bilgilerinin etkin bir şekilde filtrelenmesine ve çıkarılmasına olanak sağlayan proje.

ConceptMaster çerçevesi, özelleştirilmiş videolarda kavram sadakatini korurken kimlik ayrıştırma sorunlarını ele almak üzere tasarlanmıştır. Kaynak: https://arxiv.org/pdf/2501.04698

Derinlik açıklamaları şuradan elde edildi: Panda-70M veri kümesi kullanılarak Derinlik Her Şey.

Veri Sıralaması Yoluyla Optimizasyon

Yazarlar ayrıca daha zorlu koşulları tanıtan kademeli bir eğitim programı uyguladılar eğitimin erken dönemlerinde daha basit görevler eklenmeden önce modelin sağlam temsiller edindiğinden emin olmak için. Eğitim emri şu şekilde devam etti: metin için kamera koşullar, o zaman kimlikler, ve sonunda derinlik, daha kolay görevler genellikle daha sonra ve daha az örnekle tanıtılır.

Yazarlar iş yükünün bu şekilde sıralanmasının değerini vurgulamaktadır:

'Eğitim öncesi aşamada, daha zorlu görevlerin daha uzun eğitim süresi gerektirdiğini ve öğrenme sürecinin daha erken aşamalarında tanıtılması gerektiğini fark ettik. Bu zorlu görevler, çıktı videosundan önemli ölçüde farklı olan karmaşık veri dağılımlarını içerir ve modelin bunları doğru bir şekilde yakalamak ve temsil etmek için yeterli kapasiteye sahip olmasını gerektirir.

'Tam tersine, daha kolay görevleri çok erken tanıtmak, modelin bunları öğrenmeyi önceliklendirmesine yol açabilir, çünkü bunlar daha anında optimizasyon geri bildirimi sağlar ve bu da daha zorlu görevlerin bir araya gelmesini engeller.'

Araştırmacılar tarafından benimsenen veri eğitim sırasının bir gösterimi; kırmızı renk daha fazla veri hacmini göstermektedir.

İlk ön eğitimden sonra, son bir ince ayar aşaması görsel kaliteyi ve hareket dinamiklerini iyileştirmek için modeli daha da geliştirdi. Daha sonra eğitim, standart bir difüzyon çerçevesinin eğitimini takip etti*: video latentlerine gürültü eklendi ve model tahmin etmeyi ve onu kaldırmayı öğrenmek, gömülü koşul belirteçlerini kılavuz olarak kullanarak.

FullDiT'yi etkili bir şekilde değerlendirmek ve mevcut yöntemlerle adil bir karşılaştırma sağlamak ve başka uygun bir kıyaslama ölçütünün bulunmaması durumunda, yazarlar şunları tanıttı: Tam Sıra1,400 ayrı test vakasından oluşan, özenle seçilmiş bir kıyaslama paketi.

Yeni FullBench kıyaslaması için bir veri gezgini örneği. Kaynak: https://huggingface.co/datasets/KwaiVGI/FullBench

Her veri noktası, çeşitli koşullandırma sinyalleri için temel gerçek açıklamaları sağladı; bunlara şunlar dahildir: kamera hareketi, kimlik, ve derinlik.

Metrikleri

Yazarlar, FullDiT'i performansın beş ana yönünü kapsayan on metriği kullanarak değerlendirdi: metin hizalaması, kamera kontrolü, kimlik benzerliği, derinlik doğruluğu ve genel video kalitesi.

Metin hizalaması kullanılarak ölçüldü KLİP benzerliği, kamera kontrolü şu şekilde değerlendirildi: dönüş hatası (RotErr), çeviri hatası (TransErr), Ve kamera hareketi tutarlılığı (CamMC), yaklaşımını izleyerek CamI2V (içinde KameraKontrol proje).

Kimlik benzerliği kullanılarak değerlendirildi DINO-ben ve KLİP-Ive derinlik kontrol doğruluğu kullanılarak ölçüldü Ortalama Mutlak Hata (MAE).

Video kalitesi MiraData'dan alınan üç ölçüt ile değerlendirildi: pürüzsüzlük için kare düzeyinde CLIP benzerliği; dinamikler için optik akış tabanlı hareket mesafesi; ve LAION-Estetik puanlar görsel çekicilik için.

Eğitim

Yazarlar, FullDiT'i yaklaşık bir milyar parametre içeren dahili (açıklanmayan) bir metinden videoya yayılma modeli kullanarak eğittiler. Önceki yöntemlerle karşılaştırmalarda adaleti korumak ve yeniden üretilebilirliği sağlamak için kasıtlı olarak mütevazı bir parametre boyutu seçtiler.

Eğitim videoları uzunluk ve çözünürlük açısından farklılık gösterdiğinden, yazarlar her birini standartlaştırdı yığın videoları ortak bir çözünürlüğe yeniden boyutlandırarak ve doldurarak, dizi başına 77 kare örnekleyerek ve uygulanan dikkat ve kayıp maskeleri eğitim etkinliğini en üst düzeye çıkarmak için.

MKS Adem optimize edici bir şekilde kullanıldı öğrenme oranı 1 × 10-5 64 NVIDIA H800 GPU'dan oluşan bir kümede, toplam 5,120 GB VRAM'e ulaşıldı (meraklı sentez topluluklarında bunu göz önünde bulundurun), 24GB (RTX 3090'da hala lüks bir standart olarak kabul ediliyor).

Model, toplam 32,000 kareden eşit şekilde örneklenen 20 kamera karesi ve 21 derinlik karesi koşuluyla birlikte video başına üç kimliğe kadar dahil edilerek yaklaşık 77 adım için eğitildi.

Çıkarım için, model 384 difüzyon çıkarım adımı ve beşlik bir sınıflandırıcı içermeyen rehberlik ölçeği ile 672x15 piksel çözünürlükte (saniyede 50 karede yaklaşık beş saniye) videolar üretti.

Önceki Yöntemler

Kamera-video değerlendirmesi için yazarlar FullDiT'yi şu şekilde karşılaştırdı: HareketCtrl, CameraCtrl ve CamI2V, tutarlılık ve adaleti sağlamak için RealEstate10k veri kümesi kullanılarak eğitilen tüm modeller.

Kimlik koşullu üretimde, karşılaştırılabilir açık kaynaklı çoklu kimlik modelleri mevcut olmadığından, model aynı eğitim verileri ve mimari kullanılarak 1B parametreli ConceptMaster modeliyle kıyaslandı.

Derinlik-video görevleri için karşılaştırmalar yapıldı Ctrl-Bağdaştırıcı ve KontrolVideo.

Tek görevli video üretimi için nicel sonuçlar. FullDiT, kamera-video üretimi için MotionCtrl, CameraCtrl ve CamI2V ile; kimlik-video üretimi için ConceptMaster (1B parametre sürümü) ile; derinlik-video üretimi için Ctrl-Adapter ve ControlVideo ile karşılaştırıldı. Tüm modeller varsayılan ayarları kullanılarak değerlendirildi. Tutarlılık için, her yöntemden 16 kare eşit olarak örneklendi ve önceki modellerin çıktı uzunluğuyla eşleştirildi.

Sonuçlar, FullDiT'in aynı anda birden fazla koşullandırma sinyalini işlemesine rağmen metin, kamera hareketi, kimlik ve derinlik kontrolleriyle ilgili ölçümlerde en son teknoloji performansına ulaştığını göstermektedir.

Genel kalite ölçümlerinde sistem genel olarak diğer yöntemlerden daha iyi performans gösterdi, ancak akıcılığı ConceptMaster'ınkinden biraz daha düşüktü. Yazarların yorumu şu şekilde:

'FullDiT'in düzgünlüğü ConceptMaster'ınkinden biraz daha düşüktür çünkü düzgünlüğün hesaplanması bitişik kareler arasındaki CLIP benzerliğine dayanmaktadır. FullDiT, ConceptMaster'a kıyasla önemli ölçüde daha büyük dinamikler sergilediğinden, düzgünlük metriği bitişik kareler arasındaki büyük farklılıklardan etkilenir.

'Estetik puan açısından, derecelendirme modeli resim stilindeki görüntüleri tercih ettiğinden ve ControlVideo genellikle bu stilde videolar ürettiğinden, estetik açıdan yüksek bir puan elde ediyor.'

Nitel karşılaştırma açısından, FullDiT proje sitesindeki örnek videolara başvurulması daha iyi olabilir, çünkü PDF örnekleri kaçınılmaz olarak statiktir (ve ayrıca burada tamamen yeniden üretilemeyecek kadar büyüktür).

PDF'deki nitel sonuçların ilk bölümü. Lütfen burada yeniden üretilemeyecek kadar kapsamlı olan ek örnekler için kaynak makaleye bakın.

Yazarlar yorum:

'FullDiT, [ConceptMaster] ile karşılaştırıldığında üstün kimlik koruma özelliği gösteriyor ve daha iyi dinamiklere ve görsel kaliteye sahip videolar üretiyor. ConceptMaster ve FullDiT aynı omurgada eğitildiğinden, bu durum tam dikkatle durum enjeksiyonunun etkinliğini vurguluyor.

'...[Diğer] sonuçlar, FullDiT'in mevcut derinlik-video ve kamera-video yöntemlerine kıyasla üstün kontrol edilebilirliğini ve üretim kalitesini göstermektedir.'

FullDiT'in çoklu sinyal çıktılarına ait PDF örneklerinin bir bölümü. Ek örnekler için lütfen kaynak makaleye ve proje sitesine bakın.

Sonuç

FullDiT, daha fazla özelliğe sahip bir video temel modeli için heyecan verici bir adım olsa da, ControlNet tarzı araçlara olan talebin, en azından ticari destek olmadan gerekli olan muazzam miktardaki GPU işlem gücünü elde etmekte zorluk çekecek olan FOSS projeleri için, bu tür özelliklerin büyük ölçekte uygulanmasını haklı çıkarıp çıkarmayacağını merak etmek gerek.

Birincil zorluk, Depth ve Pose gibi sistemleri kullanmanın genellikle ComfyUI gibi nispeten karmaşık kullanıcı arayüzlerine ilişkin önemsiz olmayan bir aşinalık gerektirmesidir. Bu nedenle, bu tür bir işlevsel FOSS modelinin, kapalı kapılar ardında böyle bir modeli küratörlüğünü yapmak ve eğitmek için parası (veya bu tür sistemlerin model yükseltmeleriyle hızla eskimiş hale gelmesi göz önüne alındığında isteği) olmayan daha küçük VFX şirketlerinden oluşan bir kadro tarafından geliştirilmesi daha olasıdır.

Öte yandan, API odaklı 'kirala-yapay zeka' sistemleri, yardımcı kontrol sistemlerinin doğrudan eğitildiği modeller için daha basit ve daha kullanıcı dostu yorumlama yöntemleri geliştirmek için iyi motive olmuş olabilir.

Oynatmak için tıklayın. FullDiT kullanılarak video üretimine uygulanan Derinlik+Metin kontrolleri.

* Yazarlar bilinen herhangi bir temel model (örneğin SDXL, vb.) belirtmiyorlar.

İlk yayın tarihi Perşembe, 27 Mart 2025