Kacerdasan buatan

LoReFT: Representasi Finetuning pikeun Modél Basa

Parameter-efisien fine-tuning atawa métode PeFT neangan adaptasi model basa badag ngaliwatan apdet kana sajumlah leutik beurat. Sanajan kitu, seuseueurna karya interpretability aya geus nunjukkeun yén Répréséntasi encode informasi euyeub semantik, suggesting yén éta bisa jadi alternatif hadé tur leuwih kuat pikeun ngédit Répréséntasi ieu. Modél ageung anu tos dilatih sering disaluyukeun pikeun dianggo pikeun domain atanapi tugas énggal, sareng salami prosés nyéépkeun, modél dasar tunggal tiasa diadaptasi kana rupa-rupa pancén sanajan ngan ukur sajumlah leutik data dina domain anu sayogi. kana modél. Sanajan kitu, prosés fine-tuning sakabéh modél téh resource-consuming, sarta mahal, utamana pikeun model basa kalawan jumlah nyata luhur ukuran jeung parameter.

Parameter-efisien fine-tuning atawa métode PeFT ngajukeun tackle biaya tinggi pakait sareng fine-tuning sakabeh model ku ngamutahirkeun ngan jumlah leutik tina total beurat sadia, prosés nu mantuan dina ngurangan waktu latihan babarengan jeung pamakéan memori. Anu langkung penting nyaéta Parameter-efisien fine-tuning atanapi metode PeFT parantos nunjukkeun kinerja anu sami sareng finetune dina sababaraha setélan praktis. Adaptor, kulawarga umum tina Parameter-efisien fine-tuning atawa métode PeFT, diajar éditan nu bisa ditambahkeun kana set tambahan tina beurat nu beroperasi barengan model dasar beku, jeung adapters panganyarna kawas LoRA ngurangan jumlah parameter trainable dina diajar. apdet beurat ku ngagunakeun perkiraan-rank low tinimbang matrices full-beurat nalika ngalatih adaptor.

Kalayan karya-karya saméméhna anu nunjukkeun répréséntasi éditan tiasa janten alternatif anu langkung saé pikeun paramèter-efisién fine-tuning atanapi metode PeFT, dina tulisan ieu, urang bakal ngobrol ngeunaan Representasi Fine-tuning atanapi metode ReFT anu beroperasi dina modél beku, sareng diajar tugas-spésifik. interventions on Répréséntasi disumputkeun. Artikel ieu boga tujuan pikeun nutupan kerangka ReFt atanapi Representasi Fine-tuning sacara jero, sareng urang ngajalajah mékanisme, metodologi, arsitéktur kerangka sareng ngabandingkeunana sareng kerangka seni. Ku kituna hayu urang ngamimitian.

ReFT: Representasi Fine-tuning pikeun Modél Basa

Dina usaha pikeun ngadopsi modél basa anu tos dilatih pikeun domain sareng tugas énggal, kerangka kerja anu ayeuna nyaluyukeun modél basa anu tos dilatih ieu sering sapertos dina prosés fine-tuning anu dilaksanakeun, modél dasar tunggal tiasa diadaptasi kana rupa-rupa tugas bahkan. nalika damel sareng sajumlah leutik data dina domain. Sanajan prosés fine-tuning naekeun kinerja sakabéh, éta mangrupa prosés mahal utamana lamun model basa boga jumlah signifikan tinggi parameter. Pikeun tackle masalah ieu, sarta ngurangan waragad pakait, PeFT atanapi Parameter-efisien kerangka fine-tuning Ngamutahirkeun ukur sabagian leutik tina total beurat, prosés anu henteu ngan ukur ngirangan waktos latihan, tapi ogé ngirangan pamakean mémori, ngamungkinkeun kerangka PeFT pikeun ngahontal prestasi anu sami upami dibandingkeun sareng pendekatan lengkep anu cocog dina skenario praktis. Adapter, kulawarga umum tina PeFTs, dianggo ku diajar éditan nu bisa ditambahkeun kana set tambahan tina beurat babarengan jeung sawaréh ti beurat nu beroperasi dina unison jeung model dasar kalawan beurat beku. kerangka adaptor panganyarna kawas LoRA sareng QLoRA geus nunjukkeun yén kasebut nyaéta dimungkinkeun pikeun ngalatih adapters full-precision dina luhureun model precision ngurangan tanpa mangaruhan kinerja. Adaptor biasana leuwih éfisién jeung éféktif lamun dibandingkeun jeung métode séjénna nu ngawanohkeun komponén modél anyar.

Hiji sorotan utama kaayaan kiwari seni Parameter-efisien fine-tuning frameworks éta tinimbang ngaropéa representasi, aranjeunna ngaropéa beurat. Tapi, kerangka anu aya hubunganana sareng interpretasi parantos nunjukkeun yén répréséntasi ngodekeun inpormasi semantik anu beunghar, nunjukkeun yén répréséntasi ngedit tiasa janten pendekatan anu langkung saé sareng langkung kuat upami dibandingkeun sareng pembaruan beurat. Anggapan éditan répréséntasi ieu mangrupikeun pendekatan anu langkung saé nyaéta anu ngabentuk pondasi kerangka ReFT atanapi Representasi Fine-tuning anu ngalatih intervensi tinimbang adaptasi beurat modél, ngamungkinkeun modél ngamanipulasi fraksi leutik sadaya répréséntasi dina usaha pikeun ngarahkeun paripolah modél. pikeun ngajawab tugas hilir salila inferensi. Metodeu ReFT atanapi Representation Fine-tuning mangrupikeun panggantian pikeun PeFT dumasar-beurat atanapi kerangka-parameter-efisien fine-tuning. Pendekatan ReFT ngagambar inspirasi ti model panganyarna gawé bareng interpretability model badag nu intervenes on Répréséntasi pikeun manggihan mékanisme kausal satia, sarta steers paripolah model salila inferensi, sarta ku kituna bisa ditempo salaku generalisasi model representasi-ngédit. Ngawangun sami, LoReFT atanapi Low-Rank Subspace ReFT mangrupakeun conto kuat tur éféktif ReFT, sarta mangrupakeun parameterization of ReFT nu intervenes on Répréséntasi disumputkeun dina spasi linier spanned ku low-rank proyéksi matrix, sarta ngawangun langsung dina DAS. atanapi Distributed Alignment Search kerangka.

Pindah sapanjang, sabalikna mun pinuh fine-tuning, PeFT atawa Parameter-efisien kerangka fine-tuning ngalatih ukur fraksi leutik tina parameter model, sarta manages adaptasi modél kana tugas hilir. Parameter-efisien kerangka fine-tuning bisa digolongkeun kana tilu kategori utama:

- Métode dumasar kana adaptor: Métode dumasar adaptor ngalatih modul tambahan sapertos lapisan anu disambungkeun pinuh di luhur modél anu tos dilatih kalayan beurat beku. Adaptor séri nyelapkeun komponén antara perceptron multilayer atanapi MLP sareng LM atanapi lapisan perhatian modél ageung, sedengkeun adaptor paralel nambihan modul sareng komponén anu tos aya. Kusabab adapters nambahkeun komponén anyar nu teu bisa narilep kana beurat model aya gampang, aranjeunna pasang aksi beungbeurat tambahan salila inferensi.

- LoRA: LoRA sareng varian panganyarna na perkiraan beurat aditif nalika latihan ku ngagunakeun matriks peringkat rendah, sareng aranjeunna henteu meryogikeun overhead tambahan nalika inferensi sabab apdet beurat tiasa dihijikeun kana modél, sareng éta alesan kunaon aranjeunna dianggap ayeuna. kerangka PeFT pangkuatna.

- Métode dumasar ajakan: Métode dumasar ajakan nambahkeun token lemes nu initialized acak kana input, sarta ngalatih embeddings maranéhna bari tetep beurat model basa beku. Kinerja anu ditawarkeun ku metode ieu sering henteu nyugemakeun upami dibandingkeun sareng pendekatan PeFT anu sanés, sareng aranjeunna ogé ngagaduhan biaya overhead inferensi anu signifikan.

Gantina ngamutahirkeun beurat, kerangka ReFT diajar campur pikeun ngaropea fraksi leutik tina total representasi. Salaku tambahan, karya panganyarna ngeunaan rékayasa répréséntasi sareng setir aktivasina nunjukkeun yén nambihan vektor setir tetep kana aliran sésa-sésa tiasa ngagampangkeun tingkat kontrol kana generasi modél ageung anu tos dilatih tanpa meryogikeun sumber daya-intensif. Setélan lemes. Kerangka anu sanés nunjukkeun yén répréséntasi ngédit kalayan skala anu diajar sareng operasi tarjamahan tiasa nyobian cocog tapi henteu ngaleuwihan prestasi anu ditawarkeun ku adaptor LoRA dina rupa-rupa pancén kalayan parameter anu langkung saeutik. Saterusna, kasuksésan kerangka ieu dina sauntuyan pancén geus nunjukkeun yén répréséntasi diwanohkeun ku modél basa pra-dilatih mawa semantik euyeub, sanajan kinerja model ieu sub-optimal, hasilna PeFTs neruskeun jadi kaayaan tina pendekatan seni. tanpa beban inferensi tambahan.

ReFT: Métodologi jeung Arsitéktur

Pikeun ngajaga prosés pelestarian gaya saderhana, kerangka ReFT nganggap modél ageung dumasar-trafo salaku modél targétna anu sanggup ngahasilkeun répréséntasi kontekstual tina runtuyan token. Pikeun sekuen anu dipasihkeun ku n jumlah token input, kerangka ReFT mimiti nyelapkeun token input ieu kana daptar perwakilan anu saatos lapisan m ngitung daptar perwakilan disumputkeun sacara berturut-turut salaku fungsi tina daptar representasi disumputkeun sateuacana. Unggal ngagambarkeun disumputkeun mangrupakeun vektor, sarta model basa ngagunakeun Répréséntasi disumputkeun final pikeun ngahasilkeun prediksi. Kerangka ReFT nganggap duanana model basa masked jeung model basa autoregressive. Ayeuna, dumasar kana hipotésis répréséntasi linier, dina jaringan saraf, konsép disandikeun dina subruang liniér répréséntasi. Modél panganyarna mendakan klaim ieu leres dina modél jaringan saraf anu dilatih dina basa alami sareng distribusi input anu sanés.

Saterusna, dina studi interpretability, kerangka abstraksi kasual ngagunakeun interventions silih tukeur pikeun ngadegkeun peran komponén jaringan neural casually nalika ngalaksanakeun paripolah nu tangtu. Logika balik interventions interchange nyaeta lamun salah nangtukeun hiji ngagambarkeun naon eta bakal jadi pikeun input counterfactual, sarta campur ieu mangaruhan kaluaran model konsistén dina cara nu klaim dijieun ku kerangka ReFT ngeunaan komponén jawab ngahasilkeun. éta ngagambarkeun, mangka komponén muterkeun hiji peran kausal dina kabiasaan. Sanajan aya sababaraha métode, intervention interchange disebarkeun mangrupa pendekatan idéal pikeun nguji naha hiji konsép disandikeun dina subspace linier representasi, sakumaha diklaim ku hipotesa ngagambarkeun linier. Satuluyna, métode DAS geus dipaké saméméhna pikeun manggihan répréséntasi linier dina modél basa atribut entity, sentimen, fitur linguistik, jeung nalar matematik. Sanajan kitu, sababaraha percobaan geus nunjukkeun yén métode DAS téh kacida ekspresif, sarta mibanda kamampuhan pikeun manggihan kausal efficacious subspaces sanajan model basa trafo geus initialized acak, sarta ku kituna can diajar sagala tugas-spésifik representasi, hasilna debat naha DAS téh éféktif jeung cukup jawab tugas interpretability.

Ekspresivitas anu ditawarkeun ku DAS nunjukkeun yén pendekatan éta tiasa janten alat anu idéal pikeun ngontrol paripolah modél basa sareng karyana dina generasi anu tiasa dikontrol sareng éditan anu tanggung jawab. Ku alatan éta, pikeun adaptasi model basa keur tugas hilir, kerangka ReFT ngagunakeun operasi interchange disebarkeun pikeun nyieun hiji métode efisien parameter anyar. Saterusna, métode ReFT nyaéta sakumpulan interventions, sarta kerangka enforces yén pikeun sagala dua interventions nu beroperasi dina lapisan sarua, posisi campur kudu disjoint, kalawan parameter sadaya fungsi campur tetep bebas. Hasilna, ReFT mangrupakeun kerangka generik nu ngawengku interventions on Répréséntasi disumputkeun salila modél maju pass.

ReFT: Percobaan sareng Hasil

Pikeun meunteun kinerjana ngalawan kerangka PEFT anu tos aya, kerangka ReFT ngalaksanakeun ékspérimén dina opat tolok ukur pamrosésan basa alami anu rupa-rupa, sareng nyertakeun langkung ti 20 setét, sareng tujuan utami pikeun masihan gambaran anu saé ngeunaan kumaha kerangka LoReFT ngalaksanakeun dina skenario anu béda. Saterusna, nalika kerangka LoReFT dilaksanakeun dina kahirupan nyata, pamekar kudu mutuskeun dina sabaraha interventions diajar babarengan jeung posisi input sarta lapisan pikeun nerapkeun tiap on. Pikeun ngarengsekeun tugas, kerangka ReFT nyetél opat hyperparameter.

- Jumlah posisi awalan pikeun campur dina.

- Jumlah posisi sufiks pikeun campur dina.

- Naon susunan lapisan pikeun campur dina.

- Naha atanapi henteu dasi parameter intervensi dina posisi anu béda dina lapisan anu sami.

Ku ngalakukeun ieu, kerangka ReFT simplifies spasi pilarian hyperparameter, sarta ensures ngan waragad inferensi tambahan tetep nu teu skala jeung panjang ajakan.

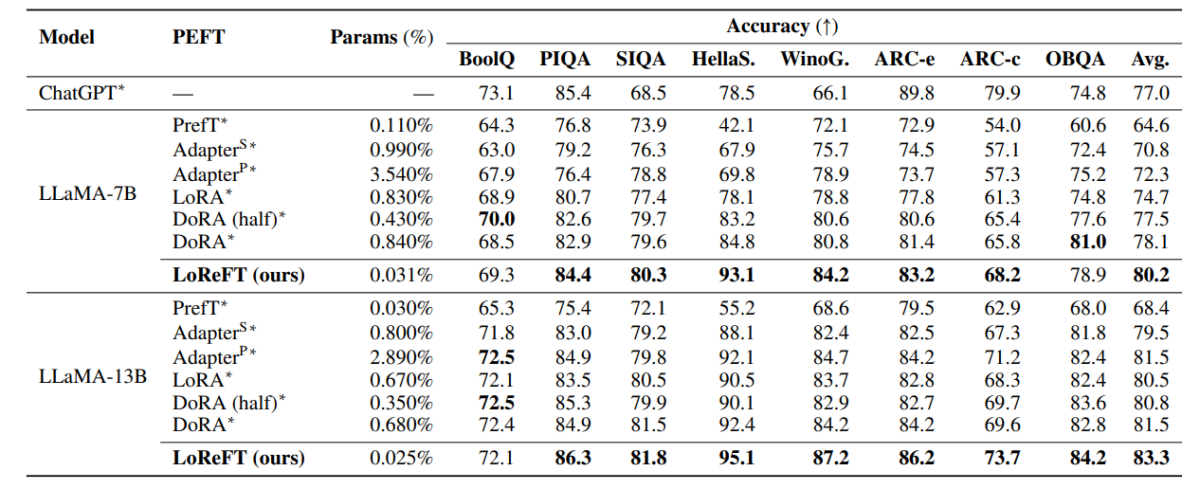

Tabel di luhur ngabandingkeun katepatan kerangka LLaMA-7B sareng LLaMA-13B ngalawan model PEFT anu tos aya dina 8 set data alesan akal sehat. Salaku bisa dititénan, modél LoReFT outperforms pendekatan PEFT aya ku margin santun, sanajan ngabogaan parameter leuwih saeutik, kalawan kinerja rata-rata tilu ngalir dilaporkeun kalawan siki parameter béda pikeun modél LoReFT. Param(%) diitung ku ngabagi jumlah parameter dilatih jeung jumlah total parameter model badag dasar.

Tabél di luhur nyimpulkeun perbandingan akurasi kerangka LLaMA-7B sareng LLaMA-13B ngalawan modél PEFT anu tos aya dina 4 set data penalaran aritmetika anu béda, kalayan kerangka ngalaporkeun kinerja rata-rata tilu run kalayan siki acak anu béda. Salaku bisa dititénan, sanajan boga leuwih saeutik params(%), kerangka LoReFT outperforms kerangka PEFT aya ku margin considerable.

Tabel di luhur summarizes babandingan akurasi RoBERTa-base na RoBERTa-ageung frameworks ngalawan model PEFT aya sakuliah patokan lem, kalawan kerangka ngalaporkeun kinerja rata-rata lima ngajalankeun kalawan siki acak béda. Salaku bisa dititénan, sanajan boga leuwih saeutik params(%), kerangka LoReFT outperforms kerangka PEFT aya ku margin considerable.

Pikiran final

Dina artikel ieu, urang geus ngobrol ngeunaan LoReFT, alternatif kuat pikeun kerangka PEFT aya nu ngahontal kinerja kuat sakuliah tolok ukur tina opat domain béda bari nawarkeun nepi ka 50 kali efisiensi ditawarkeun ku kaayaan saméméhna tina model PEFT seni. Modél ageung anu tos dilatih sering disaluyukeun pikeun dianggo pikeun domain atanapi tugas énggal, sareng salami prosés nyéépkeun, modél dasar tunggal tiasa diadaptasi kana rupa-rupa pancén sanajan ngan ukur sajumlah leutik data dina domain anu sayogi. kana modél. Sanajan kitu, prosés fine-tuning sakabéh modél téh resource-consuming, sarta mahal, utamana pikeun model basa kalawan jumlah nyata luhur ukuran jeung parameter. Parameter-efisien fine-tuning atawa métode PeFT ngajukeun tackle biaya tinggi pakait sareng fine-tuning sakabeh model ku ngamutahirkeun ngan jumlah leutik tina total beurat sadia, prosés nu mantuan dina ngurangan waktu latihan babarengan jeung pamakéan memori. Utamana, LoReFT ngadegkeun kinerja canggih anyar dina nalar commonsense, instruksi-nuturkeun, jeung pamahaman basa alam ngalawan PEFTs neneng.